Vad är Prompt Engineering för AI-sök – Komplett Guide

Lär dig vad prompt engineering är, hur det fungerar med AI-sökmotorer som ChatGPT och Perplexity, och upptäck viktiga tekniker för att optimera dina AI-sökresul...

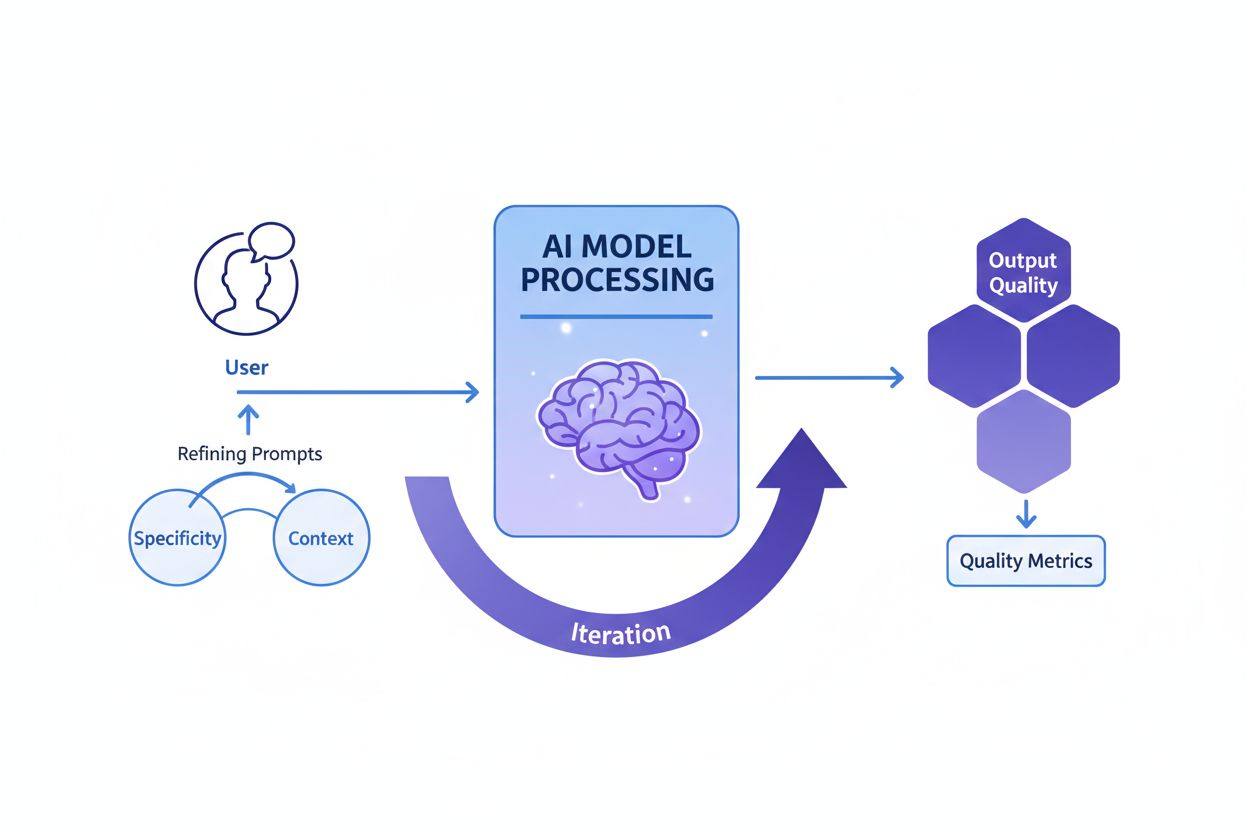

Prompt engineering är processen att skapa, förfina och optimera instruktioner i naturligt språk för att styra generativa AI-modeller mot att producera önskade, korrekta och relevanta resultat. Det innebär iterativt experimenterande med formulering, kontext och struktur för att maximera AI-prestanda utan att ändra den underliggande modellen.

Prompt engineering är processen att skapa, förfina och optimera instruktioner i naturligt språk för att styra generativa AI-modeller mot att producera önskade, korrekta och relevanta resultat. Det innebär iterativt experimenterande med formulering, kontext och struktur för att maximera AI-prestanda utan att ändra den underliggande modellen.

Prompt engineering är den systematiska processen att utforma, förfina och optimera instruktioner i naturligt språk—så kallade prompts—för att styra generativa AI-modeller mot att producera önskade, korrekta och kontextuellt relevanta resultat. Istället för att ändra den underliggande AI-modellen arbetar promptingenjörer med modellens befintliga kapacitet genom att noggrant strukturera sin inmatning för att påverka hur modellen bearbetar information och genererar svar. Denna disciplin uppstod som en kritisk färdighet under boomen för generativa AI 2023-2025, då organisationer insåg att tillgång till kraftfulla AI-verktyg som ChatGPT, Claude, Perplexity och Google AI inte räckte utan expertis i effektiv kommunikation med dessa system. Prompt engineering överbryggar klyftan mellan mänsklig avsikt och AI-kapacitet, och omvandlar vaga affärsmål till handlingsbara, högkvalitativa AI-resultat. Praktiken är i grunden iterativ och kräver kontinuerligt experimenterande, testning och förfining för att uppnå optimala resultat för specifika användningsfall.

Konceptet prompt engineering växte fram organiskt efter att ChatGPT offentliggjordes i november 2022, när miljontals användare började experimentera med hur man kunde få bättre resultat från stora språkmodeller. Tidiga användare upptäckte att kvaliteten på AI-resultaten varierade kraftigt beroende på hur frågor formulerades, vilken kontext som gavs och hur specifika instruktionerna var. Denna insikt ledde till att prompt engineering formaliserades som en egen disciplin. År 2023 började stora teknikföretag som OpenAI, Google, Microsoft och Anthropic anställa dedikerade promptingenjörer, där vissa tjänster erbjöd löner över 300 000 USD. Den globala marknaden för prompt engineering värderades till cirka 222,1 miljoner USD år 2023 och förväntas nå 2,06 miljarder USD till 2030, vilket motsvarar en betydande årlig tillväxttakt (CAGR). Denna snabba marknadstillväxt återspeglar den ökande insikten att prompt engineering inte är en tillfällig trend utan en grundläggande färdighet för organisationer som använder AI i stor skala. Disciplinen har utvecklats från enkelt trial-and-error till en sofistikerad praktik med etablerade tekniker, utvärderingsramverk och bästa praxis dokumenterade av ledande AI-forskningsinstitut och branschaktörer.

Effektiv prompt engineering bygger på flera grundläggande principer som särskiljer högkvalitativa prompts från ineffektiva. Specificitet är avgörande—ju mer detaljerad och beskrivande en prompt är, desto bättre kan AI-modellen förstå exakta krav och generera anpassade resultat. Istället för att be en AI att “skriva om hundar”, kan en specifik prompt vara “skapa en 300-ords veterinärguide om hälsoproblem hos golden retrievers, skriven för djurägare med åttondeklassnivå, med fokus på förebyggande vård.” Tillhandahållande av kontext är lika viktigt; att ge relevant bakgrund, exempel eller begränsningar hjälper modellen att fokusera och producera mer relevanta svar. Tydlighet säkerställer att instruktionerna är entydiga och direkt kommunicerar den önskade uppgiften utan att modellen behöver tolka vaga formuleringar. Iterativ förfining innebär att den första prompten sällan ger optimala resultat; framgångsrika promptingenjörer testar kontinuerligt varianter, analyserar resultat och justerar sin metod. Tonanpassning och stil innebär att specificera önskad röst, formalitetsnivå och presentationsformat så att resultaten överensstämmer med organisationens eller användarens förväntningar. Dessa principer gäller över alla AI-plattformar, oavsett om användare skapar prompts för ChatGPT, Perplexity, Claude eller Google AI Overviews, och gör dem universellt värdefulla för alla som vill optimera AI-interaktioner.

Inom prompt engineering har många sofistikerade tekniker utvecklats för att hantera olika uppgifter och komplexitetsnivåer. Zero-shot prompting är det mest direkta tillvägagångssättet och ger AI:n en tydlig instruktion eller fråga utan extra exempel eller kontext. Metoden fungerar bra för enkla uppgifter men kan ha svårt med komplexa resonemang. Few-shot prompting förbättrar prestandan genom att ge modellen ett eller flera exempel som visar önskat outputformat eller resonemangsmönster, vilket effektivt lär modellen genom demonstration. Chain-of-thought (CoT) prompting delar upp komplexa problem i mellanliggande resonemangs-steg, så att modellen får visa sitt arbete och förbättra noggrannheten vid flerstegsproblem. Prompt chaining delar upp en komplex uppgift i mindre, sekventiella deluppgifter där resultatet från en prompt används som indata till nästa, vilket ökar tillförlitligheten för komplicerade arbetsflöden. Tree-of-thought prompting generaliserar chain-of-thought genom att utforska flera möjliga resonemangsvägar samtidigt, så att modellen kan utvärdera olika tillvägagångssätt innan det mest lovande väljs. Maieutisk prompting innebär att modellen får förklara sitt resonemang, följt av följdfrågor för att utveckla särskilda delar av förklaringen, vilket hjälper till att identifiera och rätta inkonsekvenser. Generated knowledge prompting instruerar modellen att först ta fram relevanta fakta eller bakgrund innan huvuduppgiften löses, vilket ger användbar kontext. Self-refine prompting innebär att modellen löser ett problem, kritiserar sin egen lösning och sedan reviderar utifrån kritiken, tills tillfredsställande resultat nås. Varje teknik har sitt syfte, och den mest effektiva prompt engineering kombinerar ofta flera tekniker strategiskt anpassade till uppgiften.

| Teknik | Bäst för | Komplexitet | Typiskt användningsfall | Effektivitet |

|---|---|---|---|---|

| Zero-shot Prompting | Enkla, direkta uppgifter | Låg | Grundläggande frågor, tydliga instruktioner | Bra för enkla uppgifter, begränsad för komplext resonemang |

| Few-shot Prompting | Uppgifter som kräver formatkonsekvens | Medel | Innehållsgenerering, klassificering, formatering | Utmärkt för att visa önskade outputmönster |

| Chain-of-Thought | Flerstegsresonemang | Medel-hög | Matteproblem, logisk deduktion, analys | Förbättrar noggrannheten vid komplexa uppgifter avsevärt |

| Prompt Chaining | Komplexa arbetsflöden med beroenden | Hög | Flerstegs-innehållsskapande, databehandling | Utmärkt för att bryta ner komplexa problem |

| Tree-of-Thought | Problem med flera lösningsvägar | Hög | Strategisk planering, kreativ problemlösning | Överlägsen för att utforska alternativa tillvägagångssätt |

| Generated Knowledge | Uppgifter som kräver bakgrundskontext | Medel | Domänspecifika frågor, tekniska förklaringar | Förbättrar relevans och noggrannhet genom kontext |

| Self-Refine | Kvalitetskänsliga tillämpningar | Hög | Professionellt skrivande, teknisk dokumentation | Ger högsta outputkvalitet genom iteration |

För att förstå hur prompts påverkar AI-modellers beteende krävs grundläggande kunskap om hur stora språkmodeller (LLM) fungerar. Dessa modeller bearbetar text genom att dela upp den i tokens (små textenheter), för att sedan förutsäga mest sannolika nästa token baserat på mönster från träningen. Prompten fungerar som det initiala sammanhanget som formar alla efterföljande förutsägelser. När en prompt innehåller specifika instruktioner, exempel eller begränsningar, begränsar den effektivt sannolikhetsfördelningen för möjliga svar och styr modellen mot resultat som överensstämmer med promptens syfte. Temperature- och top-p sampling-parametrar påverkar ytterligare outputvariationen—lägre temperaturer ger mer deterministiska, fokuserade svar, medan högre temperaturer ökar kreativitet och variation. Kontextfönstret (hur mycket text modellen kan ta in) begränsar hur mycket information som kan ingå i en prompt; längre prompts tar upp mer av detta fönster, vilket kan minska utrymmet för själva uppgiften. Effektiva promptingenjörer förstår dessa tekniska begränsningar och utformar prompts som fungerar inom dem. För organisationer som övervakar varumärkessynlighet på AI-plattformar med verktyg som AmICited är förståelsen av dessa mekanismer avgörande, eftersom de prompts användare matar in avgör vilken information AI-systemen hämtar och citerar. En välkonstruerad prompt som ber en AI att “lista de tre främsta företagen inom molntjänster” ger andra resultat än “lista innovativa molnföretag grundade efter 2015”, vilket kan påverka vilka varumärken som syns i AI-genererade svar.

För att implementera effektiv prompt engineering i organisationer krävs att etablerade bästa praxis följs, utvecklade utifrån både akademisk forskning och branscherfarenhet. Börja enkelt och iterera är grundprincipen—börja med en enkel prompt och lägg gradvis till komplexitet, testa vid varje steg för att förstå vad som förbättrar resultatet. Var tydlig med kraven genom att klart ange önskat outputformat, längd, ton och eventuella begränsningar; vaga prompts ger vaga resultat. Ge relevant kontext utan att överbelasta modellen; inkludera bakgrundsinformation som hjälper modellen att förstå uppgiften men undvik onödiga detaljer som tar plats i kontextfönstret. Använd tydliga avgränsare som “###” eller “—” för att skilja olika sektioner av prompten (instruktioner, kontext, exempel), så modellen lättare kan tolka strukturen. Undvik negationer genom att ange vad du vill ha istället för vad du inte vill ha; istället för “var inte för formell”, ange “använd en samtalston”. Testa systematiskt flera varianter, ändra en sak i taget för att förstå vad som ger bättre resultat. Dokumentera framgångsrika prompts i ett centralt bibliotek, så att team kan återanvända och anpassa testade mallar. Övervaka prestandamått som noggrannhet, relevans, konsistens och användarnöjdhet för att objektivt bedöma om prompts når sina mål. Inkludera återkopplingsslingor där användarfeedback direkt används för att förfina prompts, vilket skapar en ständig förbättringscykel. Organisationer som tillämpar dessa metoder rapporterar betydande förbättringar i AI-outputens kvalitet och konsistens, vilket minskar tiden för manuella korrigeringar.

Relationen mellan prompt engineering och AI-synlighetsbevakning blir allt viktigare för organisationer som vill förstå hur deras varumärken, produkter och innehåll syns i AI-genererade svar. Plattformar som AmICited spårar varumärkesomnämnanden över ChatGPT, Perplexity, Google AI Overviews och Claude, men de prompts användare matar in i systemen avgör direkt vilken information AI hämtar och citerar. Organisationer som förstår prompt engineering kan skapa strategiska frågor för att upptäcka hur deras varumärke representeras, vilka konkurrenter som nämns samtidigt och om deras innehåll citeras korrekt. Exempelvis kan ett företag konstruera prompts som “Vilka är de bästa lösningarna för företagsdatamanagement?” för att se hur AI-system placerar deras erbjudanden jämfört med konkurrenter. Genom att analysera vilka prompts som ger gynnsamma eller ogynnsamma varumärkesomnämnanden kan organisationer utveckla innehållsstrategier som förbättrar deras synlighet i AI-genererade svar. Detta är ett nytt område inom sökmotoroptimering (SEO) och varumärkeshantering, där förståelsen för hur man kommunicerar med AI-system blir lika viktig som traditionell nyckelordsoptimering. Företag som investerar i prompt engineering-kompetens får strategiska fördelar i det AI-drivna informationslandskapet och säkerställer att deras varumärken syns och representeras korrekt.

Att mäta om en prompt verkligen är effektiv kräver tydliga, objektiva kriterier anpassade till affärsmålen. Noggrannhet mäter om outputen är faktamässigt korrekt, särskilt viktigt inom områden som hälsa, finans och juridik där fel kan få stora konsekvenser. Relevans bedömer hur väl svaret matchar användarens ursprungliga intention, ofta mätt med semantisk likhet eller manuell utvärdering. Konsistens utvärderar om identiska prompts ger liknande svar vid flera försök, avgörande för applikationer som kräver pålitligt, förutsägbart beteende. Fullständighet avgör om svaren täcker alla nödvändiga delar, mätt som andel täckta komponenter. Specificitet bedömer detaljnivån i svaren, viktigt för teknisk dokumentation och specialiserade områden. Läsbarhet och sammanhang mäter tydlighet och logiskt flöde, bedömt med läsbarhetsformler eller mänsklig utvärdering. Användarnöjdhet speglar hur nöjda slutanvändare är med output, vanligtvis insamlat via enkäter eller inbäddad feedback. Organisationer som använder omfattande utvärderingsramverk rapporterar att promptens effektivitet förbättras med 40–60 % genom systematisk mätning och förfining. Verktyg som Portkey, DSPy och Hugging Face’s Evaluate Library ger automatiska mått på dessa dimensioner, medan A/B-testningsplattformar möjliggör jämförelse av olika promptversioner. De mest avancerade organisationerna kombinerar flera utvärderingsmetoder och viktar måtten efter sina prioriteringar för att skapa ett samlat kvalitetsbetyg.

Arbetsmarknaden för promptingenjörer har vuxit explosionsartat, vilket speglar den avgörande betydelsen av denna kompetens i AI-eran. Enligt Glassdoor är medellönen för promptingenjörer cirka 123 274 USD per år 2025, med tjänster från 90 000 USD (25:e percentilen) till över 335 000 USD för specialroller på ledande AI-bolag som Anthropic. Indeed listar över 110 000 lediga promptingenjörstjänster, vilket visar på fortsatt efterfrågan i alla branscher. Stora teknikföretag som Google, Microsoft, Amazon och Meta rekryterar aktivt promptingenjörer med löner på 110 000–250 000 USD. AI-fokuserade företag som OpenAI, Anthropic, Cohere och Midjourney erbjuder utmanande arbetsuppgifter, fjärrarbete och betydande aktiepaket. Stora företag inom finans, vård, försäkring och andra reglerade sektorer anställer promptingenjörer för AI-integration, ofta med titlar som “AI Solutions Architect.” Konsultfirmor inklusive de fyra stora samt specialiserade företag som Booz Allen Hamilton utlyser tjänster upp till 212 000 USD för myndighets- och företagsprojekt. Frilansmöjligheter via plattformar som Upwork och Toptal ger 100–300 USD per timme för erfarna proffs. Karriärvägen kräver vanligen en kandidatexamen i datavetenskap eller närliggande område, men yrkesverksamma från skrivande, journalistik och kreativa fält har också lyckats ta sig in i prompt engineering-roller. Viktigast är dokumenterade färdigheter med AI-verktyg, en portfolio som visar prompt engineering-kompetens och kontinuerligt lärande i takt med att området utvecklas.

Prompt engineering står inför betydande utveckling i takt med att AI-tekniken avancerar och organisatoriska arbetssätt mognar. Multimodal prompting kommer i ökande grad att kombinera text, kod, bilder och andra datatyper i en och samma prompt, vilket kräver att ingenjörer förstår hur olika modaliteter samverkar i AI-system. Adaptiva prompts som automatiskt justeras utifrån kontext, användarbeteende och realtidsfeedback blir allt mer avancerade, från statiska mallar till dynamiska, responsiva system. Kontext engineering växer fram som en utveckling av prompt engineering och fokuserar på det bredare sammanhanget snarare än bara prompttexten. Etik- och rättvisefokuserad prompting kommer att bli viktigare när organisationer prioriterar ansvarsfull AI-användning, med prompts som explicit utformas för att minimera bias, säkerställa transparens och uppfylla regulatoriska krav. Integration med AI-agenter suddar ut gränsen mellan prompt engineering och bredare AI-orientering, när prompts blir komponenter i mer autonoma system. Rollen som “promptingenjör” kan utvecklas eller slås samman med angränsande roller som “AI-strateg”, “kontextingenjör” eller “AI-produktchef”, vilket speglar områdets mognad. Organisationer som investerar i prompt engineering-kompetens idag kommer att vara bäst positionerade i AI-ekonomin, eftersom förmågan att effektivt kommunicera med och styra AI-system blir alltmer central för konkurrenskraft. För företag som använder AmICited för att övervaka varumärkessynlighet i AI-svar blir prompt engineering-kunskap avgörande för att optimera sin närvaro i AI-söklandskapet och säkerställa korrekt representation på plattformar som ChatGPT, Perplexity, Google AI och Claude.

Prompt engineering skiljer sig fundamentalt från traditionell programmering: istället för att skriva explicit kod som direkt styr beteendet, vägleder promptingenjörer AI-modeller genom instruktioner i naturligt språk. Traditionell programmering kräver exakt syntax och logik, medan prompt engineering bygger på iterativ förfining, tillhandahållande av kontext och strategisk formulering för att styra AI-resultat mot önskade resultat. Båda kräver problemlösningsförmåga, men prompt engineering betonar kommunikation och experimenterande snarare än strikt kodsyntax.

Prompt engineering påverkar direkt hur varumärken syns i AI-genererade svar på plattformar som ChatGPT, Perplexity, Google AI Overviews och Claude. Välkonstruerade prompter kan påverka om och hur AI-system citerar, nämner eller rekommenderar varumärken. För organisationer som använder verktyg som AmICited för att bevaka AI-synlighet hjälper förståelse för prompt engineering till att förutsäga och optimera hur deras varumärke syns i AI-svar, vilket säkerställer korrekt representation och konkurrenskraftig positionering i AI-söklandskapet.

Viktiga tekniker inkluderar chain-of-thought-prompting (att bryta ner komplexa problem i steg), few-shot prompting (tillhandahålla exempel), zero-shot prompting (direkta instruktioner), prompt chaining (dela upp uppgifter i deluppgifter) och tree-of-thought prompting (utforska flera resonemangsvägar). Effektiviteten hos varje teknik beror på uppgiftens komplexitet, modellens kapacitet och önskad outputtyp. De mest framgångsrika implementationerna kombinerar flera tekniker anpassade till specifika användningsfall.

Promptens effektivitet mäts med hjälp av mått som noggrannhet (faktakorrekthet), relevans (överensstämmelse med syfte), konsistens (återupprepbarhet), fullständighet (täckning av nödvändiga element) och användarnöjdhet. Utvärderingsmetoder inkluderar manuell granskning, automatisk bedömning med verktyg som BLEU- och ROUGE-poäng, A/B-testning av olika promptversioner och insamling av direkt användarfeedback. Organisationer kombinerar ofta flera mått till ett viktat betyg som speglar deras specifika prioriteringar.

Promptingenjörer behöver starka kommunikations- och skrivfärdigheter, förståelse för hur stora språkmodeller fungerar, kännedom om AI-begrepp som tokenisering och kontextfönster samt kreativ problemlösningsförmåga. Tekniska kunskaper i Python, SQL eller JavaScript är ofta meriterande men inte alltid ett krav. Domänexpertis inom specifika branscher (hälso- och sjukvård, finans, juridik) ger högre ersättning. Viktigast är att framgångsrika promptingenjörer uppvisar kontinuerligt lärande och experimenterande.

Prompt engineering är avgörande för AI-bevakning eftersom de prompts användare matar in i AI-system avgör vilken information systemen hämtar och citerar. Genom att förstå prompt engineering kan organisationer skapa frågor som hjälper dem att upptäcka hur deras varumärke, innehåll eller domän syns i AI-svar. AmICited spårar dessa förekomster över flera AI-plattformar, vilket gör prompt engineering-kunskap oumbärlig för att optimera varumärkessynlighet i AI-genererat innehåll.

Arbetsmarknaden för promptingenjörer är fortsatt stark med genomsnittliga löner på cirka 123 274 USD per år enligt Glassdoor, med tjänster från 90 000 till över 335 000 USD beroende på erfarenhet och företag. Över 110 000 tjänster som promptingenjör är för närvarande lediga på jobbsajter. Yrket utvecklas från en specialiserad roll mot bredare AI-integrationsansvar, med möjligheter hos teknikbolag, företag, konsultfirmor och frilansplattformar. Distansarbete är vanligt, vilket gör geografisk placering mindre avgörande.

Prompt engineering förväntas utvecklas mot multimodal prompting (kombinera text, kod och bilder), adaptiva prompts som justeras efter kontext samt ökat fokus på AI-etik och rättvisa. När AI-modeller blir mer kapabla kan prompt engineering smälta samman med bredare AI-strategi- och kontext engineering-roller. Området kommer sannolikt att betona ansvarsfull AI-användning, bias-minimering och säkerställande av transparens i AI-genererade resultat över plattformar som övervakas av AmICited.

Börja spåra hur AI-chatbotar nämner ditt varumärke på ChatGPT, Perplexity och andra plattformar. Få handlingsbara insikter för att förbättra din AI-närvaro.

Lär dig vad prompt engineering är, hur det fungerar med AI-sökmotorer som ChatGPT och Perplexity, och upptäck viktiga tekniker för att optimera dina AI-sökresul...

Lär dig hur prompt engineering förbättrar GEO-strategin så att ditt varumärke citeras av AI-sökmotorer som ChatGPT, Perplexity och Google AI Overviews.

Diskussion i communityt om marknadsförare behöver färdigheter i prompt engineering för att optimera för AI-sök. Förståelse för hur användare ställer frågor till...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.