Förutseende av Frågor

Lär dig hur Förutseende av Frågor hjälper ditt innehåll att fånga utökade AI-konversationer genom att ta upp uppföljande frågor. Upptäck strategier för att iden...

Förfining av sökfrågor är processen att förbättra och optimera sökfrågor genom iterativa justeringar, förtydliganden och utökningar för att generera mer exakta, relevanta och heltäckande resultat från AI-sökmotorer och informationsåtervinningssystem. Det innebär att bryta ner komplexa användarfrågor i underfrågor, lägga till kontextuella detaljer och utnyttja feedback-loopar för att stegvis förbättra sökprestanda och resultatkvalitet.

Förfining av sökfrågor är processen att förbättra och optimera sökfrågor genom iterativa justeringar, förtydliganden och utökningar för att generera mer exakta, relevanta och heltäckande resultat från AI-sökmotorer och informationsåtervinningssystem. Det innebär att bryta ner komplexa användarfrågor i underfrågor, lägga till kontextuella detaljer och utnyttja feedback-loopar för att stegvis förbättra sökprestanda och resultatkvalitet.

Förfining av sökfrågor är en iterativ process för att förbättra och optimera sökfrågor genom systematiska justeringar, förtydliganden och utökningar för att generera mer exakta, relevanta och heltäckande resultat från informationsåtervinningssystem och AI-sökmotorer. Istället för att betrakta användarens initiala sökning som slutlig, erkänner förfining av sökfrågor att användare ofta behöver modifiera, utöka eller förtydliga sina frågor för att hitta exakt det de söker. Denna process innebär att analysera hur användare ändrar sina sökningar, föreslå förbättrade frågeformuleringar och använda feedback-loopar för att stegvis förbättra sökprestandan. I kontexten av moderna AI-sökmotorer som ChatGPT, Perplexity, Google AI Overviews och Claude har förfining av sökfrågor blivit en grundläggande mekanism för att leverera heltäckande, mångsidiga svar på komplexa användarfrågor. Tekniken omvandlar sökning från en enda, statisk interaktion till en dynamisk, flerstegs-konversation där varje förfining för användaren närmare den önskade informationen.

Förfining av sökfrågor är inget nytt i informationsåtervinning, men tillämpningen har utvecklats dramatiskt i takt med framväxten av artificiell intelligens och stora språkmodeller. Historiskt förlitade sig sökmotorer främst på nyckelordsmatchning, där en användares fråga jämfördes direkt med indexerade dokument. Om du sökte efter “löparskor” visade motorn dokument som innehöll just de orden, oavsett kontext eller användarens avsikt. Detta tillvägagångssätt var stelt och gav ofta irrelevanta resultat eftersom det ignorerade mänskliga språkets nyanser och användarens komplexa behov.

Utvecklingen mot förfining av sökfrågor inleddes med introduktionen av förslagsfunktioner för frågor i början av 2000-talet, där sökmotorer började analysera användarbeteenden för att föreslå relaterade eller förfinade frågor. Googles “Menade du?"-funktion och autokomplettering var tidiga exempel på detta. Dessa system var dock relativt enkla och baserades främst på historiska frågeloggar och frekvensanalys. De saknade den semantiska förståelse som krävs för att verkligen förstå användarens avsikt eller relationen mellan olika frågeformuleringar.

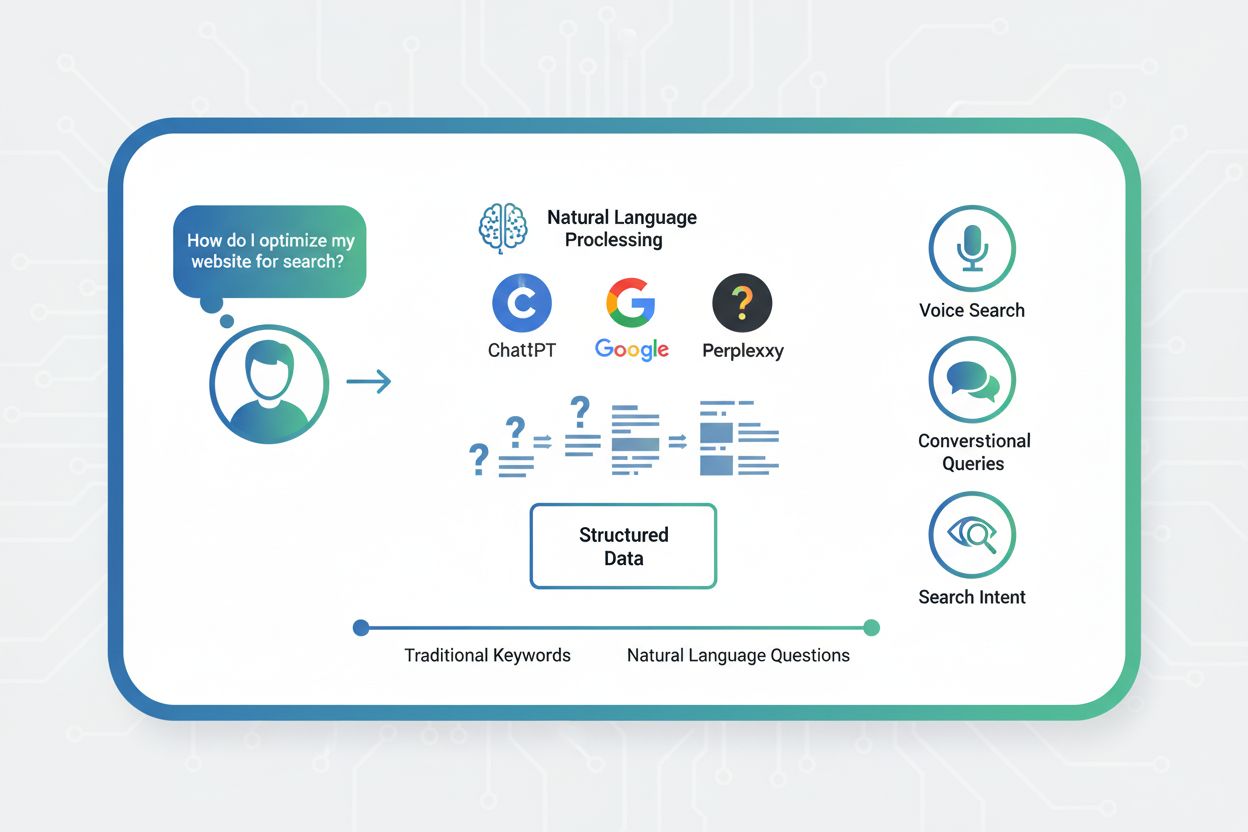

Introduktionen av naturlig språkbehandling (NLP) och maskininlärning förändrade förfining av sökfrågor i grunden. Moderna system kan nu förstå att “bästa vattentäta löparskor” och “topprankade regntåliga träningsskor” i grunden är samma fråga, trots att de använder helt olika termer. Denna semantiska förståelse gör det möjligt för systemen att känna igen frågevariationer, identifiera underförstådda behov och föreslå förfiningar som verkligen förbättrar sökresultaten. Enligt forskning från Kopp Online Marketing SEO Research Suite har metoderna för förfining av sökfrågor blivit allt mer sofistikerade, och systemen kan nu generera syntetiska frågor (konstgjorda frågor som simulerar riktiga användarsökningar) för att förbättra träningsdata och höja återvinningsnoggrannheten.

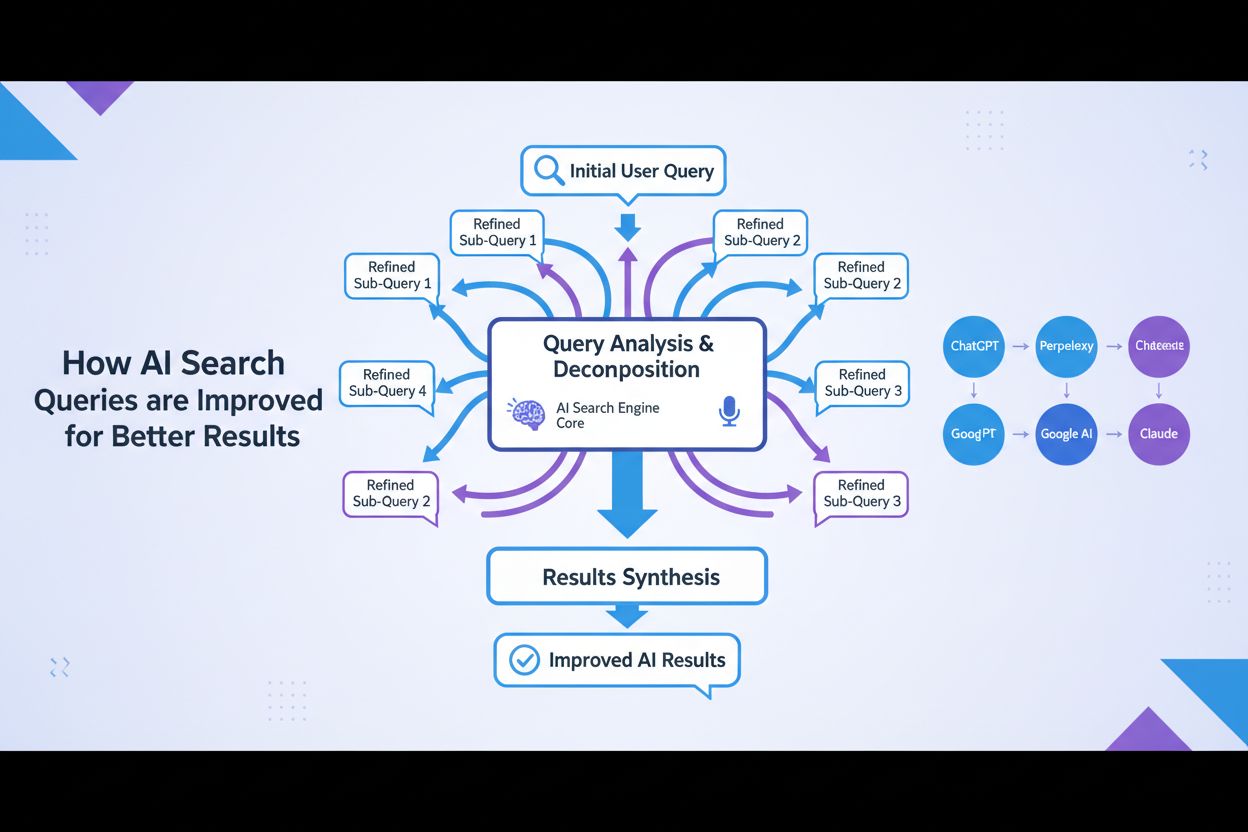

Framväxten av generativ AI och stora språkmodeller har ytterligare accelererat denna utveckling. Moderna AI-sökmotorer nöjer sig inte med att förfina frågor; de delar upp dem i flera underfrågor, kör dessa parallellt över olika datakällor och syntetiserar resultaten till heltäckande svar. Detta innebär en grundläggande förskjutning från förfining av sökfrågor som en användarstyrd funktion till att vara en kärnkomponent i AI-söksystemens arkitektur.

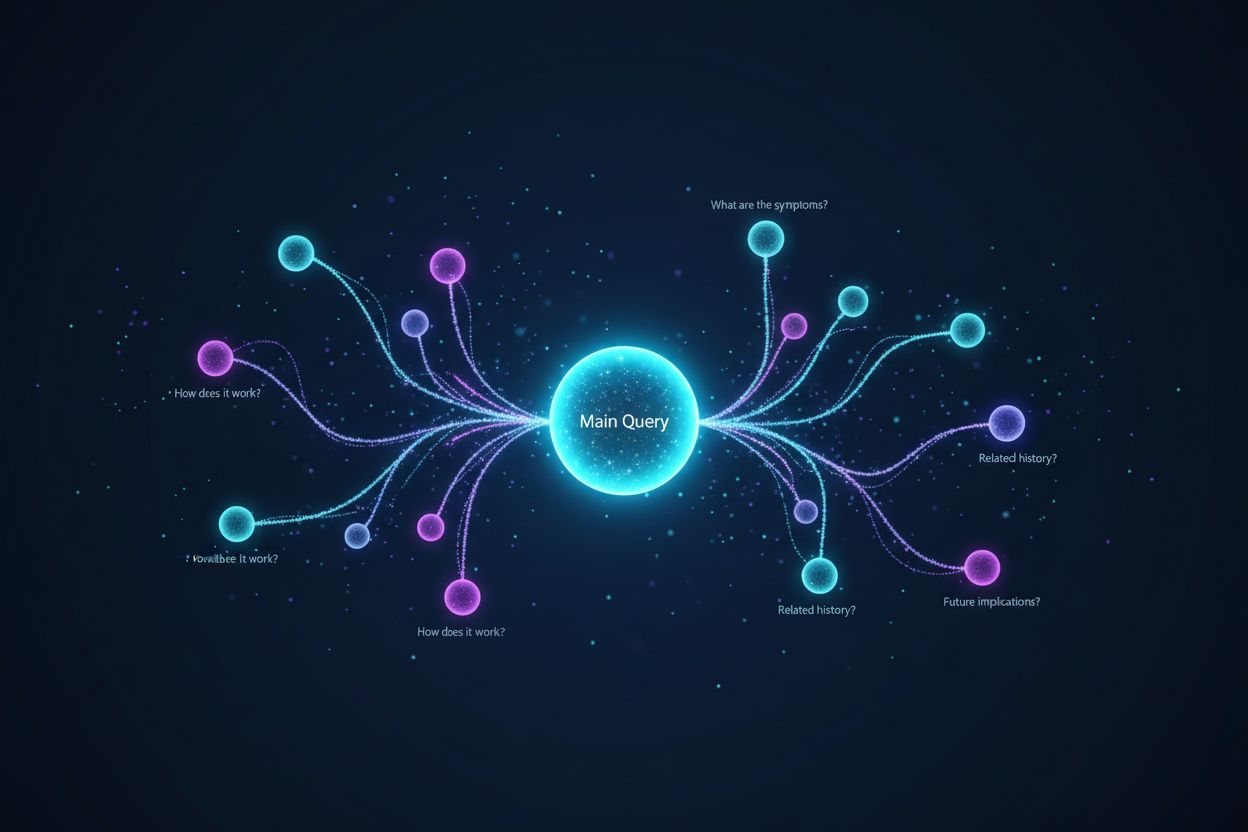

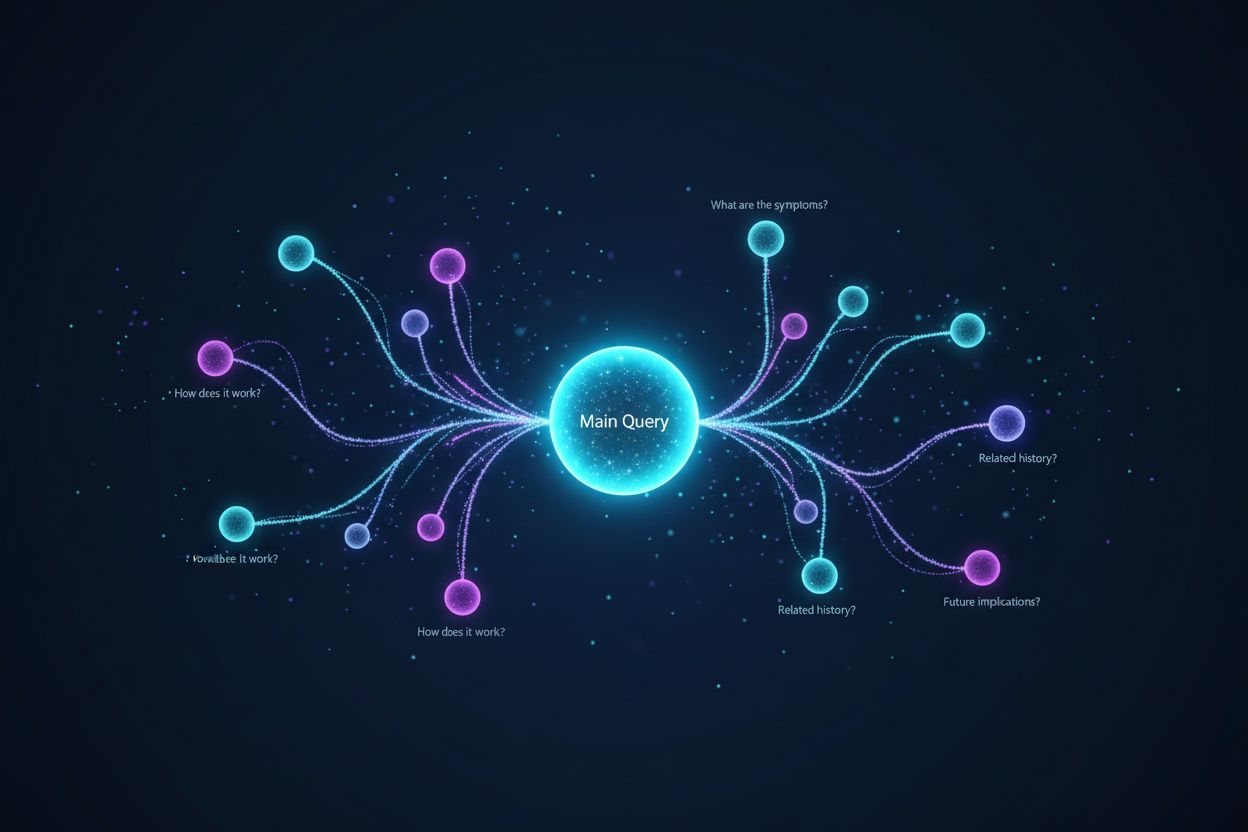

Förfining av sökfrågor sker via flera sammankopplade tekniska mekanismer som samverkar för att förbättra sökkvaliteten. Den första mekanismen är frågeanalys och avsiktsdetektion, där systemet bearbetar användarens ursprungliga fråga för att identifiera underliggande avsikt, komplexitetsnivå och vilken typ av svar som behövs. Avancerade NLP-modeller analyserar faktorer som frågelängd, terminologisk specificitet och kontextuella signaler för att avgöra om enkel nyckelordsmatchning räcker eller om mer sofistikerad förfining krävs. Till exempel kan en enkel faktabaserad fråga som “Tysklands huvudstad” inte utlösa omfattande förfining, medan en komplex fråga som “bästa praxis för att optimera innehåll för AI-sökmotorer” aktiverar heltäckande förfiningsprocesser.

Den andra mekanismen är frågedecomposition och fan-out, en teknik där komplexa frågor delas upp i flera underfrågor. Denna process, känd som query fan-out, är särskilt viktig i AI-söksystem. När en användare frågar “Vilka är de bästa vattentäta löparskorna för någon med platta fötter som springer i terräng?”, delar systemet upp detta i flera underfrågor: en som utforskar produktlistor, en annan som undersöker expertrecensioner, en som analyserar användarupplevelser och en som granskar tekniska specifikationer. Dessa underfrågor körs sedan samtidigt över olika datakällor, inklusive webben, kunskapsgrafer och specialiserade databaser. Denna parallellkörning utökar avsevärt informationsmängden för syntes, vilket möjliggör mer heltäckande och nyanserade svar från AI.

Den tredje mekanismen är frågeaugmentation, vilket innebär att generera ytterligare frågor för att förbättra sökprestandan. Enligt forskning från Kopp Online Marketing SEO Research Suite använder frågeaugmentation flera metoder: historisk dataanalys (granskning av tidigare förfiningar i användarens sökhistorik), n-gram-substitution (modifiering av frågor genom att byta ut intilliggande ordsekvenser), entitetsassociation (identifiera entiteter från sökresultat och kombinera dem med ursprungliga frågevillkor) och syskonfrågeidentifiering (hitta relaterade frågor som delar samma ursprungsfråga). Dessa augmentationstekniker säkerställer att systemet undersöker flera vinklar och perspektiv på användarens informationsbehov.

Den fjärde mekanismen är feedback-loopar och kontinuerlig förbättring, där användarinteraktioner med sökresultaten informerar förfiningsprocessen. När användare klickar på vissa resultat, spenderar tid på specifika sidor eller omformulerar sina frågor, återförs denna data till systemet för att förbättra framtida förfiningar. Förstärkningsinlärning kan tillämpas för att optimera generativa modeller och förbättra kvaliteten på frågevarianter över tid baserat på tillfredsställande svar. Detta skapar en positiv spiral där varje användarinteraktion gör systemet smartare och mer effektivt på att förfina frågor.

| Aspekt | Google AI Overviews | ChatGPT | Perplexity | Claude |

|---|---|---|---|---|

| Primär förfiningsmetod | Query fan-out med tematisk sökning | Konversationell, flerstegs-förfining | Interaktiva frågeförslag med följdfrågor | Kontextuell förtydligande genom dialog |

| Generering av underfrågor | Automatisk uppdelning baserat på avsikt | Användarstyrd via samtal | Föreslagna förfiningar visas som piller | Underförstådd genom kontextförståelse |

| Datakällor | Webb, kunskapsgrafer, shoppinggrafer | Träningsdata + webbsök (med plugins) | Realtidswebbsökning över flera källor | Träningsdata med webbsöksförmåga |

| Citeringsmekanism | Direkt källhänvisning i översikten | Länkreferenser i svaren | Källkort med detaljerad attribution | Inbäddade citat med källhänvisningar |

| Användarkontroll | Begränsad (systemstyrd förfining) | Hög (användaren styr samtalet) | Medel (föreslagna förfiningar + anpassad input) | Hög (användaren kan be om specifika förfiningar) |

| Förfiningssynlighet | Underförstådd (användaren ser syntetiserat svar) | Tydlig (användaren ser samtalshistorik) | Tydlig (förfiningsförslag synliga) | Underförstådd (förfining via dialog) |

| Hastighet på förfining | Omedelbar (parallell bearbetning) | Sekventiell (tur-för-tur) | Omedelbar (realtidssökning) | Sekventiell (samtalsbaserat) |

| Personalisering | Hög (baserat på sökhistorik & plats) | Medel (baserat på samtalskontext) | Medel (baserat på sessionsdata) | Medel (baserat på samtalskontext) |

Processen för förfining av sökfrågor i dagens AI-sökmotorer följer ett sofistikerat, flerstegs-arbetsflöde som skiljer sig avsevärt från traditionell sökning. När en användare skickar en fråga till ett system som Google AI Mode eller ChatGPT, söker systemet inte direkt efter resultat. Istället analyseras frågan först med avancerad naturlig språkbehandling för att förstå vad användaren egentligen frågar efter. Denna analys tar hänsyn till faktorer som användarens sökhistorik, plats, enhetstyp och frågans komplexitet. Systemet avgör om frågan är enkel (kräver endast nyckelordsmatchning) eller komplex (kräver uppdelning och flerkällsyntes).

För komplexa frågor aktiveras query fan-out-processen. Detta innebär att den ursprungliga frågan delas upp i flera relaterade underfrågor som utforskar olika aspekter av användarens informationsbehov. Om en användare till exempel frågar “Hur ska jag optimera min webbplats för AI-sökmotorer?”, kan systemet generera underfrågor som: “Vilka är de viktigaste rankningsfaktorerna för AI-sökmotorer?”, “Hur utvärderar AI-system innehållskvalitet?”, “Vad är E-E-A-T och varför är det viktigt för AI?”, “Hur strukturerar jag innehåll för AI-citat?” och “Vilka är de bästa praxis för AI-vänlig innehållsformatering?”. Var och en av dessa underfrågor körs parallellt över olika datakällor och hämtar olika typer av information som svarar mot olika aspekter av den ursprungliga frågan.

Systemet utvärderar sedan den hämtade informationen med hjälp av kvalitetssignaler som domänauktoritet, innehållets aktualitet, tematisk relevans och citeringsmönster. Information från flera källor kombineras och syntetiseras till ett sammanhängande, heltäckande svar som direkt adresserar den ursprungliga frågan. Under hela processen identifierar systemet de mest auktoritativa och relevanta källorna, som sedan presenteras som citat eller referenser i det slutliga svaret. Det är därför förståelse för förfining av sökfrågor är kritiskt för AmICited-användare – de källor som syns i AI-genererade svar avgörs till stor del av hur väl de stämmer överens med de förfinade underfrågor som AI-systemet genererar.

Sambandet mellan förfining av sökfrågor och synlighet i AI Overviews är direkt och mätbart. Forskning visar att över 88 % av sökningarna som utlöser AI Overviews har informationssyfte, vilket innebär att användarna vill lära sig något snarare än genomföra ett köp eller navigera till en specifik webbplats. Dessa informationsfrågor är just de som mest sannolikt förfinas omfattande, eftersom de ofta kräver syntes från flera källor för att ge ett komplett svar. När ditt innehåll överensstämmer med de förfinade underfrågor som ett AI-system genererar har din webbplats avsevärt högre chans att bli citerad som källa.

Data är övertygande: att bli utvald som källa i en AI Overview ökar klickfrekvensen från 0,6 % till 1,08 %, vilket nästan fördubblar trafiken jämfört med att bara synas i traditionella sökresultat under översikten. Detta gör förståelse för förfining av sökfrågor avgörande för modern SEO-strategi. Istället för att optimera för ett enskilt nyckelord måste innehållsskapare nu tänka på hur deras innehåll svarar mot de olika förfinade frågor som ett AI-system kan generera. Om du till exempel skriver om “hållbart mode” bör du förutse att ett AI-system kan förfina detta till underfrågor som “miljöpåverkan av fast fashion”, “etiska tillverkningsmetoder”, “hållbara material”, “rättvisemärkningar” och “prisvärda hållbara varumärken”. Ditt innehåll bör heltäckande adressera dessa förfinade vinklar för att maximera citeringspotentialen.

Dessutom indikerar forskning att ungefär 70 % av användarna bara läser den första tredjedelen av AI Overviews, vilket innebär att det är mycket mer värdefullt att bli citerad tidigt i svaret än senare. Det innebär att innehållsskapare bör strukturera sin information med de viktigaste, sammanfattande svaren överst, i ett tydligt och citerbart format. Målet är att bli en källa som AI-systemet “måste” citera för att ge ett trovärdigt och heltäckande svar på de förfinade frågor det genererar.

Effektiv förfining av sökfrågor kräver förståelse och tillämpning av flera viktiga tekniker. Den första tekniken är tillägg av kontextuella detaljer, där användare eller system lägger till specifik kontext för att göra frågorna mer precisa. Istället för att söka efter “löparskor” kan en förfinad fråga vara “bästa vattentäta löparskor för kvinnor med höga fotvalv under 1 500 kr.” Denna extra kontext hjälper AI-system att förstå de specifika begränsningar och preferenser som är viktiga för användaren, vilket möjliggör mer riktad informationshämtning. För innehållsskapare innebär detta att förutse dessa kontextuella förfiningar och skapa innehåll som adresserar specifika användarfall, målgrupper och begränsningar.

Den andra tekniken är specificering av begränsningar, där användaren definierar gränser eller villkor för sin sökning. Det kan handla om prisspann, geografiska platser, tidsramar eller kvalitetsnivåer. AI-system känner av dessa begränsningar och förfinar sökningen därefter. Exempelvis innehåller en fråga om “bästa projektledningsverktyg för distansteam med färre än 50 anställda” flera begränsningar som bör styra innehållsskapandet. Ditt innehåll bör tydligt adressera sådana begränsningsscenarier för att öka chansen att bli citerad.

Den tredje tekniken är uppföljande frågor, där användare ställer förtydligande frågor för att förfina sin förståelse. I konversationella AI-system som ChatGPT kan användare fråga “Kan du förklara det enklare?” eller “Hur gäller det småföretag?” Dessa följdfrågor utlöser förfining av sökfrågor, där systemet justerar sitt tillvägagångssätt baserat på användarens feedback. Det är därför konversationsdjup och förmågan att täcka flera vinklar på ett ämne blir allt viktigare för synlighet.

Den fjärde tekniken är frågedecomposition, där komplexa frågor delas upp i enklare delkomponenter. Detta är särskilt viktigt för AI-system, som använder denna teknik för att säkerställa heltäckande täckning av ett ämne. Om en användare frågar “Vilka är bästa praxis för att optimera e-handelswebbplatser för AI-sökmotorer?”, kan ett AI-system dela upp det i: “Vad är AI-sökmotorer?”, “Hur rankar AI-system e-handelsinnehåll?”, “Vilka tekniska optimeringar är viktiga?”, “Hur ska produktbeskrivningar struktureras?” och “Vilken roll spelar användargenererat innehåll?”. Innehåll som heltäckande täcker dessa delkomponenter har större chans att bli citerat i flera förfinade frågor.

Generative Engine Optimization (GEO), även känt som Large Language Model Optimization (LLMO), handlar i grunden om att förstå och optimera för processerna kring förfining av sökfrågor. Traditionell SEO fokuserade på ranking för specifika nyckelord; GEO fokuserar på att bli citerad som källa i de förfinade frågor som AI-system genererar. Detta innebär ett paradigmskifte i hur innehållsskapare bör arbeta med sökoptimering.

I GEO-kontexten är förfining av sökfrågor inte något som händer med ditt innehåll – det är något du måste förutse och förbereda dig för. När du skapar innehåll bör du tänka på alla sätt som ett AI-system kan förfina eller dela upp ditt ämne i underfrågor. Om du till exempel skriver om “hållbart mode”, bör du skapa innehåll som adresserar: miljöpåverkan av konventionellt mode, hållbara material och deras egenskaper, etisk tillverkning och arbetsvillkor, certifieringar och standarder, kostnadsaspekter, varumärkesrekommendationer och hur man byter till hållbart mode. Genom att heltäckande adressera dessa vinklar ökar du chansen att bli citerad i flera AI-genererade svar.

Forskning från Elementors AI SEO-statistik 2026 visar att AI-söktrafiken ökade med 527 % år över år, och vissa webbplatser rapporterar nu att över 1 % av totaltrafiken kommer från plattformar som ChatGPT, Perplexity och Copilot. Denna explosiva tillväxt understryker vikten av att förstå förfining av sökfrågor. Trafiken från AI-plattformar är också betydligt mer värdefull – AI-hänvisade besökare är värda 4,4x mer än traditionella organiska sökbesökare, med 27 % lägre avvisningsfrekvens och 38 % längre sessionstid för detaljhandelssajter. Det innebär att optimering för förfining av sökfrågor inte bara handlar om synlighet; det handlar om att driva högkvalitativ, konverteringsklar trafik.

Framtiden för förfining av sökfrågor rör sig mot allt mer sofistikerade, personliga och autonoma system. Syntetisk frågegeneration blir allt mer avancerad, där AI-system kan generera olika, kontextuellt lämpliga frågor som simulerar verkliga användarsökningar. Dessa syntetiska frågor är avgörande för att träna AI-system att hantera nya eller sällsynta frågor genom att utnyttja inlärda mönster och kontextuell information. I takt med att AI-system blir mer kapabla kommer de att generera allt mer nyanserade och specifika underfrågor, vilket kräver att innehållsskapare tänker ännu djupare kring olika vinklar och perspektiv på sina ämnen.

En annan framväxande trend är stateful query refinement, där AI-system bibehåller kontext över flera samtalsomgångar, vilket möjliggör mer sofistikerad förfining baserat på användarens föränderliga behov och preferenser. Istället för att behandla varje fråga som oberoende, förstår dessa system hur frågor relaterar till tidigare interaktioner, vilket möjliggör mer personlig och kontextuellt lämplig förfining. Detta har betydelse för innehållsstrategi – ditt innehåll bör vara strukturerat för att stödja flerstegskonversationer där användare successivt förfinar sin förståelse.

Integreringen av förstärkningsinlärning i förfiningssystem är också betydelsefull. Dessa system kan lära sig av användarfeedback för att kontinuerligt förbättra kvaliteten på förfiningarna över tid. Om användare konsekvent klickar på vissa källor eller spenderar mer tid på specifika sidor lär sig systemet att prioritera dessa källor i framtida förfiningar. Detta skapar en konkurrensfördel för innehållsskapare som konsekvent levererar högkvalitativ, auktoritativ information – de blir de “självklara” källorna som AI-systemen lär sig att citera.

Vidare antyder framväxten av AI-agenter och autonoma söksystem att förfining av sökfrågor kommer att bli än mer avancerad. Istället för att användare manuellt förfinar frågor kommer AI-agenter att autonomt generera och exekvera förfinade frågor å användarens vägnar och utforska informationsrymder heltäckande för att besvara komplexa frågor. Det innebär att innehållsskapare måste säkerställa att deras innehåll är upptäckbart inte bara för mänskliga sökare utan även för autonoma AI-agenter som systematiskt utforskar och förfinar frågor på nätet.

Konkurrenslandskapet förändras också. I takt med att fler plattformar implementerar förfiningsfunktioner blir förmågan att synas i förfinade frågor en avgörande konkurrensfördel. AmICited-användare som förstår och övervakar sin närvaro bland förfinade frågor i olika AI-plattformar kommer ha ett

Förfining av sökfrågor fokuserar på att förbättra relevansen och noggrannheten i sökresultaten genom att justera eller föreslå frågor baserat på användarens kontext och historiska data, med målet att tillhandahålla mer exakt information. Utökning av sökfrågor, däremot, innebär att generera ytterligare frågor för att förbättra sökmotorns prestanda genom att ta itu med problem som dåligt formulerade ursprungliga frågor eller irrelevanta resultat. Medan förfining förbättrar en befintlig fråga, skapar utökning flera relaterade frågor för att bredda sökomfånget. Båda teknikerna arbetar tillsammans i moderna AI-söksystem för att förbättra kvaliteten på informationsåtervinning.

AI-sökmotorer använder förfining av sökfrågor genom en process som kallas query fan-out, där en enskild användarfråga delas upp i flera underfrågor som körs samtidigt över olika datakällor. Till exempel kan en komplex fråga om 'bästa vattentäta löparskor för platta fötter' brytas ner i underfrågor som utforskar produktlistor, expertrecensioner, användarupplevelser och tekniska specifikationer. Denna parallella informationshämtning från olika källor utökar avsevärt informationsmängden som finns tillgänglig för svarssyntes, vilket gör det möjligt för AI att ge mer heltäckande och exakta svar.

Naturlig språkbehandling är grundläggande för förfining av sökfrågor eftersom den gör det möjligt för AI-system att tolka mening utöver enkel nyckelords-matchning. NLP använder mönster och kontextuella relationer mellan ord för att tyda hur människor talar, vilket gör sökningar mer intuitiva och exakta. Till exempel gör NLP att ett system kan förstå att 'öppna kaféer' betyder företag som för närvarande har öppet och finns i närheten, inte bara dokument som innehåller exakt de orden. Denna kontextuella förståelse är det som gör att moderna AI-system kan förfina frågor intelligent och ge resultat som matchar användarens avsikt snarare än bara bokstavliga nyckelord.

Förfining av sökfrågor förbättrar synligheten i AI Overviews genom att hjälpa innehållsskapare att förstå hur användare ändrar sina sökningar för att hitta bättre resultat. Genom att rikta in sig på både ursprungliga och förfinade frågor med heltäckande innehåll som förutser användarbehov och följdfrågor kan webbplatser öka sina chanser att bli citerade som källor. Forskning visar att att visas som källa i en AI Overview ökar klickfrekvensen från 0,6 % till 1,08 %, vilket gör förståelse av förfining av sökfrågor avgörande för modern SEO-strategi och synlighet i AI-citat.

Syntetiska frågor är konstgjort genererade frågor som skapas av stora språkmodeller och som simulerar verkliga användarsökningar. De är avgörande för förfining av sökfrågor eftersom de utökar märkt träningsdata, förbättrar recall och möjliggör generativ informationshämtning i stor skala genom att fylla i dataluckor. Syntetiska frågor genereras genom att granska strukturerad data, analysera dokumenttitlar och ankartexter samt använda strukturerade regeluppsättningar. De hjälper AI-system att förstå och förfina frågor genom att tillhandahålla olika exempel på hur användare kan formulera liknande informationsbehov, vilket i slutändan förbättrar systemets förmåga att effektivt förfina och utöka användarfrågor.

Företag kan optimera för förfining av sökfrågor genom att analysera data från Google Search Console för att identifiera relaterade nyckelord och frågevariationer som användare söker efter i följd. De bör skapa heltäckande innehåll som adresserar både initiala breda frågor och förfinade, specifika varianter. Genom att använda verktyg som seoClarity eller liknande plattformar kan företag hämta data om förfiningar och autosuggest för att hitta relevanta frågevariationer för nyckelordsforskning. Dessutom hjälper övervakning av ranking efter förfining av frågor och spårning av hur olika facetterade sidor presterar till att styra beslut om innehållsstrategi och teknisk implementering.

Förfining av sökfrågor är nära kopplat till användarens avsikt eftersom det avslöjar hur användares informationsbehov utvecklas under deras sökresa. Genom att analysera mönster i förfining av frågor kan företag förstå vad användare egentligen letar efter i varje steg i deras beslutsprocess. Till exempel kan en användare börja med bred avsikt ('löparskor') och successivt förfina till mer specifik avsikt ('bästa vattentäta löparskor för platta fötter'). Att förstå dessa förfiningsmönster gör det möjligt för innehållsskapare att utveckla riktat innehåll för varje steg i användarresan, vilket i slutändan förbättrar både synlighet i sökningar och konverteringsgrader.

Börja spåra hur AI-chatbotar nämner ditt varumärke på ChatGPT, Perplexity och andra plattformar. Få handlingsbara insikter för att förbättra din AI-närvaro.

Lär dig hur Förutseende av Frågor hjälper ditt innehåll att fånga utökade AI-konversationer genom att ta upp uppföljande frågor. Upptäck strategier för att iden...

Frågebaserad sökning är naturliga språkfrågor formulerade som frågor. Lär dig hur detta skifte påverkar AI-övervakning, varumärkesexponering och modern SEO-stra...

Lär dig hur du forskar och övervakar AI-sökfrågor över ChatGPT, Perplexity, Claude och Gemini. Upptäck metoder för att spåra varumärkesomnämnanden och optimera ...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.