JavaScript SEO

JavaScript SEO optimerar JavaScript-renderade webbplatser för sökmotorers crawling och indexering. Lär dig bästa praxis, renderingsmetoder och strategier för at...

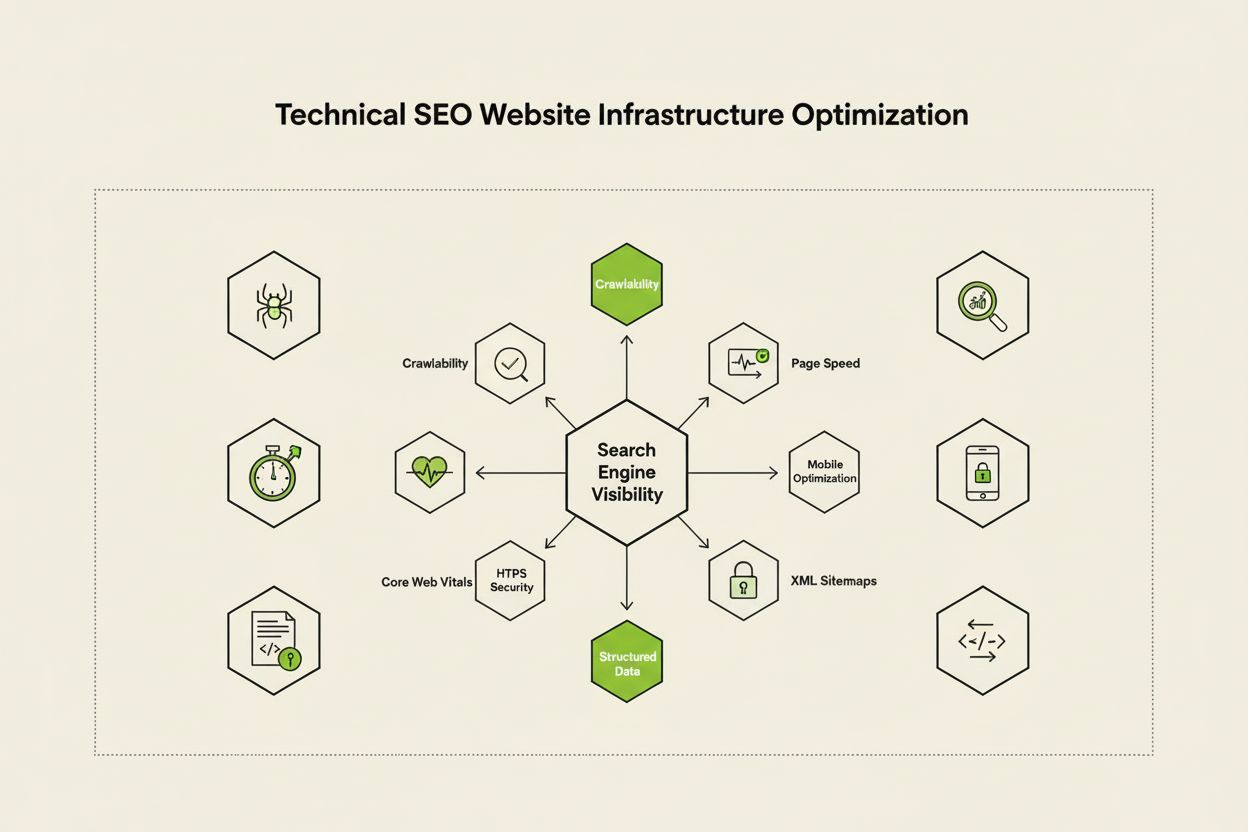

Teknisk SEO är processen att optimera en webbplats infrastruktur så att sökmotorer kan genomsöka, rendera, indexera och leverera innehåll korrekt och effektivt. Det omfattar webbplatshastighet, mobilvänlighet, webbplatsarkitektur, säkerhet och implementering av strukturerad data för att säkerställa att sökmotorer kan upptäcka och ranka dina sidor.

Teknisk SEO är processen att optimera en webbplats infrastruktur så att sökmotorer kan genomsöka, rendera, indexera och leverera innehåll korrekt och effektivt. Det omfattar webbplatshastighet, mobilvänlighet, webbplatsarkitektur, säkerhet och implementering av strukturerad data för att säkerställa att sökmotorer kan upptäcka och ranka dina sidor.

Teknisk SEO är processen att optimera en webbplats backend-infrastruktur för att säkerställa att sökmotorer effektivt kan genomsöka, rendera, indexera och leverera innehåll korrekt. Till skillnad från on-page SEO, som fokuserar på innehållskvalitet och nyckelordsoptimering, adresserar teknisk SEO de grundläggande element som avgör om sökmotorer ens kan komma åt och förstå din webbplats. Detta inkluderar webbplatshastighet, mobilresponsivitet, webbplatsarkitektur, säkerhetsprotokoll, implementering av strukturerad data och crawlability-faktorer. Teknisk SEO fungerar som den osynliga grunden som alla andra SEO-insatser vilar på – utan den förblir även det högkvalitativa innehållet osynligt för sökmotorer och användare. Enligt branschundersökningar uppgav 91 % av marknadsförare att SEO förbättrade webbplatsens prestanda under 2024, där teknisk optimering spelade en avgörande roll för att uppnå mätbara resultat. Betydelsen av teknisk SEO har ökat i takt med att sökmotorer blivit mer sofistikerade och AI-drivna sökplattformar har dykt upp, vilket kräver att webbplatser möter allt strängare tekniska krav för synlighet.

Teknisk SEO vilar på fyra sammankopplade pelare som samverkar för att maximera synligheten i sökmotorer. Crawlability avgör om Googlebot och andra sökmotorsrobotar kan komma åt din webbplats sidor via länkar, sitemaps och interna navigationsstrukturer. Indexerbarhet säkerställer att genomsökta sidor faktiskt lagras i Googles index och kan visas i sökresultat. Prestanda och Core Web Vitals mäter hur snabbt sidor laddar och hur responsiva de är för användarinteraktioner – faktorer som direkt påverkar ranking och användarupplevelse. Mobiloptimering säkerställer att din webbplats fungerar felfritt på smartphones och surfplattor, som nu står för över 60 % av all söktrafik enligt Sistrix forskning. Dessa fyra pelare är ömsesidigt beroende; svaghet inom ett område kan underminera de andras effektivitet. Till exempel kommer en snabbladdad desktopsajt som fungerar dåligt på mobil att ha svårt att ranka i Googles mobilförsta index, oavsett hur väl crawlability är optimerat. Att förstå hur dessa pelare samverkar är avgörande för att utveckla en heltäckande teknisk SEO-strategi som adresserar alla aspekter av synlighet i sökmotorer.

Även om de ofta förväxlas representerar crawlability och indexerbarhet två distinkta steg i sökmotorns pipeline. Crawlability syftar på sökmotorns förmåga att upptäcka och komma åt din webbplats sidor genom att följa interna länkar, externa bakåtlänkar och XML-sitemaps. Det besvarar frågan: “Kan Googlebot nå denna sida?” Om en sida inte är crawlbar – kanske på grund av att den blockeras av robots.txt, döljs bakom JavaScript eller är föräldralös utan interna länkar – kan den inte gå vidare till indexeringssteget. Indexerbarhet, däremot, avgör om en genomsökt sida faktiskt lagras i Googles index och kan visas i sökresultat. En sida kan vara helt crawlbar men ändå inte indexeras om den innehåller en noindex-metatag, har duplicerat innehåll eller inte uppfyller Googles kvalitetskrav. Enligt Search Engine Lands omfattande guide om teknisk SEO är det avgörande att förstå denna skillnad, eftersom lösningar på crawlability-problem skiljer sig från lösningar på indexeringsproblem. Crawlability-problem rör oftast webbplatsstruktur, robots.txt-konfiguration och intern länkning, medan indexerbarhetsproblem ofta rör metataggar, kanoniska taggar, innehållskvalitet och renderingsproblem. Båda måste åtgärdas för att uppnå optimal synlighet i sök.

Core Web Vitals är tre specifika mätvärden som Google använder för att mäta verklig användarupplevelse och som direkt påverkar sökrankning. Largest Contentful Paint (LCP) mäter hur snabbt det största synliga elementet på en sida laddas – Google rekommenderar en LCP på 2,5 sekunder eller mindre. Interaction to Next Paint (INP), som ersatte First Input Delay under 2024, mäter hur responsiv en sida är vid användarinteraktioner som klick och tryck – målet är under 200 millisekunder. Cumulative Layout Shift (CLS) mäter visuell stabilitet genom att spåra oväntade layoutförändringar under sidladdning – ett värde under 0,1 anses bra. Forskning från DebugBear visar att webbplatser behöver att 75 % av användarna upplever “Bra” prestanda över alla tre mätvärden för att få maximal rankingfördel. Övergången till INP som rankingfaktor återspeglar Googles engagemang för att utvärdera sidans totala responsivitet under hela användarens interaktion, inte bara initial laddning. Optimering av Core Web Vitals kräver ett mångfacetterat angreppssätt: förbättring av LCP innebär att optimera bilder, använda CDN och skjuta upp icke-kritisk JavaScript; förbättring av INP kräver uppdelning av långa JavaScript-uppgifter och optimering av event handlers; och minskning av CLS innebär att reservera utrymme för dynamiskt innehåll och undvika annonser som ändrar layouten. Dessa mätvärden är numera icke-förhandlingsbara för konkurrenskraftig SEO, då sidor med dåliga Core Web Vitals riskerar rankingstraff och högre avvisningsfrekvens.

Webbplatsarkitektur syftar på hur din webbplats sidor är organiserade, strukturerade och sammankopplade genom interna länkar. En väl utformad webbplatsarkitektur fyller flera viktiga funktioner: den hjälper sökmotorer att förstå din innehållshierarki, fördelar länkkraft (rankingkraft) över hela sajten, säkerställer att viktiga sidor enkelt kan upptäckas och förbättrar användarnavigationen. Den idealiska webbplatsarkitekturen följer en tydlig hierarki med startsidan överst, kategorisidor på andra nivån och individuella innehållssidor på djupare nivåer. Bästa praxis föreskriver att alla viktiga sidor ska vara åtkomliga inom tre klick från startsidan, så att Googlebot inte slösar crawlbudget på djupt liggande, isolerade sidor. Intern länkning fungerar som bindväven i din webbplatsarkitektur och vägleder både användare och sökmotorer genom ditt innehåll. Strategisk intern länkning konsoliderar rankningssignaler till prioriterade sidor, etablerar ämnesrelationer mellan relaterat innehåll och hjälper sökmotorer att förstå vilka sidor som är viktigast. Till exempel skapar en nav-och-ekrar-modell – där en omfattande pelarsida länkar till flera relaterade undersidor som i sin tur länkar tillbaka till pelarsidan – en kraftfull struktur som signalerar ämnesauktoritet till sökmotorerna. Dålig webbplatsarkitektur, kännetecknad av föräldralösa sidor, inkonsekvent navigation och djupa nivåer, gör att sökmotorer slösar crawlbudget på mindre viktigt innehåll och försvårar etableringen av ämnesauktoritet. Företag som omstrukturerar sin webbplatsarkitektur ser ofta dramatiska förbättringar i indexeringshastighet och rankingprestanda.

Mobilförst-indexering innebär att Google främst använder mobilversionen av din webbplats för genomsökning, indexering och ranking – inte desktopversionen. Denna grundläggande förändring speglar verkligheten att över 60 % av alla sökningar idag kommer från mobila enheter. För teknisk SEO innebär detta att din mobila upplevelse måste vara felfri: responsiv design som anpassar sig till alla skärmstorlekar, beröringsvänlig navigation med tillräckligt avstånd mellan klickbara element, läsbara teckenstorlekar utan zoom och snabba laddningstider optimerade för mobilnät. Responsiv design använder flytande layouter och flexibla bilder för att automatiskt anpassa sig till olika skärmstorlekar och säkerställa konsekvent funktionalitet på alla enheter. Vanliga misstag inom mobiloptimering inkluderar påträngande interstitials (pop-ups) som blockerar huvudinnehållet, text som är för liten för att läsas utan att zooma, knappar som sitter för tätt för exakt tryckning och sidor som laddar långsamt på mobilnät. Googles Mobile-Friendly Test och Lighthouse-analyser kan identifiera dessa problem, men verklig testning på faktiska mobila enheter är fortsatt avgörande. Sambandet mellan mobiloptimering och ranking är direkt: sidor med dålig mobilupplevelse riskerar rankingstraff, medan mobiloptimerade sidor får ökad synlighet. För e-handelssajter, SaaS-plattformar och innehållspublicister är mobiloptimering inte valfritt – det är grundläggande för konkurrenskraftig synlighet i sök.

XML-sitemaps fungerar som en vägkarta för sökmotorer och listar alla URL:er du vill ska indexeras, tillsammans med metadata som senaste ändringsdatum och prioritet. En väl underhållen sitemap ska endast innehålla kanoniska, indexerbara URL:er – exkludera ompekningar, 404-sidor och duplicerat innehåll. Robots.txt är en textfil i webbplatsens rotkatalog som ger sökmotorrobotar instruktioner om vilka kataloger och filer de får och inte får komma åt. Robots.txt kan blockera genomsökning, men förhindrar inte indexering om sidan upptäcks på annat sätt; för verklig uteslutning, använd istället noindex-metataggar. Crawlbudget syftar på hur många sidor Googlebot kommer att genomsöka på din webbplats under en viss tidsperiod – en begränsad resurs som måste hanteras strategiskt. Stora webbplatser med miljontals sidor måste optimera crawlbudget genom att säkerställa att Googlebot fokuserar på innehåll med högt värde istället för att slösa resurser på lågprioriterade sidor, duplicerat innehåll eller varianter skapade av facetterad navigering. Vanligt slöseri med crawlbudget sker när sökparametrar genererar oändliga URL-varianter, när staging- eller utvecklingsmiljöer exponeras för robotar eller när tunna sidor får överdriven intern länkning. Enligt Googles officiella rekommendationer är hantering av crawlbudget särskilt viktigt för stora sajter, eftersom ineffektiv genomsökning kan fördröja upptäckt och indexering av nytt eller uppdaterat innehåll. Verktyg som Google Search Consoles rapport för crawlstatistik och serverlogganalys visar exakt vilka sidor Googlebot besöker och hur ofta, vilket möjliggör datadriven optimering av crawlbudget.

Strukturerad data, implementerad via schema markup, hjälper sökmotorer att förstå betydelsen och kontexten av ditt innehåll utöver enkel textanalys. Schema markup använder standardiserad vokabulär (från schema.org) för att märka olika typer av innehåll – produkter, artiklar, recept, evenemang, lokala företag med mera. När schema markup implementeras korrekt möjliggör det rich results i sök, där Google visar utökad information som stjärnbetyg, priser, tillagningstider eller evenemangsdatum direkt i sökresultaten. Denna ökade synlighet kan avsevärt förbättra klickfrekvens och användarengagemang. Olika innehållstyper kräver olika schemaimplementering: Artikelschema för blogginlägg och nyheter, Produktschema för e-handelssidor, FAQ-schema för vanliga frågor, Lokalt företag-schema för fysiska platser och Evenemangsschema för kommande evenemang. Implementering sker vanligtvis med JSON-LD-format, vilket är Googles föredragna metod. Schema markup måste dock korrekt återspegla faktiskt innehåll på sidan – vilseledande eller fabricerad schema kan leda till manuella straff. Enligt forskning från Search Engine Land kvalificerar sig endast sidor med giltig och relevant schema markup för rich results, vilket gör noggrann implementering avgörande. Organisationer som implementerar omfattande schema markup på sina viktigaste sidor ser ofta förbättrad synlighet både i traditionella sökresultat och AI-drivna sökplattformar, eftersom dessa system förlitar sig på strukturerad data för att förstå och citera innehåll korrekt.

HTTPS (Hypertext Transfer Protocol Secure) krypterar data som överförs mellan användares webbläsare och din webbserver, skyddar känslig information och signalerar trovärdighet till både användare och sökmotorer. Google har bekräftat att HTTPS är en rankingfaktor och sajter utan HTTPS riskerar både direkta rankingstraff och indirekta konsekvenser som webbläsarvarningar som avskräcker användare. Implementering av HTTPS kräver att du skaffar ett SSL/TLS-certifikat från en betrodd certifikatutfärdare och konfigurerar din server att använda HTTPS på alla sidor. Utöver grundläggande HTTPS-implementering ger säkerhetsrubriker som Content-Security-Policy, Strict-Transport-Security och X-Content-Type-Options ytterligare skydd mot vanliga webbhot. Mixed content-fel – där HTTPS-sidor laddar resurser via HTTP – undergräver säkerheten och kan utlösa webbläsarvarningar. Sambandet mellan säkerhet och SEO sträcker sig bortom ranking: säkra sajter bygger användarförtroende, minskar avvisningsfrekvensen och förbättrar konverteringsgraden. För e-handelssajter som hanterar betalningsinformation, SaaS-plattformar med användardata och alla sajter som samlar in personuppgifter är säkerhet icke-förhandlingsbart. Regelbundna säkerhetsgranskningar med verktyg som Google Search Consoles rapport för säkerhetsproblem och tredjeparts sårbarhetsskannrar hjälper till att identifiera och åtgärda säkerhetsproblem innan de påverkar ranking eller användartillit.

| Aspekt | Teknisk SEO | On-page SEO | Off-page SEO |

|---|---|---|---|

| Primärt fokus | Webbplatsinfrastruktur, hastighet, crawlability, indexerbarhet | Innehållskvalitet, nyckelord, metataggar, rubriker | Bakåtlänkar, varumärkesomnämnanden, sociala signaler |

| Sökmotoråtkomst | Säkerställer att sökmotorer kan genomsöka och indexera sidor | Hjälper sökmotorer att förstå sidans relevans | Bygger auktoritet och förtroendesignaler |

| Viktiga element | Webbplatshastighet, mobiloptimering, Core Web Vitals, webbplatsarkitektur, HTTPS, strukturerad data | Nyckelordsplacering, innehållsdjup, intern länkning, metabeskrivningar | Bakåtlänksprofil, domänauktoritet, varumärkesomnämnanden |

| Använda verktyg | PageSpeed Insights, Google Search Console, Screaming Frog, Lighthouse | Yoast SEO, Surfer SEO, Content Genius | Ahrefs, Semrush, Moz, Majestic |

| Påverkan på ranking | Grundläggande – utan det kan sidor inte rankas alls | Direkt – förbättrar relevans för målnyckelord | Betydande – bygger auktoritet och förtroende |

| Påverkan på användarupplevelse | Hög – påverkar sidans hastighet, mobilanvändbarhet, tillgänglighet | Medel – påverkar läsbarhet och engagemang | Låg – indirekt via varumärkesuppfattning |

| Implementeringstid | Löpande – kräver kontinuerlig övervakning och optimering | Löpande – kräver uppdateringar och optimering av innehåll | Långsiktig – kräver uthålliga länkbyggarinsatser |

| ROI-mätning | Crawleffektivitet, indexeringsgrad, Core Web Vitals-poäng, rankingar | Nyckelordsranking, organisk trafik, klickfrekvens | Bakåtlänktillväxt, domänauktoritet, referraltrafik |

JavaScript SEO adresserar de unika utmaningar som JavaScript-tunga webbplatser, single-page applications (SPA) och dynamisk rendering skapar. Historiskt hade Googlebot svårigheter med JavaScript eftersom det krävde rendering – att köra JavaScript-kod för att bygga den slutliga sidan – vilket lade till komplexitet och fördröjning i genomsökningsprocessen. Moderna Googlebot renderar nu de flesta sidor innan indexering, men denna process innebär nya tekniska SEO-överväganden. Server-side rendering (SSR) genererar komplett HTML på servern innan det skickas till webbläsaren, vilket säkerställer att sökmotorerna ser allt innehåll omedelbart utan att vänta på JavaScript-körning. Statisk sajtgenerering (SSG) förrenderar sidor vid bygget och skapar statiska HTML-filer som laddas direkt. Dynamisk rendering levererar förrenderad HTML till sökmotorer men JavaScript till användare, även om Google anser detta vara en tillfällig lösning. Det viktigaste är: allt väsentligt innehåll, metataggar och strukturerad data ska vara synliga i det initiala HTML, inte laddas dynamiskt efter JavaScript-körning. Sidor som döljer kritiskt innehåll bakom JavaScript riskerar ofullständig eller fördröjd indexering. React-, Vue- och Angular-ramverk kräver särskild omsorg – många organisationer som använder dessa ramverk implementerar Next.js eller Nuxt.js just för att hantera server-side rendering och förbättra SEO-prestanda. Testa hur Googlebot ser dina sidor med Google Search Consoles verktyg för URL-inspektion och renderad förhandsvisning avslöjar om JavaScript-beroende innehåll indexeras korrekt.

Effektiv implementering av teknisk SEO kräver ett systematiskt angreppssätt där optimeringar med störst effekt prioriteras. Börja med grundläggande element: säkerställ att din sajt är crawlbar genom att kontrollera robots.txt och interna länkar, verifiera att viktiga sidor är indexerbara genom att leta efter noindex-taggar och kanoniska problem och skapa en grund för Core Web Vitals-prestanda. Gå sedan vidare till prestandaoptimering: komprimera och optimera bilder, implementera lazy loading för innehåll under folden, skjuta upp icke-kritisk JavaScript och använd Content Delivery Networks (CDN) för snabbare leverans. Optimera sedan webbplatsstruktur: se till att viktiga sidor är inom tre klick från startsidan, implementera brödsmulenavigation med schema markup och skapa tydliga interna länkstrukturer som vägleder både användare och sökmotorer. Implementera strukturerad data för dina viktigaste innehållstyper – produkter, artiklar, lokal företagsinformation eller evenemang – med JSON-LD och validera med Googles Rich Results Test. Övervaka kontinuerligt med hjälp av Google Search Console för indexeringsproblem, PageSpeed Insights för Core Web Vitals och serverloggar för crawl-mönster. Etablera ansvar genom att spåra nyckeltal som antal indexerade sidor, Core Web Vitals-poäng och crawleffektivitet över tid. Organisationer som behandlar teknisk SEO som en löpande process istället för en engångsgranskning presterar konsekvent bättre än konkurrenter i synlighet och användarupplevelse.

I takt med att AI-drivna sökplattformar som Google AI Overviews, Perplexity, ChatGPT och Claude blir allt mer framträdande har den tekniska SEOns betydelse utökats bortom traditionell Google-sökning. Dessa AI-system förlitar sig på korrekt indexerat, välstrukturerat innehåll från sökmotorindex för att generera svar och citat. Teknisk SEO säkerställer att ditt innehåll är upptäckbart och tolkas korrekt av AI-system genom flera mekanismer: korrekt indexering gör innehållet tillgängligt för AI-träning och hämtning, strukturerad data hjälper AI-system att förstå kontext och betydelse och semantisk rikedom gör att AI-system kan känna igen ditt innehåll som auktoritativt och relevant. Enligt forskning från Conductor och Botify kommer sidor som syns i AI Overviews typiskt från välindexerade, tekniskt solida webbplatser med starka semantiska signaler. Sambandet är ömsesidigt: medan traditionell SEO fokuserar på ranking för specifika nyckelord fokuserar AI-sök på att ge heltäckande svar som kan citera flera källor. Detta innebär att teknisk SEO måste stödja båda paradigmerna – säkerställa att sidor indexeras för traditionell sökning och samtidigt vara semantiskt rika nog för att AI-system ska känna igen och citera dem. Organisationer som övervakar sin synlighet över flera AI-plattformar med verktyg som AmICited kan identifiera vilka tekniska optimeringar som mest effektivt förbättrar citeringsgrad och synlighet i generativa sökresultat.

Effektiv teknisk SEO kräver att man spårar specifika mått som indikerar webbplatsens hälsa och sökmotorns åtkomst. Antal indexerade sidor visar hur många av dina avsedda sidor som faktiskt finns i Googles index – att jämföra detta mot totala indexerbara sidor avslöjar ditt indexeffektivitetsförhållande. Crawleffektivitet mäter hur effektivt Googlebot använder sin crawlbudget, beräknat genom att dividera antalet genomsökta sidor med totala antal sidor på din webbplats. Core Web Vitals-poäng visar kvaliteten på användarupplevelsen över laddhastighet (LCP), interaktivitet (INP) och visuell stabilitet (CLS). Mobilanvändbarhetsproblem som spåras i Google Search Console avslöjar problem som små klickytor, fel i viewportkonfiguration eller påträngande interstitials. Längd på omdirigeringskedjor bör minimeras för att bevara länkkraft och minska genomsökningsfördröjningar. Täckning av strukturerad data visar hur stor andel av dina sidor som har giltig schema markup. Sidans hastighetsmått som First Contentful Paint (FCP), Time to Interactive (TTI) och Total Blocking Time (TBT) ger detaljerad prestandainsikt. Organisationer bör fastställa baslinjemätningar för dessa mått, sätta förbättringsmål och följa upp framsteg månadsvis eller kvartalsvis. Plötsliga förändringar i dessa mått signalerar ofta tekniska problem innan de påverkar ranking, vilket möjliggör proaktiv åtgärd. Verktyg som Google Search Console, PageSpeed Insights, Lighthouse och företagsplattformar som Semrush erbjuder omfattande dashboards för övervakning av dessa mått över hela webbplatsen.

Det tekniska SEO-landskapet fortsätter att utvecklas i takt med förändringar i sökmotorernas algoritmer, ny teknik och förändrade användarbeteenden. AI-drivna indexerings- och rankingprocesser kommer i ökande grad att påverka vilka sidor som indexeras och hur de rankas, vilket kräver att teknisk SEO stödjer semantisk förståelse och entitetsigenkänning. Edge computing och serverlösa arkitekturer möjliggör snabbare innehållsleverans och realtidsoptimering vid nätverkets edge, vilket minskar latens och förbättrar Core Web Vitals. Ökat fokus på E-E-A-T-signaler (Experience, Expertise, Authoritativeness, Trustworthiness) innebär att teknisk SEO måste stödja innehållskredibilitet genom korrekt författarmarkup, publiceringsdatum och förtroendesignaler. Optimering för flera ytor kommer att bli standard i takt med att AI-sökplattformar sprids, vilket kräver att webbplatser optimeras för synlighet på Google, Perplexity, ChatGPT, Claude och andra framväxande plattformar. Integritetsförst-analys och förstapartsdatainsamling kommer att omforma hur organisationer mäter effekten av teknisk SEO, med en övergång från tredjepartscookies mot serverside-tracking och samtyckesbaserad mätning. Mognad inom JavaScript-ramverk fortsätter att förbättra SEO-förmågan, med ramverk som Next.js, Nuxt.js och Remix som blir standard för SEO-vänliga applikationer. Automatiserad teknisk SEO driven av AI kommer att möjliggöra snabbare upptäckt och åtgärd av problem, där plattformar automatiskt identifierar och föreslår lösningar för crawlability-, indexerbarhets- och prestandaproblem. Organisationer som ligger steget före dessa trender genom att kontinuerligt uppdatera sin tekniska infrastruktur och bevaka nya bästa praxis kommer att bibehålla konkurrensfördelar i organisk synlighet.

Teknisk SEO fokuserar på att optimera en webbplats backend-infrastruktur – såsom webbplatshastighet, crawlability, indexerbarhet och serverkonfiguration – för att hjälpa sökmotorer att upptäcka och bearbeta innehåll. On-page SEO, däremot, koncentrerar sig på att optimera enskilda sidelement som nyckelordsplacering, metataggar, rubriker och innehållskvalitet för att förbättra relevansen för specifika sökfrågor. Medan teknisk SEO säkerställer att sökmotorer kan komma åt din webbplats, säkerställer on-page SEO att de förstår vad ditt innehåll handlar om och varför det är viktigt för användarna.

Core Web Vitals – Largest Contentful Paint (LCP), Interaction to Next Paint (INP) och Cumulative Layout Shift (CLS) – är bekräftade rankingfaktorer som mäter verklig användarupplevelse. Enligt forskning från DebugBear behöver webbplatser att 75 % av användarna har en 'Bra' upplevelse över alla tre mätvärden för att få maximal rankingfördel. Dåliga Core Web Vitals kan leda till rankingstraff, minskad klickfrekvens och högre avvisningsfrekvens, vilket direkt påverkar organisk synlighet och användarengagemang.

Crawlability avgör om sökmotorernas robotar kan komma åt och följa länkar på hela din webbplats. Om Googlebot inte kan genomsöka dina sidor på grund av blockerade resurser, dålig webbplatsstruktur eller begränsningar i robots.txt kan dessa sidor inte indexeras eller rankas. Utan korrekt crawlability förblir även innehåll av hög kvalitet osynligt för sökmotorer, vilket gör det omöjligt att uppnå organisk synlighet oavsett innehållskvalitet eller bakåtlänksprofil.

När AI-drivna sökplattformar som Google AI Overviews och Perplexity blir mer framträdande förblir teknisk SEO grundläggande. Dessa AI-system är beroende av korrekt indexerat, välstrukturerat innehåll från Googles index för att generera svar. Teknisk SEO säkerställer att ditt innehåll är upptäckbart, korrekt renderat och semantiskt rikt nog för att AI-system ska kunna citera och referera till det. Utan solida tekniska grunder kommer ditt innehåll inte att synas i AI Overviews eller andra generativa sökresultat.

För de flesta webbplatser rekommenderas det att genomföra en omfattande teknisk SEO-granskning kvartalsvis, med månatlig övervakning av kritiska problem. Större företagssajter med frekventa uppdateringar bör granska varje månad eller införa system för kontinuerlig övervakning. Efter större webbplatsändringar, migreringar eller omdesign är omedelbara granskningar nödvändiga. Regelbundna granskningar hjälper till att upptäcka problem tidigt innan de påverkar rankingen och säkerställer att din webbplats bibehåller optimal crawlability, indexerbarhet och prestanda.

Webbplatsarkitektur avgör hur sökmotorer navigerar och förstår din webbplats innehållshierarki. En väloptimerad arkitektur säkerställer att viktiga sidor finns inom tre klick från startsidan, fördelar länkkraft effektivt och hjälper sökmotorer att prioritera genomsökning av innehåll med högt värde. Dålig webbplatsarkitektur kan leda till föräldralösa sidor, slöseri med crawlbudget och svårigheter att etablera ämnesauktoritet, vilket alla påverkar ranking och synlighet negativt.

Sidans hastighet påverkar direkt både sökrankning och användarbeteende. Google har bekräftat att Core Web Vitals – som mäter laddningshastighet, interaktivitet och visuell stabilitet – är rankingfaktorer. Långsamt laddande sidor får högre avvisningsfrekvens, lägre engagemang och minskade konverteringar. Studier visar att sidor som laddar på under 2,5 sekunder har avsevärt bättre användarretention och rankingprestanda jämfört med långsammare sidor, vilket gör hastighetsoptimering avgörande för SEO-framgång.

Börja spåra hur AI-chatbotar nämner ditt varumärke på ChatGPT, Perplexity och andra plattformar. Få handlingsbara insikter för att förbättra din AI-närvaro.

JavaScript SEO optimerar JavaScript-renderade webbplatser för sökmotorers crawling och indexering. Lär dig bästa praxis, renderingsmetoder och strategier för at...

Content SEO är den strategiska skapandet och optimeringen av högkvalitativt innehåll för att förbättra sökmotorrankningar och organisk synlighet. Lär dig hur du...

Diskussion i communityn om hur AI-sökmotorer indexerar och upptäcker innehåll. Tekniska experter förklarar skillnaderna mellan traditionell sökindexering och AI...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.