如何为 AI 爬虫配置 robots.txt:完整指南

了解如何配置 robots.txt 以控制 AI 爬虫的访问,包括 GPTBot、ClaudeBot 和 Perplexity。管理您的品牌在 AI 生成答案中的可见性。

针对AI爬虫设置的robots.txt用户代理规则配置。AI专用robots.txt允许网站所有者控制人工智能系统、大型语言模型和AI训练机器人如何访问和使用其内容。它区分不同类型的AI爬虫——训练爬虫、搜索爬虫和用户触发式抓取器——从而实现对AI系统内容可见性的精细控制。随着AI爬虫现在占据许多网站约80%的机器人流量,这种配置已变得至关重要。

针对AI爬虫设置的robots.txt用户代理规则配置。AI专用robots.txt允许网站所有者控制人工智能系统、大型语言模型和AI训练机器人如何访问和使用其内容。它区分不同类型的AI爬虫——训练爬虫、搜索爬虫和用户触发式抓取器——从而实现对AI系统内容可见性的精细控制。随着AI爬虫现在占据许多网站约80%的机器人流量,这种配置已变得至关重要。

AI专用robots.txt配置指的是在您的robots.txt文件中制定针对人工智能爬虫和训练机器人(区别于传统搜索引擎爬虫如Googlebot)的定向规则。传统robots.txt主要用于管理Googlebot、Bingbot等搜索引擎索引器,而大型语言模型和AI训练系统的出现则催生了一类全新的机器人流量,需要采用独立的管理策略。根据2025年11月的最新数据,AI爬虫现在已占许多出版商网站全部机器人流量的约80%,使得robots.txt配置的重要性从可选的SEO工具转变为关键的内容保护机制。这一区别十分重要,因为AI训练爬虫的运作模式与搜索引擎不同——它们主要收集数据训练专有模型,而非为网站带来推荐流量,因此“允许爬虫换取可见性”的传统权衡已不再适用。对于出版商而言,这意味着robots.txt的决策现在会直接影响内容在AI系统中的可见性、专有内容被未经授权用于训练数据集的风险,以及AI发现带来的流量和收入影响。

AI爬虫主要分为三大运作类别,每类有不同的特点、流量影响和出版商需要考虑的战略因素。训练爬虫专为收集大量文本数据以用于机器学习模型开发,通常带宽消耗大、服务器负载高,且不会带来任何推荐流量——如OpenAI的GPTBot和Anthropic的ClaudeBot。搜索与引用爬虫则类似传统搜索引擎,通过索引内容便于检索,并可提供归属引用;它们带来的流量适中,能通过引用和链接带来推荐流量——如OpenAI的OAI-SearchBot和Google的AI Overviews爬虫。用户触发爬虫在终端用户主动请求AI分析某网页时按需运行,例如ChatGPT的网页浏览能力或Claude的文档分析功能,此类爬虫流量较低,但代表用户对您内容的直接参与。这样的分类具有重要的战略意义:训练爬虫内容保护风险最高而业务收益最小,搜索爬虫在带来推荐流量方面处于中间地带,而用户触发爬虫通常符合用户意图,并能提升内容曝光。

| 爬虫类别 | 目的 | 流量等级 | 推荐潜力 | 内容风险 | 示例 |

|---|---|---|---|---|---|

| 训练 | 模型开发 | 很高 | 无 | 很高 | GPTBot, ClaudeBot |

| 搜索/引用 | 内容索引与归属 | 中等 | 中等 | 中等 | OAI-SearchBot, Google AI |

| 用户触发 | 按需分析 | 低 | 低 | 低 | ChatGPT Web Browse, Claude |

主要运营爬虫的AI公司包括OpenAI、Anthropic、Google、Meta、Apple和Amazon,每家公司的用户代理字符串不同,可用于在服务器日志和robots.txt配置中识别。OpenAI运营多个爬虫:用于训练数据采集的GPTBot(user-agent: GPTBot/1.0)、用于搜索与引用索引的OAI-SearchBot(user-agent: OAI-SearchBot/1.0),以及用于用户触发网页浏览的ChatGPT-User(user-agent: ChatGPT-User/1.0)。Anthropic的主爬虫为ClaudeBot(user-agent: Claude-Web/1.0 或 anthropic-ai),用于训练和知识库建设。Google运营Google-Extended(user-agent: Google-Extended/1.1),用于Gemini及其他AI产品;Meta使用facebookexternalhit进行内容分析,Apple运营AppleBot用于Siri和搜索功能,Amazon则通过Amazonbot服务Alexa和搜索能力。要在服务器日志中识别这些爬虫,请检查HTTP请求中的User-Agent头部——大多数合法的AI爬虫会在此字段中包含公司名和版本号。为加强安全性,可通过核对请求IP地址与各公司公布的IP段来验证爬虫的合法性;OpenAI、Google等主要厂商均公布了其爬虫的IP段,从而帮助区分合法爬虫与伪造用户代理的请求。

AI专用robots.txt规则的基本语法遵循标准robots.txt格式,根据用户代理匹配及allow/disallow指令针对特定爬虫进行控制。若要阻止OpenAI的GPTBot进行训练数据采集,但允许其搜索爬虫,则robots.txt应如下设置:

User-agent: GPTBot

Disallow: /

User-agent: OAI-SearchBot

Allow: /

如需更细致控制,可以对路径进行限定,例如阻止AI爬虫访问您的付费墙内容或用户生成内容板块:

User-agent: GPTBot

Disallow: /premium/

Disallow: /user-content/

Allow: /public-articles/

User-agent: ClaudeBot

Disallow: /

您可以将多个用户代理归为同一组规则,以便对多种爬虫统一施加限制,降低配置复杂度。测试和验证robots.txt配置至关重要;可通过Google Search Console的robots.txt测试工具及第三方验证器,确保您的规则语法正确并可被爬虫正确解释。需注意,robots.txt仅具建议性——规范爬虫会遵守规则,但恶意或不合规爬虫可能完全忽视这些指令,对于敏感内容还需额外的服务端防护机制。

是否屏蔽AI爬虫,涉及内容保护与可见性之间的根本权衡,这一决策需结合您的业务模式和内容战略。完全屏蔽训练爬虫如GPTBot,可彻底杜绝您的内容被无偿用于专有AI模型训练的风险,但也会导致您的内容无法出现在AI生成的答案中,可能降低通过AI系统被发现和带来的流量。反之,允许训练爬虫访问,则增加了您的内容被纳入AI训练数据集的风险,且不一定会获得归属或补偿,但如果AI系统将来引用您的内容,可能提升可见性。战略决策应结合您的内容竞争力——专有研究、原创分析和独家数据建议严格屏蔽,而常绿教育内容或通用信息则可能适合获得更广泛AI曝光。不同出版商类型的权衡亦不同:新闻机构可允许搜索爬虫带来引用流量,同时屏蔽训练爬虫;教育出版商可考虑放宽访问以扩大影响;SaaS公司则应严格屏蔽AI爬虫以保护专有文档。通过服务器日志和流量分析工具监测屏蔽效果,是确保配置实现预期商业目标的关键。

虽然robots.txt为爬虫政策提供了明确的沟通机制,但它本质上是建议性、非强制性的——合规爬虫会遵守您的规则,不合规者则可能完全无视,因此需额外技术防护。IP验证及白名单机制是最可靠的防护方式;通过维护OpenAI、Google、Anthropic等主流AI公司公布的合法IP地址列表,可验证自称为这些爬虫的请求是否来自真实基础设施。防火墙规则与服务端屏蔽则是最强力的防护,可在网络层拒绝特定用户代理或IP段的请求,避免服务器资源被消耗。对于Apache服务器,可通过**.htaccess配置**实施爬虫限制:

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} GPTBot [NC]

RewriteRule ^.*$ - [F,L]

</IfModule>

Meta标签可在HTML head区块实现页面级的精细爬虫控制,无需修改robots.txt:

<meta name="robots" content="noindex, noimageindex, nofollowbyai">

定期检查服务器日志,可发现新爬虫、验证规则是否被遵守,并检测试图规避限制的伪造用户代理。Knowatoa和Merkle等工具可自动验证和监控您的robots.txt配置及爬虫行为,帮助了解哪些爬虫在访问您的网站,以及它们是否遵守您的指令。

持续维护AI专用robots.txt配置至关重要,因为AI爬虫生态快速变化,新爬虫不断涌现,现有爬虫的用户代理字符串和行为模式也在调整。建议的监控策略包括:

AI爬虫技术的快速演进意味着六个月前适用的robots.txt配置,可能已经无法满足当前需求或应对最新威胁,因此定期审查和调整至关重要,以确保内容保护有效。

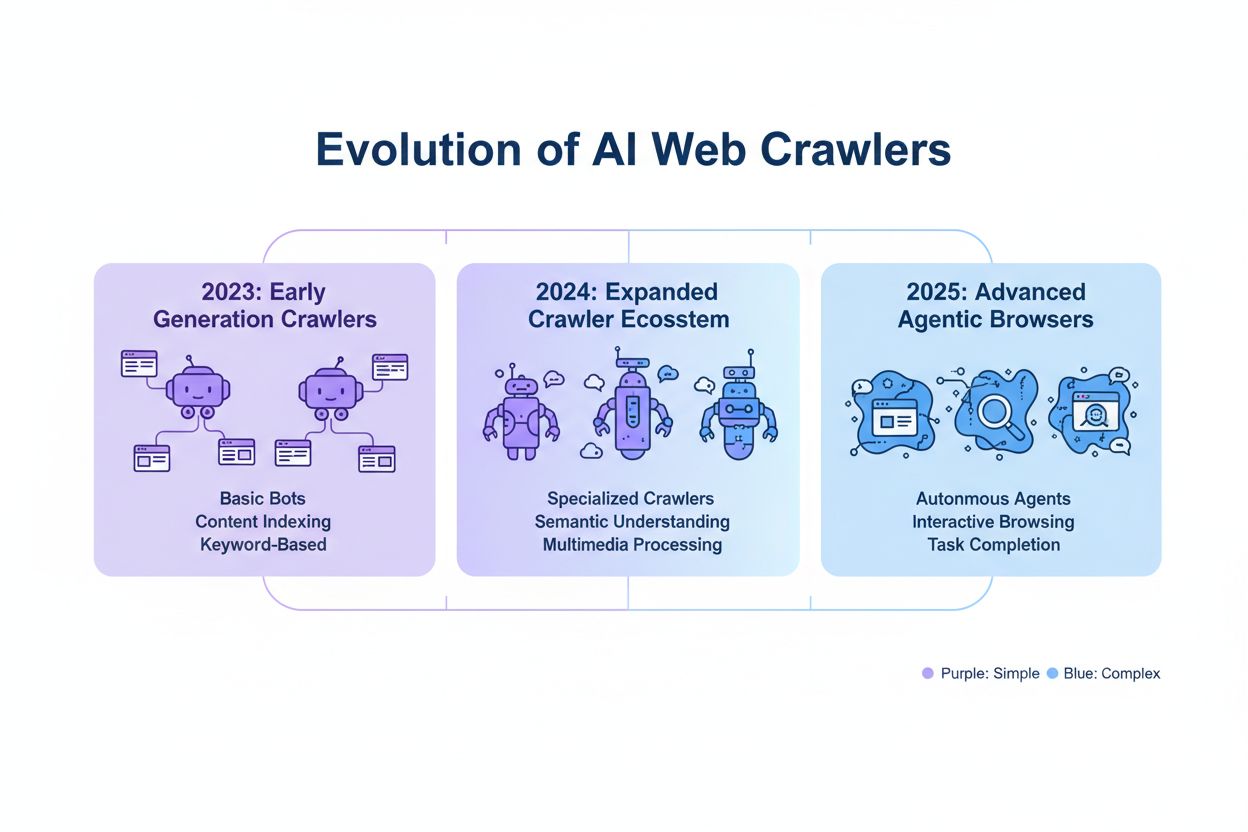

新一代AI爬虫正在带来传统robots.txt难以应对的新挑战。智能浏览器爬虫如ChatGPT Atlas和Google Project Mariner以完整网页浏览器形态运行,可渲染JavaScript、执行用户交互,其行为与真人用户几乎无异——这些爬虫往往不再用独特用户代理字符串自我标识,导致基于robots.txt的屏蔽失效。越来越多的新兴爬虫开始采用标准Chrome用户代理字符串,有意规避检测与屏蔽,掩饰自身身份以绕过robots.txt和其它访问控制。这一趋势推动出版商转向基于IP的屏蔽,即维护合法爬虫IP白名单,屏蔽所有其他可疑来源流量,将防护模式从用户代理匹配转为网络级访问控制。伪造用户代理与规避技术也日益普遍,恶意行为者冒充合法爬虫或使用通用用户代理字符串以逃避检测。未来AI爬虫管理势必采取多层次策略,结合robots.txt配置、IP验证、防火墙规则,甚至行为分析,以有效区分合法爬虫和恶意行为者。持续关注新兴爬虫技术,并积极参与行业关于爬虫伦理和标准的讨论,是出版商维护有效内容保护战略的关键。

实施有效的AI专用robots.txt配置需采取全面方法,在内容保护与战略可见性目标中取得平衡。首先制定清晰的内容保护政策,明确哪些内容类别需屏蔽(如专有研究、付费内容、用户原创内容),哪些可安全暴露给AI爬虫(如公开文章、教育内容、通用信息)。采用分层屏蔽策略,区分训练爬虫(通常屏蔽)、搜索爬虫(通常允许并监控)、用户触发爬虫(通常允许),而非对所有AI爬虫一刀切。将robots.txt与服务端防护结合,为最敏感内容实施防火墙规则和IP验证,认识到仅靠robots.txt无法实现强力内容保护。将AI爬虫管理纳入整体SEO和内容战略,充分考虑屏蔽决策对您在AI生成答案、引用和AI搜索功能中的可见性影响——这样可确保您的robots.txt配置服务于整体业务目标。建立定期监控与维护机制,包括每周日志审查、每月IP验证、每季度全面审计,确保配置随着爬虫生态变化始终有效。使用AmICited.com等工具,监测您的内容在各大AI系统中的可见性,了解您的屏蔽决策对AI发现和引用的影响。针对不同出版商类型:新闻机构建议允许搜索爬虫同时屏蔽训练爬虫以最大化引用流量,教育出版商可考虑放宽访问以扩大覆盖,SaaS公司应对专有文档实施最严格屏蔽。当robots.txt屏蔽因伪造用户代理或不合规爬虫而失效时,应升级为防火墙规则和基于IP的屏蔽,在网络层面强制执行内容保护政策。

训练爬虫如GPTBot和ClaudeBot用于模型开发的数据采集,不会带来任何推荐流量,因此对于内容保护来说风险较高。搜索爬虫如OAI-SearchBot和PerplexityBot则负责AI驱动的内容索引,并可能通过引用带来流量。大多数出版商会屏蔽训练爬虫,同时允许搜索爬虫,以在内容保护和可见性之间取得平衡。

Google官方表示,屏蔽Google-Extended不会影响搜索排名或AI Overviews的收录。然而,一些站长仍有顾虑,因此建议在实施屏蔽后监测您的搜索表现。Google搜索中的AI Overviews遵循的是标准Googlebot规则,而不是Google-Extended。

会的,robots.txt是建议性而非强制性的。主要公司的规范爬虫通常会遵守robots.txt指令,但有些爬虫会无视它们。为实现更强的保护,请通过.htaccess或防火墙规则在服务器层面进行屏蔽,并通过公布的IP地址段验证合法爬虫。

至少每季度审查和更新一次您的屏蔽名单。新的AI爬虫不断出现,因此建议每月检查服务器日志,识别新的爬虫访问您的网站。关注如ai.robots.txt GitHub项目等社区资源,获取新兴爬虫和用户代理字符串的最新信息。

这取决于您的业务优先级。屏蔽训练爬虫可以防止您的内容被无偿用于AI模型训练。屏蔽搜索爬虫可能会降低您在AI驱动发现平台(如ChatGPT搜索或Perplexity)中的可见性。许多出版商选择有选择性的屏蔽,即只屏蔽训练爬虫,允许搜索和引用爬虫。

查看服务器日志中的爬虫用户代理字符串,确认被屏蔽的爬虫没有访问您的内容页面。使用分析工具监测机器人流量模式。通过Knowatoa AI Search Console或Merkle robots.txt Tester等工具测试您的配置,验证规则是否如预期生效。

智能浏览器爬虫如ChatGPT Atlas和Google Project Mariner作为功能完整的网页浏览器运行,而不是简单的HTTP客户端。它们常用标准的Chrome用户代理字符串,使其难以与普通浏览器流量区分。针对这些高级爬虫,需要基于IP的屏蔽来控制访问。

AI专用robots.txt用于控制您的内容访问,而如AmICited这样的工具则监测AI平台如何引用和提及您的内容。两者结合可实现完整的可见性与控制:robots.txt管理爬虫访问,监测工具跟踪您的内容在各大AI系统中的影响力。

了解如何配置 robots.txt 以控制 AI 爬虫的访问,包括 GPTBot、ClaudeBot 和 Perplexity。管理您的品牌在 AI 生成答案中的可见性。

学习如何让GPTBot、PerplexityBot和ClaudeBot等AI机器人抓取你的网站。配置robots.txt,设置llms.txt,并为AI可见性优化。

了解应在robots.txt中允许或阻止哪些AI爬虫。全面指南涵盖GPTBot、ClaudeBot、PerplexityBot及25+种AI爬虫,并附配置示例。

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.