AI幻觉

当大型语言模型(LLM)自信地生成虚假或误导性信息时,就会出现AI幻觉。了解幻觉的成因、其对品牌监测的影响,以及AI系统的缓解策略。...

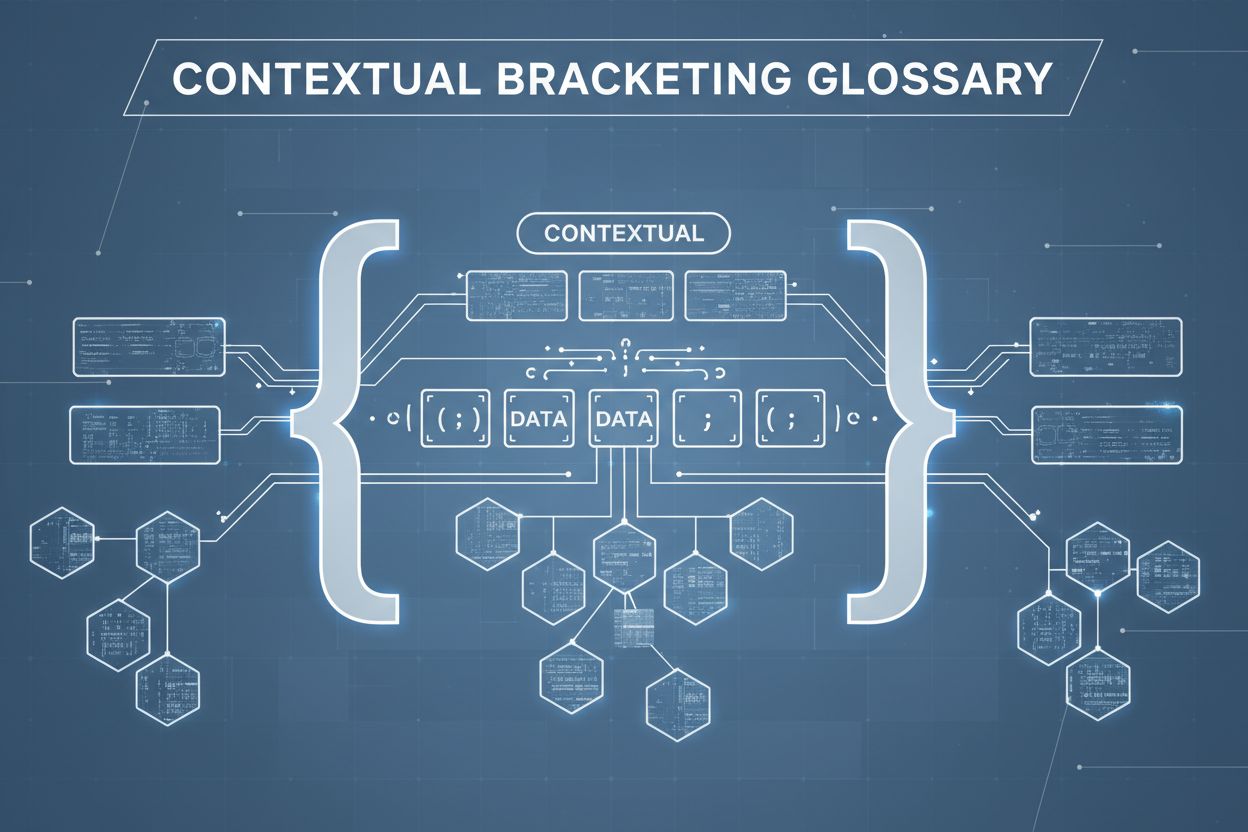

上下文括界是一种内容优化技术,通过在信息周围建立明确边界,防止AI误解和产生幻觉。它使用显式的分隔符和上下文标记,确保AI模型准确理解相关信息的开始和结束位置,避免基于假设或虚构细节生成回应。

上下文括界是一种内容优化技术,通过在信息周围建立明确边界,防止AI误解和产生幻觉。它使用显式的分隔符和上下文标记,确保AI模型准确理解相关信息的开始和结束位置,避免基于假设或虚构细节生成回应。

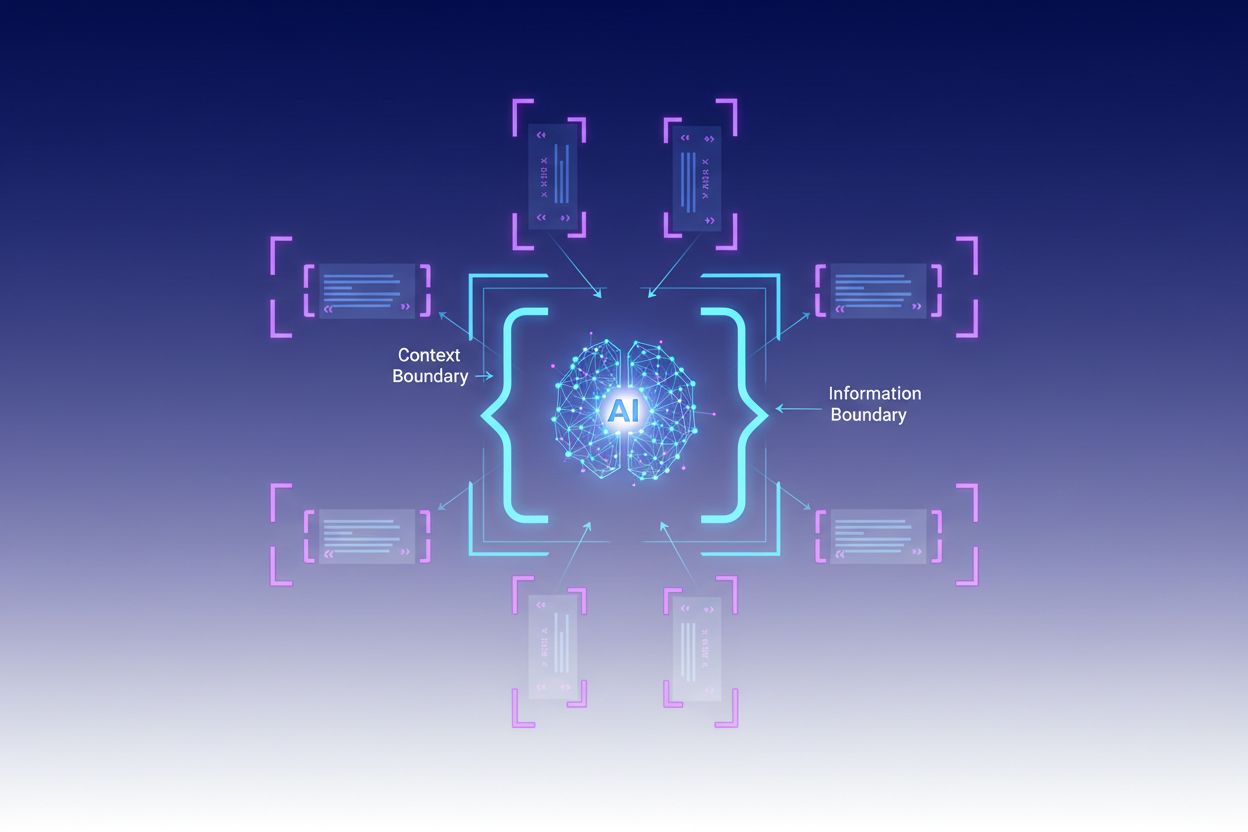

上下文括界是一种内容优化技术,通过明确的信息边界防止AI误解和产生幻觉。该方法涉及使用显式分隔符——如XML标签、markdown标题或特殊字符——标记特定信息块的开始和结束,形成专家所称的“上下文边界”。通过用这些清晰标记结构化提示和数据,开发者确保AI模型准确理解相关信息的起止点,防止模型基于假设或虚构细节生成回应。上下文括界代表了传统提示工程的演进,扩展到更广泛的上下文工程领域,专注于优化提供给LLM的所有信息以实现预期结果。该技术在对准确性和一致性要求极高的生产环境中尤为有价值,因为它提供了数学和结构上的护栏,无需复杂条件逻辑即可引导AI行为。

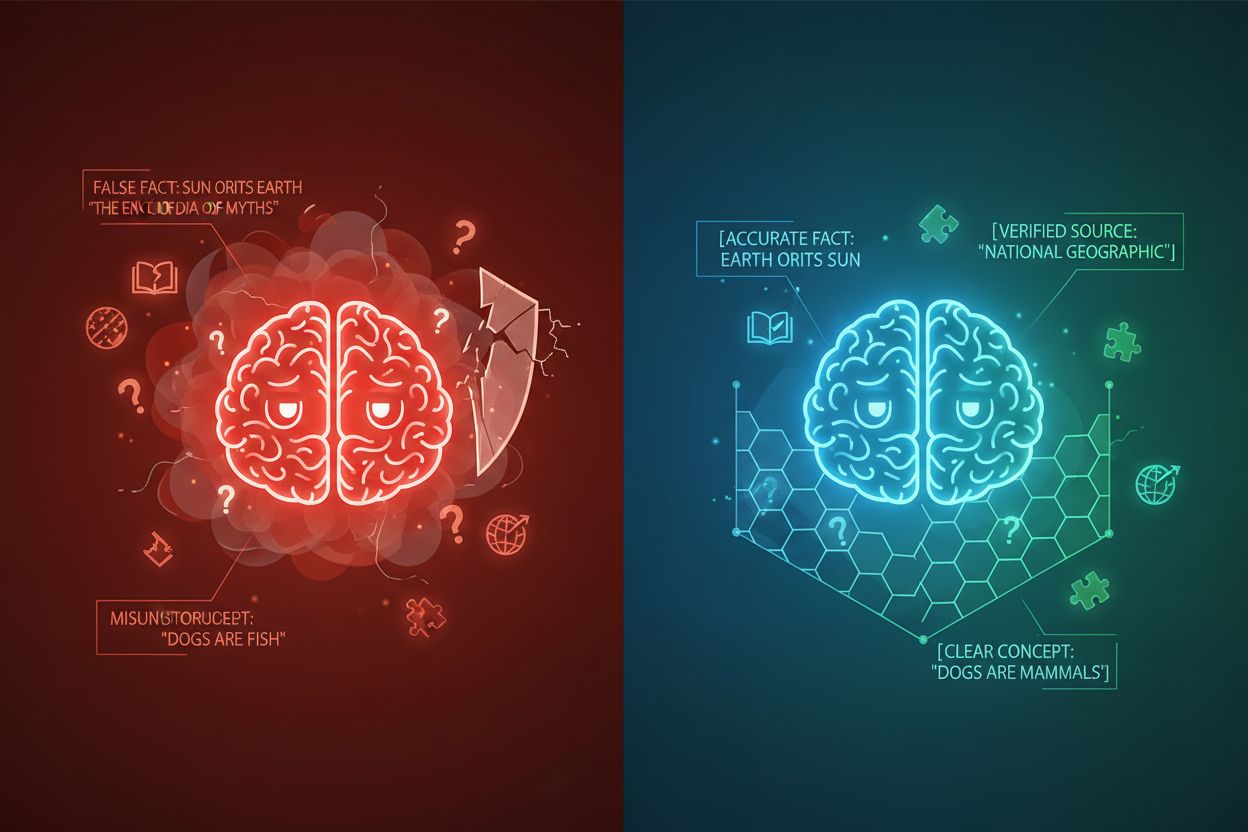

AI幻觉是指语言模型生成的回应不基于事实信息或所提供的具体上下文,导致虚假事实、误导性陈述或引用不存在的来源。研究显示,聊天机器人约有27%的事实是编造的,46%的文本包含事实错误,而ChatGPT在新闻引用中76%的引文是错误的。这些幻觉源于多种原因:模型可能从有偏或不完整的训练数据中学习模式,误解token之间的关系,或缺乏足够限制输出的约束条件。其后果在各行业均极为严重——在医疗领域,幻觉可能导致错误诊断和不必要的医疗干预;在法律场景下,幻觉会造成虚构案例引用(如Mata诉Avianca案,一名律师因使用ChatGPT虚假法律引用而受罚);在商业领域,则因错误分析和预测浪费资源。根本问题在于,没有清晰的上下文边界时,AI模型如同在信息真空中运作,更容易用貌似合理但实际上不准确的信息“填补空白”,将幻觉视为特性而非缺陷。

| 幻觉类型 | 频率 | 影响 | 示例 |

|---|---|---|---|

| 事实错误 | 27-46% | 虚假信息传播 | 虚构产品功能 |

| 来源伪造 | 76%(引用) | 信誉受损 | 不存在的引用 |

| 概念误解 | 可变 | 错误分析 | 错误法律先例 |

| 偏见模式 | 持续 | 歧视性输出 | 刻板印象回复 |

上下文括界的有效性建立在五大基本原则之上:

<context>、markdown标题或特殊字符),清晰划分信息块,防止模型混淆不同数据源或指令类型之间的边界。实现上下文括界需精心设计信息结构和呈现方式。结构化输入格式(如JSON或XML模式)提供显式字段定义,引导模型行为——例如,将用户查询包裹在<user_query>标签中,预期输出包裹在<expected_output>标签中,形成明确边界。系统提示应用markdown标题或XML标签分区:<background_information>、<instructions>、<tool_guidance>、<output_description>各自承担特定功能,帮助模型理解信息层级。few-shot示例应包含带括界的上下文,清楚展示模型应如何结构化回应,输入和输出外部均有分隔符。工具定义需有明确参数说明和使用约束,防止模型误用工具或超出意图范围。**检索增强生成(RAG)**系统可通过将检索文档包裹在来源标记(<source>document_name</source>)内,并用grounding分数验证生成内容是否留在检索信息边界内。例如,CustomGPT的上下文边界特性是通过仅在上传数据集上训练模型实现的,确保回应绝不超出知识库——这是在架构层面实践上下文括界的典型案例。

虽然上下文括界与相关技术有相似之处,但在AI工程领域占有独特位置。基础提示工程主要着力于编写有效指令和示例,但缺乏对全部上下文元素系统化管理的能力。上下文工程是更广泛的学科,涵盖上下文括界、提示优化、工具设计、记忆管理和动态上下文检索等,是一个包含上下文括界的超集。简单的指令遵循依赖模型理解自然语言指令,但在指令复杂或情况模糊时容易失效,因缺少结构化边界。护栏与验证系统在输出层面校验内容,而上下文括界则在输入层面防止幻觉发生。关键区别在于,括界是预防性和结构性的——塑造模型运行的信息环境,而不是事后纠正或反应性措施,因此在生产系统中更高效、更可靠。

上下文括界在多种应用中带来可衡量的价值。客户服务聊天机器人通过上下文边界将回应限制在公司批准的知识库内,防止虚构产品功能或做出未经授权的承诺。法律文档分析系统对相关判例、法规和先例进行括界,确保AI仅引用验证过的来源,不虚构法律引用。医疗AI系统对临床指南、患者数据和批准的治疗方案设定严格上下文边界,防止产生危害患者的危险幻觉。内容生成平台通过括界确保品牌规范、语气要求和事实约束,确保内容符合组织标准。研究与分析工具对主要来源、数据集和验证信息进行括界,使AI在保持清晰归属的前提下综合洞见,防止虚构统计或研究。AmICited.com通过监控AI系统在GPTs、Perplexity和Google AI概览中如何引用品牌,体现了这一原则——本质上追踪AI模型在讨论特定公司或产品时是否保持在适当上下文边界内,帮助组织了解AI是否对品牌产生幻觉还是准确反映信息。

成功实施上下文括界需遵循经过验证的最佳实践:

多家平台已将上下文括界能力集成进核心产品。CustomGPT.ai通过其“上下文边界”功能实现括界,确保AI仅用用户提供的数据,从不引用通用知识或虚构信息——这一做法已为如麻省理工学院等对知识传递准确性要求极高的机构验证有效。Anthropic的Claude强调上下文工程原则,提供详尽文档指导如何结构化提示、管理上下文窗口并实现护栏,确保回应在定义边界内。AWS Bedrock Guardrails提供自动推理校验,依据数学和逻辑规则检测生成内容,grounding分数高于0.85才适用于金融等行业。Shelf.io提供带上下文管理的RAG解决方案,使组织可在检索增强生成的同时,严格限定模型可访问和引用的信息范围。AmICited.com则补充性地监控AI系统在多平台中如何引用和参考您的品牌,帮助您了解AI模型在讨论贵组织时是否尊重适当的上下文边界,确保信息准确、经过验证——本质上为上下文括界在真实环境下的有效性提供可见性。

提示工程主要侧重于制定有效的指令和示例,而上下文括界是一种通过显式分隔符和边界系统化管理所有上下文元素的方法。上下文括界更为结构化和预防性,作用于输入层面,提前阻止幻觉产生,而提示工程更宽泛,包含多种优化技术。

上下文括界通过使用如XML标签或markdown标题等分隔符建立清晰的信息边界。这告知AI模型应考虑哪些信息,应该忽略哪些,从而防止其虚构细节或对未说明信息做出假设。通过将模型的关注点限制在已定义的边界内,可降低生成错误事实或虚构来源的可能性。

常见分隔符包括XML标签(如

上下文括界原则可应用于大多数现代语言模型,但效果有所不同。那些训练有更好指令遵循能力的模型(如Claude、GPT-4和Gemini)通常能更可靠地遵守边界。该技术与支持结构化输出并在多样且格式良好的数据上训练过的模型结合时效果最佳。

首先通过清晰分隔符将系统提示组织为不同部分。用JSON或XML模式结构化输入和输出。全程使用一致的分隔符模式。实现few-shot示例,清楚展示模型应如何尊重边界。进行大量测试,确保模型遵守定义的边界,并随时间监控性能,防止上下文漂移。

上下文括界会因增加分隔符和结构化标记而略微提升token用量,但通常通过提升准确率和减少幻觉补偿了这一点。该技术实际上提升了效率,因为它防止模型在虚构信息上浪费token。在生产系统中,准确性的提升远超微小的token开销。

上下文括界与RAG是互补技术。RAG从外部来源检索相关信息,而上下文括界确保模型只在检索到的信息边界内活动。二者结合,使模型既能访问外部知识,又被约束只能引用经过验证、已检索的来源。

有多个平台内置了支持:CustomGPT.ai提供上下文边界功能,Anthropic的Claude有上下文工程文档及结构化输出支持,AWS Bedrock Guardrails包含自动化推理检查,Shelf.io提供具备上下文管理的RAG。AmICited.com监控AI系统如何引用您的品牌,帮助验证上下文括界的有效性。

当大型语言模型(LLM)自信地生成虚假或误导性信息时,就会出现AI幻觉。了解幻觉的成因、其对品牌监测的影响,以及AI系统的缓解策略。...

了解如何识别、应对和预防AI关于您品牌的幻觉。针对ChatGPT、Google AI等平台的危机管理策略。

了解AI幻觉是什么、为何会发生在ChatGPT、Claude和Perplexity中,以及如何在搜索结果中检测AI生成的虚假信息。

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.