AI 模型中的上下文窗口是什么

了解什么是 AI 语言模型中的上下文窗口,它们的工作原理、对模型性能的影响,以及它们为何对 AI 应用和监控至关重要。...

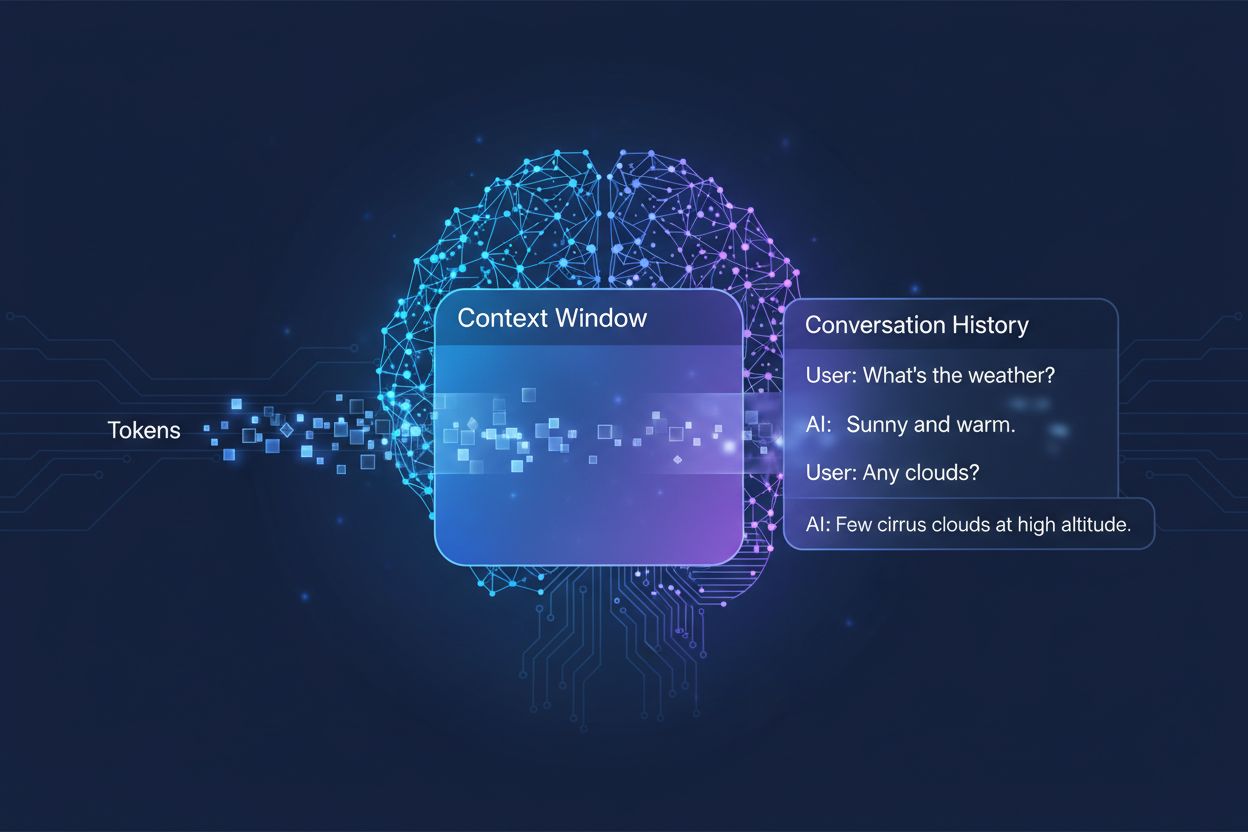

AI系统在生成回复时可参考的先前对话内容量,以“token”(标记)为单位衡量。它决定了AI一次能同时处理多少文本,并直接影响其在多轮对话中的输出质量和连贯性。

AI系统在生成回复时可参考的先前对话内容量,以“token”(标记)为单位衡量。它决定了AI一次能同时处理多少文本,并直接影响其在多轮对话中的输出质量和连贯性。

上下文窗口指的是AI语言模型在一次对话或任务中,能够同时处理和参考的最大文本量。可以把它类比为模型的“工作记忆”——就像人类在短时记忆中只能保留有限信息,AI模型在当前时刻前后也只能“看到”一定量的文本。这一能力以**token(标记)**为单位衡量,token通常代表一个词或词片段(平均一个英文单词约为1.5个token)。了解模型的上下文窗口至关重要,因为它直接决定了AI生成回复时能够参考多少信息,是模型能否高效处理复杂多轮对话或长文档的根本限制。

现代语言模型,尤其是基于Transformer架构的模型,通过将文本切分为token,并同时分析上下文窗口内所有token之间的关系来处理文本。Transformer架构最早发表于2017年的论文《Attention is All You Need》,其核心机制为自注意力(self-attention),用以判断输入中哪些部分彼此最相关。注意力机制让模型能权衡不同token间的重要性,从而理解整个窗口内的上下文和含义。但随着窗口变大,这一过程的计算成本急剧上升,因为注意力机制必须计算每个token与所有其它token的关系,呈二次增长。下表展示了主流AI模型在上下文窗口方面的能力对比:

| 模型 | 上下文窗口(Token) | 发布日期 |

|---|---|---|

| GPT-4 | 128,000 | 2023年3月 |

| Claude 3 Opus | 200,000 | 2024年3月 |

| Gemini 1.5 Pro | 1,000,000 | 2024年5月 |

| GPT-4 Turbo | 128,000 | 2023年11月 |

| Llama 2 | 4,096 | 2023年7月 |

这些差异反映了各机构在设计和算力权衡上的不同选择,窗口越大,应用越强大,但对计算资源的要求也越高。

上下文窗口的扩大是过去十年AI能力提升最显著的进步之一。早期循环神经网络(RNN)和长短期记忆网络(LSTM)在处理上下文时表现不佳,因为它们按顺序处理文本,难以保留输入中较远的信息。2017年Transformer架构的提出实现了全序列的并行处理,极大提升了模型跨长文保持上下文的能力。这一突破催生了2019年的GPT-2(1024 token窗口)、2020年的GPT-3(2048 token),最终发展到2023年的GPT-4(128,000 token)。每一次进步都扩展了可能性:更大窗口让模型能处理更长文档、保持多轮对话连贯、理解文本中相距较远的复杂关系。上下文窗口的指数级增长既受益于架构创新,也依赖于顶尖AI实验室不断增强的算力。

更大的上下文窗口极大拓展了AI模型的应用边界,使许多原本不可能或受限的场景成为现实。主要优势包括:

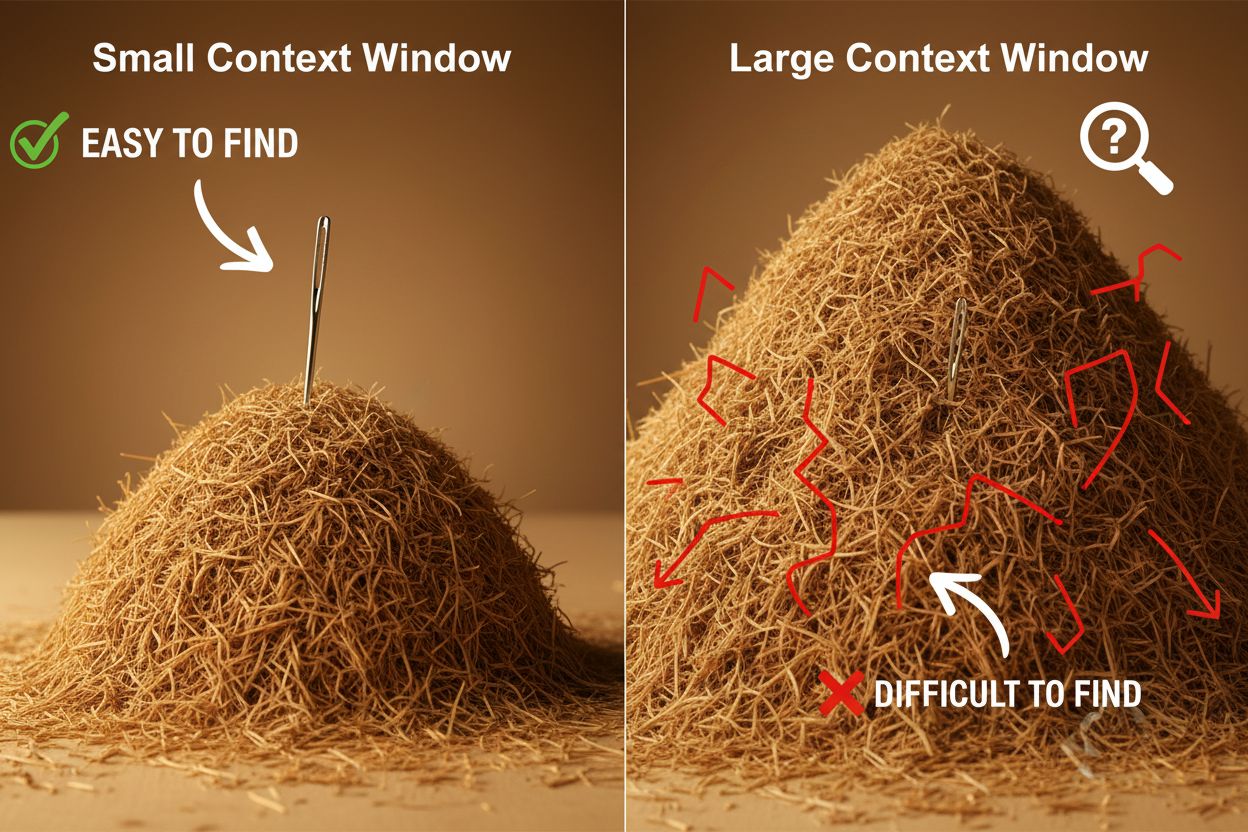

尽管大窗口带来诸多好处,但也带来显著的技术与实际挑战。最突出的是计算成本:处理更长序列需要指数级增长的内存和算力,注意力机制的二次扩展使大窗口运行更昂贵。由此还会带来响应延迟,窗口越大,响应越慢,影响实时应用体验。还有一个隐性但重要的问题是**“大海捞针”现象**:模型在超大窗口中反而难以定位和利用关键信息,有时效果不如小窗口。此外,**上下文腐蚀(context rot)**会导致窗口前段的信息对输出影响逐渐减弱,因为注意力资源被分摊到更长文本上。以上挑战意味着,盲目追求最大窗口并不总是最佳选择。

理解上下文腐蚀对于高效利用大窗口至关重要:随着序列变长,开头的token对模型输出的影响不断减弱,关键信息虽在窗口内却容易“被遗忘”。这是因为注意力预算——模型实际能关注的token数量——被长文本摊薄。幸运的是,已有多种先进技术应对这些限制。**检索增强生成(RAG)**通过将信息存储在外部数据库中,仅在需要时检索最相关内容,等效于拓展知识库而无需超大窗口。上下文压缩技术则通过摘要或压缩不重要信息,保留关键信息的同时降低token消耗。结构化笔记则鼓励用户分层、条理清晰地组织信息,便于模型优先获取关键概念。这些方法的核心在于有策略地筛选和整理进入窗口的信息,而不是一味塞满模型的“记忆”。

现代AI模型扩展的上下文窗口已解锁许多以往无法实现的实际场景。客户支持系统可以一次性回顾完整工单历史和相关文档,无需客户重复描述情况即可生成准确、贴合上下文的回复。文档分析与研究方面,模型能“吃下”整篇论文、合同或技术文档,快速提取关键信息并解答细致问题,大幅提升效率。代码审查与开发得益于足够大的窗口,模型可一次参考完整文件甚至多文件,理解架构并给出更智能建议。长内容创作和反复写作流程中,模型能持续把握全文语气、风格和结构,助力高效编辑。会议记录分析和研究综述可利用大窗口,从数小时对话或几十份资料中提炼洞见,发现人工难以察觉的主题和联系。这些应用都说明,上下文窗口的大小直接转化为各行业专业人士的实际价值。

上下文窗口的发展趋势显示,未来窗口还将进一步扩大,Gemini 1.5 Pro已实现100万token窗口,研究机构也在探索更大容量。除了“更大”,未来还会出现动态上下文窗口,根据任务智能调整窗口大小,复杂任务分配更多容量,简单任务则缩减以提升效率与降低成本。研究者也在开发更高效的注意力机制,试图突破目前限制窗口规模的二次扩展瓶颈。随着这些技术成熟,上下文窗口将不再是束缚,开发者可以将注意力转向AI能力与可靠性的其他方面。更大窗口、更高效率和更智能的上下文管理,将定义下一代AI应用,带来更多尚未想象的创新场景。

上下文窗口是指AI模型一次可以处理的全部文本量(以token计),而token限制则指模型能够处理的最大token数量。这两个术语常常互换使用,但上下文窗口特指模型单次推理时可用的工作记忆,而token限制还可以指输出约束或API用量限制。

更大的上下文窗口通常能提升回复质量,因为模型能参考更多相关信息,并更好地保持对话连贯性。然而,极大的窗口有时反而会因“上下文腐蚀”(context rot)而影响质量——模型难以在大量文本中优先处理重要信息。最佳上下文窗口大小取决于具体任务及信息组织程度。

更大的上下文窗口需要更多算力,是因为Transformer模型中注意力机制的计算复杂度呈二次增长。注意力机制需要计算每个token与其它所有token的关系,因此上下文窗口扩大一倍,计算需求大约增加四倍。这就是为何更大窗口更昂贵且响应更慢的原因。

“针在大海捞针”问题是指当AI模型需要在非常大的上下文窗口(‘大海捞针’)中查找和利用相关信息(‘针’)时遇到的困难。由于注意力机制被大量信息稀释,模型有时在极大窗口下反而更难识别关键信息,表现甚至不如较小窗口。

要最大化上下文窗口的有效性,应清晰分层地组织信息,将最重要内容放在上下文的开头或结尾,采用如JSON或markdown等结构化格式,并考虑使用RAG(检索增强生成)动态加载最相关信息。避免用无关细节占用token而无实质价值。

上下文窗口是模型一次能处理的技术容量,而对话历史是实际对话中前面消息的记录。对话历史必须适配于上下文窗口,但上下文窗口还包括系统提示、指令及其他元数据。对话历史可以比上下文窗口更长,需要摘要或截断处理。

当前没有真正拥有无限上下文窗口的AI模型,所有模型都受限于架构和算力。但如Gemini 1.5 Pro等模型已具备极大的窗口(100万token),且RAG等技术可通过动态检索有效扩展模型知识库超出上下文窗口。

上下文窗口大小直接影响API成本,因为更大窗口需要更多算力。大多数AI API按token用量计费,使用更大窗口意味着处理更多token、成本更高。有些服务商还对大窗口模型收取更高价格,因此选择合适模型大小很重要。

AmICited 跟踪 ChatGPT、Perplexity 和 Google AI Overviews 等AI系统如何引用和参考您的内容。了解您的AI可见度,并监控您的品牌在各大AI平台上的提及情况。

了解什么是 AI 语言模型中的上下文窗口,它们的工作原理、对模型性能的影响,以及它们为何对 AI 应用和监控至关重要。...

社区讨论 AI 上下文窗口及其对内容营销的影响。了解上下文限制如何影响 AI 对您内容的处理。

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.