企业级AI可见性解决方案:如何选择合适的平台

企业级AI可见性解决方案完整指南。对比Conductor、Profound和Athena等顶级平台。了解大型企业的评估标准及选择策略。

企业级AI可视化战略是指组织为监控、追踪和理解其基础设施内所有人工智能系统、模型和应用程序而实施的全面方法。该战略涵盖了了解AI系统的使用情况、性能表现、使用者身份以及这些系统在整个组织范围内带来的风险的能力。对于管理数百或数千个AI应用的大型企业来说,可视化尤为重要,因为影子AI(未经授权或未记录的AI工具)在缺乏适当监管的情况下可能迅速蔓延。如果没有全面的可视化,组织无法确保合规、管理风险、优化性能或从AI投资中获得最大价值。

企业级AI可视化战略是指组织为监控、追踪和理解其基础设施内所有人工智能系统、模型和应用程序而实施的全面方法。该战略涵盖了了解AI系统的使用情况、性能表现、使用者身份以及这些系统在整个组织范围内带来的风险的能力。对于管理数百或数千个AI应用的大型企业来说,可视化尤为重要,因为影子AI(未经授权或未记录的AI工具)在缺乏适当监管的情况下可能迅速蔓延。如果没有全面的可视化,组织无法确保合规、管理风险、优化性能或从AI投资中获得最大价值。

企业级AI可视化战略是指组织为监控、追踪和理解其基础设施内所有人工智能系统、模型和应用程序而实施的全面方法。该战略涵盖了了解AI系统的使用情况、性能表现、使用者身份,以及这些系统在整个组织范围内带来的风险的能力。对于管理数百或数千个AI应用的大型企业来说,可视化尤为重要,因为影子AI(未经授权或未记录的AI工具)在缺乏适当监管的情况下可能迅速蔓延。随着企业规模的扩大,这一挑战愈发严峻——85%的企业已在某种程度上使用AI,但只有11%报告获得了明确的业务价值,这表明部署与有效管理之间存在巨大差距。如果没有全面的可视化,组织无法确保合规、管理风险、优化性能或从AI投资中获得最大价值。

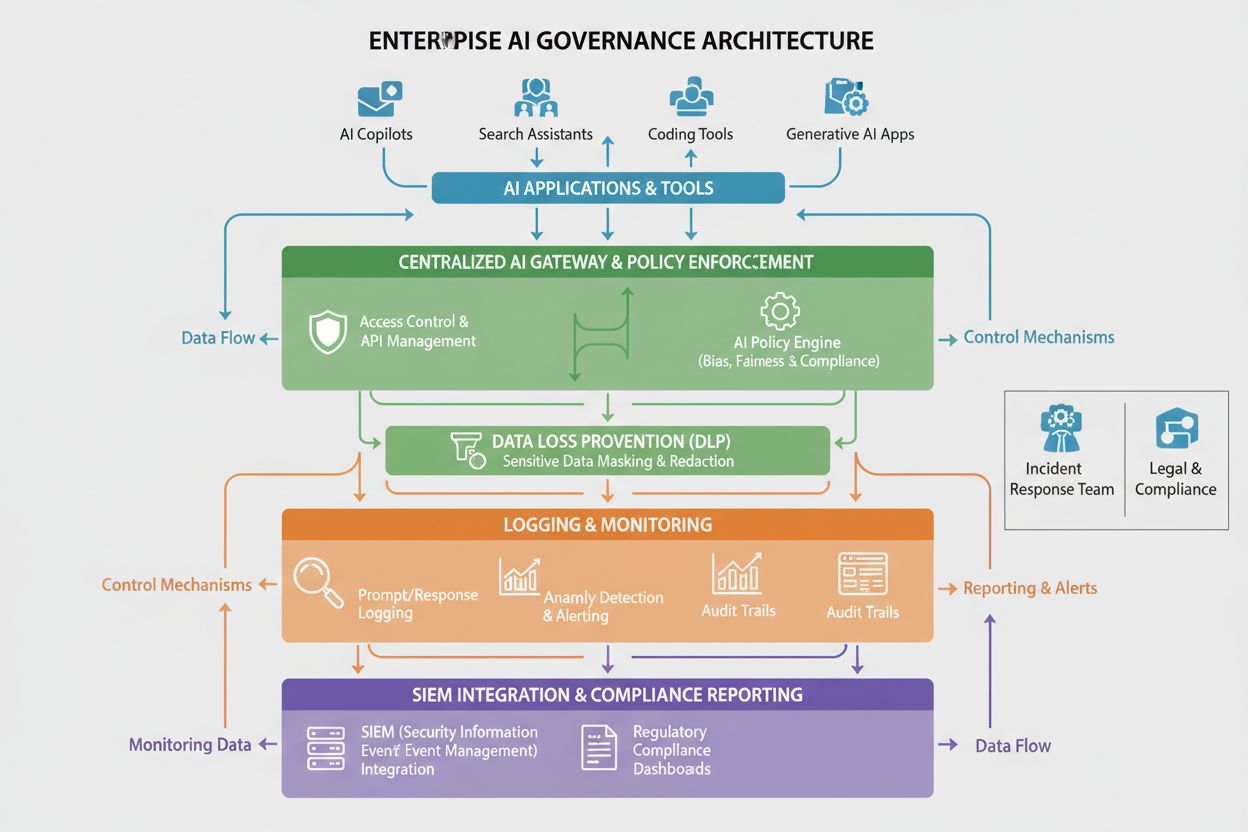

企业级AI可视化涵盖三个互相关联的维度,共同实现对AI系统及其影响的全方位组织认知。第一个维度,使用监控,追踪已部署的AI系统、访问者、使用频率及其业务用途。第二个维度,质量监控,确保AI模型按预期运行、保持准确标准,并防止因数据漂移或模型老化而性能下降。第三个维度,安全监控,防止未经授权访问、数据泄露、提示注入攻击,并确保符合法规要求。这三大维度需协同运作,辅以集中日志、实时仪表盘与自动化告警系统。全面实现这三大维度可视化的组织,治理成效和事件响应速度均显著提升。

| 维度 | 目的 | 关键指标 |

|---|---|---|

| 使用监控 | 跟踪AI系统的部署与使用模式 | 活跃用户、API调用、模型版本、业务部门采纳情况 |

| 质量监控 | 确保模型性能和可靠性 | 准确率、精确率、召回率、预测漂移、延迟 |

| 安全监控 | 防护威胁并确保合规 | 访问日志、检测到的异常、政策违规、审计追踪 |

组织在大规模、复杂环境下推行全面AI可视化时会遇到诸多障碍。影子AI或许是最突出的问题——员工和部门在IT不知情或未批准的情况下部署AI工具,形成盲区,阻碍集中监控和治理。数据孤岛导致部门间信息碎片化,难以关联AI使用模式或识别重复和资源浪费。集成复杂性体现在需将可视化工具与旧有系统、云平台和多样AI框架对接,而这些系统原本并未考虑可监控性。监管碎片化使不同地区需遵循不同可视化标准,增加了合规复杂性,对灵活、可适配的监控基础设施提出更高要求。此外,84%的IT主管表示缺乏正式治理流程,72%的组织存在数据质量问题,进一步削弱了可视化指标的可靠性。

主要可视化挑战包括:

高效的企业级AI可视化需与成熟的治理框架和标准对齐,为监控工作提供结构和公信力。**NIST AI风险管理框架(RMF)**提供了识别、衡量和管理AI风险的全面方法,为各组织职能部门的可视化需求奠定基础。ISO/IEC 42001制定了AI管理体系的国际标准,包括与可视化目标对齐的监控、文档和持续改进要求。欧盟AI法案对高风险AI系统提出了严格的透明度和文档记录要求,强制详实记录AI系统行为和决策过程。行业特定框架还有额外要求——金融服务需遵守银行监管AI治理标准,医疗需符合FDA临床AI系统要求,政府机构需遵守联邦AI治理指令。组织应根据行业、地域和风险状况选择框架,并建设可证明合规的可视化基础设施。

实施企业级AI可视化需强大的技术基础,对AI系统行为和性能的数据进行捕获、处理和呈现。集中式AI平台作为可视化基础设施的核心,无论AI系统部署在哪,均可在同一界面监控。AI网关充当应用与AI服务之间的中介,捕获每次请求与响应的元数据,实现细致的使用追踪和安全监控。全面日志系统集中记录所有AI活动、模型预测、用户互动及性能指标,支持审计追踪和取证分析。数据防泄漏(DLP)工具监控AI系统的数据外泄行为,防止模型被训练于机密数据或响应中泄露敏感信息。SIEM集成将AI可视化数据纳入更广泛的安全信息与事件管理系统,实现AI相关安全事件与其他威胁的关联分析。应用这些技术组件的组织在AI相关安全事件发生时,事件响应时间平均缩短30%。例如Liminal、Ardoq、Knostic等平台聚焦于治理型可视化方案,AmICited.com则专注于GPT、Perplexity和Google AI Overviews等AI答案质量的监控。

成功的企业级AI可视化需明确组织架构和职责分工,将监控与治理责任分布到全组织。AI治理委员会通常作为执行机构,统筹AI可视化战略、制定政策,确保与业务目标和法规要求对齐。模型负责人对具体AI系统负责,确保其符合组织标准的文档记录、监控和维护。AI推动者嵌入业务单元,作为IT治理与终端用户间的桥梁,推动可视化实践并在影子AI失控前及时发现。数据管理员负责训练和监控AI系统所用数据的质量与可用性,确保可视化指标可靠可信。安全与合规团队制定监控要求、执行审计并确保可视化基础设施符合法规。清晰的责任划分确保可视化不是IT部门的专属责任,而是需要业务、技术与治理多方共同承诺的组织级任务。

组织需制定明确的关键绩效指标(KPI)和衡量框架,评估AI可视化战略是否为组织目标创造价值。可视化覆盖率衡量已记录和监控的AI系统比例,成熟组织目标为95%以上。治理成熟度以CMMI等框架衡量,从临时监控到标准化流程再到优化自动化治理的阶段进展。事件检测与响应指标反映组织发现及应对AI问题的速度,检测和响应时间提升表明可视化更高效。合规达标率监控AI系统满足监管和内部标准的比例,审计发现与整改时效为关键参考。业务价值实现衡量可视化投资是否带来风险降低、模型性能提升、AI项目上市加速或资源优化等具体收益。组织应部署实时仪表盘,向各方展示上述指标,实现持续监控和在出现可视化缺口时迅速调整。

不同行业因监管环境、风险特征和业务模式差异,对AI可视化有独特要求,需量身定制监控方案。金融服务需符合银行监管机构的AI治理要求,包括对信贷、反欺诈和交易算法等AI系统的详细监控,特别强调偏见检测和公平性指标。医疗行业需满足FDA对临床AI系统的要求,包括模型性能验证、安全监控和AI影响临床决策的文档。法律行业在合同分析、法律检索和尽职调查等AI应用中,需确保训练数据的可视化以防泄密、维护律师-客户保密权。政府机构必须遵守联邦AI治理指令,包括透明度、偏见审计和决策过程文档等要求,确保公众问责。零售与电商需监控推荐引擎和个性化AI系统,符号消费者保护法规和公平竞争法。制造业需追踪应用于质控和预测性维护的AI系统,确保安全与可靠性。行业专属可视化要求应纳入整体治理框架,而非孤立的合规举措。

推行企业级AI可视化建议采用分阶段方法,既实现快速成果,又为成熟治理能力奠定基础。从资产清查与文档入手——审计所有现有AI系统,包括影子AI,建立中心化登记,记录系统用途、负责人、数据源和业务关键性。聚焦快速获益点,优先监控高风险系统,如面向客户的AI、处理敏感数据的系统或对个人决策有重大影响的模型。实施集中日志作为基础能力,记录所有AI活动的元数据,便于实时监控与历史分析。制定治理政策,明确AI系统的文档、监控和合规标准,并向全员清晰传达。组建跨职能团队,涵盖IT、安全、业务和合规,确保可视化项目兼顾各方关切。衡量并传播进展,持续跟踪可视化指标,向管理层报告结果,证明治理投资价值,并为AI可视化基础设施的持续投入赢得组织支持。

AI可视化是指了解和监控AI系统行为的能力,而AI治理则是管理AI系统开发、部署和使用的更广泛的政策、流程和控制框架。可视化是治理的基础组成部分——无法治理看不见的系统。高效的AI治理需要在使用、质量和安全监控三大维度实现全面可视化。

大型组织在多个部门、云服务商和业务单元之间管理数百甚至数千个AI应用,面临独特的挑战。没有全面的可视化,影子AI会大量出现,合规风险上升,组织无法优化AI投资或确保负责任的AI使用。可视化有助于发现风险、执行政策,并从AI项目中获得最大价值。

可视化薄弱会带来多重风险:影子AI系统在无监管下运行,敏感数据可能通过未监控的AI系统泄漏,合规违规未被发现,模型性能下降得不到识别,安全威胁未被察觉,组织无法向监管机构证明治理能力。这些风险可能导致数据泄露、监管罚款、声誉损害和客户信任流失。

影子AI——指未经IT知情而部署的未授权AI工具——会造成盲区,阻碍集中监控和治理。员工可能会在无组织监管情况下使用如ChatGPT等公共AI服务,潜在泄露敏感数据或违反合规要求。影子AI还会导致重复工作、资源浪费和无法执行组织AI政策与标准。

专为AI治理打造的平台如Liminal、Ardoq和Knostic可实现集中监控、政策执行和合规报告。这些平台可集成AI服务,捕捉详细日志、检测异常,并为治理团队提供仪表盘。此外,AmICited专注于监控GPT、Perplexity和Google AI Overviews等AI系统如何引用您的品牌,提升对AI答案质量的可视化。

欧盟AI法案、GDPR、CCPA等监管框架,以及行业特定法规(如银行业OCC、医疗行业FDA)均要求特定的可视化和文档记录。组织必须实施可用于证明合规的监控措施,包括审计追踪、偏见测试、性能监控和AI系统决策的文档。可视化基础设施需设计以满足这些监管义务。

关键指标包括:可视化覆盖率(已记录和监控的AI系统占比)、治理成熟度(治理阶段推进情况)、事件检测与响应时间、合规达标率(系统满足监管要求的比例)、以及可视化投资的业务价值实现(可量化的收益)。还应监控使用指标(活跃用户、API调用)、质量指标(准确率、漂移)和安全指标(检测到的异常、政策违规)。

具体时间取决于组织规模与复杂性。初步的可视化基础设施(资产清单、基础日志、仪表盘)可在3-6个月建立。实现对全部AI系统的全面可视化通常需6-12个月。达到成熟、优化的治理能力通常需12-24个月。建议采用分阶段方法,先覆盖高风险系统和快速获益项目,再逐步扩展至全覆盖。

企业级AI可见性解决方案完整指南。对比Conductor、Profound和Athena等顶级平台。了解大型企业的评估标准及选择策略。

了解如何向高管层展示AI可见性成果。探索关键指标、仪表盘设计,以及高管AI报告与治理的最佳实践。

了解AI可见性成熟度模型,这是一种评估组织AI监控与治理准备度的框架。探索5个成熟度等级、关键维度及实施策略。

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.