AI 可见性工作的透明度:披露最佳实践

学习 AI 透明度和披露的关键最佳实践。了解行为、口头和技术披露方法,以建立信任并确保遵守不断变化的 AI 法规。

金融机构在决策、风险管理及面向客户的应用中使用人工智能时,需透明披露其使用情况的监管要求。涵盖美国证券交易委员会(SEC)、消费者金融保护局(CFPB)、金融业监管局(FINRA)及其他监管机构对于人工智能治理、模型表现以及对消费者和市场影响的记录要求。

金融机构在决策、风险管理及面向客户的应用中使用人工智能时,需透明披露其使用情况的监管要求。涵盖美国证券交易委员会(SEC)、消费者金融保护局(CFPB)、金融业监管局(FINRA)及其他监管机构对于人工智能治理、模型表现以及对消费者和市场影响的记录要求。

金融人工智能披露指的是金融机构在决策流程、风险管理及面向客户的应用中,需透明披露其人工智能使用情况的监管要求与最佳实践。它涵盖美国证券交易委员会(SEC)、消费者金融保护局(CFPB)、金融业监管局(FINRA)以及其他监管机构对于人工智能治理、模型表现及对消费者和市场潜在影响的记录要求。2024年12月,SEC投资者咨询委员会(IAC)提出正式建议,要求SEC发布指导意见,要求发行人披露人工智能对其公司的影响。IAC指出,当前AI披露“缺乏一致性”,这“对寻求清晰、可比信息的投资者来说可能是个问题”。仅有40%的标普500公司提供了与AI相关的披露,仅有15%披露了董事会对AI的监督信息,尽管有60%的标普500公司将AI视为重大风险。

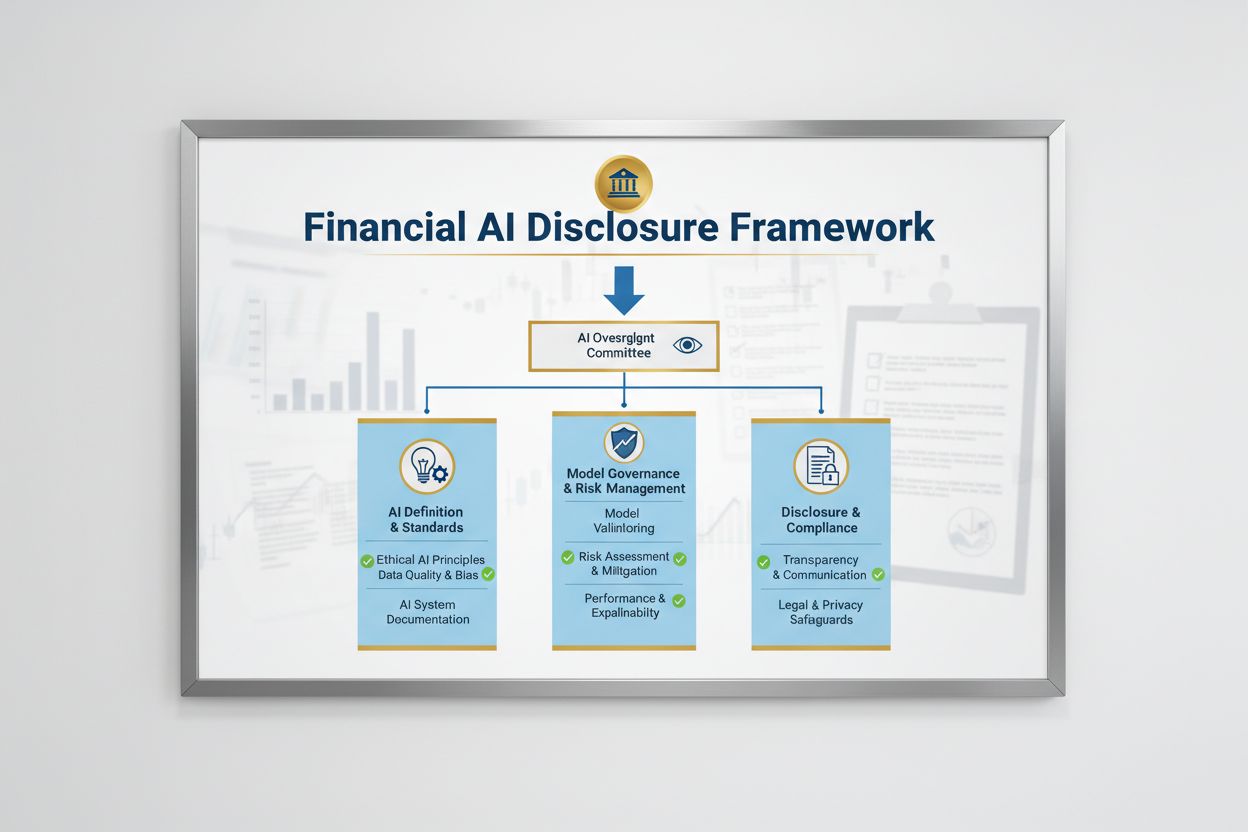

金融人工智能披露的监管格局由多个联邦机构通过适用于AI系统的现有技术中立法律共同塑造。SEC投资者咨询委员会提出了三大框架支柱:(1)要求发行人明确定义“人工智能”的含义;(2)披露人工智能部署的董事会监督机制;(3)报告重大人工智能部署及其对内部运营和面向消费者产品的影响。除SEC外,CFPB、FINRA、美国货币监理署(OCC)和联邦储备委员会也发布了指导意见,强调现有消费者保护法律——包括公平放贷、数据隐私和反欺诈法规——无论技术如何变化,均适用于AI系统。这些机构采取技术中立的方法,意味着平等信贷机会法(ECOA)、公平信用报告法(FCRA)、金融服务现代化法案(GLBA)及“不公平或欺骗性行为或做法”(UDAAP)等合规义务在涉及AI时并未改变。

| 监管机构 | 关注领域 | 核心要求 |

|---|---|---|

| SEC | 投资者披露、利益冲突 | 明确定义AI,披露董事会监督,报告重大部署 |

| CFPB | 公平放贷、消费者保护 | 确保AI模型符合ECOA,提供不利决定通知 |

| FINRA | 经纪商运营、客户沟通 | 建立AI治理政策,监督全流程AI使用 |

| OCC/联邦储备/FDIC | 银行模型治理、操作风险 | 验证AI模型,记录控制措施,评估可靠性 |

| FTC | 欺骗行为、数据处理 | 监控AI相关声明,防止不公平数据使用 |

有效的金融人工智能披露要求对人工智能部署和风险管理进行明确的董事会层级监督。SEC投资者咨询委员会的建议强调,投资者有权了解在内部业务运营和产品线中部署AI技术时,是否存在明确的权责分工。金融机构必须建立治理架构,将AI监督责任分配给董事会或指定委员会,确保AI相关风险在最高层级得到管理。治理框架应包括AI开发、测试、验证、部署的书面政策和流程,并定期向董事会报告模型表现、已识别风险及整改措施。如缺乏明确的董事会问责,金融机构可能因对重大AI系统监督不力而面临监管审查及潜在执法行动。

金融机构必须分别披露AI部署对内部业务运营和面向消费者产品的重大影响。对于内部运营,应披露AI对人力资本(如裁员或技能提升需求)、财务报告准确性、治理流程和网络安全风险的影响。对于面向消费者事项,机构应披露对AI驱动平台的投资、AI在产品和服务中的集成、AI使用带来的监管影响,以及AI如何影响定价策略或业务基准。SEC建议将这些披露整合进现有的Regulation S-K披露项目(如101、103、106和303条款),并以重大性为导向,而非新设披露类别。这一做法便于金融机构利用现有框架,同时为投资者提供关于AI在机构运营和战略方向中作用的清晰、可比信息。

高质量数据是金融服务领域负责任AI部署的基础,但许多机构难以建立符合监管预期的数据治理框架。金融机构必须确保用于训练、测试和验证AI模型的数据干净、完整、标准化且全面,并对数据来源、数据流转及已知局限进行详尽记录。数据安全保护措施要防止“数据投毒”——即训练数据被篡改以破坏模型完整性,并防止敏感信息被未经授权访问或泄露。金融服务现代化法案(GLBA)为消费者金融数据提供基础保护,但许多监管者和消费者倡导者认为,在AI背景下这些保护措施还不够充分,尤其是在数据收集和模型训练用途大幅扩展的情况下。金融机构还需解决知识产权问题,确保有权使用相关数据进行AI开发,并尊重第三方知识产权。建立健全的数据治理框架,包括数据最小化原则、访问控制和定期审计,是展现监管合规能力的关键。

监管机构明确要求在金融决策中使用的AI模型必须进行偏见和歧视性结果的测试,无论其总体准确率或性能如何。“黑箱”问题——即复杂AI系统生成的输出难以或无法解释——在面向消费者的信用授信、定价和欺诈检测等应用中带来重大合规风险。金融机构需在模型全生命周期内检测和缓解偏见,包括开发、验证及持续监控阶段的偏见测试。公平放贷合规要求机构能够解释不利决策(如信贷拒绝)的具体原因,并证明其AI模型不会对受保护群体造成差别影响。对“更少歧视性替代方案”的测试——即在实现业务目标的基础上减少偏见的方法——正逐步成为监管期望。越来越多机构采用可解释人工智能(xAI)技术,如特征重要性分析和决策树,以提升AI决策的透明度和责任性。

在面向消费者的应用中使用AI的金融机构,必须遵守现有的消费者保护法律,包括不利决定通知、数据隐私披露及公平对待等要求。当AI系统用于或显著影响信用、保险或其他金融产品的决策时,消费者有权了解被拒绝或获得不利条件的原因。CFPB强调,受平等信贷机会法(ECOA)约束的放贷机构不得在无法提供具体、准确不利决定原因的情况下使用“黑箱”模型。此外,“不公平或欺骗性行为或做法”(UDAAP)标准也适用于可能因数据收集不透明、隐私侵犯或导向不适宜产品而损害消费者利益的AI系统。金融机构必须确保用于客户服务、产品推荐和账户管理的AI系统,透明说明AI的使用情况,并就消费者数据如何被收集、使用和保护进行清晰披露。

大多数金融机构依赖第三方供应商开发、部署或维护AI系统,带来重要的第三方风险管理(TPRM)义务。联邦银行机构的《第三方关系联席指导意见》强调,即便金融机构未自行开发模型,也要对第三方AI系统的表现和合规性负责。有效的AI TPRM需在选择供应商前开展尽职调查,包括评估供应商的数据治理、模型验证流程及对模型操作透明度的能力。金融机构还需监测集中风险——即少数AI供应商发生中断或故障时可能引发的系统性影响。供应链风险,包括数据来源的可靠性和第三方基础设施的稳定性,也必须进行评估和记录。与AI供应商的合同中应明确数据安全、模型性能监控、事件报告和系统审计或测试的相关条款。尤其是中小金融机构,可能因技术能力有限而难以评估复杂AI系统,这对行业标准或认证机制提出了更高的需求。

跨境经营的金融机构面临日益复杂的AI监管格局,其中欧盟人工智能法案是迄今最全面的监管框架。欧盟AI法案将用于信用评分、反欺诈和反洗钱的AI系统归为“高风险”,要求详尽的文件、偏见测试、人为监督及合规评估。OECD和G7也发布了金融服务领域负责任AI治理的原则和建议,强调透明度、公平性、问责制和人为监督。许多国际标准具有域外效力,意味着为欧盟、英国或其他受监管司法辖区客户服务的金融机构,即便总部位于其他地区,也可能需遵守相关标准。全球监管协调仍在推进,但不同司法辖区间存在重大差异,给全球金融机构带来合规挑战。主动对标最高国际标准——如欧盟AI法案和OECD原则——有助于机构为未来监管变化做准备,并降低在多地遭遇执法行动的风险。

金融机构应建立完善的文档和治理措施,以证明对金融人工智能披露的合规。主要最佳实践包括:

通过实施上述措施,金融机构可降低监管风险,增强利益相关方信任,并在金融服务行业内树立负责任AI部署的领先地位。

金融人工智能披露是指金融机构在决策、风险管理及面向客户的应用中,需透明披露其使用人工智能的监管要求。它涵盖SEC、CFPB、FINRA及其他监管机构对于人工智能治理、模型表现以及对消费者和市场影响的记录要求。2024年12月,SEC投资者咨询委员会建议金融机构明确人工智能使用情况、披露董事会监督机制,并报告重大AI部署。

金融机构必须披露人工智能的使用情况,以保护投资者、消费者和市场的完整性。监管机构发现,只有40%的标普500公司提供了与人工智能相关的披露,导致投资者信息不一致和信息缺口。披露要求确保利益相关方了解人工智能如何影响金融决策、风险管理和消费者结果。此外,现有的消费者保护法律——包括公平放贷和数据隐私法规——也适用于人工智能系统,使得披露成为合规的关键。

SEC投资者咨询委员会提出了人工智能披露的三大支柱建议:(1)要求发行人明确定义“人工智能”的含义;(2)披露人工智能部署的董事会监督机制;(3)报告重大人工智能部署及其对内部运营和面向消费者产品的影响。这些建议旨在为投资者提供关于人工智能如何影响金融机构运营和战略方向的清晰、可比信息。

金融人工智能披露专注于对外部利益相关者(投资者、监管者、消费者)透明沟通人工智能使用的监管要求,而一般的人工智能治理则指机构内部对AI系统的管理流程和控制。披露是人工智能治理的对外部分,确保利益相关方获得关于人工智能部署、风险和影响的重要信息。两者对于金融服务领域负责任的人工智能部署都至关重要。

人工智能部署披露应涵盖内部运营和面向消费者的影响。对于内部运营,应披露对人力资本、财务报告、治理和网络安全风险的影响。对于面向消费者的产品,应披露对AI驱动平台的投资、AI在产品中的集成、监管影响及人工智能如何影响定价或业务策略。披露应基于重大性原则,整合进现有的监管披露项目(如SEC Regulation S-K)。

包括平等信贷机会法(ECOA)和公平信用报告法(FCRA)在内的公平放贷法律,适用于用于信贷决策的人工智能系统,无论使用何种技术。金融机构必须能够解释不利决策(如信贷拒绝)的具体原因,并证明其人工智能模型不会对受保护群体产生差别影响。监管机构要求机构对AI模型进行偏见测试,在适当情况下采用“更少歧视性替代方案”,并保留公平性测试和验证的文档。

大多数金融机构依赖第三方供应商提供人工智能系统,这带来了重要的第三方风险管理(TPRM)义务。即使金融机构未自行开发模型,也要对第三方AI系统的表现和合规性负责。有效的TPRM需要开展尽职调查、持续监控、评估供应商数据治理实践,并记录模型表现。机构还需关注集中风险——即少数AI供应商发生中断时的系统性影响。

欧盟人工智能法案是最全面的AI监管框架,将金融人工智能系统归为“高风险”,要求广泛的文档、偏见测试和人工监督。经合组织(OECD)和G7也发布了负责任人工智能治理原则。许多国际标准具有域外效力,意味着为受监管司法辖区客户提供服务的金融机构可能需遵守这些标准。主动对标国际标准有助于机构应对未来监管变化,降低执法风险。

学习 AI 透明度和披露的关键最佳实践。了解行为、口头和技术披露方法,以建立信任并确保遵守不断变化的 AI 法规。

监控您的金融品牌在AI生成答案中的展现方式。了解合规要求、可见性策略以及适用于受监管金融服务的优化技术。

了解人工智能认证如何通过标准化框架、透明度要求和第三方验证来建立信任。了解CSA STAR、ISO 42001及合规标准。

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.