什么是向量搜索及其工作原理?

了解向量搜索如何利用机器学习嵌入,根据意义而非精确关键词来查找相似项。掌握向量数据库、ANN算法及其在现实中的应用。...

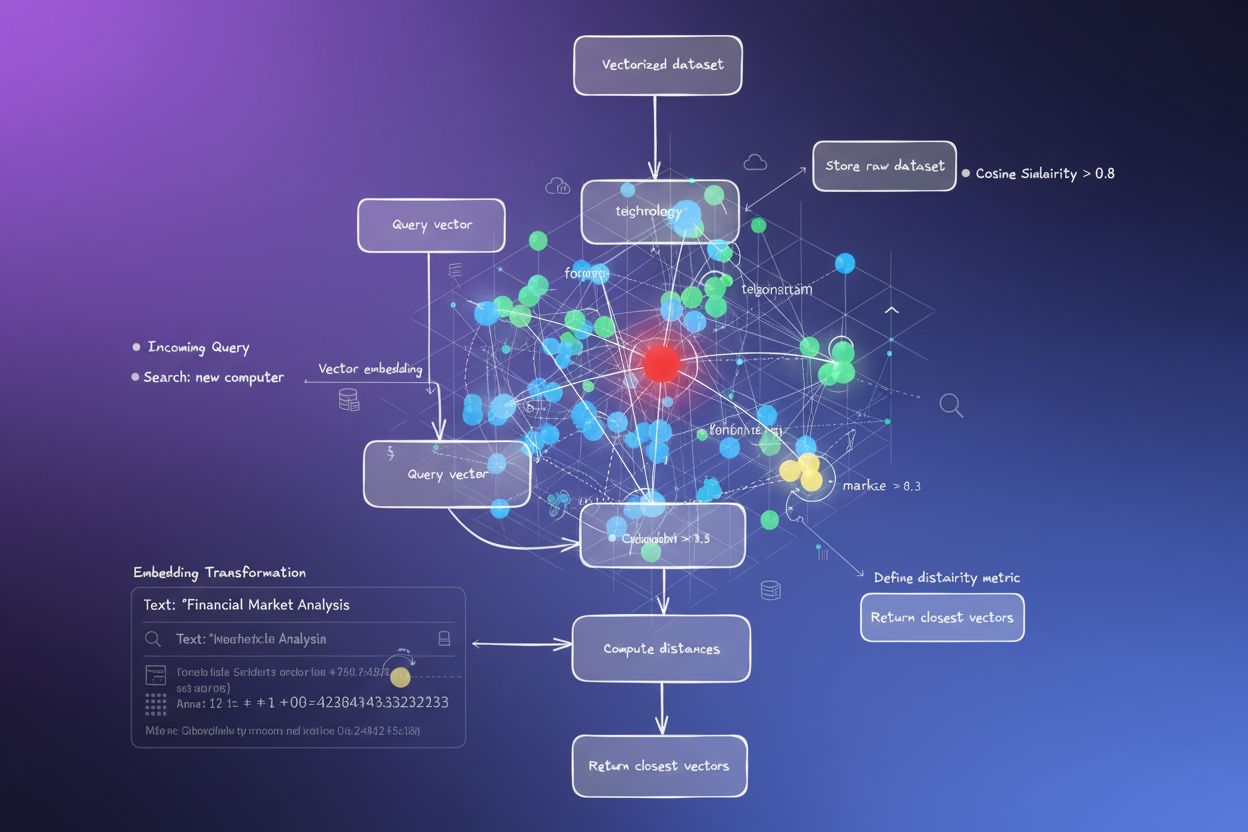

向量搜索是一种通过将数据表示为数学向量,并利用余弦相似度或欧氏距离等距离度量进行比较,从而在数据集中查找相似项的方法。这种方法实现了超越关键词匹配的语义理解,使系统能够基于含义而非精确文本匹配发现关系和相似性。

向量搜索是一种通过将数据表示为数学向量,并利用余弦相似度或欧氏距离等距离度量进行比较,从而在数据集中查找相似项的方法。这种方法实现了超越关键词匹配的语义理解,使系统能够基于含义而非精确文本匹配发现关系和相似性。

向量搜索是一种通过将数据表示为数学向量,并利用距离度量来衡量语义相似性的方式,在数据集中查找相似项的方法。与依赖精确文本匹配的传统关键词搜索不同,向量搜索通过将数据转换为称为向量嵌入的高维数值表示,能够理解数据背后的含义和上下文。这种方法使系统能够基于语义内容而非表层特征发现关系和相似性,尤其适用于需要理解上下文的应用场景。向量搜索已成为现代 AI 系统的基础能力,支撑着语义搜索、推荐引擎、异常检测和检索增强生成(RAG),广泛应用于ChatGPT、Perplexity、Google AI Overviews 和 Claude 等平台。

从本质上讲,向量搜索将数据转化为数值表示,空间中的距离反映语义相似性。每个数据点——无论是文本、图像还是音频——都会被转换为一个向量,本质上是代表特征或含义的数字数组。例如,“餐厅”这个词可以被表示为 [0.2, -0.5, 0.8, 0.1],每个数字对应该词语义含义的不同方面。核心原则是,语义相似的项在高维空间中的向量会彼此靠近,而不相似的则相距较远。这种数学结构让计算机能够基于含义而非关键词进行概念比较,使得“最佳用餐场所”的搜索结果可以返回“高评分餐厅”,即便没有词汇重叠。

将数据转换为向量的过程称为嵌入,由经过大规模数据集训练的机器学习模型完成。这些模型通过处理数十亿样本,学习将相似概念映射到向量空间的相邻位置。常见的嵌入模型包括 Word2Vec(通过上下文学习词语关系)、BERT(双向编码器,捕捉上下文含义)和 CLIP(对比语言-图像预训练,支持多模态数据)。生成的嵌入通常有 100 到 1000 以上维度,形成丰富的语义关系数学表示。当用户发起搜索请求时,系统会用相同的嵌入模型将查询转化为向量,并与所有已存储向量计算距离,找出最相似的项。

向量搜索依赖于距离度量来量化两个向量的相似程度。三种主要度量方式为:余弦相似度、欧氏距离和点积相似度,各自具有不同的数学特性和应用场景。余弦相似度衡量两个向量间的夹角,取值范围为 -1 到 1,其中 1 表示完全同向(最大相似),0 表示正交(无关)。这种度量方式在 NLP 中尤为重要,因为它只关注语义方向,不受向量长度影响,非常适合比较不同长度文档。欧氏距离则计算高维空间中两个向量之间的直线距离,同时考虑幅度和方向,适合需要重视向量大小的场景(如购买频率影响推荐系统)。

点积相似度兼具上述两种方式的特点,既考虑幅度又考虑方向,计算效率高。许多大型语言模型在训练时采用点积,因此在相关应用中也应采用点积度量。选择合适的距离度量至关重要——研究表明,采用与训练嵌入模型相同的度量方式,能获得最佳效果。例如 all-MiniLM-L6-v2 模型采用余弦相似度训练,在索引中使用余弦相似度会获得最准确的结果。组织在实现向量搜索时,必须结合嵌入模型和具体场景,精确匹配距离度量以保证准确性与性能。

| 方面 | 向量搜索 | 关键词搜索 | 混合搜索 |

|---|---|---|---|

| 匹配方式 | 基于含义的语义相似性 | 精确词语或短语匹配 | 结合语义与关键词匹配 |

| 查询理解 | 理解意图和上下文 | 需查询中包含精确关键词 | 利用两种方法实现全面结果 |

| 同义词处理 | 自动查找同义词及相关词 | 除非显式索引,否则无法识别同义词 | 通过双重方式捕捉同义词 |

| 模糊查询表现 | 优秀——理解意图 | 较差——需精确关键词 | 很好——兼顾两种理解 |

| 计算成本 | 较高——需嵌入及相似度计算 | 较低——字符串匹配 | 中等——并行运行两种搜索 |

| 可扩展性 | 需专用向量数据库 | 可用传统数据库 | 需支持混合搜索的系统 |

| 应用场景 | 语义搜索、推荐、RAG、异常检测 | 精确短语检索、结构化数据 | 企业搜索、AI 监测、品牌跟踪 |

| 示例 | 搜“健康晚餐创意”可找到“营养餐备” | 仅返回包含“健康”和“晚餐”的结果 | 既找精确匹配,也找语义相关内容 |

实现向量搜索需要多个相互关联的步骤,将原始数据转化为可搜索的语义表示。第一步是数据采集与预处理,对原始文档、图片等数据进行清洗和标准化。接着进行向量转换,通过嵌入模型将每条数据转为 100 到 1000 以上维度的数值向量。随后,这些向量被存储在向量数据库或针对高维数据优化的索引结构中。当有搜索请求到来时,系统会用相同的嵌入方式将查询转为向量。接下来,系统利用距离度量计算查询向量与所有已存向量的相似度分数,并按距离远近排序返回结果。

为实现大规模高效检索,系统采用近似最近邻(ANN)算法,如 HNSW(分层可导航小世界)、IVF(倒排文件索引)或 ScaNN(可扩展最近邻)。这些算法以牺牲极少精度为代价,大幅提升检索速度,使得数百万乃至数十亿向量的搜索可在毫秒级完成。例如,HNSW 将向量组织为多层图结构,高层提供远程连接以加速遍历,底层则提供精确连接以提升查准率。这种分层结构将搜索复杂度由线性 O(n) 降低到对数级 O(log n),大幅提升了大规模向量搜索的可行性。算法选择需结合数据集规模、查询量、延迟需求及计算资源等因素。

向量搜索已成为AI 监测平台(如 AmICited)跨 AI 系统追踪品牌提及的核心能力。传统基于关键词的监测无法发现改述、上下文引用以及品牌名或域名的语义变体。向量搜索让这些平台即使在措辞不同的 AI 生成回答中,也能检测到品牌被提及。例如,若您的域名为“amicited.com”,向量搜索可识别“AI 提示监测平台”或“生成式 AI 品牌可见度”等语境与您的业务相关,而无需明确出现 URL。这种语义理解对AI 引用追踪至关重要,覆盖 ChatGPT、Perplexity、Google AI Overviews 和 Claude 等全平台。

向量搜索技术市场正在爆发式增长,反映出企业对其价值的高度认可。市场研究显示,向量数据库市场在 2024 年估值 19.7 亿美元,预计到 2032 年将达 106 亿美元,复合年增长率(CAGR)为 23.38%。此外,Databricks 报告称自 2023 年 12 月推出向量搜索公测起,向量数据库采用率一年内增长了 186%。这一迅猛增长表明,企业已将向量搜索视为 AI 基础设施。对于关注自身在 AI 系统中表现的组织,向量搜索提供了捕捉所有有效提及的语义理解能力,而不仅仅是关键词匹配。

向量搜索在大规模场景下的性能高度依赖于能够平衡速度、准确性和内存占用的高级索引技术。HNSW(分层可导航小世界)已成为最流行的方案之一,将向量组织为多层图,每层连接范围逐步缩短。算法在顶层通过长距离连接实现快速遍历,逐层向下则利用更精确的短距离连接。研究显示,HNSW 能实现 99% 以上的召回率,同时保持亚毫秒级查询延迟。但 HNSW 的内存消耗较大——基准测试表明,索引 100 万个向量约需 0.5GB 至 5GB 的内存,具体取决于参数,因此大规模部署时必须重视内存优化。

IVF(倒排文件索引)则通过对向量进行聚类,并以聚类中心索引,大幅减少搜索空间,仅对相关聚类进行检索。ScaNN(可扩展最近邻)由 Google Research 开发,专为内积搜索优化,非常适合推荐系统。Product Quantization (PQ) 则通过将向量切分为子向量并分别量化,大幅压缩内存占用(可达 10-100 倍),以牺牲部分精度为代价。组织在实现向量搜索时,需根据自身对召回精度、检索速度、内存效率等指标的权衡选择合适的索引技术。该领域发展迅速,新的算法与优化方案不断涌现,以应对高维向量运算的计算挑战。

随着 AI 系统日益复杂、企业应用加速,向量搜索的定义与应用也在持续进化。未来趋势将朝着混合搜索系统发展,将向量搜索与传统关键词搜索及高级过滤能力结合。这类混合方案兼具向量搜索的语义理解与关键词匹配的精确性与易用性,为复杂查询带来卓越体验。此外,多模态向量搜索正成为关键能力,使系统能基于统一嵌入空间同时搜索文本、图片、音频和视频,极大提升搜索体验的直观性和全面性。

对于关注自身在 AI 系统中表现的组织而言,向量搜索的演进具有深远意义。随着 ChatGPT、Perplexity、Google AI Overviews 和 Claude 等平台越来越多地依赖向量搜索进行内容检索与排序,您的品牌如何在语义层面被 AI 理解和体现,已和传统关键词可见度同等重要。向语义理解的转变要求品牌监测与AI 引用追踪超越简单的关键词检测,捕捉上下文提及与语义关系。投资于向量搜索及其应用的企业,将更有能力优化自身在生成式 AI 系统中的可见度。向量搜索与 AI 监测平台的结合,标志着品牌在 AI 驱动信息生态中理解和管理自身影响力的根本性转变。

传统的关键词搜索是在文档中查找精确的词语匹配,而向量搜索则理解语义含义和上下文。向量搜索将文本转换为称为嵌入的数值表示,从而即使没有完全匹配的关键词也能找到相关结果。例如,使用向量搜索查找“无线耳机”时,也会返回“蓝牙耳塞”等结果,因为它们有相似的语义含义,而关键词搜索则会错过这种关联。

向量嵌入是数据(文本、图像、音频)的数值表示,被转换为捕捉语义含义的数字数组。它们通过 Word2Vec、BERT 或基于 Transformer 的模型等机器学习模型生成,这些模型能够学习将相似概念映射到高维空间中的相近位置。例如,“king”和“queen”这两个词的嵌入会非常接近,因为它们有语义关系,而“king”和“banana”会相距很远。

三种主要的距离度量是余弦相似度(衡量向量间夹角)、欧氏距离(衡量直线距离)和点积相似度(考虑幅度和方向)。余弦相似度在自然语言处理应用中最常见,因为它关注语义方向而不受向量大小影响。选择的度量应与训练嵌入模型时所用的一致,以获得最佳准确性。

向量搜索使得像 AmICited 这样的 AI 监测平台能够跨 ChatGPT、Perplexity、Google AI Overviews、Claude 等 AI 系统追踪品牌提及,不再依赖于精确关键词匹配,而是理解语义上下文。这可以识别改述提及、相关概念和上下文引用,为企业全面了解自身在多平台 AI 生成回应中的出现方式提供支持。

像 HNSW(分层可导航小世界)这样的 ANN 算法能够通过查找近似而非精确的最近邻,实现对数百万向量的快速相似性搜索。这些算法利用分层图结构,将搜索复杂度从线性降低到对数级,使向量搜索在大规模应用中变得可行。HNSW 通过在高层建立远程连接实现更快的遍历。

企业产生了海量的非结构化数据(邮件、文档、工单),而传统关键词搜索难以有效组织这些数据。向量搜索能够实现对数据的语义理解,推动智能搜索、推荐系统、异常检测和检索增强生成(RAG)等应用。市场研究显示,向量数据库市场预计将从 2025 年的 26.5 亿美元增长到 2030 年的 89.5 亿美元,反映了企业的广泛采用。

向量数据库是针对存储、索引和查询高维向量数据进行了优化的专用系统。它们实现了如 HNSW、IVF(倒排文件索引)和 ScaNN 等高效索引技术,实现大规模下的快速相似性搜索。典型产品包括 Milvus、Pinecone、Weaviate 和 Zilliz Cloud。这些数据库能够处理向量运算的计算复杂性,让企业无需管理底层基础设施就能构建生产级的语义搜索和 AI 应用。

了解向量搜索如何利用机器学习嵌入,根据意义而非精确关键词来查找相似项。掌握向量数据库、ANN算法及其在现实中的应用。...

了解 AI 搜索索引如何将数据转换为可搜索的向量,使 ChatGPT、Perplexity 等 AI 系统能够从您的内容中检索并引用相关信息。

了解向量嵌入如何使AI系统理解语义含义并将内容与查询匹配。探索语义搜索和AI内容匹配背后的技术。

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.