Technické SEO faktory ovlivňující viditelnost v ChatGPT, Perplexity & AI vyhledávání

Objevte klíčové technické SEO faktory ovlivňující vaši viditelnost v AI vyhledávačích jako ChatGPT, Perplexity a Google AI Mode. Zjistěte, jak rychlost načítání...

Kompletní průvodce AI crawlery a boty. Identifikujte GPTBot, ClaudeBot, Google-Extended a dalších 20+ AI crawlerů podle user agentů, rychlostí procházení a strategií blokování.

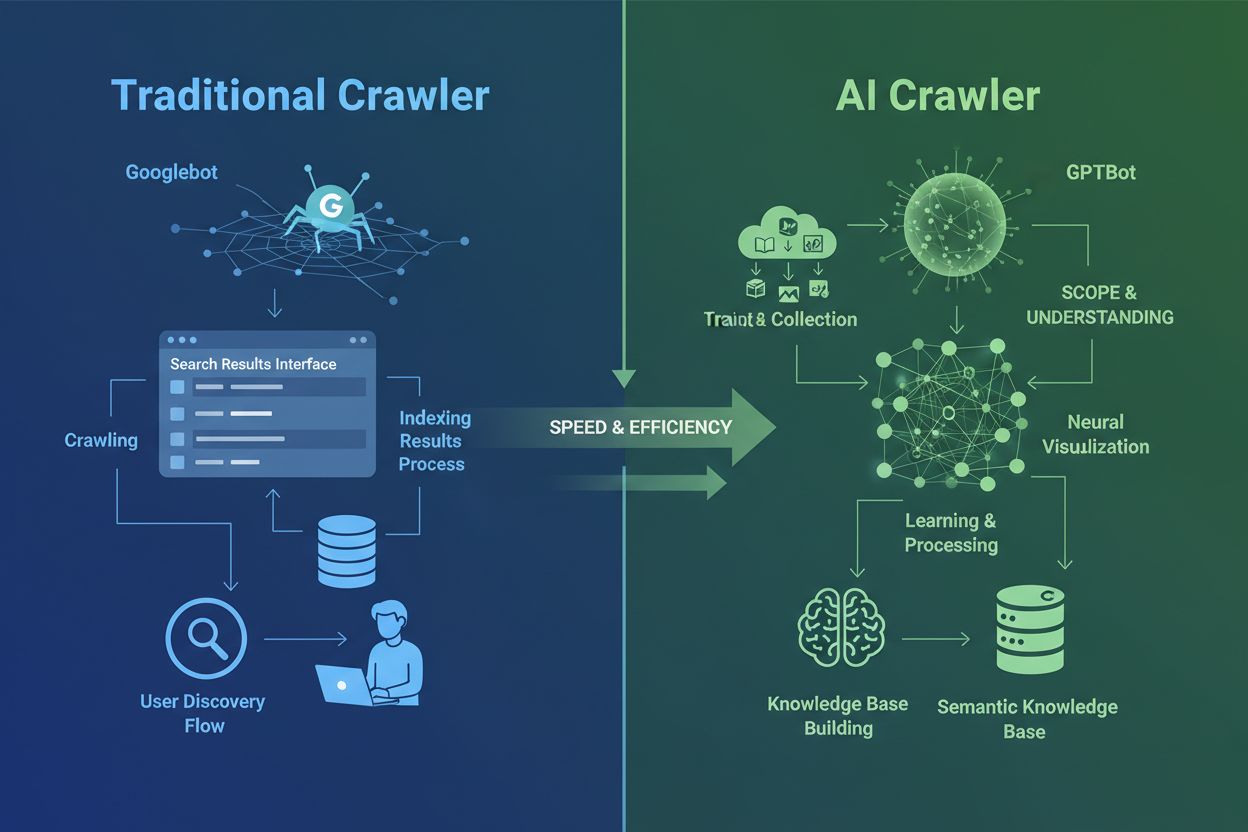

AI crawleři se zásadně liší od tradičních crawlerů vyhledávačů, které znáte již desítky let. Zatímco Googlebot a Bingbot indexují obsah, aby uživatelé našli informace ve výsledcích vyhledávání, AI crawleři jako GPTBot a ClaudeBot sbírají data specificky pro trénování velkých jazykových modelů. Tento rozdíl je zásadní: tradiční crawleři vytvářejí cesty pro lidské objevování, zatímco AI crawleři naplňují znalostní báze umělé inteligence. Podle aktuálních dat AI crawleři nyní tvoří téměř 80 % veškerého botího provozu na webu, přičemž trénovací crawleři spotřebovávají obrovské množství obsahu, aniž by zpět vydavatelům posílali významnou návštěvnost. Na rozdíl od tradičních crawlerů, které mají problémy s dynamickými weby s JavaScriptem, AI crawleři využívají pokročilé strojové učení k pochopení obsahu v kontextu, podobně jako lidský čtenář. Dokážou interpretovat význam, tón i účel bez ručních aktualizací konfigurace. To představuje kvantový skok ve webovém indexování, který vyžaduje, aby majitelé webů zcela přehodnotili své strategie řízení crawlerů.

Prostředí AI crawlerů je stále přeplněnější, protože hlavní technologické firmy spěchají s vývojem vlastních velkých jazykových modelů. OpenAI, Anthropic, Google, Meta, Amazon, Apple a Perplexity provozují každý několik specializovaných crawlerů, z nichž každý plní rozdílnou roli v rámci jejich AI ekosystémů. Firmy nasazují více crawlerů, protože různé účely vyžadují různé chování: některé crawleři sbírají data pro trénink modelů, jiné zajišťují indexaci pro vyhledávání v reálném čase a další získávají obsah na požádání uživatele. Porozumění tomuto ekosystému vyžaduje rozeznávat tři hlavní kategorie crawlerů: trénovací crawleři, kteří sbírají data pro zlepšení modelů, vyhledávací a citační crawleři pro AI-poháněné vyhledávací zážitky a uživatelem spouštění fetchery, které se aktivují na základě konkrétního požadavku. Následující tabulka nabízí rychlý přehled hlavních hráčů:

| Společnost | Název crawleru | Hlavní účel | Rychlost procházení | Tréninková data |

|---|---|---|---|---|

| OpenAI | GPTBot | Trénink modelu | 100 str./hod | Ano |

| OpenAI | ChatGPT-User | Požadavky uživatele v reálném čase | 2400 str./hod | Ne |

| OpenAI | OAI-SearchBot | Indexace vyhledávání | 150 str./hod | Ne |

| Anthropic | ClaudeBot | Trénink modelu | 500 str./hod | Ano |

| Anthropic | Claude-User | Web v reálném čase | <10 str./hod | Ne |

| Google-Extended | Trénink Gemini AI | Proměnlivá | Ano | |

| Gemini-Deep-Research | Výzkumná funkce | <10 str./hod | Ne | |

| Meta | Meta-ExternalAgent | Trénink AI modelu | 1100 str./hod | Ano |

| Amazon | Amazonbot | Zlepšování služby | 1050 str./hod | Ano |

| Perplexity | PerplexityBot | Indexace vyhledávání | 150 str./hod | Ne |

| Apple | Applebot-Extended | AI trénink | <10 str./hod | Ano |

| Common Crawl | CCBot | Otevřený dataset | <10 str./hod | Ano |

OpenAI provozuje tři různé crawlery s konkrétními rolemi v ekosystému ChatGPT. Porozumění těmto crawlerům je zásadní, protože GPTBot od OpenAI je jedním z nejagresivnějších a nejrozšířenějších AI crawlerů na internetu:

GPTBot – Hlavní trénovací crawler OpenAI, který systematicky sbírá veřejně dostupná data pro trénink a vylepšování modelů GPT včetně ChatGPT a GPT-4o. Tento crawler pracuje přibližně 100 stránek za hodinu a respektuje pravidla robots.txt. OpenAI zveřejňuje oficiální IP adresy na adrese https://openai.com/gptbot.json pro účely ověření.

ChatGPT-User – Tento crawler se objevuje, když skutečný uživatel zadá ChatGPT požadavek na procházení konkrétní webové stránky. Pracuje mnohem rychleji (až 2400 stránek/hod), protože je spouštěn uživatelskou akcí, ne systematickým crawlingem. Obsah získaný tímto crawlerem není použit pro trénink modelu, což je cenné pro okamžitou viditelnost ve výsledcích ChatGPT.

OAI-SearchBot – Navržen speciálně pro vyhledávací funkci ChatGPT, indexuje obsah pro výsledky vyhledávání v reálném čase bez sběru dat pro trénink. Pracuje přibližně na 150 stránkách/hod a umožňuje vaše stránky zobrazit ve vyhledávání ChatGPT na relevantní dotazy.

Crawleři OpenAI respektují robots.txt a fungují z ověřených IP adres, což je činí jednoduššími na správu oproti méně transparentním konkurentům.

Anthropic, tvůrce Claude AI, provozuje několik crawlerů s různými účely a úrovněmi transparentnosti. Firma zveřejňuje méně dokumentace než OpenAI, ale jejich chování je dobře zdokumentované analýzou serverových logů:

ClaudeBot – Hlavní trénovací crawler Anthropicu, který sbírá webový obsah pro zlepšení znalostní báze a schopností Clauda. Pracuje přibližně na 500 stránkách za hodinu a je hlavním cílem, pokud nechcete, aby byl váš obsah použit k tréninku Claude. User agent: Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; ClaudeBot/1.0; +claudebot@anthropic.com).

Claude-User – Aktivuje se, když uživatelé Clauda požadují přístup na web v reálném čase; tento crawler získává obsah na požádání s minimálním objemem. Respektuje autentizaci a nesnaží se obejít omezení přístupu, proto je z pohledu zátěže neškodný.

Claude-SearchBot – Podporuje interní vyhledávací schopnosti Clauda, pomáhá zobrazit váš obsah ve výsledcích vyhledávání při dotazech uživatelů. Tento crawler je velmi nízkoobjemový a slouží primárně pro indexaci, nikoli pro trénink.

Klíčovým tématem u crawlerů Anthropicu je poměr crawl/citation: Data Cloudflare ukazují, že na každé jedno doporučení (referral), které Anthropic posílá zpět na web, jejich crawleři navštíví cca 38 000 až 70 000 stránek. Tato obrovská nerovnováha znamená, že váš obsah je masivně využíván bez odpovídající kompenzace za citace.

Přístup Googlu k AI crawlery se výrazně liší od konkurence, protože firma odděluje indexaci pro vyhledávání a AI trénink. Google-Extended je konkrétní crawler zodpovědný za sběr dat pro trénink Gemini (dříve Bard) a dalších AI produktů Googlu, zcela odděleně od tradičního Googlebotu:

User agent Google-Extended: Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Google-Extended/1.0. Tato separace je pro majitele webů výhodná, protože můžete Google-Extended zablokovat v robots.txt bez dopadu na viditelnost ve vyhledávání Google. Google oficiálně uvádí, že blokování Google-Extended nemá žádný vliv na pozice ve vyhledávání ani na zařazení do AI Overview, přesto někteří webmasteři hlásí obavy, které stojí za sledování. Gemini-Deep-Research je další Google crawler, který podporuje výzkumnou funkci Gemini, ale pracuje na velmi nízkých objemech a má minimální dopad na server. Technickou výhodou crawlerů Googlu je schopnost vykonávat JavaScript a renderovat dynamický obsah, na rozdíl od většiny konkurence. Google-Extended tak dokáže účinně procházet aplikace v Reactu, Vue či Angularu, zatímco GPTBot od OpenAI a ClaudeBot od Anthropic nikoliv. Pro weby s JavaScriptovými aplikacemi je tento rozdíl klíčový pro AI viditelnost.

Kromě technologických gigantů provozuje AI crawlery řada dalších organizací, které si zaslouží pozornost. Meta-ExternalAgent, tiše spuštěný v červenci 2024, prohledává web za účelem trénování AI modelů Mety a vylepšování produktů Facebooku, Instagramu a WhatsApp. Tento crawler pracuje cca 1100 stránek/hod a přestože je velmi agresivní, získal méně mediální pozornosti než konkurence. Bytespider od ByteDance (mateřská společnost TikToku) je jedním z nejagresivnějších crawlerů od svého spuštění v dubnu 2024. Nezávislá monitorování ukazují, že Bytespider prohledává web mnohem intenzivněji než GPTBot či ClaudeBot, i když přesné násobky se liší. Některé zprávy upozorňují, že nemusí vždy respektovat robots.txt, proto je spolehlivější blokace podle IP.

Crawleři Perplexity zahrnují PerplexityBot pro indexaci a Perplexity-User pro získávání obsahu v reálném čase. Perplexity čelí občasným zprávám o ignorování robots.txt, ačkoliv firma tvrdí opak. Amazonbot pohání schopnosti odpovídání Alexa a respektuje robots.txt, pracuje cca 1050 stránek/hod. Applebot-Extended, představený v červnu 2024, rozhoduje o tom, jak bude již indexovaný obsah použit pro AI trénink Applu, ale přímo webové stránky necrawluje. CCBot od Common Crawl (nezisková organizace) buduje otevřené webové archivy, které využívá řada AI firem včetně OpenAI, Google, Meta a Hugging Face. Noví crawleři od firem jako xAI (Grok), Mistral a DeepSeek se začínají objevovat v serverových logách, což signalizuje další rozšiřování AI ekosystému crawlerů.

Níže najdete komplexní referenční tabulku ověřených AI crawlerů, jejich účelů, user agentů a syntaxe robots.txt. Tabulka je pravidelně aktualizována na základě serverových logů a oficiální dokumentace. Každá položka byla ověřena podle oficiálních IP seznamů (pokud jsou k dispozici):

| Název crawleru | Společnost | Účel | User Agent | Rychlost | Ověření IP | Syntaxe robots.txt |

|---|---|---|---|---|---|---|

| GPTBot | OpenAI | Sběr tréninkových dat | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; GPTBot/1.3; +https://openai.com/gptbot) | 100/hod | ✓ Oficiální | User-agent: GPTBot Disallow: / |

| ChatGPT-User | OpenAI | Požadavky uživatele v reálném čase | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko); compatible; ChatGPT-User/1.0 | 2400/hod | ✓ Oficiální | User-agent: ChatGPT-User Disallow: / |

| OAI-SearchBot | OpenAI | Indexace vyhledávání | Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36; compatible; OAI-SearchBot/1.3 | 150/hod | ✓ Oficiální | User-agent: OAI-SearchBot Disallow: / |

| ClaudeBot | Anthropic | Sběr tréninkových dat | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; ClaudeBot/1.0; +claudebot@anthropic.com) | 500/hod | ✓ Oficiální | User-agent: ClaudeBot Disallow: / |

| Claude-User | Anthropic | Web v reálném čase | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Claude-User/1.0) | <10/hod | ✗ Nedostupné | User-agent: Claude-User Disallow: / |

| Claude-SearchBot | Anthropic | Indexace vyhledávání | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Claude-SearchBot/1.0) | <10/hod | ✗ Nedostupné | User-agent: Claude-SearchBot Disallow: / |

| Google-Extended | Trénink Gemini AI | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Google-Extended/1.0) | Proměnlivá | ✓ Oficiální | User-agent: Google-Extended Disallow: / | |

| Gemini-Deep-Research | Výzkumná funkce | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Gemini-Deep-Research) | <10/hod | ✓ Oficiální | User-agent: Gemini-Deep-Research Disallow: / | |

| Bingbot | Microsoft | Bing vyhledávání & Copilot | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; bingbot/2.0) | 1300/hod | ✓ Oficiální | User-agent: Bingbot Disallow: / |

| Meta-ExternalAgent | Meta | Trénink AI modelu | meta-externalagent/1.1 (+https://developers.facebook.com/docs/sharing/webmasters/crawler) | 1100/hod | ✗ Nedostupné | User-agent: Meta-ExternalAgent Disallow: / |

| Amazonbot | Amazon | Zlepšování služby | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Amazonbot/0.1) | 1050/hod | ✓ Oficiální | User-agent: Amazonbot Disallow: / |

| Applebot-Extended | Apple | AI trénink | Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/605.1.15; compatible; Applebot-Extended | <10/hod | ✓ Oficiální | User-agent: Applebot-Extended Disallow: / |

| PerplexityBot | Perplexity | Indexace vyhledávání | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; PerplexityBot/1.0) | 150/hod | ✓ Oficiální | User-agent: PerplexityBot Disallow: / |

| Perplexity-User | Perplexity | Získávání v reálném čase | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Perplexity-User/1.0) | <10/hod | ✓ Oficiální | User-agent: Perplexity-User Disallow: / |

| Bytespider | ByteDance | AI trénink | Mozilla/5.0 (Linux; Android 5.0) AppleWebKit/537.36; compatible; Bytespider | <10/hod | ✗ Nedostupné | User-agent: Bytespider Disallow: / |

| CCBot | Common Crawl | Otevřený dataset | CCBot/2.0 (https://commoncrawl.org/faq/ ) | <10/hod | ✓ Oficiální | User-agent: CCBot Disallow: / |

| DuckAssistBot | DuckDuckGo | AI vyhledávání | DuckAssistBot/1.2; (+http://duckduckgo.com/duckassistbot.html) | 20/hod | ✓ Oficiální | User-agent: DuckAssistBot Disallow: / |

| Diffbot | Diffbot | Extrakce dat | Mozilla/5.0 (Windows; U; Windows NT 5.1; en-US; rv:1.9.1.2) Gecko/20090729 Firefox/3.5.2 Diffbot/0.1 | <10/hod | ✗ Nedostupné | User-agent: Diffbot Disallow: / |

| MistralAI-User | Mistral | Získávání v reálném čase | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; MistralAI-User/1.0) | <10/hod | ✗ Nedostupné | User-agent: MistralAI-User Disallow: / |

| ICC-Crawler | NICT | Trénink AI/ML | ICC-Crawler/3.0 (Mozilla-compatible; https://ucri.nict.go.jp/en/icccrawler.html ) | <10/hod | ✗ Nedostupné | User-agent: ICC-Crawler Disallow: / |

Ne všichni AI crawleři slouží stejnému účelu, a pochopení těchto rozdílů je zásadní pro správné rozhodnutí o blokování. Trénovací crawleři představují cca 80 % veškerého provozu AI botů a sbírají obsah konkrétně pro sestavování datasetů pro vývoj velkých jazykových modelů. Jakmile se váš obsah dostane do tréninkového datasetu, stává se trvalou součástí znalostní báze modelu, což může snížit potřebu uživatelů navštěvovat váš web kvůli odpovědím. Trénovací crawleři jako GPTBot, ClaudeBot a Meta-ExternalAgent pracují ve vysokém objemu a systematicky, přičemž vracejí minimum, případně žádný referral traffic.

Vyhledávací a citační crawleři indexují obsah pro AI-poháněné vyhledávání a mohou vám poslat určitou návštěvnost prostřednictvím citací. Když uživatelé zadávají dotazy v ChatGPT nebo Perplexity, tito crawleři pomáhají zobrazit relevantní zdroje. Na rozdíl od trénovacích crawlerů operují vyhledávací crawleři jako OAI-SearchBot a PerplexityBot ve středním objemu a zaměřují se na vyhledávání s případným uvedením zdroje a odkazem. Fetchery spouštěné uživatelem se aktivují pouze, když uživatel konkrétně požádá AI asistenta o analýzu stránky. Fetchery operují v nízkém objemu a nejde o systematický crawling; většina AI firem potvrzuje, že tyto požadavky nejsou použity pro trénink modelů. Porozumění těmto kategoriím vám pomůže strategicky rozhodnout, které crawlery povolit a které blokovat podle vašich obchodních priorit.

Prvním krokem v řízení AI crawlerů je zjistit, které z nich skutečně navštěvují váš web. Přístupové logy serveru obsahují detailní záznamy každého požadavku, včetně user agentu identifikujícího crawler. Většina hostingových panelů nabízí nástroje pro analýzu logů, ale můžete přistupovat také ke syrovým logům. U Apache jsou logy obvykle v /var/log/apache2/access.log, u Nginx v /var/log/nginx/access.log. Pomocí grep můžete filtrovat aktivitu crawlerů:

grep -i "gptbot\|claudebot\|google-extended\|bytespider" /var/log/apache2/access.log | head -20

Tento příkaz zobrazí 20 nejnovějších požadavků hlavních AI crawlerů. Google Search Console poskytuje statistiky pro crawlery Googlu, ale pouze pro vlastní boty. Cloudflare Radar nabízí globální pohled na provoz AI botů a pomáhá identifikovat nejaktivnější crawlery. Pro ověření, zda je crawler legitimní nebo podvržený, zkontrolujte IP požadavku podle oficiálních seznamů IP hlavních společností. OpenAI zveřejňuje ověřené IP na https://openai.com/gptbot.json, Amazon na https://developer.amazon.com/amazonbot/ip-addresses/ a další mají podobné seznamy. Falešný crawler, který předstírá legitimní user agent z neověřené IP, by měl být ihned blokován, protože pravděpodobně jde o škodlivé scrapingové aktivity.

Soubor robots.txt je vaším hlavním nástrojem pro řízení přístupu crawlerů. Tento jednoduchý textový soubor v kořenovém adresáři webu říká crawlerům, kam mohou a nemohou. Pro blokaci konkrétního AI crawleru přidejte například:

# Blokovat GPTBot od OpenAI

User-agent: GPTBot

Disallow: /

# Blokovat ClaudeBot od Anthropic

User-agent: ClaudeBot

Disallow: /

# Blokovat AI trénink od Googlu (ne vyhledávání)

User-agent: Google-Extended

Disallow: /

# Blokovat Common Crawl

User-agent: CCBot

Disallow: /

Můžete také povolit crawlery, ale nastavit omezení rychlosti:

User-agent: GPTBot

Crawl-delay: 10

Disallow: /private/

Tímto zadáte GPTBotovi, aby čekal 10 sekund mezi požadavky a nechodil do složky /private/. Pro vyvážený přístup, který povoluje vyhledávací crawlery a blokuje trénovací:

# Povolit tradiční vyhledávače

User-agent: Googlebot

Allow: /

User-agent: Bingbot

Allow: /

# Blokovat všechny AI trénovací crawlery

User-agent: GPTBot

User-agent: ClaudeBot

User-agent: CCBot

User-agent: Google-Extended

User-agent: Bytespider

User-agent: Meta-ExternalAgent

Disallow: /

# Povolit AI vyhledávací crawlery

User-agent: OAI-SearchBot

Allow: /

User-agent: PerplexityBot

Allow: /

Většina renomovaných AI crawlerů respektuje robots.txt, ale někteří agresivní crawleři ho zcela ignorují. Proto samotný robots.txt není nikdy 100% ochranou.

Robots.txt je pouze doporučením, ne vynutitelným pravidlem, což znamená, že crawleři ho mohou ignorovat. Pro silnější ochranu před crawlery, kteří robots.txt nerespektují, použijte blokaci podle IP na úrovni serveru. Tento postup je spolehlivější, protože IP adresu je těžší podvrhnout než user agent. Můžete povolit pouze ověřené IP z oficiálních zdrojů a blokovat vše ostatní, co se vydává za AI crawlery.

Na Apache serverech použijte pravidla .htaccess:

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} (GPTBot|ClaudeBot|anthropic-ai|Bytespider|CCBot) [NC]

RewriteRule .* - [F,L]

</IfModule>

Tímto vracíte odpověď 403 Forbidden každému odpovídajícímu user agentu bez ohledu na robots.txt. Pravidla firewallu poskytují další úroveň ochrany povolením pouze ověřených IP rozsahů. Většina hostingů a WAF umožňuje pravidla, která povolí pouze ověřené IP a ostatní požadavky blokují. HTML meta tagy nabízí detailní kontrolu na úrovni stránky. Amazon a někteří další crawleři respektují direktivu noarchive:

<meta name="robots" content="noarchive">

Tím crawlerům sdělujete, že stránku nemají používat pro trénink, i když mohou indexovat. Volte způsob blokace podle technických možností a konkrétních cílů – IP blokace je nejspolehlivější, ale náročnější na správu; robots.txt je nejjednodušší, ale méně účinný proti neukázněným crawlerům.

Implementace blokací crawlerů je jen polovina úspěchu; musíte ověřit, že skutečně fungují. Pravidelný monitoring vám umožní včas zachytit problémy a identifikovat nové crawlery. Kontrolujte serverové logy každý týden na neobvyklou aktivitu botů, hledejte user agenty s obsahem “bot”, “crawler”, “spider” nebo jména firem jako “GPT”, “Claude” či “Perplexity”. Nastavte si upozornění na náhlé nárůsty botího provozu, což může značit nové crawlery nebo agresivní chování stávajících. Google Search Console ukazuje statistiky pro crawlery Googlu, včetně Googlebotu a Google-Extended. Cloudflare Radar nabízí globální přehled provozu AI crawlerů a pomůže odhalit nové boty.

Ověřte funkčnost bloků v robots.txt tím, že si soubor přímo zobrazíte na vasedomena.cz/robots.txt a zkontrolujete, že obsahuje správné user agenty a direktivy. Pro bloky na úrovni serveru sledujte access logy na požadavky od blokovaných crawlerů; pokud se stále vyskytují, crawler ignoruje pravidla nebo spoofuje user agenta. Testujte implementaci kontrolou crawlerů v analytice i serverových logách. Čtvrtletní revize jsou nutné, protože prostředí AI crawlerů se rychle mění – vznikají nové boty, stávající mění user agenty a společnosti zavádějí nové crawlery bez upozornění. Pravidelně aktualizujte svůj blocklist, abyste byli stále chráněni.

Kromě řízení přístupu crawlerů je klíčové také chápat, jak AI systémy skutečně citují a využívají váš obsah. AmICited.com nabízí komplexní monitoring toho, jak se vaše značka a obsah objevují v AI odpovědích

AI crawleři jako GPTBot a ClaudeBot sbírají obsah specificky pro trénování velkých jazykových modelů, zatímco crawleři vyhledávačů jako Googlebot indexují obsah, aby ho lidé mohli najít ve výsledcích vyhledávání. AI crawleři naplňují znalostní báze AI systémů, zatímco vyhledávací crawleři pomáhají uživatelům objevovat váš obsah. Klíčový rozdíl je v účelu: trénování versus vyhledávání.

Ne, blokování AI crawlerů neovlivní vaše tradiční pozice ve vyhledávačích. AI crawleři jako GPTBot a ClaudeBot jsou zcela odděleni od crawlerů vyhledávačů, jako je Googlebot. Můžete zablokovat Google-Extended (pro AI trénink) a zároveň povolit Googlebot (pro vyhledávání). Každý crawler má jiný účel a blokování jednoho neovlivní druhého.

Zkontrolujte přístupové logy serveru, abyste viděli, které user agenty váš web navštěvují. Hledejte názvy botů jako GPTBot, ClaudeBot, CCBot a Bytespider v řetězcích user agentů. Většina hostingových panelů nabízí nástroje pro analýzu logů. Lze také použít Google Search Console pro monitorování aktivity crawlerů, ale ta ukazuje pouze crawleři Googlu.

Ne všichni AI crawleři dodržují robots.txt stejně. GPTBot od OpenAI, ClaudeBot od Anthropic a Google-Extended obecně respektují pravidla robots.txt. Bytespider a PerplexityBot však čelily zprávám naznačujícím, že nemusí vždy robots.txt dodržovat. U crawlerů, které robots.txt nerespektují, je třeba implementovat blokaci na základě IP adresy na úrovni serveru prostřednictvím firewallu nebo souboru .htaccess.

Rozhodnutí záleží na vašich cílech. Blokujte trénovací crawlery, pokud máte proprietární obsah nebo omezené serverové zdroje. Povolit vyhledávací crawlery se vyplatí, pokud chcete být viditelní ve výsledcích vyhledávání a chatbotech poháněných AI, což může přinést návštěvnost a upevnit autoritu. Mnoho firem volí selektivní přístup — povolují konkrétní crawlery a blokují agresivní jako Bytespider.

Noví AI crawleři se objevují pravidelně, proto revidujte a aktualizujte svůj seznam blokací minimálně čtvrtletně. Sledujte projekty jako ai.robots.txt na GitHubu pro komunitní seznamy. Měsíčně kontrolujte serverové logy, abyste identifikovali nové crawlery, které nejsou ve vaší aktuální konfiguraci. Prostředí AI crawlerů se rychle vyvíjí a vaše strategie by se měla vyvíjet spolu s ním.

Ano, zkontrolujte IP adresu požadavku podle oficiálních seznamů IP, které zveřejňují hlavní společnosti. OpenAI zveřejňuje ověřené IP na https://openai.com/gptbot.json, Amazon na https://developer.amazon.com/amazonbot/ip-addresses/ a další mají podobné seznamy. Crawler, který předstírá legitimní user agent z neověřené IP adresy, by měl být ihned blokován, protože pravděpodobně představuje škodlivé scrapingové aktivity.

AI crawleři mohou spotřebovávat značnou šířku pásma a serverové zdroje. Bytespider a Meta-ExternalAgent patří mezi nejagresivnější crawlery. Někteří vydavatelé uvádějí, že zablokováním AI crawlerů snížili spotřebu dat z 800GB na 200GB denně, což představuje úsporu asi 1 500 $ měsíčně. Sledujte serverové zdroje během špičky crawlování a v případě potřeby nastavte omezení rychlosti pro agresivní boty.

Sledujte, které AI crawleři citují váš obsah a optimalizujte svou viditelnost napříč ChatGPT, Perplexity, Google Gemini a dalšími.

Objevte klíčové technické SEO faktory ovlivňující vaši viditelnost v AI vyhledávačích jako ChatGPT, Perplexity a Google AI Mode. Zjistěte, jak rychlost načítání...

Zjistěte, jak SSR a CSR strategie vykreslování ovlivňují viditelnost pro AI crawlery, citace značky v ChatGPT a Perplexity a vaši celkovou přítomnost ve vyhledá...

Zjistěte, jak povolit AI botům jako GPTBot, PerplexityBot a ClaudeBot procházet váš web. Nastavte robots.txt, vytvořte llms.txt a optimalizujte svůj web pro AI ...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.