Vysvětlení AI crawlerů: GPTBot, ClaudeBot a další

Pochopte, jak fungují AI crawleři jako GPTBot a ClaudeBot, v čem se liší od tradičních crawlerů vyhledávačů a jak optimalizovat svůj web pro viditelnost ve vyhl...

Naučte se, jak strategicky rozhodovat o blokování AI crawlerů. Vyhodnoťte typ obsahu, zdroje návštěvnosti, modely příjmů a konkurenční pozici pomocí našeho komplexního rozhodovacího rámce.

AI crawleři se stali významnou silou v digitálním ekosystému a zásadně mění způsob, jakým je obsah objevován, indexován a využíván na internetu. Tyto automatizované systémy jsou navrženy tak, aby systematicky procházely weby, extrahovaly data a předávaly je do modelů strojového učení, které pohání vše od vyhledávačů po generativní AI aplikace. Mezi crawlery rozlišujeme tři hlavní typy: data scrapery, které získávají konkrétní informace pro komerční účely, vyhledávací crawlery jako Googlebot, které indexují obsah pro výsledky vyhledávání, a AI asistenty, kteří shromažďují trénovací data pro velké jazykové modely. Mezi příklady patří GPTBot od OpenAI, Claude-Web od Anthropic a crawler AI Overviews od Googlu, každý s různým účelem a dopadem. Podle nedávných analýz už přibližně 21 % z tisíce největších webů implementovalo nějakou formu blokování AI crawlerů, což ukazuje rostoucí povědomí o nutnosti tyto automatizované návštěvníky řídit. Porozumění tomu, kteří crawleři na váš web přistupují a proč, je prvním klíčovým krokem k informovanému rozhodnutí, zda je blokovat či povolit. Sázky jsou vysoké, protože toto rozhodnutí přímo ovlivňuje viditelnost vašeho obsahu, strukturu návštěvnosti a v konečném důsledku i váš příjmový model.

Namísto plošného rozhodnutí blokovat nebo povolit všechny AI crawlery je sofistikovanější přístup vyhodnotit vaši konkrétní situaci pomocí BEDC Frameworku (Business Model, Exposure Risk, Dependency on Organic Search, Competitive Position). Každý z těchto čtyř faktorů má různou váhu v závislosti na charakteristice vašeho webu a dohromady tvoří komplexní rozhodovací matici, která zohledňuje složitost moderního digitálního publikování. Rámec uznává, že neexistuje univerzální odpověď – co funguje pro zpravodajský web, může být zcela nevhodné pro SaaS společnost, a co prospívá zavedené značce, může uškodit začínajícímu konkurentovi. Systematickým vyhodnocením každého faktoru překročíte emocionální reakce na AI a učiníte rozhodnutí založená na datech v souladu s vašimi obchodními cíli.

| Faktor | Doporučení | Klíčové hledisko |

|---|---|---|

| Business Model | Weby financované z reklamy by měly být opatrnější; předplatitelské modely mohou být otevřenější | Závislost příjmů na přímé interakci uživatelů vs. licencování |

| Exposure Risk | Originální výzkum a proprietární obsah si zaslouží blokaci; běžný obsah může být otevřenější | Konkurenční výhoda spojená s unikátními poznatky či daty |

| Organic Search Dependency | Vysoká závislost (>40 % návštěvnosti) naznačuje povolit Google crawlery, ale blokovat AI asistenty | Rovnováha mezi viditelností ve vyhledávači a ochranou dat pro AI trénink |

| Competitive Position | Lídři trhu si blokování mohou dovolit; začínající hráči mohou těžit z viditelnosti v AI | Prvo-mover výhoda v AI partnerstvích vs. ochrana obsahu |

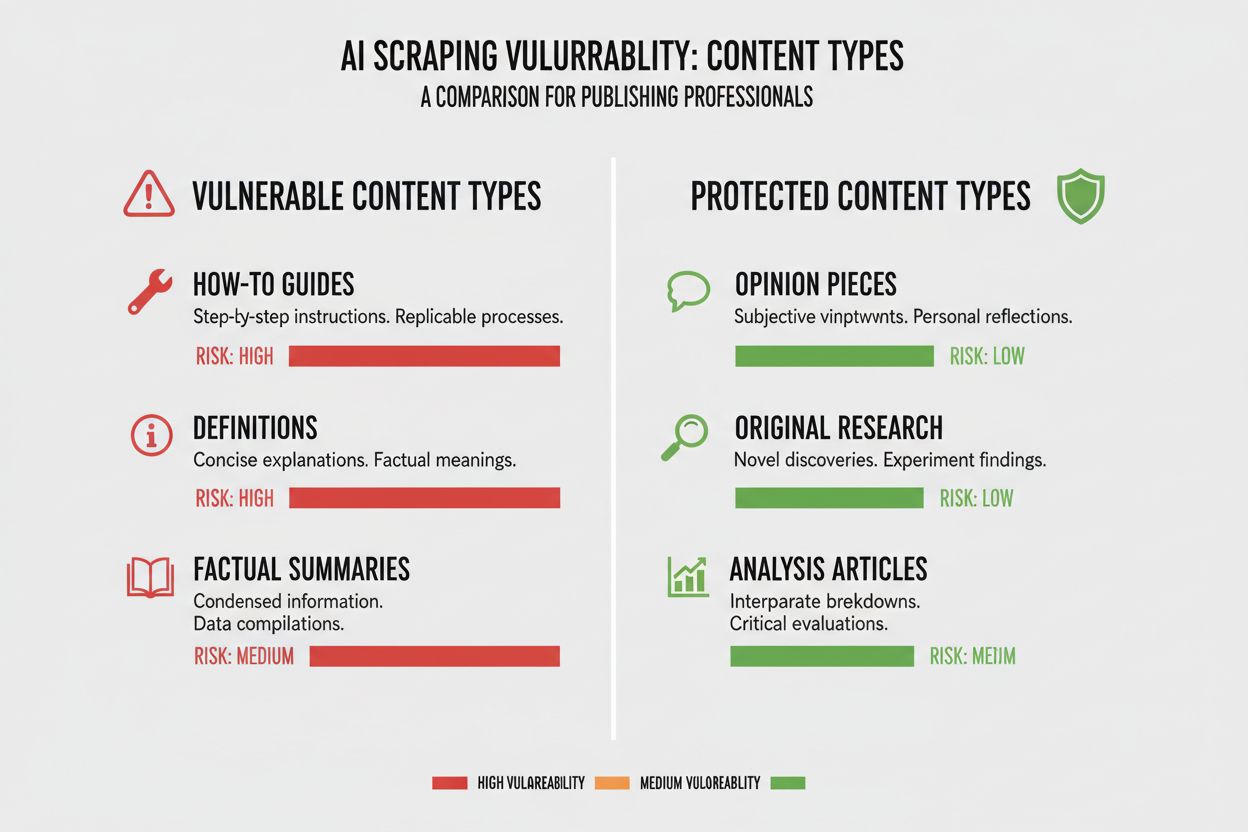

Různé typy obsahu mají různou zranitelnost vůči AI crawlingu a pochopení pozice vašeho obsahu je zásadní pro správné rozhodnutí. Originální výzkum a proprietární data jsou vaše nejcennější aktiva a zaslouží si nejsilnější ochranu, protože AI modely trénované na těchto datech mohou přímo konkurovat vašemu monetizačnímu modelu. Zpravodajství a aktuální informace představují střední cestu – jejich hodnota rychle klesá, ale indexace vyhledávači je klíčová pro návštěvnost, což vytváří napětí mezi viditelností ve vyhledávači a ochranou pro trénink AI. Běžný obsah, například návody, tutoriály a obecné informační materiály, jsou méně zranitelné, protože jsou široce dostupné a často nejsou hlavním zdrojem příjmů. Hlasový a multimediální obsah je přirozeně chráněn, protože současné AI crawleři mají problém zpracovat audio a video, což tyto formáty činí bezpečnějšími před extrakcí pro AI modely. Evergreen vzdělávací obsah a názorové texty jsou někde uprostřed – cenné pro návštěvnost z vyhledávačů, ale méně přímo ohrožené konkurencí AI. Klíčovým postřehem je, že strategie blokování by měla být úměrná konkurenční výhodě, kterou váš obsah poskytuje – chraňte své nejcennější informace a pro běžný obsah zůstaňte otevření crawlerům, pokud z toho plyne širší distribuce.

Vaše závislost na organickém vyhledávání je pravděpodobně nejkonkrétnějším faktorem v rozhodování o AI crawlerech, protože kvantifikuje kompromis mezi viditelností ve vyhledávači a ochranou obsahu. Weby, které získávají více než 40 % návštěvnosti z organického vyhledávání, čelí zásadnímu omezení: blokování AI crawlerů často znamená i blokování nebo omezení Google crawlerů, což by zásadně poškodilo jejich viditelnost a organickou návštěvnost. Rozlišení mezi Google-Extended (pro AI trénink) a Googlebotem (pro indexaci vyhledávačem) je zde klíčové, protože teoreticky můžete povolit jednoho a druhého blokovat, což je však technicky složité. Výrazná případová studie The New York Times ukazuje sázky na návštěvnost: publikace obdržela přibližně 240 600 návštěv od AI crawlerů v určitém období, což ukazuje rozsah AI provozu pro velké vydavatele. Data z Akamai však ukazují, že blokování crawlerů vede k 96% poklesu referral návštěvnosti z těchto zdrojů, což naznačuje, že AI crawlery přinášejí ve srovnání s tradičním vyhledáváním jen minimální návštěvnost. Poměr crawl-to-referral je u většiny AI crawlerů extrémně nízký – často méně než 0,15 % procházeného obsahu generuje návraty – což znamená, že blokování těchto crawlerů má minimální dopad na reálnou uživatelskou návštěvnost. Weby silně závislé na organickém vyhledávání musí rozhodnutí blokovat AI crawlery zvážit s ohledem na riziko nechtěného zablokování crawlerů vyhledávačů, což by bylo pro podnikání mnohem škodlivější.

Váš model příjmů zásadně ovlivňuje, jak byste měli k AI crawlerům přistupovat, protože různé strategie monetizace vytvářejí různé pobídky kolem distribuce a ochrany obsahu. Weby financované reklamou jsou v největším napětí s AI crawlery, protože jejich příjmy závisejí na návštěvnících, kteří přijdou na web a vidí reklamu, zatímco AI modely shrnující jejich obsah snižují motivaci uživatele kliknout. Předplatitelské modely si mohou dovolit být vůči AI crawlerům povolnější, protože jejich příjmy plynou z předplatného a určitá viditelnost v AI může přivést nové předplatitele. Hybridní modely kombinující reklamu, předplatné i affiliate příjmy vyžadují nuancovanější přístup, protože blokování crawlerů může chránit reklamní příjmy, ale poškodit affiliate příležitosti nebo růst předplatného. Nově se objevuje AI referral model, kdy weby mohou potenciálně vydělávat tím, že povolí AI crawlerům přístup ke svému obsahu výměnou za atribuci a referral návštěvnost – jde o rozvíjející se model, který by mohl změnit ekonomiku distribuce obsahu. Pro vydavatele, kteří chtějí pochopit dopad AI crawlerů na své podnikání, jsou nástroje jako AmICited.com zásadní pro sledování, kde je jejich obsah citován a využíván AI systémy, a poskytují přehled o skutečné hodnotové výměně. Klíčem je hluboce porozumět svému modelu příjmů a předpovídat, jak AI crawleři ovlivní jednotlivé příjmové proudy, místo abyste činili plošná rozhodnutí jen podle principu.

Jakmile se rozhodnete blokovat určité AI crawlery, je potřeba pochopit možnosti i omezení dostupných nástrojů. Nejčastějším přístupem je použití robots.txt, jednoduchého textového souboru v kořenovém adresáři webu, který crawlerům říká, které části webu mohou či nemohou procházet. Robots.txt má však zásadní omezení: je to dobrovolný standard a záleží, zda jej jednotliví crawleři respektují, přičemž škodlivé nebo agresivní crawlery jej mohou zcela ignorovat. Zde je příklad, jak blokovat konkrétní AI crawlery v robots.txt:

User-agent: GPTBot

Disallow: /

User-agent: CCBot

Disallow: /

User-agent: anthropic-ai

Disallow: /

User-agent: Claude-Web

Disallow: /

Kromě robots.txt byste měli zvážit blokaci těchto hlavních AI crawlerů:

Pro robustnější ochranu mnoho organizací implementuje blokování na úrovni CDN přes služby jako Cloudflare, které mohou zastavit provoz na síťové úrovni ještě před vstupem na vaše servery, což zlepšuje výkon i bezpečnost. Dvouvrstvý přístup kombinující robots.txt a blokování na úrovni CDN nabízí nejsilnější ochranu, protože zachytí jak crawlery, které robots.txt ctí, tak i ty, co jej ignorují. Blokování na úrovni CDN však vyžaduje vyšší technickou odbornost a může mít nechtěné následky, pokud není správně nastaveno, proto je vhodné spíše pro organizace s vlastními odborníky.

Nepříjemnou pravdou o blokování AI crawlerů je, že skutečný dopad na návštěvnost je často mnohem menší, než by se podle emocí kolem AI scraping dalo čekat, a data ukazují složitější obrázek, než vydavatelé často předpokládají. Podle nedávných analýz tvoří AI crawleři obvykle jen 0,15 % celkové návštěvnosti webu většiny vydavatelů, což je překvapivě málo vzhledem k pozornosti, kterou tato otázka vzbuzuje. Růst AI crawler provozu je však dramatický – některé zprávy ukazují 7násobný meziroční růst požadavků AI crawlerů, což znamená, že současný dopad je malý, ale trend je strmý. ChatGPT tvoří zhruba 78 % veškerého AI crawler provozu, což z crawleru OpenAI dělá dominantní sílu, následovanou menšími AI společnostmi. Poměr crawl-to-referral je zásadní: i když AI crawleři požádají o miliony stránek, reálné návraty generují často pod 0,15 %, což znamená, že blokování má minimální dopad na uživatelskou návštěvnost. Blokování AI crawlerů snižuje referral návštěvnost o 96 %, ale protože tato návštěvnost byla už předtím zanedbatelná (často pod 0,15 % celkové návštěvnosti), je celkový dopad na podnikání obvykle zanedbatelný. Vzniká tak paradox: blokování AI crawlerů vypadá jako zásadový postoj proti krádeži obsahu, ale reálný obchodní dopad je často tak malý, že se v analytice téměř neprojeví. Skutečná otázka tedy není, zda blokování crawlerů poškodí vaši návštěvnost – většinou ne – ale zda jejich povolení vytváří strategické příležitosti nebo rizika, která převáží minimální přínos v návštěvnosti.

Vaše pozice na trhu zásadně ovlivňuje, jak byste měli k AI crawlerům přistupovat, protože optimální strategie pro lídra trhu se výrazně liší od optimální strategie začínajícího konkurenta. Dominantní hráči na trhu jako The New York Times, Wall Street Journal a hlavní zpravodajské organizace si mohou dovolit blokovat AI crawlery, protože jejich známost a přímý vztah s publikem znamená, že nepotřebují AI objevování pro získání návštěvnosti. Začínající a úzce zaměření vydavatelé čelí jiné situaci: indexace AI systémy a zobrazování v AI-generovaných souhrnech může být jednou z mála cest, jak získat viditelnost oproti zavedeným hráčům. Prvo-mover výhoda v AI partnerstvích může být významná – vydavatelé, kteří včas dojednají výhodné podmínky s AI firmami, mohou získat lepší atribuci, referral návštěvnost nebo licenční dohody než ti, kdo vyčkávají. Dále zde působí efekt dotace: když dominantní vydavatelé blokují AI crawlery, vzniká motivace pro AI firmy spoléhat více na obsah od těch, kdo crawlery povolují, což těmto webům zajišťuje neúměrnou viditelnost v AI systémech. Vzniká tak konkurenční dynamika, kdy blokování může vaši pozici zhoršit, pokud vaši konkurenti crawlery povolí a získají AI viditelnost. Pochopení vaší pozice v konkurenčním prostředí je zásadní pro odhad, jak vaše rozhodnutí ovlivní vaši tržní pozici vůči konkurenci.

Rozhodnutí blokovat nebo povolit AI crawlery si žádá systematické vyhodnocení vaší konkrétní situace podle konkrétních kritérií. Použijte tento checklist při rozhodování:

Hodnocení expozice obsahu

Analýza složení návštěvnosti

Vyhodnocení tržní pozice

Hodnocení rizika pro příjmy

Kromě tohoto prvotního hodnocení implementujte čtvrtletní revize své strategie k AI crawlerům, protože prostředí se rychle vyvíjí a optimální rozhodnutí se může během měsíců změnit. Využívejte nástroje jako AmICited.com pro sledování, kde je váš obsah v AI systémech využíván a citován, abyste měli konkrétní data o hodnotové výměně. Klíčovým postřehem je, že rozhodnutí nesmí být jednorázové a zapomenuté – vyžaduje průběžné vyhodnocování a úpravy podle vývoje AI prostředí a vaší obchodní situace.

Významnou nově vznikající příležitostí, která by mohla změnit celý svět AI crawlerů, je funkce pay-per-crawl od Cloudflare, která zavádí model povolení přístupu za úplatu, kde provozovatelé webů mohou monetizovat přístup AI crawlerů místo prostého blokování či povolování. Tento přístup uznává, že AI společnosti získávají hodnotu procházením vašeho obsahu, a místo konfrontačního boje o blokování byste mohli jednat o kompenzaci za přístup. Model spoléhá na kryptografické ověření, které zajistí, že k obsahu přistupují jen povolení crawleři, což zabraňuje neoprávněnému scraping a umožňuje legitimním AI společnostem za přístup zaplatit. To přináší detailní kontrolu nad tím, kteří crawleři mají ke kterému obsahu přístup, a umožňuje vám monetizovat hodnotný obsah, zatímco zůstáváte otevření vyhledávačům a užitečným crawlerům. Pay-per-crawl model také umožňuje AI audit, kde vidíte přesně, který obsah byl kdy a kým procházen, což přináší transparentnost, jaká při tradičním blokování není možná. Pro vydavatele, kteří tuto strategii implementují, jsou monitorovací schopnosti AmICited.com ještě cennější, protože mohou sledovat nejen výskyt svého obsahu v AI systémech, ale také ověřovat, zda za jeho využití dostávají odpovídající kompenzaci. Přestože je tento model stále v začátcích a rozšíření je omezené, představuje potenciálně sofistikovanější přístup než binární volba mezi blokováním a povolováním – takový, který uznává oboustrannou hodnotu vztahu mezi vydavateli a AI firmami a zároveň chrání vaše zájmy technicky i smluvně.

Blokování AI crawlerů jim zabrání v přístupu k vašemu obsahu pomocí robots.txt nebo blokováním na úrovni CDN, čímž chráníte svůj obsah před použitím pro trénování AI. Povolením crawlerů umožníte, aby byl váš obsah indexován AI systémy a mohl se objevit v AI-generovaných souhrnech a odpovědích. Výběr závisí na typu vašeho obsahu, modelu příjmů a konkurenční pozici.

Blokování AI crawlerů přímo neškodí vašemu SEO, pokud blokujete pouze AI-specific crawlery jako GPTBot a zároveň povolíte Googlebot. Pokud ale omylem zablokujete i Googlebot, vaše pozice ve vyhledávání výrazně utrpí. Klíčem je detailní řízení a blokování pouze crawlerů pro AI trénink, přičemž přístup vyhledávačům zůstane zachován.

Ano, můžete využít robots.txt k blokování konkrétních crawlerů podle jejich user-agentu a ostatním povolit přístup. Například můžete blokovat GPTBot a povolit Google-Extended nebo naopak. Tento detailní přístup vám umožní chránit svůj obsah před určitými AI firmami a zároveň zůstat viditelní pro jiné.

robots.txt je dobrovolný standard, který spoléhá na to, že crawleři vaše instrukce budou respektovat – některé AI společnosti jej ignorují. Blokování na úrovni CDN (například Cloudflare) blokuje provoz na úrovni sítě ještě předtím, než dorazí na vaše servery, a poskytuje silnější vynucení. Nejlepší ochranu zajistí dvouvrstvý přístup využívající obě metody současně.

Můžete zkontrolovat serverové logy na user-agenty známých AI crawlerů, jako jsou GPTBot, CCBot a Claude-Web. Nástroje jako AmICited.com umožňují sledovat, kde se váš obsah v AI systémech objevuje a jak často k němu AI crawleři přistupují.

Pay-per-crawl je nově vznikající model, kdy AI společnosti platí za přístup k vašemu obsahu. Zatím je v beta fázi a má omezené rozšíření, ale představuje potenciální nový zdroj příjmů. Jeho životaschopnost záleží na objemu AI crawler provozu a sazbách, které jsou AI společnosti ochotny platit.

Pokud AI crawler ignoruje vaše pokyny v robots.txt, implementujte blokování na úrovni CDN přes služby jako Cloudflare. Také můžete nastavit server, aby vracel chyby 403 známým user-agentům AI crawlerů. Při opakovaném porušování zvažte právní kroky nebo kontaktování AI společnosti přímo.

Strategii k AI crawlerům přehodnocujte čtvrtletně, protože prostředí se rychle mění. Sledujte změny v provozu AI crawlerů, nové crawlery na trhu i posuny ve své konkurenční pozici. Využívejte nástroje jako AmICited.com pro sledování využití vašeho obsahu v AI systémech a podle toho upravujte strategii.

Sledujte, kde se váš obsah objevuje v AI-generovaných odpovědích a pochopte dopad AI crawlerů na vaše podnikání díky komplexní monitorovací platformě AmICited.com.

Pochopte, jak fungují AI crawleři jako GPTBot a ClaudeBot, v čem se liší od tradičních crawlerů vyhledávačů a jak optimalizovat svůj web pro viditelnost ve vyhl...

Zjistěte, které AI crawlery povolit nebo blokovat ve vašem robots.txt. Komplexní průvodce zahrnující GPTBot, ClaudeBot, PerplexityBot a 25+ AI crawlerů s ukázka...

Komplexní průvodce AI crawlery v roce 2025. Identifikujte GPTBot, ClaudeBot, PerplexityBot a více než 20 dalších AI botů. Naučte se, jak crawlery blokovat, povo...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.