LLM Meta Odpovědi

Zjistěte, co jsou LLM Meta Odpovědi a jak optimalizovat svůj obsah pro viditelnost v AI-generovaných odpovědích z ChatGPT, Perplexity a Google AI Overviews. Obj...

Zjistěte, jak vytvářet LLM meta odpovědi, které systémy AI citují. Objevte strukturální techniky, strategie hustoty odpovědí a formáty obsahu připravené k citaci, které zvyšují viditelnost ve výsledcích vyhledávání AI.

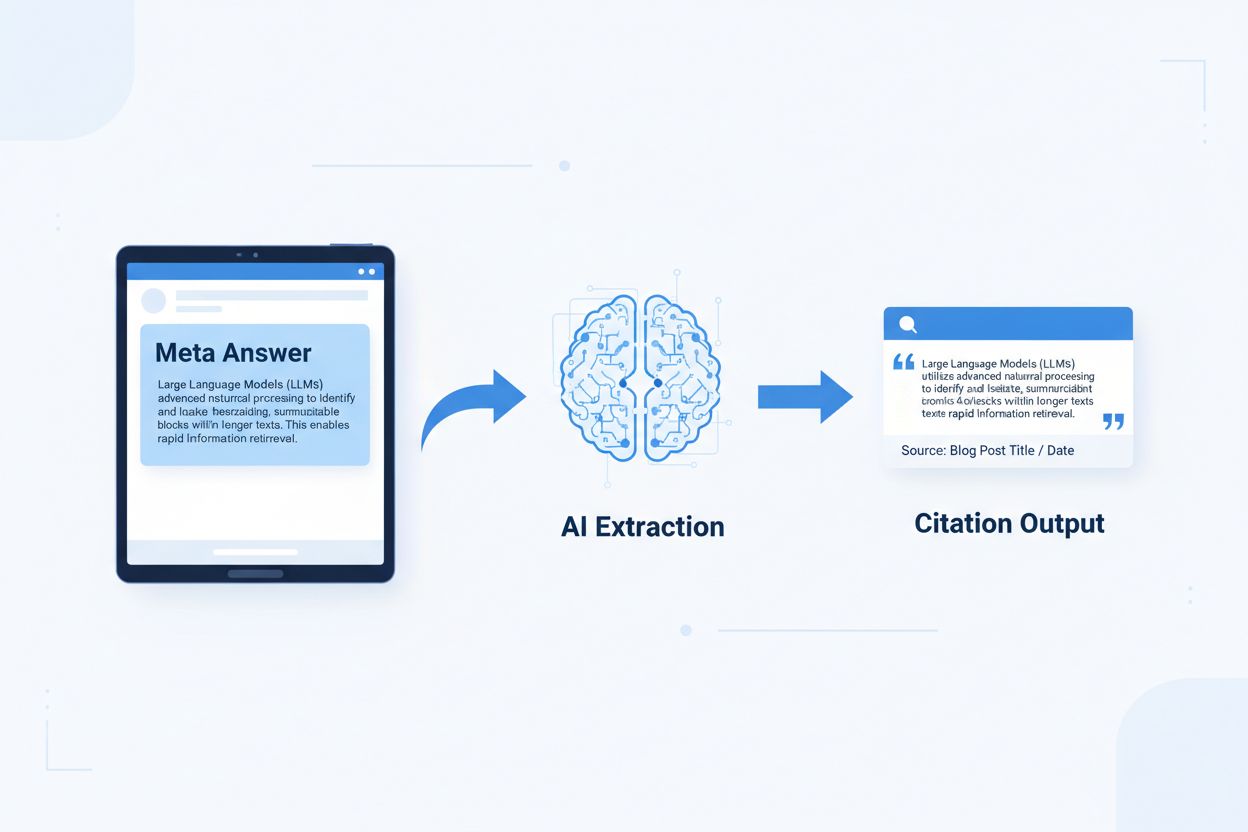

LLM meta odpovědi jsou samostatné, pro AI optimalizované bloky obsahu, které mohou jazykové modely přímo extrahovat a citovat bez potřeby dalšího kontextu. Na rozdíl od tradičního webového obsahu, který pro význam spoléhá na navigaci, nadpisy a okolní text, fungují meta odpovědi jako samostatné postřehy, které si při izolaci zachovávají plnou sémantickou hodnotu. Toto rozlišení je důležité, protože moderní AI systémy neprocházejí weby jako lidé – rozdělují obsah na části, hodnotí relevanci a extrahují pasáže na podporu svých odpovědí. Když AI narazí na dobře strukturované meta odpovědi, může je s jistotou citovat, protože informace jsou kompletní, ověřitelné a kontextově nezávislé. Výzkum společnosti Onely ukazuje, že obsah optimalizovaný pro citace AI získává 3–5× více zmínek ve výstupech LLM oproti tradičně formátovanému obsahu, což přímo ovlivňuje viditelnost značky v AI-generovaných odpovědích. Tento posun představuje zásadní změnu ve výkonu obsahu: místo soupeření o pozice ve vyhledávání meta odpovědi soutěží o zařazení do AI odpovědí. Platformy pro monitoring citací, jako je AmICited.com, nyní sledují tyto AI zmínky jako klíčovou výkonnostní metriku a odhalují, že organizace s obsahem připraveným k citaci zaznamenávají měřitelné nárůsty AI návštěvnosti a autority značky. Spojitost je přímá – obsah strukturovaný jako meta odpovědi je citován častěji, což zvyšuje viditelnost značky v informačním prostředí orientovaném na AI.

Obsah připravený k citaci vyžaduje specifické strukturální prvky, které AI systémům signalizují: „Toto je kompletní, citovatelná odpověď.“ Nejefektivnější meta odpovědi spojují jasné věty s tvrzením, podpůrné důkazy a samostatné závěry do jednoho logického celku. Tyto prvky spolu vytváří to, co AI systémy rozpoznávají jako extrahovatelné znalosti – informace, které obstojí samostatně bez nutnosti navštívit zdrojovou stránku. Strukturální přístup se zásadně liší od tradičního webového obsahu, který často tříští informace mezi více stránek a pro vytváření kontextu spoléhá na interní prolinkování.

| Prvek připravený k citaci | Proč jej AI systémy upřednostňují |

|---|---|

| Věta s tvrzením (topic sentence) | Okamžitě signalizuje hlavní hodnotu odpovědi; AI vyhodnotí relevanci v prvních 20 tokenech |

| Podpůrné důkazy (data/příklady) | Poskytují ověřitelné podklady; zvyšují důvěru v přesnost citace |

| Konkrétní metriky nebo statistiky | Kvantifikovatelná tvrzení jsou častěji citována; snižují nejasnost |

| Definice nebo vysvětlení | Zajišťují samostatné pochopení; AI nepotřebuje externí kontext |

| Akční závěr | Signalizuje úplnost; AI ví, že odpověď je dokončená |

| Uvedení zdroje | Buduje důvěru; AI upřednostňuje citaci obsahu s jasným původem |

Tipy pro maximální extrahovatelnost AI:

Optimální velikost části pro extrakci AI je mezi 256–512 tokeny, což odpovídá zhruba 2–4 dobře strukturovaným odstavcům. Toto rozmezí představuje ideální bod, kde AI systémy mohou extrahovat smysluplné informace bez ztráty kontextu nebo zahrnutí nerelevantního materiálu. Menší části často postrádají dostatečný kontext pro jistou citaci, zatímco větší části nutí AI systémy odpověď zestručnit nebo zkrátit, čímž snižují možnost přímé citace. Dělení podle odstavců – kde každý odstavec představuje kompletní myšlenku – předčí náhodné dělení podle tokenů, protože zachovává sémantickou soudržnost a logickou návaznost, kterou AI využívá při hodnocení relevance.

Správné dělení zachovává sémantické hranice:

✓ SPRÁVNĚ: "Obsah připravený k citaci vyžaduje specifické strukturální prvky.

Nejúčinnější meta odpovědi spojují jasné věty s tvrzením,

podpůrné důkazy a samostatné závěry do jednoho

logického celku. Tyto prvky spolu vytváří to, co AI systémy

rozpoznávají jako extrahovatelné znalosti."

✗ ŠPATNĚ: "Obsah připravený k citaci vyžaduje specifické strukturální prvky,

které AI systémům signalizují: 'Toto je kompletní, citovatelná odpověď.' Nejefektivnější

meta odpovědi spojují jasné věty s tvrzením, podpůrné důkazy a samostatné závěry do jednoho logického celku.

Tyto prvky spolu vytváří to, co AI systémy rozpoznávají jako extrahovatelné znalosti – informace,

které obstojí samostatně bez nutnosti navštívit zdrojovou stránku. Strukturální přístup se zásadně

liší od tradičního webového obsahu, který často tříští informace mezi více stránek a pro vytváření

kontextu spoléhá na interní prolinkování."

Správný příklad udržuje sémantickou soudržnost a končí přirozeným závěrem. Špatný příklad kombinuje více myšlenek, což nutí AI buď zkrátit uprostřed myšlenky, nebo zahrnout nerelevantní kontext. Strategie překryvu – kdy poslední věta jedné části předznamenává následující – pomáhá AI pochopit vztahy mezi částmi bez ztráty extrahovatelnosti. Praktický kontrolní seznam pro optimalizaci dělení: Odpovídá každá část na jednu otázku? Lze ji pochopit bez čtení okolních odstavců? Obsahuje 256–512 tokenů? Končí na přirozené sémantické hranici?

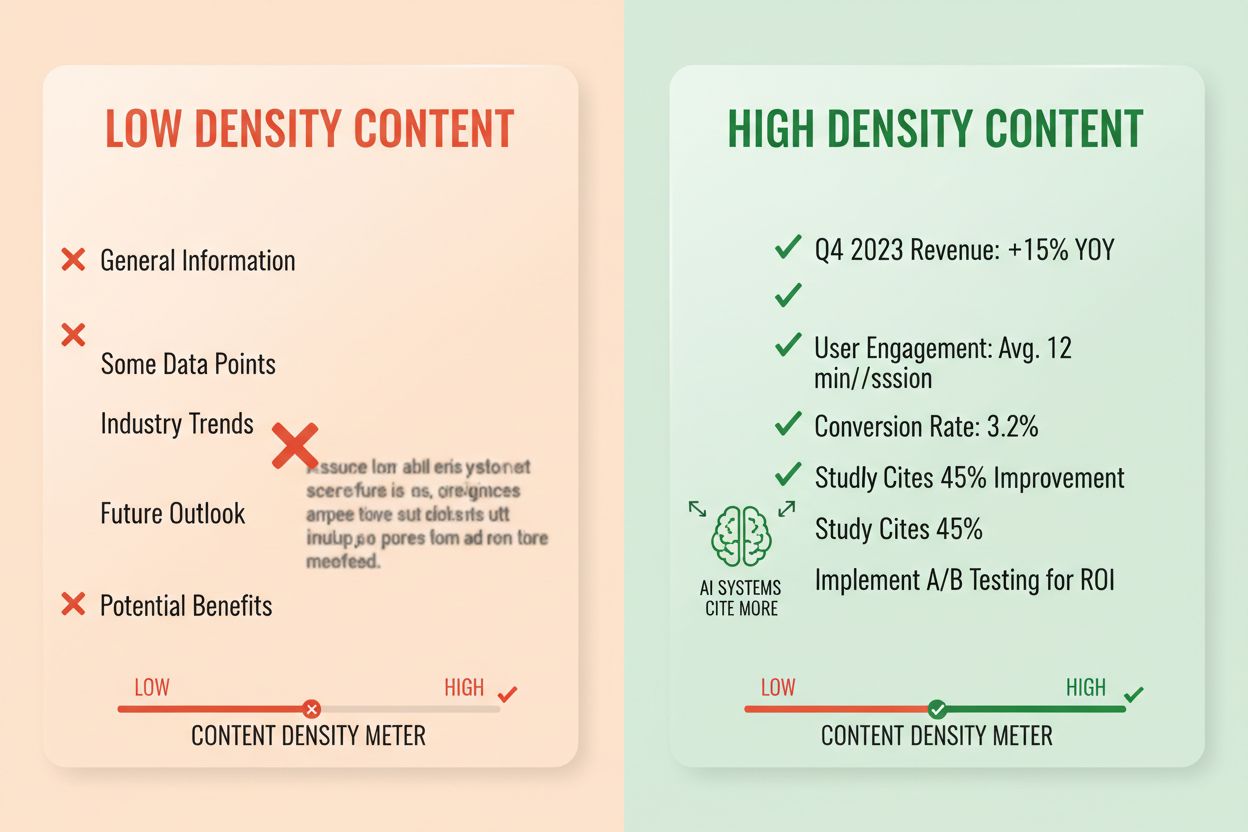

Hustota odpovědí měří poměr akčních informací k celkovému počtu slov a obsah s vysokou hustotou získává 2–3× více AI citací než alternativy s nízkou hustotou. Odstavec s hustotou 80 % obsahuje převážně tvrzení, důkazy a akční postřehy, zatímco odstavec se 40 % zahrnuje významné množství vaty, opakování nebo budování kontextu, které přímo nepodporuje jádro odpovědi. AI systémy hustotu hodnotí implicitně – pravděpodobněji extrahují a citují pasáže, kde každá věta přispívá k zodpovězení dotazu uživatele. Vysoce husté prvky zahrnují konkrétní statistiky, postupné instrukce, srovnávací data, definice a akční doporučení. Nízko husté vzorce zahrnují dlouhé úvody, opakující se koncepty, řečnické otázky a příběhy, které jádro tvrzení nerozvíjí.

Metodika měření: Spočítejte věty, které přímo odpovídají na otázku, oproti větám, které poskytují kontext nebo přechod. Vysoce hustý odstavec může znít: „Obsah připravený k citaci získává 3–5× více AI zmínek (statistika). Dochází k tomu, protože AI systémy extrahují kompletní, samostatné odpovědi (vysvětlení). Pro maximalizaci hustoty použijte formátování s odpovědí na začátku a sémantické dělení (akce).“ Nízko hustá verze může doplnit: „Mnoho organizací zápasí s viditelností v AI. Digitální prostředí se rychle mění. Obsahová strategie se významně vyvinula. Obsah připravený k citaci je stále důležitější…“ Druhá verze rozředí hlavní sdělení kontextem, který přímo nepodporuje odpověď.

Skutečné dopady ve statistikách: Obsah s hustotou nad 70 % získává průměrně 4,2 citací měsíčně ve výstupech AI oproti 1,1 citacím u obsahu pod 40 % hustoty. Organizace, které restrukturalizovaly stávající obsah s cílem zvýšit hustotu, zaznamenaly v průměru 156% nárůst citací během 60 dní. Příklad vysoce hustého obsahu: „Používejte části o velikosti 256–512 tokenů pro optimální extrakci AI (tvrzení). Toto rozmezí zachovává kontext a zabraňuje zkracování (důkaz). Pro udržení sémantické soudržnosti použijte dělení podle odstavců (akce).“ Nízko hustá verze: „Dělení je pro AI systémy důležité. Existují různé přístupy k organizaci obsahu. Někteří lidé preferují menší části, jiní větší. Správný přístup závisí na vašich konkrétních potřebách.“ Vysoce hustá verze přináší akční rady; nízko hustá uvádí zřejmá fakta bez konkrétnosti.

Konkrétní struktury obsahu signalizují AI, že informace jsou uspořádány pro extrakci, což dramaticky zvyšuje pravděpodobnost citace. Sekce FAQ jsou obzvlášť účinné, protože explicitně párují otázky s odpověďmi, což AI umožňuje snadnou identifikaci a extrakci relevantních pasáží. Srovnávací tabulky umožňují AI rychle vyhodnotit více možností a citovat konkrétní řádky jako odpovědi na dotazy uživatelů. Postupné instrukce poskytují jasné sémantické hranice a jsou často citovány při dotazech typu „jak na to…“. Seznamy definic párují termíny s vysvětlením, čímž vytvářejí přirozené body extrakce. Shrnovací boxy zvýrazňují klíčové poznatky a seznamy (listicles) rozdělují komplexní témata do konkrétních, citovatelných položek.

Strukturální prvky maximalizující dohledatelnost AI:

Praktické příklady: FAQ sekce s otázkou „Co je hustota odpovědí?“ následovanou kompletní definicí a vysvětlením se stává přímým zdrojem citace. Srovnávací tabulka „Prvek připravený k citaci | Proč jej AI systémy upřednostňují“ (jako v sekci 2) je citována při porovnávacích dotazech. Postupný návod „Jak implementovat sémantické dělení“ s očíslovanými kroky je citovatelným návodem. Tyto struktury fungují, protože odpovídají způsobu, jakým AI obsah zpracovává a extrahuje – hledají jasné páry otázka-odpověď, strukturovaná srovnání a jednotlivé kroky.

Sémantický HTML5 markup signalizuje AI strukturu obsahu, zlepšuje přesnost extrakce a zvyšuje pravděpodobnost citace o 40–60 %. Použití správné hierarchie nadpisů (H1 pro hlavní téma, H2 pro podtémata, H3 pro podpůrné body) pomáhá AI pochopit vztahy v obsahu a identifikovat hranice extrakce. Sémantické prvky jako <article>, <section> a <aside> poskytují další kontext o účelu obsahu. Strukturovaná data schema.org – zejména ve formátu JSON-LD – AI explicitně sdělují, jaké informace se v obsahu nacházejí, což umožňuje jistější citace.

Příklad JSON-LD pro FAQ obsah:

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [{

"@type": "Question",

"name": "Co je hustota odpovědí?",

"acceptedAnswer": {

"@type": "Answer",

"text": "Hustota odpovědí měří poměr akčních informací k celkovému počtu slov. Obsah s vysokou hustotou získává 2–3× více AI citací než alternativy s nízkou hustotou."

}

}]

}

Příklad JSON-LD pro metadata článku:

{

"@context": "https://schema.org",

"@type": "Article",

"headline": "Vytváření LLM meta odpovědí",

"author": {"@type": "Organization", "name": "AmICited"},

"datePublished": "2024-01-15",

"articleBody": "..."

}

Meta obsah – včetně meta popisů a Open Graph tagů – pomáhá AI pochopit účel obsahu ještě před jeho zpracováním. Výkonové a přístupové vylepšení (rychlé načítání stránky, optimalizace pro mobily, správné alt texty) nepřímo podporují dohledatelnost AI tím, že obsah je plně prohledatelný a indexovatelný. Kontrolní seznam technické implementace: Je váš HTML sémantický a správně strukturovaný? Implementovali jste pro svůj typ obsahu schema.org markup? Odpovídají meta popisy obsahu? Je váš web optimalizovaný pro mobily a rychlý? Jsou obrázky opatřeny správným alt textem?

Monitoring citací se stal zásadním pro měření výkonu obsahu, přesto většina organizací nemá přehled o tom, jak často se jejich obsah objevuje v AI odpovědích. Testování vyhledatelnosti zahrnuje zadání cílových otázek hlavním LLM (ChatGPT, Claude, Gemini) a zaznamenání, které zdroje jsou v odpovědích citovány. Audit obsahu systematicky kontroluje stávající obsah podle standardů připravenosti k citaci, čímž odhaluje mezery a příležitosti k optimalizaci. Výkonnostní metriky by měly sledovat frekvenci citací, kontext citace (jak je obsah použit) a růst citací v čase. Iterativní optimalizace znamená testování strukturálních změn, měření jejich dopadu na frekvenci citací a rozšiřování úspěšných postupů.

| Nástroj sledování | Hlavní funkce | Nejvhodnější pro |

|---|---|---|

| AmICited.com | Komplexní monitoring AI citací napříč všemi hlavními LLM | Kompletní přehled o citacích a konkurenční analýzu |

| Otterly.AI | Detekce AI obsahu a sledování citací | Zjištění, kde se váš obsah objevuje ve výstupech AI |

| Peec AI | Výkon obsahu v AI systémech | Měření frekvence a trendů citací |

| ZipTie | Monitoring AI-generovaného obsahu | Sledování zmínek o značce v AI odpovědích |

| PromptMonitor | Analýza výstupů LLM | Pochopení, jak AI využívá váš obsah |

AmICited.com vyniká jako nejlepší řešení, protože poskytuje monitoring v reálném čase napříč ChatGPT, Claude, Gemini a dalšími hlavními LLM, nabízí konkurenční benchmarking a detailní kontext citací. Platforma ukazuje nejen to, zda je váš obsah citován, ale i jak je použit – zda je citován přímo, parafrázován nebo použit jako podpůrný důkaz. Metodika měření: Stanovte základní frekvenci citací pro svých top 20 obsahových položek. Proveďte optimalizace připravené na citace u 5–10 položek. Změřte změny citací za 30–60 dní. Rozšiřte úspěšné postupy na zbytek obsahu. Sledujte metriky včetně frekvence, růstu, kontextu a podílu citací oproti konkurenci.

Chyba 1: Skrytí odpovědi v kontextu. Mnoho autorů začíná úvodními informacemi, historickým kontextem nebo popisem problému před samotnou odpovědí. AI hodnotí relevanci v prvních 50–100 tokenech; pokud odpověď není přítomná, přechází k dalšímu zdroji. Problém: Uživatel se ptá „Co je hustota odpovědí?“ a narazí na odstavec začínající „Obsahová strategie se významně vyvinula…“ místo definice. Řešení: Používejte formátování s odpovědí na začátku – uveďte klíčový postřeh nejprve, až poté podpůrný kontext.

Chyba 2: Odpovědi vyžadující externí kontext. Obsah odkazující na „předchozí sekci“ nebo „jak již bylo zmíněno“ nelze extrahovat samostatně. Problém: Odstavec typu „Podle dříve popsaného postupu proveďte tyto kroky…“ selhává, protože zmíněný postup v extrahované části není. Řešení: Každá odpověď musí být samostatná; potřebný kontext zahrňte přímo do části, i za cenu drobného opakování.

Chyba 3: Kombinování více odpovědí v jedné části. Odstavce odpovídající na více otázek nutí AI buď zkracovat, nebo zahrnovat nerelevantní informace. Problém: 600slovný odstavec pokrývající „Co je hustota odpovědí?“, „Jak ji měřit?“ a „Proč je důležitá?“ je pro extrakci příliš velký. Řešení: Každou jednotlivou otázku nebo koncept zpracujte v samostatné, zaměřené části.

Chyba 4: Používání vágního jazyka místo konkrétních metrik. Výrazy jako „mnoho“, „někteří“, „často“ a „typicky“ snižují důvěru v citaci kvůli nepřesnosti. Problém: „Mnoho organizací zaznamenalo zlepšení“ je méně citovatelné než „Organizace, které restrukturalizovaly obsah, dosáhly 156% nárůstu citací.“ Řešení: Nahrazujte vágní slova konkrétními daty; pokud přesná čísla nejsou, použijte rozpětí („40–60 %“) místo vágních výrazů.

Chyba 5: Opomíjení strukturálního markupu. Obsah bez správné HTML struktury, nadpisů nebo schema.org markup je pro AI obtížněji zpracovatelný a extrahovatelný. Problém: Odstavec bez nadpisu, sémantického HTML a schema markup je vnímán jako běžný text, ne jako samostatná odpověď. Řešení: Používejte sémantický HTML5, správnou hierarchii nadpisů a schema.org markup pro daný typ obsahu.

Chyba 6: Odpovědi příliš krátké nebo příliš dlouhé. Části pod 150 tokenů postrádají dostatečný kontext; části nad 700 tokenů nutí AI odpověď zkrátit. Problém: 100slovná odpověď postrádá podpůrné důkazy; 1000slovná je rozdělena do více extrakcí. Řešení: Cilte na 256–512 tokenů (2–4 odstavce); zahrňte tvrzení, důkaz a závěr v tomto rozmezí.

Konzistence entit – používání totožné terminologie pro stejný pojem napříč obsahem – zvyšuje pravděpodobnost citace AI, protože signalizuje autoritativní znalosti. Pokud v jedné sekci definujete „hustotu odpovědí“, používejte tento termín důsledně a nestřídejte jej například s „informační hustotou“ nebo „hustotou obsahu“. AI rozpoznává konzistenci entit jako signál odbornosti a pravděpodobněji cituje obsah, kde je terminologie přesná a jednotná. Platí to pro názvy produktů, metodiky i technické pojmy – konzistence buduje důvěru v přesnost citace.

Zmínky třetích stran a původní výzkum dramaticky zvyšují frekvenci citací. Obsah odkazující na jiné autoritativní zdroje (s řádným uvedením) signalizuje důvěryhodnost, zatímco původní výzkum nebo vlastní data činí váš obsah jedinečně citovatelným. Když uvedete statistiky z vlastního výzkumu nebo případové studie vlastních klientů, AI to rozpozná jako originální poznatek, který jinde nenajde. Organizace publikující původní výzkum mají 3–4× vyšší míru citací než ty, které pouze syntetizují informace. Strategie: Proveďte původní výzkum ve svém oboru, publikujte výsledky s detailní metodikou a odkazujte na ně ve svých meta odpovědích.

Signály aktuálnosti – data publikace, data aktualizace a odkazy na nedávné události – pomáhají AI vnímat novost obsahu. Obsah aktualizovaný v posledních 30 dnech získává vyšší prioritu citace než zastaralý obsah, zejména u témat s častou změnou informací. Datum publikace zahrňte do schema.org markup a při úpravách obsahu aktualizujte časové značky. Strategie: Zaveďte plán obnovy obsahu; aktualizujte nejvýkonnější obsah každých 30–60 dní o nové statistiky, aktuální příklady nebo rozšířená vysvětlení.

Signály E-E-A-T (Zkušenost, Odbornost, Autoritativnost, Důvěryhodnost) ovlivňují rozhodování AI o citaci. Obsah od renomovaných expertů, publikovaný na autoritativních doménách a podložený odborností získává vyšší prioritu citace. Přidejte do článků životopisy autorů s relevantními údaji, publikujte na ověřených doménách a budujte zpětné odkazy z autoritativních zdrojů. Strategie: Uvádějte odborné autory, doplňujte bio s odbornými údaji a získávejte odkazy z uznávaných médií.

Generativní hustota značky – poměr značkových postřehů ke generickým informacím – určuje, zda vás AI cituje, nebo dá přednost konkurenci. Obsah zahrnující vlastní frameworky, unikátní metodiky nebo značkové postupy je častěji citovatelný, protože je odlišitelný. Generický obsah o „nejlepších postupech“ je citován méně často než například „Rámec optimalizace citací AmICited“, protože značka je jedinečná a dohledatelná. Organizace s vysokou generativní hustotou značky získávají 2–3× více citací než ty, které publikují obecný obsah. Strategie: Vyvíjejte vlastní frameworky, metodiky nebo terminologii, používejte je konzistentně napříč obsahem a stavte na nich své meta odpovědi.

LLM meta odpovědi jsou navrženy speciálně pro extrakci a citaci AI, zatímco featured snippets jsou optimalizovány pro zobrazování ve výsledcích vyhledávání Google. Meta odpovědi dávají přednost samostatné úplnosti a sémantické soudržnosti, zatímco featured snippets se zaměřují na stručnost a shodu klíčových slov. Oba typy mohou koexistovat ve vašem obsahu, ale meta odpovědi vyžadují odlišnou strukturální optimalizaci.

Optimální délka je 256–512 tokenů, což odpovídá přibližně 2–4 dobře strukturovaným odstavcům nebo 200–400 slovům. Toto rozmezí zachovává dostatečný kontext pro spolehlivou extrakci AI a zároveň zabraňuje zkracování. Kratší odpovědi postrádají kontext; delší odpovědi nutí AI systémy odpověď zestručnit nebo rozdělit do více extrakcí.

Ano, ale vyžaduje to restrukturalizaci. Zkontrolujte stávající obsah z hlediska formátování s odpovědí na začátku, sémantické soudržnosti a samostatné úplnosti. Většinu obsahu lze přizpůsobit přesunutím klíčových postřehů na začátek, odstraněním vzájemných odkazů a zajištěním, že každá sekce odpovídá na kompletní otázku bez nutnosti externího kontextu.

Nejvýkonnější obsah aktualizujte každých 30–60 dní novými statistikami, aktuálními příklady nebo rozšířenými vysvětleními. AI systémy upřednostňují obsah aktualizovaný v posledních 30 dnech, zejména u témat, kde se informace často mění. Do schema.org značky zahrňte datum publikace a čas poslední aktualizace.

Hustota odpovědí přímo koreluje s frekvencí citací. Obsah s hustotou odpovědí nad 70 % průměrně získává 4,2 citací měsíčně ve výstupech AI, zatímco obsah pod 40 % hustoty jen 1,1 citací. Vysoce hustý obsah poskytuje akční informace bez zbytečné vaty, díky čemuž je pro AI systémy hodnotnější k citaci.

Použijte platformy pro sledování citací, jako je AmICited.com, která sleduje citace napříč ChatGPT, Claude, Gemini a dalšími hlavními LLM. Proveďte manuální testování zadáním cílových otázek do AI systémů a zaznamenejte, které zdroje jsou citovány. Změřte základní frekvenci citací, proveďte optimalizace a sledujte změny během 30–60 dní.

Základní struktura meta odpovědi zůstává napříč platformami stejná, ale můžete optimalizovat pro specifické preference dané platformy. ChatGPT upřednostňuje komplexní, dobře doložený obsah. Perplexity zdůrazňuje aktuální informace a jasné citace. Google AI Overviews klade důraz na strukturovaná data a signály E-E-A-T. Testujte varianty a sledujte výkon citací napříč platformami.

AmICited poskytuje monitoring citací vašeho obsahu v reálném čase napříč všemi hlavními AI platformami, ukazuje přesně, kde se vaše meta odpovědi objevují, jak jsou používány a podíl na citacích v porovnání s konkurencí. Platforma odhaluje kontext citace – zda je obsah citován přímo, parafrázován nebo použit jako podpůrný důkaz – což umožňuje rozhodování na základě dat.

Zjistěte přesně, kde je váš obsah citován ChatGPT, Perplexity, Google AI Overviews a dalšími AI systémy. Sledujte trendy citací, monitorujte konkurenci a optimalizujte svou obsahovou strategii s AmICited.

Zjistěte, co jsou LLM Meta Odpovědi a jak optimalizovat svůj obsah pro viditelnost v AI-generovaných odpovědích z ChatGPT, Perplexity a Google AI Overviews. Obj...

Naučte se ověřené strategie citování zdrojů, aby byl váš obsah důvěryhodný pro LLM. Objevte, jak získat AI citace od ChatGPT, Perplexity a Google AI Overviews p...

Naučte se osvědčené techniky, jak zlidštit AI-generovaný obsah pro lepší citace v AI generátorech odpovědí. Zvýšíte autentičnost, zlepšíte viditelnost ve výsled...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.