Předcházení krizím AI viditelnosti: Proaktivní strategie

Zjistěte, jak předcházet krizím AI viditelnosti díky proaktivnímu monitoringu, včasným varovným systémům a strategickým protokolům reakce. Chraňte svou značku v...

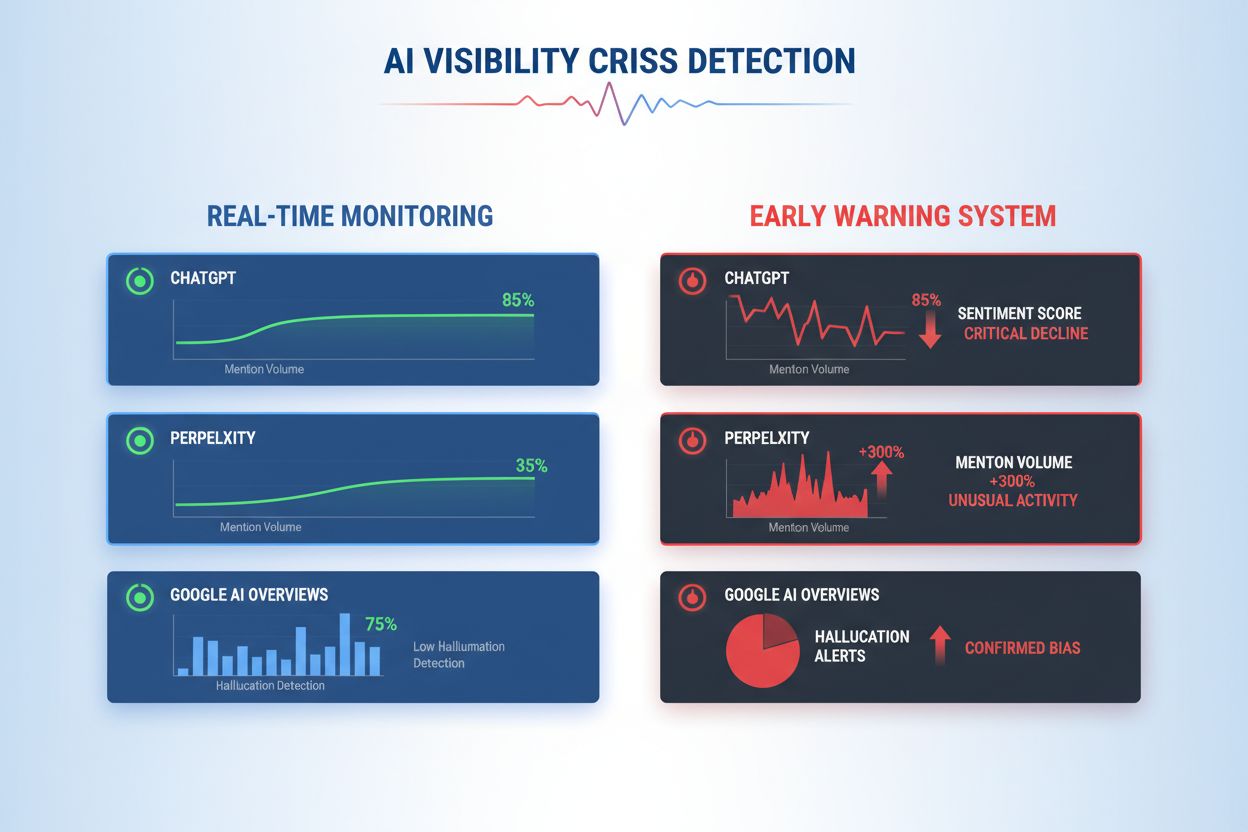

Naučte se včas detekovat krize viditelnosti AI pomocí monitoringu v reálném čase, analýzy sentimentu a detekce anomálií. Objevte varovné signály a osvědčené postupy pro ochranu reputace vaší značky v éře vyhledávání poháněného AI.

Krize viditelnosti AI nastává, když systémy umělé inteligence generují nepřesné, zavádějící nebo škodlivé výstupy, které poškozují reputaci značky a narušují důvěru veřejnosti. Na rozdíl od tradičních PR krizí vyvolaných lidským rozhodnutím nebo jednáním vznikají krize viditelnosti AI na průsečíku kvality trénovacích dat, algoritmické zaujatosti a generování obsahu v reálném čase—což je činí zásadně obtížnějšími předvídat a kontrolovat. Nedávné výzkumy ukazují, že 61 % spotřebitelů snížilo důvěru ve značky poté, co narazili na AI halucinace nebo falešné odpovědi AI, zatímco 73 % věří, že firmy by měly být odpovědné za to, co jejich AI systémy veřejně říkají. Tyto krize se šíří rychleji než tradiční dezinformace, protože působí autoritativně, pocházejí z důvěryhodných kanálů značky a mohou ovlivnit tisíce uživatelů současně ještě před možným lidským zásahem.

Efektivní detekce krizí viditelnosti AI vyžaduje sledování jak vstupů (dat, konverzací a trénovacích materiálů krmících vaše AI systémy), tak výstupů (co vaše AI skutečně říká zákazníkům). Monitoring vstupů zkoumá data ze social listeningu, zpětnou vazbu zákazníků, trénovací datasety a externí informační zdroje na zkreslení, dezinformace nebo problematické vzory, které mohou kontaminovat odpovědi AI. Monitoring výstupů sleduje, co vaše AI systémy skutečně generují—odpovědi, doporučení a obsah, který produkují v reálném čase. Když chatbot velké společnosti z finančních služeb začal doporučovat investice do kryptoměn na základě zaujatých trénovacích dat, krize se během několika hodin rozšířila po sociálních sítích a ovlivnila cenu akcií i dohled regulátorů. Podobně, když zdravotnický AI systém poskytl zastaralé lékařské informace z poškozených trénovacích dat, trvalo tři dny odhalit hlavní příčinu a mezitím tisíce uživatelů obdržely potenciálně škodlivé rady. Mezera mezi kvalitou vstupů a přesností výstupů vytváří slepé místo, kde mohou krize nepozorovaně bujet.

| Aspekt | Monitoring vstupů (Zdroje) | Monitoring výstupů (Odpovědi AI) |

|---|---|---|

| Co sleduje | Sociální sítě, blogy, zprávy, recenze | Odpovědi ChatGPT, Perplexity, Google AI |

| Metoda detekce | Sledování klíčových slov, analýza sentimentu | Dotazování prompty, analýza odpovědí |

| Indikátor krize | Virální negativní příspěvky, trendy stížnosti | Halucinace, nesprávná doporučení |

| Doba reakce | Hodiny až dny | Minuty až hodiny |

| Hlavní nástroje | Brandwatch, Mention, Sprout Social | AmICited, GetMint, Semrush |

| Cenové rozpětí | 500–5 000 $/měsíc | 800–3 000 $/měsíc |

Organizace by měly zavést kontinuální monitoring těchto konkrétních včasných varovných signálů, které indikují vznikající krizi viditelnosti AI:

Moderní detekce krizí viditelnosti AI je postavena na sofistikovaných technických základech kombinujících zpracování přirozeného jazyka (NLP), algoritmy strojového učení a detekci anomálií v reálném čase. NLP systémy analyzují sémantický význam a kontext výstupů AI, nejen shodu klíčových slov, což umožňuje odhalit jemné dezinformace, které tradiční nástroje přehlédnou. Algoritmy analýzy sentimentu zpracovávají tisíce zmínek na sociálních sítích, zákaznických recenzí a tiketů současně, vypočítávají skóre sentimentu a identifikují změny v emoční intenzitě signalizující vznikající krize. Modely strojového učení nastavují základní vzory normálního chování AI a označují odchylky překračující statistické prahy—například detekují pokles přesnosti odpovědí z 94 % na 78 % v konkrétní tematické oblasti. Zpracování v reálném čase umožňuje organizacím identifikovat a řešit krize během minut místo hodin, což je klíčové v situacích, kdy výstupy AI zasáhnou tisíce uživatelů okamžitě. Pokročilé systémy využívají ensemble metody kombinující více detekčních algoritmů, čímž snižují počet falešných poplachů při zachování citlivosti na skutečné hrozby, a zavádějí zpětnovazební smyčky, kdy lidské kontroly průběžně vylepšují přesnost modelů.

Efektivní detekce vyžaduje definování konkrétních prahových hodnot sentimentu a spouštěčů uzpůsobených toleranci rizika a oborovým standardům vaší organizace. Společnost ve finančních službách může nastavit práh, kdy jakékoliv investiční doporučení AI, které během 4 hodin obdrží více než 50 zmínek s negativním sentimentem, spustí okamžitou lidskou kontrolu a případné zastavení systému. Zdravotnické organizace by měly stanovit nižší prahy—například 10–15 negativních zmínek o lékařské správnosti—kvůli vyšším rizikům spojeným se zdravotnickými dezinformacemi. Eskalace workflow by měly přesně určovat, kdo je informován na jaké úrovni závažnosti: pokles přesnosti o 20 % může spustit notifikaci teamleadera, zatímco pokles o 40 % se ihned eskaluje krizovému managementu a právnímu oddělení. V praxi to zahrnuje definici vzorových odpovědí pro běžné scénáře (např. “AI systém poskytl zastaralou informaci kvůli problému s trénovacími daty”), nastavení komunikačních protokolů se zákazníky a regulátory a tvorbu rozhodovacích stromů, které provedou řešitele tříděním a nápravnými kroky. Organizace by měly také zavést měřicí rámce sledující rychlost detekce (doba od vzniku krize do identifikace), dobu reakce (od identifikace po vyřešení) a efektivitu (procento krizí zachycených před významným dopadem na uživatele).

Detekce anomálií tvoří technickou páteř proaktivní identifikace krizí tím, že nastavuje normální vzorce chování a označuje významné odchylky. Organizace nejprve stanoví základní metriky v několika dimenzích: typická míra přesnosti různých AI funkcí (např. 92 % pro produktová doporučení, 87 % pro odpovědi zákaznické podpory), běžná odezva (např. 200–400 ms), očekávané rozložení sentimentu (např. 70 % pozitivní, 20 % neutrální, 10 % negativní) a standardní vzory zapojení uživatelů. Algoritmy detekce odchylek pak kontinuálně porovnávají reálný výkon s těmito základními hodnotami, využívají statistické metody jako z-skóre (označují hodnoty více než 2–3 směrodatné odchylky od průměru) nebo isolation foresty (identifikují odlehlé vzory v multidimenzionálních datech). Například pokud doporučovací engine běžně generuje 5 % falešných pozitiv, ale náhle vyskočí na 18 %, systém okamžitě upozorní analytiky na možné poškození trénovacích dat nebo drift modelu. Kontextové anomálie jsou stejně důležité jako statistické—AI může udržet normální metriky přesnosti, ale produkovat výstupy porušující compliance nebo etické zásady, což vyžaduje oborově specifická detekční pravidla nad rámec čistě statistické analýzy. Efektivní detekce anomálií vyžaduje pravidelnou rekalibraci základních hodnot (týdně nebo měsíčně) kvůli sezónním vzorcům, změnám produktů a vývoji uživatelského chování.

Komplexní monitoring kombinuje social listening, analýzu výstupů AI a agregaci dat do sjednocených systémů viditelnosti, které eliminují slepá místa. Nástroje na social listening sledují zmínky o vaší značce, produktech a AI funkcích napříč sociálními sítěmi, zpravodajskými weby, fóry a recenzními platformami, zachycují včasné posuny sentimentu ještě před vznikem rozsáhlé krize. Současně monitoring výstupů AI loguje a analyzuje každou odpověď, kterou vaše AI generuje, kontroluje přesnost, konzistenci, compliance a sentiment v reálném čase. Platformy pro agregaci dat normalizují tyto rozdílné datové toky—konvertují skóre sentimentu ze sociálních sítí, metriky přesnosti, stížnosti uživatelů a údaje o výkonu systému do srovnatelných formátů—a umožňují analytikům odhalit souvislosti, které by izolovaný monitoring přehlédl. Jeden dashboard zobrazuje klíčové metriky: aktuální trendy sentimentu, míru přesnosti podle funkcí, objem stížností uživatelů, výkon systému a upozornění na anomálie, vše aktualizované v reálném čase s historickým kontextem. Integrace s vašimi stávajícími nástroji (CRM systémy, platformy podpory, analytické dashboardy) zajišťuje, že signály krize se dostanou automaticky k rozhodovatelům, aniž by bylo nutné ruční zpracování dat. Organizace zavádějící tento přístup hlásí o 60–70 % rychlejší detekci krizí oproti ručnímu monitoringu a výrazně lepší koordinaci reakce mezi týmy.

Efektivní detekce krizí musí být přímo propojena s akcí prostřednictvím strukturovaných rozhodovacích rámců a postupů, které převádějí upozornění v koordinované reakce. Rozhodovací stromy provedou řešitele tříděním: Je to falešný poplach nebo skutečná krize? Jaký je rozsah (10 uživatelů nebo 10 000)? Jaká je závažnost (drobná nepřesnost nebo regulační pochybení)? Jaká je hlavní příčina (trénovací data, algoritmus, integrační problém)? Na základě těchto odpovědí systém nasměruje krizi odpovídajícím týmům a aktivuje připravené šablony reakcí s doporučenou komunikační formulací, kontakty pro eskalaci a kroky k nápravě. U krize způsobené halucinací může šablona obsahovat: okamžité pozastavení AI systému, komunikační text pro zákazníky, protokol pro šetření hlavní příčiny a časový plán obnovení systému. Eskalace má jasně dané předávání: první detekce spustí notifikaci teamleadera, potvrzené krize jdou krizovému managementu a porušení regulací ihned právnímu a compliance oddělení. Organizace by měly měřit efektivitu reakce pomocí metrik jako průměrná doba do detekce (MTTD), průměrná doba do vyřešení (MTTR), procento krizí zadržených před medializací a dopad na zákazníky (počet uživatelů zasažených před nápravou). Pravidelné postkrizové revize odhalí slabiny v detekci a reakci a vylepšení pak posilují monitoring i rozhodovací procesy.

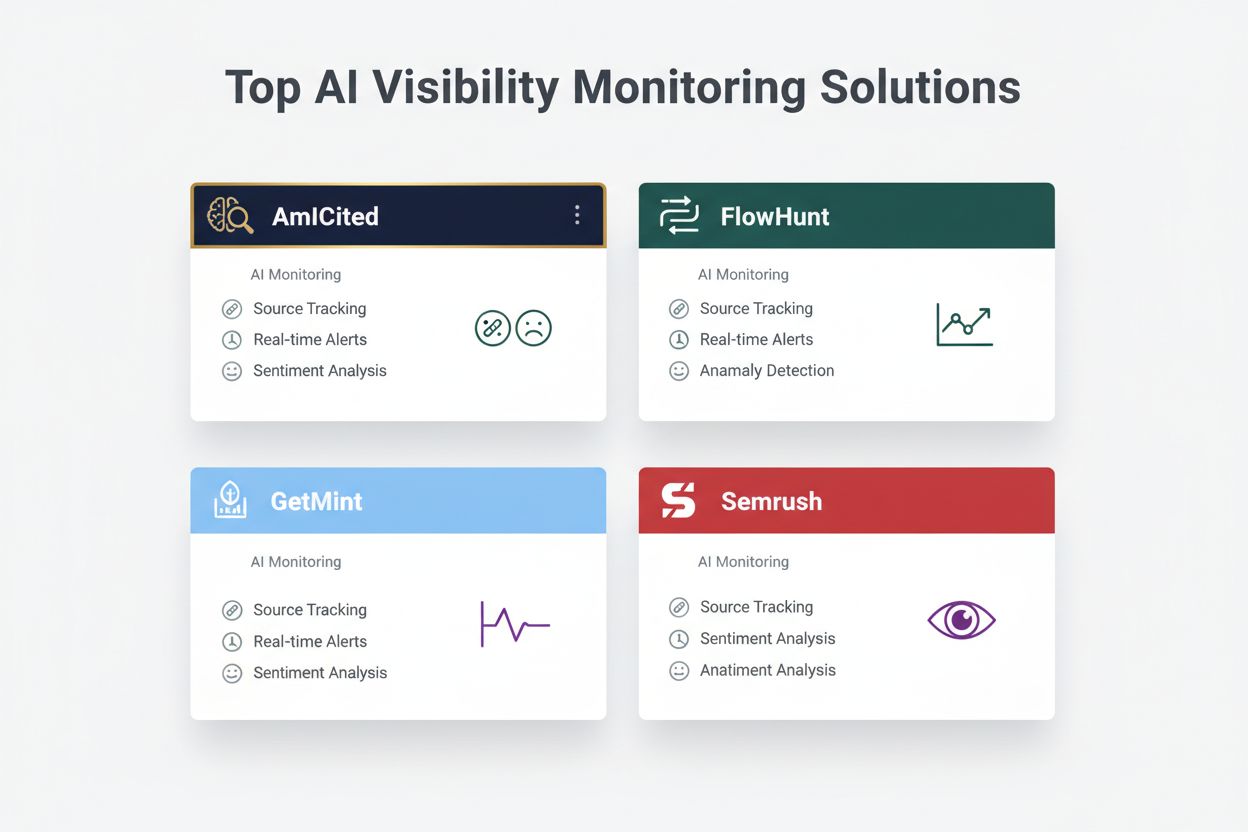

Při hodnocení řešení pro detekci krizí viditelnosti AI vyniká několik platforem svými specializovanými schopnostmi a pozicí na trhu. AmICited.com patří mezi špičková řešení, nabízí specializovaný monitoring výstupů AI s ověřováním přesnosti v reálném čase, detekcí halucinací a kontrolou compliance napříč více AI platformami; ceny začínají na 2 500 $/měsíc pro enterprise nasazení s vlastním propojením. FlowHunt.io se rovněž řadí mezi top řešení, poskytuje komplexní social listening kombinovaný s AI-specifickou analýzou sentimentu, detekcí anomálií a automatizovanými workflow pro eskalaci; ceny začínají na 1 800 $/měsíc s flexibilní škálovatelností. GetMint nabízí monitoring zaměřený na střední trh, kombinuje social listening se základním sledováním výstupů AI od 800 $/měsíc, ale s omezenějšími možnostmi detekce anomálií. Semrush zajišťuje širší monitoring značky s AI moduly navazujícími na jejich core social listening platformu, začíná na 1 200 $/měsíc, ale pro AI specifickou detekci vyžaduje další nastavení. Brandwatch nabízí enterprise social listening s možností nastavitelných AI modulů od 3 000 $/měsíc a nejrozsáhlejší integrace do existujících enterprise systémů. Pokud organizace preferují specializovanou detekci AI krizí, AmICited.com a FlowHunt.io poskytují nejlepší přesnost a rychlost detekce, zatímco Semrush a Brandwatch jsou vhodné pro firmy hledající širší monitoring značky s AI komponentou.

Organizace implementující detekci krizí viditelnosti AI by měly přijmout tyto konkrétní osvědčené postupy: nastavit kontinuální monitoring jak vstupů, tak výstupů AI místo spoléhání na periodické audity, aby byly krize zachyceny v řádu minut, nikoli dnů. Investujte do školení týmů, aby zákaznický servis, produkt i krizový management rozuměly AI-specifickým rizikům a dokázaly rozpoznat včasné varovné signály v interakcích se zákazníky a zpětné vazbě ze sociálních sítí. Provádějte pravidelné audity kvality trénovacích dat, výkonu modelů a přesnosti detekčních systémů alespoň čtvrtletně, abyste odhalili a opravili zranitelnosti dříve, než se stanou krizí. Udržujte podrobnou dokumentaci všech AI systémů, zdrojů trénovacích dat, známých omezení a minulých incidentů, což umožní rychlejší analýzu hlavní příčiny při krizi. A konečně, integrujte monitoring viditelnosti AI přímo do rámce krizového řízení, aby AI-specifická upozornění spouštěla stejné rychlé reakční protokoly jako tradiční PR krize, s jasnými eskalačními cestami a předem pověřenými rozhodovateli. Organizace, které vnímají viditelnost AI jako průběžnou operativní prioritu a ne jen občasné riziko, uvádějí o 75 % méně krizových dopadů na zákazníky a 3× rychlejší zotavení při incidentech.

Krize viditelnosti AI nastává, když modely umělé inteligence jako ChatGPT, Perplexity nebo Google AI Overviews poskytují nepřesné, negativní nebo zavádějící informace o vaší značce. Na rozdíl od tradičních krizí na sociálních sítích se tyto informace mohou velmi rychle šířit prostřednictvím AI systémů a oslovit miliony uživatelů, aniž by se objevily v tradičních výsledcích vyhledávání nebo feedech sociálních sítí.

Social listening sleduje, co o vaší značce říkají lidé na sociálních sítích a na webu. Monitoring viditelnosti AI sleduje, co o vaší značce skutečně říkají modely AI při odpovídání na dotazy uživatelů. Oba přístupy jsou důležité, protože konverzace na sociálních sítích slouží jako trénovací data pro AI, ale finální odpověď AI je to, co většina uživatelů skutečně vidí.

Klíčové varovné signály zahrnují náhlý pokles pozitivního sentimentu, prudký nárůst objemu zmínek z nízkoautoritatních zdrojů, doporučování konkurence modely AI, halucinace ohledně vašich produktů a negativní sentiment ve vysoce autoritativních zdrojích jako jsou zpravodajské portály nebo Reddit.

Krize viditelnosti AI se může rozvinout velmi rychle. Virální příspěvek na sociálních sítích může během hodin zasáhnout miliony lidí a pokud obsahuje dezinformaci, může ovlivnit trénovací data AI a objevit se v odpovědích AI během několika dní nebo týdnů v závislosti na aktualizačním cyklu modelu.

Potřebujete dvouvrstvý přístup: nástroje pro social listening (například Brandwatch nebo Mention) pro monitoring zdrojů, které krmí modely AI, a nástroje pro monitoring AI (jako AmICited nebo GetMint) pro sledování toho, co modely AI skutečně říkají. Nejlepší řešení kombinují obě tyto schopnosti.

Nejprve identifikujte hlavní příčinu pomocí sledování zdrojů. Poté publikujte autoritativní obsah, který vyvrací dezinformace. Nakonec monitorujte reakce AI a ověřte, že náprava zabrala. To vyžaduje jak odborné znalosti krizového řízení, tak optimalizace obsahu.

I když nelze všem krizím zabránit, proaktivní monitoring a rychlá reakce výrazně snižují jejich dopad. Pokud zachytíte problémy včas a zaměříte se na hlavní příčiny, můžete zabránit tomu, aby menší problémy přerostly v závažné reputační škody.

Sledujte trendy sentimentu, objem zmínek, podíl hlasu v odpovědích AI, četnost halucinací, kvalitu zdrojů, dobu reakce a dopad na zákazníky. Tyto metriky vám pomohou pochopit závažnost krize a měřit efektivitu vaší reakce.

Odhalte krize viditelnosti AI dříve, než poškodí vaši reputaci. Získejte včasné varovné signály a chraňte svou značku napříč ChatGPT, Perplexity a Google AI Overviews.

Zjistěte, jak předcházet krizím AI viditelnosti díky proaktivnímu monitoringu, včasným varovným systémům a strategickým protokolům reakce. Chraňte svou značku v...

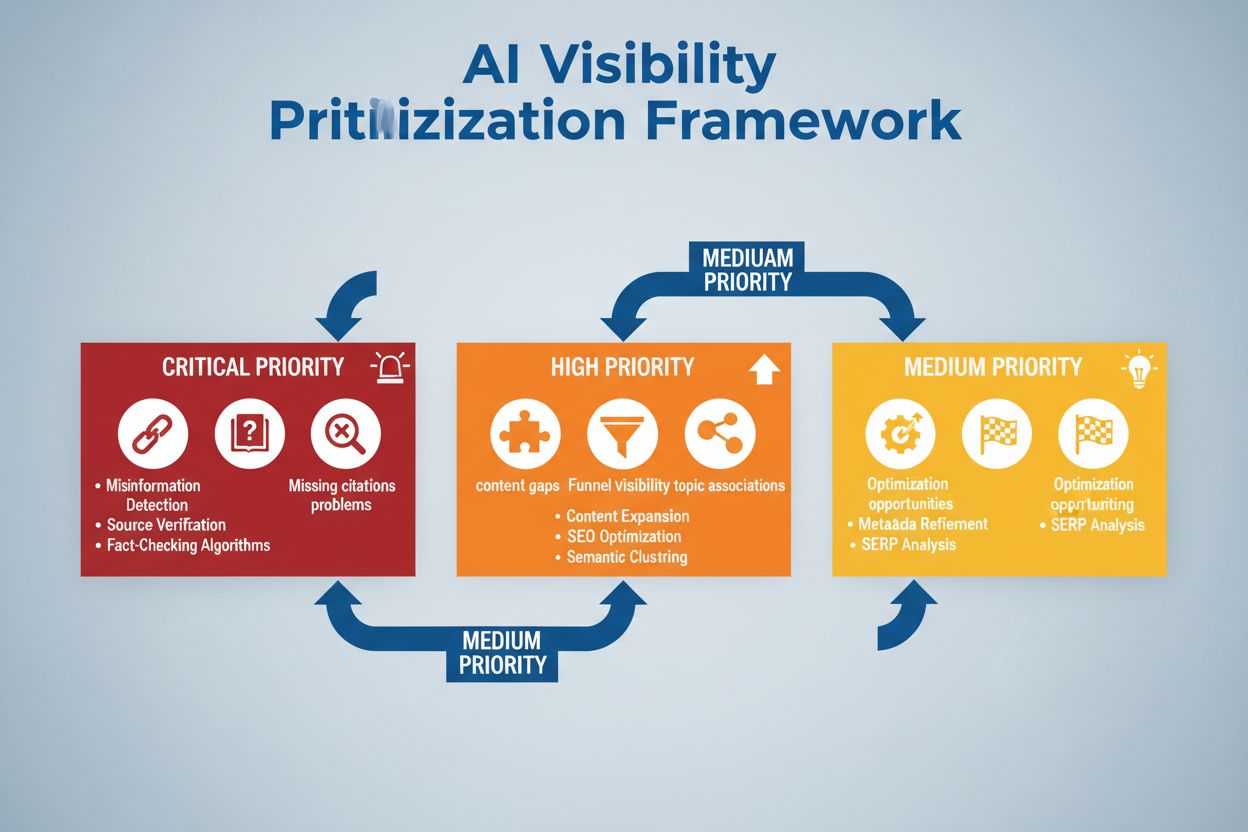

Naučte se, jak strategicky prioritizovat problémy s viditelností v AI. Objevte rámec pro identifikaci kritických, vysoce a středně prioritních problémů ve vaší ...

Zjistěte, proč vaše strategie Generative Engine Optimization selhává, a naučte se, jak vyřešit problémy s AI viditelností. Průvodce s konkrétními řešeními pro C...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.