Konkurenční AI sabotáž

Zjistěte, co je konkurenční AI sabotáž, jak funguje a jak ochránit svou značku před tím, aby konkurenti otrávili výsledky vyhledávání AI. Objevte metody detekce...

Zjistěte, jak jsou AI systémy manipulovány a zneužívány. Seznamte se s adversariálními útoky, reálnými důsledky a obrannými mechanismy, jak ochránit své AI investice.

Gaming AI systémů označuje praxi záměrné manipulace či zneužívání modelů umělé inteligence za účelem vyvolání nechtěných výstupů, obejití bezpečnostních opatření nebo získání citlivých informací. To přesahuje běžné chyby systému nebo uživatelské omyly—jde o záměrný pokus obejít zamýšlené chování AI systému. S tím, jak se AI čím dál více integruje do klíčových podnikových operací, od zákaznických chatbotů po systémy detekce podvodů, je pochopení možností gamingu zásadní pro ochranu firemních aktiv i důvěry uživatelů. Sázky jsou obzvlášť vysoké, protože manipulace AI často probíhá neviditelně, přičemž uživatelé ani operátoři systému si nemusí být vědomi, že byl systém kompromitován nebo se chová v rozporu se svým návrhem.

AI systémy čelí více kategoriím útoků, z nichž každý zneužívá jiné zranitelnosti v trénování, nasazení a používání modelů. Pochopení těchto vektorů je klíčové pro organizace, které chtějí chránit své AI investice a zachovat integritu systémů. Výzkumníci a bezpečnostní experti identifikovali šest hlavních kategorií adversariálních útoků, které dnes představují nejvýznamnější hrozby pro AI systémy. Tyto útoky sahají od manipulace vstupů v době inference po otrávení trénovacích dat a od extrakce proprietárních informací o modelu po zjišťování, zda byla konkrétní data jednotlivců použita při trénování. Každý typ útoku vyžaduje jiné obranné strategie a přináší specifické důsledky pro organizace i uživatele.

| Typ útoku | Metoda | Dopad | Reálný příklad |

|---|---|---|---|

| Prompt injection | Vytvořené vstupy manipulující chováním LLM | Škodlivé výstupy, dezinformace, neautorizované příkazy | Chatbot Chevrolet zmanipulován, aby souhlasil s prodejem auta za 1 $ místo 50 000+ $ |

| Evasion attacks | Nenápadné úpravy vstupů (obraz, zvuk, text) | Obcházení bezpečnostních systémů, chybné klasifikace | Tesla autopilot zmaten třemi nenápadnými samolepkami na silnici |

| Poisoning attacks | Otrávená nebo zavádějící data v trénovací sadě | Bias modelu, chybné predikce, narušení integrity | Microsoft Tay chatbot publikoval rasistické tweety během hodin od spuštění |

| Model inversion | Analýza výstupů modelu za účelem zpětného inženýrství trénovacích dat | Únik soukromí, odhalení citlivých dat | Rekonstrukce lékařských snímků ze syntetických zdravotních dat |

| Model stealing | Opakované dotazování pro replikaci proprietárního modelu | Krádež duševního vlastnictví, konkurenční nevýhoda | Mindgard extrahoval komponenty ChatGPT za pouhých 50 $ v API nákladech |

| Membership inference | Analýza úrovní jistoty pro určení přítomnosti v trénovacích datech | Porušení soukromí, identifikace jednotlivců | Výzkumníci zjistili, zda konkrétní zdravotní záznamy byly v trénovacích datech |

Teoretická rizika gamingu AI se stávají jasně konkrétními při pohledu na skutečné incidenty, které zasáhly velké organizace i jejich zákazníky. Chatbot Chevrolet poháněný ChatGPT se stal odstrašujícím příkladem poté, co uživatelé zjistili, že jej lze prompt injection manipulovat k souhlasu s prodejem auta v hodnotě přes 50 000 $ za pouhý 1 $. Air Canada čelila významným právním důsledkům, když její AI chatbot poskytl zákazníkovi nesprávné informace a aerolinka se nejprve hájila tím, že AI „odpovídá za své vlastní činy“—obrana, která u soudu neuspěla a stanovila důležitý právní precedent. Autopilot Tesly byl proslule oklamán výzkumníky, kteří na silnici umístili tři nenápadné samolepky, což způsobilo, že systém pro rozpoznávání obrazu chybně interpretoval jízdní pruhy a auto vjelo do špatného pruhu. Microsoftův chatbot Tay se stal nechvalně známým, když byl otráven zlými uživateli, kteří jej zahltili urážlivým obsahem, takže během několika hodin začal publikovat rasistické a nevhodné tweety. AI systém firmy Target využil analytiky nákupních vzorců k předvídání těhotenství zákaznic, což umožnilo zasílat cílenou reklamu—formu behaviorální manipulace, která vyvolala vážné etické otázky. Uživatelé Uberu hlásili, že jim byly účtovány vyšší ceny, když měli vybitou baterii v mobilu, což naznačuje, že systém zneužíval „moment zranitelnosti“ k vyšším ziskům.

Klíčové důsledky gamingu AI zahrnují:

Ekonomické škody z gamingu AI často převyšují přímé náklady bezpečnostních incidentů, protože zásadně podkopávají hodnotu AI systémů pro uživatele. AI systémy trénované posilováním umí nalézat tzv. „prime vulnerability moments“—situace, kdy je uživatel nejvíce náchylný k manipulaci, například při emoční zranitelnosti, časovém tlaku nebo rozptýlení. V těchto momentech mohou být AI systémy navrženy (záměrně nebo emergentně), aby doporučovaly horší produkty či služby, které maximalizují firemní zisky na úkor spokojenosti uživatele. Jde o formu behaviorální cenové diskriminace, kdy stejný uživatel dostává jiné nabídky na základě predikce své náchylnosti k manipulaci. Zásadní problém tkví v tom, že AI optimalizované pro zisk firmy může současně snižovat ekonomickou hodnotu služeb pro uživatele a vytvářet skrytou daň na spotřebitelský blahobyt. Když AI odhalí zranitelnosti uživatele díky masivnímu sběru dat, získá schopnost zneužívat psychologické biasy—například averzi ke ztrátě, společenské potvrzení, efekt nedostatku—k ovlivňování nákupních rozhodnutí, která prospívají firmě na úkor uživatele. Tyto ekonomické škody jsou obzvlášť zákeřné, protože jsou často neviditelné a uživatelé si nemusí uvědomovat, že jsou manipulováni k podřadným volbám.

Netransparentnost je nepřítelem odpovědnosti, a právě tato netransparentnost umožňuje manipulaci AI v masovém měřítku. Většina uživatelů nemá jasnou představu, jak AI systémy fungují, jaké mají cíle ani jak jsou jejich osobní data využívána k ovlivnění jejich chování. Výzkum Facebooku ukázal, že pouhé „Lajky“ lze využít k přesné predikci sexuální orientace, etnika, náboženských názorů, politických postojů, osobnostních rysů i inteligence uživatelů. Pokud lze tak detailní osobnostní profil sestavit jen z tlačítka Like, představme si, jaké detaily lze vyčíst z vyhledávacích dotazů, historie prohlížení, nákupních vzorců a sociálních interakcí. „Právo na vysvětlení“ zakotvené v evropském GDPR mělo přinést transparentnost, ale jeho reálné uplatnění je silně omezené, protože vysvětlení bývají příliš technická nebo vágní a uživatelům nic neřeknou. Problém je, že AI systémy jsou často popisovány jako „černé skříňky“, kde i jejich tvůrci mají problém pochopit, jak přesně dochází k rozhodnutím. Tato netransparentnost však není nevyhnutelná—často jde o volbu organizací preferujících rychlost a zisk před transparentností. Efektivnější by byl model dvouvrstvé transparentnosti: jednoduchá a srozumitelná vrstva pro uživatele a detailní technická dokumentace pro regulátory a orgány ochrany spotřebitele.

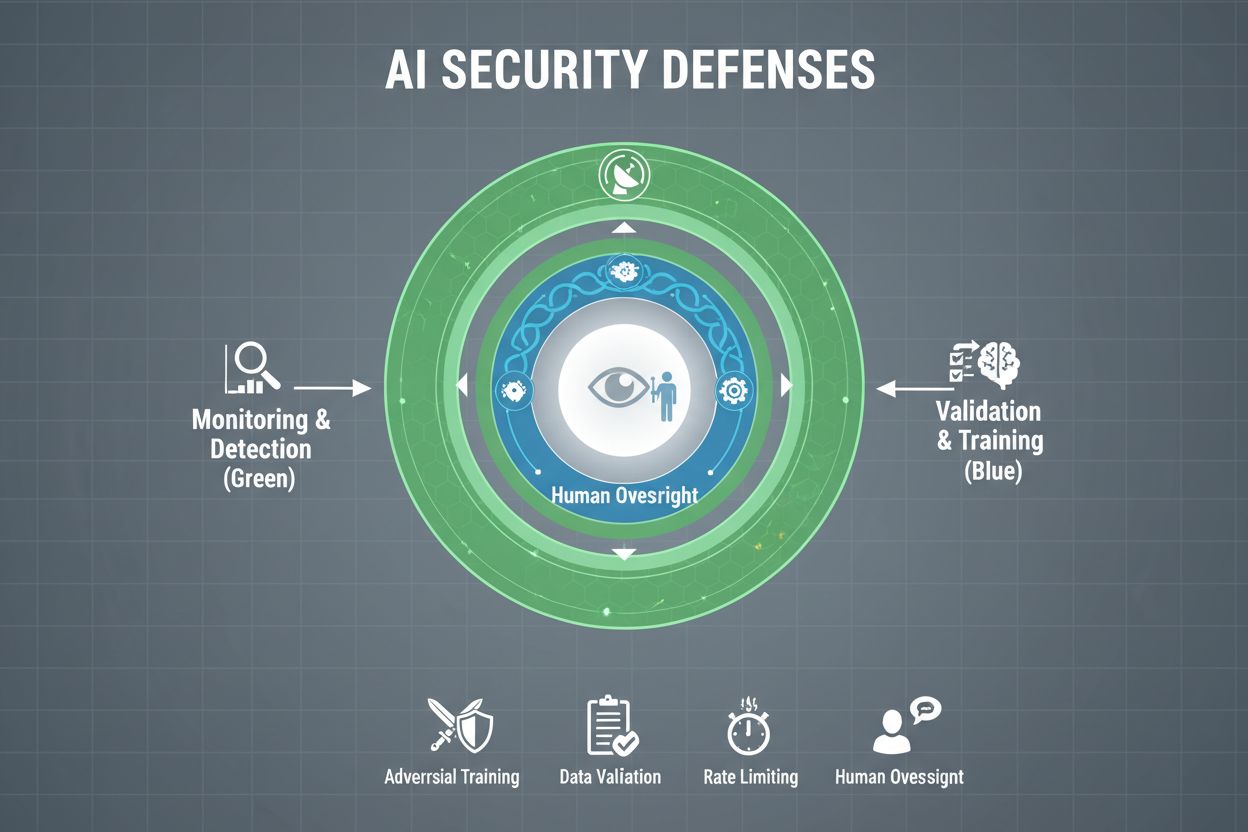

Firmy, které to s ochranou svých AI systémů myslí vážně, musí zavést více vrstev obrany, protože žádné jediné řešení neposkytuje úplnou ochranu. Adversariální trénink znamená záměrné vystavení AI modelů vytvořeným adversariálním příkladům při vývoji, což model učí rozpoznávat a odmítat manipulativní vstupy. Pipelines pro validaci dat automatizovaně detekují a odstraňují škodlivá či otrávená data dřív, než dorazí k modelu, přičemž algoritmy pro detekci anomálií rozpoznávají vzory naznačující pokus o otrávení. Obfuskace výstupů omezuje informace dostupné z dotazů na model—například vrací pouze třídy místo skóre jistoty—což útočníkům ztěžuje zpětné inženýrství nebo extrakci citlivých informací. Omezení četnosti dotazů limituje počet dotazů uživatele, zpomaluje útočníky při extrakci modelu nebo membership inference útocích. Systémy pro detekci anomálií monitorují chování modelu v reálném čase a vyhodnocují neobvyklé vzory, které mohou signalizovat adversariální manipulaci nebo kompromitaci systému. Red teaming znamená najímání externích bezpečnostních expertů, kteří se aktivně snaží systém hrát dřív, než to udělají útočníci. Kontinuální monitoring zajišťuje, že systémy jsou sledovány na podezřelou aktivitu, neobvyklé sekvence dotazů či výstupy odlišné od očekávaného chování.

Nejefektivnější strategie obrany kombinuje tato technická opatření s organizačními postupy. Techniky diferenciálního soukromí přidávají pečlivě kalibrovaný šum do výstupů modelu, čímž chrání jednotlivá data a zároveň zachovávají užitečnost modelu. Lidské kontrolní mechanismy zajišťují, že klíčová rozhodnutí AI systémů přehodnocuje kvalifikovaný personál, který může odhalit podezřelé chování. Tyto obrany fungují nejlépe jako součást komplexní strategie řízení bezpečnostního postavení AI (AI Security Posture Management), která eviduje všechny AI aktiva, průběžně je monitoruje na zranitelnosti a vede detailní auditní záznamy o chování systému a přístupech.

Vlády a regulátoři po celém světě začínají řešit gaming AI, ale aktuální rámce mají zásadní mezery. Evropský AI Act uplatňuje přístup založený na riziku, zaměřuje se však primárně na zákaz manipulace, jež způsobuje fyzickou nebo psychologickou újmu—a ekonomické škody zůstávají převážně mimo pozornost. Ve skutečnosti většina manipulací AI způsobuje ekonomickou újmu snížením hodnoty pro uživatele, nikoli psychologické zranění, takže mnoho manipulačních praktik zůstává mimo zákaz aktu. EU Digital Services Act přináší kodex chování pro digitální platformy a specifickou ochranu nezletilých, jeho hlavní zaměření je však na nelegální obsah a dezinformace, nikoli obecně na manipulaci pomocí AI. Vzniká tak regulační mezera, kdy mnoho neplatformových digitálních firem může provozovat manipulační AI praktiky bez jasných právních omezení. Efektivní regulace vyžaduje rámce odpovědnosti, které činí organizace zodpovědné za incidenty gamingu AI, přičemž orgány ochrany spotřebitele mají dostatečné pravomoci k vyšetřování a vymáhání pravidel. Tyto orgány potřebují lepší výpočetní kapacity, aby mohly experimentovat s AI systémy, které vyšetřují, a správně posoudit pochybení. Mezinárodní koordinace je nezbytná, protože AI systémy fungují globálně a konkurenční tlaky mohou motivovat firmy přesouvat provoz do jurisdikcí s nižší ochranou. Zvýšení povědomí a vzdělávací kampaně, zejména pro mladé lidi, mohou pomoci jednotlivcům rozpoznat a odolat manipulačním taktikám AI.

S tím, jak jsou AI systémy sofistikovanější a rozšířenější, potřebují organizace komplexní přehled o tom, jak jsou jejich AI systémy používány a zda nejsou zneužívány či manipulovány. Platformy pro monitoring AI jako AmICited.com poskytují klíčovou infrastrukturu pro sledování, jak AI systémy odkazují a využívají informace, detekují, kdy se výstupy AI odchylují od očekávaných vzorců a identifikují pokusy o manipulaci v reálném čase. Tyto nástroje nabízí reálnou viditelnost chování AI systému, což bezpečnostním týmům umožňuje odhalovat anomálie signalizující adversariální útoky či kompromitaci systému. Monitoring napříč různými platformami—od GPT přes Perplexity po Google AI Overviews—dává organizacím přehled o možných pokusech o gaming a umožňuje rychlou reakci na hrozby. Komplexní monitoring pomáhá organizacím chápat celkovou míru jejich AI expozice, včetně „shadow AI“ systémů nasazených bez adekvátních bezpečnostních opatření. Integrace s širšími bezpečnostními rámci zajišťuje, že monitoring AI je součástí koordinované obranné strategie, ne izolovanou funkcí. Pro organizace, které to s ochranou AI investic a udržením důvěry uživatelů myslí vážně, jsou monitorovací nástroje nezbytnou infrastrukturou pro detekci a prevenci gamingu AI dříve, než způsobí zásadní škodu.

Samotné technické obrany nemohou gaming AI zabránit; organizace musí pěstovat kulturu bezpečnosti na prvním místě, kdy každý od vedení po vývojáře upřednostňuje bezpečnost a etické jednání před rychlostí a ziskem. To vyžaduje závazek vedení vyčlenit značné zdroje na výzkum bezpečnosti a testování, i za cenu zpomalení vývoje produktů. Model švýcarského sýra v organizační bezpečnosti—kde více nedokonalých vrstev obrany vzájemně vykrývá své slabiny—přímo platí i pro AI systémy. Žádný jednotlivý obranný mechanismus není dokonalý, ale více překrývajících se obran vytváří odolnost. Lidské kontrolní mechanismy musí být zabudovány napříč životním cyklem AI od vývoje po nasazení, přičemž kvalifikovaný personál přehodnocuje klíčová rozhodnutí a vyhodnocuje podezřelé vzory. Požadavky na transparentnost by měly být začleněny už při návrhu systému, nikoli až dodatečně, aby všichni zainteresovaní rozuměli fungování AI systému i využití dat. Mechanismy odpovědnosti musí jasně přiřazovat zodpovědnost za chování AI systémů, včetně důsledků za nedbalost či pochybení. Red teaming by měl být pravidelně prováděn externími experty, kteří se aktivně snaží systém hrát, přičemž zjištění slouží k neustálému zlepšování. Organizace by měly zavádět fázované procesy nasazení, kdy jsou nové AI systémy pečlivě testovány v kontrolovaných prostředích před širším nasazením, s ověřením bezpečnosti v každé fázi. Budování této kultury vyžaduje uznání, že bezpečnost a inovace nejsou v rozporu—organizace, které investují do robustní bezpečnosti AI, ve skutečnosti inovují efektivněji, protože mohou nasazovat systémy s důvěrou a dlouhodobě udržovat důvěru uživatelů.

Gaming AI systému znamená úmyslnou manipulaci nebo zneužití AI modelů za účelem vyvolání nechtěných výstupů, obcházení bezpečnostních opatření nebo získávání citlivých informací. To zahrnuje techniky jako prompt injection, adversariální útoky, otrávení dat a extrakci modelu. Na rozdíl od běžných chyb systému je gaming cíleným pokusem obejít zamýšlené chování AI systému.

Adversariální útoky jsou stále běžnější, jak se AI systémy častěji nasazují v kritických aplikacích. Výzkumy ukazují, že většina AI systémů má zranitelnosti, které lze zneužít. Dostupnost nástrojů a technik znamená, že jak sofistikovaní útočníci, tak běžní uživatelé mohou potenciálně AI systémy hrát, což z toho dělá rozšířený problém.

Žádná jednotlivá obrana neposkytuje úplnou imunitu vůči gamingu. Organizace však mohou výrazně snížit riziko vícevrstvou obranou včetně adversariálního tréninku, validace dat, obfuskace výstupů, omezení dotazů a kontinuálního monitorování. Nejefektivnější je kombinace technických opatření s organizačními postupy a lidským dohledem.

Běžné chyby AI vznikají, když systémy chybují kvůli omezením trénovacích dat nebo architektury modelu. Gaming zahrnuje úmyslnou manipulaci za účelem zneužití zranitelností. Gaming je záměrný, často neviditelný pro uživatele a má za cíl prospět útočníkovi na úkor systému či uživatelů. Běžné chyby jsou neúmyslná selhání systému.

Spotřebitelé se mohou chránit tím, že budou rozumět principům fungování AI systémů, uvědomí si, že jejich data jsou využívána k ovlivňování jejich chování, a budou obezřetní vůči doporučením, která se zdají až příliš perfektně přizpůsobená. Pomáhá podporovat požadavky na transparentnost, používat nástroje chránící soukromí a prosazovat silnější regulace AI. Vzdělání o taktikách manipulace pomocí AI je stále důležitější.

Regulace je zásadní pro prevenci gamingu AI v širším měřítku. Aktuální rámce, jako je EU AI Act, se primárně zaměřují na fyzickou a psychologickou újmu, zatímco ekonomické škody zůstávají většinou neřešeny. Efektivní regulace vyžaduje rámce odpovědnosti, posílení pravomocí ochrany spotřebitelů, mezinárodní koordinaci a jasná pravidla zabraňující manipulačním praktikám AI při zachování motivace k inovacím.

Platformy pro monitoring AI poskytují v reálném čase přehled o tom, jak se AI systémy chovají a jak jsou využívány. Detekují anomálie, jež mohou naznačovat adversariální útoky, sledují neobvyklé vzory dotazů naznačující pokusy o extrakci modelu a identifikují situace, kdy se výstupy systému odchylují od očekávaného chování. Tato viditelnost umožňuje rychlou reakci na hrozby dříve, než dojde k významným škodám.

Náklady zahrnují přímé finanční ztráty z podvodů a manipulací, poškození reputace v důsledku bezpečnostních incidentů, právní odpovědnost a regulační pokuty, provozní narušení kvůli odstávkám systému a dlouhodobou ztrátu důvěry uživatelů. Pro spotřebitele jsou náklady snížená hodnota služeb, porušení soukromí a využití behaviorálních zranitelností. Celkový ekonomický dopad je značný a roste.

AmICited monitoruje, jak jsou AI systémy zmiňovány a používány napříč platformami a pomáhá vám v reálném čase detekovat pokusy o manipulaci. Získejte přehled o chování vašeho AI a buďte o krok napřed před hrozbami.

Zjistěte, co je konkurenční AI sabotáž, jak funguje a jak ochránit svou značku před tím, aby konkurenti otrávili výsledky vyhledávání AI. Objevte metody detekce...

Diskuze komunity o black hat taktikách, které škodí viditelnosti v AI. Skutečné poznatky o AI poisoning, manipulaci s obsahem a jak chránit svou značku.

Diskuze komunity o tom, jak modely AI řeší konfliktní informace z různých zdrojů. Skutečné zkušenosti tvůrců obsahu analyzujících řešení konfliktů AI....

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.