JavaScript renderování pro AI

Zjistěte, jak JavaScript renderování ovlivňuje viditelnost v AI. Objevte, proč AI crawlery nemohou spouštět JavaScript, jaký obsah zůstává skrytý a jak řešení t...

Zjistěte, jak prerendrování zpřístupňuje JavaScriptový obsah AI crawlerům jako ChatGPT, Claude a Perplexity. Objevte nejlepší technická řešení pro optimalizaci hledání v AI a zlepšete svou viditelnost ve výsledcích vyhledávání poháněných AI.

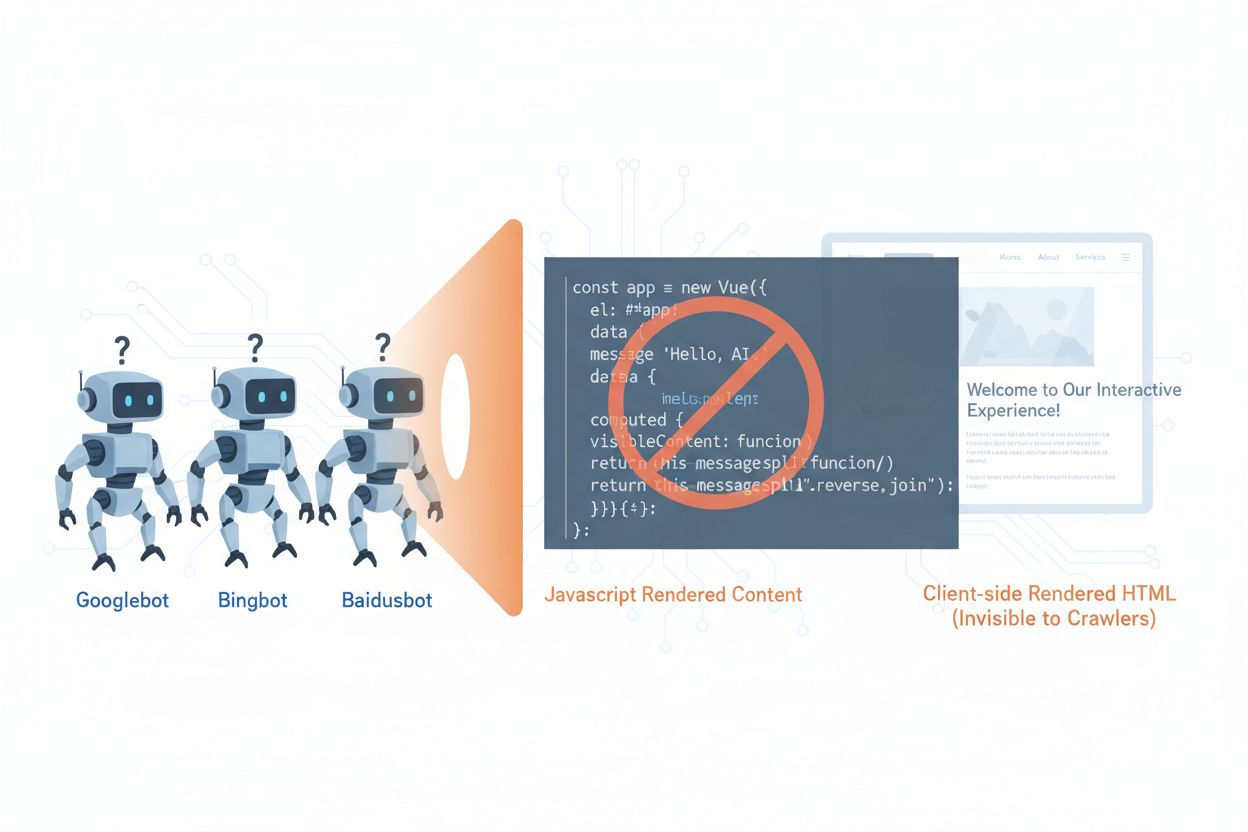

AI crawlery jako GPTBot, ClaudeBot a PerplexityBot zásadně změnily způsoby, jakými je obsah na webu objevován a indexován, avšak čelí zásadnímu omezení: neumí spouštět JavaScript. To znamená, že jakýkoli obsah generovaný dynamicky pomocí JavaScriptu—což je základ moderních jednostránkových aplikací (SPA), dynamických produktových stránek a interaktivních dashboardů—zůstává pro tyto crawlery zcela neviditelný. Podle nedávných dat nyní AI crawlery tvoří přibližně 28 % provozu Googlebotu, což z nich činí významnou část vašeho crawl budgetu a klíčový faktor zpřístupnění obsahu. Když AI crawler požádá o stránku, dostane pouze počáteční HTML obal bez vygenerovaného obsahu, takže ve výsledku vidí prázdnou nebo neúplnou verzi vašeho webu. Vzniká tím paradox: váš obsah je dokonale viditelný pro lidské uživatele s prohlížeči podporujícími JavaScript, ale neviditelný pro AI systémy, které čím dál více ovlivňují objevování, sumarizaci a řazení obsahu ve vyhledávačích a aplikacích poháněných AI.

Technické důvody omezení AI crawlerů ohledně JavaScriptu vycházejí ze zásadních architektonických rozdílů mezi tím, jak prohlížeče a crawlery zpracovávají webový obsah. Prohlížeče mají plnohodnotný JavaScript engine, který provádí kód, manipuluje s DOM (Document Object Model) a vykresluje finální vizuální výstup, zatímco AI crawlery obvykle fungují s omezenou nebo žádnou schopností spouštět JavaScript kvůli nárokům na zdroje a bezpečnostním ohledům. Asynchronní načítání—kdy se obsah získává z API až po načtení stránky—je dalším zásadním problémem, protože crawlery dostanou jen počáteční HTML dříve, než dorazí obsah. Jednostránkové aplikace (SPA) tento problém ještě zhoršují, protože spoléhají výhradně na klientskou routovací a renderovací logiku, takže crawlerům zůstane jen JavaScriptový balík. Takto vypadají různé metody renderování z pohledu viditelnosti pro AI crawlery:

| Metoda renderování | Jak funguje | Viditelnost pro AI crawlery | Výkon | Náklady |

|---|---|---|---|---|

| CSR (Client-Side Rendering) | Prohlížeč vykoná JavaScript a vykreslí obsah | ❌ Špatná | Rychlé pro uživatele | Nízké náklady |

| SSR (Server-Side Rendering) | Server rendruje HTML při každém požadavku | ✅ Výborná | Pomalejší první načtení | Vysoké náklady |

| SSG (Static Site Generation) | Obsah předgenerovaný při build time | ✅ Výborná | Nejrychlejší | Střední (doba buildu) |

| Prerendrování | Statické HTML ukládané na vyžádání | ✅ Výborná | Rychlé | Střední (vyvážené) |

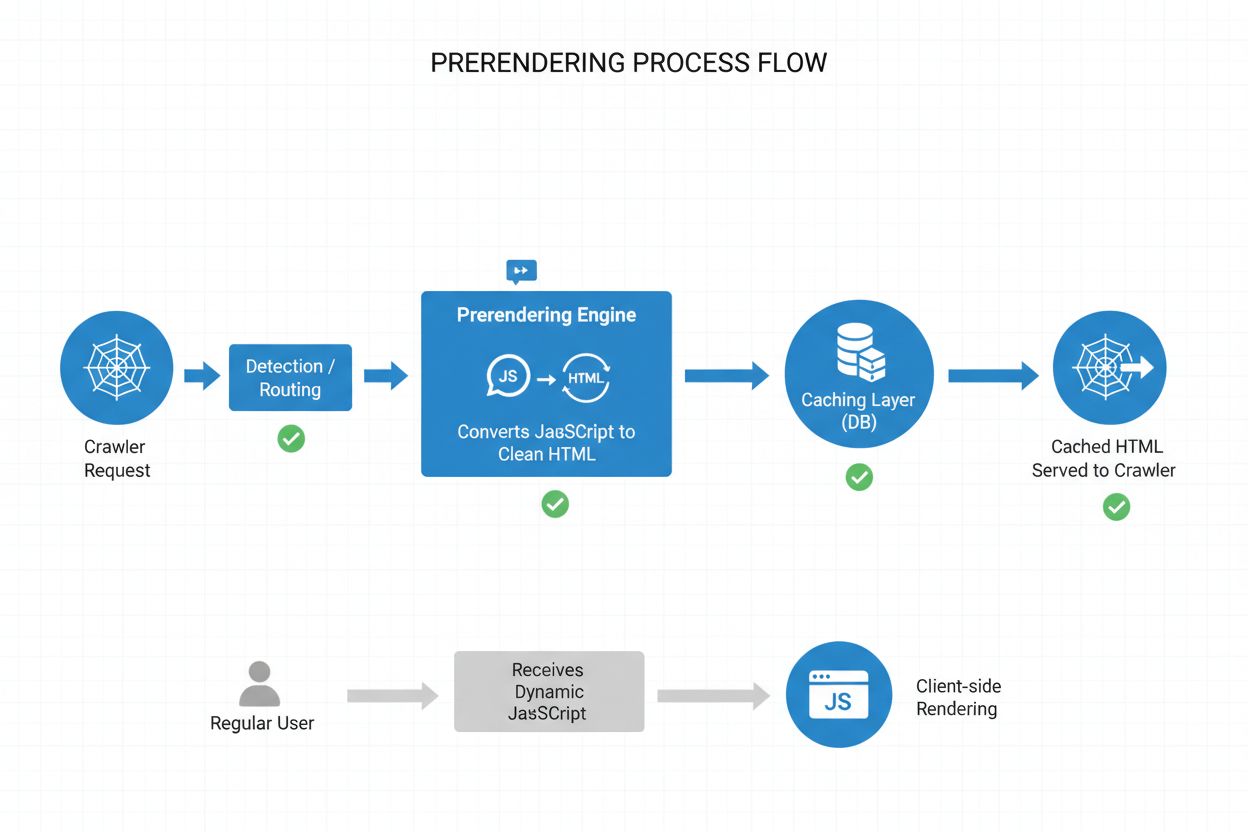

Prerendrování představuje elegantní střední cestu mezi náročností SSR a omezeními statické generace (SSG). Namísto renderování obsahu při každém požadavku (SSR) nebo při buildu (SSG) prerendrování generuje statické HTML snímky na vyžádání ve chvíli, kdy crawler nebo bot požádá o stránku, a tuto verzi ukládá do cache pro další požadavky. To znamená, že AI crawlery dostanou plně renderované, statické HTML se vším obsahem, který by jinak generoval JavaScript, zatímco běžní uživatelé nadále dostávají dynamickou, interaktivní verzi vašeho webu beze změny uživatelského zážitku. Prerendrování je navíc velmi úsporné, protože rendruje pouze stránky skutečně požadované crawlery, takže se vyhnete režii spojené s prerendrováním celého webu nebo udržováním nákladné SSR infrastruktury. Nároky na údržbu jsou minimální—vaše aplikační kód zůstává nezměněn a prerendrovací vrstva běží transparentně na pozadí, takže jde o ideální řešení pro týmy, které chtějí zpřístupnit obsah AI crawlerům bez zásadních architektonických změn.

Prerendrovací proces běží podle sofistikovaného, ale přímočarého workflow, které zajistí, že AI crawlery obdrží optimalizovaný obsah, zatímco uživatelé nepocítí žádné změny. Když na vašem serveru přijde požadavek, systém nejprve detekuje user agent, aby zjistil, zda jde o AI crawler (GPTBot, ClaudeBot, PerplexityBot) nebo běžný prohlížeč. Pokud je detekován AI crawler, požadavek je přesměrován do prerendrovacího enginu, který spustí headless prohlížeč, provede veškerý JavaScript, počká na načtení asynchronního obsahu a vytvoří kompletní statický HTML snímek stránky. Toto HTML je pak uloženo do cache (typicky na 24–48 hodin) a podáváno přímo crawleru, čímž obejde vaši aplikaci a sníží zatížení serveru. Běžné požadavky uživatelů naopak prerendrovací vrstvu obejdou a dostávají vaši dynamickou aplikaci beze změn, takže uživatelé mají plně interaktivní zážitek v reálném čase. Celý proces je transparentní—crawlery vidí plně renderovaný obsah, uživatelé aplikaci beze změn a vaše infrastruktura zůstává efektivní, protože prerendrování se aktivuje pouze pro boty.

Ačkoli prerendrování i server-side rendering (SSR) řeší problém s viditelností JavaScriptu, zásadně se liší v implementaci, nákladech i škálovatelnosti. SSR rendruje obsah při každém požadavku, takže server musí spustit JavaScriptový runtime, vykonat celou aplikaci a vygenerovat HTML pro každého návštěvníka—což je při větším provozu velmi nákladné a prodlužuje Time to First Byte (TTFB) pro všechny uživatele. Prerendrování naproti tomu cacheuje rendrované stránky a obnovuje je pouze při změně obsahu nebo po vypršení cache, čímž dramaticky snižuje zátěž serveru a zrychluje odezvu jak pro crawlery, tak pro uživatele. SSR dává smysl pro vysoce personalizovaný obsah nebo často se měnící data, kde každý uživatel potřebuje unikátní HTML, zatímco prerendrování je ideální tam, kde je obsah spíše statický nebo se mění zřídka—produktové stránky, blogy, dokumentace a marketingový obsah. Mnoho pokročilých implementací používá hybridní přístup: prerendrování pro AI crawlery a statický obsah, SSR pro personalizované zážitky a client-side rendering pro interaktivní funkce. Tato vrstvená strategie nabízí to nejlepší z obou světů—výbornou přístupnost pro crawlery, rychlost pro uživatele a rozumné náklady na infrastrukturu.

Strukturovaná data ve formátu JSON-LD jsou zásadní pro to, aby AI crawlery pochopily význam a kontext vašeho obsahu, přesto většina implementací nepočítá s omezeními AI crawlerů. Pokud jsou strukturovaná data vkládána do stránky pomocí JavaScriptu—což je běžné například u Google Tag Manageru a podobných nástrojů—AI crawlery je nikdy neuvidí, protože nespustí JavaScript, který tato data generuje. To znamená, že rozšířené výsledky, informace o produktech, detailech organizace a další sémantické značky zůstávají pro AI systémy neviditelné, i když tradiční vyhledávače, které se naučily JavaScript zpracovávat, je najdou. Řešení je jednoduché: všechna klíčová strukturovaná data musí být přímo v HTML generovaném na serveru, ne vkládána pomocí JavaScriptu. To může znamenat přesunutí JSON-LD bloků z tag manageru do serverových šablon aplikace, nebo využití prerendrování ke “zachycení” JavaScriptem vkládaných struktur a jejich podání crawlerům jako statického HTML. AI crawlery se na strukturovaná data silně spoléhají při extrakci faktů, vztahů a údajů o entitách, proto je serverové vkládání strukturovaných dat zásadní pro AI vyhledávače a integraci do knowledge graphů.

Implementace prerendrování vyžaduje strategický přístup, který vybalancuje pokrytí, náklady a údržbu. Postupujte následovně:

Identifikujte stránky náročné na JavaScript: Proveďte audit webu a najděte stránky, kde je klíčový obsah vykreslován pomocí JavaScriptu—typicky SPA, dynamické produktové stránky a interaktivní dashboardy. K identifikaci stránek, kde se počáteční HTML výrazně liší od vykreslené verze, použijte nástroje jako Lighthouse nebo manuální inspekci.

Vyberte prerendrovací službu: Zvolte poskytovatele jako Prerender.io, který zajistí headless rendering, cacheování a detekci crawlerů. Zvažte ceny, dobu cachování, spolehlivost API a podporu vašeho technologického stacku.

Nastavte detekci user agentů: Nakonfigurujte server nebo CDN pro detekci uživatelských agentů AI crawlerů (GPTBot, ClaudeBot, PerplexityBot, Bingbot, Googlebot) a jejich přesměrování do prerendrovací služby, zatímco běžné prohlížeče pustíte standardně.

Otestujte a ověřte: Pomocí nástrojů jako curl s vlastními user agenty ověřte, že crawlery dostávají plně renderované HTML. Testujte přímo s user agenty AI crawlerů, aby byl obsah i strukturovaná data skutečně viditelná.

Sledujte výsledky: Nastavte logování a analytiku pro sledování efektivity prerendrování, míry zásahů cache a případných chyb při renderování. Sledujte dashboard prerendrovací služby kvůli výkonovým metrikám a chybám.

Účinný monitoring je klíčový pro zajištění, že vaše prerendrování funguje správně a že AI crawlery mají k obsahu přístup. Analýza logů je základ—zkoumejte serverové logy a identifikujte požadavky od uživatelských agentů AI crawlerů, sledujte, které stránky navštěvují a hledejte vzorce v crawlování či chyby. Většina služeb jako Prerender.io nabízí dashboardy s mírou zásahů cache, statistikami úspěšnosti/neúspěšnosti renderování a výkonovými metrikami, což vám dává přehled o efektivitě podávání prerendrovaného obsahu. Klíčové metriky ke sledování zahrnují míru zásahů cache (kolik požadavků je obslouženo z cache), úspěšnost renderování (procento stránek bez chyb), průměrný čas renderování a objem crawler provozu. Nastavte si upozornění na chyby při renderování nebo neobvyklé vzory crawlování, které mohou signalizovat problémy s JavaScriptem nebo dynamickým obsahem. Porovnáním metrik prerendrování s návštěvností z AI vyhledávačů a viditelností obsahu můžete změřit dopad implementace a identifikovat možnosti optimalizace.

Úspěšné prerendrování vyžaduje pečlivost a průběžnou údržbu. Vyhněte se těmto častým chybám:

Neprerendrujte 404 stránky: Nakonfigurujte službu tak, aby stránky s kódem 404 přeskočila, protože cacheování chybových stránek plýtvá zdroji a mate crawlery o struktuře webu.

Zajistěte aktuálnost obsahu: Nastavte správnou dobu vypršení cache podle toho, jak často se obsah mění. Stránky s vysokou návštěvností a častými změnami mohou potřebovat cache na 12–24 hodin, statický obsah může mít delší platnost.

Sledujte průběžně: Prerendrování nenastavujte a nezapomeňte na něj. Pravidelně kontrolujte, že se stránky správně renderují, strukturovaná data jsou přítomná a crawlery dostávají očekávaný obsah.

Vyvarujte se cloaingu: Nikdy nepodávejte crawlerům jiný obsah než uživatelům—to je v rozporu s pravidly vyhledávačů a snižuje důvěru. Prerendrování má crawlerům ukázat totéž, co uživatelům, jen ve statické podobě.

Testujte s reálnými crawlery: Používejte v testech skutečné user agenty AI crawlerů, ne jen obecné identifikátory botů. Různé crawlery mohou mít různé požadavky či omezení.

Udržujte obsah aktuální: Pokud prerendrovaný obsah zastarává, crawlery indexují neaktuální informace. Implementujte strategie, které při změně obsahu obnoví prerendrované stránky.

Význam optimalizace pro AI crawlery bude dále růst, jak se tyto systémy stávají středobodem objevování obsahu a extrakce znalostí. Zatímco současné AI crawlery mají omezenou schopnost vykonávat JavaScript, nové technologie jako Comet a Atlas browsers naznačují, že budoucí crawlery mohou mít pokročilejší renderovací možnosti, přesto však prerendrování zůstane cenné kvůli výkonu a spolehlivosti. Implementací prerendrování nyní nejen řešíte aktuální problém AI crawlerů—zajistíte budoucí dostupnost svého obsahu bez ohledu na změny schopností crawlerů. Prolínání tradičního SEO a optimalizace pro AI crawlery znamená, že je potřeba komplexní přístup: optimalizovat pro uživatele i AI systémy, podávat obsah v různých formátech a udržovat flexibilitu pro rychlé přizpůsobení změnám v oboru. Prerendrování představuje pragmatické, škálovatelné řešení, které překlenuje propast mezi moderními JavaScriptově náročnými aplikacemi a požadavky na přístupnost pro vyhledávání a objevování pomocí AI, a stává se tak základním kamenem každé moderní SEO a obsahové strategie.

Prerendrování generuje statické HTML snímky na vyžádání a ukládá je do mezipaměti, zatímco server-side rendering (SSR) rendruje obsah při každém požadavku. Prerendrování je ve většině případů úspornější a lépe škálovatelné, zatímco SSR je vhodnější pro vysoce personalizovaný nebo často se měnící obsah, který vyžaduje unikátní HTML pro každého uživatele.

Ne, prerendrování ovlivňuje pouze to, jak váš obsah vidí crawlery. Běžní uživatelé nadále dostávají vaši dynamickou, interaktivní JavaScriptovou aplikaci přesně jako dosud. Prerendrování běží nenápadně na pozadí a nemá žádný vliv na funkčnost nebo výkon z pohledu uživatele.

Doba vypršení cache závisí na tom, jak často se váš obsah mění. Stránky s vysokou návštěvností a častými aktualizacemi mohou potřebovat cache v rozmezí 12–24 hodin, zatímco statický obsah může mít delší dobu. Většina prerendrovacích služeb umožňuje nastavit dobu cache pro jednotlivé stránky nebo šablony.

Ano, prerendrování dobře funguje i s dynamickým obsahem. U stránek, které se často mění, můžete nastavit kratší dobu vypršení cache nebo implementovat strategie, které obnoví prerendrované stránky při aktualizaci obsahu. Tím zajistíte, že crawlery uvidí vždy relativně čerstvý obsah.

Hlavními AI crawlery, na které byste se měli zaměřit, jsou GPTBot (ChatGPT), ClaudeBot (Claude) a PerplexityBot (Perplexity). Optimalizaci byste měli zachovat i pro tradiční crawlery, jako jsou Googlebot a Bingbot. Většina prerendrovacích služeb umožňuje konfiguraci pro všechny hlavní AI i vyhledávací crawlery.

Pokud již používáte SSR, máte dobrou přístupnost pro AI crawlery. Nicméně prerendrování může stále přinést výhody jako snížení zátěže serveru, zlepšení výkonu a poskytování cache vrstvy, která zvyšuje efektivitu a škálovatelnost vaší infrastruktury.

Sledujte dashboard své prerendrovací služby kvůli míře zásahů z cache, metrikám úspěšného renderování a statistikám výkonu. Kontrolujte serverové logy na požadavky AI crawlerů a ověřte, že dostávají plně renderované HTML. Sledujte změny v AI viditelnosti a citacích vašeho obsahu v čase.

Náklady na prerendrování se liší podle služby a objemu využití. Většina poskytovatelů nabízí odstupňované ceny podle počtu renderovaných stránek za měsíc. Náklady bývají výrazně nižší než udržování SSR infrastruktury, a proto je prerendrování pro většinu webů velmi úsporným řešením.

Sledujte, jak AI platformy jako ChatGPT, Claude a Perplexity odkazují na váš obsah s AmICited. Získejte okamžité přehledy o vaší viditelnosti ve vyhledávání přes AI a optimalizujte svou obsahovou strategii.

Zjistěte, jak JavaScript renderování ovlivňuje viditelnost v AI. Objevte, proč AI crawlery nemohou spouštět JavaScript, jaký obsah zůstává skrytý a jak řešení t...

Naučte se, jak implementovat nekonečné scrollování při zachování indexovatelnosti pro AI crawlery, ChatGPT, Perplexity a tradiční vyhledávače. Objevte strategie...

Zjistěte, jak JavaScript ovlivňuje viditelnost pro AI crawlery. Objevte, proč AI boti nemohou vykreslovat JavaScript, jaký obsah zůstává skrytý a jak optimalizo...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.