Transparentnost řazení AI

Zjistěte, co znamená transparentnost řazení AI, proč je důležitá pro tvůrce obsahu a uživatele a jak různé platformy AI jako Perplexity, Google a ChatGPT zveřej...

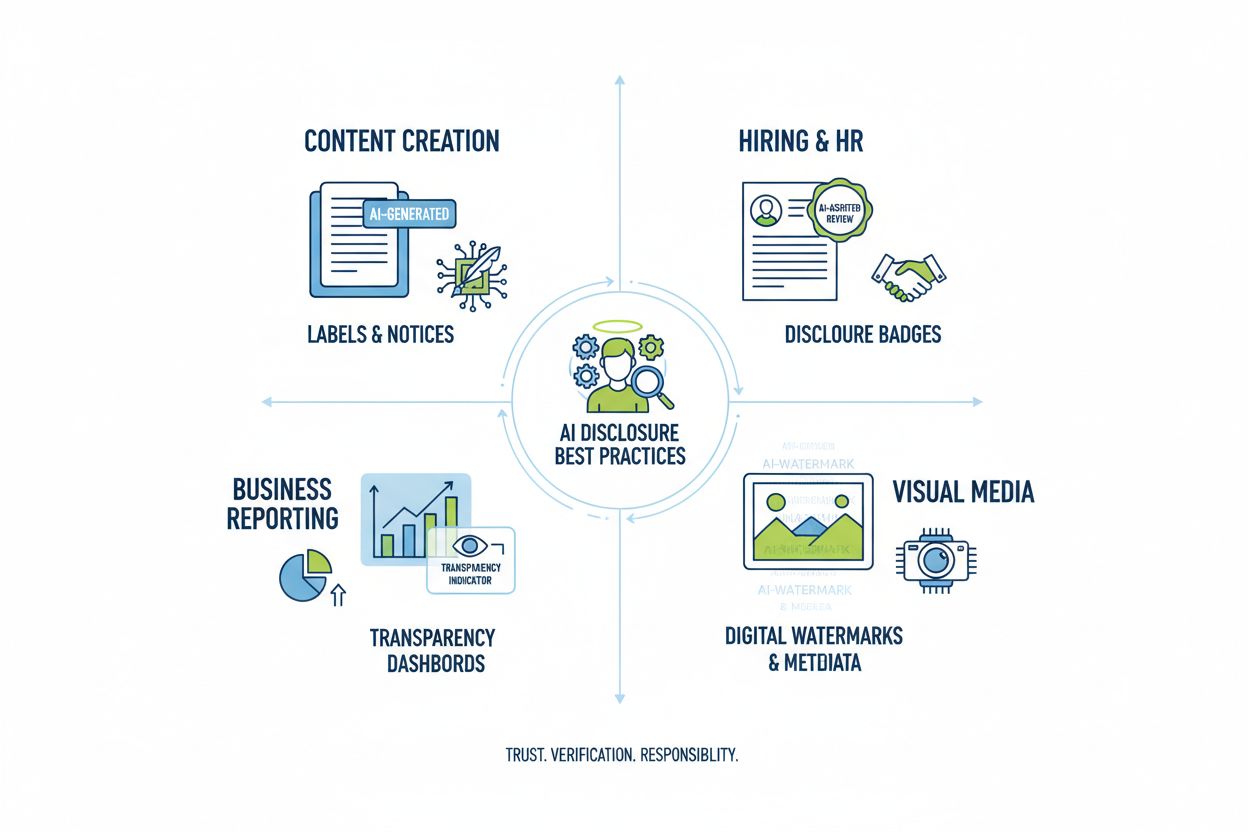

Zjistěte zásadní osvědčené postupy transparentnosti a zveřejnění AI. Objevte behaviorální, slovní a technické metody zveřejnění pro budování důvěry a zajištění souladu s vyvíjejícími se předpisy pro AI.

Transparentnost AI se stala zásadní nutností v době, kdy systémy umělé inteligence ovlivňují vše od tvorby obsahu po rozhodování při přijímání zaměstnanců a finanční doporučení. S tím, jak obsah generovaný AI rychle přibývá na digitálních platformách, jsou organizace pod stále větším tlakem zveřejnit, kdy a jak tyto technologie používají – nejen jako právní povinnost, ale jako základní požadavek pro udržení důvěry a důvěryhodnosti u svého publika. Sázky jsou obzvlášť vysoké pro značky a tvůrce obsahu, protože spotřebitelé stále více požadují vědět, zda informace, které konzumují, pocházejí z lidské odbornosti nebo byly generovány algoritmem. Bez transparentních postupů zveřejňování riskují organizace erozi důvěry, kterou budovaly roky, a potenciálně čelí poškození pověsti, regulačním sankcím a ztrátě důvěry publika. Vztah mezi transparentností a důvěryhodností je symbiotický – organizace, které proaktivně zveřejňují své využití AI, prokazují integritu a respekt ke svým stakeholderům, čímž se profilují jako poctiví aktéři v čím dál více AI-orientovaném prostředí.

Rozmach AI-generovaného obsahu vytvořil zásadní paradox důvěry: publikum má problém rozlišit mezi autentickým lidským dílem a sofistikovanými AI-alternativami, přičemž transparentnost ohledně použití AI je v různých odvětvích stále nekonzistentní. Tento zmatek podkopává základní smlouvu mezi tvůrci a konzumenty, kdy publikum očekává vědět skutečný původ obsahu, se kterým se setkává. Pokud je AI-generovaný obsah prezentován bez zveřejnění, porušuje to tuto implicitní dohodu a vytváří dichotomii „skutečný vs. falešný“, která přesahuje běžné otázky autenticity – dotýká se témat klamání, manipulace a informovaného souhlasu. Paradox se prohlubuje, protože některý AI-generovaný obsah může být ve kvalitě a stylu nerozeznatelný od lidské práce, což činí vizuální či stylistické náznaky nespolehlivými ukazateli původu. Transparentnost je důležitá právě proto, že tento paradox řeší tím, že dává publiku informace, které potřebuje pro informované rozhodování o obsahu, který konzumuje a čemu důvěřuje. Organizace, které přijímají jasné postupy zveřejnění, přeměňují potenciální skepsi v důvěru a ukazují, že nemají co skrývat a naopak mohou z upřímné komunikace těžit.

Regulační prostředí týkající se zveřejňování AI se rychle vyvíjí, přičemž různé jurisdikce zavádějí či navrhují požadavky, v nichž se organizace musí pečlivě orientovat. EU AI Act, jeden z nejkomplexnějších rámců, nařizuje, že AI-generovaný nebo silně AI-editovaný obsah musí obsahovat viditelné či v metadatech uvedené zveřejnění, se specifickými požadavky pro vysoce rizikové AI systémy a povinností transparentnosti pro vývojáře. Ve Spojených státech vydala FTC varování, že neaktualizování Podmínek užití a Zásad ochrany soukromí ohledně použití AI může být považováno za klamavé jednání, zatímco státní regulace – zejména nový kalifornský AI frontier model disclosure law – ukládají vývojářům velkých AI systémů vyšší povinnosti transparentnosti a reportování. Autorskoprávní a duševní vlastnictví představuje další vrstvu složitosti, protože organizace musí zveřejnit, zda trénovací data obsahovala chráněné materiály a jak byly AI systémy trénovány. Dále požadavky GDPR a CCPA platí i pro AI systémy zpracovávající osobní údaje, což vyžaduje zveřejnění automatizovaného rozhodování a poskytnutí smysluplných informací o AI zpracování jednotlivcům. Následující tabulka shrnuje klíčové regulační požadavky v hlavních jurisdikcích:

| Jurisdikce | Regulace | Klíčové požadavky | Datum účinnosti |

|---|---|---|---|

| Evropská unie | EU AI Act | Zveřejnění pro vysoce rizikové AI; zprávy o transparentnosti; metadata pro AI-generovaný obsah | Fázováno (2024-2026) |

| USA (federální) | Pokyny FTC | Aktualizace zásad ochrany osobních údajů; zveřejnění použití AI; zabránění klamavým praktikám | Průběžně |

| Kalifornie | AI Frontier Model Law | Standardizované zveřejnění; povinnosti reportování; bezpečnostní opatření | 2025 |

| Evropská unie | GDPR | Zveřejnění automatizovaného rozhodování; informace o AI zpracování | Průběžně |

| USA (více států) | CCPA & podobné | Zveřejnění použití dat v AI systémech; mechanismy odhlášení | Liší se dle státu |

| Mezinárodní | Autorskoprávní hlediska | Zveřejnění zdrojů trénovacích dat; řešení autorských práv v AI výstupech | Vznikající |

Organizace působící ve více jurisdikcích musí zavádět postupy zveřejnění, které splňují nejpřísnější požadavky, protože splnění jednoho standardu často překračuje minimum ostatních.

Behaviorální signály představují nejjemnější, přesto však silnou formu zveřejnění AI, která působí prostřednictvím prezentace, stylu, hlasu a kreativních voleb, které publikum nevědomky zpracovává při hodnocení autenticity obsahu. Tyto signály zahrnují charakteristické vzorce ve stylu psaní, konzistenci hlasu, volby vizuální kompozice, vlastnosti avatarů či person a celkovou „věrnost“ prezentace tvůrce – tedy do jaké míry obsah odráží skutečnou lidskou osobnost a rozhodování. Například AI-generovaný text často vykazuje určité vzorce ve stavbě vět, volbě slovní zásoby a logickém toku, které se liší od lidského psaní, zatímco AI-generované obrázky mohou mít jemné nesrovnalosti v osvětlení, anatomii či pozadí, jež mohou odhalit trénovaní pozorovatelé. Klíčovým pojmem je zde věrnost tvůrce: publikum si utváří očekávání, jak by měl konkrétní tvůrce znít, vypadat a prezentovat se, a odchylky od tohoto vzorce mohou signalizovat zapojení AI. Spoléhat se však pouze na behaviorální signály je problematické, protože AI systémy se rychle zlepšují v napodobování lidských vlastností a nelze očekávat, že publikum bude odborníky na AI forenzní analýzu. Proto by měly behaviorální signály sloužit jako doplněk, nikoli náhrada explicitních metod zveřejnění – jsou sekundární vrstvou transparentnosti posilující, nikoli nahrazující jasnou a přímou komunikaci o využití AI.

Strategie slovního zveřejnění představují explicitní, přímou komunikaci o využití AI prostřednictvím jazykových signálů, které nenechávají žádné pochybnosti o původu obsahu a zapojení AI. Tyto metody jsou zásadní, protože vytvářejí jasný, dokumentovaný záznam o zveřejnění a zajišťují, že publikum dostává jednoznačné informace o využití AI. Organizace mohou slovní zveřejnění implementovat pomocí několika doplňujících přístupů:

Vhodnost jednotlivých metod závisí na kontextu: štítky se hodí pro sociální sítě a vizuální obsah, vodoznaky pro video a audio, autorství pro žurnalistickou a kreativní tvorbu, pole pro zveřejnění pro delší obsah a poděkování poskytují komplexní kontext u složitějších projektů. Organizace by měly volit způsoby zveřejnění odpovídající formátu obsahu a očekáváním publika, aby bylo zveřejnění nepřehlédnutelné a přitom nerušilo uživatelský zážitek.

Technické signály a metadata poskytují strojově čitelnou, standardizovanou informaci o zapojení AI, která umožňuje automatizovanou detekci, ověření a sledování AI-generovaného obsahu napříč digitálními ekosystémy. Tyto přístupy využívají vložená data a kryptografické techniky pro vytvoření trvalých, nezměnitelných záznamů o původu obsahu a historii jeho zpracování. IPTC standardy, nedávno rozšířené o AI-specifická metadata, umožňují tvůrcům vkládat strukturované informace o využití AI přímo do obrazových souborů, včetně detailů o použitých AI systémech, aplikovaném zpracování a lidských úpravách. C2PA (Coalition for Content Provenance and Authenticity) představuje nový průmyslový standard, který využívá kryptografické podpisy a údaje o obsahu pro vytvoření ověřitelných „řetězců původu“ digitálního obsahu, díky nimž může publikum dohledat původ obsahu a všechny provedené úpravy. Tyto technické přístupy řeší zásadní omezení lidsky čitelného zveřejnění: vytvářejí trvalé, ověřitelné záznamy, které nelze snadno odstranit nebo pozměnit, a umožňují automatizovaným systémům rozpoznávat a označovat AI-generovaný obsah ve velkém rozsahu. Organizace implementující technické zveřejnění by měly zvážit zavedení C2PA údajů pro hodnotný obsah, vkládání IPTC metadat do obrázků a médií a vést detailní dokumentaci digitálního zdroje sledující zapojení AI v celém životním cyklu obsahu. Výhodou technických signálů je jejich trvalost a ověřitelnost; výzvou je zajistit, aby publikum a platformy těmto signálům rozuměly a respektovaly je.

Úspěšné zveřejnění AI vyžaduje institucionalizaci transparentních postupů v celém procesu tvorby obsahu, aby se zveřejnění stalo základní součástí správy obsahu, nikoli dodatečným krokem. Organizace by měly zavádět strukturované rámce obsahu, které zachycují zapojení AI v každé fázi tvorby – od výzkumu a psaní přes editaci až po publikaci – a zajistit, aby informace o zveřejnění přirozeně procházely stávajícími systémy pro správu obsahu. Automatizace a integrace do workflow jsou klíčové: systémy pro správu obsahu by měly obsahovat povinná pole pro zveřejnění AI, automatické výzvy vyžadující od tvůrců dokumentaci využití AI před publikací a schvalovací workflow ověřující úplnost zveřejnění před zveřejněním obsahu. Tento přístup považuje zveřejnění za požadavek kontroly kvality, nikoli za volitelný doplněk – podobně jako organizace spravují faktickou kontrolu, právní revizi či dodržování značky. Organizace by měly také stanovit jasné politiky, co představuje využití AI vyžadující zveřejnění (např. vyžaduje zveřejnění použití AI pro výzkum? Co AI-asistovaná editace?), zajistit konzistenci napříč týmy a zabránit mezerám ve zveřejnění. Důležitá je i školení a dokumentace: tvůrci obsahu potřebují jasné pokyny, jak vhodně zveřejňovat využití AI pro různé typy obsahu a platformy. Včleněním zveřejnění do obsahových modelů a workflow proměňují organizace transparentnost z compliance zátěže na standardní provozní postup, který chrání jak organizaci, tak její publikum.

Různá použití AI vyžadují odlišné přístupy ke zveřejnění, které zohledňují kontext, očekávání publika a regulační požadavky. Tvorba obsahu (články, sociální sítě, marketingové texty) by měla obsahovat jasné štítky nebo úpravy autorských řádků indikující zapojení AI, s doplňujícími poli vysvětlujícími použité AI nástroje a uplatněný lidský dohled; to je zvlášť důležité pro zpravodajský a redakční obsah, kde důvěra publika závisí na znalosti původu. Nábor a HR vyžaduje nejpřísnější zveřejnění, protože uchazeči mají právo vědět, kdy jsou jejich přihlášky posuzovány AI nebo podrobeny automatickému předvýběru, včetně detailního vysvětlení, jak AI rozhoduje a jaký následuje lidský dohled. Reporting a analýzy (finanční zprávy, průzkumy trhu, datové analýzy) by měly obsahovat technická zveřejnění a metadata o tom, které analýzy byly podpořeny AI, zejména pokud AI identifikovala vzory nebo generovala insighty ovlivňující závěry. Vizuální obsah (obrázky, videa, grafika) vyžaduje jak vizuální vodoznaky, tak metadata, protože publikum nemůže spolehlivě rozlišit AI-generované vizuály od autentických – to je zásadní zejména u zpravodajských fotografií, produktových snímků či jakéhokoli obsahu, kde autenticita ovlivňuje nákupní či důvěryhodnostní rozhodnutí. Komunikace směrem k zákazníkům (chatboti, automatizované odpovědi, zákaznický servis) by měla jasně identifikovat zapojení AI na začátku interakcí a umožnit zákazníkům požádat o lidskou asistenci, pokud si přejí. Organizace by měly provést audit svého využití AI v těchto kontextech a implementovat postupy zveřejnění úměrné citlivosti a dopadu jednotlivých použití, s vědomím, že požadavky na transparentnost se liší podle toho, jak AI ovlivňuje publikum.

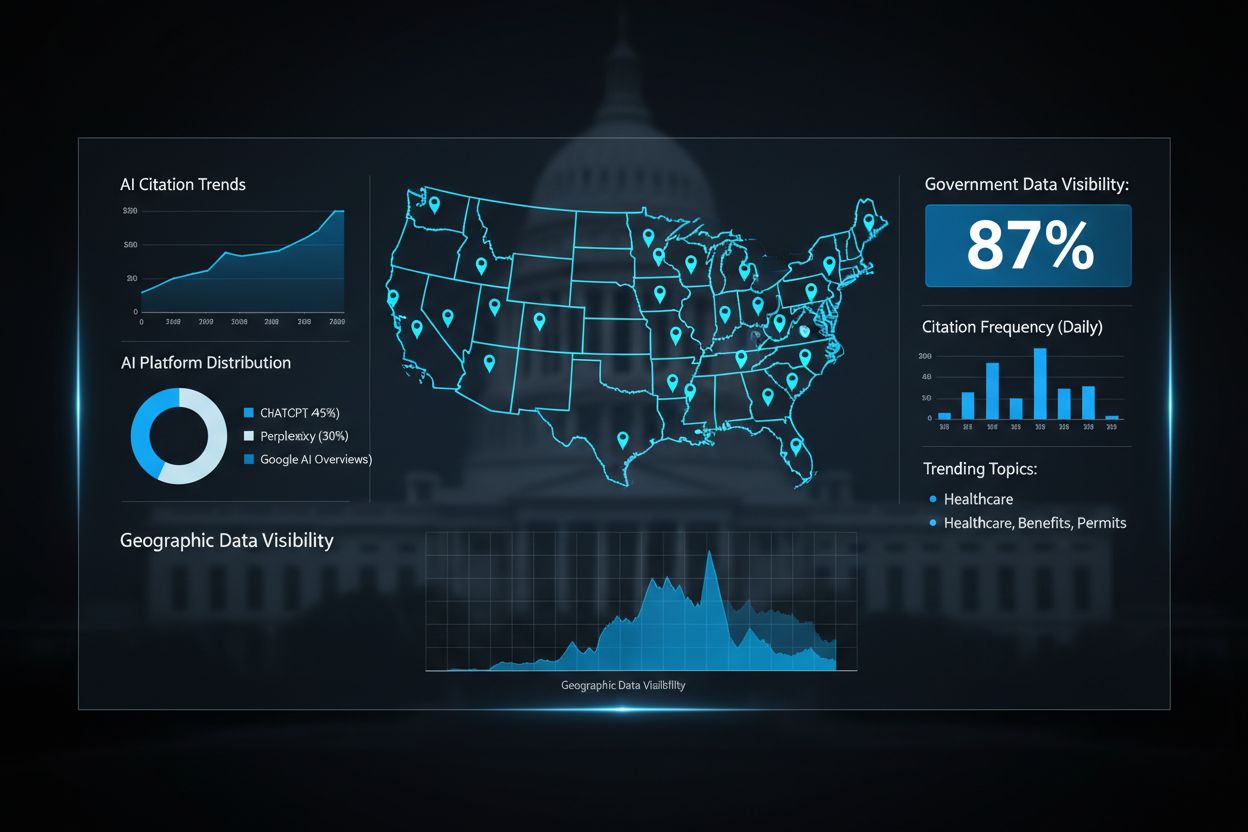

Budoucnost zveřejňování AI závisí na standardizaci v celém odvětví a vývoji interoperabilních rámců umožňujících konzistentní a porovnatelnou transparentnost napříč organizacemi a platformami. Nově vznikající standardy jako C2PA, specifikace metadat IPTC a NIST AI Risk Management Framework vytvářejí základní struktury, ale široké přijetí vyžaduje koordinované úsilí technologických platforem, tvůrců obsahu, regulátorů i profesních sdružení. EU AI Act a podobné regulační rámce tlačí na standardizaci tím, že vyžadují konkrétní formáty zveřejnění a kategorie informací, což vytváří tlak na celoodvětvové přijetí společných standardů místo individuálních přístupů. Oborové iniciativy jako etické pokyny PRSA pro AI a různé rámce pro reporting transparentnosti ukazují rostoucí shodu ohledně nejlepších postupů zveřejnění, ačkoli dobrovolné přijetí zůstává nekonzistentní. Klíčovým dalším krokem je přechod od dobrovolných standardů k regulacím, které standardizované zveřejnění vyžadují – obdobně jako nutriční etikety FDA standardizovaly transparentnost u potravin. Platformy pro monitoring a viditelnost – jako AmICited.com – hrají v tomto ekosystému stále důležitější roli sledováním, jak AI odkazuje na značky a obsah v AI-generovaných odpovědích, a poskytují organizacím přehled o tom, jak se jejich práce zobrazuje ve výstupech AI a zda dochází ke správné atribuci a zveřejnění. S tím, jak se AI systémy stávají sofistikovanějšími a rozšířenějšími, je schopnost monitorovat, ověřovat a auditovat postupy zveřejnění AI zásadní pro udržení důvěry v digitálních informačních ekosystémech. Organizace, které dnes investují do robustních postupů zveřejnění a monitorovacích schopností, budou nejlépe připraveny zvládnout vyvíjející se regulační prostředí a udržet si důvěru publika v budoucnosti řízené AI.

Behaviorální zveřejnění využívá volby prezentace (styl, hlas, avatar) k signalizaci zapojení AI. Slovní zveřejnění používá explicitní prohlášení, štítky a vodoznaky. Technické zveřejnění vkládá strojově čitelná metadata a kryptografické podpisy. Každá metoda slouží různým publikům a kontextům a organizace by měly používat více metod současně pro komplexní transparentnost.

Právní požadavky se liší podle jurisdikce. EU AI Act vyžaduje zveřejnění u vysoce rizikových AI systémů. FTC vyžaduje zveřejnění, pokud by použití AI mohlo ovlivnit rozhodování spotřebitelů. Státní zákony jako kalifornský AI Frontier Model Law ukládají povinnosti ohlašování. Autorský zákon vyžaduje zveřejnění AI-generovaného obsahu. Organizace by se měly poradit s právníky ohledně požadavků konkrétní jurisdikce.

AI-generované obrázky by měly obsahovat jak vizuální vodoznaky, tak metadata o zveřejnění. Vizuální vodoznaky by měly být viditelné, ale ne rušivé, jasně označující AI původ. Metadata by měla obsahovat informace o digitálním zdroji typu IPTC a pokud možno i C2PA údaje. Popisky a pole pro zveřejnění by měly výslovně uvádět, že obrázky jsou generovány AI, zejména u zpravodajství, produktů nebo propagačního obsahu.

Standardy IPTC poskytují strukturovaná metadata pro dokumentaci použití AI v obrázcích a mediálních souborech. Umožňují automatizované rozpoznání a sledování AI-generovaného obsahu napříč platformami. Kategorie digitálního zdroje IPTC zahrnují „Trained Algorithmic Media“, „Composite Synthetic“ a „Algorithmic Media“. Tyto standardy jsou důležité, protože vytvářejí trvalé, ověřitelné záznamy o zapojení AI, které nelze snadno odstranit nebo pozměnit.

Firmy by měly provést audit AI za účelem identifikace všech použití AI, zavést politiky zveřejňování v souladu se vztahujícími předpisy, integrovat zveřejnění do pracovních postupů správy obsahu, školit týmy v požadavcích na zveřejnění a pravidelně sledovat soulad. Konzultace s právními experty se znalostí AI regulací ve vaší jurisdikci je zásadní, protože požadavky se mezi regiony výrazně liší.

Důsledky zahrnují regulační sankce (pokuty FTC, porušení státních zákonů), poškození pověsti a ztrátu důvěry publika, právní odpovědnost za porušení autorských práv nebo klamavé praktiky a možné soudní spory od dotčených stran. Organizace, které nezveřejní použití AI, riskují ztrátu důvěry, kterou budovaly roky, takže proaktivní zveřejnění je strategickou investicí do dlouhodobé důvěry.

Různí zainteresovaní potřebují různou úroveň informací. Obecné publikum potřebuje jednoduchá, jasná prohlášení o zapojení AI. Regulátoři vyžadují podrobnou technickou dokumentaci a důkazy o souladu. Novináři a tvůrci obsahu potřebují konkrétní informace o použitých AI nástrojích a lidském dohledu. Zákazníci potřebují porozumět, jak AI ovlivňuje jejich zkušenost. Přizpůsobte formát a podrobnost zveřejnění potřebám a očekáváním každého publika.

C2PA (Koalice pro původ a autenticitu obsahu) poskytuje kryptografické údaje pro ověření obsahu. Standardy IPTC umožňují vkládání metadat do obrázků. Systémy pro správu obsahu stále častěji zahrnují pole pro zveřejnění AI. Sledovací platformy jako AmICited.com sledují odkazy a viditelnost AI. Průmyslové rámce od PRSA, NIST a dalších poskytují doporučení. Přijetí těchto nástrojů a standardů se zrychluje s přísnějšími předpisy.

Sledujte, jak AI systémy odkazují na vaši značku napříč GPTs, Perplexity a Google AI Overviews. Zajistěte, aby byl váš obsah správně připisován a viditelný v AI-generovaných odpovědích.

Zjistěte, co znamená transparentnost řazení AI, proč je důležitá pro tvůrce obsahu a uživatele a jak různé platformy AI jako Perplexity, Google a ChatGPT zveřej...

Prozkoumejte budoucnost monitoringu AI viditelnosti, od standardů transparentnosti po regulatorní soulad. Zjistěte, jak se mohou značky připravit na informační ...

Zjistěte, jak mohou vládní agentury optimalizovat svou digitální přítomnost pro AI systémy jako ChatGPT a Perplexity. Objevte strategie pro zlepšení AI viditeln...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.