Prořezávání obsahu

Prořezávání obsahu je strategické odstraňování nebo aktualizace neefektivního obsahu ke zlepšení SEO, uživatelské zkušenosti a viditelnosti ve vyhledávání. Nauč...

Zjistěte, co je ořezávání obsahu pro AI, jak funguje, jaké existují metody ořezávání a proč je klíčové pro nasazení efektivních AI modelů na edge zařízeních a v prostředích s omezenými zdroji.

Ořezávání obsahu pro AI je technika, která selektivně odstraňuje redundantní nebo méně důležité parametry, váhy či tokeny z AI modelů za účelem zmenšení jejich velikosti, zrychlení inferencí a snížení paměťových nároků při zachování kvality výstupu.

Ořezávání obsahu pro AI je základní optimalizační technika používaná ke snížení výpočetní složitosti a paměťové náročnosti modelů umělé inteligence bez výrazného kompromisu v jejich výkonu. Tento proces spočívá v systematické identifikaci a odstraňování redundantních nebo méně důležitých komponent z neuronových sítí, včetně jednotlivých vah, celých neuronů, filtrů nebo i tokenů v jazykových modelech. Primárním cílem je vytvořit štíhlejší, rychlejší a efektivnější modely, které lze efektivně nasadit na zařízeních s omezenými zdroji, jako jsou chytré telefony, edge computing systémy a IoT zařízení.

Koncept ořezávání čerpá inspiraci z biologických systémů, konkrétně z synaptického ořezávání v lidském mozku, kde jsou během vývoje eliminovány nepotřebné nervové spojení. Podobně AI ořezávání rozpoznává, že vytrénované neuronové sítě často obsahují mnoho parametrů, které mají minimální přínos pro konečný výstup. Odstraněním těchto redundantních komponent mohou vývojáři dosáhnout výrazného zmenšení velikosti modelu při zachování nebo dokonce zlepšení přesnosti prostřednictvím pečlivého dolaďování.

Ořezávání obsahu funguje na principu, že ne všechny parametry v neuronové síti jsou stejně důležité pro predikce. Během tréninku neuronové sítě vytvářejí složité propojení, z nichž mnohé se stanou redundantními nebo přispívají jen zanedbatelně k rozhodovacímu procesu modelu. Ořezávání identifikuje tyto méně důležité komponenty a odstraňuje je, což vede k řídké architektuře sítě, která pro svůj provoz vyžaduje méně výpočetních zdrojů.

Efektivita ořezávání závisí na několika faktorech, včetně použité metody, agresivity strategie ořezávání a následného procesu dolaďování. Různé přístupy k ořezávání cílí na různé aspekty neuronových sítí. Některé metody se zaměřují na jednotlivé váhy (nestrukturované ořezávání), jiné odstraňují celé neurony, filtry nebo kanály (strukturované ořezávání). Výběr metody zásadně ovlivňuje jak efektivitu výsledného modelu, tak kompatibilitu s moderními hardwarovými akcelerátory.

| Typ ořezávání | Cíl | Výhody | Výzvy |

|---|---|---|---|

| Ořezávání vah | Jednotlivá spojení/váhy | Maximální komprese, řídké sítě | Nemusí zrychlit provádění na hardwaru |

| Strukturované ořezávání | Neurony, filtry, kanály | Přátelské k hardwaru, rychlejší inference | Nižší komprese než nestrukturované |

| Dynamické ořezávání | Kontextově závislé parametry | Adaptivní efektivita, úpravy v reálném čase | Složitá implementace, vyšší režie |

| Ořezávání vrstev | Celé vrstvy nebo bloky | Výrazné snížení velikosti | Riziko ztráty přesnosti, nutná důkladná validace |

Nestrukturované ořezávání, známé také jako ořezávání vah, pracuje na granulární úrovni tím, že odstraňuje jednotlivé váhy z váhových matic sítě. Tento přístup obvykle využívá kritéria na základě velikosti, kdy váhy s hodnotami blízkými nule jsou považovány za méně důležité a jsou eliminovány. Výsledná síť se stává řídkou, což znamená, že během inference zůstává aktivní pouze zlomek původních spojení. Přestože nestrukturované ořezávání může dosáhnout působivých kompresních poměrů – někdy sníží počet parametrů o 90 % nebo více – výsledné řídké sítě nemusí na běžném hardwaru bez specializované podpory řídkých výpočtů dosahovat odpovídajícího zrychlení.

Strukturované ořezávání volí jiný přístup tím, že najednou odstraňuje celé skupiny parametrů, například celé filtry v konvolučních vrstvách, celé neurony ve zcela propojených vrstvách nebo celé kanály. Tato metoda je zvlášť cenná pro praktické nasazení, protože výsledné modely jsou přirozeně kompatibilní s moderními hardwarovými akcelerátory jako GPU a TPU. Pokud jsou z konvolučních vrstev ořezány celé filtry, úspory výpočetních zdrojů se projeví okamžitě a není nutná specializovaná podpora pro řídké matice. Výzkumy ukazují, že strukturované ořezávání může snížit velikost modelu o 50–90 % při zachování srovnatelné přesnosti s původními modely.

Dynamické ořezávání představuje sofistikovanější přístup, kdy se proces ořezávání přizpůsobuje během inference modelu na základě konkrétního zpracovávaného vstupu. Tato technika využívá externí kontext jako jsou řečnické embeddingy, signály událostí či jazykově specifické informace k dynamické úpravě toho, které parametry jsou aktivní. V systémech generování s podporou vyhledávání může dynamické ořezávání snížit velikost kontextu přibližně o 80 % a zároveň zlepšit přesnost odpovědí díky filtrování nerelevantních informací. Tento adaptivní přístup je zvlášť cenný pro multimodální AI systémy, které musí efektivně zpracovávat rozmanité typy vstupů.

Iterativní ořezávání a dolaďování představuje jeden z nejčastěji používaných přístupů v praxi. Tato metoda zahrnuje cyklický proces: ořezat část sítě, doladit zbylé parametry k obnovení ztracené přesnosti, vyhodnotit výkon a opakovat. Iterativní povaha tohoto přístupu umožňuje vývojářům pečlivě vyvažovat kompresi modelu s udržením výkonu. Namísto jednorázového odstranění všech nepotřebných parametrů – což by mohlo katastroficky poškodit výkon modelu – iterativní ořezávání postupně snižuje složitost sítě a zároveň umožňuje modelu přizpůsobit se a “naučit se”, které parametry jsou klíčové.

Jednorázové ořezávání nabízí rychlejší alternativu, kdy je celý proces ořezání proveden v jediném kroku po tréninku, následovaném fází dolaďování. Tento přístup je výpočetně efektivnější než iterativní metody, nese však vyšší riziko zhoršení přesnosti, pokud je odstraněno příliš mnoho parametrů najednou. Jednorázové ořezávání je užitečné zejména tehdy, když jsou omezené výpočetní zdroje pro iterativní procesy; obvykle však vyžaduje rozsáhlejší dolaďování k obnovení výkonu.

Ořezávání založené na analýze citlivosti využívá sofistikovanější mechanismus hodnocení tím, že měří, o kolik se zvýší ztrátová funkce modelu, když jsou odstraněny konkrétní váhy nebo neurony. Parametry, které mají minimální dopad na ztrátovou funkci, jsou identifikovány jako bezpečné kandidáty pro ořezání. Tento datově řízený přístup umožňuje nuance v rozhodování oproti jednoduchým metodám založeným na velikosti, často vede k lepšímu zachování přesnosti při stejných úrovních komprese.

Hypotéza „výherního losu“ (Lottery Ticket Hypothesis) nabízí zajímavý teoretický rámec, podle kterého v rámci velkých neuronových sítí existuje menší, řídká podsíť – „výherní los“ – která může dosáhnout srovnatelné přesnosti s původní sítí, pokud je trénována od stejného počátečního stavu. Tato hypotéza má zásadní dopad na chápání redundance v sítích a inspirovala nové metodiky ořezávání, které se snaží tyto efektivní podsítě identifikovat a izolovat.

Ořezávání obsahu se stalo nezbytným v mnoha AI aplikacích, kde je klíčová výpočetní efektivita. Nasazení na mobilních a embedded zařízeních představuje jeden z nejvýznamnějších scénářů, kdy ořezané modely umožňují pokročilé AI funkce na smartphonech a IoT zařízeních s omezeným výpočetním výkonem a kapacitou baterie. Zpracování obrazu, hlasoví asistenti i aplikace pro překlad v reálném čase těží z ořezaných modelů, které si udržují přesnost při minimální spotřebě zdrojů.

Autonomní systémy včetně samořiditelných vozidel a dronů vyžadují rozhodování v reálném čase s minimální latencí. Ořezané neuronové sítě umožňují těmto systémům zpracovávat data ze senzorů a činit klíčová rozhodnutí v přísných časových limitech. Snížení výpočetní zátěže se přímo promítá do rychlejších reakcí, což je zásadní pro bezpečnostně kritické aplikace.

V cloudových a edge computing prostředích ořezávání snižuje jak výpočetní náklady, tak nároky na úložiště při nasazování rozsáhlých modelů. Organizace mohou obsloužit více uživatelů se stejnou infrastrukturou nebo zásadně snížit své provozní výdaje. Edge computing scénáře výrazně těží z ořezaných modelů, protože umožňují pokročilé AI zpracování na zařízeních vzdálených od centrálních datových center.

Hodnocení efektivity ořezávání vyžaduje pečlivé zohlednění více metrik než jen snížení počtu parametrů. Latence inference – tedy čas potřebný k vygenerování výstupu z modelu – je klíčovou metrikou, která přímo ovlivňuje uživatelský zážitek v aplikacích v reálném čase. Efektivní ořezávání by mělo výrazně snížit latenci inference a umožnit rychlejší odezvy koncovým uživatelům.

Přesnost modelu a F1 skóre musí být během ořezávání zachovány. Základní výzvou je dosáhnout výrazné komprese bez ztráty predikčního výkonu. Dobře navržené strategie ořezávání udrží přesnost v rozmezí 1–5 % oproti původnímu modelu při 50–90% snížení parametrů. Snížení paměťové náročnosti je stejně důležité, protože určuje, zda lze modely nasadit na zařízeních s omezenými zdroji.

Výzkumy srovnávající velké-řídké modely (velké sítě s mnoha odstraněnými parametry) s malými-hustými modely (menší sítě trénované od začátku) se stejnou paměťovou stopou opakovaně ukazují, že velké-řídké modely překonávají své malé-husté protějšky. Tento poznatek zdůrazňuje hodnotu začínat s většími, dobře natrénovanými sítěmi a strategicky je ořezávat, namísto pokusů trénovat malé sítě od začátku.

Zhoršení přesnosti zůstává hlavní výzvou ořezávání obsahu. Agresivní ořezávání může výrazně snížit výkon modelu a vyžaduje pečlivé kalibrování intenzity ořezávání. Vývojáři musí najít optimální bod, kdy je komprese maximalizována bez nepřijatelné ztráty přesnosti. Tento bod se liší podle konkrétní aplikace, architektury modelu a požadovaných výkonových parametrů.

Problémy s kompatibilitou hardwaru mohou omezit praktický přínos ořezávání. Zatímco nestrukturované ořezávání vytváří řídké sítě s méně parametry, moderní hardware je optimalizován pro husté matice. Řídké sítě nemusí na běžných GPU bez specializovaných knihoven a podpory řídkých výpočtů dosahovat výrazně vyšší rychlosti. Strukturované ořezávání tuto nevýhodu řeší zachováním hustých výpočetních vzorců, ovšem za cenu méně agresivní komprese.

Výpočetní režie samotných metod ořezávání může být značná. Iterativní ořezávání a přístupy založené na analýze citlivosti vyžadují více průchodů tréninkem a důkladné hodnocení, což spotřebovává značné výpočetní zdroje. Vývojáři musí vážit jednorázové náklady spojené s ořezáváním vůči dlouhodobým úsporám při nasazování efektivnějších modelů.

Obavy z generalizace nastávají při příliš agresivním ořezávání. Nadměrně ořezané modely mohou podávat dobré výkony na trénovacích a validačních datech, ale špatně se generalizovat na nová, neznámá data. Správné validační strategie a důkladné testování na rozmanitých datech jsou nezbytné pro zajištění robustního výkonu ořezaných modelů v produkčním prostředí.

Úspěšné ořezávání obsahu vyžaduje systematický přístup vycházející z osvědčených postupů podložených výzkumem i praxí. Začněte s většími, dobře natrénovanými sítěmi místo pokusů trénovat malé sítě od začátku. Větší sítě poskytují více redundance a flexibilitu pro ořezávání a výzkumy opakovaně ukazují, že ořezané velké sítě překonávají malé sítě trénované od začátku.

Používejte iterativní ořezávání s pečlivým dolaďováním, abyste postupně snižovali složitost modelu při zachování výkonu. Tento přístup poskytuje lepší kontrolu nad kompromisem mezi přesností a efektivitou a umožňuje modelu přizpůsobit se odstranění parametrů. Pro praktické nasazení využívejte strukturované ořezávání, pokud je důležitá hardwarová akcelerace, protože produkuje modely, které efektivně běží na běžném hardwaru bez potřeby specializované podpory pro řídké výpočty.

Důkladně validujte na rozmanitých datových sadách, abyste zajistili, že ořezané modely dobře generalizují i mimo trénovací data. Sledujte více výkonnostních metrik, včetně přesnosti, latence inference, využití paměti a spotřeby energie, abyste komplexně vyhodnotili efektivitu ořezávání. Zohledněte cílové prostředí nasazení při výběru strategií ořezávání, protože různá zařízení a platformy vyžadují různé optimalizační přístupy.

Oblast ořezávání obsahu se neustále vyvíjí s novými technikami a metodikami. Contextually Adaptive Token Pruning (CATP) představuje špičkový přístup, který využívá sémantické sladění a rozmanitost znaků k selektivnímu zachování pouze nejrelevantnějších tokenů v jazykových modelech. Tato technika je zvlášť cenná pro velké jazykové modely a multimodální systémy, kde je správa kontextu klíčová.

Integrace s vektorovými databázemi jako Pinecone a Weaviate umožňuje sofistikovanější strategie ořezávání kontextu díky efektivnímu ukládání a vyhledávání relevantních informací. Tyto integrace podporují dynamická rozhodnutí o ořezávání na základě sémantické podobnosti a hodnocení relevance, což zvyšuje jak efektivitu, tak přesnost.

Kombinace s dalšími technikami komprese jako kvantizace a destilace znalostí vytváří synergické efekty a umožňuje ještě agresivnější kompresi modelů. Modely, které jsou současně ořezané, kvantizované a destilované, mohou dosáhnout kompresních poměrů 100x a více při zachování přijatelné úrovně výkonu.

Jak modely AI nadále rostou na složitosti a scénáře jejich nasazení se stávají stále rozmanitějšími, ořezávání obsahu zůstane klíčovou technikou, která činí pokročilou AI dostupnou a praktickou napříč celým spektrem výpočetních prostředí – od výkonných datových center až po zařízení s omezenými zdroji na okraji sítě.

Objevte, jak vám AmICited pomáhá sledovat, kdy se váš obsah objeví v odpovědích generovaných AI napříč ChatGPT, Perplexity a dalšími AI vyhledávači. Zajistěte viditelnost své značky v AI budoucnosti.

Prořezávání obsahu je strategické odstraňování nebo aktualizace neefektivního obsahu ke zlepšení SEO, uživatelské zkušenosti a viditelnosti ve vyhledávání. Nauč...

Diskuze komunity o prořezávání obsahu pro lepší viditelnost v AI. Kdy odstranit starý obsah, kdy jej konsolidovat a kdy ho ponechat.

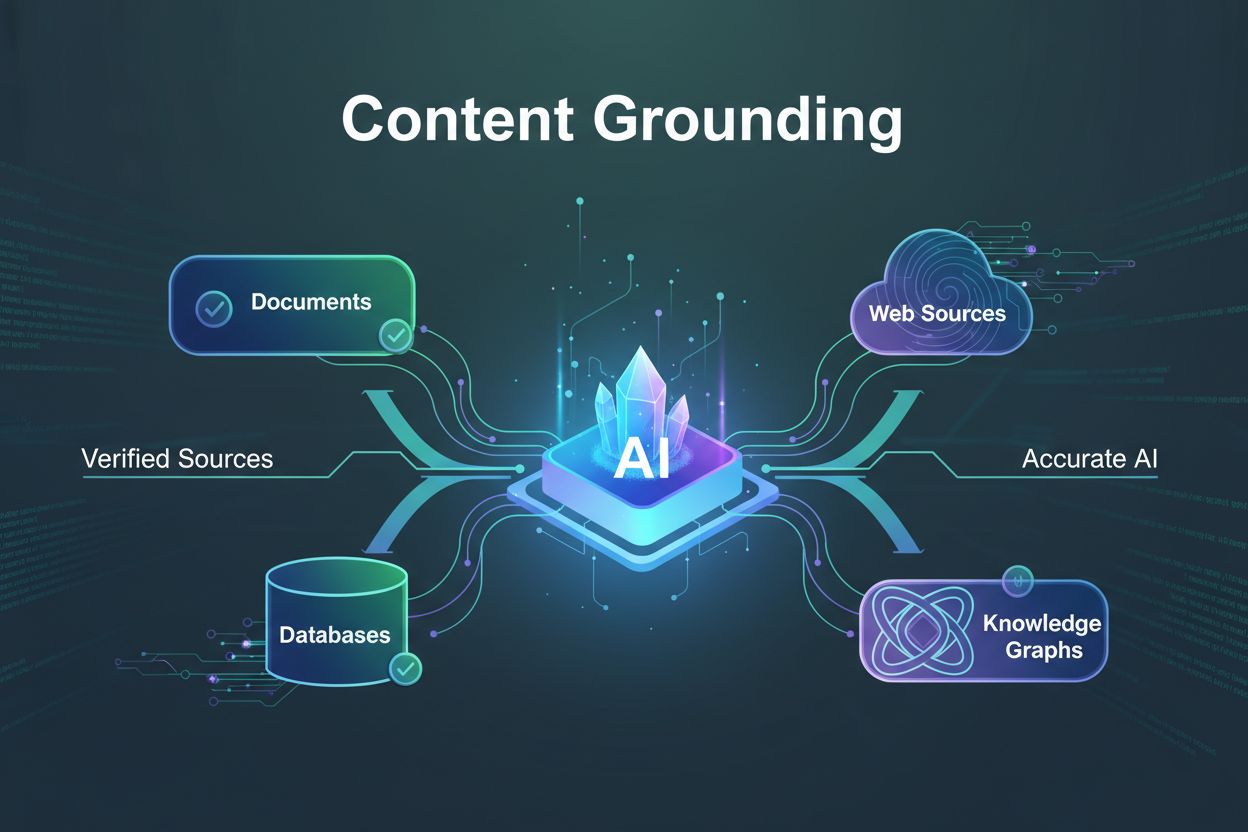

Zjistěte, co je uzemnění obsahu, jak předchází halucinacím AI a proč je nezbytné pro důvěryhodné AI systémy. Objevte techniky, nástroje a osvědčené postupy pro ...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.