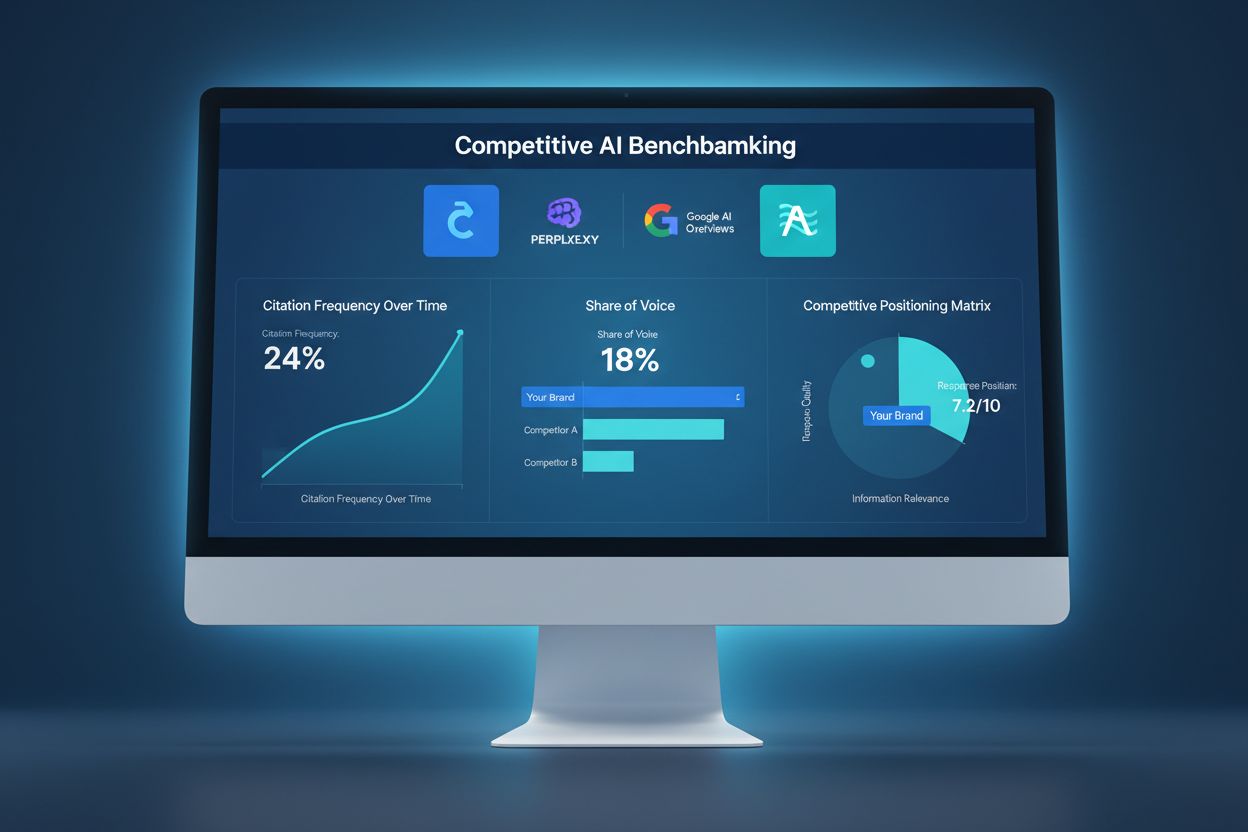

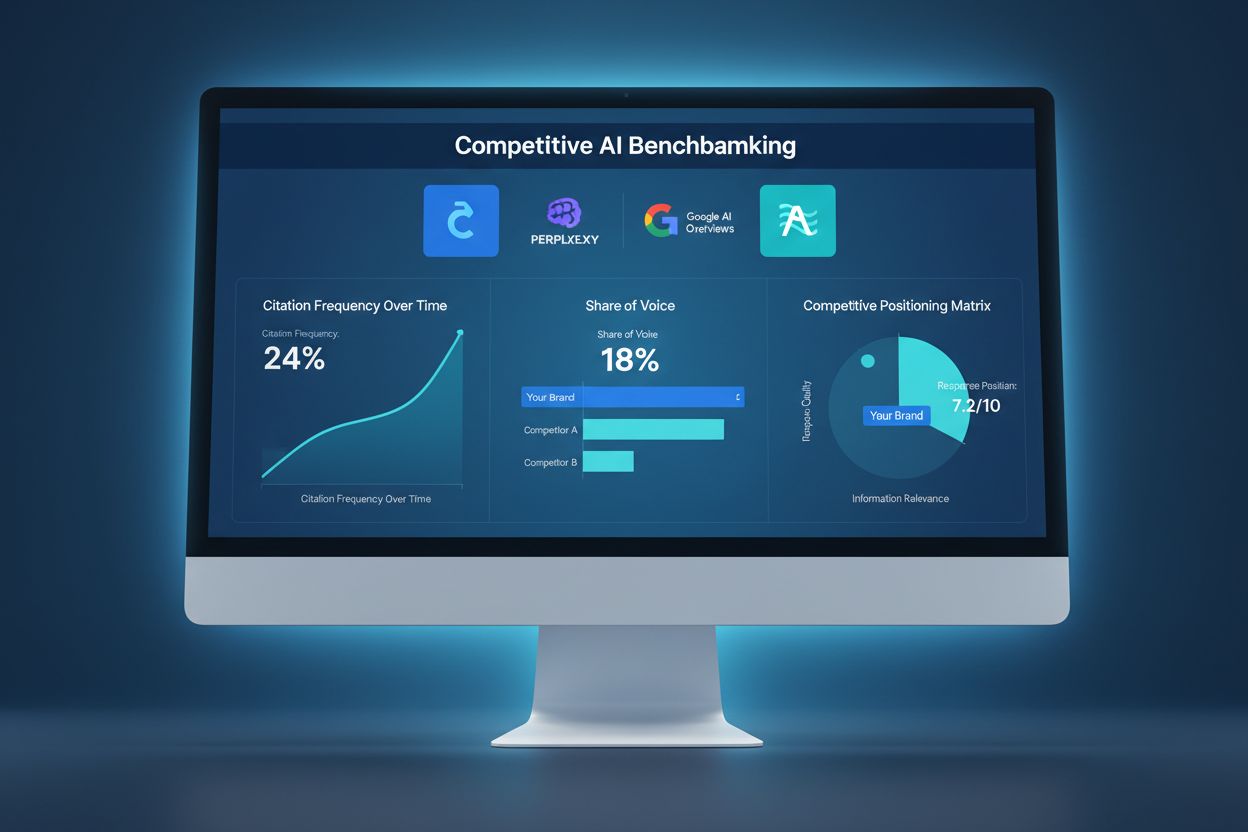

Konkurenční AI benchmarking

Zjistěte, jak porovnat svou AI viditelnost s konkurencí. Sledujte citace, podíl hlasu a konkurenční pozici napříč ChatGPT, Perplexity a Google AI. Objevte nástr...

Konkurenční AI sabotáž označuje úmyslné pokusy konkurentů negativně ovlivnit viditelnost, sentiment nebo výkon značky ve výsledcích vyhledávání a odpovědích chatbotů poháněných umělou inteligencí. Patří sem otrava dat, falešné recenze, dezinformační kampaně a manipulace s trénovacími daty AI za účelem poškození reputace značky a snížení počtu citací značky AI systémy.

Konkurenční AI sabotáž označuje úmyslné pokusy konkurentů negativně ovlivnit viditelnost, sentiment nebo výkon značky ve výsledcích vyhledávání a odpovědích chatbotů poháněných umělou inteligencí. Patří sem otrava dat, falešné recenze, dezinformační kampaně a manipulace s trénovacími daty AI za účelem poškození reputace značky a snížení počtu citací značky AI systémy.

Konkurenční AI sabotáž označuje záměrné pokusy manipulovat, otrávit nebo zkorumpovat data, která AI vyhledávače a jazykové modely používají k vytváření výsledků a citací. Na rozdíl od tradičního negativního SEO, které se zaměřuje na poškození pozic webu konkurenta prostřednictvím odkazových schémat či technických exploitů, AI sabotáž cílí na trénovací data a zdroje, na které se AI systémy spoléhají při poskytování odpovědí. Tento rozdíl je zásadní, protože AI systémy jako Google AI Overviews, Perplexity a GPT přímo citují zdroje z trénovacích dat, což je činí zranitelnými vůči koordinovaným dezinformačním kampaním. Dopad v reálném světě je značný: 60 % vyhledávání končí bez prokliku na web, takže konkurenti nyní mohou otrávit AI výsledky, přesměrovat návštěvnost, poškodit reputaci značky nebo šířit falešné informace, aniž by zasáhli tradiční pozice ve vyhledávačích.

Konkurenční AI sabotáž funguje prostřednictvím několika navzájem propojených vektorů útoku, které zneužívají způsob, jakým AI systémy přijímají a zpracovávají informace. Otrava dat je hlavní technika, spočívající v injektování falešných, zavádějících nebo škodlivých informací do zdrojů, které AI systémy používají k tréninku—například veřejné databáze, fóra, recenzní weby a agregátory zpráv. Útočníci využívají label flipping (změna metadat pro špatnou klasifikaci obsahu), data injection (přidání falešných položek do datasetů) a backdoor útoky (vkládání skrytých spouštěčů do trénovacích dat). Konkurenti také spouštějí koordinované kampaně s falešnými recenzemi, aby zahltili platformy vymyšlenými svědectvími, a zároveň šíří dezinformace a deepfaky prostřednictvím sociálních sítí, blogů a obsahu indexovaného AI. Zranitelnost spočívá v tom, že AI systémy často důvěřují objemu a konzistenci informací místo ověření jejich pravosti. Takto se jednotlivé metody sabotáže liší:

| Metoda | Jak funguje | Dopad na AI | Obtížnost detekce |

|---|---|---|---|

| Otrava dat | Vkládání falešných informací do trénovacích datasetů | AI přímo cituje otrávené zdroje ve výsledcích | Vysoká – vyžaduje analýzu dat |

| Falešné recenze | Koordinované „bombardování“ recenzemi na platformách | Zkresluje sentimentální analýzu a doporučení AI | Střední – pomáhá analýza vzorců |

| Dezinformační kampaně | Šíření nepravdivých tvrzení napříč indexovanými weby | AI zesiluje falešné narativy ve výsledcích | Vysoká – vyžaduje fact-checking |

| Deepfaky | Vytváření syntetických médií manažerů nebo produktů | Poškozuje důvěryhodnost značky při citaci AI | Velmi vysoká – vyžaduje ověření |

| Únos katalogů | Převzetí firemních profilů konkurence | AI přebírá falešné informace z unesených katalogů | Střední – pomáhají ověřovací kontroly |

| Falešné zpravodajské články | Publikace vymyšlených zpráv na zpravodajských webech | AI je považuje za autoritativní zdroje | Vysoká – vyžaduje ověření zdrojů |

AI systémy jsou v zásadě náchylnější k sabotáži než tradiční vyhledávače, protože důvěřují trénovacím datům více implicitně než lidé. Zatímco algoritmus Googlu hodnotí autoritu odkazů a reputaci domény, AI modely se jednoduše učí vzorce ze všech dat, na kterých jsou trénovány—a to je činí zranitelnými vůči koordinovaným útokům. Výzkumy ukazují, že už 250 škodlivých dokumentů může otrávit AI model, což je výrazně nižší bariéra než u tradičních SEO útoků. Problém zhoršuje i fakt, že AI systémy citují zdroje přímo—otravená data tak nejen ovlivní výsledky, ale stávají se autoritativní odpovědí pro uživatele. Odhalit otrávená data je násobně složitější než rozpoznat špatný zpětný odkaz, protože manipulace probíhá na úrovni tréninku a bývá zcela neviditelná pro vnější audit. S 527% nárůstem AI vyhledávání během pouhých pěti měsíců (leden–květen 2025) a 79 % Američanů důvěřujících AI vyhledávačům je motivace konkurentů k sabotáži větší než kdy dřív, zatímco bezpečnostní infrastruktura zůstává nedostatečná.

Nejznámějším příkladem AI sabotáže je situace, kdy se Target stal obětí koordinované dezinformační kampaně, která nepravdivě tvrdila, že řetězec prodává „satanistické“ dětské oblečení. AI systémy, natrénované na tento smyšlený narativ, začaly tyto falešné informace zobrazovat ve výsledcích vyhledávání a AI přehledech, což způsobilo značné reputační škody dříve, než firma stihla zareagovat. Podobné útoky zažily i e-mailové systémy v podobě otrávení spamových filtrů, kdy konkurenti vnášejí do trénovacích dat škodlivé vzory, aby byly legitimní e-maily označeny jako spam. Bombardování konkurence falešnými recenzemi je stále častější, kdy firmy zaplavují profily soupeřů negativními recenzemi, které AI systémy agregují do sentimentálních skóre. Únos katalogových záznamů je další vektor, kdy útočníci převezmou firemní profily konkurence na platformách jako Google My Business nebo v oborových katalozích a vkládají falešné informace, které AI indexuje a cituje. Tyto případy ukazují, že AI sabotáž není teoretická—poškozuje firmy už dnes, přičemž škody jsou umocněny tím, že výsledky AI působí autoritativně a často jsou první informací, na kterou uživatel narazí.

Odhalení konkurenční AI sabotáže vyžaduje vícevrstvý monitorovací přístup, který sleduje, jak se vaše značka zobrazuje ve výsledcích AI vyhledávání a citovaných zdrojích. Prvním krokem je nepřetržité sledování výsledků AI vyhledávání pro vaši značku, produkty a klíčové manažery na platformách jako Google AI Overviews, Perplexity, ChatGPT a Claude. Sledování sentimentu v indexovaných zdrojích pomáhá odhalit náhlé změny v tom, jak je vaše značka popisována—což je varovný signál pro koordinované dezinformační kampaně. Identifikace falešných recenzí spočívá v analýze recenzních vzorců na statistické anomálie, například náhlý nárůst jedné hvězdičky nebo opakující se formulace. Včasná detekce je zásadní; výzkumy ukazují, že prvních 48 hodin od zahájení sabotáže je klíčových pro omezení a reakci. Monitoring by měl sledovat i to, které zdroje AI systémy citují v souvislosti s vaší značkou, abyste mohli identifikovat otrávené zdroje dříve, než způsobí rozsáhlé škody. Základní metody detekce zahrnují:

Vybudování odolnosti proti konkurenční AI sabotáži vyžaduje proaktivní, víceúrovňovou obranu, která přesahuje tradiční správu reputace. Tvorba kvalitního, autoritativního obsahu je vaší nejsilnější ochranou—AI systémy jsou trénovány rozpoznávat a upřednostňovat obsah z etablovaných, důvěryhodných zdrojů, což ztěžuje otráveným datům konkurovat legitimním informacím. Šíření přesných informací na více indexovaných platformách zajišťuje, že když AI systémy hledají informace o vaší značce, narazí na konzistentní, pravdivé narativy z důvěryhodných zdrojů. Zabezpečení přítomnosti značky znamená převzít a ověřit všechny firemní profily, sociální sítě a oborové katalogy, aby nedošlo k únosům. Implementujte robustní monitorovací systémy, které sledují vaši značku v reálném čase napříč AI výsledky, což umožňuje rychlou reakci na nové hrozby. Vypracujte reakční protokoly popisující postup týmu při zjištění sabotáže, včetně dokumentace, hlášení platformám a právních kroků, pokud je to třeba. Budování vztahů s novináři, oborovými influencery a důvěryhodnými médii vytváří další vrstvy důvěryhodnosti, které AI systémy rozpoznají a upřednostní.

Specializované platformy pro monitorování AI se staly nezbytnou infrastrukturou pro ochranu značky v éře AI vyhledávání. Tyto nástroje poskytují upozornění v reálném čase, když se vaše značka objeví ve výsledcích AI vyhledávání, takže můžete sledovat nejen pozice, ale i skutečné citace a zdroje, které AI systémy používají. AmICited.com vyniká jako komplexní řešení navržené pro sledování toho, jak jsou vaše značka, produkty a manažeři citováni napříč AI vyhledávači včetně Google AI Overviews, Perplexity a GPT. Platforma sleduje, které zdroje AI cituje o vaší značce, což vám umožňuje identifikovat otrávené zdroje a reagovat dříve, než způsobí rozsáhlé škody. Integrace s širší strategií bezpečnosti značky znamená, že můžete korelovat vzorce AI citací s tradičními metrikami vyhledávání, sentimentem na sociálních sítích a recenzními platformami a získat tak kompletní přehled o konkurenčním prostředí. Kombinací AI monitoringu s existujícími nástroji pro správu reputace vytváříte jednotný obranný systém, který včas zachytí pokusy o sabotáž a poskytne data potřebná pro rychlou reakci.

Jak se konkurenční AI sabotáž stává častější, právní rámce se vyvíjejí, aby čelily novým hrozbám. DMCA výzvy k odstranění obsahu lze využít k odstranění otráveného obsahu z indexovaných zdrojů, i když proces bývá zdlouhavý a vyžaduje jasné důkazy o porušení autorských práv či vydávání se za jiného. Zákony o pomluvě poskytují možnost obrany, pokud sabotáž zahrnuje nepravdivá tvrzení poškozující vaši pověst, i když prokazování škod v kontextu AI je složité. Většina hlavních platforem má nyní mechanismy pro hlášení zneužití týkající se AI, včetně otravy dat, falešných recenzí a dezinformačních kampaní, ačkoliv vymahatelnost se značně liší. Nově vznikající regulace jako EU AI Act a navrhovaná americká legislativa začínají stanovovat odpovědnost za AI systémy, které šíří falešné informace, což může otevřít nové možnosti právní obrany. Firmy by měly veškeré pokusy o sabotáž pečlivě dokumentovat, neboť tyto důkazy jsou klíčové jak pro právní řízení, tak pro odvolání na platformách. Konzultace s právníky se zkušenostmi s AI a digitální reputací je stále důležitější pro tvorbu strategií, které odpovídají měnícím se předpisům.

Oblast konkurenční AI sabotáže se bude dále vyvíjet, jak útočníci i obránci zdokonalují své techniky. AI generované falešné recenze prostřednictvím velkých jazykových modelů bude stále těžší rozeznat od autentické zpětné vazby uživatelů, což si vyžádá pokročilejší detekční systémy. Ověřování pomocí blockchainu a decentralizované systémy důvěryhodnosti se rýsují jako možná řešení pro ověřování pravosti zdrojů před jejich zařazením do trénovacích dat AI. Poskytovatelé platforem intenzivně investují do vylepšených obran, včetně lepší validace dat, ověřování zdrojů a algoritmů pro detekci otravy, i když tato opatření budou vždy zaostávat za novými vektory útoku. Komunitní ověřovací systémy, kde uživatelé a experti označují podezřelý obsah, se mohou stát standardem a vytvořit kolektivní obranu proti sabotáži. Konkurenční výhoda bude stále častěji na straně firem, které drží krok s novými hrozbami prostřednictvím nepřetržitého monitoringu, rychlých reakčních protokolů a investic do AI gramotnosti v týmu. Organizace, které vnímají monitoring AI jako klíčovou součást ochrany značky už dnes, budou nejlépe připraveny čelit sofistikovanějším útokům zítřka.

Tradiční negativní SEO cílí na pozice ve vyhledávačích prostřednictvím manipulace s odkazy a kopírování obsahu. Konkurenční AI sabotáž cílí na trénovací data AI a chování modelu, otravuje zdroje, které AI systémy citují ve svých odpovědích. AI systémy jsou zranitelnější, protože přímo citují zdroje a více důvěřují trénovacím datům než tradiční algoritmy vyhledávačů.

Jednou týdně sledujte, jak AI platformy popisují vaši značku, pomocí nástrojů jako AmICited.com. Všímejte si náhlých změn sentimentu, falešných tvrzení ve výstupech AI, koordinovaných negativních recenzí nebo šíření dezinformací napříč platformami. Klíčová je včasná detekce během prvních 48 hodin pro omezení škod.

Okamžitě vše zdokumentujte pomocí screenshotů a časových razítek. Nahlaste postiženým platformám (OpenAI, Google, Anthropic). Šiřte přesné informace prostřednictvím vlastních kanálů. Kontaktujte právníka, pokud došlo k pomluvě nebo finanční újmě. Zaveďte monitorovací systémy, abyste včas zachytili budoucí útoky.

Výzkumy ukazují, že útočníkům stačí pouze 250 škodlivých dokumentů nebo 7–8 % datového souboru, aby významně otrávili AI modely. Tato nízká vstupní bariéra činí AI systémy obzvláště zranitelnými ve srovnání s tradičními vyhledávači, které mají sofistikovanější mechanismy detekce spamu.

Současné AI platformy mají omezené detekční schopnosti a většinou spoléhají na hlášení uživatelů a periodické přeškolování na čistých datech. Platformy ale zavádějí lepší ověřovací systémy, detekci anomálií a řízení přístupu. Odpovědnost za včasnou detekci často leží na samotných značkách.

Budujte silnou autentickou reputaci s kvalitním obsahem, pravidelně monitorujte výsledky AI vyhledávání, zabezpečte přítomnost své značky v katalozích, implementujte monitorovací systémy v reálném čase a rychle reagujte na útoky. Prevence budováním reputace je účinnější než náprava škod po sabotáži.

AmICited.com monitoruje, jak AI platformy (ChatGPT, Perplexity, Google AI Overviews) odkazují na vaši značku, sleduje změny sentimentu a vzorce citací. Upozornění v reálném čase vás informují o náhlých změnách v tom, jak AI popisuje vaši značku, což umožňuje rychlou reakci na pokusy o sabotáž.

Můžete podat žalobu na pomluvu, odeslat DMCA výzvy k odstranění falešného obsahu, nahlásit platformám porušení podmínek a případně žádat náhradu škody za finanční újmu. Zásadní je důkladná dokumentace sabotáže. Konzultujte s právníkem specializovaným na digitální práva a duševní vlastnictví.

Chraňte svou značku před konkurenční AI sabotáží pomocí monitorování v reálném čase napříč ChatGPT, Perplexity a Google AI Overviews. Odhalte hrozby dříve, než poškodí vaši reputaci.

Zjistěte, jak porovnat svou AI viditelnost s konkurencí. Sledujte citace, podíl hlasu a konkurenční pozici napříč ChatGPT, Perplexity a Google AI. Objevte nástr...

Zjistěte, jak sledovat zmínky o konkurenci ve vyhledávačích využívajících AI. Sledujte viditelnost v ChatGPT, Perplexity, Claude a Google AI pomocí metrik podíl...

Zjistěte, co je AI Competitive Intelligence a jak sledovat viditelnost konkurence napříč ChatGPT, Perplexity a Google AI Overviews. Sledujte citace, podíl na hl...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.