Co je Crawl Budget pro AI? Pochopení alokace zdrojů AI botů

Zjistěte, co znamená crawl budget pro AI, jak se liší od tradičních vyhledávačů a proč je důležitý pro viditelnost vaší značky v odpovědích generovaných AI a AI...

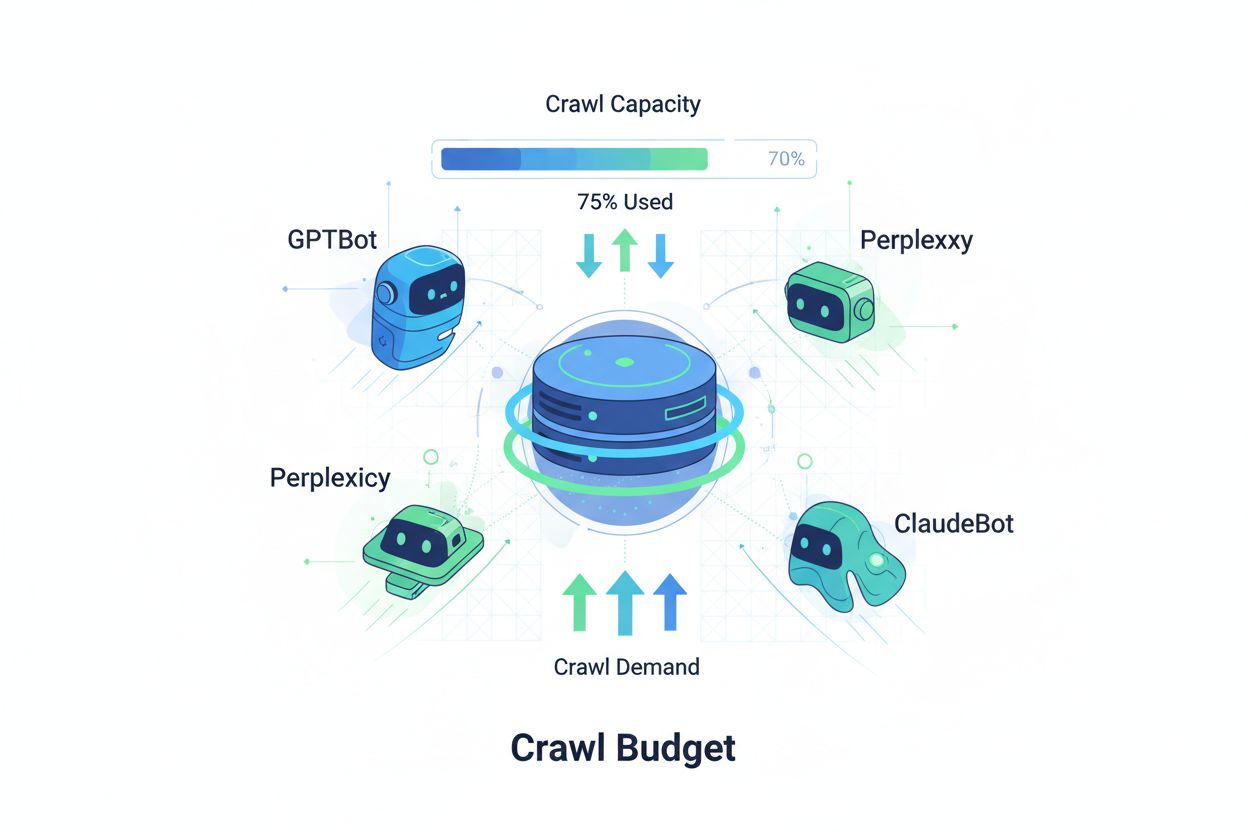

Techniky zajišťující, aby AI crawlery efektivně přistupovaly a indexovaly nejdůležitější obsah webu v rámci jejich crawl limitů. Optimalizace crawl budgetu vyvažuje crawl kapacitu (serverové zdroje) a crawl poptávku (požadavky botů) s cílem maximalizovat viditelnost ve výsledcích generovaných AI a zároveň kontrolovat provozní náklady a zatížení serveru.

Techniky zajišťující, aby AI crawlery efektivně přistupovaly a indexovaly nejdůležitější obsah webu v rámci jejich crawl limitů. Optimalizace crawl budgetu vyvažuje crawl kapacitu (serverové zdroje) a crawl poptávku (požadavky botů) s cílem maximalizovat viditelnost ve výsledcích generovaných AI a zároveň kontrolovat provozní náklady a zatížení serveru.

Crawl budget označuje množství zdrojů—měřených počtem požadavků a šířkou pásma—které vyhledávače a AI boti alokují na procházení vašeho webu. Původně se tento koncept týkal hlavně chování Googlebota, ale s příchodem botů řízených umělou inteligencí se zásadně změnila strategie správy crawl budgetu. Rovnice crawl budgetu má dva klíčové parametry: kapacitu procházení (maximální počet stránek, které může bot projít) a poptávku po procházení (skutečný počet stránek, které chce bot projít). V éře AI se tato dynamika mnohonásobně zkomplikovala, protože boti jako GPTBot (OpenAI), Perplexity Bot a ClaudeBot (Anthropic) soutěží o serverové zdroje spolu s tradičními crawlery vyhledávačů. Tito AI boti mají odlišné priority a vzory chování než Googlebot, často spotřebovávají výrazně více datového toku a sledují jiné indexační cíle, což činí optimalizaci crawl budgetu nezbytnou pro udržení výkonu webu i kontrolu provozních nákladů.

AI crawlery se zásadně liší od tradičních vyhledávacích botů v chování při procházení, frekvenci i spotřebě zdrojů. Zatímco Googlebot respektuje limity crawl budgetu a využívá sofistikované mechanismy pro omezení, AI boti často vykazují agresivnější chování, někdy opakovaně žádají stejný obsah a méně reagují na signály zatížení serveru. Výzkumy ukazují, že GPTBot od OpenAI může na některých webech spotřebovat 12–15krát více datového toku než crawler od Googlu, zejména u webů s rozsáhlými knihovnami obsahu nebo častými aktualizacemi. Toto agresivní chování je dáno požadavky na trénink AI – boti musí neustále získávat nový obsah pro zlepšení modelů, což je zásadně odlišná filozofie od vyhledávačů zaměřených na indexaci pro vyhledávání. Dopad na server je značný: organizace hlásí výrazné zvýšení nákladů na datový přenos, využití procesoru i zatížení serveru přímo způsobené AI boty. Navíc kumulativní efekt několika AI botů procházejících zároveň může degradovat uživatelskou zkušenost, zpomalit načítání stránek a zvýšit hostingové náklady – rozdíl mezi tradičními a AI crawlery se tak stává zásadní otázkou byznysu, nikoli jen technickým detailem.

| Charakteristika | Tradiční crawlery (Googlebot) | AI crawlery (GPTBot, ClaudeBot) |

|---|---|---|

| Frekvence procházení | Adaptivní, respektuje crawl budget | Agresivní, kontinuální |

| Spotřeba datového toku | Mírná, optimalizovaná | Vysoká, náročná na zdroje |

| Respektování robots.txt | Striktní dodržování | Různorodé dodržování |

| Caching | Sofistikované ukládání do mezipaměti | Časté opakované požadavky |

| Identifikace User-Agent | Jasná, konzistentní | Někdy skrytá |

| Obchodní cíl | Indexace vyhledávání | Trénink modelu/získávání dat |

| Dopad na náklady | Minimální | Významný (12–15× vyšší) |

K pochopení crawl budgetu je potřeba zvládnout jeho dva základní prvky: kapacita procházení a poptávka po procházení. Kapacita procházení znamená maximální počet URL, které váš server zvládne během určitého období, a ovlivňuje ji několik faktorů:

Poptávka po procházení naopak vyjadřuje, kolik stránek chtějí boti skutečně projít, což je dáno vlastnostmi obsahu a prioritami botů. Ovlivňují ji:

Optimalizační výzva nastává, když poptávka po procházení převýší kapacitu – boti musí volit, které stránky projdou, a mohou minout důležité aktualizace. Naopak pokud kapacita výrazně převyšuje poptávku, plýtváte serverovými zdroji. Cílem je dosáhnout efektivního procházení: maximalizovat crawl důležitých stránek a minimalizovat plýtvání na málo hodnotném obsahu. V éře AI je tento balanc složitější, protože různé typy botů s různými prioritami soupeří o stejný serverový výkon, což vyžaduje sofistikované strategie pro efektivní rozdělení crawl budgetu mezi všechny zúčastněné.

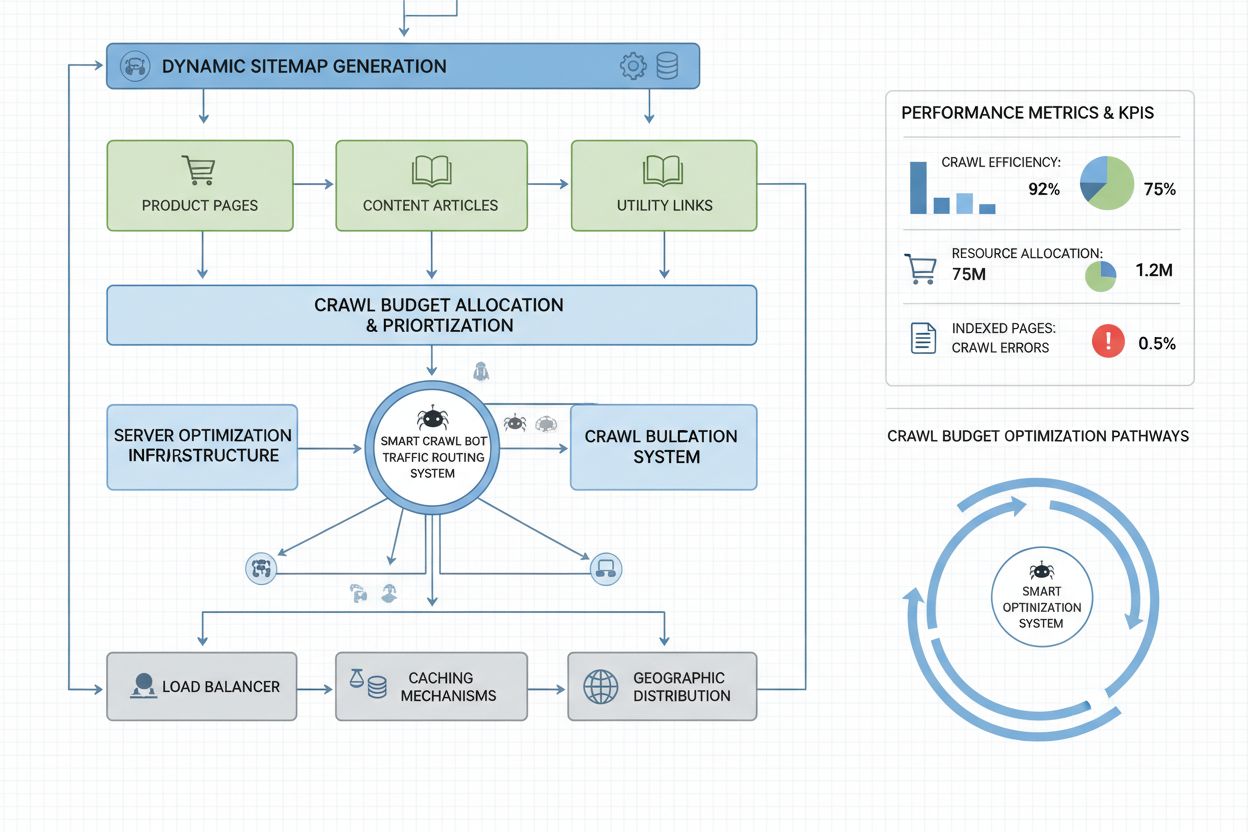

Měření výkonu crawl budgetu začíná v Google Search Console, kde v sekci „Nastavení“ najdete statistiky procházení – denní počty požadavků, stažených bajtů a odezvu serveru. Pro výpočet poměru efektivity procházení vydělte počet úspěšných crawlů (odpovědi HTTP 200) celkovým počtem požadavků; zdravé weby dosahují 85–95% efektivity. Základní výpočet: (Úspěšné crawlery ÷ Celkový počet požadavků) × 100 = Efektivita procházení v %. Kromě dat od Googlu je potřeba sledovat:

Pro monitoring AI crawlerů nabízí AmICited.com speciální sledování aktivity GPTBot, ClaudeBot a Perplexity Bot s přehledem, které stránky mají prioritu a jak často se na ně vracejí. Implementací vlastních upozornění na neobvyklé špičky v crawl provozu—zejména od AI botů—můžete rychle reagovat na neplánované čerpání zdrojů. Klíčovou metrikou je náklad na crawl na stránku: vydělením celkových serverových zdrojů spotřebovaných crawlery počtem unikátních crawlovaných stránek zjistíte, zda efektivně využíváte crawl budget nebo plýtváte na málo hodnotném obsahu.

Optimalizace crawl budgetu pro AI boty vyžaduje vícevrstvý přístup kombinující technické úpravy a strategická rozhodnutí. Hlavní taktiky zahrnují:

Volba konkrétní taktiky závisí na vašem byznys modelu a strategii obsahu. E-shopy mohou blokovat AI crawlery na produktových stránkách, aby zabránily tréninku konkurence, zatímco vydavatelé povolují crawling kvůli viditelnosti v AI odpovědích. Pokud AI boti skutečně přetěžují server, blokování dle uživatelského agenta v robots.txt je nejpřímočařejší: User-agent: GPTBot a Disallow: / zabrání GPTBotu OpenAI přístup na web. Toto řešení ale znamená ztrátu možné viditelnosti v odpovědích ChatGPT a dalších AI aplikacích. Nuancovanější strategií je selektivní blokování: povolit AI crawlerům přístup k veřejnému obsahu a blokovat jim přístup do citlivých sekcí, archivů nebo duplicit, kde crawl budget nemá přidanou hodnotu.

Weby v podnikovém měřítku s miliony stránek potřebují pokročilé strategie optimalizace crawl budgetu. Dynamické sitemapy jsou zásadní inovací – generují se v reálném čase na základě čerstvosti obsahu, důležitosti a historie procházení. Místo statických XML sitemap s výčtem všech stránek dynamické sitemap zvýrazňují nedávno aktualizované, nejnavštěvovanější a konverzní stránky, takže boti zaměří crawl budget na skutečně důležitý obsah. Segmentace URL rozdělí web na logické crawl zóny s individuální optimalizací – například sekce zpráv může agresivně aktualizovat sitemap kvůli rychlému procházení, zatímco evergreen obsah méně často.

Optimalizace na straně serveru zahrnuje caching strategie citlivé na crawlery, kdy se botům doručují cachované odpovědi a uživatelům čerstvý obsah, což snižuje zátěž serveru při opakovaných požadavcích. CDN s rozlišením botů může oddělit provoz crawlerů od uživatelů, takže crawlery nespotřebovávají šířku pásma nutnou pro návštěvníky. Omezení rychlosti podle user-agent umožní serveru zpomalit AI boty bez ovlivnění Googlebota a běžných uživatelů. U opravdu velkých operací distribuovaná správa crawl budgetu napříč více regiony zabrání přetížení a umožní geografické rozložení crawl provozu. Predikce crawlů pomocí strojového učení analyzuje historii požadavků a předpovídá, které stránky budou boti chtít příště, takže lze tyto stránky předem optimalizovat. Tyto podnikové strategie mění crawl budget z omezení na řízený zdroj, který umožňuje obsloužit miliardy stránek a udržet optimální výkon pro boty i uživatele.

Rozhodnutí blokovat či povolit AI crawlery je klíčovým byznys krokem s významným dopadem na viditelnost, konkurenční postavení i provozní náklady. Povolení AI crawlerů přináší výhody: váš obsah může být zařazen do AI odpovědí, získáváte návštěvnost z ChatGPT, Claude, Perplexity i dalších AI aplikací, vaše značka je viditelná v novém distribučním kanálu a profitujete ze SEO signálů plynoucích z citací AI systémy. Tyto výhody však znamenají zvýšené zatížení serveru, vyšší datové náklady, riziko tréninku konkurenčních modelů na vašem obsahu a ztrátu kontroly nad tím, jak je váš obsah prezentován a připisován v AI odpovědích.

Blokování AI crawlerů eliminuje tyto náklady, ale znamená obětování viditelnosti a potenciálně přenecháváte trh konkurenci, která crawling povoluje. Optimální strategie závisí na vašem byznys modelu: vydavatelé a zpravodajství často profitují z povolení kvůli distribuci prostřednictvím AI souhrnů; SaaS firmy a e-shopy mohou blokovat crawlery kvůli ochraně produktových dat před konkurencí; vzdělávací a výzkumné organizace obvykle crawling povolují pro maximální šíření znalostí. Hybridní přístup nabízí kompromis: povolit crawling veřejného obsahu a blokovat přístup do citlivých sekcí, uživatelského obsahu nebo chráněných informací. Tak maximalizujete viditelnost a zároveň chráníte hodnotné zdroje. Monitoring přes AmICited.com a podobné nástroje vám ukáže, zda váš obsah AI systémy skutečně citují—pokud se na AI výstupech neobjevujete, i když crawling povolujete, stává se blokování atraktivnější, protože nesete náklady bez viditelnosti.

Efektivní správa crawl budgetu vyžaduje specializované nástroje pro přehled o chování botů a umožňuje datově podloženou optimalizaci. Conductor a Sitebulb poskytují podnikové analýzy crawlů, simulují procházení vyhledávači a odhalují neefektivnosti, zbytečné crawlery na chybových stránkách i příležitosti ke zlepšení rozdělení budgetu. Cloudflare nabízí správu botů na síťové úrovni, umožňuje detailně řídit, kteří boti mají přístup, a nastavovat omezení rychlosti pro AI crawlery. Pro monitoring AI crawlerů je AmICited.com nejkomplexnějším řešením, sleduje aktivitu GPTBot, ClaudeBot, Perplexity Bot a dalších AI crawlerů s detailními statistikami o tom, které stránky navštěvují, jak často a zda se váš obsah objevuje ve výstupech AI.

Analýza serverových logů zůstává základem optimalizace crawl budgetu—nástroje jako Splunk, Datadog nebo open-source ELK Stack umožňují procházet logy, segmentovat provoz podle user-agent a zjistit, které boty spotřebují nejvíce zdrojů a které stránky jsou nejčastěji procházeny. Vlastní dashboardy sledující trendy v čase ukáží, zda optimalizační snahy fungují a zda se objevují nové typy botů. Google Search Console stále poskytuje klíčová data o chování Googlebota, Bing Webmaster Tools obdobně pro crawler Microsoftu. Nejvyspělejší organizace zavádějí víceúrovňové monitorovací strategie: kombinují Google Search Console pro tradiční crawl data, AmICited.com pro monitoring AI crawlerů, analýzu logů pro kompletní přehled botů a specializované nástroje jako Conductor pro simulaci a analýzu efektivity. Tento vrstevnatý přístup zajišťuje kompletní přehled o interakcích všech typů botů s vaším webem a umožňuje optimalizovat crawl budget na základě dat, nikoli jen odhadu. Pravidelný monitoring—ideálně týdenní kontrola metrik—umožňuje rychle odhalit problémy jako nečekané špičky v crawl provozu, zvýšený počet chyb nebo nové agresivní boty a včas zareagovat, než crawl budget negativně ovlivní výkon webu nebo provozní náklady.

AI boti jako GPTBot a ClaudeBot fungují s jinými prioritami než Googlebot. Zatímco Googlebot respektuje limity crawl budgetu a používá sofistikované omezení, AI boti často vykazují agresivnější vzory procházení a spotřebují 12–15krát více datového toku. AI boti upřednostňují kontinuální získávání obsahu pro trénink modelů místo indexace pro vyhledávání, což zásadně mění jejich chování a vyžaduje odlišné optimalizační strategie.

Výzkumy ukazují, že GPTBot od OpenAI může na některých webech spotřebovat 12–15krát více datového toku než Googlebot, zejména u rozsáhlých knihoven obsahu. Skutečná spotřeba závisí na velikosti webu, frekvenci aktualizací a počtu současně procházejících AI botů. Pokud více AI botů prochází zároveň, může výrazně vzrůst zatížení serveru i náklady na hosting.

Ano, konkrétní AI crawlery můžete zablokovat pomocí robots.txt, aniž byste ovlivnili tradiční SEO. Blokováním AI crawlerů však obětujete viditelnost ve výsledcích generovaných AI, například v ChatGPT, Claude, Perplexity a dalších AI aplikacích. Rozhodnutí závisí na vašem byznys modelu – vydavatelé obvykle z povolení profitují, zatímco e-shopy často blokují, aby zabránily tréninku konkurence.

Špatná správa crawl budgetu může vést k tomu, že důležité stránky nebudou procházeny ani indexovány, zpomalí se indexace nového obsahu, zvýší se zatížení serveru a náklady na přenos dat, zhorší se uživatelská zkušenost kvůli spotřebě zdrojů boty a přijdete o příležitosti k viditelnosti ve vyhledávání i AI odpovědích. Nejzranitelnější jsou rozsáhlé weby s miliony stránek.

Pro optimální výsledky sledujte metriky crawl budgetu týdně a při zásadních aktualizacích obsahu nebo nečekaných nárůstech provozu denně. Použijte Google Search Console pro tradiční data, AmICited.com pro monitoring AI crawlerů a serverové logy pro kompletní přehled o botech. Pravidelné sledování umožní včas odhalit problémy dříve, než ovlivní výkon webu.

Účinnost robots.txt u AI botů je různá. Zatímco Googlebot striktně respektuje pravidla robots.txt, AI boti mají nekonzistentní přístup – někteří pravidla dodržují, jiní je ignorují. Pro spolehlivější kontrolu použijte blokování podle user-agent, omezení rychlosti na serveru nebo nástroje pro správu botů na CDN, například Cloudflare, pro detailnější řízení.

Crawl budget přímo ovlivňuje AI viditelnost, protože AI boti nemohou citovat ani odkazovat obsah, který neprocházejí. Pokud vaše důležité stránky nejsou kvůli omezenému rozpočtu procházeny, neobjeví se ve výsledcích generovaných AI. Optimalizace crawl budgetu zajistí, že váš nejlepší obsah AI boti objeví a zvýší šanci na citace v ChatGPT, Claude a Perplexity.

Prioritizujte stránky pomocí dynamických sitemap, které zvýrazní nedávno aktualizovaný obsah, stránky s vysokou návštěvností a konverzním potenciálem. Blokujte nízkohodnotné stránky (archivy, duplicity) v robots.txt. Používejte čisté URL struktury a strategické interní odkazy, které vedou boty k důležitému obsahu. Sledujte, které stránky AI boti skutečně procházejí pomocí nástrojů jako AmICited.com a podle toho upravte strategii.

Sledujte, jak AI boti procházejí váš web a optimalizujte svou viditelnost v AI odpovědích pomocí komplexní platformy pro monitoring AI crawlerů od AmICited.com.

Zjistěte, co znamená crawl budget pro AI, jak se liší od tradičních vyhledávačů a proč je důležitý pro viditelnost vaší značky v odpovědích generovaných AI a AI...

Crawl budget je počet stránek, které vyhledávače prochází na vašem webu během určitého období. Naučte se, jak optimalizovat crawl budget pro lepší indexaci a SE...

Zjistěte, jak povolit AI botům jako GPTBot, PerplexityBot a ClaudeBot procházet váš web. Nastavte robots.txt, vytvořte llms.txt a optimalizujte svůj web pro AI ...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.