Dolaďování AI modelů

Zjistěte, jak dolaďování AI modelů přizpůsobuje předtrénované modely pro konkrétní úkoly v odvětví a značce, zvyšuje přesnost a zároveň snižuje náklady a výpoče...

Ladění (fine-tuning) je proces přizpůsobení předtrénovaného AI modelu pro specifické úlohy trénováním na menší, doménově specifické datové sadě. Tato technika upravuje parametry modelu tak, aby vynikal ve specializovaných aplikacích a zároveň využíval široké znalosti získané během počátečního předtrénování, což je efektivnější a levnější než trénování od začátku.

Ladění (fine-tuning) je proces přizpůsobení předtrénovaného AI modelu pro specifické úlohy trénováním na menší, doménově specifické datové sadě. Tato technika upravuje parametry modelu tak, aby vynikal ve specializovaných aplikacích a zároveň využíval široké znalosti získané během počátečního předtrénování, což je efektivnější a levnější než trénování od začátku.

Ladění je proces přizpůsobení předtrénovaného AI modelu pro plnění specifických úloh trénováním na menší, doménově specifické datové sadě. Namísto budování AI modelu od začátku – což vyžaduje obrovské výpočetní zdroje a obrovské množství označených dat – ladění využívá široké znalosti, které model již získal během počátečního předtrénování, a dolaďuje je pro specializované aplikace. Tato technika se stala základem moderního deep learningu a generativní AI a umožňuje organizacím přizpůsobovat výkonné modely, jako jsou velké jazykové modely (LLM), pro jejich jedinečné obchodní potřeby. Ladění představuje praktickou implementaci přenosu učení (transfer learning), kdy znalosti získané z jedné úlohy zlepšují výkon v příbuzné úloze. Intuice je jednoduchá: je mnohem jednodušší a levnější vylepšit schopnosti modelu, který už rozumí obecným vzorcům, než trénovat nový model od začátku pro konkrétní účel.

Ladění se objevilo jako klíčová technika s tím, jak modely hlubokého učení exponenciálně rostly ve velikosti i složitosti. Na počátku 10. let 21. století vědci zjistili, že předtrénování modelů na obrovských datových sadách a jejich následné přizpůsobení konkrétním úlohám dramaticky zlepšuje výkon a zároveň zkracuje dobu trénování. Tento přístup získal na významu s nástupem transformerových modelů a BERTu (Bidirectional Encoder Representations from Transformers), které ukázaly, že předtrénované modely lze efektivně doladit pro množství navazujících úloh. Exploze generativní AI a velkých jazykových modelů jako GPT-3, GPT-4 a Claude učinila ladění ještě relevantnějším, protože organizace po celém světě hledají způsoby, jak tyto výkonné modely přizpůsobit doménově specifickým aplikacím. Podle nedávných dat o adopci v podnicích 51 % organizací využívajících generativní AI používá retrieval-augmented generation (RAG), zatímco ladění zůstává zásadním doplňkovým přístupem pro specializované případy užití. Vývoj metod efektivního ladění parametrů (PEFT) jako LoRA (Low-Rank Adaptation) demokratizoval přístup k ladění tím, že snižuje výpočetní požadavky až o 90 %, což tuto techniku zpřístupňuje i organizacím bez masivní GPU infrastruktury.

Ladění probíhá prostřednictvím přesně definovaného matematického a výpočetního procesu, který upravuje parametry (váhy a biasy) modelu pro optimalizaci výkonu na nových úlohách. Během předtrénování se model učí obecné vzorce z obrovských datových sad pomocí gradientního sestupu a zpětného šíření chyb (backpropagation), čímž si buduje širokou základnu znalostí. Ladění začíná s těmito předtrénovanými váhami jako výchozím bodem a pokračuje v trénovacím procesu na menší, úlohám přizpůsobené datové sadě. Klíčový rozdíl spočívá v použití výrazně menší učící rychlosti – velikosti aktualizací vah v každé iteraci tréninku – aby se předešlo katastrofickému zapomínání, kdy model ztrácí důležité obecné znalosti. Proces ladění zahrnuje průchody dopředu, kdy model dělá předpovědi na trénovacích příkladech, výpočet ztráty měřící chyby v předpovědích a zpětné průchody, při nichž jsou počítány gradienty a upravovány váhy. Tento iterativní proces pokračuje po více epochách (úplných průchodech trénovacími daty), dokud model nedosáhne uspokojivého výkonu na validačních datech. Matematická elegance ladění spočívá v jeho efektivitě: díky zahájení s předtrénovanými váhami, které již obsahují užitečné vzorce, model konverguje k dobrým řešením mnohem rychleji než při trénování od začátku, často vyžaduje 10–100krát méně dat a výpočetních prostředků.

| Aspekt | Ladění | Retrieval-Augmented Generation (RAG) | Prompt Engineering | Plné trénování modelu |

|---|---|---|---|---|

| Zdroj znalostí | Zapečeno v parametrech modelu | Externí databáze/znalostní báze | Uživatelsky zadaný kontext v promptu | Naučeno od začátku z dat |

| Aktualizace dat | Statické do dalšího přeškolení | Reálný čas/dynamické | Aktuální pouze v promptu | Zmrazeno při trénování |

| Výpočetní náročnost | Vysoká při trénování, nízká při inferenci | Nízká na začátku, střední inference | Minimální | Extrémně vysoká |

| Složitost implementace | Střední až vysoká (vyžaduje ML expertizu) | Střední (vyžaduje infrastrukturu) | Nízká (bez trénování) | Velmi vysoká |

| Hloubka přizpůsobení | Hluboká (mění se chování modelu) | Mělká (jen retrieval) | Povrchová (na úrovni promptu) | Úplná (od základu) |

| Frekvence aktualizací | Týdny/měsíce (vyžaduje přeškolení) | Reálný čas (aktualizace databáze) | Při dotazu (manuální) | Nepraktické pro časté změny |

| Konzistence výstupu | Vysoká (naučené vzorce) | Proměnlivá (závisí na retrievalu) | Střední (závislé na promptu) | Závisí na trénovacích datech |

| Připisování zdrojů | Žádné (implicitně ve vahách) | Úplné (citované dokumenty) | Částečné (prompt viditelný) | Žádné |

| Škálovatelnost | Více modelů na doménu | Jeden model, více datových zdrojů | Jeden model, více promptů | Nepraktické ve velkém měřítku |

| Ideální použití | Specializované úlohy, konzistentní formátování | Aktuální informace, transparentnost | Rychlé iterace, jednoduché úlohy | Nové domény, unikátní požadavky |

Ladění následuje strukturovaný postup, který promění univerzální model ve specializovaného experta. Proces začíná přípravou dat, kdy organizace shromažďují a kurátorují příklady relevantní pro konkrétní úlohu. U právního AI asistenta to může být tisíce právních dokumentů spárovaných s příslušnými otázkami a odpověďmi. U diagnostického nástroje ve zdravotnictví například klinické případy s diagnózami. Kvalita této datové sady je zásadní – výzkumy opakovaně prokazují, že menší sada vysoce kvalitních, dobře označených příkladů vede k lepším výsledkům než větší sada s šumem nebo nekonzistentním označením. Po přípravě dat se data dělí na trénovací, validační a testovací sady, aby měl model šanci generalizovat na neviděné příklady.

Samotné ladění začíná načtením předtrénovaného modelu a jeho vah do paměti. Architektura modelu zůstává nezměněna; upravují se pouze váhy. V každé trénovací iteraci model zpracuje dávku trénovacích příkladů, provede predikce a porovná je se správnými odpověďmi pomocí ztrátové funkce kvantifikující chyby v předpovědích. Backpropagace poté spočítá gradienty – matematická vyjádření toho, jak by se měla každá váha změnit pro snížení ztráty. Optimalizační algoritmus jako Adam nebo SGD (Stochastic Gradient Descent) použije tyto gradienty k aktualizaci vah, obvykle s učící rychlostí 10–100krát menší než při předtrénování, aby se zachovaly obecné znalosti. Tento proces se opakuje v průběhu několika epoch, přičemž model se postupně specializuje na úlohy z doménových dat. Během trénování je model průběžně vyhodnocován na validační sadě za účelem monitorování výkonu a detekce overfittingu – tedy situace, kdy si model pouze pamatuje trénovací příklady místo učení obecných vzorců. Jakmile se výkon na validačních datech ustálí nebo začne zhoršovat, trénování končí, aby se zabránilo overfittingu.

Plné ladění aktualizuje všechny parametry modelu, což může být výpočetně velmi náročné u velkých modelů. Model s miliardami parametrů vyžaduje při backpropagaci ukládat gradienty ke každému parametru, což spotřebuje obrovské množství GPU paměti. Pro model o 7 miliardách parametrů může plné ladění vyžadovat více než 100 GB GPU paměti, což je pro většinu organizací nedostupné. Plné ladění však často přináší nejlepší výkon, protože všechny váhy modelu se mohou přizpůsobit nové úloze.

Metody efektivního ladění parametrů (PEFT) tuto nevýhodu řeší tím, že aktualizují pouze malou podmnožinu parametrů. LoRA (Low-Rank Adaptation), jedna z nejpopulárnějších PEFT technik, přidává malé trénovatelné matice do specifických vrstev a původní váhy ponechává zamražené. Tyto nízko-rankové matice zachycují úpravy specifické pro danou úlohu bez změny základního modelu. Výzkumy ukazují, že LoRA dosahuje výkonu srovnatelného s plným laděním při použití o 90 % méně paměti a trénování je 3–5krát rychlejší. QLoRA to posouvá dále kvantizací základního modelu na 4bitovou přesnost, což snižuje nároky na paměť o dalších 75 %. Další PEFT přístupy zahrnují adaptéry (malé doménové vrstvy vložené do modelu), prompt tuning (učení měkkých promptů místo vah modelu) a BitFit (ladění pouze biasů). Tyto metody demokratizovaly ladění a umožnily organizacím bez masivních GPU clusterů přizpůsobovat špičkové modely.

Ladění LLM zahrnuje specifická hlediska odlišná od ladění modelů pro počítačové vidění či tradiční NLP. Předtrénované LLM jako GPT-3 či Llama jsou trénovány self-supervised learningem na obrovských textových korpusech, kde se učí predikovat další slovo v sekvenci. Toto předtrénování sice zajišťuje silné schopnosti generování textu, ale samo o sobě neučí model následovat uživatelské instrukce nebo chápat záměr. Předtrénovaný LLM dotázaný “nauč mě psát životopis” může pouze větu dokončit “pomocí Microsoft Word”, místo aby skutečně poskytl radu, jak životopis napsat.

Instruction tuning tento nedostatek řeší laděním na datových sadách s páry (instrukce, odpověď) pokrývajícími různé úlohy. Tyto datasety učí model rozpoznávat různé typy instrukcí a vhodně na ně reagovat. Model s instruction tuningem se naučí, že prompt začínající “nauč mě jak” si zaslouží odpověď krok za krokem, nikoli pouze dokončení věty. Tento specializovaný přístup se ukázal být zásadní pro tvorbu praktických AI asistentů.

Reinforcement Learning from Human Feedback (RLHF) je pokročilá technika ladění, která doplňuje instruction tuning. Místo spoléhání pouze na označené příklady RLHF začleňuje lidské preference k optimalizaci vlastností, které je těžké přesně specifikovat – jako užitečnost, faktická správnost, humor nebo empatie. Proces zahrnuje generování více výstupů modelu pro prompt, jejich hodnocení lidmi, trénink reward modelu predikujícího, které výstupy lidé preferují, a použití reinforcement learningu k optimalizaci LLM podle tohoto signálu. RLHF byl klíčový pro sladění modelů jako ChatGPT s lidskými hodnotami a preferencemi.

Ladění se stalo centrálním prvkem AI strategií podniků, které tak mohou nasazovat přizpůsobené modely odrážející jejich jedinečné požadavky a hlas značky. Podle State of AI reportu od Databricks z roku 2024, který analyzoval data z více než 10 000 organizací, jsou podniky při nasazování AI modelů dramaticky efektivnější, když poměr experimentálních a produkčních modelů klesl ze 16:1 na 5:1 – trojnásobné zlepšení efektivity. Zatímco RAG pronikl mezi 51 % uživatelů generativní AI, ladění zůstává klíčové pro specializované aplikace, kde je nutná konzistence výstupu, doménová odbornost nebo offline nasazení.

Finanční služby vedou v adopci AI s nejvyšším využitím GPU a růstem GPU poptávky o 88 % za šest měsíců, zejména díky ladění modelů pro detekci podvodů, hodnocení rizik a algoritmické obchodování. Zdravotnictví & Life Sciences překvapivě rychle adoptovalo AI, přičemž 69 % využití Python knihoven směřuje na natural language processing, což odráží aplikace ladění v objevování léků, analýzách klinického výzkumu a zdravotnické dokumentaci. Výroba & automobilový průmysl zaznamenaly meziroční růst NLP o 148 %, využívajíce doladěné modely pro kontrolu kvality, optimalizaci dodavatelského řetězce a analýzu zpětné vazby zákazníků. Tyto trendy ukazují, že ladění přešlo z experimentálních projektů do produkčních systémů přinášejících měřitelnou obchodní hodnotu.

Ladění přináší řadu přesvědčivých výhod, které vysvětlují jeho trvalou roli i přes nástup alternativních přístupů. Doménově specifická přesnost je zřejmě největším přínosem – model doladěný na tisících právních dokumentů nejen zná právní terminologii, ale rozumí právnímu uvažování, vhodným strukturám klauzulí a relevantním precedentům. Toto hluboké zacílení umožňuje generovat výstupy, které odpovídají standardům expertů způsobem, jakého generické modely nikdy nedosáhnou. Efektivita díky ladění může být dramatická; výzkum Snorkel AI ukázal, že doladěný malý model dosáhl kvality GPT-3, ačkoliv byl 1 400krát menší, vyžadoval méně než 1 % trénovacích štítků a stál v produkci 0,1 % ceny. Tato efektivita mění ekonomiku AI nasazení a zpřístupňuje sofistikované AI i organizacím s omezeným rozpočtem.

Přizpůsobení tónu a stylu umožňuje organizacím udržet konzistentní komunikaci a brand. Firemní chatbot může být doladěn tak, aby dodržoval komunikační manuál, ať už formálně a profesionálně v právu, nebo vřele a konverzačně v retailu. Možnost offline nasazení je další zásadní výhodou – po doladění obsahují modely všechny potřebné znalosti ve svých parametrech a nevyžadují přístup k externím datům, což je činí vhodnými pro mobilní aplikace, vestavěné systémy a zabezpečená prostředí bez internetu. Snížení halucinací ve specializovaných doménách nastává proto, že model se naučil přesné vzorce specifické pro danou oblast, což snižuje tendenci generovat věrohodně znějící, ale nesprávné informace.

Navzdory výhodám přináší ladění významné výzvy, které je třeba zvážit. Požadavky na data jsou zásadní překážkou – ladění vyžaduje stovky až tisíce kvalitních, označených příkladů a jejich příprava znamená rozsáhlé shromažďování, čištění a anotaci, což může trvat týdny až měsíce. Výpočetní náklady zůstávají vysoké; plné ladění velkých modelů vyžaduje výkonné GPU nebo TPU, přičemž jeden tréninkový běh může stát desítky tisíc dolarů. I metody efektivního ladění parametrů vyžadují specializovaný hardware a znalosti, které mnoha organizacím chybí.

Katastrofické zapomínání představuje trvalé riziko, kdy ladění způsobí, že model ztratí obecné znalosti získané při předtrénování. Model doladěný na právní dokumenty může excelovat v analýze smluv, ale selhávat v základních úlohách, které dříve zvládal. Tento efekt často vede k nutnosti udržovat více specializovaných modelů místo spoléhání na jednoho univerzálního asistenta. Zátěž údržby roste s vývojem doménových znalostí – když se objeví nové regulace, výzkumné poznatky či změny produktů, je nutné model přeškolit na aktualizovaných datech, což je časově i finančně náročné. Tento cyklus retrénování může vést k tomu, že modely jsou v rychle se měnících oblastech nebezpečně zastaralé.

Absence připisování zdrojů vytváří problémy s transparentností a důvěrou v aplikacích s vysokými nároky na auditovatelnost. Doladěné modely generují odpovědi z interních parametrů místo explicitně načtených dokumentů, což prakticky znemožňuje ověřit původ konkrétní informace. Ve zdravotnictví nemohou lékaři ověřit, z jakých studií model čerpá doporučení. V právu nelze ověřit, které případy utvářely radu. Tato netransparentnost činí doladěné modely nevhodnými pro aplikace vyžadující auditní stopu či regulatorní soulad. Riziko overfittingu je významné zejména u menších datových sad, kdy si model pamatuje konkrétní příklady místo učení obecných vzorců, což vede ke špatnému výkonu na odlišných případech.

Oblast ladění se rychle vyvíjí a několik zásadních trendů bude formovat její budoucnost. Další rozvoj metod efektivního ladění parametrů slibuje, že ladění bude stále dostupnější, přičemž nové techniky dále snižují výpočetní nároky při zachování či zlepšení výkonu. Výzkum v oblasti few-shot ladění usiluje o dosažení efektivní specializace s minimem označených dat, což by mohlo snížit datovou bariéru bránící širšímu přijetí ladění.

Hybridní přístupy kombinující ladění s RAG získávají na popularitě, protože organizace rozpoznávají, že se tyto techniky doplňují, nikoli konkurují. Model doladěný pro doménovou odbornost může být rozšířen o RAG pro přístup k aktuálním informacím, čímž se kombinují silné stránky obou přístupů. Tato hybridní strategie je stále běžnější v produkčních systémech, zejména v regulovaných odvětvích, kde záleží na specializaci i aktuálnosti informací.

Federované ladění je nastupující oblast, kdy jsou modely laděny na distribuovaných datech bez centralizace citlivých informací, což řeší otázky soukromí ve zdravotnictví, financích a dalších regulovaných sektorech. Průběžné učení umožňující modelům adaptovat se na nové informace bez katastrofického zapomínání by mohlo zásadně změnit způsob údržby doladěných modelů v měnících se doménách. Multimodální ladění přesahující text do obrazu, zvuku či videa umožní přizpůsobovat modely pro stále rozmanitější aplikace.

Integrace ladění s AI monitorovacími platformami jako AmICited je dalším důležitým trendem. Jak firmy nasazují doladěné modely napříč různými AI platformami – včetně ChatGPT, Claude, Perplexity a Google AI Overviews – stává se klíčové sledovat, jak se tyto přizpůsobené modely objevují ve výstupech generovaných AI pro zajištění viditelnosti značky a připisování. Toto propojení ladicí technologie s AI monitoringem odráží dospívání generativní AI od experimentálních projektů k produkčním systémům vyžadujícím komplexní dohled a měření.

+++

Ladění je konkrétní podmnožinou přenosu učení. Zatímco přenos učení obecně označuje využití znalostí z jedné úlohy k vylepšení výkonu u jiné úlohy, ladění konkrétně zahrnuje převzetí předtrénovaného modelu a jeho přeškolení na novou, úlohám přizpůsobenou datovou sadu. Přenos učení je zastřešující koncept a ladění je jednou z implementačních metod. Při ladění se upravují váhy modelu pomocí učení s učitelem na označených příkladech, zatímco přenos učení může zahrnovat různé techniky včetně extrakce příznaků bez dalšího přeškolování.

Požadované množství dat závisí na velikosti modelu a složitosti úlohy, ale obecně se pohybuje od stovek do tisíců označených příkladů. Menší, více zaměřené datové sady s vysoce kvalitními příklady často překonají větší datové sady se špatnou kvalitou nebo nekonzistentním označením. Výzkumy ukazují, že menší množství kvalitních dat je cennější než velké množství dat nízké kvality. U metod efektivního ladění parametrů, jako je LoRA, můžete potřebovat ještě méně dat než u plného ladění.

Katastrofické zapomínání nastává, když v důsledku ladění model ztrácí nebo destabilizuje obecné znalosti získané při předtrénování. K tomu dochází, když je učící rychlost příliš vysoká nebo když je datová sada pro ladění příliš odlišná od původních trénovacích dat, což způsobuje, že model přepíše důležité naučené vzory. Aby se tomu předešlo, používají se při ladění nižší učící rychlosti a techniky jako regularizace, které pomáhají zachovat hlavní schopnosti modelu při adaptaci na nové úlohy.

Metody efektivního ladění parametrů (PEFT), jako je Low-Rank Adaptation (LoRA), snižují výpočetní náročnost tím, že upravují pouze malou část parametrů modelu namísto všech vah. LoRA přidává malé trénovatelné matice do specifických vrstev a původní váhy ponechává zamražené, čímž dosahuje podobného výkonu jako plné ladění při spotřebě o 90 % méně paměti a výpočetních prostředků. Mezi další PEFT metody patří adaptéry, prompt tuning a přístupy založené na kvantizaci, což umožňuje ladění i organizacím bez masivních GPU zdrojů.

Ladění vkládá znalosti přímo do parametrů modelu během trénování, zatímco Retrieval-Augmented Generation (RAG) získává informace z externích databází při dotazu. Ladění vyniká ve specializovaných úlohách a konzistentním formátování výstupů, ale vyžaduje výrazné výpočetní prostředky a zastarává, jakmile se mění informace. RAG umožňuje přístup k aktuálním informacím a snadné aktualizace, ale může poskytovat méně specializované výstupy. Mnoho organizací kombinuje oba přístupy pro dosažení optimálních výsledků.

Instruction tuning je specializovaná forma ladění, která trénuje modely k lepšímu následování uživatelských instrukcí a odpovídání na různé úlohy. Využívá datové sady s páry (instrukce, odpověď) pokrývající různé případy použití, například otázky a odpovědi, sumarizaci a překlad. Standardní ladění obvykle optimalizuje model pro jednu úlohu, zatímco instruction tuning učí model zvládat více typů instrukcí a lépe dodržovat pokyny, což je obzvlášť cenné pro tvorbu univerzálních asistentů.

Ano, doladěné modely lze nasadit na edge zařízeních i v offline prostředích, což je jedna z jejich hlavních výhod oproti přístupům založeným na RAG. Po dokončení ladění obsahuje model ve svých parametrech všechny potřebné znalosti a nepotřebuje přístup k externím datům. To činí doladěné modely ideálními pro mobilní aplikace, vestavěné systémy, IoT zařízení i zabezpečená prostředí bez připojení k internetu, je však třeba zohlednit velikost modelu a výpočetní nároky na zařízeních s omezenými zdroji.

Začněte sledovat, jak AI chatboti zmiňují vaši značku na ChatGPT, Perplexity a dalších platformách. Získejte užitečné informace pro zlepšení vaší AI prezence.

Zjistěte, jak dolaďování AI modelů přizpůsobuje předtrénované modely pro konkrétní úkoly v odvětví a značce, zvyšuje přesnost a zároveň snižuje náklady a výpoče...

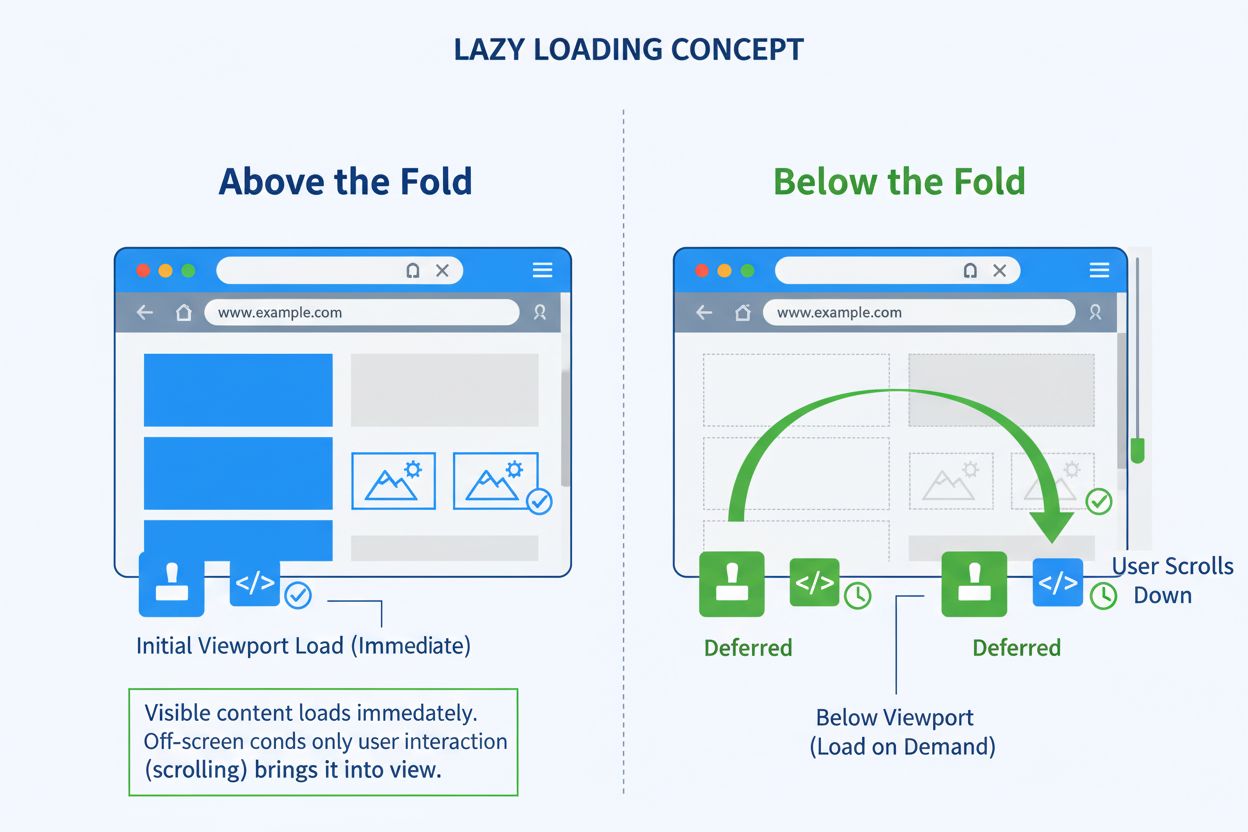

Lazy loading odkládá načítání méně důležitých zdrojů, dokud nejsou potřeba. Zjistěte, jak tato optimalizační technika zlepšuje rychlost stránky, snižuje šířku p...

Zjistěte, jak lazy loading ovlivňuje AI crawlery a odpovědní enginy. Objevte nejlepší postupy, jak zajistit, aby váš obsah zůstal viditelný pro AI systémy a zár...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.