GPTBot

Lær hvad GPTBot er, hvordan den fungerer, og om du bør blokere den fra dit websted. Forstå effekten på SEO, serverbelastning og brandets synlighed i AI-søgeresu...

Lær de vigtigste forskelle mellem GPTBot og OAI-SearchBot crawlere. Forstå deres formål, crawl-adfærd, og hvordan du kan administrere dem for optimal synlighed af dit indhold i AI-søgeresultater.

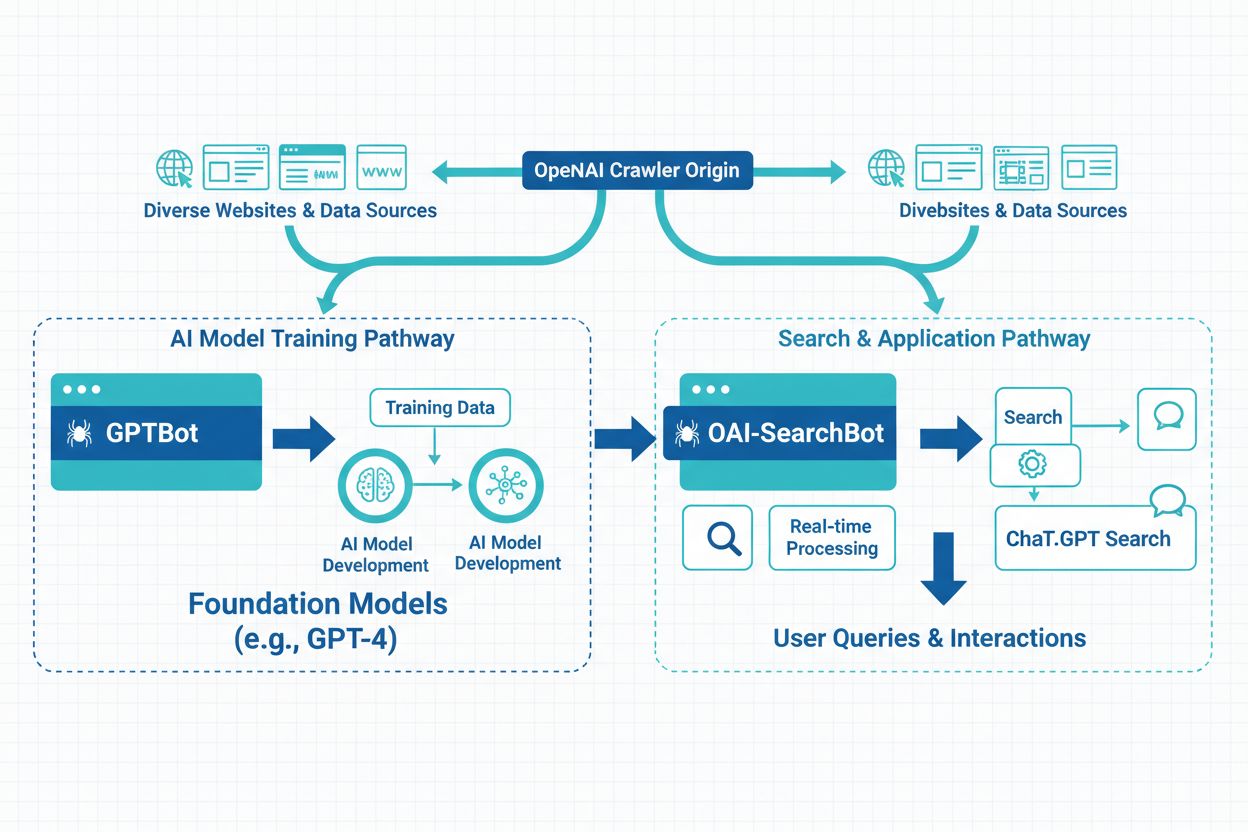

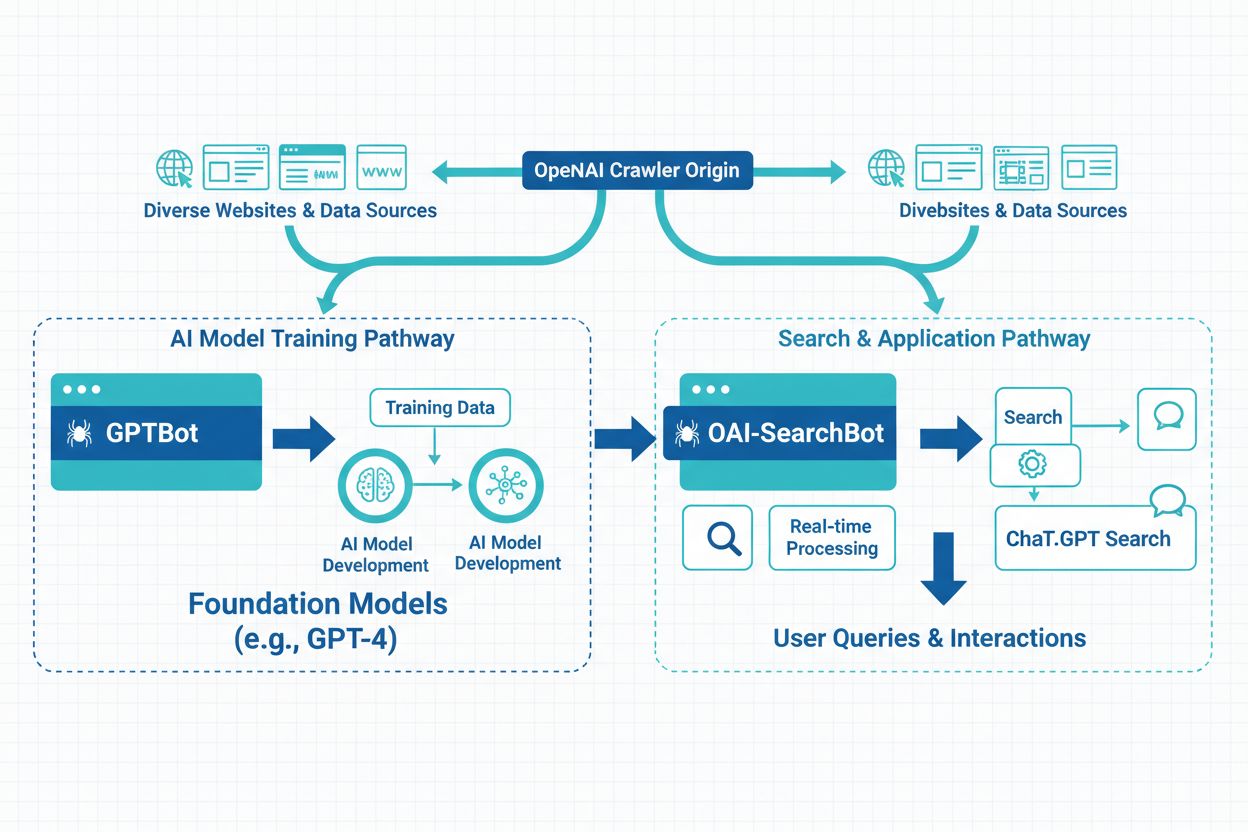

OpenAI driver to forskellige webcrawlere, der tjener forskellige formål i deres økosystem, og det er vigtigt for indholdsskabere og websiteejere at forstå forskellen mellem dem. GPTBot og OAI-SearchBot repræsenterer forskellige tilgange til datainhentning, hvor den ene fokuserer på træning af AI-modeller og den anden er dedikeret til at understøtte søgefunktionalitet. Disse crawlere har forskellige adfærdsmønstre, adgangsmønstre og betydning for dit websites synlighed og dataanvendelse. At vide, hvilken crawler der tilgår dit site, og hvordan du styrer dem, kan have stor betydning for din indholdsstrategi.

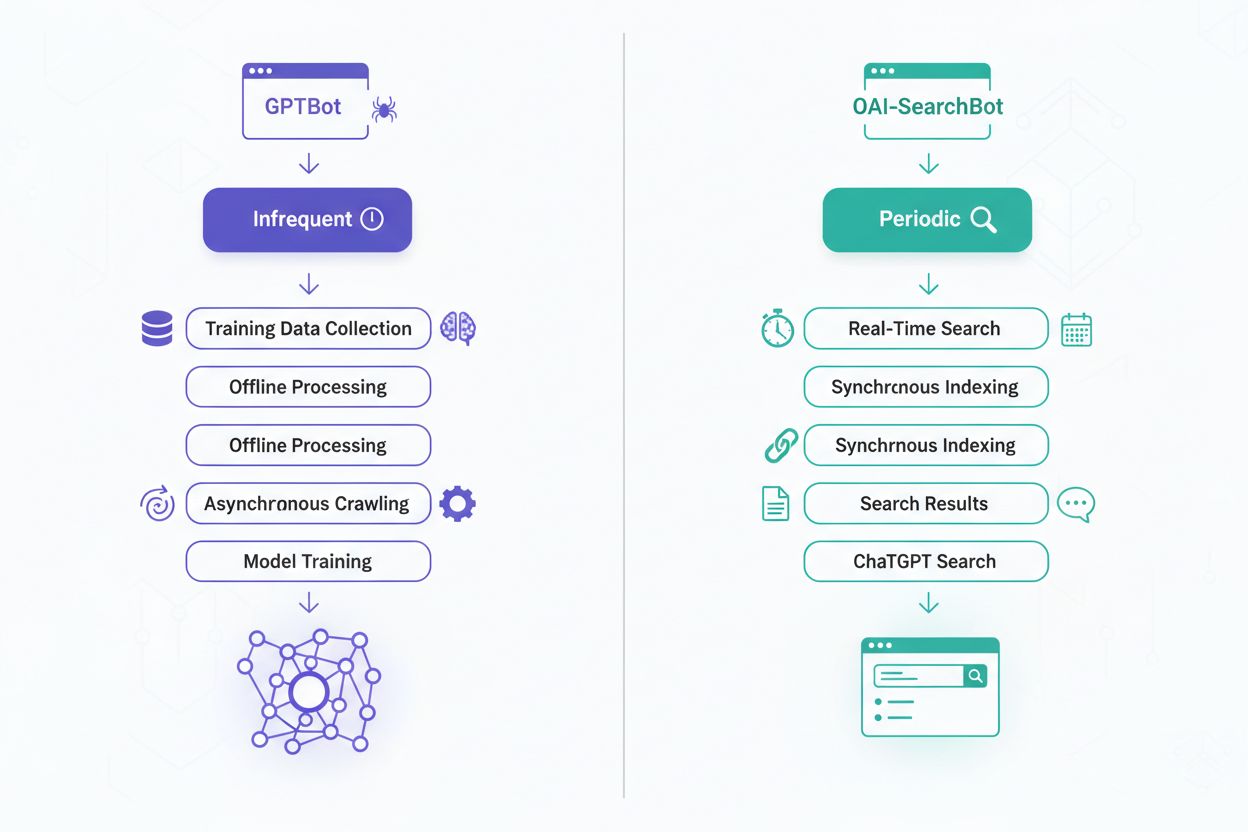

GPTBot er OpenAI’s primære webcrawler, der er designet til at indsamle træningsdata til deres store sprogmodeller, herunder ChatGPT og andre AI-systemer. Den blev lanceret for at forbedre kvaliteten og bredden af træningsdata og crawlersystematisk websites for at samle tekstindhold, der hjælper med at træne og forfine OpenAI’s AI-modeller. Denne crawler opererer under user-agent identifikatoren “GPTBot” og respekterer robots.txt-filen, hvilket gør det muligt for websiteejere at fravælge dataindsamling. GPTBot’s primære mission er at styrke AI-modellers evner ved at lære fra forskelligt, kvalitetsindhold på internettet. Crawleren er designet til at være hensynsfuld over for serverressourcer, mens den grundigt indsamler information, der bidrager til AI-træningsdatasæt. Websiteejere, der ønsker deres indhold inkluderet i fremtidig AI-modeltræning, kan tillade adgang for GPTBot, mens dem, der er bekymrede over dataanvendelse, kan blokere den helt.

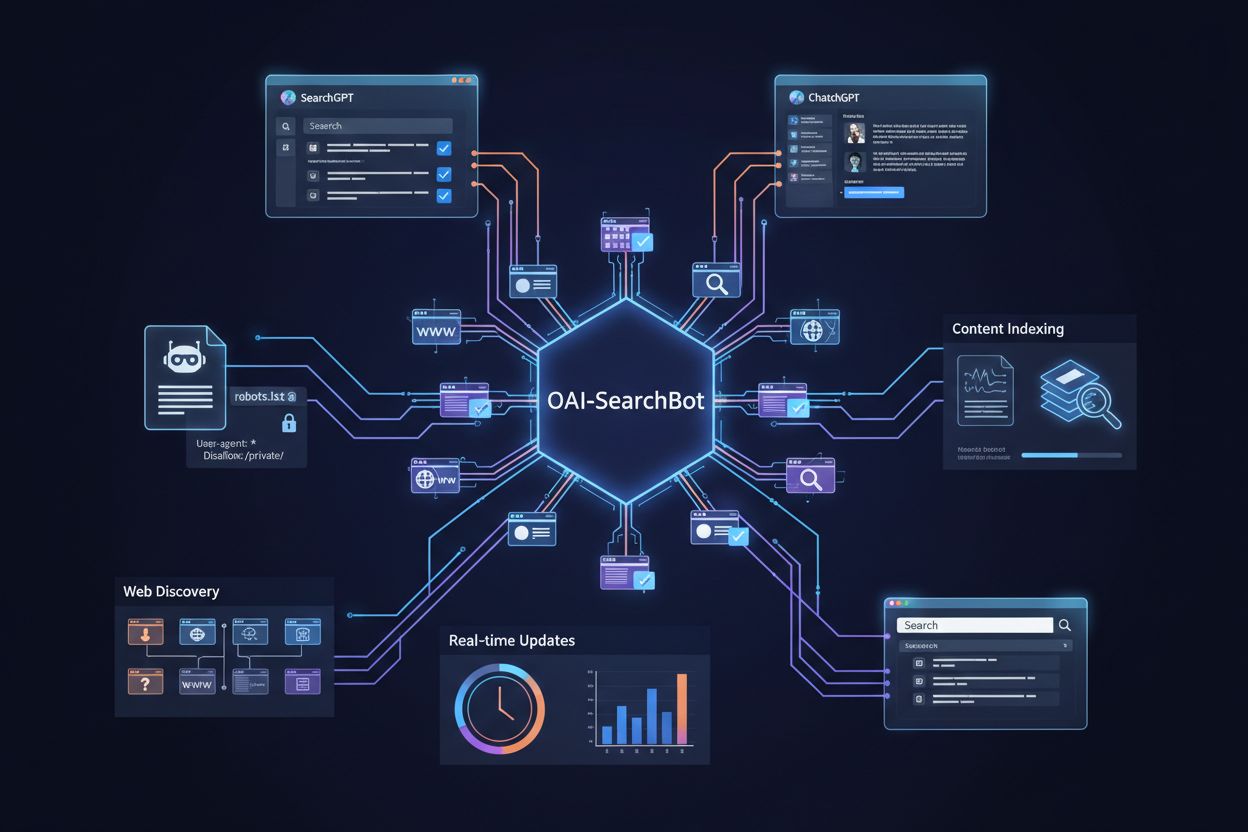

OAI-SearchBot er OpenAI’s specialiserede crawler, der er dedikeret til at understøtte søgefunktionaliteten i ChatGPT og gør det muligt for brugere at søge på nettet direkte fra ChatGPT-interfacet. Denne crawler blev introduceret som en del af ChatGPT’s søgefunktioner og gør det muligt for AI’en at hente realtidsinformation og levere aktuelle, relevante resultater til brugerne. I modsætning til GPTBot fokuserer OAI-SearchBot på at indeksere indhold til øjeblikkelig hentning snarere end til langvarig modeltræning. Crawleren opererer under user-agent identifikatoren “OAI-SearchBot” og respekterer også robots.txt-direktiver, hvilket giver websiteejere kontrol over, om deres indhold vises i ChatGPT’s søgeresultater. OAI-SearchBot’s crawlmønstre er typisk hyppigere og mere målrettede, da den skal vedligeholde opdaterede indekser for realtids-søgefunktionalitet. Denne crawler er essentiel for websites, der ønsker, at deres indhold skal kunne opdages og citeres, når brugere søger i ChatGPT.

Selvom begge crawlere tjener OpenAI’s økosystem, har de forskellige formål, adfærd og betydning for indholdsskabere. At forstå disse forskelle hjælper dig med at træffe informerede beslutninger om, hvilke crawlere du vil tillade eller blokere på dit website. Her er en omfattende sammenligning af de to crawlere:

| Funktion | GPTBot | OAI-SearchBot |

|---|---|---|

| Primært formål | Indsamling af træningsdata til AI-modeller | Realtids-søgeindeksering til ChatGPT |

| User-Agent String | GPTBot | OAI-SearchBot |

| Crawl-frekvens | Periodisk, mindre hyppig | Mere hyppig, kontinuerlige opdateringer |

| Dataanvendelse | Langsigtet modeltræning og forbedring | Øjeblikkelig søgeresultathentning |

| Indholdssynlighed | Påvirker fremtidige AI-modellers evner | Påvirker ChatGPT’s søgeresultatplaceringer |

| Robots.txt support | Ja, respekterer direktiver fuldt ud | Ja, respekterer direktiver fuldt ud |

| Realtidskrav | Nej, batchbehandling er acceptabel | Ja, kræver aktuelle indekser |

Den grundlæggende forskel mellem disse crawlere ligger i deres operationelle mål og hvordan de bruger de indsamlede data. GPTBot er designet med et langsigtet perspektiv, hvor den indsamler forskelligt indhold for at forbedre AI-modellers træning over måneder og år, hvilket bidrager til bedre sprogforståelse og generering. OAI-SearchBot arbejder derimod i realtid og vedligeholder friske indekser, så ChatGPT-brugere kan få aktuelle informationer, når de søger efter nyheder, begivenheder eller tidssensitive emner. GPTBot’s dataindsamling er mere omfattende og udforskende med det formål at indfange bredden af menneskelig viden og skrivestile. OAI-SearchBot’s tilgang er mere målrettet og effektiv, hvor indholdsrelevans og aktualitet prioriteres ved søgeforespørgsler. Konsekvenserne er væsentlige: at tillade GPTBot betyder, at dit indhold bidrager til AI-modeludvikling, mens tilladelse til OAI-SearchBot sikrer, at dit indhold kan opdages og citeres i ChatGPT’s søgeresultater. Mange websites vælger forskellige strategier for hver crawler afhængigt af indholdstype og forretningsmål.

GPTBot arbejder efter en periodisk crawlplan og besøger websites med intervaller, der kan spænde over uger eller måneder afhængigt af opdateringsfrekvensen og websitets betydning. Denne crawler er designet til at være effektiv med båndbredde og serverressourcer, da den ikke har brug for realtidsdata til træningsformål. Crawl-dybden og -bredden er typisk omfattende, da GPTBot søger at indfange forskellige indholdstyper og skrivestile til modeltræning. OAI-SearchBot, derimod, har en mere aggressiv crawlplan med hyppige genbesøg for at sikre, at søgeindekserne forbliver opdaterede og korrekte. Denne crawler prioriterer nyligt opdateret indhold og trends og laver flere gennemgange af populære eller ofte opdaterede websites. Forskellen i frekvens afspejler deres forskellige formål: GPTBot kan tillade sig at være tålmodig og grundig, mens OAI-SearchBot skal være synkroniseret med det hurtigt skiftende web for at levere relevante søgeresultater.

Hvis du tillader GPTBot adgang, bliver dit indhold en del af træningsdataene for fremtidige AI-modeller og kan potentielt påvirke, hvordan AI-systemer forstår og genererer indhold, der relaterer sig til dine emner. Det kan have langsigtede fordele, da din skrivestil, ekspertise og unikke perspektiver er med til at forme AI’s svar inden for dit område. Det betyder dog også, at dit indhold bruges til at træne systemer, der muligvis kan konkurrere med dit originale arbejde. OAI-SearchBot-adgang har direkte betydning for din synlighed i ChatGPT’s søgeresultater, hvilket gør dit indhold synligt for millioner af ChatGPT-brugere, der søger information. Når brugere finder dit indhold via ChatGPT-søgning, kan det generere betydelig trafik og etablere dit site som en autoritativ kilde. Synlighedseffekten er forskellig: GPTBot påvirker din indflydelse på AI-udvikling, mens OAI-SearchBot påvirker din umiddelbare opdagelighed og trafikpotentiale. Indholdsskabere skal afveje disse overvejelser ud fra deres mål, uanset om de prioriterer deltagelse i AI-træning eller søgeresultatsynlighed.

Både GPTBot og OAI-SearchBot respekterer robots.txt-filen, hvilket giver websiteejere fuld kontrol over crawler-adgang gennem standard webprotokoller. Du kan blokere enten eller begge crawlere ved at tilføje specifikke direktiver til din robots.txt-fil, eller du kan tillade dem, mens du blokerer andre crawlere. Denne fleksibilitet muliggør nuancerede indholdsstrategier, hvor du måske tillader den ene crawler og blokerer den anden, afhængigt af dine specifikke behov og bekymringer. OpenAI har også udgivet officiel dokumentation og retningslinjer til styring af disse crawlere, hvilket gør det nemt at implementere dine ønskede adgangspolitikker. Robots.txt-metoden er gennemsigtig og følger etablerede webstandarder, hvilket sikrer kompatibilitet med andre værktøjer og overvågningssystemer. Her er almindelige robots.txt-konfigurationer til håndtering af OpenAI-crawlere:

User-agent: GPTBot og User-agent: OAI-SearchBot med Disallow: /User-agent: GPTBot med Disallow: / og tillad OAI-SearchBotUser-agent: OAI-SearchBot med Disallow: / og tillad GPTBotDisallow: /private/ for at blokere crawlere fra følsomme sektionerCrawl-delay: 10 for at begrænse crawl-frekvens og serverbelastningFor at verificere at OpenAI’s crawlere rent faktisk tilgår dit website, skal du undersøge serverlogs og lede efter de specifikke user-agent-strenge. Du kan identificere GPTBot-forespørgsler ved at søge efter “GPTBot” og OAI-SearchBot-forespørgsler ved at søge efter “OAI-SearchBot” i dine adgangslogs. Mange websiteejere bruger loganalyseværktøjer eller webanalyseplatforme, der kan filtrere og rapportere om specifik crawler-aktivitet. Overvågning af crawler-adfærd hjælper dig med at forstå, om dine robots.txt-direktiver fungerer korrekt, og om crawlerne respekterer dine adgangspolitikker. Regelmæssig overvågning afslører også crawl-mønstre og -frekvens, hvilket hjælper dig med at optimere dine serverressourcer og forstå påvirkningen af din infrastruktur. Derudover kan du verificere crawler-IP-adresser mod OpenAI’s offentlige IP-ranges for at sikre, at forespørgslerne er legitime og ikke forfalskede af ondsindede aktører.

Din beslutning om at tillade eller blokere disse crawlere bør være i tråd med din indholdsstrategi og forretningsmål. Hvis dit primære mål er at generere trafik og synlighed, giver det mening at tillade OAI-SearchBot, da det direkte påvirker opdagelighed i ChatGPT’s søgeresultater. Hvis du er bekymret for brugen af dine data til AI-træning eller foretrækker at bevare eksklusiv kontrol over dit indhold, beskytter blokering af GPTBot din intellektuelle ejendom mod at blive brugt til modeltræning. Nogle websites vælger en hybrid tilgang, hvor de tillader OAI-SearchBot for søgeresultatsynlighed, men blokerer GPTBot for at forhindre dataindsamling til træning. Overvej din indholdstype: nyhedsmedier og aktuelle sites får mest ud af OAI-SearchBot-adgang, mens producenter af proprietært eller følsomt indhold måske foretrækker at blokere begge. Beslutningen er ikke permanent—du kan til enhver tid ændre din robots.txt-fil og dermed dine crawler-adgangspolitikker. Ved løbende at gennemgå din crawler-strategi sikrer du, at den fortsat stemmer overens med dine forretningsmål og indholdsprioriteter.

AmICited tilbyder omfattende crawler-overvågningsløsninger, der hjælper dig med at spore både GPTBot og OAI-SearchBot-aktivitet på dit website med detaljerede analyser og indsigter. Platformen giver realtidsnotifikationer, når disse crawlere tilgår dit indhold, så du kan verificere overholdelse af dine robots.txt-direktiver og overvåge crawl-mønstre. Med AmICited får du indsigt i, hvordan dit indhold bliver indekseret og brugt af OpenAI’s systemer, hvilket gør det muligt for dig at træffe databaserede beslutninger om dine crawler-adgangspolitikker. Denne overvågningsløsning gør det nemt at forstå dit indholds rolle i AI-træning og søgeindeksering og giver dig den kontrol og gennemsigtighed, du har brug for i det hastigt udviklende AI-landskab.

GPTBot er OpenAI's træningscrawler, der indsamler data til AI-modeludvikling og arbejder efter en periodisk tidsplan med langsigtede mål. OAI-SearchBot er OpenAI's søgecrawler, der vedligeholder realtidsindekser til ChatGPT's søgefunktion. Selvom begge respekterer robots.txt, tjener de forskellige formål og har forskellige crawl-frekvenser og betydning for dit indholds synlighed.

Beslutningen afhænger af din indholdsstrategi og dine forretningsmål. Tillad OAI-SearchBot, hvis du ønsker, at dit indhold kan findes i ChatGPT's søgeresultater og ønsker at tiltrække trafik. Bloker GPTBot, hvis du er bekymret for, at dit indhold bruges i AI-modeltræning. Mange websites benytter en hybrid tilgang, hvor de tillader den ene og blokerer den anden ud fra deres specifikke behov.

Søg i dine serveradgangslogs efter user-agent-strengene 'GPTBot' og 'OAI-SearchBot'. De fleste webanalyseplatforme og loganalyseværktøjer gør det muligt at filtrere på user-agent, hvilket gør det nemt at identificere og overvåge crawler-aktivitet. Du kan også verificere crawler-IP-adresser mod OpenAI's offentlige IP-ranges for at sikre, at forespørgslerne er legitime.

Nej, blokering af GPTBot og OAI-SearchBot er uafhængige handlinger. Du kan blokere begge, tillade begge eller blokere den ene og tillade den anden ved at bruge separate robots.txt-direktiver. Hver crawler respekterer sine egne user-agent-regler, så dine adgangspolitikker for én crawler gælder ikke automatisk for den anden.

GPTBot arbejder efter en periodisk crawlplan og besøger websites med intervaller, der kan spænde over uger eller måneder afhængig af indholdsaktualitet og websitets betydning. OAI-SearchBot har en mere hyppig crawlplan for at holde søgeresultaterne opdaterede og korrekte. Frekvensforskellen afspejler deres forskellige formål: GPTBot prioriterer grundighed, mens OAI-SearchBot prioriterer aktualitet.

Hvis du tillader OAI-SearchBot, kan det øge trafikken til dit website, når brugere finder og klikker gennem ChatGPT's søgeresultater. Effekten varierer afhængigt af indholdstype og relevans for brugernes forespørgsler. Nyheder, aktuelle emner og informativt indhold oplever typisk mere trafik fra AI-søgning, mens nichepræget eller specialiseret indhold kan opleve mindre umiddelbar effekt.

Ja, du kan bruge robots.txt til at blokere specifikke mapper eller filtyper for GPTBot og OAI-SearchBot. For eksempel kan du bruge 'Disallow: /private/' for at blokere crawlere fra følsomme sektioner, mens du tillader adgang til offentligt indhold. Denne granulære kontrol gør det muligt at beskytte følsomme oplysninger og samtidig bevare synlighed i AI-søgeresultater.

AmICited tilbyder realtids-overvågning og analyser af både GPTBot og OAI-SearchBot-aktivitet på dit website. Platformen sporer crawlerbesøg, verificerer robots.txt-overholdelse og giver indsigt i, hvordan dit indhold bliver indekseret og brugt af OpenAI's systemer. Det giver dig den gennemsigtighed og kontrol, der er nødvendig for at træffe informerede beslutninger om dine crawler-adgangspolitikker.

Følg hvordan GPTBot og OAI-SearchBot tilgår dit indhold med realtidsindsigt og analyser. Forstå dit indholds rolle i AI-træning og søgeindeksering.

Lær hvad GPTBot er, hvordan den fungerer, og om du bør blokere den fra dit websted. Forstå effekten på SEO, serverbelastning og brandets synlighed i AI-søgeresu...

Lær hvad GPTBot er, hvordan det fungerer, og om du bør tillade eller blokere OpenAI's webcrawler. Forstå indflydelsen på dit brands synlighed i AI-søgemaskiner ...

Lær hvad OAI-SearchBot er, hvordan den fungerer, og hvordan du optimerer dit website til OpenAI's dedikerede søgecrawler, der bruges af SearchGPT og ChatGPT.

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.