Listikler og AI: Hvorfor nummererede lister bliver citeret

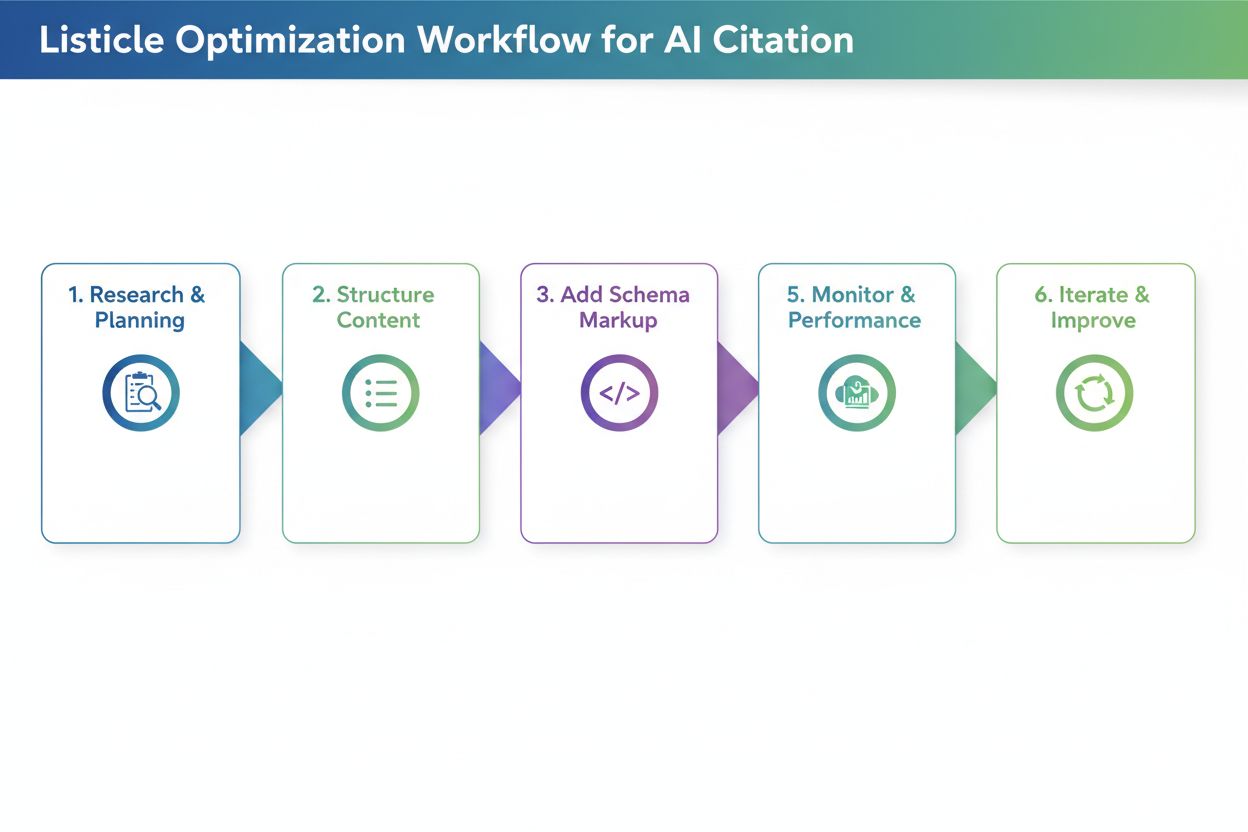

Opdag hvorfor AI-modeller foretrækker listikler og nummererede lister. Lær hvordan du optimerer listebaseret indhold for ChatGPT-, Gemini- og Perplexity-citater...

Lær hvordan du optimerer overskrifthierarki til LLM-tolkning. Mestre H1-, H2-, H3-struktur for at forbedre AI-synlighed, citationer og indholdsopdagelse på tværs af ChatGPT, Perplexity og Google AI Overviews.

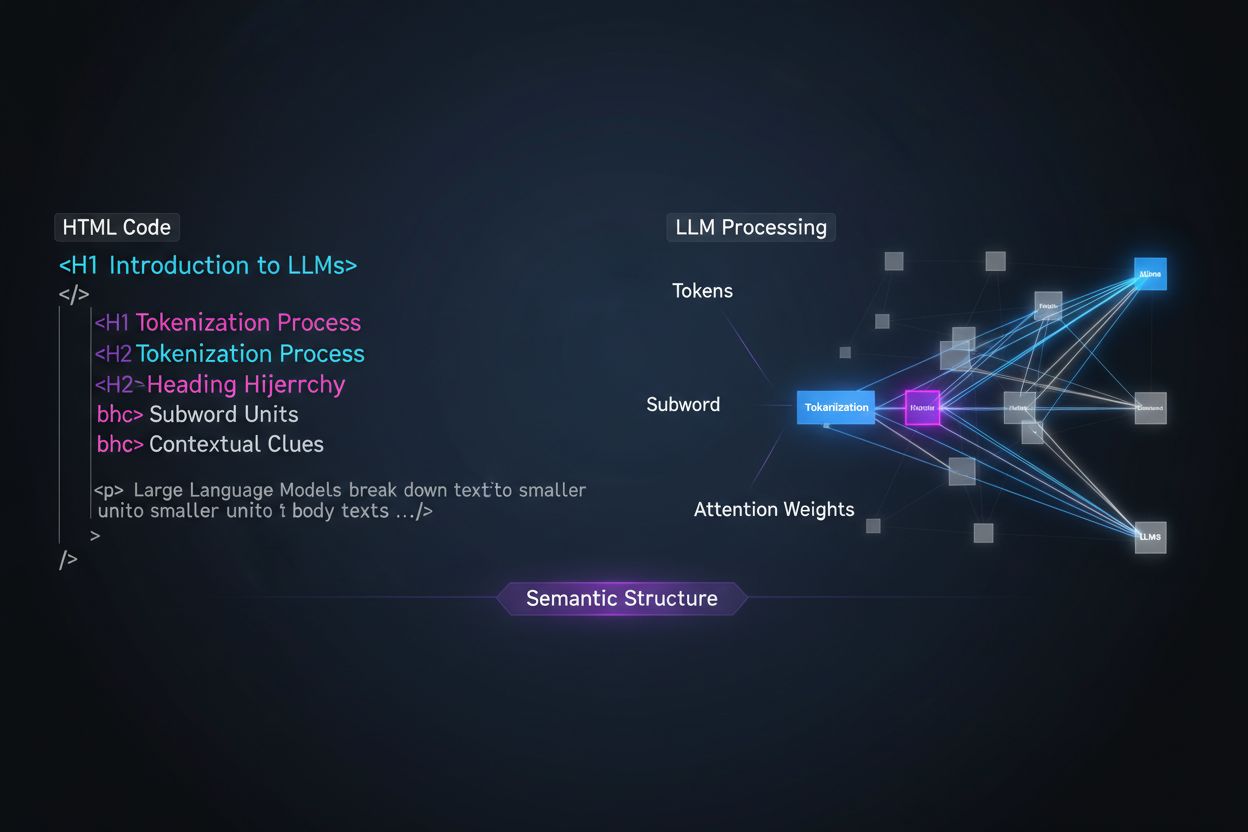

Store sprogmodeller behandler indhold grundlæggende anderledes end menneskelige læsere, og forståelsen af denne forskel er afgørende for at optimere din indholdsstrategi. Hvor mennesker skimmer sider visuelt og intuitivt opfatter dokumentstruktur, er LLM’er afhængige af tokenisering og opmærksomhedsmekanismer for at tolke betydning fra sekventiel tekst. Når en LLM møder dit indhold, opdeler den det i tokens (små tekststykker) og tildeler opmærksomhedsvægte til forskellige sektioner baseret på strukturelle signaler—og overskrifthierarki fungerer som et af de stærkeste strukturelle signaler, der findes. Uden klar overskriftsorganisering har LLM’er svært ved at identificere de primære emner, understøttende argumenter og kontekstuelle relationer i dit indhold, hvilket fører til mindre præcise svar og reduceret synlighed i AI-drevne søge- og genfindingssystemer.

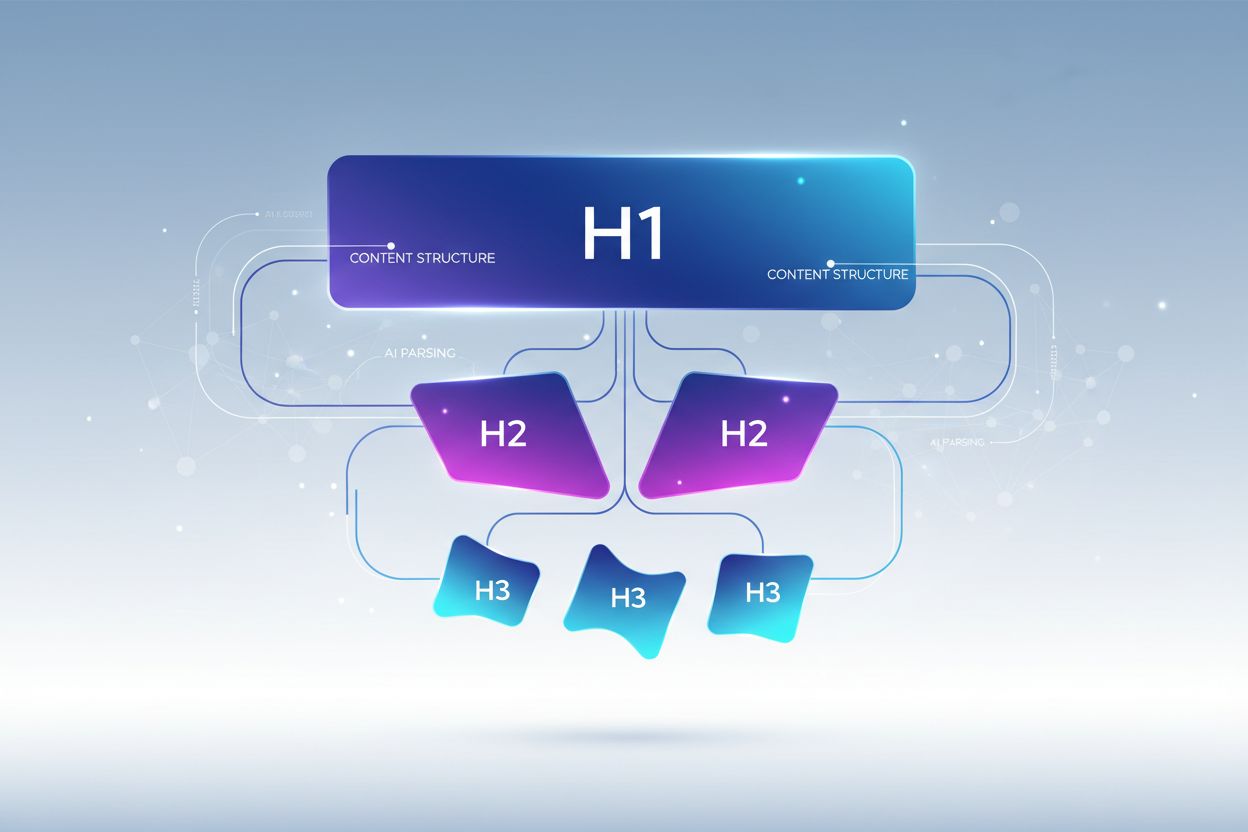

Moderne indholds-chunking-strategier i retrieval-augmented generation (RAG)-systemer og AI-søgemaskiner er stærkt afhængige af overskriftsstruktur for at bestemme, hvor dokumenter skal opdeles i hentbare segmenter. Når en LLM møder velorganiserede overskrifthierarkier, bruger den H2- og H3-grænser som naturlige skillelinjer til at skabe semantiske chunks—afgrænsede informationsenheder, der kan hentes og citeres uafhængigt. Denne proces er langt mere effektiv end vilkårlig opdeling på tegnantal, fordi overskriftsbaserede chunks bevarer semantisk sammenhæng og kontekst. Overvej forskellen mellem to tilgange:

| Approach | Chunk Kvalitet | LLM-citationsrate | Retrieval-nøjagtighed |

|---|---|---|---|

| Semantisk Rig (Overskriftsbaseret) | Høj sammenhæng, hele tanker | 3x højere | 85%+ nøjagtighed |

| Generisk (Tegnantal) | Fragmenteret, ufuldstændig kontekst | Basisniveau | 45-60% nøjagtighed |

Forskning viser, at dokumenter med klare overskrifthierarkier oplever 18-27% forbedring i spørgsmålsbesvarelsesnøjagtighed, når de behandles af LLM’er, primært fordi chunking-processen bevarer de logiske relationer mellem ideer. Systemer som Retrieval-Augmented Generation (RAG)-pipelines, der driver værktøjer som ChatGPT’s browsing-funktion og virksomheds-AI-systemer, leder eksplicit efter overskriftsstrukturer for at optimere deres hentningssystemer og forbedre citationsnøjagtigheden.

Korrekt overskrifthierarki følger en streng indlejret struktur, der afspejler, hvordan LLM’er forventer, at information organiseres, hvor hvert niveau har en særskilt rolle i din indholdsarkitektur. H1-tagget repræsenterer dit dokuments primære emne—der bør kun være én pr. side, og den skal klart angive hovedtemaet. H2-tags repræsenterer større emneopdelinger, der støtter eller uddyber H1, hvor hver H2 adresserer et særskilt aspekt af hovedemnet. H3-tags går dybere ned i specifikke underemner under hver H2-sektion og leverer detaljer og svar på opfølgende spørgsmål. Den kritiske regel for LLM-optimering er, at du aldrig må springe niveauer over (for eksempel fra H1 direkte til H3) og skal opretholde ensartet indlejring—hver H3 skal høre til en H2, og hver H2 til en H1. Denne hierarkiske struktur skaber det, forskere kalder et “semantisk træ,” som LLM’er kan gennemgå for at forstå dit indholds logiske flow og udtrække relevante informationer præcist.

Den mest effektive overskriftsstrategi for LLM-synlighed behandler hver H2-overskrift som et direkte svar på en specifik brugerintention eller et spørgsmål, med H3-overskrifter som underopdelte spørgsmål, der leverer understøttende detaljer. Denne “svar-først”-tilgang stemmer overens med, hvordan moderne LLM’er henter og syntetiserer information—de leder efter indhold, der direkte adresserer brugerforespørgsler, og overskrifter, der klart angiver svar, har langt større sandsynlighed for at blive udvalgt og citeret. Hver H2 skal fungere som en svarenhed, et selvstændigt svar på et konkret spørgsmål, en bruger kunne stille om dit emne. Hvis din H1 for eksempel er “Sådan optimerer du webstedets ydeevne”, kan dine H2’ere være “Reducer billedfilstørrelser (forbedrer indlæsningstiden med 40%)” eller “Implementer browser-caching (mindsker serveranmodninger med 60%)"—hver overskrift besvarer direkte et bestemt performance-spørgsmål. H3’erne under hver H2 adresserer opfølgende spørgsmål: under “Reducer billedfilstørrelser” kan du have H3’ere som “Vælg det rigtige billedformat”, “Komprimer uden at miste kvalitet” og “Implementer responsive billeder”. Denne struktur gør det dramatisk lettere for LLM’er at identificere, udtrække og citere dit indhold, fordi selve overskrifterne indeholder svarene, ikke kun emneetiketter.

At forvandle din overskriftsstrategi for at maksimere LLM-synlighed kræver, at du implementerer specifikke, handlingsorienterede teknikker, der går ud over basal struktur. Her er de mest effektive optimeringsmetoder:

Brug beskrivende, specifikke overskrifter: Udskift vage titler som “Oversigt” eller “Detaljer” med specifikke beskrivelser som “Hvordan maskinlæring forbedrer anbefalingsnøjagtighed” eller “Tre faktorer, der påvirker søgerangeringer”. Forskning viser, at specifikke overskrifter øger LLM-citationsraten op til 3x sammenlignet med generiske titler.

Implementer spørgsmålsformede overskrifter: Strukturér H2’ere som direkte spørgsmål, brugerne stiller (“Hvad er semantisk søgning?” eller “Hvorfor er overskrifthierarki vigtigt?”). LLM’er er trænet på Q&A-data og prioriterer naturligt spørgsmålsformede overskrifter, når de henter svar.

Inkluder enhedsklarhed i overskrifter: Når du omtaler specifikke koncepter, værktøjer eller enheder, nævn dem eksplicit i dine overskrifter frem for at bruge pronominer eller vage referencer. For eksempel er “PostgreSQL-ydeevneoptimering” langt mere LLM-venlig end “Databaseoptimering”.

Undgå at kombinere flere intentioner: Hver overskrift bør adressere et enkelt, fokuseret emne. Overskrifter som “Installation, konfiguration og fejlfinding” udvander semantisk klarhed og forvirrer LLM-chunking-algoritmer.

Tilføj kvantificerbar kontekst: Når det er relevant, inkluder tal, procenter eller tidshorisonter i overskrifter (“Reducer indlæsningstiden med 40% via billedoptimering” vs. “Billedoptimering”). Studier viser, at 80% af LLM-citeret indhold indeholder kvantificerbar kontekst i overskrifter.

Brug parallel struktur på tværs af niveauer: Oprethold ensartet grammatisk struktur på H2- og H3-niveau inden for samme sektion. Hvis én H2 starter med et verbum (“Implementer caching”), bør andre også (“Konfigurer databaseindekser”, “Optimer forespørgsler”).

Inkluder nøgleord naturligt: Selvom det ikke kun er for SEO, hjælper relevante nøgleord i overskrifter LLM’er med at forstå emnerelevans og forbedrer hentningsnøjagtigheden med 25-35%.

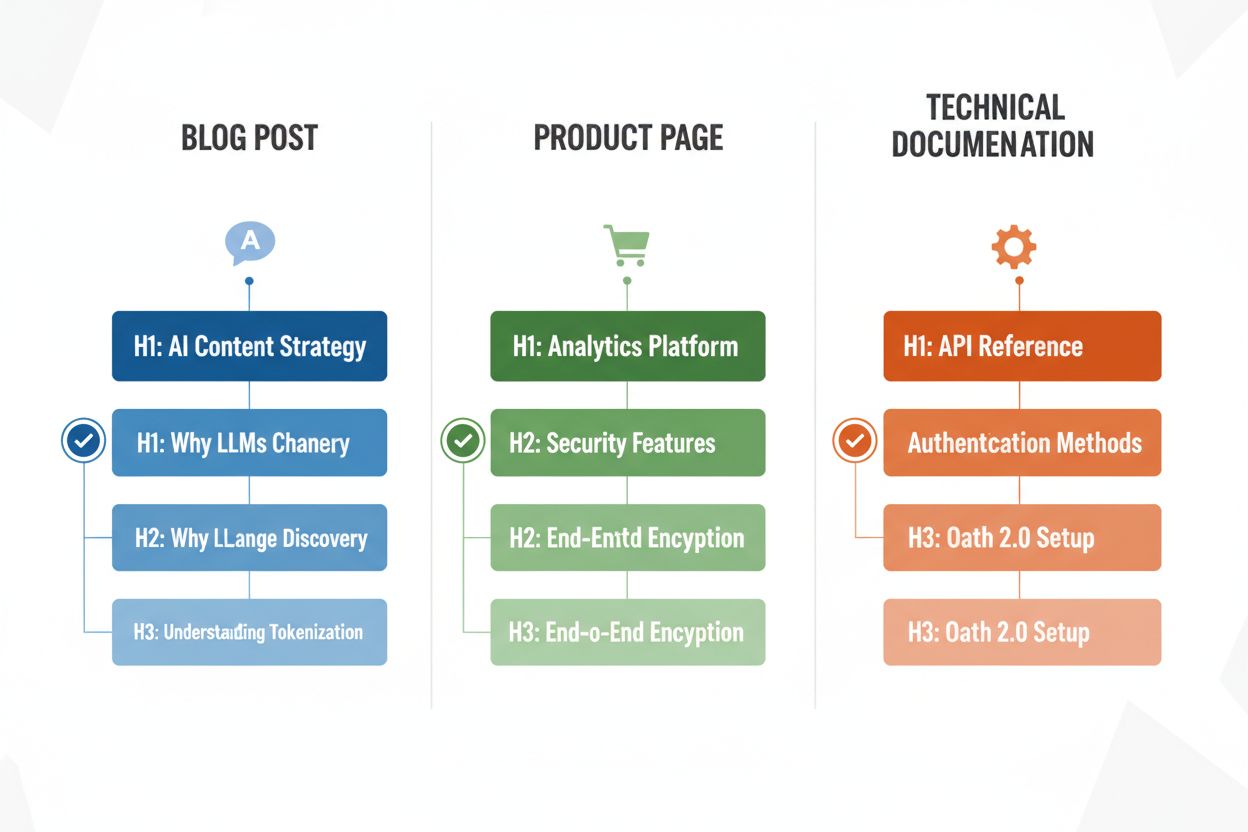

Forskellige indholdstyper kræver tilpassede overskriftsstrategier for at maksimere LLM-tolknings-effektivitet, og forståelse af disse mønstre sikrer, at dit indhold er optimeret uanset format. Blogindlæg drager fordel af fortællingsdrevne overskrifthierarkier, hvor H2’ere følger en logisk progression gennem et argument eller en forklaring, og H3’ere leverer beviser, eksempler eller dybere udforskning—for eksempel kan et indlæg om “AI-indholdsstrategi” bruge H2’ere som “Hvorfor LLM’er ændrer indholdsopdagelse”, “Sådan optimeres for AI-synlighed” og “Mål din AI-indholdsperformance”. Produktsider bør bruge H2’ere, der direkte matcher brugerbekymringer og beslutningsfaktorer (“Sikkerhed og compliance”, “Integrationsmuligheder”, “Pris og skalerbarhed”), med H3’ere om specifikke spørgsmål til funktioner eller anvendelser. Teknisk dokumentation kræver den mest detaljerede overskriftsstruktur, hvor H2’ere repræsenterer hovedfunktioner eller arbejdsgange og H3’ere beskriver specifikke opgaver, parametre eller konfigurationsmuligheder—denne struktur er kritisk, fordi dokumentation ofte citeres af LLM’er, når brugere stiller tekniske spørgsmål. FAQ-sider bør bruge H2’ere som de faktiske spørgsmål (formateret som spørgsmål) og H3’ere til opfølgende afklaringer eller relaterede emner, da denne struktur passer perfekt til, hvordan LLM’er henter og præsenterer Q&A-indhold. Hver indholdstype har forskellige brugerintentioner, og dit overskrifthierarki skal afspejle disse for at maksimere relevans og citationssandsynlighed.

Når du har omstruktureret dine overskrifter, er validering afgørende for at sikre, at de faktisk forbedrer LLM-tolkning og synlighed. Den mest praktiske tilgang er at teste dit indhold direkte med AI-værktøjer som ChatGPT, Perplexity eller Claude ved at uploade dit dokument eller indsætte en URL og stille spørgsmål, som dine overskrifter er designet til at besvare. Vær opmærksom på, om AI-værktøjet korrekt identificerer og citerer dit indhold, og om det udtrækker de rigtige sektioner—hvis din H2 om “Reducering af indlæsningstid” ikke bliver citeret, når brugere spørger om performanceoptimering, skal overskriften muligvis forbedres. Du kan også bruge specialiserede værktøjer som SEO-platforme med AI-citationstracking (såsom Semrush eller Ahrefs’ nyere AI-funktioner) til at overvåge, hvor ofte dit indhold optræder i LLM-svar over tid. Iterér baseret på resultater: hvis visse sektioner ikke bliver citeret, eksperimentér med mere specifikke eller spørgsmålsformede overskrifter, tilføj kvantificerbar kontekst, eller tydeliggør forbindelsen mellem din overskrift og almindelige brugerforespørgsler. Denne testcyklus tager typisk 2-4 uger at give målbare resultater, da det tager tid for AI-systemerne at genindeksere og genvurdere dit indhold.

Selv velmenende indholdsskabere begår ofte overskriftsfejl, der markant reducerer LLM-synlighed og tolkningsnøjagtighed. En af de mest almindelige fejl er at kombinere flere intentioner i én overskrift—for eksempel tvinger “Installation, konfiguration og fejlfinding” LLM’er til at vælge, hvilket emne sektionen omhandler, hvilket ofte fører til forkert chunking og lavere citationssandsynlighed. Vage, generiske overskrifter som “Oversigt”, “Vigtige punkter” eller “Yderligere information” giver ingen semantisk klarhed og gør det umuligt for LLM’er at forstå, hvilken specifik information sektionen indeholder; når en LLM støder på disse overskrifter, springer den ofte sektionen helt over eller fejltolker dens relevans. Manglende kontekst er en anden kritisk fejl—en overskrift som “Bedste praksis” fortæller ikke en LLM, hvilket domæne eller emne praksisserne gælder for, hvorimod “Bedste praksis for API-rate-limiting” er umiddelbart klart og kan hentes. Inkonsekvent hierarki (springe niveauer over, bruge H4 uden H3 eller blande overskriftsstile) forvirrer LLM-tolkningsalgoritmer, fordi de er afhængige af ensartede strukturelle mønstre for at forstå dokumentorganisation. For eksempel skaber et dokument, der bruger H1 → H3 → H2 → H4, uklarhed om, hvilke sektioner der hænger sammen, og hvilke der er uafhængige, hvilket reducerer hentningsnøjagtigheden med 30-40%. At teste dit indhold med ChatGPT eller lignende værktøjer vil hurtigt afsløre disse fejl—hvis AI’en har svært ved at forstå din indholdsstruktur eller citerer de forkerte sektioner, skal dine overskrifter sandsynligvis revideres.

Optimering af overskrifthierarki til LLM-tolkning skaber en stærk sekundær fordel: forbedret tilgængelighed for brugere med handicap. Semantisk HTML-overskriftsstruktur (korrekt brug af H1-H6-tags) er grundlæggende for skærmlæserfunktionalitet, så synshæmmede brugere effektivt kan navigere i dokumenter og forstå indholdsorganisationen. Når du laver klare, beskrivende overskrifter optimeret til LLM-tolkning, skaber du samtidig bedre navigation for skærmlæsere—den samme specificitet og klarhed, der hjælper LLM’er med at forstå dit indhold, hjælper også hjælpemiddelteknologier med at guide brugere igennem det. Denne sammenhæng mellem AI-optimering og tilgængelighed er et sjældent win-win: De tekniske krav til LLM-venligt indhold understøtter direkte WCAG-tilgængelighedsstandarder og forbedrer oplevelsen for alle brugere. Organisationer, der prioriterer overskrifthierarki for AI-synlighed, ser ofte uventede forbedringer i tilgængelighedskompliancescorer og brugertilfredshedsmetrikker fra brugere, der er afhængige af hjælpemidler.

Implementering af forbedringer i overskrifthierarki kræver måling for at retfærdiggøre indsatsen og identificere, hvad der virker. Den mest direkte KPI er LLM-citationsrate—følg hvor ofte dit indhold optræder i svar fra ChatGPT, Perplexity, Claude og andre AI-værktøjer ved regelmæssigt at stille relevante spørgsmål og logge, hvilke kilder der citeres. Værktøjer som Semrush, Ahrefs og nyere platforme som Originality.AI tilbyder nu LLM-citationstracking, der overvåger din synlighed i AI-genererede svar over tid. Du bør forvente at se en 2-3x stigning i citationer inden for 4-8 uger efter implementering af korrekt overskrifthierarki, selvom resultater varierer efter indholdstype og konkurrence. Udover citationer, følg organisk trafik fra AI-drevne søgefunktioner (Google AI Overviews, Bing Chat-citationer osv.) separat fra traditionel organisk søgning, da disse ofte viser hurtigere forbedring med overskriftsoptimering. Overvåg desuden engagement-metrics for indhold som tid på siden og scroll-dybde for sider med optimerede overskrifter—bedre struktur øger typisk engagement med 15-25%, fordi brugere nemmere kan finde relevant information. Endelig, mål hentningsnøjagtighed i dine egne systemer, hvis du bruger RAG-pipelines eller interne AI-værktøjer, ved at teste, om de rigtige sektioner hentes til almindelige forespørgsler. Disse metrics dokumenterer samlet set ROI for overskriftsoptimering og guider løbende tilpasning af din indholdsstrategi.

Overskrifthierarki påvirker primært AI-synlighed og LLM-citationer frem for traditionelle Google-rangeringer. Korrekt overskriftsstruktur forbedrer dog den overordnede indholdskvalitet og læsbarhed, hvilket indirekte understøtter SEO. Den største fordel er øget synlighed i AI-drevne søgeresultater som Google AI Overviews, ChatGPT og Perplexity, hvor overskriftsstruktur er afgørende for indholdsekstraktion og citation.

Ja, hvis dine nuværende overskrifter er vage eller ikke følger et klart H1→H2→H3-hierarki. Start med at revidere dine bedst præsterende sider og implementer overskriftsforbedringer på indhold med høj trafik først. Den gode nyhed er, at LLM-venlige overskrifter også er mere brugervenlige, så ændringerne gavner både mennesker og AI-systemer.

Absolut. Faktisk fungerer de bedste overskriftsstrukturer godt for begge. Klare, beskrivende, hierarkiske overskrifter, der hjælper mennesker med at forstå indholdsorganisationen, er præcis det, LLM'er har brug for til at tolke og opdele indhold. Der er ingen konflikt mellem menneskevenlige og LLM-venlige overskriftspraksisser.

Der er ingen streng grænse, men sigt efter 3-7 H2'ere pr. side afhængigt af indholdets længde og kompleksitet. Hver H2 bør repræsentere et særskilt emne eller svarenhed. Under hver H2, inkluder 2-4 H3'ere for understøttende detaljer. Sider med 12-15 samlede overskriftssektioner (H2 og H3 tilsammen) klarer sig typisk godt i LLM-citationer.

Ja, selv kortformet indhold drager fordel af korrekt overskriftsstruktur. En artikel på 500 ord har måske kun 1-2 H2'ere, men de bør stadig være beskrivende og specifikke. Kortformet indhold med klare overskrifter har større sandsynlighed for at blive citeret i LLM-svar end ustruktureret kort indhold.

Test dit indhold direkte med ChatGPT, Perplexity eller Claude ved at stille spørgsmål, som dine overskrifter er designet til at besvare. Hvis AI'en korrekt identificerer og citerer dit indhold, fungerer din struktur. Hvis den har svært ved det eller citerer de forkerte sektioner, skal du forbedre dine overskrifter. De fleste forbedringer viser resultater inden for 2-4 uger.

Google AI Overviews og ChatGPT drager begge fordel af klart overskrifthierarki, men ChatGPT lægger endnu mere vægt på det. ChatGPT citerer indhold med sekventiel overskriftsstruktur 3x oftere end indhold uden. Grundprincipperne er de samme, men LLM'er som ChatGPT er mere følsomme over for overskriftskvalitet og struktur.

Spørgsmålsformede overskrifter fungerer bedst til FAQ-sider, fejlfinding-guides og undervisningsindhold. Til blogindlæg og produktsider fungerer en blanding af spørgsmål og udsagn ofte bedst. Det vigtigste er, at overskrifter tydeligt angiver, hvad sektionen handler om, uanset om det er som spørgsmål eller udsagn.

Følg hvor ofte dit indhold citeres i ChatGPT, Perplexity, Google AI Overviews og andre LLM'er. Få realtidsindsigt i din AI-søgeydelse og optimer din indholdsstrategi.

Opdag hvorfor AI-modeller foretrækker listikler og nummererede lister. Lær hvordan du optimerer listebaseret indhold for ChatGPT-, Gemini- og Perplexity-citater...

Lær de bedste praksisser for at formatere overskrifter til AI-systemer. Opdag hvordan korrekt H1, H2, H3 hierarki forbedrer AI-indhentning af indhold, citater o...

Lær hvordan du identificerer og målretter LLM-kildesider for strategiske backlinks. Oplev hvilke AI-platforme der citerer kilder mest, og optimer din linkbuildi...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.