Indeksdækning

Indeksdækning måler, hvilke hjemmesidesider der er indekseret af søgemaskiner. Lær hvad det betyder, hvorfor det er vigtigt for SEO, og hvordan du overvåger og ...

Den procentdel af websitets indhold, der med succes er indekseret og tilgængeligt for AI-systemer såsom ChatGPT, Google AI Overviews og Perplexity. Stærk AI-indeksdækning sikrer, at dit indhold kan opdages i AI-genererede svar og kan citeres som kilde. I modsætning til traditionel søgeindeksering afgør AI-indeksdækning synlighed på tværs af flere AI-platforme og LLM-drevne systemer.

Den procentdel af websitets indhold, der med succes er indekseret og tilgængeligt for AI-systemer såsom ChatGPT, Google AI Overviews og Perplexity. Stærk AI-indeksdækning sikrer, at dit indhold kan opdages i AI-genererede svar og kan citeres som kilde. I modsætning til traditionel søgeindeksering afgør AI-indeksdækning synlighed på tværs af flere AI-platforme og LLM-drevne systemer.

AI-indeksdækning refererer til den procentdel af dit websites indhold, der med succes opdages, crawles og indekseres af kunstige intelligenssystemer såsom ChatGPT, Google AI Overviews, Perplexity og andre large language models (LLM’er). I modsætning til traditionel søgemaskineindeksering, der fokuserer på at gøre indhold synligt i søgeresultater, afgør AI-indeksdækning, om dit indhold er tilgængeligt for AI-systemer til træning, citering og indlemmelse i AI-genererede svar. Når dit indhold har stærk AI-indeksdækning, bliver det opdageligt på tværs af flere AI-platforme, hvilket øger sandsynligheden for, at dit brand, dine produkter eller informationer bliver nævnt, når brugere forespørger disse systemer. Dårlig AI-indeksdækning betyder, at dit værdifulde indhold forbliver usynligt for AI-systemer og går glip af vigtige muligheder for brand-synlighed i det hastigt voksende AI-drevne søgelandskab.

AI-indeksdækning påvirker direkte din virksomheds synlighed i et stadigt mere AI-drevet digitalt økosystem. Med AI-drevne resultater, der nu vises i over 91% af produktsøgninger, og AI-platforme som ChatGPT, der håndterer over 1 milliard søgninger ugentligt, er det afgørende for moderne digital strategi, at dit indhold bliver indekseret af disse systemer. Forretningsmæssigt er det betydningsfuldt: Indhold med stærk AI-indeksdækning kan blive citeret i AI-svar, hvilket driver kvalificeret trafik og brandbevidsthed, mens indhold, der er blokeret eller dårligt indekseret, forbliver helt usynligt i disse kraftfulde opdagelseskanaler. Derudover citerer AI-systemer ofte kilder, der ikke rangerer i traditionelle søgeresultater—faktisk vises kun omkring 20% af sider, der citeres i AI-svar, i Googles top 10 organiske resultater, hvilket betyder, at AI-indeksering skaber helt nye synlighedsmuligheder.

| Scenario | Effekt på AI-synlighed | Forretningsresultat |

|---|---|---|

| Korrekt indekseret, indhold af høj kvalitet | Hyppigt citeret i AI-svar | Flere brandnævnelser, kvalificeret trafik, autoritetsopbygning |

| Indekseret men sjældent citeret | Få nævnelser i AI-resultater | Begrænset synlighed trods teknisk tilgængelighed |

| Blokeret eller ikke indekseret | Ingen synlighed i AI-systemer | Tabte muligheder, konkurrenter får større Share of Voice |

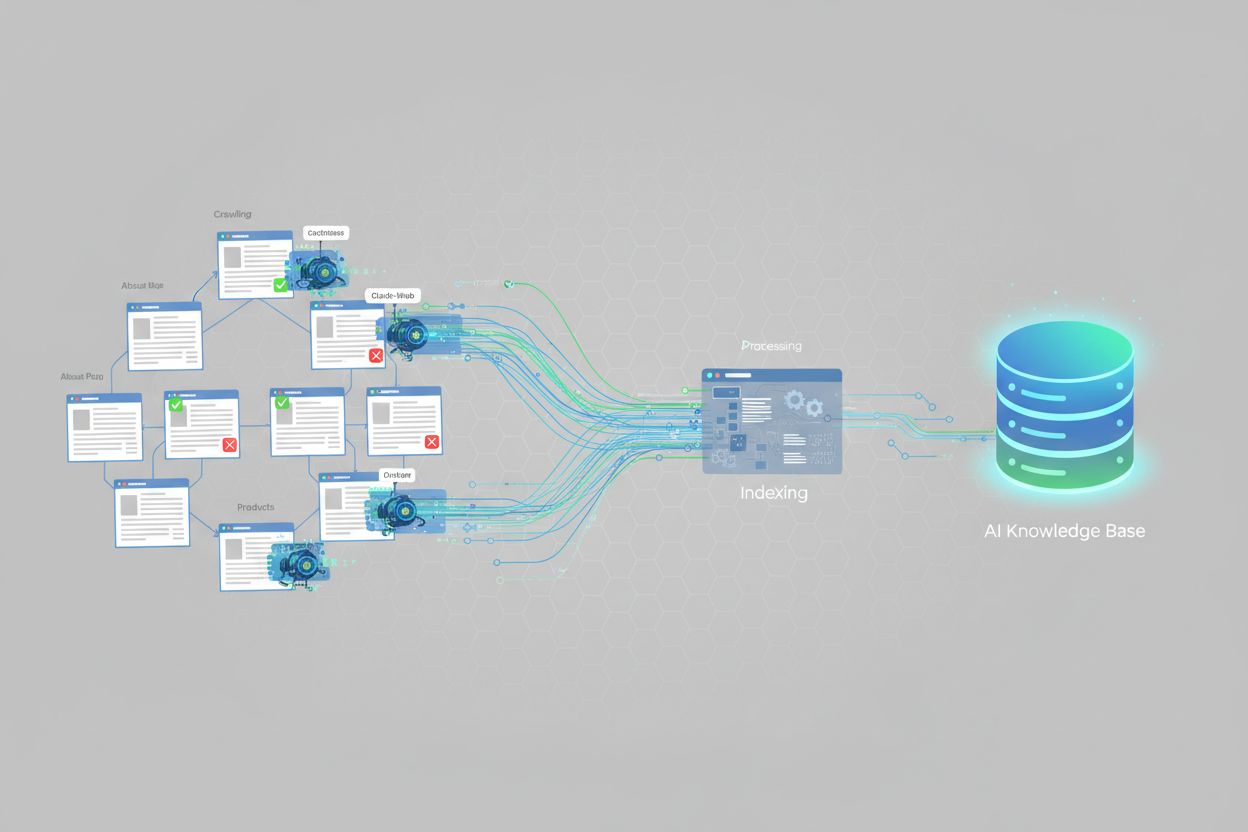

AI-systemer indekserer indhold via specialiserede crawlere, der er designet til at forstå og behandle information til large language models. ChatGPT bruger crawlere som GPTBot til løbende at scanne nettet og indsamle træningsdata, dog benyttes også realtids-websøgning for aktuelle informationer. Google AI Overviews udnytter Googles eksisterende crawl-infrastruktur, men anvender yderligere processer for at forstå indholdsstruktur, relevans og autoritet til AI-genererede sammendrag. Perplexity AI har en anden tilgang med vægt på realtids-websøgning og trækker fra over 20 kilder pr. forespørgsel, med en markant præference for platforme som Reddit og brugergenereret indhold. Hver AI-platform har særlige indekseringspræferencer: Nogle prioriterer strukturerede data og schema-markup, andre foretrækker omfattende, velskrevne tekster, og nogle vægter tredjeparts-citater og anmeldelser højt. At forstå disse forskelle er afgørende, da optimering for ét AI-system ikke automatisk optimerer for dem alle—din indholdsstrategi skal tage højde for de specifikke indekseringsadfærd på de platforme, der er mest relevante for dit publikum.

Flere tekniske faktorer har direkte indflydelse på, om AI-systemer kan indeksere dit indhold. De vigtigste er:

<meta name="robots" content="noindex"> udelukkes eksplicit fra AI-indeksering. Disse tags bliver nogle gange ved en fejl efterladt på produktionssider under udvikling.At adressere disse tekniske faktorer er grundlæggende for at forbedre AI-indeksdækningen. Værktøjer som AmICited.com kan hjælpe med at overvåge, hvor effektivt dit indhold bliver indekseret på tværs af forskellige AI-platforme og give indsigt i, hvilke tekniske problemer der kan begrænse din dækning.

At spore din AI-indeksdækning kræver en kombination af traditionelle SEO-værktøjer og AI-specifikke overvågningsløsninger. Google Search Console tilbyder rapporter over indeksdækning, der viser, hvilke sider Google har indekseret, men dette afspejler traditionel søgeindeksering snarere end AI-system-indeksering. Bing Webmaster Tools giver lignende funktionalitet for Bings indeks. Til AI-specifik overvågning specialiserer AmICited.com sig i at spore, hvordan dit brand optræder på tværs af ChatGPT, Google AI Overviews, Perplexity og andre AI-systemer med visning af citeringsfrekvens, sentiment og Share of Voice. Tredjeparts SEO-platforme som Semrush, Ahrefs og Moz inkluderer i stigende grad AI-synlighedsdata sammen med traditionelle SEO-metrics. Centrale metrics at overvåge er: procentdelen af dit sites sider, der optræder i AI-svar, hvor ofte dit brand citeres sammenlignet med konkurrenter, sentimentet af AI-omtaler, og hvilke indholdstyper der genererer flest AI-citater. Løbende overvågning hjælper med at identificere tekniske problemer, indholdshuller og muligheder for at forbedre din AI-indeksdækning over tid.

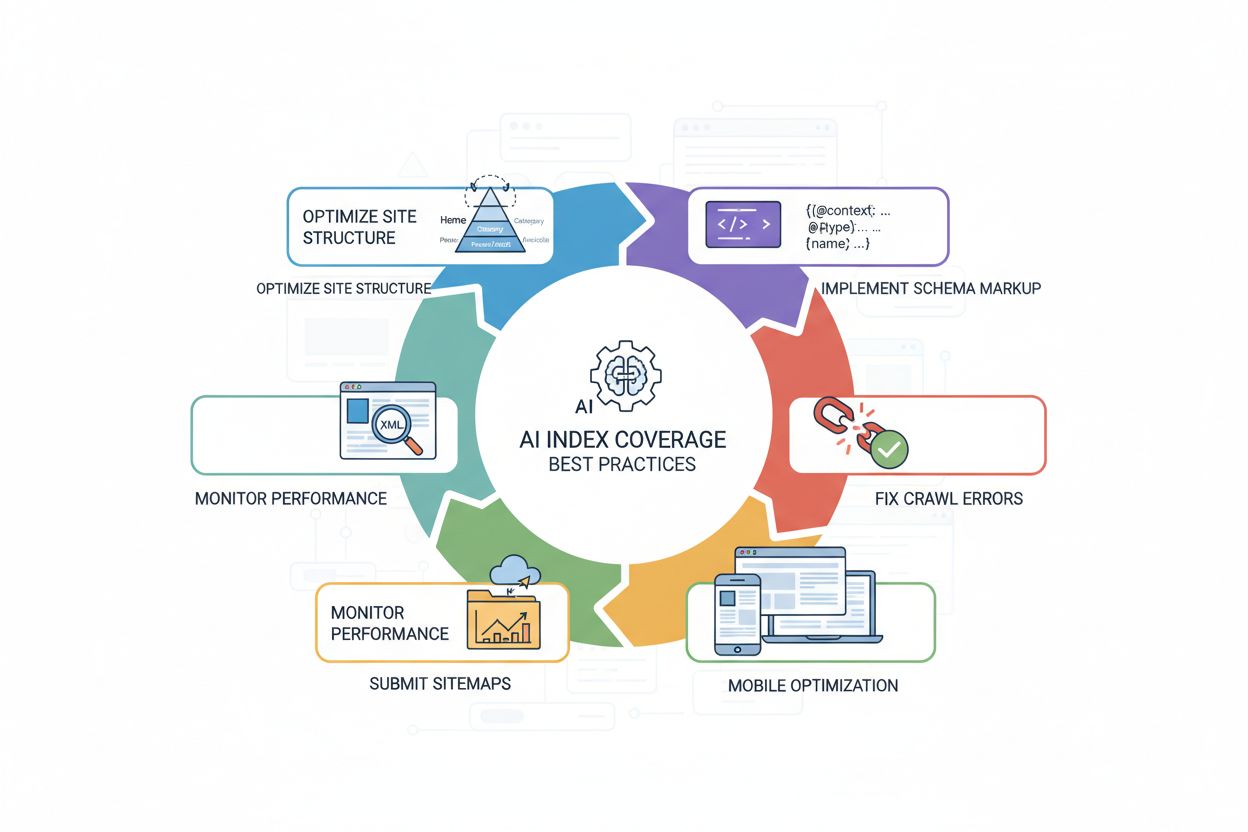

For at forbedre din AI-indeksdækning kræves en strategisk tilgang med teknisk optimering kombineret med indholdsfortræffelighed. De mest effektive praksisser omfatter:

<article>, <section>, <header>, <nav>) for tydeligt at kommunikere indholdsstruktur og betydning til AI-systemer.Disse praksisser arbejder sammen om at skabe et AI-venligt website, der er nemt for crawlere at tilgå, forstå og citere. Resultatet er stærkere AI-indeksdækning og øget synlighed på AI-drevne platforme.

Selvom AI-indeksdækning og traditionel søgeindeksdækning er relaterede, er de ikke identiske. Traditionel søgeindeksering fokuserer på at gøre indhold synligt i søgemaskinernes resultatsider (SERP’er), hvor rangering bestemmes af faktorer som backlinks, keyword-relevans og brugerengagement. AI-indeksdækning derimod afgør, om indhold er tilgængeligt for AI-systemer til træning og realtids-citering, hvor rangeringen afhænger af helt andre faktorer. AI-systemer citerer ofte kilder, der ikke rangerer højt i traditionel søgning—de 20% overlap mellem AI-citerede sider og top 10 organiske resultater illustrerer denne grundlæggende forskel. Derudover prioriterer AI-systemer ofte andre indholdstyper: Mens traditionel søgning favoriserer autoritative domænesignaler, vægter AI-systemer ofte bestemte formater (FAQ, lister, sammenligningsguides, anmeldelser) højere. En side kan rangere godt i Google, men sjældent blive citeret af AI-systemer, eller omvendt. Det betyder, at din optimeringsstrategi skal adressere begge kanaler: Traditionelle SEO-praksisser forbedrer søgesynlighed, mens AI-specifik optimering (schema-markup, indholdsstruktur, tilgængelighed) forbedrer AI-indeksdækning og sandsynlighed for at blive citeret.

Flere almindelige problemer forhindrer websites i at opnå stærk AI-indeksdækning. Alt for restriktive robots.txt-filer er blandt de hyppigste syndere—mange sites blokerer ved en fejl AI-crawlere, selvom hensigten kun var at blokere traditionelle søgebots, hvilket fuldstændig forhindrer AI-indeksering. Forkerte noindex-tags, der bliver siddende på produktionssider under udvikling eller migration, kan gøre hele sektioner usynlige for AI-systemer. Dårlig indholdsstruktur gør det svært for AI-crawlere at forstå og udtrække information; sider uden klare overskrifter, semantisk HTML eller logisk opbygning bliver sjældnere indekseret og citeret. Manglende eller ufuldstændig schema-markup fratager AI-systemer eksplicit kontekst om dit indhold, hvilket mindsker effektiviteten af indeksering og sandsynligheden for citat. JavaScript-tunge websites uden server-side rendering udgør en stor udfordring, da mange AI-crawlere ikke kan køre JavaScript, og derfor forbliver vigtigt indhold skjult. Duplikeret indhold uden korrekt canonicalisering forvirrer AI-systemer om, hvilken version der er autoritativ, og kan reducere dækningen. Endelig reducerer langsom indlæsningstid og dårlig mobiloptimering crawl-effektiviteten, så mindre af dit site bliver indekseret. At løse disse problemer systematisk—startende med robots.txt-verificering, tilføjelse af schema-markup, forbedring af sitestruktur og sikring af hurtige, mobilvenlige sider—kan markant forbedre din AI-indeksdækning og synlighed på tværs af AI-platforme.

Der findes i øjeblikket ingen standardiseret måling for AI-indeksdækning på tværs af alle websites, men forskning viser, at AI-drevne resultater vises i over 91% af produktsøgninger. Dog har mange websites dårlig AI-indeksdækning på grund af tekniske problemer såsom robots.txt-blokeringer, manglende schema-markup eller problemer med JavaScript-gengivelse. Websites med stærk teknisk SEO og strukturerede data opnår typisk bedre AI-indeksdækning.

Traditionel Google-indeksdækning fokuserer på at gøre indhold synligt i søgeresultater, mens AI-indeksdækning afgør, om indhold er tilgængeligt for AI-systemer til træning og citering. AI-systemer citerer ofte kilder, der ikke rangerer i Googles top 10-resultater—kun omkring 20% af AI-citerede sider vises i traditionelle top 10 organiske resultater. Forskellige AI-platforme har også forskellige indekseringspræferencer og vægtning af kilder.

Ja, du kan blokere specifikke AI-crawlere ved at bruge din robots.txt-fil. For eksempel kan du afvise GPTBot (OpenAI), CCBot (Common Crawl) eller Claude-Web (Anthropic). Men hvis du blokerer AI-crawlere, vil dit indhold ikke blive indekseret af disse systemer og vil ikke optræde i AI-genererede svar. De fleste virksomheder har fordel af at tillade AI-crawlere for at forbedre synlighed på tværs af AI-platforme.

Indekseringstiden varierer afhængigt af AI-platformen. ChatGPT's GPTBot crawler kontinuerligt, men kan bruge dage eller uger på at opdage nyt indhold. Google AI Overviews bruger Googles eksisterende crawl-infrastruktur, så indeksering kan ske inden for timer til dage. Perplexity lægger vægt på realtids-websøgning, så nyt indhold kan hurtigt optræde i svar. Brug af XML-sitemaps og anmodning om indeksering via webmasterværktøjer kan fremskynde processen.

AI-indeksdækning og traditionelle søgerangeringer er relaterede, men forskellige. Optimering for AI-indeksdækning (via schema-markup, sitestruktur og tilgængelighed) forbedrer også traditionel SEO. Men en side kan rangere godt i Google, men sjældent blive citeret af AI-systemer, eller omvendt. Den bedste strategi er at optimere for begge: Traditionelle SEO-praksisser forbedrer søgesynlighed, mens AI-specifik optimering forbedrer AI-indeksdækning.

De mest almindelige årsager er: 1) Alt for restriktive robots.txt-filer, der ved en fejl blokerer AI-crawlere, 2) Manglende eller ufuldstændig schema-markup, som forhindrer AI-systemer i at forstå indholdets kontekst, 3) JavaScript-tunge sites uden server-side rendering, som AI-crawlere ikke kan behandle, og 4) Dårlig sitestruktur, der gør det svært for crawlere at navigere. Løsning af disse tekniske problemer forbedrer typisk AI-indeksdækningen markant.

Du kan overvåge AI-indeksdækning med værktøjer som AmICited.com, der sporer, hvordan dit brand optræder på tværs af ChatGPT, Google AI Overviews, Perplexity og andre AI-systemer. Se efter metrics som citeringsfrekvens, Share of Voice sammenlignet med konkurrenter og omtale-sentiment. Du kan også teste manuelt ved at søge efter dit brand og nøgleemner i AI-systemer og se, om dit indhold optræder i svarene.

Selvom det ikke er strengt nødvendigt, forbedrer schema-markup AI-indeksdækning markant. Strukturerede data (JSON-LD) hjælper AI-systemer med at forstå indholdets kontekst, udtrække information korrekt og vurdere relevans. Sider med korrekt schema-markup for produkter, artikler, FAQ og organisationer har større sandsynlighed for at blive indekseret og citeret af AI-systemer. Det betragtes som best practice for optimering af AI-indeksdækning.

Følg med i, hvordan AI-systemer opdager og citerer dit brand på tværs af ChatGPT, Google AI Overviews, Perplexity og flere. Få realtidsindsigt i din AI-synlighed, citeringsfrekvens og Share of Voice i AI-genererede svar.

Indeksdækning måler, hvilke hjemmesidesider der er indekseret af søgemaskiner. Lær hvad det betyder, hvorfor det er vigtigt for SEO, og hvordan du overvåger og ...

Lær hvordan AI-motorer som ChatGPT, Perplexity og Gemini indekserer og behandler webindhold ved hjælp af avancerede crawlere, NLP og maskinlæring til at træne s...

Community-diskussion om AI-indekseringens tidslinjer. Reelle data om hvor hurtigt ChatGPT, Perplexity og andre AI-systemer opdager og citerer nyt indhold.

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.