Finjustering

Finjustering definition: tilpasning af forudtrænede AI-modeller til specifikke opgaver gennem domænespecifik træning. Lær, hvordan finjustering forbedrer modelp...

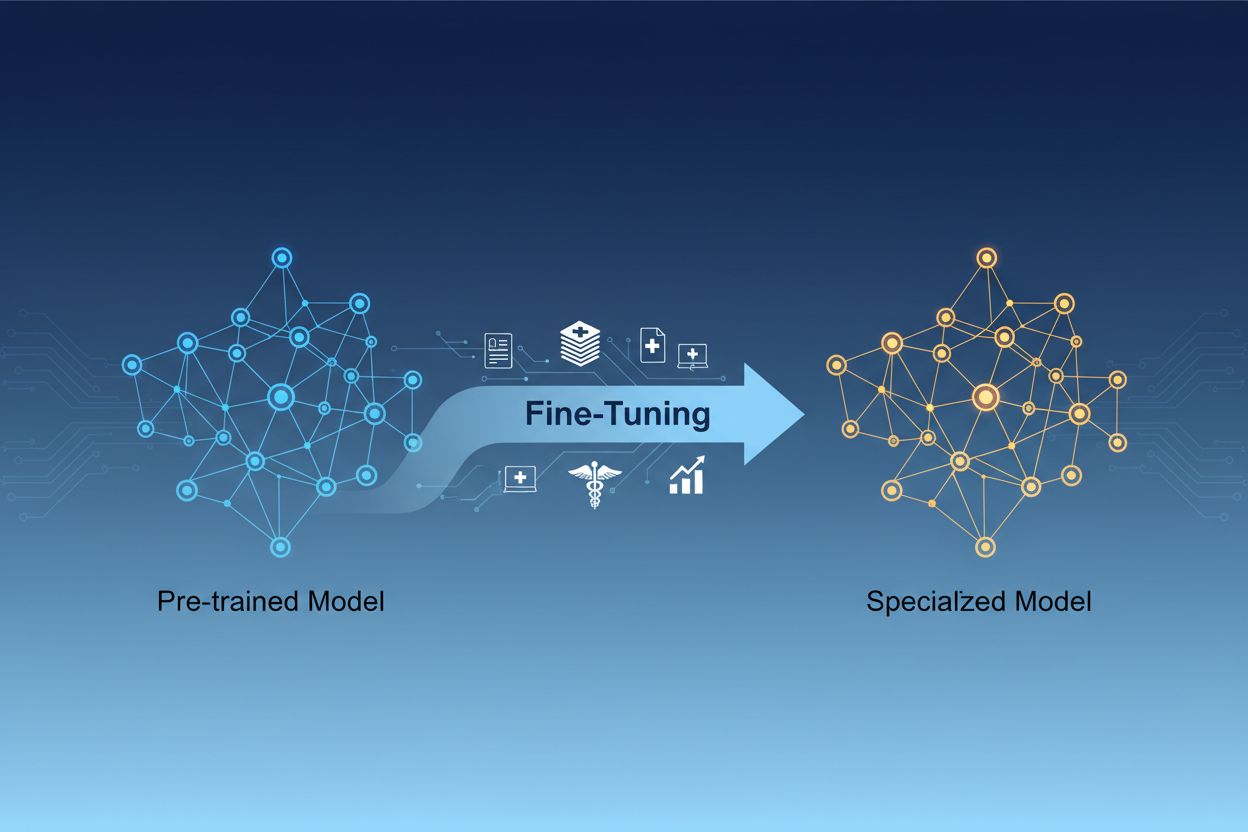

Finjustering af AI-modeller er processen med at tilpasse fortrænede kunstige intelligensmodeller til at udføre specifikke opgaver eller arbejde med specialiserede data ved at justere deres parametre gennem yderligere træning på domænespecifikke datasæt. Denne tilgang udnytter eksisterende grundlæggende viden, samtidig med at modellerne tilpasses til særlige forretningsapplikationer, hvilket gør det muligt for organisationer at skabe højt specialiserede AI-systemer uden de beregningsmæssige omkostninger ved at træne fra bunden.

Finjustering af AI-modeller er processen med at tilpasse fortrænede kunstige intelligensmodeller til at udføre specifikke opgaver eller arbejde med specialiserede data ved at justere deres parametre gennem yderligere træning på domænespecifikke datasæt. Denne tilgang udnytter eksisterende grundlæggende viden, samtidig med at modellerne tilpasses til særlige forretningsapplikationer, hvilket gør det muligt for organisationer at skabe højt specialiserede AI-systemer uden de beregningsmæssige omkostninger ved at træne fra bunden.

Finjustering af AI-model er processen, hvor man tager en fortrænet kunstig intelligensmodel og tilpasser den til at udføre specifikke opgaver eller arbejde med specialiserede data. I stedet for at træne en model fra bunden udnytter finjustering den grundviden, der allerede er indlejret i en fortrænet model, og justerer dens parametre gennem yderligere træning på domæne- eller opgavespecifikke datasæt. Denne tilgang kombinerer effektiviteten fra transfer learning med den nødvendige tilpasning til særlige forretningsapplikationer. Finjustering gør det muligt for organisationer at skabe højt specialiserede AI-modeller uden de beregningsmæssige omkostninger og tidsforbrug, som kræves ved træning fra bunden, og er dermed en essentiel teknik i moderne maskinlæringsudvikling.

Forskellen mellem finjustering og træning fra bunden er en af de vigtigste beslutninger i udviklingen af maskinlæring. Når du træner en model fra bunden, starter du med tilfældigt initierede vægte og skal lære modellen alt om sprogstrukturer, visuelle egenskaber eller domænespecifik viden ved hjælp af massive datasæt og store beregningsressourcer. Denne tilgang kan kræve uger eller måneder af træning og adgang til specialiseret hardware som GPU’er eller TPU’er. Finjustering derimod starter med en model, der allerede forstår grundlæggende mønstre og koncepter, og kræver kun en brøkdel af data og beregningskraft for at tilpasse den til dine specifikke behov. Den fortrænede model har allerede lært generelle egenskaber under den indledende træningsfase, så finjusteringen fokuserer på at justere disse egenskaber til din særlige anvendelse. Denne effektivitetsgevinst gør finjustering til den foretrukne tilgang for de fleste organisationer, fordi den både reducerer time-to-market og infrastrukturudgifter og ofte opnår bedre resultater end at træne mindre modeller fra bunden.

| Aspekt | Finjustering | Træning fra bunden |

|---|---|---|

| Træningstid | Dage til uger | Uger til måneder |

| Datakrav | Tusinder til millioner af eksempler | Millioner til milliarder af eksempler |

| Beregningomkostning | Moderat (ofte en enkelt GPU er nok) | Ekstremt høj (flere GPU’er/TPU’er krævet) |

| Startviden | Udnytter fortrænede vægte | Starter med tilfældig initiering |

| Ydeevne | Ofte bedre med begrænset data | Bedre med massive datasæt |

| Nødvendig ekspertise | Mellem | Avanceret |

| Tilpasningsniveau | Højt for specifikke opgaver | Maksimal fleksibilitet |

| Infrastruktur | Standard cloud-ressourcer | Specialiserede hardwareklynger |

Finjustering er blevet en kritisk kapabilitet for organisationer, der ønsker at implementere AI-løsninger, der giver konkurrencefordele. Ved at tilpasse fortrænede modeller til din specifikke forretningskontekst kan du skabe AI-systemer, der forstår din branches terminologi, kundernes præferencer og operationelle krav med imponerende nøjagtighed. Denne tilpasning gør det muligt at opnå præstationsniveauer, som generiske standardmodeller ikke kan matche, især inden for specialiserede områder som sundhedssektoren, juridiske tjenester eller teknisk support. Finjusteringens omkostningseffektivitet betyder, at selv mindre organisationer nu kan få adgang til AI-kapabiliteter på enterprise-niveau uden massive hardwareinvesteringer. Finjusterede modeller kan desuden implementeres hurtigere, så virksomheder hurtigere kan reagere på markedsmuligheder og konkurrencepres. Evnen til løbende at forbedre modellerne ved at finjustere dem på nye data sikrer, at dine AI-systemer forbliver relevante og effektive i takt med, at forretningsbetingelserne udvikler sig.

De vigtigste forretningsfordele ved finjustering inkluderer:

Flere etablerede teknikker har udviklet sig som best practices på området for finjustering, hver med forskellige fordele afhængigt af dine behov. Fuld finjustering indebærer opdatering af alle parametre i den fortrænede model, hvilket giver maksimal fleksibilitet og ofte bedste ydeevne, men kræver betydelige beregningsressourcer og større datasæt for at undgå overfitting. Parametereffektive finjusteringsteknikker som LoRA (Low-Rank Adaptation) og QLoRA har revolutioneret feltet ved at muliggøre effektiv modeltilpasning, mens kun en lille del af parametrene opdateres, hvilket dramatisk reducerer hukommelseskrav og træningstid. Disse teknikker fungerer ved at tilføje trænede lav-rangs matricer til modellens vægtmatricer, så opgavespecifik tilpasning kan indfanges uden at ændre de oprindelige fortrænede vægte. Adaptermoduler er en anden tilgang, hvor små trænede netværk indsættes mellem lagene i den frosne fortrænede model, hvilket gør det muligt at finjustere effektivt med minimale ekstra parametre. Prompt-baseret finjustering fokuserer på at optimere input-prompts frem for modelvægt, nyttigt for modeller hvor parameteradgang er begrænset. Instruktionsfinjustering træner modeller til at følge specifikke instruktioner og kommandoer, især vigtigt for store sprogmodeller, der skal kunne reagere hensigtsmæssigt på mange forskellige brugerhenvendelser. Valget af teknik afhænger af dine beregningsmæssige begrænsninger, datasætstørrelse, ydeevnekrav og den konkrete modelarkitektur, du arbejder med.

Finjustering af store sprogmodeller (LLM’er) giver både unikke muligheder og udfordringer sammenlignet med finjustering af mindre modeller eller andre typer neurale netværk. Moderne LLM’er som GPT-lignende modeller indeholder milliarder af parametre, hvilket gør fuld finjustering beregningsmæssigt uoverkommeligt for de fleste organisationer. Dette har ført til udbredelsen af parametereffektive teknikker, der gør det muligt at tilpasse LLM’er effektivt uden behov for infrastruktur på enterpriseniveau. Instruktionsfinjustering er blevet særligt vigtig for LLM’er, hvor modeller trænes på eksempler med instruktioner parret med højkvalitetsbesvarelser, så de følger brugerens anvisninger mere effektivt. Reinforcement Learning fra menneskelig feedback (RLHF) er en avanceret finjusteringsmetode, hvor modellerne yderligere forfines baseret på menneskelige præferencer og vurderinger, hvilket forbedrer overensstemmelse med menneskelige værdier og forventninger. Den relativt lille mængde opgavespecifikke data, der kræves for at finjustere LLM’er—ofte kun hundreder eller tusinder af eksempler—gør denne tilgang tilgængelig for organisationer uden massive mærkede datasæt. Finjustering af LLM’er kræver dog omhyggelig opmærksomhed på valg af hyperparametre, læringsrateplanlægning og forebyggelse af katastrofal glemsel, hvor modellen mister tidligere indlærte evner under tilpasning til nye opgaver.

Organisationer på tværs af brancher har opdaget stærke anvendelser af finjusterede AI-modeller, som tilfører målbar forretningsværdi. Automatiseret kundeservice er et af de mest udbredte eksempler, hvor modeller finjusteres på virksomheds-specifikke supportsager, produktinformation og kommunikationsstil for at skabe chatbots, der håndterer kundehenvendelser med domæneekspertise og brandkonsistens. Medicinsk og juridisk dokumentanalyse udnytter finjustering til at tilpasse generelle sproglige modeller til at forstå specialiseret terminologi, lovkrav og branchespecifikke formater, hvilket muliggør præcis informationsudtrækning og klassificering. Sentimentanalyse og indholdsmoderering kan forbedres betydeligt ved at finjustere modeller på eksempler fra netop din branche eller dit fællesskab, så nuancerede sprogmønstre og kontekst, som generiske modeller overser, opfanges. Kodegenerering og softwareudviklingsassistance drager fordel af finjustering på organisationens egen kodebase, programmeringssprog og arkitektoniske mønstre, hvilket gør det muligt for AI-værktøjer at generere kode, der stemmer overens med jeres standarder. Anbefalingssystemer finjusteres ofte på brugeradfærdsdata og produktkataloger for at levere personlige forslag, der øger engagement og omsætning. Navngiven entitetsgenkendelse og informationsudtrækning fra domænespecifikke dokumenter—som finansrapporter, videnskabelige artikler eller tekniske specifikationer—kan forbedres markant med finjustering på relevante eksempler. Disse forskellige anvendelser viser, at finjustering ikke er begrænset til en enkelt branche eller opgave, men er en fundamental kapabilitet til at skabe AI-systemer, der leverer konkurrencefordele i stort set enhver forretningskontekst.

Finjusteringsprocessen følger et struktureret workflow, der starter med grundig forberedelse og fortsætter gennem implementering og overvågning. Dataklargøring er det kritiske første skridt, hvor du indsamler, renser og formaterer dit domænespecifikke datasæt, så det matcher den input-output-struktur, som den fortrænede model forventer. Dette datasæt bør være repræsentativt for de opgaver, din finjusterede model skal udføre i produktion, og kvalitet er vigtigere end mængde—et mindre datasæt med eksempler af høj kvalitet overgår typisk et større datasæt med inkonsistente eller støjende labels. Trænings-, validerings- og testsplit sikrer, at du kan evaluere modelpræstationen korrekt, med typiske fordelinger på 70-80% til træning, 10-15% til validering og 10-15% til test. Valg af hyperparametre indebærer at vælge læringsrate, batch-størrelse, antal trænings-epochs og andre parametre, som styrer finjusteringsprocessen; disse valg har stor betydning for både ydeevne og træningseffektivitet. Modelinitialisering bruger de fortrænede vægte som udgangspunkt, så grundviden bevares, mens parametrene kan tilpasses din opgave. Træningsudførelse indebærer iterativ opdatering af modelparametre på dine træningsdata, mens valideringspræstationen overvåges for at opdage overfitting. Evaluering og iteration bruger testdata til at vurdere endelig præstation og afgøre, om yderligere finjustering, andre hyperparametre eller flere træningsdata ville forbedre resultatet. Implementeringsforberedelse inkluderer optimering af modellen for inferenshastighed og ressourceeffektivitet, eventuelt gennem kvantisering eller destillationsteknikker. Endelig sikrer overvågning og vedligeholdelse i produktion, at modellen fortsat præsterer godt, selv når datadistributionen ændres over tid, med periodisk genoptræning på nye data for at fastholde nøjagtighed.

Selvom finjustering er mere effektiv end træning fra bunden, medfører det sine egne udfordringer, som praktikere skal håndtere omhyggeligt. Overfitting opstår, når modeller memorerer træningsdata frem for at lære generaliserbare mønstre, hvilket især er en risiko ved små datasæt; det kan modvirkes med teknikker som tidlig stop, regularisering og dataforøgelse. Katastrofal glemsel kan ske, når finjustering får modellen til at glemme tidligere indlærte evner, hvilket især er problematisk ved tilpasning af generelle modeller til specialiserede opgaver; omhyggelig valg af læringsrate og teknikker som knowledge distillation hjælper med at bevare grundviden. Datakvalitet og mærkning er en væsentlig praktisk udfordring, da finjustering kræver eksempler af høj kvalitet, der præcist afspejler dit målområde og dine use cases. Håndtering af beregningsressourcer kræver balance mellem præstationsforbedringer, træningstid og infrastrukturudgifter, især vigtigt ved store modeller. Hyperparametersensitivitet betyder, at finjusteringsresultater kan variere meget afhængigt af læringsrate, batch-størrelse og andre indstillinger, hvilket kræver systematisk eksperimentering og validering.

Best practices for succesfuld finjustering inkluderer:

Organisationer står ofte overfor et valg mellem tre komplementære tilgange til at tilpasse AI-modeller til specifikke opgaver: finjustering, Retrieval-Augmented Generation (RAG) og prompt engineering. Prompt engineering indebærer at udforme nøje formulerede instruktioner og eksempler for at styre modellens adfærd uden at ændre selve modellen; denne tilgang er hurtig og kræver ingen træning, men har begrænset effektivitet ved komplekse opgaver og kan ikke lære modellen ægte ny viden. RAG udvider modelbesvarelser ved at hente relevante dokumenter eller data fra eksterne kilder, før der genereres svar, så modeller kan få adgang til aktuel information og domænespecifik viden uden parameteropdateringer; denne tilgang fungerer godt til videnintensive opgaver, men øger latenstid og kompleksitet ved inferens. Finjustering ændrer modelparametre for at indlejre opgavespecifik viden og mønstre dybt i modellen, hvilket giver den bedste ydeevne til veldefinerede opgaver med tilstrækkelige træningsdata, men kræver mere tid og beregningsressourcer end de andre tilgange. Den optimale løsning involverer ofte en kombination af disse teknikker: prompt engineering til hurtig prototyping, RAG til videnintensive applikationer og finjustering til performancekritiske systemer, hvor investeringen i træning er berettiget. Finjustering er bedst, når du har brug for konsekvent og høj ydeevne på specifikke opgaver, når du har tilstrækkelige træningsdata, og når præstationsgevinsterne retfærdiggør udviklingsindsatsen. RAG egner sig bedst til applikationer, der kræver adgang til aktuel eller proprietær information, der ændrer sig ofte. Prompt engineering fungerer som et fremragende udgangspunkt til udforskning og prototyping, før man forpligter sig til mere ressourcekrævende metoder. Ved at forstå styrker og begrænsninger ved hver tilgang kan organisationer træffe informerede valg om, hvilke teknikker der skal anvendes til forskellige dele af deres AI-systemer.

Transfer learning er det bredere begreb, hvor man udnytter viden fra én opgave til at forbedre ydeevnen på en anden opgave, mens finjustering er en specifik implementering af transfer learning. Finjustering tager en fortrænet model og justerer dens parametre på nye data, mens transfer learning også kan inkludere feature extraction, hvor du fryser de fortrænede vægte og kun træner nye lag. Al finjustering indebærer transfer learning, men ikke al transfer learning kræver finjustering.

Tiden for finjustering varierer markant afhængigt af modellens størrelse, datasætstørrelse og tilgængelig hardware. Ved brug af parametereffektive teknikker som LoRA kan en 13-milliarder-parameter model finjusteres på cirka 5 timer på en enkelt A100 GPU. Mindre modeller eller parametereffektive metoder kan tage blot timer, mens fuld finjustering af større modeller kan tage dage eller uger. Den største fordel er, at finjustering er dramatisk hurtigere end træning fra bunden, hvilket kan tage måneder.

Ja, finjustering er specifikt designet til at fungere effektivt med begrænsede data. Fortrænede modeller har allerede lært generelle mønstre, så du har typisk kun brug for hundreder til tusinder af eksempler for effektiv finjustering, sammenlignet med millioner der kræves for træning fra bunden. Dog er datakvalitet vigtigere end mængde—et mindre datasæt med høj kvalitet og repræsentative eksempler vil give bedre resultater end et større datasæt med inkonsistente eller støjende labels.

LoRA (Low-Rank Adaptation) er en parametereffektiv finjusteringsteknik, der tilføjer trænede lav-rangs matricer til en models vægt-matricer i stedet for at opdatere alle parametre. Denne tilgang reducerer antallet af trænede parametre med tusindvis af gange, mens den opretholder en ydeevne, der kan sammenlignes med fuld finjustering. LoRA er vigtig, fordi det gør finjustering tilgængelig på standardhardware, reducerer hukommelseskravene drastisk og gør det muligt for organisationer at finjustere store modeller uden dyr infrastruktur.

Overfitting opstår, når træningstabet falder, men valideringstabet stiger, hvilket indikerer, at modellen memorerer træningsdataene i stedet for at lære generaliserbare mønstre. Overvåg begge målinger under træning—hvis valideringspræstationen flader ud eller forværres, mens træningspræstationen fortsætter med at forbedres, overfitter din model sandsynligvis. Implementer tidlig stop, så træningen stopper, når valideringspræstationen ikke længere forbedres, og brug teknikker som regularisering og dataforøgelse for at undgå overfitting.

Omkostningerne ved finjustering inkluderer beregningsressourcer (GPU/TPU-tid), datapreparation og mærkning, modelopbevaring og implementeringsinfrastruktur samt løbende overvågning og vedligeholdelse. Disse omkostninger er dog typisk 10-100 gange lavere end træning af modeller fra bunden. Ved at bruge parametereffektive teknikker som LoRA kan beregningsomkostningerne reduceres med 80-90% i forhold til fuld finjustering, hvilket gør finjustering til en økonomisk tilgang for de fleste organisationer.

Ja, finjustering forbedrer typisk modellens nøjagtighed markant for specifikke opgaver. Ved at træne på domænespecifikke data lærer modellerne opgaverelevante mønstre og terminologi, som generiske modeller overser. Studier viser, at finjustering kan forbedre nøjagtigheden med 10-30% eller mere, afhængigt af opgaven og datasætkvaliteten. Forbedringen er mest markant, når finjusteringsopgaven adskiller sig fra den fortrænede opgave, da modellen tilpasser sine lærte egenskaber til dine specifikke krav.

Finjustering gør det muligt for organisationer at holde følsomme data på deres egen infrastruktur i stedet for at sende dem til tredjeparts-API'er. Du kan finjustere modeller lokalt på proprietære eller regulerede data uden at eksponere dem for eksterne tjenester, hvilket sikrer overholdelse af databeskyttelsesregler som GDPR, HIPAA eller branchespecifikke krav. Denne tilgang giver både sikkerheds- og overholdelsesfordele, samtidig med at du bevarer fordelene ved at bruge fortrænede modeller.

Spor hvordan AI-systemer som GPT'er, Perplexity og Google AI Overviews citerer og refererer til dit brand med AmICiteds AI-overvågningsplatform.

Finjustering definition: tilpasning af forudtrænede AI-modeller til specifikke opgaver gennem domænespecifik træning. Lær, hvordan finjustering forbedrer modelp...

Modelparametre er lærbare variable i AI-modeller, der bestemmer adfærd. Forstå vægte, bias, og hvordan parametre påvirker AI-modellers ydeevne og træning.

Lær hvordan du anmoder om rettelser fra AI-platforme som ChatGPT, Perplexity og Claude. Forstå rettelsesmekanismer, feedbackprocesser og strategier til at påvir...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.