AI-platformfeedback

Lær, hvordan du rapporterer brandunøjagtigheder og fejlagtige fremstillinger til AI-platforme som ChatGPT, Perplexity og Google Gemini. Opdag feedbackmekanismer...

AI Platform-risikovurdering er den systematiske evaluering af forretningsmæssige risici, der opstår som følge af ændringer i AI-platformes algoritmer, politikker eller operationelle parametre. Det indebærer identifikation, analyse og afbødning af potentielle skader fra AI-systemers udvikling, herunder algoritmisk bias, datapoisning, modeldrift og mangler i overholdelse af lovgivning. Organisationer skal løbende overvåge AI-platforme for at opdage risici, inden de påvirker forretningsdrift, indtægter eller overholdelsesstatus.

AI Platform-risikovurdering er den systematiske evaluering af forretningsmæssige risici, der opstår som følge af ændringer i AI-platformes algoritmer, politikker eller operationelle parametre. Det indebærer identifikation, analyse og afbødning af potentielle skader fra AI-systemers udvikling, herunder algoritmisk bias, datapoisning, modeldrift og mangler i overholdelse af lovgivning. Organisationer skal løbende overvåge AI-platforme for at opdage risici, inden de påvirker forretningsdrift, indtægter eller overholdelsesstatus.

AI Platform-risikovurdering er den systematiske evaluering af sårbarheder, trusler og potentielle fejl inden for kunstig intelligens-systemer og deres operationelle miljøer. Denne proces identificerer, hvordan AI-platforme kan fejle, skabe bias i output eller forårsage utilsigtede forretningsmæssige konsekvenser. Risikovurdering er vigtig, fordi AI-systemer i stigende grad driver kritiske forretningsbeslutninger, der påvirker omsætning, compliance og brandets omdømme. Organisationer skal forstå disse risici, før de implementerer AI-løsninger i stor skala.

Ældre risikostyringsrammer blev designet til statiske systemer med forudsigelige fejltyper, ikke dynamiske AI-platforme, der udvikler sig løbende. Traditionelle tilgange fokuserer på infrastrukturens stabilitet og datasikkerhed og overser de unikke udfordringer ved algoritmisk adfærd, modelnedbrydning og platformafhængighedsrisici. Disse rammer mangler mekanismer til at opdage subtile præstationsskift, fremkomst af bias eller ændringer hos tredjepartsplatforme, der påvirker dine AI-systemer. Overholdelsestjeklister og årlige audits kan ikke indfange realtids-algoritmedrift eller pludselige politiske ændringer fra AI-platformudbydere.

Centrale begrænsninger ved traditionelle rammer:

| Tilgang | Styrker | Begrænsninger | Forretningspåvirkning |

|---|---|---|---|

| Traditionel risikostyring | Omfattende dokumentation, etablerede processer, regulatorisk erfaring | Statisk analyse, langsom opdagelse, overser algoritmiske risici | Forsinket hændelsesrespons, compliance-mangler, skjulte fejl |

| AI-specifik risikostyring | Realtids-overvågning, bias-detektering, kontinuerlig evaluering, platformsporing | Kræver nye værktøjer og ekspertise, udviklende standarder | Hurtigere risikoafdæmpning, bedre compliance, beskyttet omsætning |

AI-platforme præsenterer særskilte risikokategorier, som traditionelle rammer helt overser. Algoritmisk bias opstår, når træningsdata afspejler historiske uligheder, hvilket forårsager diskriminerende output, der udsætter organisationer for juridisk ansvar og image-tab. Datapoisning forekommer, når ondsindede aktører indsprøjter korrupte data i træningsforløb, hvilket forringer modellens nøjagtighed og pålidelighed. Modeldrift opstår, når datadistributioner i den virkelige verden ændres, så tidligere nøjagtige modeller leverer stadigt mindre pålidelige forudsigelser uden tydelige advarselstegn. Platformafhængighedsrisici opstår, når tredjeparts AI-tjenester ændrer deres algoritmer, priser, vilkår eller tilgængelighed uden varsel. Hallucination og faktuelle fejl i store sprogmodeller kan sprede misinformation og skade brandets troværdighed. Adversarielle angreb udnytter modelsvagheder til at producere uventede eller skadelige resultater. Organisationer skal overvåge alle disse kategorier samtidigt for at bevare operationel integritet.

Det regulatoriske miljø for AI konsolideres hurtigt med håndhævelige krav, der direkte påvirker risikovurderingspraksis. EU AI Act indfører obligatoriske risikoklassifikationer og compliance-forpligtelser for højrisiko-AI-systemer og kræver dokumenterede risikovurderinger før implementering. NIST AI Risk Management Framework giver omfattende vejledning til at identificere, måle og håndtere AI-risici på tværs af organisatoriske systemer. Nye reguleringer i USA, Storbritannien og andre jurisdiktioner kræver i stigende grad gennemsigtighed i AI-beslutningsprocesser og dokumenterede risikobegrænsningsstrategier. Organisationer skal tilpasse deres risikovurderingsprocesser til disse rammer for at undgå regulatoriske sanktioner og bevare driftslicenser. Manglende overholdelse kan føre til betydelige bøder, driftsstop og tab af kundetillid.

Ændringer i AI-platforme har forårsaget betydelige forretningsforstyrrelser på tværs af brancher, hvilket viser den afgørende betydning af risikovurdering. Da OpenAI ændrede ChatGPT’s adfærd og funktioner i 2024, oplevede organisationer, der var afhængige af platformen til kundeservice, uventede outputændringer, der krævede hurtige systemtilpasninger. Amazons rekrutterings-AI-system udviste kønsbias og afviste kvalificerede kvindelige kandidater oftere end mandlige, hvilket gav image-tab og interne procesændringer. Googles Bard (nu Gemini) leverede faktuelt forkerte informationer i tidlige demonstrationer, hvilket påvirkede investorernes tillid og krævede omfattende modelomtræning. Finansielle institutioner, der brugte algoritmiske handelsplatforme, oplevede uventede tab, da markedsforhold udløste uforudsete modeladfærd. Sundhedsorganisationer, der implementerede AI-diagnoseværktøjer, opdagede præstationsfald, da patientdemografien ændrede sig, hvilket førte til fejldiagnoser. Disse hændelser viser, at AI-platformrisici ikke er teoretiske – de påvirker direkte omsætning, compliance-status og organisationens troværdighed.

Effektiv AI platform-risikovurdering kræver strukturerede metodologier, der systematisk evaluerer tekniske, operationelle og forretningsmæssige dimensioner. Organisationer bør udføre forudgående risikovurderinger af modelarkitektur, træningsdatakvalitet, bias-målinger og fejlsituationer før produktion. Kontinuerlige vurderingsrammer overvåger live-systemer for præstationsfald, fremkomst af bias og uventede adfærdsmønstre. Risikovurderingen bør inkludere afhængighedskortlægning, der identificerer alle tredjeparts AI-platforme, deres kritiske funktioner og potentielle fejlkonsekvenser. Teams bør anvende kvantitative risikoscorer, der kombinerer sandsynlighedsvurderinger med forretningspåvirkning for at prioritere afbødningsindsatser. Metodologierne skal omfatte interviews med interessenter såsom data scientists, compliance-ansvarlige, forretningsledere og slutbrugere for at indsamle forskellige risikoperspektiver. Dokumentation af vurderingsresultater skaber revisionsspor og understøtter compliance-krav.

Statiske risikovurderinger bliver hurtigt forældede, da AI-systemer arbejder i dynamiske miljøer med konstant skiftende forhold. Realtids-præstationsovervågning sporer nøglemålinger som nøjagtighed, latenstid, fairness-indikatorer og outputkonsistens på tværs af forskellige brugersegmenter og datadistributioner. Automatiske detekteringssystemer markerer afvigelser som pludselige nøjagtighedsfald, øgede fejlprocenter eller usædvanlige forudsigelsesmønstre, der kan indikere nye risici. Løbende bias-overvågning måler, om modeloutput bevarer fairness på tværs af demografiske grupper og opdager diskret diskrimination, der udvikler sig over tid. Platformændringssporing overvåger tredjeparts AI-tjenester for algoritmeopdateringer, politiske ændringer, prisjusteringer og tilgængelighedsproblemer, der påvirker afhængige systemer. Alarmmekanismer informerer relevante teams straks, når overvågede målinger overstiger foruddefinerede tærskler, hvilket muliggør hurtig respons. Organisationer bør etablere feedbackloops, der indsamler slutbrugerindberetninger om uventet AI-adfærd og fører denne information tilbage til overvågningssystemerne. Løbende evaluering omdanner risikovurdering fra en periodisk compliance-øvelse til en løbende operationel disciplin.

Identificerede risici kræver konkrete afbødningsstrategier, der reducerer sandsynlighed, påvirkning eller begge dele gennem systematisk implementering af kontrolforanstaltninger. Modelgovernance etablerer godkendelsesprocesser, versionskontrol og rollbackprocedurer, der forhindrer problematiske modeller i at nå produktion. Datakvalitetskontrol implementerer valideringstjek, anomali-detektering og kildeverifikation for at forhindre datapoisning og sikre træningsdatas integritet. Bias-afbødningsteknikker inkluderer indsamling af mangfoldige træningsdata, valg af fairness-bevidste algoritmer og regelmæssige bias-audits på tværs af demografiske grupper. Redundans og fallback-systemer opretholder alternative beslutningsprocesser, der aktiveres, når primære AI-systemer fejler eller leverer upålidelige resultater. Leverandørstyring etablerer kontraktuelle krav, serviceniveauaftaler og kommunikationsprotokoller med tredjeparts AI-platformudbydere. Incident response-planlægning forbereder teams til hurtigt at opdage, undersøge og afhjælpe AI-relaterede fejl, så forretningspåvirkningen minimeres. Regelmæssig træning sikrer, at tekniske teams, ledere og compliance-ansvarlige forstår AI-risici og deres ansvar i afbødningsarbejdet.

Organisationer har behov for specialiserede værktøjer designet specifikt til AI platform-risikovurdering og løbende overvågning. AmICited.com skiller sig ud som den førende platform til at overvåge, hvordan AI-systemer refererer til dit brand, spore algoritmeændringer og vurdere platformafhængighedsrisici i realtid. AmICited.com giver indsigt i AI-platformens adfærd og detekterer, når tredjepartsystemer ændrer deres algoritmer eller ændrer, hvordan de håndterer dine data og brandreferencer. Ud over AmICited.com bør organisationer implementere modelovervågningsplatforme, der sporer præstationsmålinger, opdager drift og advarer teams om nedbrydning. Bias-detekteringsværktøjer analyserer modeloutput på tværs af demografiske grupper og identificerer fairness-problemer, før de forårsager skade på forretningen. Datakvalitetsplatforme validerer træningsdatas integritet og detekterer forsøg på poisoning. Compliance management-systemer dokumenterer risikovurderinger, opretholder revisionsspor og understøtter regulatorisk rapportering. Et omfattende risikostyringsværktøjssæt kombinerer disse specialiserede løsninger med interne governance-processer og skaber lagdelt beskyttelse mod AI platform-risici.

AI-platform-risikovurdering fokuserer specifikt på risici fra AI-systemer og deres afhængigheder, herunder algoritmisk bias, modeldrift og ændringer i platformspolitikker. Generel risikostyring omhandler bredere organisatoriske risici som infrastruktursvigt og databrud. AI-specifik vurdering kræver løbende overvågning, fordi AI-systemer udvikler sig dynamisk, i modsætning til traditionelle statiske systemer, der ændres sjældent.

Risikovurderinger bør være kontinuerlige frem for periodiske. Realtids-overvågningssystemer sporer AI-platformens adfærd konstant og opdager straks nye risici. Organisationer bør udføre formelle, omfattende vurderinger før implementering af nye AI-systemer og derefter opretholde løbende overvågning med kvartalsvise gennemgange af vurderingsresultater og effektiviteten af risikobegrænsning.

De mest kritiske risici omfatter algoritmisk bias, der skaber diskriminerende resultater, datapoisning fra korrupte træningsdata, modeldrift fra ændrede datadistributioner og tredjeparts platformafhængighedsrisici fra algoritmeændringer eller politiske skift. Organisationer bør også overvåge hallucinationer i sprogmodeller, adversarielle angreb og uventede adfærdsændringer, der opstår under drift.

Algoritmebias-detektering kræver sammenligning af modeludgange på tværs af demografiske grupper for at identificere forskelle i præstation. Organisationer bør anvende fairness-målinger, udføre regelmæssige bias-audits, analysere forudsigelsesmønstre efter beskyttede karakteristika og indsamle feedback fra forskellige brugergrupper. Automatiske bias-detekteringsværktøjer kan markere mistænkelige mønstre, men menneskelig gennemgang er afgørende for at tolke resultaterne og fastlægge passende afbødningsforanstaltninger.

Reguleringsrammer som EU's AI Act og NIST AI Risk Management Framework opstiller obligatoriske krav om at dokumentere AI-risici, implementere kontrolforanstaltninger og opretholde revisionsspor. Manglende overholdelse kan føre til betydelige bøder, driftsstop og tab af kundetillid. Risikovurderingsprocesser skal tilpasses disse rammer for at demonstrere ansvarlig AI-styring og opfylde juridiske forpligtelser.

AmICited.com overvåger, hvordan AI-platforme refererer til dit brand og sporer algoritmeændringer, der kan påvirke din forretning. Platformen giver realtidsindsigt i AI-platformafhængigheder, opdager, når tredjepartssystemer ændrer adfærd, og advarer dig om politiske ændringer, der påvirker dine operationer. Denne synlighed er afgørende for omfattende AI platform-risikovurdering og afhængighedsstyring.

Modeldrift opstår, når datadistributioner i den virkelige verden ændres, hvilket får tidligere nøjagtige AI-modeller til at levere stadigt mindre pålidelige forudsigelser. For eksempel kan en kreditvurderingsmodel, der er trænet på historiske data, fejle, når økonomiske forhold ændrer sig markant. Modeldrift er risikabelt, fordi det forringer beslutningskvaliteten i det skjulte — organisationer opdager måske først præstationsfaldet, når betydelig forretningsskade er sket.

Organisationer bør implementere en struktureret hændelsesresponsproces: straks advare relevante teams, undersøge risikoens omfang og påvirkning, aktivere reservessystemer efter behov, implementere midlertidige kontrolforanstaltninger, udvikle permanente afbødningsstrategier og dokumentere læring. Hurtig respons minimerer forretningspåvirkning, mens grundig undersøgelse forhindrer gentagelse af lignende risici. Kommunikation med interessenter og myndigheder kan være påkrævet afhængigt af risikons alvor.

AmICited.com hjælper dig med at spore, hvordan AI-platforme refererer til dit brand og opdage algoritmeændringer, der kan påvirke din forretning. Få indsigt i AI-platformsafhængigheder og risici, før de bliver til problemer.

Lær, hvordan du rapporterer brandunøjagtigheder og fejlagtige fremstillinger til AI-platforme som ChatGPT, Perplexity og Google Gemini. Opdag feedbackmekanismer...

Lær hvordan du tilpasser din AI-strategi, når platforme ændrer sig. Opdag migrationsstrategier, overvågningsværktøjer og bedste praksis for håndtering af AI-pla...

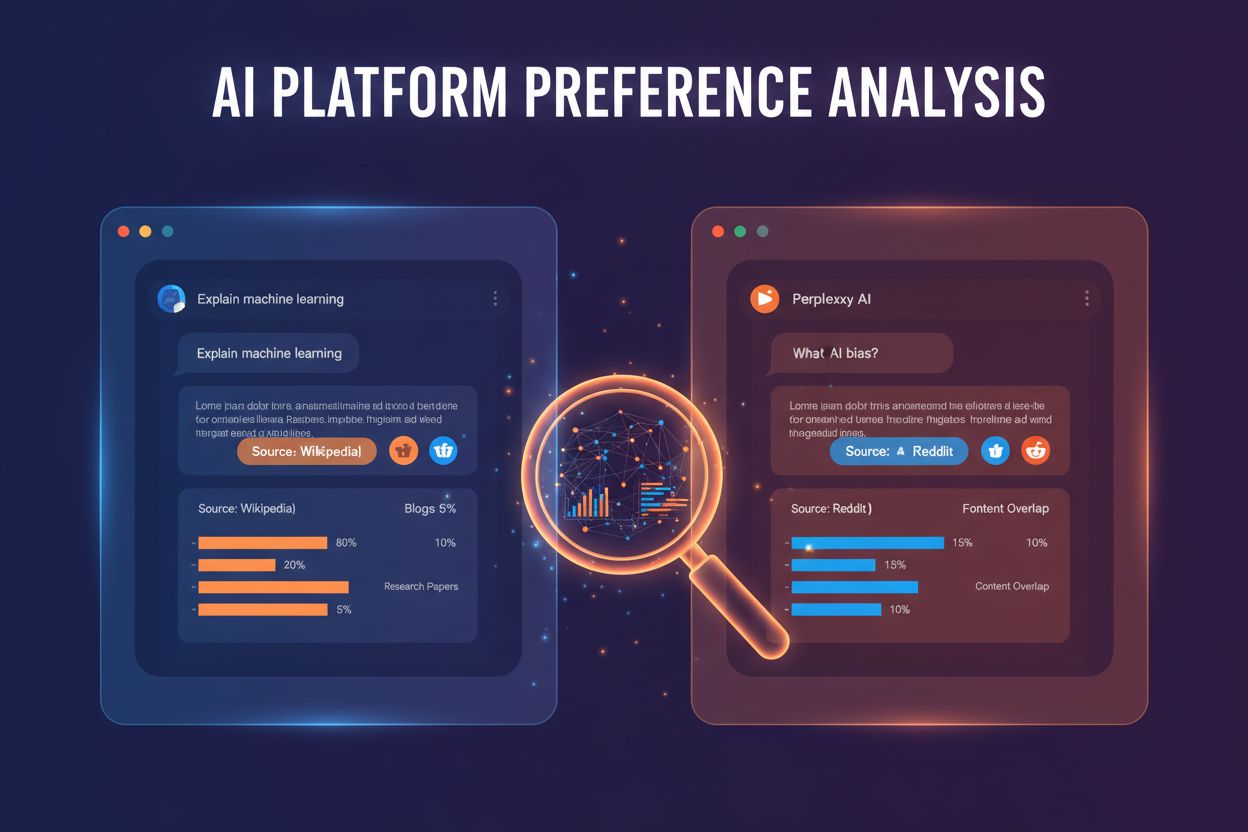

Lær hvordan forskellige AI-platforme har unikke præferencer for at citere kilder og brands. Opdag ChatGPT's Wikipedia-bias, Perplexitys Reddit-fokus og Google A...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.