Sådan konfigurerer du robots.txt til AI-crawlere: Komplet guide

Lær hvordan du konfigurerer robots.txt for at kontrollere AI-crawleres adgang, herunder GPTBot, ClaudeBot og Perplexity. Administrer din brands synlighed i AI-g...

Konfiguration af robots.txt med user-agent-regler specifikt målrettet AI-crawlere. AI-specifik robots.txt gør det muligt for webstedsejere at kontrollere, hvordan kunstig intelligens-systemer, store sprogmodeller og AI-træningsbots tilgår og bruger deres indhold. Den skelner mellem forskellige typer af AI-crawlere - træningscrawlere, søgecrawlere og brugerudløste fetchere - hvilket muliggør granulær kontrol over indholdssynlighed for AI-systemer. Denne konfiguration er blevet kritisk, da AI-crawlere nu udgør cirka 80% af bottrafik til mange websteder.

Konfiguration af robots.txt med user-agent-regler specifikt målrettet AI-crawlere. AI-specifik robots.txt gør det muligt for webstedsejere at kontrollere, hvordan kunstig intelligens-systemer, store sprogmodeller og AI-træningsbots tilgår og bruger deres indhold. Den skelner mellem forskellige typer af AI-crawlere - træningscrawlere, søgecrawlere og brugerudløste fetchere - hvilket muliggør granulær kontrol over indholdssynlighed for AI-systemer. Denne konfiguration er blevet kritisk, da AI-crawlere nu udgør cirka 80% af bottrafik til mange websteder.

AI-specifik robots.txt-konfiguration refererer til praksis med at skabe målrettede regler i din robots.txt-fil, der specifikt adresserer kunstig intelligens-crawlere og træningsbots, adskilt fra traditionelle søgemaskinecrawlere som Googlebot. Mens konventionel robots.txt historisk har fokuseret på at administrere Googlebot, Bingbot og andre søgeindeksere, har fremkomsten af store sprogmodeller og AI-træningssystemer skabt en helt ny kategori af bottrafik, der kræver separate administrationsstrategier. Ifølge nylige data fra november 2025 udgør AI-crawlere nu cirka 80% af al bottrafik til mange udgiverwebsteder.

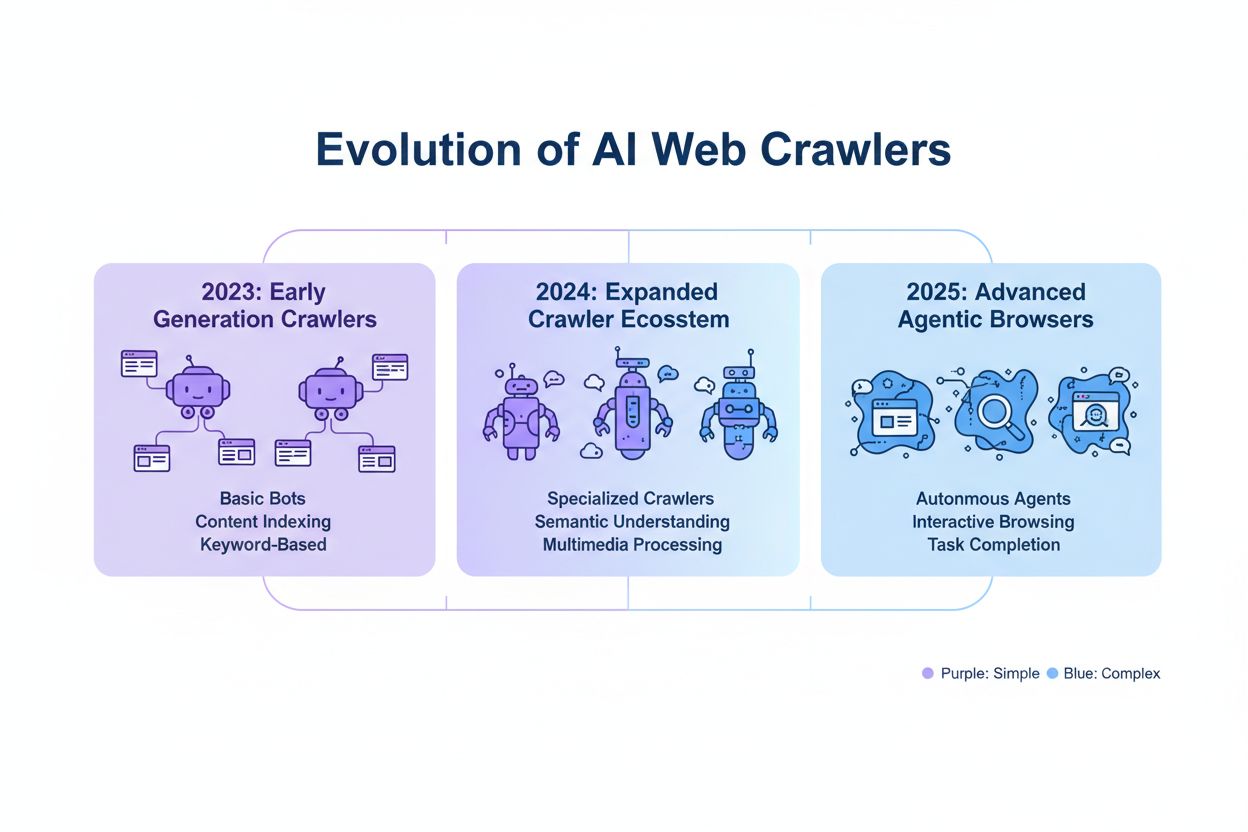

AI-crawlere falder i tre forskellige operationelle kategorier, hver med forskellige karakteristika, trafikimplikationer og strategiske overvejelser for udgivere. Træningscrawlere er designet til at indsamle store mængder tekstdata til maskinlæringsmodelludvikling; de opererer typisk med høje båndbreddekrav, genererer betydelig serverbelastning og giver nul henvisningstrafik til gengæld. Søge- og citationscrawlere fungerer på samme måde som traditionelle søgemaskiner ved at indeksere indhold til hentning og give attribution. Brugerudløste crawlere opererer on-demand, når slutbrugere eksplicit anmoder om AI-analyse af en webside.

| Crawlerkategori | Formål | Trafikvolumen | Henvisningspotentiale | Indholdsrisiko | Eksempler |

|---|---|---|---|---|---|

| Træning | Modeludvikling | Meget høj | Ingen | Meget høj | GPTBot, ClaudeBot |

| Søgning/Citation | Indholdsindeksering og attribution | Moderat | Moderat | Moderat | OAI-SearchBot, Google AI |

| Brugerudløst | On-demand analyse | Lav | Lav | Lav | ChatGPT Web Browse, Claude |

De større AI-virksomheder, der opererer crawlere, inkluderer OpenAI, Anthropic, Google, Meta, Apple og Amazon, hver med distinkte user-agent-strenge, der muliggør identifikation i serverlogs og robots.txt-konfiguration. OpenAI opererer flere crawlere: GPTBot (user-agent: GPTBot/1.0) til indsamling af træningsdata, OAI-SearchBot (user-agent: OAI-SearchBot/1.0) til søge- og citationsindeksering, og ChatGPT-User (user-agent: ChatGPT-User/1.0) til brugerudløst webbrowsing.

Den grundlæggende syntaks for AI-specifikke robots.txt-regler følger standard robots.txt-formatet med user-agent-matching og allow/disallow-direktiver målrettet specifikke crawlere. For at blokere OpenAIs GPTBot fra trænedataindsamling, mens deres søgecrawler tillades, strukturer din robots.txt som følger:

User-agent: GPTBot

Disallow: /

User-agent: OAI-SearchBot

Allow: /

For mere granulær kontrol kan du anvende sti-specifikke regler, der blokerer visse sektioner, mens andre tillades.

Beslutningen om at blokere eller tillade AI-crawlere involverer fundamentale afvejninger mellem indholdsbeskyttelse og synlighed, der varierer betydeligt baseret på din forretningsmodel og indholdsstrategi. Blokering af træningscrawlere som GPTBot eliminerer helt risikoen for, at dit indhold bruges til at træne proprietære AI-modeller uden kompensation, men det betyder også, at dit indhold ikke vil optræde i AI-genererede svar.

Mens robots.txt giver en klar mekanisme til at kommunikere crawlpolitikker, er den fundamentalt rådgivende og ikke juridisk håndhævelig. IP-verifikation og allowlisting repræsenterer den mest pålidelige håndhævelsesmetode. Firewall-regler og blokering på serverniveau giver den stærkeste håndhævelsesmekanisme.

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} GPTBot [NC]

RewriteRule ^.*$ - [F,L]

</IfModule>

Implementering af effektiv AI-specifik robots.txt-konfiguration kræver en omfattende tilgang, der balancerer indholdsbeskyttelse med strategiske synlighedsmål. Start med en klar indholdsbeskyttelsespolitik, der definerer, hvilke indholdskategorier der kræver blokering versus hvilke der trygt kan eksponeres for AI-crawlere. Implementer en lagdelt blokeringsstrategi, der skelner mellem træningscrawlere (typisk blokér), søgecrawlere (typisk tillad med overvågning) og brugerudløste crawlere (typisk tillad). Kombiner robots.txt med håndhævelse på serverniveau ved at implementere firewall-regler og IP-verifikation for dit mest følsomme indhold. Brug værktøjer som AmICited.com til at overvåge dit indholds synlighed på tværs af AI-systemer og forstå impacten af dine blokeringsbeslutninger på AI-opdagelse og citation.

Træningscrawlere som GPTBot og ClaudeBot indsamler data til modeludvikling og giver nul henvisningstrafik, hvilket gør dem højrisiko for indholdsbeskyttelse. Søgecrawlere som OAI-SearchBot og PerplexityBot indekserer indhold til AI-drevet søgning og kan sende henvisningstrafik gennem citationer. De fleste udgivere blokerer træningscrawlere, mens de tillader søgecrawlere for at balancere indholdsbeskyttelse med synlighed.

Google udtaler officielt, at blokering af Google-Extended ikke påvirker søgerangeringer eller inklusion i AI Overviews. Dog har nogle webmastere rapporteret bekymringer, så overvåg din søgepræstation efter implementering af blokeringer. AI Overviews i Google Search følger standard Googlebot-regler, ikke Google-Extended.

Ja, robots.txt er et rådgivende snarere end håndhæveligt standard. Velopdragne crawlere fra større virksomheder respekterer generelt robots.txt-direktiver, men nogle crawlere ignorerer dem. For stærkere beskyttelse, implementer blokering på serverniveau via .htaccess eller firewall-regler, og verificer legitime crawlere ved hjælp af offentliggjorte IP-adresseintervaller.

Gennemgå og opdater din blokliste minimum kvartalsvis. Nye AI-crawlere dukker op regelmæssigt, så tjek serverlogs månedligt for at identificere nye crawlere, der rammer dit websted. Spor community-ressourcer som ai.robots.txt GitHub-projektet for opdateringer om fremvoksende crawlere og user-agent-strenge.

Dette afhænger af dine forretningsprioriteter. Blokering af træningscrawlere beskytter dit indhold mod at blive inkorporeret i AI-modeller uden kompensation. Blokering af søgecrawlere kan reducere din synlighed på AI-drevne opdagelsesplatforme som ChatGPT-søgning eller Perplexity. Mange udgivere vælger selektiv blokering, der målretter træningscrawlere, mens de tillader søge- og citationscrawlere.

Tjek dine serverlogs for crawler user-agent-strenge og verificer, at blokerede crawlere ikke tilgår dine indholdssider. Brug analyseværktøjer til at overvåge bottrafikmønstre. Test din konfiguration med Knowatoa AI Search Console eller Merkle robots.txt Tester for at validere, at dine regler fungerer som tilsigtet.

Agentiske browser-crawlere som ChatGPT Atlas og Google Project Mariner opererer som fuldt udstyrede webbrowsere snarere end simple HTTP-klienter. De bruger ofte standard Chrome user-agent-strenge, hvilket gør dem umulige at skelne fra almindelig browsertrafik. IP-baseret blokering bliver nødvendig for at kontrollere adgang til disse avancerede crawlere.

AI-specifik robots.txt kontrollerer adgang til dit indhold, mens værktøjer som AmICited overvåger, hvordan AI-platforme refererer til og citerer dit indhold. Sammen giver de komplet synlighed og kontrol: robots.txt administrerer crawleradgang, og overvågningsværktøjer sporer dit indholds impact på tværs af AI-systemer.

AmICited sporer, hvordan AI-systemer som ChatGPT, Claude, Perplexity og Google AI Overviews citerer og refererer til dit brand. Kombiner robots.txt-konfiguration med AI-synlighedsovervågning for at forstå dit indholds impact på tværs af AI-platforme.

Lær hvordan du konfigurerer robots.txt for at kontrollere AI-crawleres adgang, herunder GPTBot, ClaudeBot og Perplexity. Administrer din brands synlighed i AI-g...

Fællesskabsdiskussion om konfiguration af robots.txt til AI-crawlere som GPTBot, ClaudeBot og PerplexityBot. Reelle erfaringer fra webansvarlige og SEO-speciali...

Lær hvilke AI-crawlere du skal tillade eller blokere i din robots.txt. Omfattende guide, der dækker GPTBot, ClaudeBot, PerplexityBot og 25+ AI-crawlere med konf...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.