Hvordan benchmarker jeg AI-synlighed mod konkurrenter? Komplet guide

Lær hvordan du benchmarker AI-synlighed mod konkurrenter på tværs af ChatGPT, Perplexity og andre AI-platforme. Opdag metrikker, værktøjer og strategier til at ...

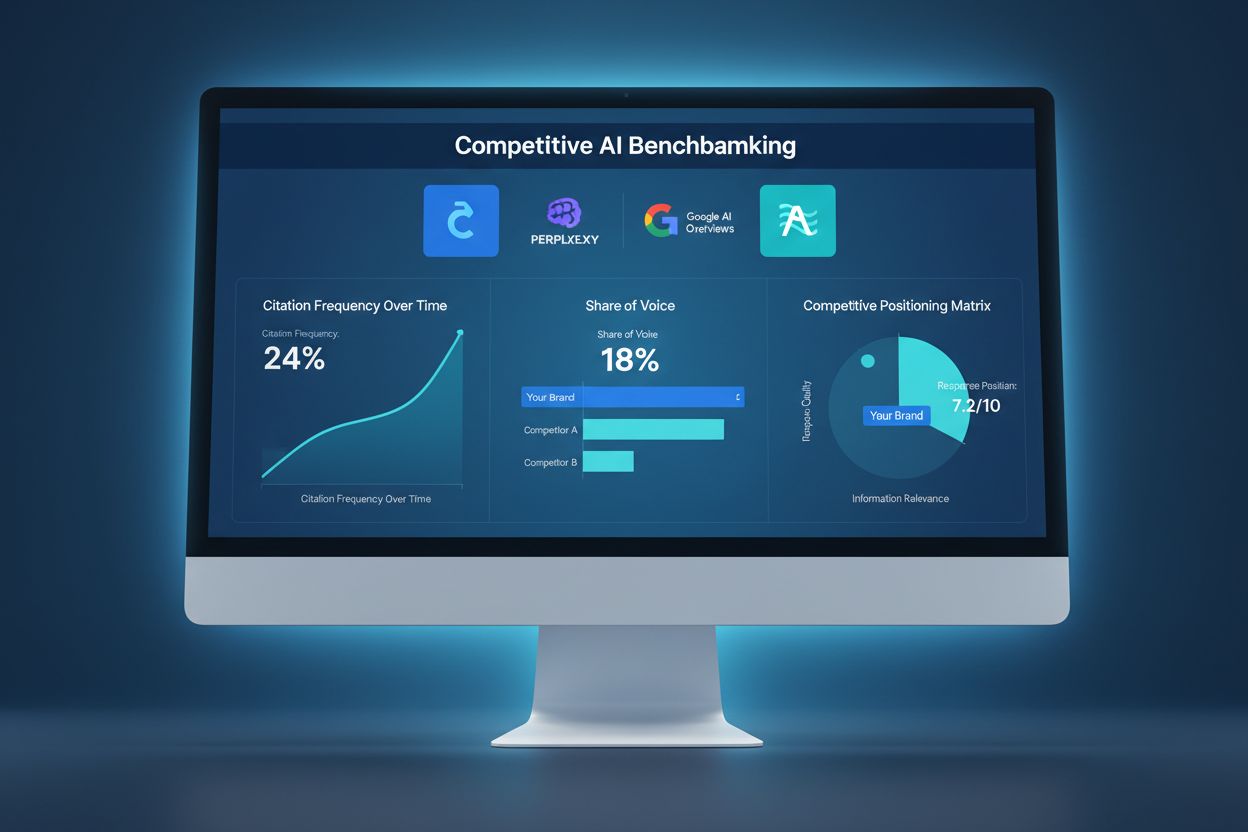

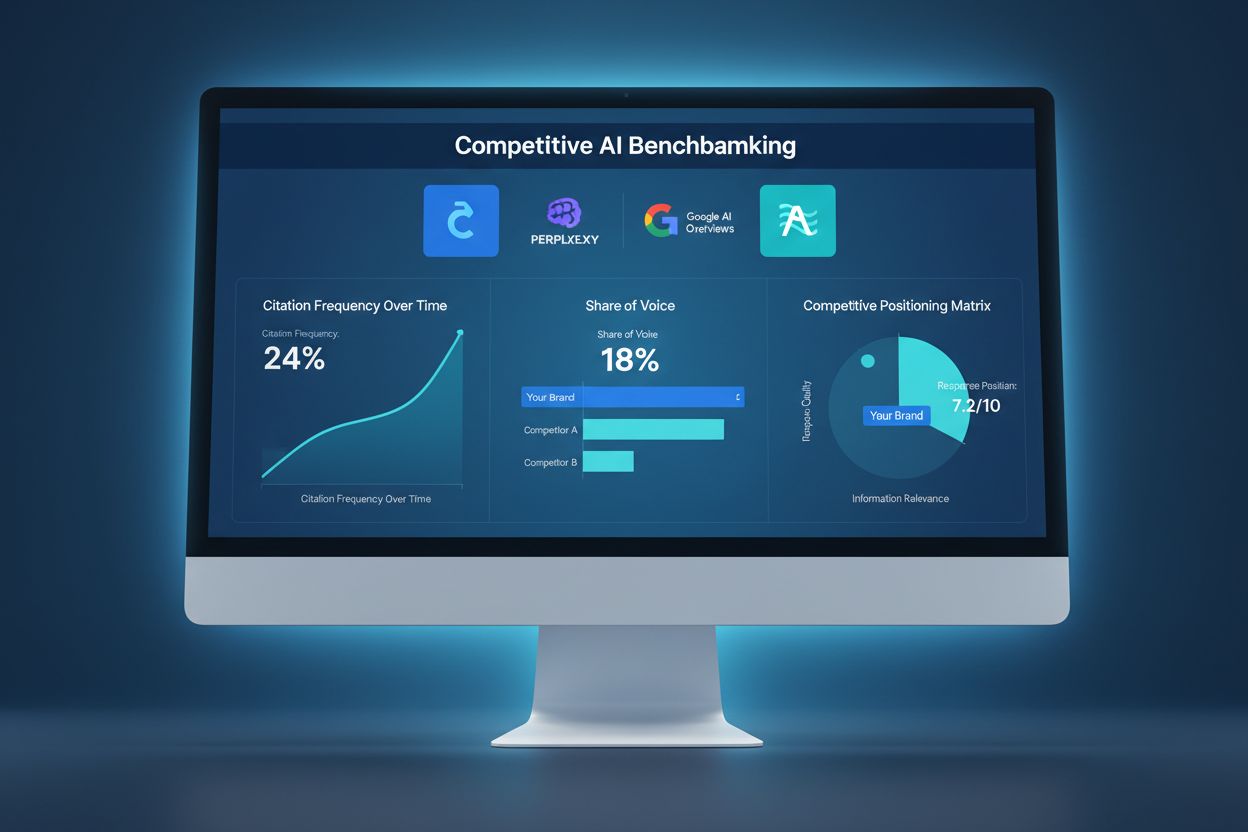

Konkurrencedygtig AI-benchmarking er den systematiske proces, hvor du sammenligner din virksomheds synligheds-metrics med branchens konkurrenter og ledere på AI-platforme som ChatGPT, Perplexity og Google AI Overviews. Det måler citationsfrekvens, responspositionering og share of voice for at identificere konkurrencemæssige huller og muligheder for at forbedre AI-drevet synlighed og kundeanskaffelse.

Konkurrencedygtig AI-benchmarking er den systematiske proces, hvor du sammenligner din virksomheds synligheds-metrics med branchens konkurrenter og ledere på AI-platforme som ChatGPT, Perplexity og Google AI Overviews. Det måler citationsfrekvens, responspositionering og share of voice for at identificere konkurrencemæssige huller og muligheder for at forbedre AI-drevet synlighed og kundeanskaffelse.

Konkurrencedygtig AI-benchmarking repræsenterer et grundlæggende skift i, hvordan organisationer måler deres synlighed og indflydelse i det digitale landskab. I modsætning til traditionel SEO-benchmarking, som fokuserer på søgemaskinerangeringer og klikrater, måler konkurrencedygtig AI-benchmarking, hvor ofte dit indhold optræder i AI-genererede svar på tværs af platforme som ChatGPT, Google AI Overviews og Perplexity. Denne sondring er afgørende, fordi 73 % af AI-forespørgsler resulterer i nul klik, hvilket betyder, at synlighed i AI-svar er blevet en primær driver for brandautoritet og kundeanskaffelse frem for en sekundær trafikkilde. Skiftet fra søgerangeringer til AI-citationer afspejler en bredere transformation i, hvordan brugere opdager information—de stiller i stigende grad spørgsmål til AI-assistenter i stedet for at taste forespørgsler i søgebokse. Organisationer, der undlader at overvåge og optimere for AI-synlighed, risikerer at miste betydelige markedsandele til konkurrenter, der aktivt håndterer deres tilstedeværelse på disse nye platforme. Denne nye benchmarkingtilgang kræver andre metrics, værktøjer og strategier end traditionel SEO, hvilket gør det essentielt for fremsynede virksomheder at forstå og implementere konkurrencedygtige AI-benchmarkingrammer.

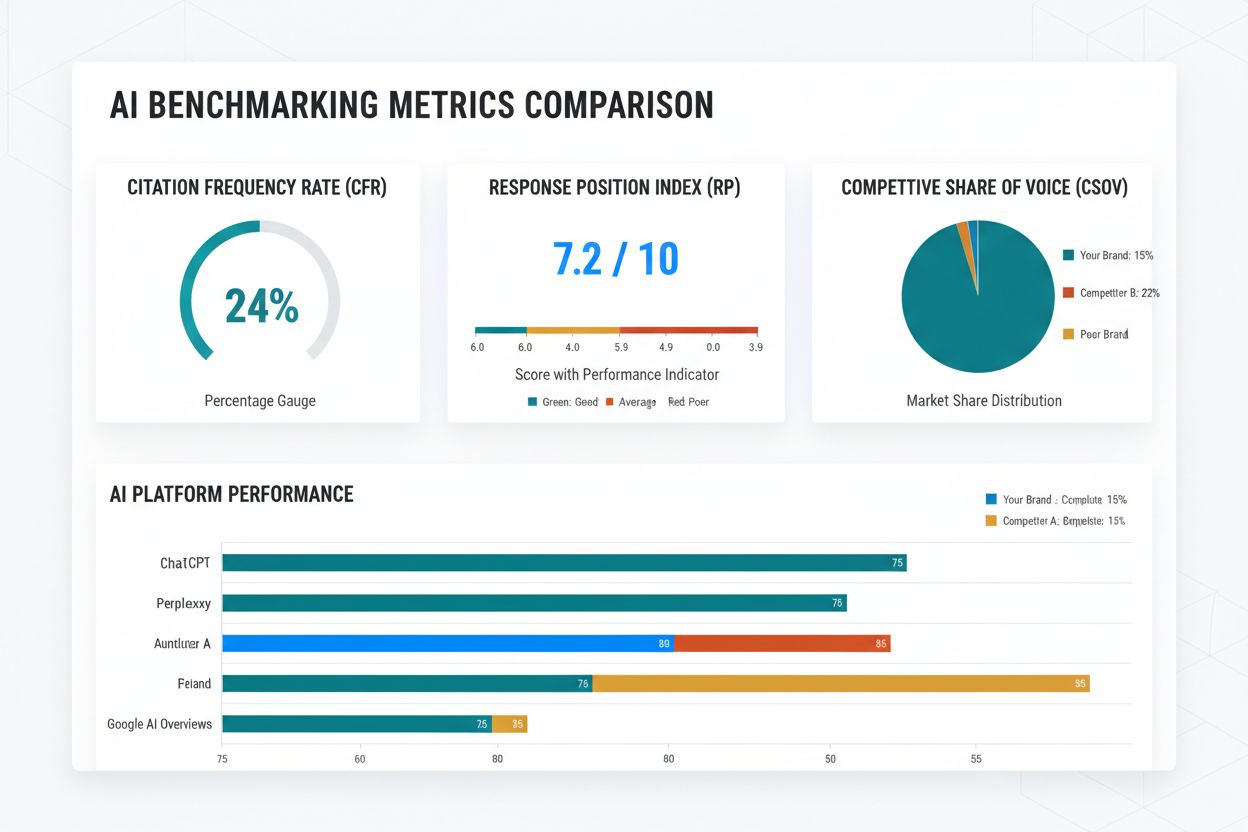

Måling af succes med konkurrencedygtig AI-benchmarking kræver forståelse af tre primære metrics, der indikerer din synlighed og performance i forhold til konkurrenterne. Citationsfrekvens (CFR) måler, hvor ofte dit indhold optræder i AI-genererede svar på de overvågede platforme, typisk udtrykt som citationer pr. 1.000 forespørgsler i din branche. Branchens benchmarks for CFR varierer betydeligt: B2B SaaS-virksomheder opnår typisk 15-35 citationer pr. 1.000 forespørgsler, mens E-commerce brands gennemsnitligt ligger på 8-20, Sundhedsorganisationer 12-28, Finansvirksomheder 18-40 og Uddannelsesinstitutioner 20-45. Responspositionsindeks (RPI) vurderer, hvor dine citationer optræder i AI-svar—citationer blandt de første tre kilder tæller væsentligt mere end dem, der vises senere, og citationer på førstepladsen er cirka 3 gange mere værd end dem på femtepladsen. Konkurrencemæssig share of voice (CSOV) beregner din citationsprocent i forhold til konkurrenter og afslører din markedsposition. Hvis din branche genererer 1.000 citationer blandt alle konkurrenter og du modtager 150, er din CSOV 15 %. Tabellen nedenfor skitserer disse metrics med målbenchmarks:

| Metric | Definition | Target Benchmark |

|---|---|---|

| Citationsfrekvens (CFR) | Citationer pr. 1.000 brancheforespørgsler | 15-40 (varierer pr. branche) |

| Responspositionsindeks (RPI) | Gennemsnitlig position for citationer i svar | Top 3 kilder (70 %+ af citationer) |

| Konkurrencemæssig share of voice (CSOV) | Dine citationer vs. totale konkurrent-citationer | 20-35 % for markedsledere |

AI-landskabet omfatter flere platforme, hver med forskellige brugerbaser, forespørgselsmønstre og citationsmekanismer, der kræver individuelle overvågningsstrategier. Forståelse af platformspecifikke forskelle er essentielt, da optimering til ChatGPT adskiller sig markant fra optimering til Google AI Overviews. De fem største platforme, du bør overvåge, er:

Hver platform vægter kilder forskelligt, prioriterer forskellige indholdstyper og betjener forskellige brugersegmenter. ChatGPT favoriserer omfattende, autoritative kilder; Google AI Overviews vægter emnerelevans og E-E-A-T-signaler; Perplexity belønner citerede, gennemsigtige kilder; Claude værdsætter detaljeret, velstruktureret information; og Gemini integrerer Googles eksisterende rangeringssignaler. Overvågning af alle fem platforme giver et komplet billede af din konkurrencemæssige position på tværs af AI-økosystemet.

Identificering af de rigtige konkurrenter til benchmarking kræver, at du går videre end traditionelle markedsaktører og inkluderer indholdskonkurrenter—organisationer, der rangerer for lignende forespørgsler og emner, uanset branche. Start med at analysere, hvilke konkurrenter der oftest optræder i AI-svar for dine målrettede søgeord og emner. Opret et konkurrencemæssigt synligheds-heatmap ved at kortlægge konkurrenter på to akser: citationsfrekvens (lodret) og gennemsnitlig responsposition (vandret). Denne visualisering viser, hvilke konkurrenter der dominerer dit felt, og hvilke der indtager nichepositioner. Udfør gapanalyse ved at sammenligne din citationsprofil med top-performere—identificér emner, hvor konkurrenter modtager citationer, men du ikke gør, samt områder hvor du er underrepræsenteret i forhold til markedsandel. Implementér kildeautoritetmapping ved at spore, hvilke specifikke sider, indhold og domæner fra hver konkurrent oftest modtager citationer. Dette afslører, hvilke indholdstyper og emner AI-systemerne favoriserer. Udled handlekraftige indsigter gennem struktureret analyse:

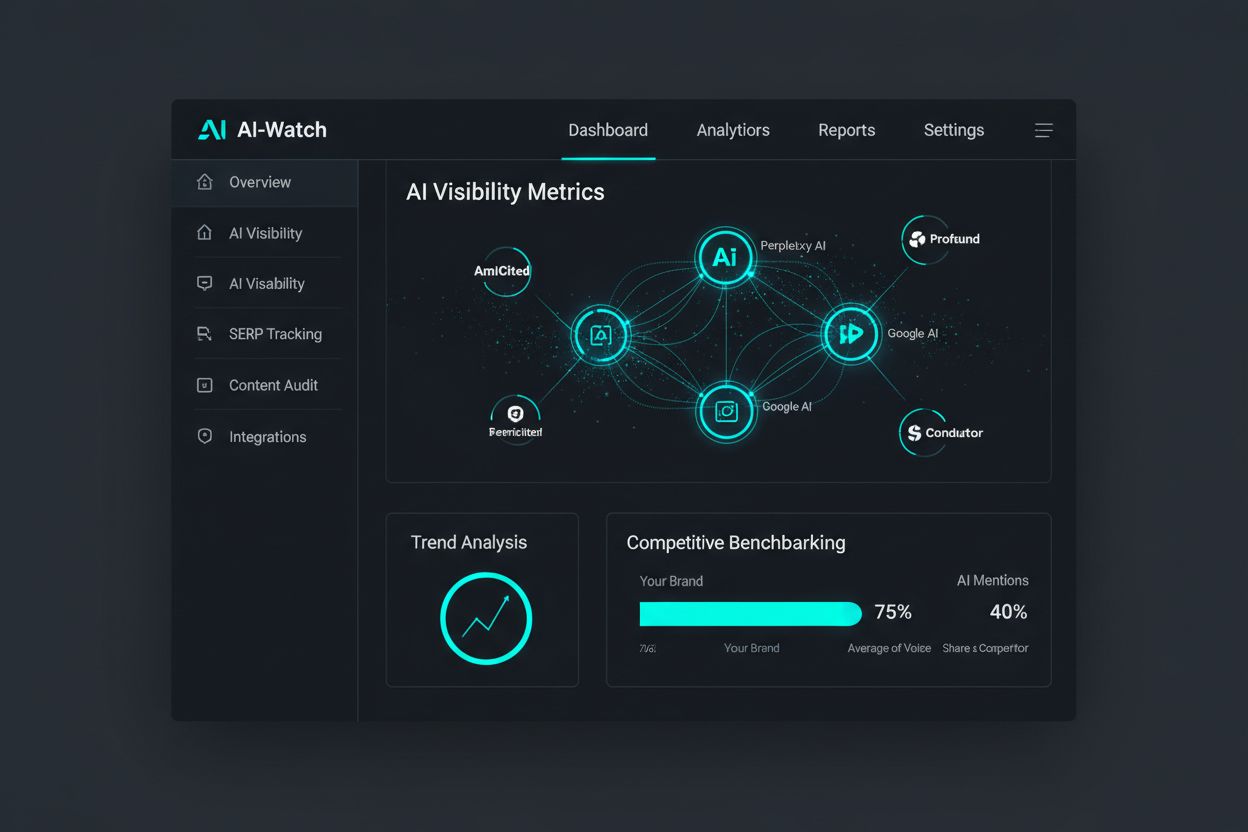

Overvågning af AI-synlighed kræver specialiserede værktøjer, der er udviklet specifikt til at spore citationer på tværs af flere AI-platforme. Markedet opdeles i tre niveauer: enterprise-løsninger med omfattende multi-platform-overvågning og avanceret analyse, mid-market-værktøjer med solide features til moderate priser og SMB-løsninger med basale trackingmuligheder til overkommelige omkostninger. Nøglefunktioner at evaluere omfatter dækning af flere platforme (ChatGPT, Google AI Overviews, Perplexity, Claude, Gemini), realtidsovervågning, konkurrencemæssig benchmarking, historisk trendanalyse og integration med eksisterende marketingsystemer. Tabellen nedenfor sammenligner førende løsninger:

| Tool | Features | Price Range | Best For |

|---|---|---|---|

| AmICited.com | Realtidsovervågning af AI-svar, konkurrencemæssig benchmarking, multi-platform tracking, detaljeret kildeanalyse | Enterprise/Custom | Omfattende AI-synlighedsstyring |

| FlowHunt.io | Indholdsgenerering, automatisering, AI-optimering, workflow-integration | $99-499/md | Indholdsskabelse og optimeringsworkflows |

| Profound | AI-synlighedssporing, citationsanalyse, konkurrentovervågning | $500-2000/md | Mid-market konkurrencemæssig analyse |

| Semrush AIO | Integreret SEO + AI-synlighed, søgeordsresearch, indholdsoptimering | $120-450/md | Kombineret SEO og AI-benchmarking |

| Conductor | Enterprise AI-overvågning, avanceret analyse, tilpasset rapportering | Custom pricing | Store virksomhedsløsninger |

| Hall | AI-svarsporing, kildeattribution, trendanalyse | $299-999/md | Specialiseret AI-synlighedsovervågning |

AmICited.com er det førende produkt til overvågning af AI-svar og tilbyder den mest omfattende multi-platform tracking, realtids-citationsopdateringer og konkurrencemæssige benchmarkingfunktioner, der er udviklet til AI-æraen. Dets avancerede analyser viser ikke bare, at du bliver citeret, men også hvor, hvor ofte og i hvilken kontekst på alle større AI-platforme. FlowHunt.io fungerer som et fremragende supplement og automatiserer indholdsskabelse og optimeringsworkflows for at hjælpe dig med at producere det kvalitetsindhold, der driver citationer. Integrationsmuligheder er vigtige—sørg for at dit valgte værktøj kan kobles til dit analytics-setup, CMS og marketing-automatiseringssystemer for at skabe et samlet workflow til konkurrencemæssig intelligence.

Implementering af konkurrencedygtig AI-benchmarking kræver en systematisk, trinvis tilgang, der etablerer baseline-metrics før optimeringsindsatsen begynder. Følg disse seks implementeringstrin:

Etabler baseline-metrics (Uge 1-2) – Kortlæg din nuværende AI-synlighed på alle fem store platforme og dokumentér din CFR, RPI og CSOV. Denne baseline bliver dit målegrundlag for fremtidig fremdrift og ROI.

Vælg 3-5 primære konkurrenter (Uge 2-3) – Udvælg konkurrenter ud fra citationsfrekvens i dine målrettede forespørgsler og emner. Inkludér både direkte markedsaktører og indholdskonkurrenter.

Kategorisér målrettede forespørgsler (Uge 3-4) – Organisér dit søgeordsunivers i 4-6 kategorier (produktrelaterede, uddannelsesmæssige, sammenligninger, problemløsning, branchenyheder, thought leadership). Alloker 50-100 forespørgsler pr. kategori til overvågning.

Konfigurér overvågningsparametre (Uge 4-5) – Opsæt tracking i dit valgte værktøj med daglig overvågning for højprioriterede forespørgsler og ugentlig for sekundære. Etabler alarmgrænser for markante ændringer i citationsfrekvens eller konkurrencesituation.

Implementér datainnsamling (Uge 5-6) – Begynd at indsamle baselinedata på tværs af alle platforme. Dokumentér ikke kun citationsforekomst, men også kildeposition, svar-kontekst og forespørgselskarakteristika.

Etabler review-kadence (Uge 6+) – Planlæg ugentlige konkurrencemæssige analysegennemgange, månedlige strategisessioner og kvartalsvise omfattende benchmarkingrapporter. Tildel ansvar for overvågnings- og optimeringsaktiviteter.

De fleste organisationer opnår stabile baseline-data inden for 30-45 dage, hvilket muliggør meningsfuld konkurrencemæssig analyse fra uge 7-8. Forvent at hele implementeringscyklussen tager 8-12 uger, før optimeringsindsatsen giver målbare forbedringer i citationer.

Konkurrencedygtig AI-benchmarking bliver først værdifuldt, når det omsættes til konkrete optimeringshandlinger. Brug dine benchmarkingindsigter til at identificere og lukke synlighedshuller via målrettede indholds- og autoritetsinitiativer. Implementér disse gennemprøvede taktikker:

Identifikation af indholdshuller – Analyser konkurrenters citationer for at finde værdifulde emner, hvor de modtager citationer, men du er fraværende. Skab omfattende indhold, der dækker disse huller med overlegen dybde og kvalitet.

Udvikling af emneautoritet – Byg tematiske klynger omkring dine kernekompetencer og skab sammenhængende indhold, der etablerer omfattende ekspertise. AI-systemer belønner sites, der viser dyb, flerstrenget viden om specifikke emner.

Styrkelse af E-E-A-T-signaler – Forbedr Experience, Expertise, Authoritativeness og Trustworthiness gennem forfatterbiografier, credentials, publiceringshistorik og tredjepartsvalidering. AI-systemer vægter disse signaler stadigt højere i citationsbeslutninger.

Optimering af schema markup – Implementér strukturerede data (Article, NewsArticle, FAQPage, HowTo-schemas), der hjælper AI-systemer med at forstå og udtrække dit indhold effektivt.

Regelmæssige opdateringer af indhold – Opdater stærkt indhold kvartalsvist med nye data, eksempler og indsigter. AI-systemer favoriserer aktuelt, løbende opdateret indhold frem for statiske sider.

Optimeringscyklussen kører løbende—overvåg citationsændringer ugentligt, justér taktikker månedligt og gennemfør omfattende strategireviews kvartalsvist. Denne iterative tilgang sikrer, at din konkurrencemæssige position styrkes over tid, efterhånden som du akkumulerer citationer og autoritetssignaler.

Konkurrencedygtig AI-benchmarking skaber målbar forretningsværdi gennem øget kvalificeret trafik, styrket brandautoritet og hurtigere kundeanskaffelse. Organisationer, der implementerer omfattende AI-benchmarkingrammer, opnår typisk 40-60 % stigning i kvalificeret trafik fra AI-kilder inden for seks måneder, med vedvarende vækst gennem de første tolv måneder. Citationssynlighed har direkte indflydelse på kundeanskaffelse, hvor 15-25 % af nye kunder tilskrives AI-omtale for organisationer med stærk AI-synlighed. Tillidseffekten er lige så markant—organisationer med høj citationsfrekvens oplever 3,2 gange højere trust scores sammenlignet med konkurrenter med begrænset AI-tilstedeværelse. De fleste opnår ROI inden for 90 dage, hvor omkostningerne til overvågnings- og optimeringsværktøjer opvejes af øget kvalificeret trafik og kundeanskaffelse i første kvartal. Den konkurrencemæssige fordel forstærkes over tid, efterhånden som din citationsfrekvens vokser i forhold til konkurrenterne og skaber et stigende synlighedsgab. For en typisk B2B SaaS-virksomhed med 2 mio. dollars i årlig omsætning genererer forbedring af AI-synlighed fra 5 % til 20 % CSOV typisk 400.000-600.000 dollars i øget årlig omsætning inden for 12 måneder. Investeringen i konkurrencedygtig AI-benchmarking—typisk $500-2000 pr. måned for værktøjer og ressourcer—giver 5-10x ROI det første år og er dermed en af de bedste marketinginvesteringer i det nuværende landskab.

Traditionel SEO-benchmarking fokuserer på søgemaskinerangeringer og klikrater, hvor din placering i søgeresultaterne måles (1-10). AI-benchmarking måler, hvor ofte dit indhold optræder i AI-genererede svar og i hvilken kontekst. Da 73 % af AI-forespørgsler resulterer i nul klik, er AI-synlighed blevet en primær trafikdriver frem for en sekundær. AI-benchmarking kræver andre metrics (citationsfrekvens, responsposition, share of voice) og andre optimeringsstrategier end traditionel SEO.

Implementér ugentlig overvågning for højprioriterede forespørgsler og månedlig for sekundære forespørgsler. Udfør ugentlige konkurrencemæssige analyser for at identificere pludselige ændringer, månedlige strategisessioner for at justere taktikker og kvartalsvise omfattende benchmarkingrapporter for at måle fremdrift. Denne kadence gør det muligt at reagere hurtigt på konkurrencetrusler, mens du bevarer det strategiske fokus på langsigtede synlighedsforbedringer.

Prioritér ud fra dit publikum og forretningsmodel. Google AI Overviews (45 % af AI-drevet trafik) bør være alles højeste prioritet. ChatGPT (30 % markedsandel) er vigtig for B2B og virksomhedspublikum. Perplexity (15 % og stigende) er relevant for forsknings- og videnarbejdere. Claude (7 %) og Gemini (3 %) er sekundære, men voksende. Start med de 2-3 vigtigste platforme og udvid efterhånden som ressourcerne tillader det.

De tre primære metrics er Citationsfrekvens (CFR) – hvor ofte dit indhold optræder i AI-svar, Responspositionsindeks (RPI) – hvor dine citationer placeres i svarene, og Konkurrencemæssig share of voice (CSOV) – dine citationer som procentdel af det samlede antal citationer blandt konkurrenter. Spor CFR ugentligt, overvåg RPI for at sikre top-3 placering, og mål CSOV månedligt for at forstå din konkurrencesituation i forhold til markedslederne.

Identificér tre typer konkurrenter: direkte markedsaktører i din branche, indholdskonkurrenter der rangerer for lignende emner uanset branche, og aspirerende konkurrenter som repræsenterer dine vækstmål. Analyser hvilke konkurrenter der oftest optræder i AI-svar for dine målrettede søgeord. Start med 3-5 primære konkurrenter og udvid til 10+ efterhånden som din overvågning modnes. Inkludér både markedsledere og nye konkurrenter for at forstå hele det konkurrencemæssige landskab.

Branchens benchmarks varierer betydeligt. B2B SaaS-virksomheder opnår typisk 15-35 citationer pr. 1.000 forespørgsler, E-commerce brands 8-20, Sundhed 12-28, Finans 18-40 og Uddannelse 20-45. For konkurrencemæssig share of voice opnår markedsledere typisk 35-45 %, stærke konkurrenter 20-30 %, og nye brands 5-15 %. Sigt efter at opnå 'gennemsnitlig' performance inden for 6 måneder og 'leder'-performance inden for 18 måneder. Brug disse benchmarks til at sætte realistiske kvartalsvise forbedringsmål.

Forvent en etableringsperiode på 30-45 dage før meningsfuld analyse kan påbegyndes. De fleste organisationer opnår 10-20 % forbedring i citationer inden for 90 dage, med positiv ROI typisk opnået efter 4-6 måneder. Betydelige forskydninger i den konkurrencemæssige positionering (40-60 % stigning i trafik) sker typisk inden for 6 måneder. Tidslinjen afhænger af indholdskvalitet, optimeringsindsats og konkurrencens intensitet. Vedvarende indsats giver stigende resultater, hvor forbedringer i andet år ofte overgår første års gevinster.

Manuel benchmarking er teoretisk mulig, men upraktisk i stor skala. Test af 50-100 forespørgsler på 5 AI-platforme dagligt kræver 4-6 timers manuelt arbejde og er derfor ikke bæredygtigt til løbende overvågning. Værktøjer som AmICited.com automatiserer processen og leverer realtidssporing, historisk trendanalyse og konkurrent-sammenligninger. Start med manuelle tests for at forstå processen (1-2 uger), og investér derefter i værktøjer for skalérbarhed og nøjagtighed. ROI på værktøjer er typisk tjent hjem inden for 30-60 dage i form af bedre beslutningsgrundlag.

Forstå hvordan dit brand sammenlignes med konkurrenter i AI-genererede svar. Få realtidsindsigt i din citationsfrekvens, responspositionering og konkurrencemæssig share of voice på alle større AI-platforme.

Lær hvordan du benchmarker AI-synlighed mod konkurrenter på tværs af ChatGPT, Perplexity og andre AI-platforme. Opdag metrikker, værktøjer og strategier til at ...

Fællesskabsdiskussion om konkurrencebenchmarking for AI-synlighed. Marketingprofessionelle deler frameworks, målemetoder og værktøjer til at måle AI-søgepræstat...

Lær, hvordan du udfører en konkurrencedygtig AI-synlighedsrevision for at forstå din brands position i ChatGPT, Perplexity og Google AI Overviews. Opdag målinge...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.