Kontekstvindue

Kontekstvindue forklaret: det maksimale antal tokens, en LLM kan behandle ad gangen. Lær hvordan kontekstvinduer påvirker AI-nøjagtighed, hallucinationer og bra...

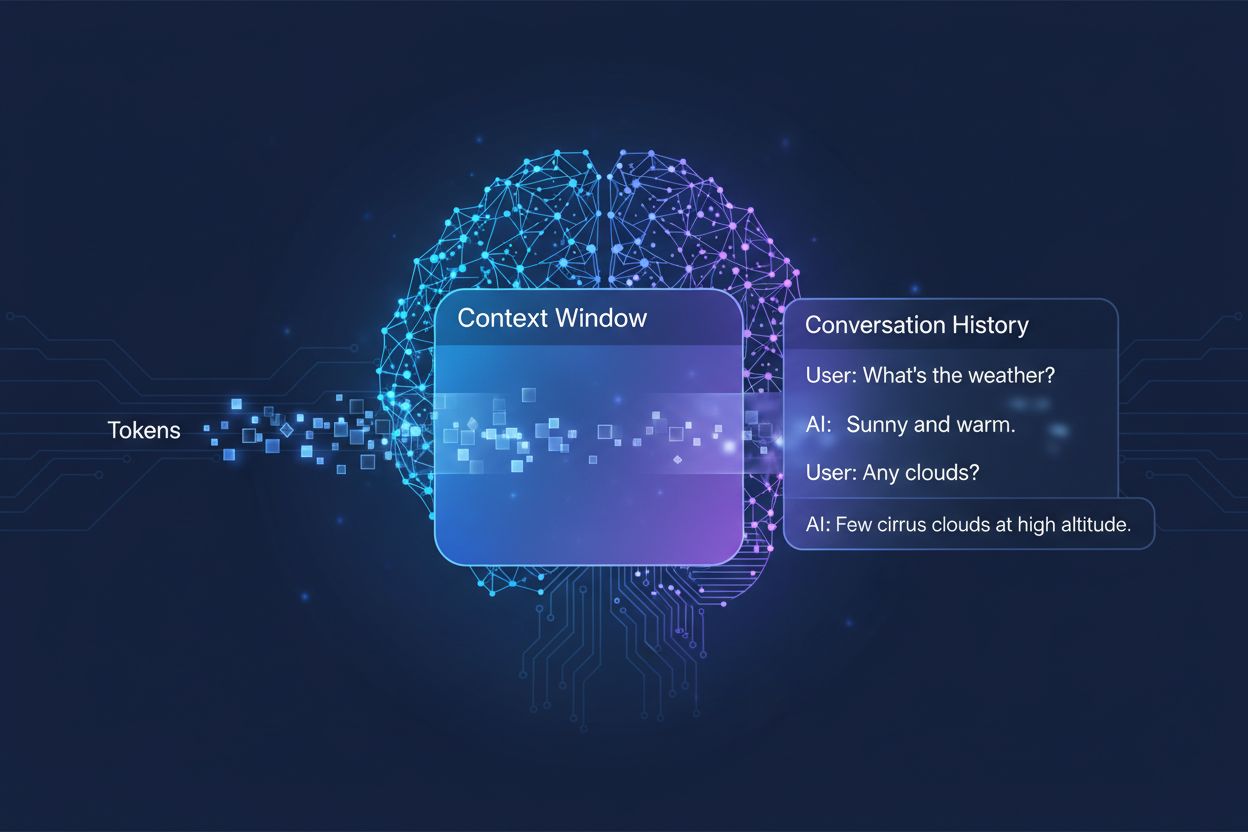

Den mængde tidligere samtale, et AI-system tager i betragtning, når det genererer svar, målt i tokens. Det afgør, hvor meget tekst en AI kan behandle samtidigt og har direkte indflydelse på kvaliteten og sammenhængen i dens output i samtaler med flere omgange.

Den mængde tidligere samtale, et AI-system tager i betragtning, når det genererer svar, målt i tokens. Det afgør, hvor meget tekst en AI kan behandle samtidigt og har direkte indflydelse på kvaliteten og sammenhængen i dens output i samtaler med flere omgange.

Et kontekstvindue er den maksimale mængde tekst, som en AI-sprogsmodel kan behandle og referere til på én gang under en samtale eller opgave. Tænk på det som modellens arbejdshukommelse—ligesom mennesker kun kan holde en begrænset mængde information i den umiddelbare bevidsthed, kan AI-modeller kun “se” en vis mængde tekst før og efter deres nuværende position. Denne kapacitet måles i tokens, som er små tekstdele, der typisk repræsenterer ord eller orddelinger (i gennemsnit svarer et engelsk ord til cirka 1,5 tokens). Det er afgørende at forstå din models kontekstvindue, fordi det direkte bestemmer, hvor meget information AI’en kan tage i betragtning, når den genererer svar, hvilket gør det til en grundlæggende begrænsning for, hvor effektivt modellen kan håndtere komplekse samtaler med flere omgange eller lange dokumenter.

Moderne sprogmodeller, især transformer-baserede arkitekturer, behandler tekst ved at konvertere den til tokens og derefter analysere relationerne mellem alle tokens inden for kontekstvinduet samtidigt. Transformer-arkitekturen, introduceret i det banebrydende papir fra 2017 “Attention is All You Need”, bruger en mekanisme kaldet self-attention til at bestemme, hvilke dele af inputtet der er mest relevante for hinanden. Denne opmærksomhedsmekanisme gør det muligt for modellen at vægte betydningen af forskellige tokens i forhold til hinanden, så den kan forstå konteksten og betydningen på tværs af hele vinduet. Denne proces bliver dog beregningsmæssigt dyr, efterhånden som kontekstvinduet vokser, da opmærksomhedsmekanismen skal beregne relationer mellem hver token og alle andre tokens—et kvadratisk skaleringsproblem. Tabellen nedenfor illustrerer, hvordan forskellige førende AI-modeller sammenlignes i deres kontekstvindue-funktionalitet:

| Model | Kontekstvindue (Tokens) | Udgivelsesdato |

|---|---|---|

| GPT-4 | 128.000 | Marts 2023 |

| Claude 3 Opus | 200.000 | Marts 2024 |

| Gemini 1.5 Pro | 1.000.000 | Maj 2024 |

| GPT-4 Turbo | 128.000 | November 2023 |

| Llama 2 | 4.096 | Juli 2023 |

Disse forskellige kapaciteter afspejler forskellige designvalg og beregningsmæssige kompromiser foretaget af hver organisation, hvor større vinduer muliggør mere sofistikerede anvendelser, men kræver mere processorkraft.

Vejen mod større kontekstvinduer repræsenterer en af de mest betydningsfulde fremskridt i AI-evner det seneste årti. Tidlige recurrent neural networks (RNNs) og long short-term memory (LSTM)-modeller havde svært ved kontekst, da de behandlede tekst sekventielt og havde svært ved at huske information fra fjerne dele af inputtet. Gennembruddet kom i 2017 med introduktionen af Transformer-arkitekturen, som muliggjorde parallel behandling af hele sekvenser og forbedrede modellens evne til at opretholde kontekst på tværs af længere tekster markant. Dette lagde grunden for GPT-2 i 2019, som demonstrerede imponerende sprogproduktion med et kontekstvindue på 1.024 tokens, efterfulgt af GPT-3 i 2020 med 2.048 tokens og til sidst GPT-4 i 2023 med 128.000 tokens. Hvert fremskridt var vigtigt, fordi det udvidede mulighederne: større vinduer betød, at modeller kunne håndtere længere dokumenter, bevare sammenhængen i samtaler med flere omgange og forstå nuancerede relationer mellem fjerne begreber i teksten. Den eksponentielle vækst i kontekstvindue-størrelser afspejler både forbedrede arkitektoniske innovationer og øgede beregningsressourcer tilgængelige for førende AI-laboratorier.

Større kontekstvinduer udvider grundlæggende, hvad AI-modeller kan opnå, og muliggør anvendelser, der tidligere var umulige eller stærkt begrænsede. Her er de vigtigste fordele:

Forbedret samtalekontinuitet: Modeller kan bevare overblikket over hele samtalehistorikker, hvilket mindsker behovet for at genforklare konteksten og muliggør mere naturlige, sammenhængende dialoger, der føles ægte og ikke fragmenterede.

Dokumentbehandling i stor skala: Større vinduer gør det muligt for AI at analysere hele dokumenter, forskningsartikler eller kodebaser i ét hug og identificere mønstre og relationer på tværs af hele indholdet uden at miste information fra tidligere afsnit.

Forbedret ræsonnement og analyse: Med mere tilgængelig kontekst kan modeller udføre mere sofistikerede ræsonnementopgaver, der kræver forståelse af relationer mellem flere begreber, hvilket gør dem mere effektive til forskning, analyse og komplekse problemløsningsopgaver.

Reduceret omkostning ved kontekstskift: Brugere behøver ikke længere manuelt at opsummere eller genintroducere information; modellen kan referere til hele samtalehistorikken, hvilket mindsker friktion og øger effektiviteten i samarbejdsarbejdsgange.

Bedre håndtering af nuancerede opgaver: Anvendelser som gennemgang af juridiske dokumenter, analyse af journaler og kodegennemgang drager stor fordel af evnen til at inddrage omfattende kontekst, hvilket fører til mere nøjagtige og grundige resultater.

Sømløse arbejdsgange på tværs af flere dokumenter: Professionelle kan arbejde med flere relaterede dokumenter samtidigt, så modellen kan krydsreferere information og identificere sammenhænge, der ville være umulige med mindre kontekstvinduer.

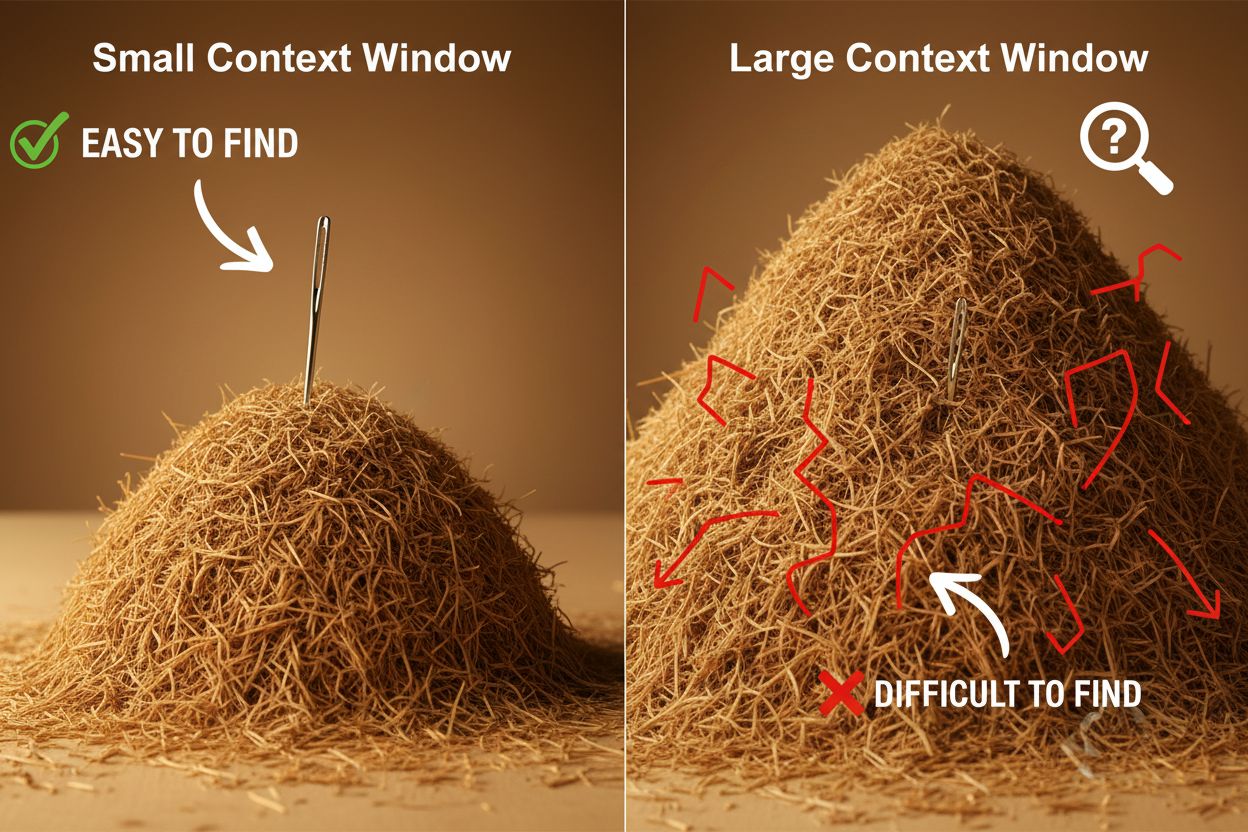

På trods af deres fordele skaber store kontekstvinduer betydelige tekniske og praktiske udfordringer, som udviklere og brugere skal håndtere omhyggeligt. Den mest åbenlyse udfordring er beregningsomkostninger: behandling af længere sekvenser kræver eksponentielt mere hukommelse og processorkraft på grund af opmærksomhedsmekanismens kvadratiske skalering, hvilket gør store kontekstvinduer væsentligt dyrere at køre. Dette øgede beregningsbehov skaber også latensproblemer, da længere kontekstvinduer betyder langsommere svartider—et kritisk problem for realtidsapplikationer, hvor brugerne forventer hurtige svar. Et andet subtilt, men vigtigt problem er “nålen i høstakken”-fænomenet, hvor modeller har svært ved at finde og bruge relevant information, når den er skjult i et meget stort kontekstvindue, og de nogle gange præsterer dårligere end med mindre vinduer. Desuden opstår der kontekstforfald, når information fra starten af et langt kontekstvindue får mindre indflydelse på modellens output, da opmærksomhedsmekanismen kan nedprioritere fjerne tokens til fordel for mere nylige. Disse udfordringer betyder, at det ikke altid er den optimale løsning blot at maksimere kontekstvinduets størrelse til enhver brugssituation.

Det er vigtigt at forstå kontekstforfald for at arbejde effektivt med store kontekstvinduer: efterhånden som sekvenser bliver længere, får tokens i starten af konteksten en faldende indflydelse på modellens output, hvilket betyder, at vigtig information reelt kan blive “glemt”, selvom den teknisk set er inden for vinduet. Dette sker, fordi opmærksomhedsbudgettet—modellens evne til meningsfuldt at fokusere på alle tokens—strækkes over et større tekstområde. Heldigvis er der opstået flere avancerede teknikker til at løse disse begrænsninger. Retrieval-Augmented Generation (RAG) løser dette ved at gemme information i eksterne databaser og kun hente de mest relevante stykker, når det er nødvendigt, hvilket effektivt giver modellen en større effektiv vidensbase uden at kræve et enormt kontekstvindue. Kontekstkomprimering opsummerer eller komprimerer mindre relevant information, så de vigtigste detaljer bevares, mens tokenforbruget reduceres. Struktureret notetagning opfordrer brugere til at organisere information hierarkisk, hvilket gør det lettere for modellen at prioritere og finde nøglebegreber. Disse løsninger virker ved at være strategiske i forhold til, hvilken information der kommer ind i kontekstvinduet, og hvordan den organiseres, frem for blot at forsøge at få alt til at være i hukommelsen på én gang.

De udvidede kontekstvinduer i moderne AI-modeller har åbnet op for adskillige virkelige anvendelser, som tidligere var upraktiske eller umulige. Kundesupportsystemer kan nu gennemgå hele ticket-historikker og relateret dokumentation i én anmodning, hvilket muliggør mere præcise og kontekstuelle svar uden at kræve, at kunderne skal forklare deres situation igen. Dokumentanalyse og research er blevet transformeret af modeller, der kan indlæse hele forskningsartikler, kontrakter eller tekniske specifikationer og identificere nøgleinformation og besvare detaljerede spørgsmål om indhold, som det ville tage mennesker timer at gennemgå. Kodegennemgang og softwareudvikling drager fordel af kontekstvinduer, der er store nok til at rumme hele filer eller endda flere relaterede filer, så AI kan forstå arkitektoniske mønstre og give mere intelligente forslag. Oprettelse af længere indhold og iterative skriveprocesser bliver mere effektive, når modellen kan bevare overblikket over et dokuments tone, stil og narrativ gennem hele redigeringsprocessen. Møde-transskriptanalyse og researchsyntese udnytter store kontekstvinduer til at udtrække indsigter fra timers samtale eller dusinvis af kildedokumenter og identificere temaer og sammenhænge, der ville være svære at opdage manuelt. Disse anvendelser viser, at kontekstvinduets størrelse direkte oversættes til praktisk værdi for professionelle på tværs af brancher.

Udviklingen af kontekstvinduer antyder, at vi bevæger os mod endnu mere dramatiske udvidelser på kort sigt, hvor Gemini 1.5 Pro allerede har demonstreret et kontekstvindue på 1.000.000 tokens, og forskningslaboratorier undersøger endnu større kapaciteter. Ud over rå størrelse vil fremtiden sandsynligvis byde på dynamiske kontekstvinduer, der intelligent tilpasser deres størrelse afhængigt af opgaven og tildeler mere kapacitet, når det er nødvendigt, og reducerer den til enklere forespørgsler for at forbedre effektivitet og sænke omkostningerne. Forskere gør også fremskridt med mere effektive opmærksomhedsmekanismer, der reducerer de beregningsmæssige omkostninger ved større vinduer og potentielt bryder den kvadratiske skaleringsbarriere, der i øjeblikket begrænser kontekststørrelsen. Efterhånden som disse teknologier modnes, kan vi forvente, at kontekstvinduer bliver mindre af en begrænsning og mere af et løst problem, hvilket gør det muligt for udviklere at fokusere på andre aspekter af AI-funktionalitet og pålidelighed. Samspillet mellem større vinduer, forbedret effektivitet og smartere kontekststyring vil sandsynligvis definere næste generation af AI-applikationer og muliggøre brugsscenarier, vi endnu ikke har forestillet os.

Et kontekstvindue er den samlede mængde tekst (målt i tokens), som en AI-model kan behandle på én gang, mens en token-grænse refererer til det maksimale antal tokens, modellen kan håndtere. Disse termer bruges ofte om hinanden, men kontekstvindue henviser specifikt til den arbejdshukommelse, der er tilgængelig under en enkelt inferens, mens token-grænse også kan referere til outputbegrænsninger eller API-brugsgrænser.

Større kontekstvinduer forbedrer generelt svarkvaliteten ved at give modellen mulighed for at tage mere relevant information i betragtning og opretholde bedre samtalekontinuitet. Meget store vinduer kan dog nogle gange forringe kvaliteten på grund af kontekstforfald, hvor modellen har svært ved at prioritere vigtig information blandt store mængder tekst. Den optimale størrelse på kontekstvinduet afhænger af den specifikke opgave og hvor godt informationen er organiseret.

Større kontekstvinduer kræver mere computerkraft på grund af den kvadratiske skalering af opmærksomhedsmekanismen i transformer-modeller. Opmærksomhedsmekanismen skal beregne relationer mellem hver token og alle andre tokens, så hvis man fordobler kontekstvinduet, firedobles de beregningsmæssige krav cirka. Derfor er større kontekstvinduer dyrere at køre og giver langsommere svartider.

'Nålen i høstakken'-problemet opstår, når en AI-model har svært ved at finde og bruge relevant information (nålen), når den er gemt i et meget stort kontekstvindue (høstakken). Modeller præsterer nogle gange dårligere med meget store kontekstvinduer, fordi opmærksomhedsmekanismen bliver udvandet over så meget information, hvilket gør det sværere at identificere, hvad der faktisk er vigtigt.

For at maksimere effektiviteten af kontekstvinduet skal du organisere information klart og hierarkisk, placere de vigtigste informationer i starten eller slutningen af konteksten, bruge strukturerede formater som JSON eller markdown og overveje at bruge Retrieval-Augmented Generation (RAG) til dynamisk kun at indlæse den mest relevante information. Undgå at overbelaste modellen med irrelevante detaljer, der bruger tokens uden at tilføje værdi.

Kontekstvindue er modellens tekniske kapacitet til at behandle tekst på én gang, mens samtalehistorik er den faktiske optegnelse af tidligere beskeder i en samtale. Samtalehistorikken skal passe ind i kontekstvinduet, men kontekstvinduet inkluderer også plads til systemprompter, instruktioner og anden metadata. En samtalehistorik kan være længere end kontekstvinduet, hvilket kræver opsummering eller afkortning.

Der findes i øjeblikket ingen AI-modeller med reelt ubegrænsede kontekstvinduer, da alle modeller har arkitektoniske og beregningsmæssige begrænsninger. Nogle modeller som Gemini 1.5 Pro tilbyder dog meget store vinduer (1.000.000 tokens), og teknikker som Retrieval-Augmented Generation (RAG) kan effektivt udvide modellens vidensbase ud over dens kontekstvindue ved dynamisk at hente information efter behov.

Størrelsen på kontekstvinduet påvirker direkte API-omkostningerne, fordi større vinduer kræver flere beregningsressourcer at behandle. De fleste AI-API-udbydere opkræver betaling baseret på tokenforbrug, så brug af et større kontekstvindue betyder flere behandlede tokens og højere omkostninger. Nogle udbydere opkræver også premiumpriser for modeller med større kontekstvinduer, så det er vigtigt at vælge den rigtige modelstørrelse til dine behov.

AmICited sporer, hvordan AI-systemer som ChatGPT, Perplexity og Google AI Overviews citerer og refererer til dit indhold. Forstå din AI-synlighed og overvåg dine brandomtaler på tværs af AI-platforme.

Kontekstvindue forklaret: det maksimale antal tokens, en LLM kan behandle ad gangen. Lær hvordan kontekstvinduer påvirker AI-nøjagtighed, hallucinationer og bra...

Lær hvad kontekstvinduer er i AI-sprogmodeller, hvordan de fungerer, deres indvirkning på modelydelse, og hvorfor de er vigtige for AI-drevne applikationer og o...

Fællesskabsdiskussion om AI-kontekstvinduer og deres betydning for indholdsmarkedsføring. Forståelse af, hvordan kontekstgrænser påvirker AI's behandling af dit...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.