Finansielle Tjenesters AI-synlighed: Overholdelse og Optimering

Overvåg, hvordan dit finansielle brand fremstår i AI-genererede svar. Lær overholdelseskrav, synlighedsstrategier og optimeringsteknikker for regulerede finansi...

Regulatoriske krav til, at finansielle institutioner gennemsigtigt offentliggør deres brug af kunstig intelligens i beslutningstagning, risikostyring og kundeorienterede applikationer. Omfatter SEC, CFPB, FINRA og andre regulatoriske forventninger om dokumentation af AI-styring, modelpræstation og påvirkning af forbrugere og markeder.

Regulatoriske krav til, at finansielle institutioner gennemsigtigt offentliggør deres brug af kunstig intelligens i beslutningstagning, risikostyring og kundeorienterede applikationer. Omfatter SEC, CFPB, FINRA og andre regulatoriske forventninger om dokumentation af AI-styring, modelpræstation og påvirkning af forbrugere og markeder.

Finansiel AI-offentliggørelse henviser til de regulatoriske krav og bedste praksisser for, at finansielle institutioner gennemsigtigt offentliggør deres brug af kunstig intelligens i beslutningsprocesser, risikostyring og kundeorienterede applikationer. Det omfatter SEC, CFPB, FINRA og andre regulatoriske forventninger om dokumentation af AI-styring, modelpræstation og potentielle påvirkninger på forbrugere og markeder. I december 2024 fremsatte SEC’s Investor Advisory Committee (IAC) en formel anbefaling om, at agenturet udsteder vejledning, der kræver, at udstedere offentliggør information om virkningen af kunstig intelligens på deres virksomheder. IAC fremhævede en “mangel på konsistens” i nutidige AI-offentliggørelser, hvilket “kan være problematisk for investorer, der søger klar og sammenlignelig information.” Kun 40% af S&P 500-virksomheder leverer AI-relaterede offentliggørelser, og kun 15% offentliggør information om bestyrelsestilsyn med AI, på trods af at 60% af S&P 500-virksomheder ser AI som en væsentlig risiko.

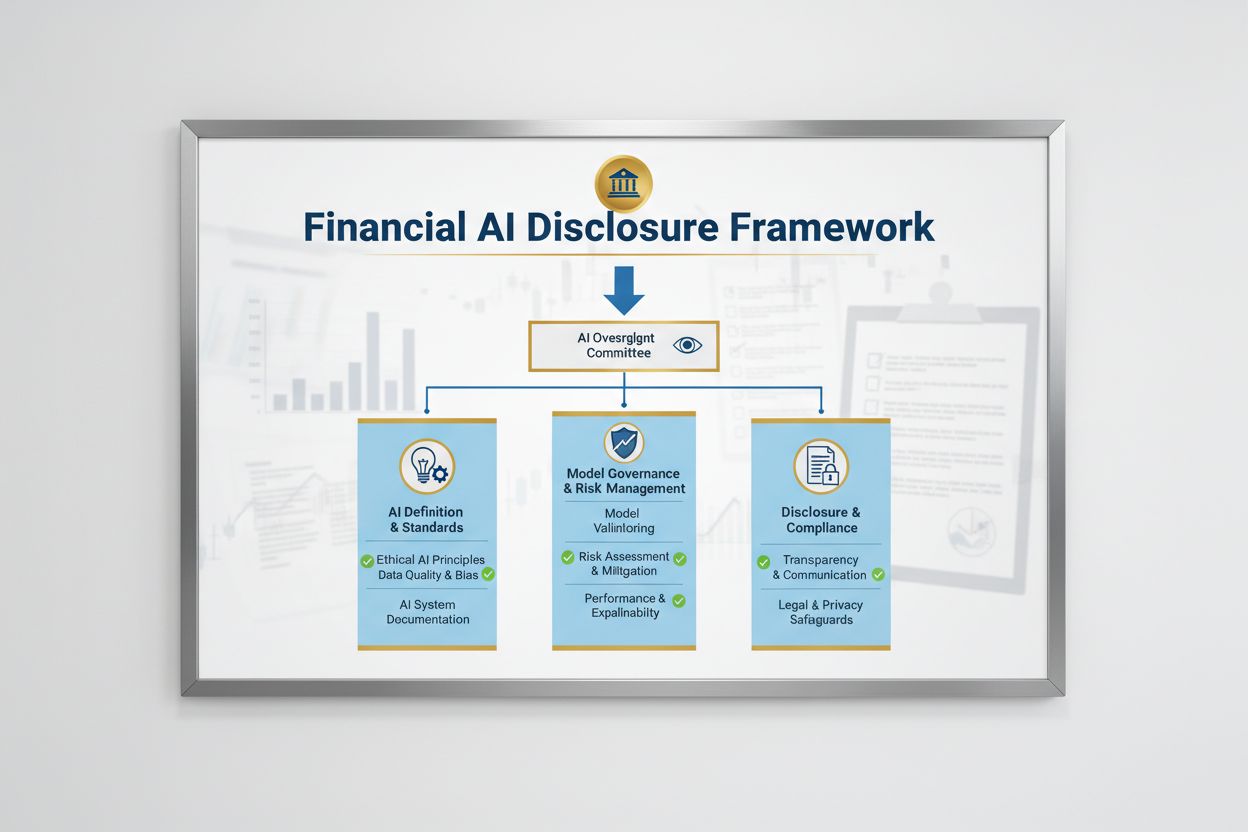

Det regulatoriske landskab for Finansiel AI-offentliggørelse formes af flere føderale agenturer, der anvender eksisterende teknologineutrale love på AI-systemer. SEC’s Investor Advisory Committee foreslog en indledende ramme med tre nøglesøjler: (1) at kræve, at udstedere definerer, hvad de mener med “Kunstig Intelligens”, (2) offentliggørelse af bestyrelsestilsynsmekanismer for AI-implementering, og (3) rapportering om væsentlige AI-implementeringer og deres effekt på interne processer og kundeorienterede produkter. Ud over SEC har CFPB, FINRA, OCC og Federal Reserve alle udstedt vejledning, der understreger, at eksisterende forbrugerbeskyttelseslove – herunder fair lending, databeskyttelse og anti-svig statutter – gælder for AI-systemer uanset den anvendte teknologi. Disse agenturer anvender en teknologineutral tilgang, hvilket betyder, at compliance-forpligtelser under Equal Credit Opportunity Act (ECOA), Fair Credit Reporting Act (FCRA), Gramm-Leach-Bliley Act (GLBA) og Unfair or Deceptive Acts or Practices (UDAAP) standarder forbliver uændrede, når AI er involveret.

| Regulator | Fokusområde | Nøglekrav |

|---|---|---|

| SEC | Investoroffentliggørelse, interessekonflikter | Definér AI, offentliggør bestyrelsestilsyn, rapportér væsentlige implementeringer |

| CFPB | Fair lending, forbrugerbeskyttelse | Sikr, at AI-modeller overholder ECOA, giv underretninger om negative beslutninger |

| FINRA | Broker-dealer-drift, kundekommunikation | Etabler AI-styringspolitikker, overvåg AI-brug på tværs af funktioner |

| OCC/Federal Reserve/FDIC | Bankmodelstyring, operationel risiko | Validér AI-modeller, dokumentér kontroller, vurder pålidelighed |

| FTC | Vildledende praksis, datahåndtering | Overvåg AI-relaterede påstande, forhindre uretmæssig brug af data |

Effektiv Finansiel AI-offentliggørelse kræver klart bestyrelsestilsyn med implementering og risikostyring af kunstig intelligens. SEC’s IAC-anbefaling understreger, at investorer har en legitim interesse i at forstå, om der er klare ansvarsstrukturer for implementering af AI-teknologi i interne forretninger og produktlinjer. Finansielle institutioner skal etablere styringsstrukturer, der tildeler ansvar for AI-tilsyn til bestyrelsen eller et udpeget bestyrelsesudvalg, så AI-relaterede risici håndteres på højeste niveau i organisationen. Denne styringsramme bør inkludere dokumenterede politikker og procedurer for AI-udvikling, test, validering og implementering med regelmæssig rapportering til bestyrelsen om modelpræstation, identificerede risici og afhjælpningstiltag. Uden klart bestyrelsesansvar risikerer finansielle institutioner regulatorisk granskning og potentielle håndhævelsesaktioner for utilstrækkeligt tilsyn med væsentlige AI-systemer.

Finansielle institutioner skal separat offentliggøre de væsentlige effekter af AI-implementering på interne forretningsprocesser og kundeorienterede produkter. For interne processer bør offentliggørelser adressere AI’s indvirkning på human kapital (såsom personalereduktioner eller behov for opkvalificering), nøjagtigheden af finansiel rapportering, styringsprocesser og cybersikkerhedsrisici. For kundeorienterede forhold skal institutioner offentliggøre investeringer i AI-drevne platforme, integration af AI i produkter og tjenester, regulatoriske påvirkninger fra AI-brug og hvordan AI påvirker prisstrategier eller forretningsmål. SEC anbefaler at integrere disse offentliggørelser i eksisterende Regulation S-K-offentliggørelsespunkter (såsom punkterne 101, 103, 106 og 303) ud fra et væsentlighedsprincip, frem for at etablere helt nye offentliggørelseskategorier. Denne tilgang giver finansielle institutioner mulighed for at udnytte eksisterende rammer og samtidig give investorer klar, sammenlignelig information om AI’s rolle i organisationens drift og strategiske retning.

Høj datakvalitet er grundlæggende for ansvarlig AI-implementering i finansielle tjenester, men mange institutioner kæmper med datastyringsrammer, der lever op til regulatoriske forventninger. Finansielle institutioner skal sikre, at data, der bruges til at træne, teste og validere AI-modeller, er rene, komplette, standardiserede og omfattende, med tydelig dokumentation af datakilder, datalinje og eventuelle kendte begrænsninger. Datasikkerhedsforanstaltninger skal forhindre “datapoisoning” – manipulation af træningsdata for at kompromittere modelintegritet – og beskytte mod uautoriseret adgang eller offentliggørelse af følsomme oplysninger. Gramm-Leach-Bliley Act (GLBA) giver grundlæggende beskyttelse af forbrugerens finansielle data, men mange regulatorer og forbrugerforkæmpere mener, at disse beskyttelser er utilstrækkelige i AI-sammenhæng, især i lyset af udvidet datainhentning og brug til modeltræning. Finansielle institutioner skal også adressere ophavsretlige problemstillinger og sikre, at de har korrekt tilladelse til at bruge data til AI-udvikling, og at de respekterer tredjeparts ophavsrettigheder. Implementering af robuste datastyringsrammer, herunder dataminimeringsprincipper, adgangskontrol og regelmæssige revisioner, er afgørende for at demonstrere overholdelse af regulatoriske forventninger.

Regulatoriske myndigheder har gjort det klart, at AI-modeller, der bruges i finansielle beslutningsprocesser, skal testes for bias og potentielt diskriminerende resultater, uanset modellens overordnede nøjagtighed eller præstation. “Black box”-problemet – hvor komplekse AI-systemer leverer output, der er svære eller umulige at forklare – skaber betydelig compliance-risiko, især i kundeorienterede applikationer som kreditvurdering, prisfastsættelse og svigdetektion. Finansielle institutioner skal implementere processer til at opdage og reducere bias gennem hele modellens livscyklus, inklusiv bias-test under udvikling, validering og løbende overvågning. Overholdelse af fair lending kræver, at institutioner kan forklare de specifikke årsager til negative beslutninger (såsom kreditaftslag) og demonstrere, at deres AI-modeller ikke har en ulige påvirkning på beskyttede grupper. Test for “mindre diskriminerende alternativer” – metoder, der opnår de samme forretningsmål med reduceret bias – forventes i stigende grad af regulatorer. Mange institutioner anvender forklarlige AI-teknikker (xAI), såsom feature importance-analyse og beslutningstræer, for at forbedre gennemsigtighed og ansvarlighed i AI-drevne beslutninger.

Finansielle institutioner, der bruger AI i kundeorienterede applikationer, skal overholde eksisterende forbrugerbeskyttelseslove, herunder krav om underretning ved negative beslutninger, databeskyttelsesoplysning og fair behandling. Når et AI-system bruges til at træffe eller væsentligt påvirke beslutninger om kredit, forsikring eller andre finansielle produkter, har forbrugere ret til at forstå, hvorfor de blev afvist eller tilbudt mindre gunstige vilkår. CFPB har understreget, at kreditorer underlagt Equal Credit Opportunity Act (ECOA) ikke må bruge “black box”-modeller, når de ikke kan give specifikke og nøjagtige begrundelser for negative beslutninger. Derudover gælder Unfair or Deceptive Acts or Practices (UDAAP)-standarden for AI-drevne systemer, der kan skade forbrugere gennem uigennemsigtig dataindsamling, brud på privatlivet eller styring mod uhensigtsmæssige produkter. Finansielle institutioner skal sikre, at AI-systemer, der bruges i kundeservice, produktanbefalinger og kontoadministration, er gennemsigtige omkring deres brug af AI og giver klare oplysninger om, hvordan forbrugerdata indsamles, bruges og beskyttes.

De fleste finansielle institutioner er afhængige af tredjepartsleverandører til at udvikle, implementere eller vedligeholde AI-systemer, hvilket skaber betydelige forpligtelser for tredjeparts risikostyring (TPRM). De føderale bankmyndigheders Interagency Guidance on Third-Party Relationships understreger, at finansielle institutioner forbliver ansvarlige for ydeevne og compliance af tredjeparts AI-systemer, selv når institutionen ikke selv har udviklet modellen. Effektiv TPRM for AI kræver grundig due diligence før engagement af en leverandør, herunder vurdering af leverandørens datastyring, modelvalideringsprocesser og evne til at give gennemsigtighed i modeldriften. Finansielle institutioner skal også overvåge for koncentrationsrisiko – den potentielle systemiske effekt, hvis et lille antal AI-udbydere oplever forstyrrelser eller fejl. Forsyningskæderisici, inklusiv datakilders pålidelighed og tredjepartsinfrastrukturens stabilitet, skal vurderes og dokumenteres. Kontrakter med AI-leverandører bør indeholde klare krav om datasikkerhed, overvågning af modelpræstation, hændelsesrapportering og mulighed for at auditere eller teste AI-systemet. Især mindre finansielle institutioner kan have svært ved at opnå den tekniske ekspertise, der kræves for at evaluere komplekse AI-systemer, hvilket skaber et behov for branchestandarder eller certificeringsprogrammer til leverandørvurdering.

Finansielle institutioner, der opererer på tværs af grænser, står over for et stadigt mere komplekst kludetæppe af AI-reguleringer, hvor Den Europæiske Unions AI-forordning er den mest omfattende regulatoriske ramme til dato. EU AI-forordningen klassificerer AI-systemer, der bruges til kreditvurdering, svigforebyggelse og hvidvaskningsbekæmpelse som “højrisiko”, hvilket kræver omfattende dokumentation, bias-test, menneskeligt tilsyn og overensstemmelsesvurderinger. OECD og G7 har også udstedt principper og anbefalinger for ansvarlig AI-styring i finansielle tjenester, med vægt på gennemsigtighed, fairness, ansvarlighed og menneskeligt tilsyn. Mange af disse internationale standarder har ekstraterritorial rækkevidde, hvilket betyder, at finansielle institutioner, der betjener kunder i EU, Storbritannien eller andre regulerede jurisdiktioner, kan være nødt til at overholde disse standarder, selv hvis de er hjemmehørende andetsteds. Arbejdet med regulatorisk harmonisering pågår, men der er stadig betydelige forskelle mellem jurisdiktioner, hvilket skaber compliance-udfordringer for globale finansielle institutioner. Proaktiv tilpasning til de højeste internationale standarder – såsom EU AI-forordningen og OECD-principper – kan hjælpe institutioner med at forberede sig på fremtidige regulatoriske udviklinger og mindske risikoen for håndhævelsesaktioner på tværs af flere jurisdiktioner.

Finansielle institutioner bør implementere omfattende dokumentations- og styringspraksis for at demonstrere compliance med forventningerne om Finansiel AI-offentliggørelse. Centrale bedste praksisser inkluderer:

Ved at tage disse praksisser i brug kan finansielle institutioner reducere regulatorisk risiko, opbygge tillid hos interessenter og positionere sig som ledere inden for ansvarlig AI-implementering i den finansielle sektor.

Finansiel AI-offentliggørelse henviser til de regulatoriske krav for, at finansielle institutioner gennemsigtigt offentliggør deres brug af kunstig intelligens i beslutningstagning, risikostyring og kundeorienterede applikationer. Det omfatter SEC, CFPB, FINRA og andre regulatoriske forventninger om dokumentation af AI-styring, modelpræstation og påvirkning af forbrugere og markeder. SEC's Investor Advisory Committee anbefalede i december 2024, at finansielle institutioner definerer deres brug af AI, offentliggør bestyrelsestilsynsmekanismer og rapporterer om væsentlige AI-implementeringer.

Finansielle institutioner skal offentliggøre AI-brug for at beskytte investorer, forbrugere og markedets integritet. Regulatorer har konstateret, at kun 40% af S&P 500-virksomheder giver AI-relaterede offentliggørelser, hvilket skaber inkonsistens og informationshuller for investorer. Offentliggørelseskrav sikrer, at interessenter forstår, hvordan AI påvirker finansielle beslutninger, risikostyring og forbrugerresultater. Derudover gælder eksisterende forbrugerbeskyttelseslove – herunder fair lending og databeskyttelseslovgivning – for AI-systemer, hvilket gør offentliggørelse afgørende for regulatorisk overholdelse.

SEC's Investor Advisory Committee anbefalede tre hovedsøjler for AI-offentliggørelse: (1) at kræve, at udstedere definerer, hvad de mener med 'Kunstig Intelligens', (2) offentliggørelse af bestyrelsestilsynsmekanismer for AI-implementering, og (3) rapportering om væsentlige AI-implementeringer og deres effekt på interne processer og kundeorienterede produkter. Disse anbefalinger er designet til at give investorer klar og sammenlignelig information om, hvordan AI påvirker finansielle institutioners drift og strategiske retning.

Finansiel AI-offentliggørelse fokuserer specifikt på regulatoriske krav til gennemsigtig kommunikation om AI-brug til eksterne interessenter (investorer, regulatorer, forbrugere), mens generel AI-styring refererer til interne processer og kontroller for styring af AI-systemer. Offentliggørelse er den udadvendte del af AI-styring, der sikrer, at interessenter har adgang til væsentlig information om AI-implementering, risici og påvirkninger. Begge dele er afgørende for ansvarlig AI-implementering i finansielle tjenester.

Offentliggørelser om AI-implementering skal adressere både interne processer og kundeorienterede påvirkninger. For interne processer bør institutioner offentliggøre indvirkningen på human kapital, finansiel rapportering, styring og cybersikkerhedsrisici. For kundeorienterede produkter skal offentliggørelser dække investeringer i AI-drevne platforme, integration af AI i produkter, regulatoriske påvirkninger samt hvordan AI påvirker prisfastsættelse eller forretningsstrategier. Offentliggørelser bør integreres i eksisterende regulatoriske offentliggørelseskrav (såsom SEC Regulation S-K) ud fra et væsentlighedsprincip.

Fair lending-lovgivning, herunder Equal Credit Opportunity Act (ECOA) og Fair Credit Reporting Act (FCRA), gælder for AI-systemer, der bruges i kreditbeslutninger uanset den anvendte teknologi. Finansielle institutioner skal kunne forklare de specifikke årsager til negative beslutninger (såsom kreditaftslag) og demonstrere, at deres AI-modeller ikke har en ulige påvirkning på beskyttede grupper. Regulatorer forventer, at institutioner tester AI-modeller for bias, implementerer 'mindre diskriminerende alternativer', hvor det er relevant, og opretholder dokumentation for fairness-test og validering.

De fleste finansielle institutioner er afhængige af tredjepartsleverandører til AI-systemer, hvilket skaber betydelige forpligtelser for tredjeparts risikostyring (TPRM). Finansielle institutioner forbliver ansvarlige for ydeevne og compliance af tredjeparts AI-systemer, selv når de ikke selv har udviklet modellen. Effektiv TPRM for AI kræver grundig due diligence, løbende overvågning, vurdering af leverandørens datastyring og dokumentation af modelpræstation. Institutioner skal også overvåge for koncentrationsrisiko – den potentielle systemiske effekt, hvis et lille antal AI-udbydere oplever forstyrrelser.

Den Europæiske Unions AI-forordning repræsenterer den mest omfattende regulatoriske ramme for AI, klassificerer finansielle AI-systemer som 'højrisiko' og kræver omfattende dokumentation, bias-test og menneskeligt tilsyn. OECD og G7 har også udstedt principper for ansvarlig AI-styring. Mange af disse internationale standarder har ekstraterritorial rækkevidde, hvilket betyder, at finansielle institutioner, der betjener kunder i regulerede jurisdiktioner, muligvis skal overholde disse standarder. Proaktiv tilpasning til internationale standarder kan hjælpe institutioner med at forberede sig på fremtidige regulatoriske udviklinger og reducere håndhævelsesrisiko.

Følg, hvordan din finansielle institution nævnes i AI-svar på tværs af GPT'er, Perplexity og Google AI Overviews. Sikr, at dit brand opretholder synlighed og nøjagtighed i AI-genereret finansielt indhold.

Overvåg, hvordan dit finansielle brand fremstår i AI-genererede svar. Lær overholdelseskrav, synlighedsstrategier og optimeringsteknikker for regulerede finansi...

Lær hvordan du præsenterer AI-synlighedsresultater for direktionsmedlemmer. Opdag nøglemålinger, dashboard-design og best practices for AI-rapportering og styri...

Omfattende guide til udvikling og implementering af redaktionelle retningslinjer for AI-genereret og AI-assisteret indhold. Lær best practices fra store forlag ...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.