Hvordan optimerer jeg til Google Gemini? Komplet guide til AI-søgeoptimering

Lær, hvordan du optimerer dit indhold til Google Gemini og andre AI-søgemaskiner. Mestre Answer Engine Optimization (AEO)-strategier for at øge din brands synli...

Google Gemini er en familie af multimodale store sprogmodeller (LLM’er) udviklet af Google DeepMind, der behandler og genererer tekst, billeder, lyd og video. Det repræsenterer Googles efterfølger til LaMDA og PaLM 2, designet til at forstå og ræsonnere på tværs af flere datatyper samtidigt, og driver Gemini AI-chatbotten samt er integreret i Googles økosystem af produkter og tjenester.

Google Gemini er en familie af multimodale store sprogmodeller (LLM'er) udviklet af Google DeepMind, der behandler og genererer tekst, billeder, lyd og video. Det repræsenterer Googles efterfølger til LaMDA og PaLM 2, designet til at forstå og ræsonnere på tværs af flere datatyper samtidigt, og driver Gemini AI-chatbotten samt er integreret i Googles økosystem af produkter og tjenester.

Google Gemini er en familie af multimodale store sprogmodeller (LLM’er) udviklet af Google DeepMind, som repræsenterer efterfølgeren til tidligere modeller som LaMDA og PaLM 2. I modsætning til traditionelle sprogmodeller, der kun behandler tekst, er Gemini grundlæggende designet til at håndtere flere datamodaliteter samtidigt, herunder tekst, billeder, lyd, video og softwarekode. Modellen driver Gemini AI-chatbotten (tidligere kendt som Bard) og er i stigende grad integreret i hele Googles økosystem af produkter og tjenester. Geminis multimodale arkitektur gør den i stand til at forstå komplekse relationer mellem forskellige typer information, hvilket gør den kompetent til opgaver lige fra billedeanalyse og kodegenerering til realtidsoversættelse og dokumentforståelse. Begrebet “Gemini” stammer fra latin og betyder “tvillinger”, hvilket henviser til samarbejdet mellem Google DeepMind- og Google Brain-teams, og var også inspireret af NASAs Project Gemini-rumprogram.

Googles rejse mod at skabe Gemini afspejler års grundforskning i store sprogmodeller og neurale netværksarkitekturer. I 2017 introducerede Google-forskere transformer-arkitekturen, et gennembrud i neurnal netværksdesign, som blev grundlaget for de fleste moderne LLM’er. Virksomheden udviklede efterfølgende Meena (2020), en samtale-AI med 2,6 milliarder parametre, efterfulgt af LaMDA (Language Model for Dialogue Applications) i 2021, som specialiserede sig i dialogopgaver. Lanceringen af PaLM (Pathways Language Model) i 2022 bragte forbedrede kode-, flersproglige og ræsonnementsevner. Google lancerede derefter Bard i begyndelsen af 2023, først drevet af en letvægts LaMDA-variant, før den blev opgraderet til PaLM 2 i midten af 2023. Virksomheden annoncerede officielt Gemini 1.0 i december 2023, hvilket markerede et betydeligt spring i multimodale kapaciteter. I 2024 omdøbte Google Bard til Gemini og udgav Gemini 1.5, som introducerede et revolutionerende 2 millioner token kontekstvindue. Senest har Gemini 2.0 og Gemini 2.5 (udgivet i december 2024) introduceret agentiske AI-evner, der gør det muligt for modellen at tage autonome handlinger og ræsonnere på tværs af udvidede kontekster. Denne udvikling demonstrerer Googles engagement i at fremme AI-kapaciteter samtidig med fokus på praktiske, virkelige anvendelser.

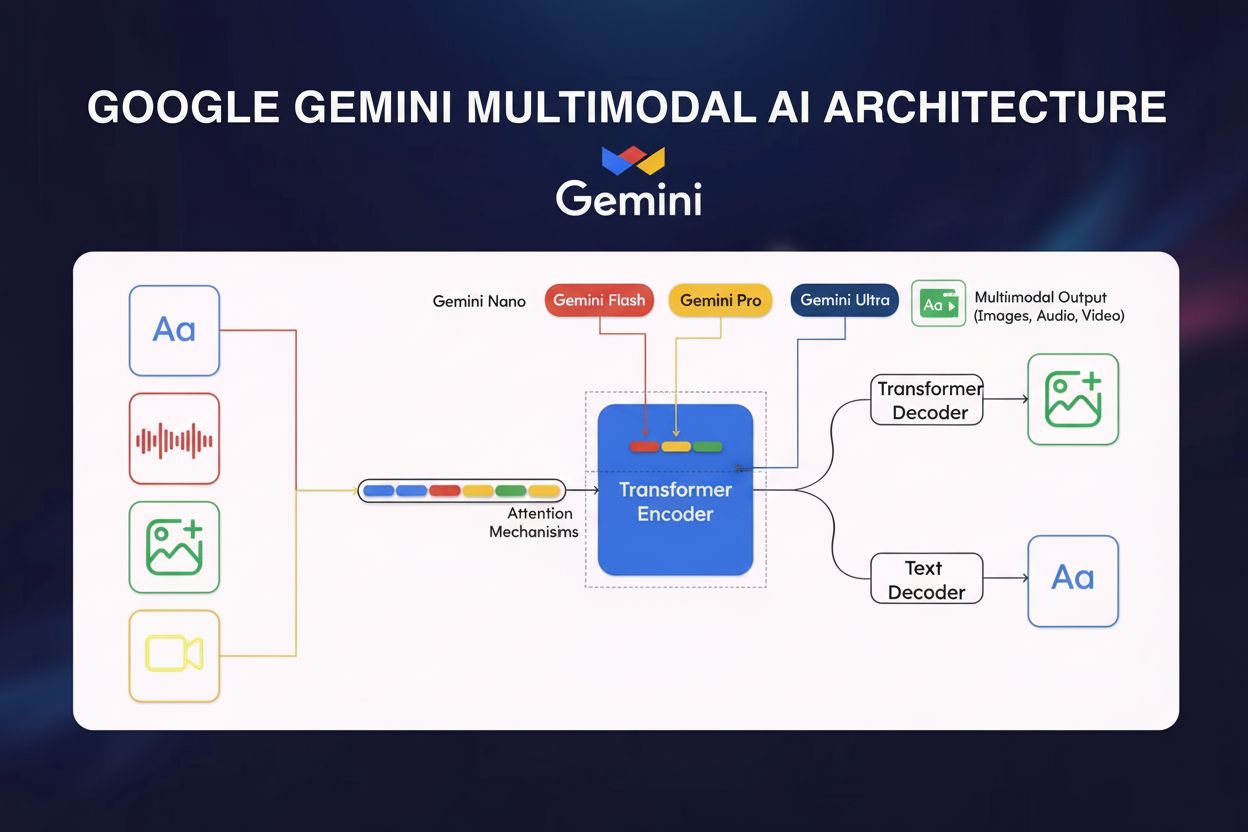

Det tekniske fundament for Google Gemini hviler på flere sofistikerede arkitektoniske innovationer, der adskiller den fra konkurrerende modeller. Kernen i Gemini er en transformer-baseret neuralt netværksarkitektur optimeret med Cloud TPU v5p (Tensor Processing Units) til højtydende træning og inferens. Modellens multimodale encoder integrerer visuelle data, tale og tekst gennem specialiserede behandlingsveje, der samles i et samlet repræsentationsrum. En central innovation er cross-modal attention-mekanismen, som gør det muligt for modellen at oprette meningsfulde forbindelser mellem forskellige datatyper—for eksempel at forbinde visuelle elementer i et billede med tekstbeskrivelser eller forstå, hvordan lydindhold relaterer sig til visuel kontekst. Gemini 1.5 Pro introducerede Mixture of Experts (MoE)-arkitekturen, som repræsenterer et paradigmeskifte i model-effektivitet. I stedet for at aktivere alle neurale netværksparametre for hvert input, deler MoE modellen op i mindre ekspert-netværk, der hver især specialiserer sig i bestemte domæner eller datatyper. Modellen lærer at aktivere kun de mest relevante eksperter baseret på inputkarakteristika, hvilket drastisk reducerer beregningsomkostningerne samtidig med at ydeevnen opretholdes eller forbedres. Denne arkitektur gør det muligt for Gemini 1.5 Flash at opnå sammenlignelig ydeevne med Gemini 1.0 Ultra, men med væsentligt højere effektivitet, opnået gennem vidensdestillation—en maskinlæringsteknik, hvor indsigt fra den større Pro-model overføres til den mere kompakte Flash-variant. Kontekstvinduet—antallet af tokens, en model kan behandle samtidigt—er steget dramatisk: fra 32.000 tokens i Gemini 1.0 til 1 million tokens i Gemini 1.5 Flash og 2 millioner tokens i Gemini 1.5 Pro, hvilket gør det muligt at behandle hele bøger, lange videoer eller tusindvis af kodelinjer på én gang.

| Modelvariant | Størrelse/Niveau | Kontekstvindue | Primære anvendelsestilfælde | Implementering | Nøglefordel |

|---|---|---|---|---|---|

| Gemini 1.0 Nano | Mindst | 32.000 tokens | Mobile opgaver, on-device behandling, billedbeskrivelse, chatbesvarelser | Android-enheder (Pixel 8 Pro+), Chrome desktop | Kører uden internetforbindelse |

| Gemini 1.0 Ultra | Størst | 32.000 tokens | Kompleks ræsonnement, avanceret kodning, matematisk analyse, multimodalt ræsonnement | Cloud-baseret, virksomhed | Højeste nøjagtighed på benchmarks |

| Gemini 1.5 Pro | Mellemstørrelse | 2 millioner tokens | Dokumentanalyse, koderepositorier, langformet indhold, virksomhedsapplikationer | Google Cloud, API-adgang | Længste kontekstvindue, balanceret ydeevne |

| Gemini 1.5 Flash | Letvægts | 1 million tokens | Hurtige svar, omkostningseffektiv behandling, realtidsapplikationer | Cloud, mobil, edge | Hastigheds- og effektivitetsoptimering |

| Gemini 2.0/2.5 | Next-generation | Variabel | Agentisk AI, autonom opgaveløsning, avanceret ræsonnement, realtidsinteraktion | Cloud, integrerede tjenester | Agentiske evner, forbedret ræsonnement |

Den multimodale karakter af Google Gemini repræsenterer et grundlæggende brud med tidligere AI-modeller, der primært opererede inden for én modalitet. Geminis evne til at behandle sammenflettede sekvenser af lyd, billede, tekst og video som både input og output muliggør sofistikerede ræsonnementsopgaver, der ville være umulige for enkeltmodalitetsmodeller. For eksempel kan Gemini analysere en video, udtrække relevant tekst fra frames, forstå talt dialog og generere omfattende sammendrag, der syntetiserer information på tværs af alle modaliteter. Denne evne har dybtgående konsekvenser for virkelige anvendelser: i medicinsk diagnostik kan Gemini analysere patientjournaler (tekst), medicinske billeder (visuelt) og patientinterviews (lyd) samtidigt for at give samlede vurderinger. I kundeservice kan den behandle kundehenvendelser (tekst), analysere produktbilleder, gennemgå videodemonstrationer og generere kontekstuelle svar. Cross-modal attention-mekanismen, der muliggør denne integration, fungerer ved at skabe delte repræsentationer, hvor information fra forskellige modaliteter kan påvirke hinandens behandling. Når et billede analyseres med tilhørende tekst, hjælper tekstkonteksten for eksempel den visuelle behandlingsvej med at fokusere på relevante billedområder, mens visuel information hjælper med at afklare tekstuelle referencer. Denne dobbelte indflydelse giver en mere holistisk forståelse end hvad der ville være muligt ved at behandle modaliteter uafhængigt. De praktiske konsekvenser for AI-overvågning og brandsporing er betydelige: når Gemini genererer svar, der inkluderer billeder, tekst og muligvis lyd, skal overvågningssystemer spore, hvordan brands optræder på tværs af alle disse modaliteter, ikke kun i tekstbaserede svar.

Google Gemini Ultra har demonstreret enestående ydeevne på tværs af flere standardiserede AI-benchmarks og har etableret sig som en yderst kapabel model i det konkurrencedygtige landskab for store sprogmodeller. På MMLU-benchmarket (Massive Multitask Language Understanding), der tester sprogforståelse på tværs af 57 forskellige emner, overgik Gemini Ultra endda menneskelige eksperter—et betydeligt milepæl i AI-udviklingen. For matematisk ræsonnement (GSM8K benchmark) overgik Gemini Ultra konkurrerende modeller som Claude 2, GPT-4 og Llama 2. Ved kodegenerering (HumanEval benchmark) demonstrerede Gemini overlegne evner, hvilket muliggør avanceret programmeringshjælp og kodeanalyse. Ydeevnen varierer dog på tværs af forskellige evalueringsmetrikker: mens Gemini Ultra udmærker sig i dokumentforståelse, billedforståelse og automatisk talegenkendelse, viser den mere beskedne forbedringer i områder som sund fornuft-ræsonnement (HellaSwag benchmark), hvor GPT-4 stadig har en fordel. Gemini 1.5-serien har vist sig særligt imponerende, idet både Flash- og Pro-varianterne matcher eller overgår Gemini 1.0 Ultra’s ydeevne, mens de tilbyder markant forbedret effektivitet og udvidede kontekstvinduer. Denne ydeevne er især relevant for AI-citationsovervågning: efterhånden som Geminis evner forbedres og brugerbasen vokser til 350 millioner månedlige aktive brugere, påvirker nøjagtigheden og omfanget af dens svar direkte, hvordan brands og domæner repræsenteres i AI-genereret indhold. Organisationer, der bruger platforme som AmICited, kan spore, om Geminis svar om deres brand er faktuelt korrekte og kontekstualiseret passende.

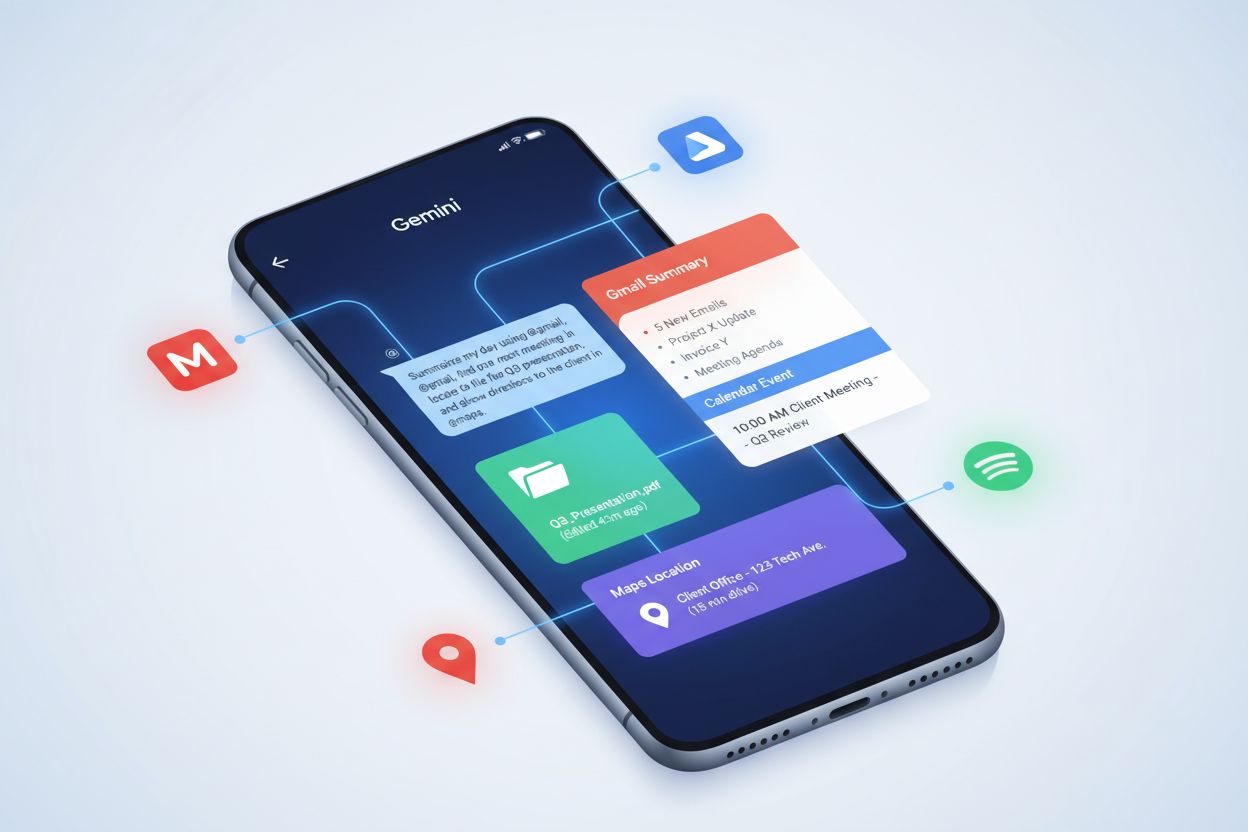

Den strategiske integration af Google Gemini i hele Googles produktøkosystem repræsenterer en af de mest omfattende implementeringer af en AI-model på tværs af en teknologivirksomheds tilbud. Gemini er nu standard AI-assistent på Google Pixel 9 og Pixel 9 Pro smartphones og erstatter den tidligere Google Assistant, hvilket gør den til den primære AI-grænseflade for millioner af brugere. I Google Workspace optræder Gemini i Docs-sidepanelet for at hjælpe med at skrive og redigere, i Gmail til at udarbejde beskeder og foreslå svar samt på tværs af andre produktivitetsapplikationer. Google Maps udnytter Geminis evner til at levere intelligente sammendrag af steder og områder, hvilket forbedrer brugeroplevelsen med kontekstuel information. Google Søgning har integreret Gemini gennem AI Overviews, som genererer omfattende svar på brugerforespørgsler ved at syntetisere information fra flere kilder. Gemini API er tilgængelig via Google AI Studio og Google Cloud Vertex AI, hvilket gør det muligt for udviklere at integrere Gemini-evner i tilpassede applikationer. Denne økosystemintegration har dybtgående konsekvenser for brandovervågning og AI-citationssporing. Når en bruger søger information om en virksomhed eller et produkt på Google Søgning, kan Gemini generere en AI Overview, der inkluderer eller udelader nævnelser af det brand. Når nogen bruger Gmail med Gemini, kan modellen nævne virksomhedsoplysninger i foreslåede svar. Når udviklere bygger applikationer med Gemini API’et, skaber de nye kontaktpunkter, hvor brands kan optræde i AI-genereret indhold. Denne udbredte integration gør omfattende overvågning på tværs af alle disse platforme essentiel for at opretholde brandets integritet og sikre korrekt repræsentation i AI-svar.

Fremkomsten af Google Gemini som en stor AI-platform med 350 millioner månedlige aktive brugere har skabt nye nødvendigheder for brandovervågning og AI-citationssporing. I modsætning til traditionelle søgemaskiner, hvor brands optræder i rangerede resultatlister, genererer Gemini syntetiserede svar, der måske eller måske ikke nævner specifikke virksomheder, produkter eller domæner. Når en bruger spørger Gemini om en bestemt branche eller et emne, beslutter modellen, hvilke kilder der skal refereres til, hvilken information der skal fremhæves, og hvordan brandnævnelser skal kontekstualiseres. Dette repræsenterer et betydeligt skift fra traditionel SEO, hvor synlighed afhænger af placering, til det, man kunne kalde “AI-citationsoptimering”—at sikre, at brands optræder korrekt og passende i AI-genererede svar. Den multimodale karakter af Gemini tilføjer kompleksitet til overvågningen: brands kan optræde ikke kun i tekstsvar, men også i billeder, lydtransskriptioner eller videoreferencer, som Gemini genererer. Integrationen af Gemini på tværs af Googles økosystem betyder, at brandnævnelser kan forekomme i flere sammenhænge: i Google Søgning AI Overviews, i Gmail-forslag, i Google Maps-sammendrag og i tilpassede applikationer bygget med Gemini API’et. Organisationer skal forstå, hvordan Gemini repræsenterer deres brand på tværs af disse forskellige kontekster, og om den leverede information er korrekt, komplet og passende kontekstualiseret. Platforme som AmICited imødekommer dette behov ved at overvåge, hvordan brands optræder i Gemini-svar sammen med andre AI-platforme som ChatGPT, Perplexity, Claude og Google AI Overviews, og giver omfattende indsigt i AI-genereret brandrepræsentation.

På trods af dens imponerende evner står Google Gemini over for flere dokumenterede udfordringer, som organisationer skal tage i betragtning, når de stoler på dens output. AI-bias blev et væsentligt problem i februar 2024, da Google satte Geminis billedgenerering på pause på grund af unøjagtige og forudindtagede fremstillinger af historiske personer, hvor modellen slettede historisk kontekst omkring raceforskellighed. Denne hændelse understregede, hvordan multimodale AI-systemer kan videreføre eller forstærke bias i træningsdata. Hallucinationer—tilfælde hvor modellen genererer faktuelt forkerte oplysninger—påvirker fortsat Gemini, især i AI Overviews, hvor brugere muligvis stoler på syntetiseret information uden verifikation. Google har anerkendt igangværende problemer med Gemini-understøttede søgeresultater, der lejlighedsvis producerer falske eller vildledende svar. Overtrædelser af ophavsret udgør en anden bekymring: Google fik en bøde i Frankrig (250 millioner euro) for at have trænet Gemini på ophavsretligt beskyttet nyhedsindhold uden forlags viden eller samtykke, hvilket rejser spørgsmål om datakilder og fair brug. Disse begrænsninger har direkte konsekvenser for brandovervågning: organisationer kan ikke antage, at information, Gemini giver om konkurrenter eller brancheemner, er korrekt, og de skal verificere, hvordan deres eget brand repræsenteres. Muligheden for, at Gemini genererer vildledende information om en virksomheds produkter, historie eller markedsposition, skaber risici, som traditionel søgemaskineovervågning ikke kan håndtere alene. Derudover betyder modellens tendens til at syntetisere information fra flere kilder uden altid tydeligt at angive kilder, at brandnævnelser i Gemini-svar kan mangle korrekt kontekst eller kildeangivelse.

Udviklingen af Google Gemini antyder fortsat udvidelse af kapaciteter, effektivitet og integration på tværs af Googles økosystem og videre. Gemini 2.0 og 2.5 introducerede agentiske AI-evner, der gør det muligt for modellen at tage autonome handlinger, planlægge flertrinsopgaver og ræsonnere på tværs af udvidede kontekster—en betydelig udvikling fra tidligere versioner, der primært svarede på brugerforespørgsler. Fremtidige versioner forventes yderligere at forfine ræsonnementsevner, håndtere endnu større kontekstvinduer og forbedre ydeevnen på specialiserede opgaver. Project Astra, Googles initiativ til at bygge universelle AI-agenter, repræsenterer den langsigtede vision for Gemini: AI-systemer, der kan behandle, huske og forstå multimodal information i realtid og muliggøre mere naturlige og kapable interaktioner. Project Mariner og andre forskningsinitiativer antyder, at Google undersøger, hvordan Gemini kan assistere med komplekst vidensarbejde og potentielt automatisere forskning, analyse og beslutningsprocesser. Integrationen af Gemini i flere Google-produkter og -tjenester vil sandsynligvis fortsætte og udvide de kontaktpunkter, hvor brands optræder i AI-genererede svar. Forbedringer i on-device effektivitet vil gøre Gemini mere tilgængelig på mobile enheder og edge computing-platforme og potentielt øge brugerbasen ud over de nuværende 350 millioner månedlige aktive brugere. Det konkurrenceprægede landskab vil også påvirke Geminis udvikling: efterhånden som andre AI-platforme som ChatGPT, Claude og Perplexity fortsætter deres udvikling, skal Google opretholde Geminis konkurrencefordele inden for multimodal behandling, integration med Google-tjenester og realtidsvidensadgang. For organisationer med fokus på AI-overvågning og brandrepræsentation betyder denne udvikling, at sporing af brands synlighed i Gemini-svar bliver stadig vigtigere, efterhånden som platformens kapaciteter udvides og brugerbasen vokser. Overgangen til agentisk AI rejser også nye spørgsmål om, hvordan autonome AI-systemer vil repræsentere og referere brands, når de træffer beslutninger eller handler på vegne af brugere.

Google Gemini repræsenterer et grundlæggende skift i, hvordan AI-systemer behandler information og genererer svar, med dybtgående konsekvenser for brandovervågning og AI-citationssporing. Som en multimodal AI-model med 350 millioner månedlige aktive brugere, integreret på tværs af Googles økosystem og under løbende udvikling mod mere kompetente agentiske systemer, er Gemini blevet en kritisk platform, som organisationer bør overvåge. I modsætning til traditionelle søgemaskiner, hvor synlighed afhænger af placering, skaber Geminis syntetiserede svar nye dynamikker, hvor brands måske eller måske ikke nævnes, og når de nævnes, kan de være repræsenteret korrekt eller ukorrekt. Modellens dokumenterede begrænsninger—herunder bias, hallucinationer og ophavsretslige bekymringer—understreger vigtigheden af aktiv overvågning frem for passiv tillid til AI-genereret information. Organisationer, der ønsker at opretholde brandets integritet og sikre korrekt repræsentation i AI-svar, skal indføre omfattende overvågningsstrategier, der sporer, hvordan deres brand optræder på tværs af Gemini og andre store AI-platforme. Dette repræsenterer en ny grænse inden for digital marketing og brand management, hvor succes ikke kun afhænger af traditionel SEO og søgesynlighed, men af forståelse og optimering af, hvordan AI-systemer repræsenterer og refererer brands i deres genererede svar.

Google Gemini er grundlæggende designet som en multimodal AI-model fra bunden, der behandler tekst, billeder, lyd og video samtidigt, hvorimod ChatGPT primært fokuserer på tekstbaserede interaktioner og Claude lægger vægt på sikkerhed og etisk ræsonnement. Geminis integration med Googles økosystem, herunder Google Søgning, Workspace og Cloud-tjenester, giver unikke fordele for virksomhedskunder. Derudover gør Geminis Mixture of Experts (MoE)-arkitektur det muligt selektivt at aktivere specialiserede neurale netværk, hvilket gør den mere effektiv til forskellige opgaver sammenlignet med traditionelle transformer-baserede metoder, som konkurrenterne bruger.

Google Gemini har nået 350 millioner månedlige aktive brugere pr. 2024, hvilket viser en hurtig udbredelse på tværs af Googles forbruger- og virksomhedstjenester. Platformen understøtter 1,5 milliarder månedlige interaktioner gennem Googles integrerede tjenester. Daglige aktive brugere steg fra 9 millioner i oktober 2024 til 35 millioner i april 2025, hvilket viser accelererende vækstrater. Denne vækstposition gør Gemini til en af de hurtigst voksende AI-platforme globalt, selvom den stadig ligger bag visse konkurrenter på nogle markeder.

Google Gemini findes i flere versioner optimeret til forskellige anvendelser: Gemini 1.0 Nano (mindst, til mobile enheder med 32K token kontekst), Gemini 1.0 Ultra (størst, til komplekse opgaver med 32K token kontekst), Gemini 1.5 Pro (mellemstørrelse med 2 millioner token kontekstvindue) og Gemini 1.5 Flash (letvægtsversion med 1 million token kontekst). De nyeste Gemini 2.0 og 2.5-modeller introducerer agentiske AI-evner og forbedret ræsonnement. Hver version er designet til specifikke implementeringsscenarier, fra on-device behandling til virksomhedsskala cloud-applikationer.

Gemini behandler flere datatyper gennem en samlet transformer-arkitektur med specialiserede kodere for hver modalitet (tekst, billede, lyd, video). Modellen bruger cross-modal attention-mekanismer til at forbinde information på tværs af forskellige formater, hvilket gør det muligt at forstå relationer mellem for eksempel tekstbeskrivelser og visuelt indhold. I modsætning til modeller, der kræver separate behandlingsrør for forskellige datatyper, tillader Geminis indfødte multimodale design sammenflettede sekvenser af forskellige modaliteter som både input og output, hvilket gør den mere effektiv og i stand til komplekse ræsonnementsopgaver.

Mixture of Experts-arkitekturen i Gemini 1.5 Pro opdeler modellen i mindre specialiserede neurale netværk, som hver fungerer som en 'ekspert' inden for specifikke domæner eller datatyper. Modellen lærer at aktivere kun de mest relevante eksperter baseret på inputtypen, hvilket resulterer i hurtigere ydeevne og lavere beregningsomkostninger. Denne tilgang gør det muligt for Gemini at skalere effektivt uden proportionalt øgede beregningskrav, hvilket gør den egnet til både ressourcebegrænsede mobile enheder og store virksomhedsimplementeringer.

Google Gemini bliver systematisk integreret på tværs af hele produktøkosystemet: det er standard AI-assistenten på Google Pixel 9-telefoner, tilgængelig i Google Workspace til dokumentredigering og e-mailudkast, integreret i Google Maps til lokationssammendrag og driver Google Søgningens AI Overviews. Gemini API'et er tilgængeligt via Google AI Studio og Google Cloud Vertex AI for udviklere. Denne udbredte integration gør Gemini til en kritisk komponent for overvågning af brandnævnelser i AI-genererede svar på tværs af Googles platforme, hvilket er særligt relevant for AI-overvågning og kildehenvisningssporing.

Google Gemini står over for flere dokumenterede udfordringer, herunder AI-bias-problemer (Google satte billedgenerering på pause i februar 2024 på grund af unøjagtige gengivelser af historiske personer), hallucinationer, der giver faktuelt forkerte svar i AI Overviews, og ophavsretlige bekymringer (Google blev idømt en bøde på 250 millioner euro i Frankrig for træning på ophavsretligt beskyttet nyhedsindhold uden forlagets samtykke). Disse begrænsninger understreger vigtigheden af at overvåge, hvordan Gemini repræsenterer brands og domæner i AI-genererede svar, hvilket gør værktøjer som AmICited essentielle for at spore nøjagtighed og brandsikkerhed.

Begynd at spore, hvordan AI-chatbots nævner dit brand på tværs af ChatGPT, Perplexity og andre platforme. Få handlingsrettede indsigter til at forbedre din AI-tilstedeværelse.

Lær, hvordan du optimerer dit indhold til Google Gemini og andre AI-søgemaskiner. Mestre Answer Engine Optimization (AEO)-strategier for at øge din brands synli...

Lær hvad Gemini-udvidelser er, hvordan de fungerer, og hvordan de muliggør AI-drevet produktivitet ved at forbinde Gemini med Gmail, Drive, Maps og andre tjenes...

Lær, hvordan du optimerer dit brand til Google Gemini-henvisninger. Opdag dokumenterede strategier til at øge synligheden i AI-genererede svar, hvor 52,15 % af ...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.