Hvad er GPTBot, og bør du tillade det? Komplet guide for websideejere

Lær hvad GPTBot er, hvordan det fungerer, og om du bør tillade eller blokere OpenAI's webcrawler. Forstå indflydelsen på dit brands synlighed i AI-søgemaskiner ...

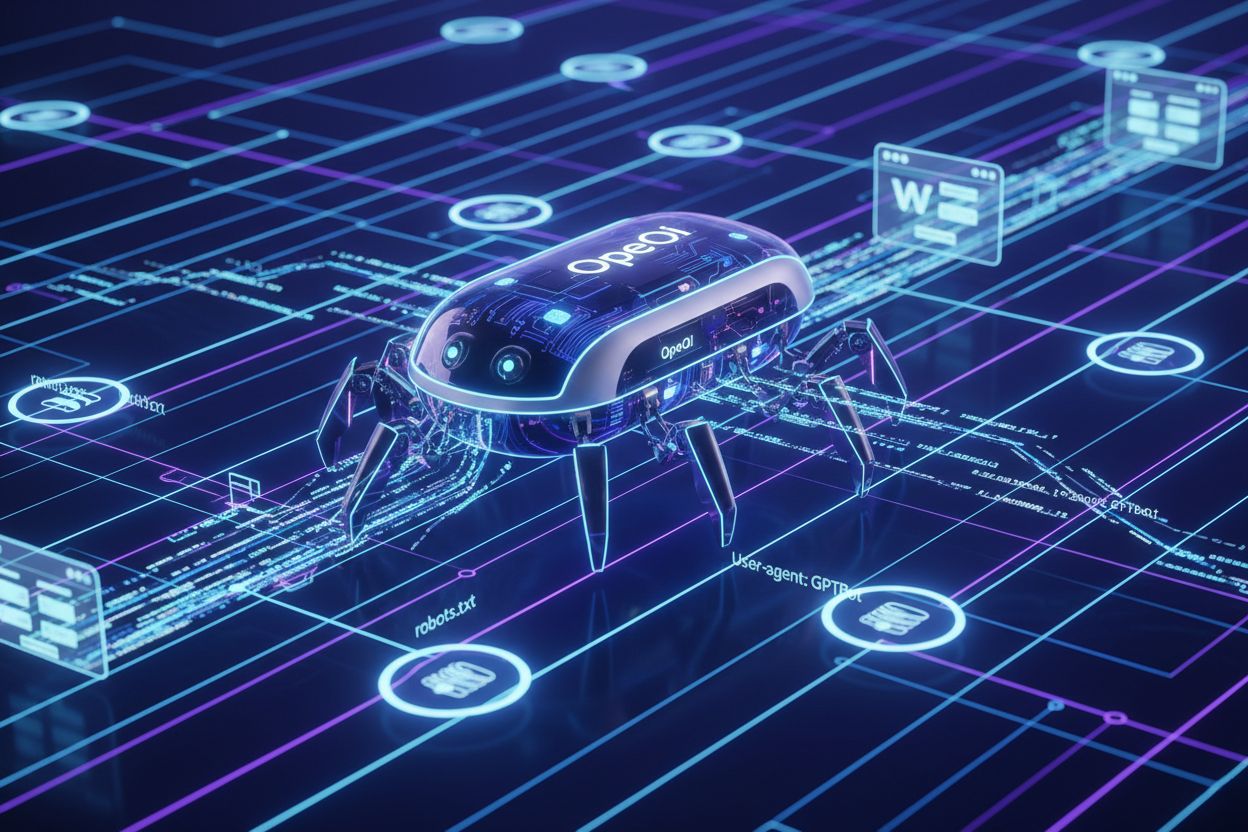

OpenAIs officielle webcrawler, der indsamler træningsdata til AI-modeller som ChatGPT og GPT-4. Webstedsejere kan styre adgang via robots.txt ved at bruge ‘User-agent: GPTBot’ direktiver. Crawleren overholder standard webprotokoller og indekserer kun offentligt tilgængeligt indhold.

OpenAIs officielle webcrawler, der indsamler træningsdata til AI-modeller som ChatGPT og GPT-4. Webstedsejere kan styre adgang via robots.txt ved at bruge 'User-agent: GPTBot' direktiver. Crawleren overholder standard webprotokoller og indekserer kun offentligt tilgængeligt indhold.

GPTBot er OpenAIs officielle webcrawler, designet til at indeksere offentligt tilgængeligt indhold fra internettet til træning og forbedring af AI-modeller som ChatGPT og GPT-4. I modsætning til generelle søgemaskine-crawlere som Googlebot arbejder GPTBot med en specifik mission: at indsamle data, der hjælper OpenAI med at forbedre sine sprogmodeller og levere bedre AI-baserede svar til brugerne. Webstedsejere kan identificere GPTBot via dens karakteristiske user agent string (“GPTBot/1.0”), som vises i serverlogs og analyseplatforme, når crawleren får adgang til deres sider. GPTBot respekterer robots.txt-filen, hvilket betyder, at webstedsejere kan styre, om crawleren får adgang til deres indhold, ved at tilføje specifikke direktiver til denne fil. Crawleren indekserer kun offentligt tilgængeligt indhold og forsøger ikke at omgå autentificering eller få adgang til begrænsede områder af websteder. Det er vigtigt for webstedsejere at forstå GPTBots formål og adfærd for at kunne træffe informerede beslutninger om, hvorvidt denne crawler skal have adgang til deres digitale ejendomme.

GPTBot fungerer ved systematisk at crawle websider, analysere deres indhold og sende data tilbage til OpenAIs servere til behandling og modeltræning. Crawleren tjekker først webstedets robots.txt-fil for at afgøre, hvilke sider den har tilladelse til at tilgå, og respekterer de direktiver, som webstedsejeren har angivet, før der påbegyndes nogen indekseringsaktivitet. Når GPTBot identificerer sig selv ved hjælp af sin user agent-string, downloader og behandler den sideindholdet og udtrækker tekst, metadata og strukturelle oplysninger, der anvendes i træningsdatasæt. Crawleren kan generere betydeligt båndbreddeforbrug, hvor nogle websteder rapporterer 30TB eller mere i månedlig crawlertrafik på tværs af alle bots, selvom GPTBots individuelle påvirkning varierer afhængigt af webstedets størrelse og indholdets relevans.

| Crawler-navn | Formål | Respekterer robots.txt | Indvirkning på SEO | Dataanvendelse |

|---|---|---|---|---|

| GPTBot | AI-modeltræning | Ja | Indirekte (AI-synlighed) | Træningsdatasæt |

| Googlebot | Søgeindeksering | Ja | Direkte (rangering) | Søgeresultater |

| Bingbot | Søgeindeksering | Ja | Direkte (rangering) | Søgeresultater |

| ClaudeBot | AI-modeltræning | Ja | Indirekte (AI-synlighed) | Træningsdatasæt |

Webstedsejere kan overvåge GPTBot-aktivitet gennem serverlogs ved at søge efter den specifikke user agent-string, så de kan følge crawl-frekvens og identificere potentielle performance-påvirkninger. Crawlerens adfærd er designet til at tage hensyn til serverressourcer, men websteder med meget trafik kan stadig opleve mærkbart båndbreddeforbrug, når flere AI-crawlere arbejder samtidigt.

Mange webstedsejere vælger at blokere GPTBot på grund af bekymringer om indholdsbrug uden kompensation, da OpenAI bruger crawlet indhold til at træne kommercielle AI-modeller uden at give direkte fordel eller betaling til indholdsskaberne. Serverbelastning udgør en anden væsentlig bekymring, især for mindre websteder eller dem med begrænset båndbredde, da AI-crawlere kan forbruge betydelige ressourcer—nogle sites rapporterer over 30TB månedlig crawlertrafik på tværs af alle bots, og GPTBot bidrager væsentligt til dette tal. Dataeksponering og sikkerhedsrisici bekymrer indholdsskabere, der frygter, at deres fortrolige oplysninger, forretningshemmeligheder eller følsomme data utilsigtet kan blive indekseret og brugt i AI-træning, hvilket potentielt kan kompromittere konkurrencefordele eller krænke fortrolighedsaftaler. Det juridiske landskab omkring AI-træningsdata er fortsat usikkert, med uløste spørgsmål om GDPR-overholdelse, CCPA-forpligtelser og ophavsretskrænkelser, hvilket skaber potentielle ansvar for både OpenAI og websteder, der tillader ubegrænset crawling. Statistikker viser, at cirka 3,5 % af websteder aktivt blokerer GPTBot, mens mere end 30 store publikationer blandt de 100 største websteder blokerer crawleren, herunder The New York Times, CNN, Associated Press og Reuters—hvilket indikerer, at indholdsskabere med høj autoritet anerkender betydelige risici. Kombinationen af disse faktorer har gjort blokering af GPTBot til en stadig mere almindelig praksis blandt udgivere, mediehuse og indholdstunge websteder, der ønsker at beskytte deres intellektuelle ejendom og bevare kontrollen over, hvordan deres indhold anvendes.

Webstedsejere, der giver GPTBot adgang, anerkender den strategiske værdi af ChatGPT-synlighed, idet platformen betjener omkring 800 millioner ugentlige brugere, der regelmæssigt interagerer med AI-genererede svar, som kan henvise til eller opsummere indekseret indhold. Når GPTBot crawler et websted, øges sandsynligheden for, at webstedets indhold bliver citeret, opsummeret eller nævnt i ChatGPT-svar, hvilket giver brandrepræsentation i AI-grænseflader og adgang til brugere, der i stigende grad vælger AI-værktøjer frem for traditionelle søgemaskiner. Forskning viser, at AI-søgetrafik konverterer 23x bedre end traditionel organisk søgetrafik, hvilket betyder, at brugere, der finder indhold gennem AI-opsummeringer og anbefalinger, har betydeligt højere engagement og konverteringsrater sammenlignet med almindelige søgemaskinebesøgende. At tillade GPTBot-adgang er en form for fremtidssikring, da AI-drevet søgning og indholdsopdagelse bliver stadig mere dominerende i måden, brugere finder information online, hvilket gør tidlig adoption af AI-synlighedsstrategier til en konkurrencefordel. Webstedsejere, der omfavner GPTBot, drager også fordel af Generative Engine Optimization (GEO), en voksende disciplin, der fokuserer på at optimere indhold til AI-systemer frem for traditionelle søgealgoritmer, hvilket kan skabe betydelig langsigtet trafikvækst. Ved at tillade GPTBot adgang positionerer proaktive udgivere og virksomheder sig til at fange trafik fra det hastigt voksende segment af brugere, der stoler på AI-værktøjer til informationssøgning og beslutningstagning.

At blokere GPTBot er ligetil og kræver kun ændringer i din websteds robots.txt-fil, som ligger i rodmappen og styrer crawleradgang på hele domænet. Den enkleste metode er at tilføje en fuld blokering for alle OpenAI-crawlere:

User-agent: GPTBot

Disallow: /

Hvis du ønsker at blokere GPTBot fra specifikke mapper, men tillade adgang til andre, brug målrettede direktiver:

User-agent: GPTBot

Disallow: /private/

Disallow: /admin/

Disallow: /api/

For at blokere alle OpenAI-relaterede crawlere, inklusive GPTBot, ChatGPT-User og ChatGPT-Plugins:

User-agent: GPTBot

User-agent: ChatGPT-User

User-agent: ChatGPT-Plugins

Disallow: /

Ud over ændringer i robots.txt kan webstedsejere implementere alternative blokeringsmetoder såsom IP-baseret blokering via firewalls, Web Application Firewalls (WAF), der filtrerer forespørgsler efter user agent, og rate limiting, der begrænser crawleres båndbreddeforbrug. For maksimal kontrol kombinerer nogle websteder flere tilgange—med robots.txt som primær mekanisme og IP-blokering som sekundær sikkerhedsforanstaltning mod crawlere, der ignorerer robots.txt-direktiver. Efter implementering af en blokeringsstrategi bør du verificere effekten ved at kontrollere dine serverlogs for GPTBot-user agent-strenge for at sikre, at crawleren ikke længere får adgang til dit indhold.

Visse brancher står over for særlige risici ved ubegrænset AI-crawleradgang og bør nøje overveje, om blokering af GPTBot passer til deres forretningsinteresser og indholdsbeskyttelsesstrategier:

Disse brancher bør implementere blokeringsstrategier for at opretholde konkurrencefordele, beskytte proprietær information og sikre overholdelse af databeskyttelsesregler.

Webstedsejere bør regelmæssigt overvåge deres serverlogs for at identificere GPTBot-aktivitet og følge crawler-mønstre, hvilket giver indsigt i, hvordan AI-systemer får adgang til og potentielt bruger deres indhold. Identifikation af GPTBot er nemt—crawleren identificerer sig via user agent-strengen “GPTBot/1.0” i HTTP-anmodningshoveder, hvilket gør den let at skelne fra andre crawlere i serverlogs og analyseplatforme. De fleste moderne analyseværktøjer og SEO-overvågningssoftware (herunder Google Analytics, Semrush, Ahrefs og specialiserede bot-overvågningsplatforme) kategoriserer og rapporterer automatisk GPTBot-aktivitet, så webstedsejere kan følge crawl-frekvens, båndbreddeforbrug og tilgåede sider uden manuel log-analyse. Gennemgang af serverlogs afslører detaljerede oplysninger om GPTBot-forespørgsler, herunder tidsstempler, tilgåede URL’er, svarkoder og båndbreddeforbrug, hvilket giver dybtgående indsigt i crawlerens adfærd. Regelmæssig overvågning er afgørende, da crawler-adfærd kan ændre sig over tid, nye AI-crawlere kan dukke op, og blokeringsstrategiens effektivitet kræver periodisk verificering for at sikre, at direktiver fungerer efter hensigten. Webstedsejere bør fastlægge basismålinger for normal crawlertrafik og undersøge væsentlige afvigelser, der kan indikere øget AI-crawleraktivitet eller potentielle sikkerhedsproblemer, der kræver opmærksomhed.

OpenAI har givet offentlige løfter om ansvarlig AI-udvikling og datahåndtering, herunder eksplicitte udmeldinger om, at GPTBot respekterer webstedsejeres præferencer, som udtrykt gennem robots.txt-filer og andre tekniske direktiver. Virksomheden fremhæver databeskyttelse og ansvarlig AI-praksis og anerkender, at indholdsskabere har legitime interesser i at kontrollere, hvordan deres arbejde bruges og kompenseres, selvom OpenAIs nuværende tilgang ikke tilbyder direkte kompensation til crawlede indholdsskabere. OpenAIs dokumenterede politik bekræfter, at GPTBot respekterer robots.txt-direktiver, hvilket betyder, at virksomheden har indbygget overholdelsesmekanismer i sin crawler-infrastruktur og forventer, at webstedsejere bruger standardtekniske værktøjer til at styre adgang. Virksomheden har også udtrykt vilje til at engagere sig med udgivere og indholdsskabere om dataanvendelsesbekymringer, selvom formelle licensaftaler og kompensationsordninger fortsat er begrænsede. OpenAIs politikker udvikler sig løbende som reaktion på juridiske udfordringer, regulering og branchefeedback, hvilket antyder, at fremtidige versioner af GPTBot kan inkludere yderligere sikkerhedsforanstaltninger, transparens eller kompensationsmekanismer. Webstedsejere bør følge med i OpenAIs officielle kommunikation og politikopdateringer for at forstå, hvordan virksomhedens tilgang til indholdscrawling og dataanvendelse kan ændre sig over tid.

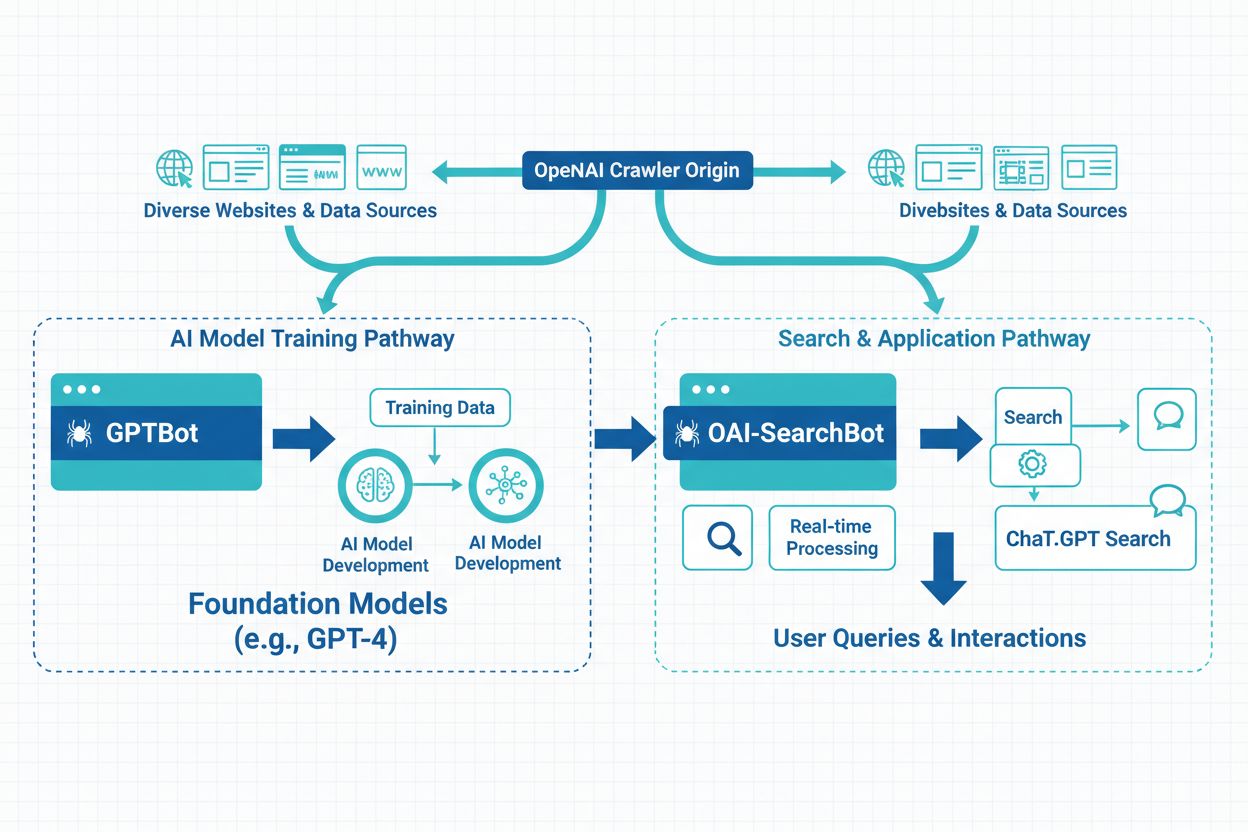

OpenAI driver tre forskellige crawlertyper til forskellige formål: GPTBot (generel webcrawling til modeltræning), ChatGPT-User (crawler links delt af ChatGPT-brugere) og ChatGPT-Plugins (tilgår indhold via plugin-integrationer)—hver med forskellige user agent-strenge og adgangsmønstre. Ud over OpenAIs crawlere omfatter AI-landskabet adskillige andre crawlere, der drives af konkurrerende virksomheder: Google-Extended (Googles AI-træningscrawler), CCBot (Commoncrawl), Perplexity (AI-søgemaskine), Claude (Anthropics AI-model) og nye crawlere fra andre AI-aktører, hver med forskellige formål og dataanvendelsesmønstre. Webstedsejere står over for et strategisk valg mellem selektiv blokering (målrettet specifikke crawlere som GPTBot, mens andre tillades) og omfattende blokering (begrænsning af alle AI-crawlere for at opretholde fuld kontrol over indholdsbrug). Fremkomsten af AI-crawlere betyder, at blokering af GPTBot alene muligvis ikke fuldt ud beskytter indholdet mod AI-træning, da andre crawlere stadig kan tilgå og indeksere det samme materiale via alternative mekanismer. Nogle webstedsejere implementerer lagdelte strategier, hvor de blokerer de mest aggressive eller kommercielt betydningsfulde crawlere, mens mindre eller forskningsfokuserede crawlere tillades adgang til indholdet. At forstå forskellene mellem disse crawlere hjælper webstedsejere med at træffe informerede beslutninger om, hvilke crawlere der bør blokeres ud fra deres specifikke bekymringer om dataanvendelse, konkurrencepåvirkning og forretningsmål.

ChatGPTs indflydelse på søgeadfærd ændrer fundamentalt, hvordan brugere opdager information, med 800 millioner ugentlige brugere, der i stigende grad vælger AI-værktøjer frem for traditionelle søgemaskiner, hvilket ændrer konkurrencesituationen for indholdssynlighed. AI-genererede sammenfatninger og udvalgte uddrag i ChatGPT-svar fungerer nu som alternative opdagelsesmekanismer, hvilket betyder, at indhold, der rangerer højt i traditionelle søgeresultater, kan blive overset, hvis det ikke udvælges til AI-genererede svar. Generative Engine Optimization (GEO) er blevet en afgørende disciplin for fremsynede indholdsskabere, med fokus på at optimere indholdsstruktur, klarhed og autoritet for at øge sandsynligheden for inklusion i AI-genererede svar og opsummeringer. De langsigtede synlighedskonsekvenser er betydelige: Websteder, der blokerer GPTBot, kan miste muligheder for at optræde i ChatGPT-svar og dermed reducere trafikken fra det hurtigt voksende segment af AI-drevne søgebrugere, mens dem, der tillader adgang, positionerer sig for AI-drevet opdagelse. Forskning indikerer, at 86,5 % af indholdet i Googles top 20 søgeresultater indeholder delvist AI-genererede elementer, hvilket viser, at AI-integration er ved at blive standard i søgelandskabet snarere end et nichefænomen. Konkurrencepositionering afhænger i stigende grad af synlighed på både traditionelle søgemaskiner og AI-systemer, hvilket gør strategiske beslutninger om GPTBot-adgang afgørende for langsigtet SEO-succes og organisk trafikvækst. Webstedsejere skal balancere hensynet til indholdsbeskyttelse mod risikoen for at miste synlighed i AI-systemer, der bliver primære opdagelsesmekanismer for millioner af brugere verden over.

GPTBot er OpenAIs officielle webcrawler, der er designet til at indsamle træningsdata til AI-modeller som ChatGPT og GPT-4. I modsætning til Googlebot, der indekserer indhold til søgeresultater, indsamler GPTBot data specifikt for at forbedre sprogmodeller. Begge crawlere respekterer robots.txt-direktiver og får kun adgang til offentligt tilgængeligt indhold, men de tjener grundlæggende forskellige formål i det digitale økosystem.

Beslutningen afhænger af dine forretningsmål og din indholdsstrategi. Bloker GPTBot, hvis du har proprietært indhold, opererer i regulerede brancher eller har bekymringer om intellektuel ejendomsret. Tillad GPTBot, hvis du ønsker synlighed i ChatGPT (800M ugentlige brugere), drager fordel af AI-søgetrafik (der konverterer 23x bedre end organisk), eller ønsker at fremtidssikre din digitale tilstedeværelse for AI-drevet søgning.

Tilføj disse linjer til din robots.txt-fil for at blokere GPTBot fra hele dit site: User-agent: GPTBot / Disallow: /. For at blokere specifikke mapper skal du erstatte skråstregen med stien til mappen. For at blokere alle OpenAI-crawlere skal du tilføje separate User-agent-poster for GPTBot, ChatGPT-User og ChatGPT-Plugins. Ændringer træder i kraft med det samme og er lette at fortryde.

GPTBots indvirkning varierer afhængigt af dit websteds størrelse og indholdets relevans. Selvom påvirkningen fra den enkelte crawler typisk er håndterbar, kan flere AI-crawlere, der arbejder samtidig, forbruge betydelig båndbredde—nogle sites rapporterer over 30TB månedlig crawlertrafik på tværs af alle bots. Overvåg dine serverlogs for at følge GPTBot-aktivitet og implementér begrænsninger eller IP-blokering, hvis båndbreddeforbruget bliver problematisk.

Ja, du kan bruge målrettede robots.txt-direktiver til at blokere GPTBot fra specifikke mapper eller sider, mens du tillader adgang til andre. For eksempel kan du afvise /private/ og /admin/ mapper, mens resten af dit site tillades. Denne selektive tilgang gør det muligt at beskytte følsomt indhold, mens du bevarer synlighed i AI-systemer for offentlige sider.

Tjek dine serverlogs for brugeragent-strengen 'GPTBot/1.0' i HTTP-anmodningshoveder. De fleste analyseplatforme (Google Analytics, Semrush, Ahrefs) kategoriserer og rapporterer automatisk GPTBot-aktivitet. Du kan også bruge SEO-overvågningsværktøjer, der specifikt sporer AI-crawler-aktivitet. Regelmæssig overvågning hjælper dig med at forstå crawl-frekvens og identificere eventuelle performance-påvirkninger.

Det juridiske landskab er stadig under udvikling. At tillade GPTBot rejser spørgsmål om GDPR-overholdelse, CCPA-forpligtelser og ophavsret, selvom OpenAI hævder at respektere robots.txt-direktiver. At blokere GPTBot er juridisk ligetil, men kan begrænse din synlighed i AI-systemer. Rådfør dig med juridisk rådgiver, hvis du opererer i regulerede brancher eller håndterer følsomme data for at finde den bedste tilgang for din situation.

At tillade GPTBot påvirker ikke direkte de traditionelle Google-placeringer, men øger din synlighed i ChatGPT-svar og andre AI-drevne søgeresultater. Med 800M ChatGPT-brugere og AI-søgetrafik, der konverterer 23x bedre end organisk, positionerer du dig for langsigtet synlighed i AI-systemer ved at tillade GPTBot. At blokere GPTBot kan reducere mulighederne for at optræde i AI-genererede svar og dermed begrænse trafikken fra det hurtigst voksende søgesegment.

Følg hvordan dit brand vises på ChatGPT, Perplexity, Google AI og andre AI-platforme. Få indsigt i realtid om AI-citater og synlighed med AmICited.

Lær hvad GPTBot er, hvordan det fungerer, og om du bør tillade eller blokere OpenAI's webcrawler. Forstå indflydelsen på dit brands synlighed i AI-søgemaskiner ...

Lær de vigtigste forskelle mellem GPTBot og OAI-SearchBot crawlere. Forstå deres formål, crawl-adfærd, og hvordan du kan administrere dem for optimal synlighed ...

Få indsigt i hvordan AI-crawlere som GPTBot og ClaudeBot fungerer, hvordan de adskiller sig fra traditionelle søgemaskinecrawlere, og hvordan du optimerer dit s...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.