Oprettelse af LLM Meta-svar: Selvstændige indsigter AI kan citere

Lær hvordan du skaber LLM meta-svar, som AI-systemer citerer. Opdag strukturelle teknikker, strategier for svartæthed og formater til indhold klar til citation,...

Indhold, der direkte adresserer, hvordan sprogmodeller kan fortolke og besvare relaterede forespørgsler, designet til at forbedre synligheden i AI-genererede svar på tværs af platforme som ChatGPT, Google AI Overviews og Perplexity. LLM Meta Answers repræsenterer syntetiserede svar, der kombinerer information fra flere kilder til sammenhængende, samtalebaserede svar, der imødekommer brugerens hensigt.

Indhold, der direkte adresserer, hvordan sprogmodeller kan fortolke og besvare relaterede forespørgsler, designet til at forbedre synligheden i AI-genererede svar på tværs af platforme som ChatGPT, Google AI Overviews og Perplexity. LLM Meta Answers repræsenterer syntetiserede svar, der kombinerer information fra flere kilder til sammenhængende, samtalebaserede svar, der imødekommer brugerens hensigt.

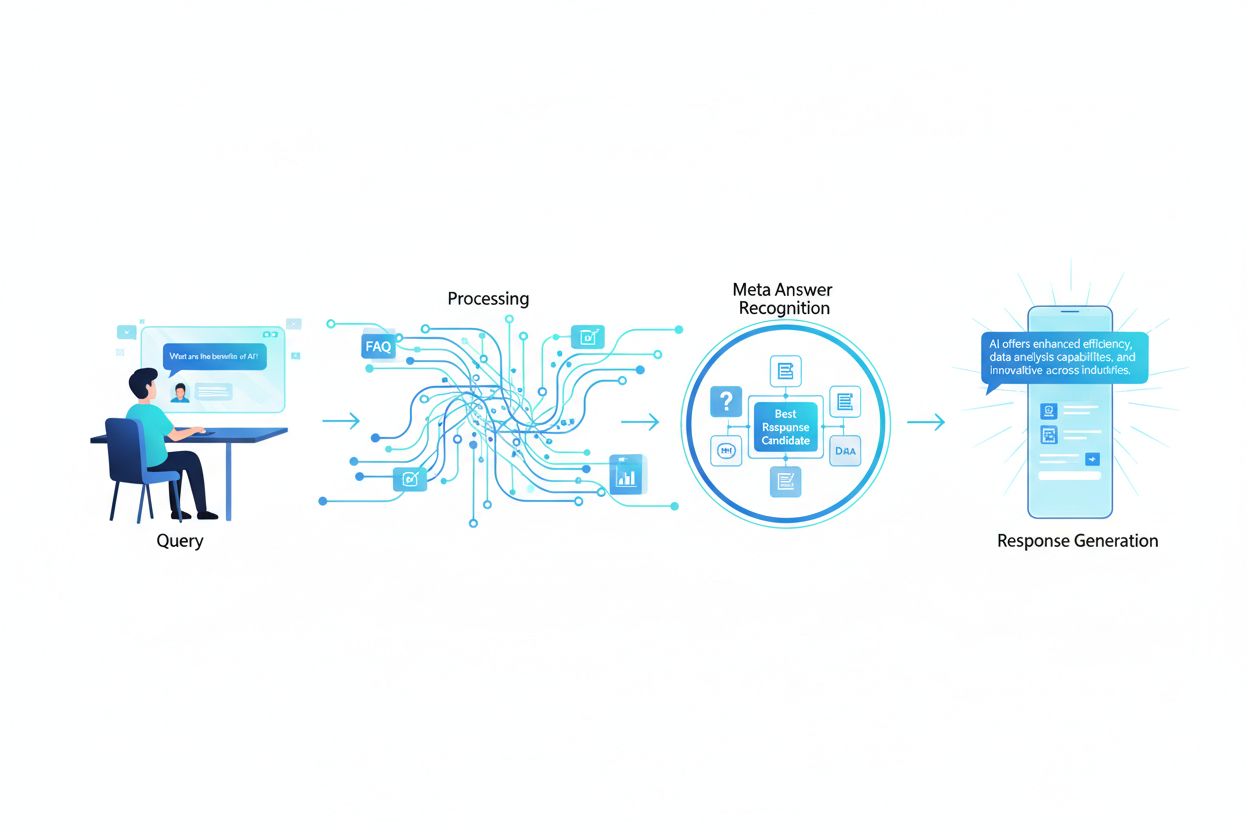

LLM Meta Answers repræsenterer de syntetiserede, AI-genererede svar, som store sprogmodeller producerer, når brugere forespørger dem via platforme som ChatGPT, Claude eller Google’s AI Overviews. Disse svar adskiller sig grundlæggende fra traditionelle søgeresultater, fordi de kombinerer information fra flere kilder til et sammenhængende, samtalebaseret svar, der direkte imødekommer brugerens hensigt. I stedet for at præsentere en liste af links analyserer LLM’er det indhentede indhold og genererer original tekst, der inkorporerer fakta, perspektiver og indsigter fra deres træningsdata og retrieval-augmented generation (RAG) systemer. At forstå, hvordan LLM’er konstruerer disse meta-svar, er essentielt for indholdsskabere, der ønsker, at deres arbejde skal citeres og refereres i AI-genererede svar. Synligheden af dit indhold i disse AI-svar er blevet lige så vigtig som rangering i traditionelle søgeresultater, hvilket gør LLM-optimering (LLMO) til en afgørende del af moderne indholdsstrategi.

Når en bruger sender en forespørgsel til en LLM, matcher systemet ikke blot søgeord som traditionelle søgemaskiner. I stedet udfører LLM’er semantisk analyse for at forstå den underliggende hensigt, kontekst og nuance i spørgsmålet. Modellen opdeler forespørgslen i konceptuelle komponenter, identificerer relaterede emner og entiteter og bestemmer, hvilken type svar der vil være mest hjælpsomt—hvad enten det er en definition, sammenligning, trin-for-trin guide eller analytisk perspektiv. LLM’er henter derefter relevant indhold fra deres vidensbase ved hjælp af RAG-systemer, der prioriterer kilder baseret på relevans, autoritet og fyldestgørelse. Indhentningsprocessen tager ikke kun højde for præcise søgeordsmatch, men også semantisk lighed, tematiske relationer og hvor godt indholdet adresserer de specifikke aspekter af forespørgslen. Det betyder, at dit indhold skal være opdageligt ikke bare for præcise søgeord, men for de semantiske begreber og relaterede emner, som brugerne faktisk spørger om.

| Forespørgselsfortolkning | Traditionel søgning | LLM Meta Answers |

|---|---|---|

| Matchingmetode | Søgeordsmatch | Semantisk forståelse |

| Resultatformat | Linkliste | Syntetiseret narrativ |

| Kildevalg | Relevansrangering | Relevans + fyldestgørelse + autoritet |

| Kontekstovervejelse | Begrænset | Omfattende semantisk kontekst |

| Svarkonstruktion | Brugeren skal læse flere kilder | AI kombinerer flere kilder |

| Citationskrav | Valgfrit | Ofte inkluderet |

For at dit indhold skal blive udvalgt og citeret i LLM meta-svar, skal det have flere kritiske egenskaber, der stemmer overens med, hvordan disse systemer vurderer og syntetiserer information. For det første skal dit indhold demonstrere klar ekspertise og autoritet om emnet, med stærke E-E-A-T-signaler (Erfaring, Ekspertise, Autoritet, Troværdighed), der hjælper LLM’er med at identificere pålidelige kilder. For det andet bør indholdet levere ægte informationsgevinst—unikke indsigter, data eller perspektiver, der tilfører værdi ud over det, der allerede findes. For det tredje skal dit indhold være struktureret, så LLM’er let kan analysere og udtrække relevant information, ved at bruge klare hierarkier og logisk organisering. For det fjerde er semantisk rigdom essentiel; dit indhold bør grundigt udforske relaterede begreber, bruge varieret terminologi og opbygge omfattende tematisk autoritet frem for at fokusere snævert på enkelte søgeord. For det femte er aktualitet meget vigtig for nutidige emner, da LLM’er prioriterer ny, opdateret information ved syntese af svar. Endelig bør dit indhold inkludere underbyggende dokumentation gennem citationer, data og eksterne referencer, der opbygger tillid hos LLM-systemerne.

Nøgleegenskaber, der øger LLM-citation:

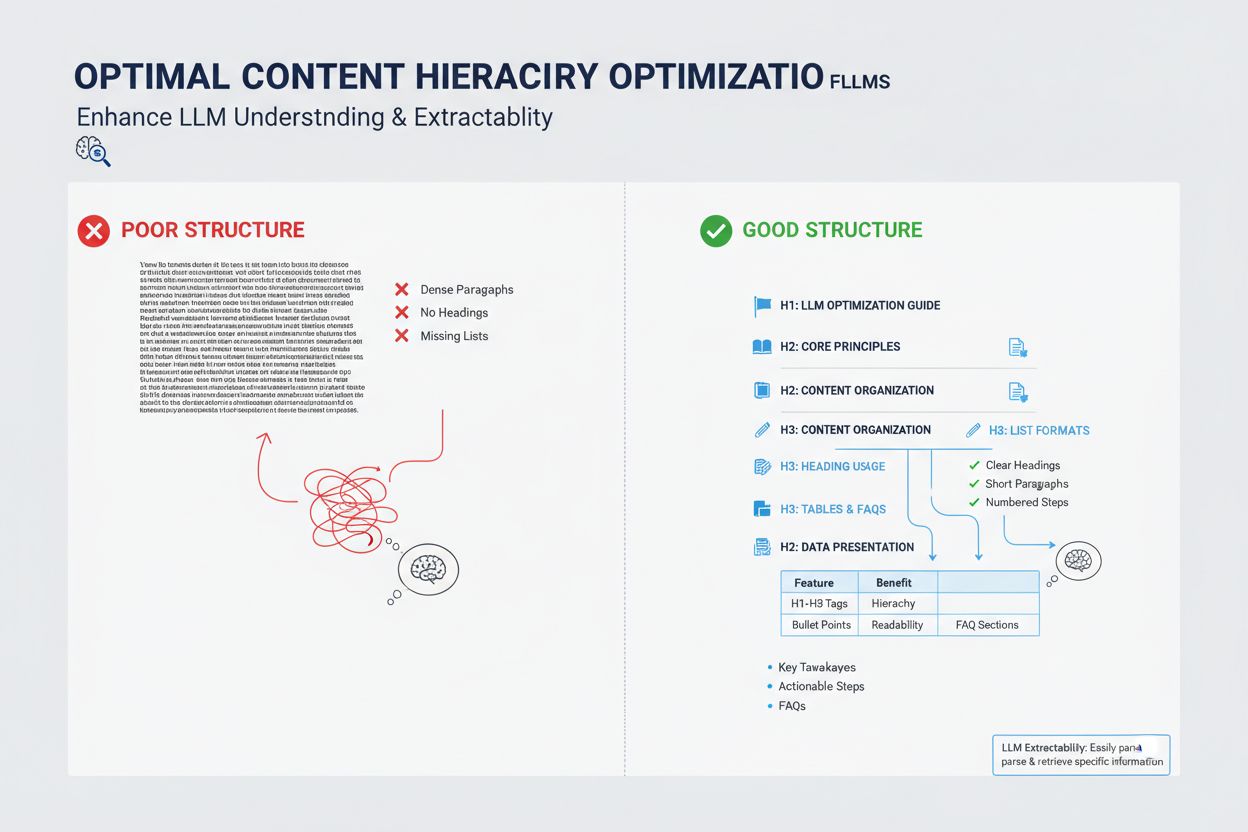

Måden du strukturerer dit indhold på har stor betydning for, om LLM’er vil udvælge det til meta-svar, da disse systemer er optimeret til at udtrække og syntetisere velorganiseret information. LLM’er foretrækker stærkt indhold med klare overskriftshierarkier (H1, H2, H3), der skaber logisk informationsarkitektur og gør det muligt for modellen at forstå relationen mellem begreber og finde relevante sektioner effektivt. Punktlister og nummererede lister er særligt værdifulde, fordi de præsenterer information i overskuelige, afgrænsede enheder, som LLM’er let kan inkorporere i deres syntetiserede svar. Tabeller er især effektive til LLM-synlighed, da de præsenterer strukturerede data i et format, som AI-systemer let kan analysere og referere til. Korte afsnit (3-5 sætninger) klarer sig bedre end tætte tekstblokke, da de gør det muligt for LLM’er at identificere og udtrække specifik information uden at skulle igennem irrelevant indhold. Derudover giver brugen af schema markup (FAQ, Artikel, HowTo) eksplicitte signaler til LLM’er om dit indholds struktur og formål, hvilket markant øger sandsynligheden for citation.

Selvom LLM meta-svar og fremhævede uddrag kan virke ens på overfladen, repræsenterer de grundlæggende forskellige mekanismer for indholdssynlighed og kræver forskellige optimeringsstrategier. Fremhævede uddrag udvælges af traditionelle søgealgoritmer fra eksisterende webindhold og vises på en bestemt position på søgeresultatsiden, typisk med 40-60 ord af udtrukket tekst. LLM meta-svar er derimod AI-genererede svar, der syntetiserer information fra flere kilder til en ny, original fortælling, der kan være længere og mere omfattende end nogen enkelt kilde. Fremhævede uddrag belønner indhold, der direkte besvarer et specifikt spørgsmål i et kort format, mens LLM meta-svar belønner omfattende, autoritativt indhold, der giver dybdegående temadækning. Citationsmekanismerne adskiller sig betydeligt: Fremhævede uddrag viser et kildelink, men indholdet udtrækkes ordret, mens LLM meta-svar kan omskrive eller syntetisere dit indhold og typisk inkluderer attribuering. Derudover er fremhævede uddrag primært optimeret til traditionel søgning, mens LLM meta-svar er optimeret til AI-platforme og måske slet ikke vises i søgeresultater.

| Aspekt | Fremhævede uddrag | LLM Meta Answers |

|---|---|---|

| Genereringsmetode | Algoritme udtrækker eksisterende tekst | AI syntetiserer fra flere kilder |

| Visningsformat | Position på søgeresultatside | AI-platformsvar |

| Indholdslængde | Typisk 40-60 ord | 200-500+ ord |

| Citationsstil | Kildelink med udtrukket tekst | Attribuering med omskrevet indhold |

| Optimeringsfokus | Korte, direkte svar | Omfattende autoritet |

| Platform | Google Søgning | ChatGPT, Claude, Google AI Overviews |

| Synlighedsmetrik | Søgevisninger | AI-svarscitationer |

Semantisk rigdom—dybden og bredden af konceptuel dækning i dit indhold—er en af de vigtigste, men ofte oversete faktorer i LLM-optimering. LLM’er leder ikke kun efter dit mål-søgeord; de analyserer de semantiske relationer mellem begreber, den kontekstuelle information omkring dit hovedemne, og hvor grundigt du udforsker relaterede idéer. Indhold med høj semantisk rigdom bruger varieret terminologi, udforsker flere vinkler af et emne og bygger forbindelser mellem relaterede begreber, hvilket hjælper LLM’er med at forstå, at dit indhold er reelt autoritativt og ikke blot overfladisk søgeordsoptimeret. Når du skriver om et emne, bør du inkludere relaterede termer, synonymer og konceptuelt beslægtede idéer, der hjælper LLM’er med at placere dit indhold i en bredere vidensgraf. For eksempel bør en artikel om “content marketing” naturligt inddrage diskussioner om målgruppesegmentering, køberpersonas, indholdsdistribution, analyse og ROI—not fordi du søgerordsstopper, men fordi disse begreber er semantisk relaterede og essentielle for at forstå emnet grundigt. Denne semantiske dybde signalerer til LLM’er, at du har reel ekspertise og kan levere de nuancerede, mangefacetterede svar, som brugerne efterspørger.

LLM’er vurderer autoritet anderledes end traditionelle søgemaskiner og lægger større vægt på signaler, der indikerer reel ekspertise og troværdighed frem for blot linkpopularitet. Oplysninger om forfatterens kvalifikationer og dokumenteret erfaring er særligt vigtige; LLM’er foretrækker indhold fra anerkendte eksperter, praktikere eller organisationer med etableret autoritet på deres område. Eksterne citationer og referencer til andre autoritative kilder opbygger troværdighed hos LLM-systemerne, da de viser, at dit indhold er forankret i bredere viden og underbygget af andre eksperter. Konsistens på tværs af flere indholdsstykker om et emne er med til at opbygge tematisk autoritet; LLM’er genkender, når en forfatter eller organisation har udgivet flere omfattende stykker om beslægtede emner. Tredjepartsvalidering gennem omtaler, citater eller referencer fra andre autoritative kilder øger din synlighed i LLM meta-svar markant. Original forskning, proprietære data eller unikke metoder giver stærke autoritetssignaler, fordi de repræsenterer information, der ikke kan findes andre steder. Derudover signalerer en opdateret udgivelseshistorik og regelmæssig opdatering, at du er aktivt engageret i dit emne og følger med i udviklingen.

Autoritetssignaler, der påvirker LLM-udvælgelse:

Indholdsaktualitet er blevet stadig vigtigere for LLM-synlighed, især for emner, hvor information ofte ændrer sig, eller hvor nyere udviklinger har stor betydning for svaret. LLM’er trænes på data med vidensgrænser, men de benytter i stigende grad RAG-systemer, der henter aktuel information fra nettet, hvilket betyder, at din udgivelsesdato og opdateringsfrekvens direkte påvirker, om dit indhold bliver udvalgt til meta-svar. For evergreen-emner signalerer regelmæssige opdateringer—selv mindre, der opfrisker udgivelsesdatoen—til LLM’er, at dit indhold bliver aktivt vedligeholdt og er pålideligt. For tidssensitive emner som branchens tendenser, teknologiske opdateringer eller aktuelle begivenheder bliver forældet indhold aktivt nedprioriteret af LLM-systemerne til fordel for nyere kilder. Best practice er at etablere en vedligeholdelsesplan, hvor du gennemgår og opdaterer nøgleindhold hvert kvartal eller halvårligt, opdaterer statistikker, tilføjer nye eksempler og inkorporerer de seneste udviklinger. Denne løbende vedligeholdelse forbedrer ikke kun din LLM-synlighed, men demonstrerer også over for både AI-systemer og menneskelige læsere, at du er en aktuel, troværdig informationskilde.

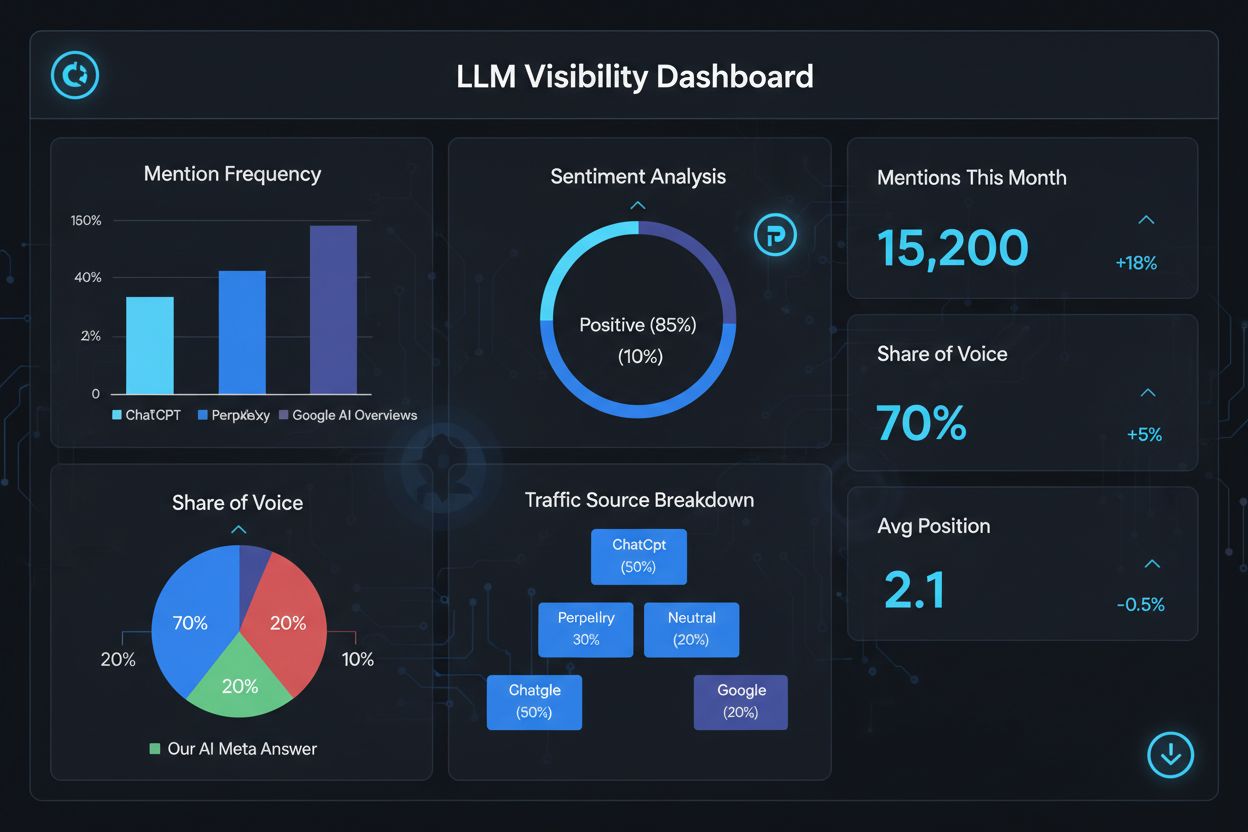

Måling af din succes med LLM meta-svar kræver andre metrikker og værktøjer end traditionel SEO, da disse svar eksisterer uden for det traditionelle søgeresultat-økosystem. Værktøjer som AmICited.com tilbyder specialiseret overvågning, der sporer, hvornår og hvor dit indhold vises i AI-genererede svar, og giver dig indsigt i, hvilke stykker der bliver citeret og hvor ofte. Du bør overvåge flere nøglemetrikker: citationshyppighed (hvor ofte dit indhold optræder i LLM-svar), citationskontekst (hvilke emner udløser, at dit indhold bliver inkluderet), kildediversitet (om du bliver citeret på forskellige LLM-platforme) og svarpositionering (om dit indhold er fremhævet i det syntetiserede svar). Spor hvilke specifikke sider eller sektioner af dit indhold, der citeres hyppigst, da det afslører, hvilke informationstyper LLM’er finder mest værdifulde og pålidelige. Overvåg ændringer i dine citationsmønstre over tid for at identificere, hvilke optimeringstiltag der virker, og hvilke emner der kræver yderligere udvikling. Analysér også de forespørgsler, der udløser dine citationer, for at forstå, hvordan LLM’er fortolker brugerhensigt, og hvilke semantiske variationer der er mest effektive.

Nøglemetrikker for LLM meta answer performance:

Optimering til LLM meta-svar kræver en strategisk tilgang, der kombinerer teknisk implementering, indholdskvalitet og løbende måling. Start med at udføre grundig tematisk research for at identificere huller, hvor din ekspertise kan tilføre unik værdi, som LLM’er vil prioritere over generiske kilder. Strukturer dit indhold med klare hierarkier ved at bruge H2- og H3-overskrifter for at skabe logisk informationsarkitektur, som LLM’er let kan analysere og udtrække fra. Implementér schema markup (FAQ, Artikel, HowTo) for eksplicit at signalere dit indholds struktur og formål til LLM-systemer, hvilket markant forbedrer opdageligheden. Udarbejd omfattende, autoritativt indhold, der grundigt udforsker dit emne fra flere vinkler, inkorporerer relaterede begreber og opbygger semantisk rigdom, der demonstrerer reel ekspertise. Inkludér original forskning, data eller indsigter, der giver informationsgevinst og differentierer dit indhold fra konkurrenterne. Oprethold en regelmæssig opdateringsplan, hvor nøgleindhold opdateres kvartalsvist, for at sikre aktualitet og signalere løbende autoritet. Opbyg tematisk autoritet ved at skabe flere relaterede stykker, der samlet etablerer din ekspertise på et fagområde. Brug klart, direkte sprog, der besvarer specifikke spørgsmål, brugerne stiller, så LLM’er let kan udtrække og syntetisere dit indhold. Overvåg endelig din LLM-citationsperformance med specialiserede værktøjer for at identificere, hvad der virker, og løbende forfine din strategi baseret på datadrevne indsigter.

LLM Meta Answers fokuserer på, hvordan sprogmodeller fortolker og citerer indhold, mens traditionel SEO fokuserer på placering i søgeresultater. LLM'er prioriterer relevans og klarhed frem for domæneautoritet, hvilket gør velformuleret, svar-først indhold vigtigere end backlinks. Dit indhold kan blive citeret i LLM-svar, selvom det ikke rangerer i Googles topresultater.

Strukturer indhold med klare overskrifter, giv direkte svar med det samme, brug schema markup (FAQ, Artikel), inkluder citationer og statistikker, oprethold faglig autoritet, og sørg for, at dit site kan gennemsøges af AI-bots. Fokuser på semantisk rigdom, informationsgevinst og omfattende emnedækning frem for snæver søgeordsoptimering.

LLM'er udtrækker uddrag fra velorganiseret indhold lettere. Klare overskrifter, lister, tabeller og korte afsnit hjælper modellerne med at identificere og citere relevant information. Studier viser, at sider citeret af LLM'er har væsentligt flere strukturelle elementer end gennemsnitlige websider, hvilket gør struktur til en kritisk rangeringsfaktor.

Ja. I modsætning til traditionel SEO prioriterer LLM'er forespørgslers relevans og indholdskvalitet frem for domæneautoritet. En velstruktureret, højt relevant niche-side kan blive citeret af LLM'er, selvom den ikke rangerer i Googles topresultater, hvilket gør ekspertise og klarhed vigtigere end site-autoritet.

Opdater indhold regelmæssigt, især for tidssensitive emner. Tilføj tidsstempler, der viser, hvornår indholdet sidst blev opdateret. For evergreen-emner anbefales kvartalsvise gennemgange. Friskt indhold signalerer nøjagtighed til LLM'er, forbedrer sandsynligheden for citation og demonstrerer løbende autoritet.

AmICited.com er specialiseret i at overvåge AI-omtaler på ChatGPT, Perplexity og Google AI Overviews. Andre værktøjer inkluderer Semrush's AI SEO Toolkit, Ahrefs Brand Radar og Peec AI. Disse værktøjer sporer omtalehyppighed, share of voice, sentiment og hjælper dig med at måle optimeringssucces.

Schema markup (FAQ, Artikel, HowTo) giver maskinlæsbar struktur, der hjælper LLM'er med at forstå og udtrække indhold mere præcist. Det signalerer indholdstype og formål, hvilket øger sandsynligheden for, at din side vælges til relevante forespørgsler og forbedrer den samlede synlighed.

Eksterne omtaler på højautoritetssider (nyheder, Wikipedia, branchepublikationer) opbygger troværdighed og øger chancen for, at LLM'er citerer dit indhold. Flere uafhængige kilder, der nævner dit brand eller data, skaber et mønster af autoritet, som LLM'er genkender og belønner med hyppigere citationer.

Følg, hvordan dit brand vises i AI-genererede svar på ChatGPT, Perplexity og Google AI Overviews med AmICited's specialiserede overvågningsplatform.

Lær hvordan du skaber LLM meta-svar, som AI-systemer citerer. Opdag strukturelle teknikker, strategier for svartæthed og formater til indhold klar til citation,...

Lær hvad LLMO er, hvordan det fungerer, og hvorfor det er vigtigt for AI-synlighed. Opdag optimeringsteknikker for at få dit brand nævnt i ChatGPT, Perplexity o...

Lær hvad LLMO er, og opdag gennemprøvede teknikker til at optimere dit brand for synlighed i AI-genererede svar fra ChatGPT, Perplexity, Claude og andre LLM'er....

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.