Spamdetektion

Spamdetektion identificerer uønsket, manipulerende indhold ved hjælp af ML-algoritmer og adfærdsanalyse. Lær hvordan AI-systemer filtrerer spam på tværs af e-ma...

Søgemaskinespam henviser til bevidste manipulationstaktikker, der bruges til kunstigt at påvirke søgemaskinernes placeringer gennem vildledende teknikker, som overtræder søgemaskinernes retningslinjer. Disse praksisser inkluderer keyword stuffing, cloaking, linkfarme og skjult tekst, designet til at narre algoritmer fremfor at give ægte værdi til brugerne.

Søgemaskinespam henviser til bevidste manipulationstaktikker, der bruges til kunstigt at påvirke søgemaskinernes placeringer gennem vildledende teknikker, som overtræder søgemaskinernes retningslinjer. Disse praksisser inkluderer keyword stuffing, cloaking, linkfarme og skjult tekst, designet til at narre algoritmer fremfor at give ægte værdi til brugerne.

Søgemaskinespam, også kendt som spamdexing, henviser til bevidst manipulation af søgemaskinernes indekser gennem vildledende teknikker, der er designet til kunstigt at forøge en hjemmesides placering. Begrebet dækker en bred vifte af uetiske praksisser, der overtræder søgemaskinernes retningslinjer, herunder keyword stuffing, cloaking, linkfarme, skjult tekst og snydende redirects. Disse taktikker prioriterer at narre søgealgoritmer frem for at give ægte værdi til brugerne, hvilket grundlæggende underminerer integriteten af søgeresultaterne. Når søgemaskiner opdager spam på en hjemmeside, pålægges der typisk sanktioner, der spænder fra fald i placering til fuldstændig fjernelse fra søgeindekser, så siden bliver usynlig for potentielle besøgende.

Søgemaskinespam har eksisteret siden internettets tidlige dage, hvor søgealgoritmer var mindre sofistikerede og lettere at manipulere. I 1990’erne og begyndelsen af 2000’erne spredte spamdexing-teknikker sig, da webmastere opdagede, at de kunne forøge placeringer gennem simpel gentagelse af nøgleord og linkmanipulation. Efterhånden som søgemaskiner udviklede sig, især efter Googles introduktion af PageRank og følgende algoritmeopdateringer som Panda (2011) og Penguin (2012), blev opdagelse og sanktionering af spam mere sofistikeret. Fremkomsten af SpamBrain, Googles AI-baserede spam-forebyggelsessystem introduceret i 2022, markerede et markant skifte mod maskinlæringsbaseret spam-opdagelse. I dag benytter søgemaskiner avancerede algoritmer, der analyserer hundreder af rangeringsfaktorer, hvilket gør traditionelle spam-taktikker stort set ineffektive, samtidig med at det skaber nye muligheder for sofistikerede manipulationforsøg.

Keyword stuffing er stadig en af de mest genkendelige spam-taktikker, hvor målrettede nøgleord gentages unaturligt gennem sideindhold, metatags og skjulte elementer. Denne praksis forøger kunstigt nøgleordsdensiteten uden at levere sammenhængende, værdifuld information til læseren. Cloaking repræsenterer en mere vildledende tilgang, hvor forskelligt indhold vises til søgemaskine-crawlere end det, brugerne ser i deres browsere – ofte ved hjælp af JavaScript eller server-side-teknikker til at skelne mellem bot- og menneskebesøgende. Linkfarme og Private Blog Networks (PBNs) udgør en anden stor kategori af spam, hvor netværk af lavkvalitetssider udelukkende oprettes for at generere kunstige backlinks til målsider. Disse netværk udnytter, at søgemaskiner historisk har vægtet backlinks højt som rangeringssignal, selvom moderne algoritmer er blevet dygtige til at identificere og nedvurdere sådanne kunstige linkordninger.

Snydende redirects manipulerer brugeradfærd ved at sende besøgende til andre URLs end dem, søgemaskiner crawler, og ofte omdirigeres brugerne til irrelevant eller skadeligt indhold efter klik fra søgeresultaterne. Skjult tekst og links indebærer placering af indhold i samme farve som baggrunden, brug af ekstremt små skrifttyper eller placering af tekst uden for skærmen – så det er usynligt for brugere, men stadig synligt for søgecrawlere. Kommentar- og forumspam udnytter bruger-genererede platforme ved automatisk at poste links og reklameindhold på blogs, fora og sociale medier. Contentscraping indebærer kopiering af indhold fra andre hjemmesider uden tilladelse eller ændring, og genudgivelse for kunstigt at forøge mængden af indhold og fange søgetrafik. Hver af disse taktikker er et forsøg på at snyde søgealgoritmer frem for at opnå placeringer på legitim vis.

| Aspekt | Søgemaskinespam (Black Hat) | Legitim SEO (White Hat) | Gray Hat SEO |

|---|---|---|---|

| Primært mål | Manipulere algoritmer gennem bedrag | Give værdi til brugere og opnå placeringer naturligt | Udnytte gråzoner i retningslinjerne |

| Indholdskvalitet | Lav kvalitet, keyword-stuffet eller scraped | Høj kvalitet, originalt, brugerfokuseret indhold | Blandet kvalitet med tvivlsomme taktikker |

| Linkbuilding | Kunstige links fra farme, PBNs eller hackede sider | Naturlige links opnået gennem kvalitetsindhold | Købte links eller bytteordninger |

| Tekniske metoder | Cloaking, skjult tekst, snydende redirects | Ren HTML, korrekte metatags, strukturerede data | JavaScript-redirects, doorway-sider |

| Brugeroplevelse | Dårlig; indhold designet til algoritmer, ikke brugere | Fremragende; indhold designet til brugerens tilfredshed | Moderat; visse kompromiser på brugeroplevelsen |

| Søgemaskinesanktioner | Manuelle handlinger, deindeksering, fald i rangering | Ingen; løbende forbedring i placeringer | Potentielle sanktioner ved opdagelse |

| Langtidsholdbarhed | Uholdbar; sanktioner er uundgåelige | Holdbar; opbygger varig autoritet | Risikabelt; afhænger af opdagelsesrisiko |

| Genopretningstid | Måneder til år; visse fordele er irreversible | N/A; ingen sanktioner at komme sig fra | Uger til måneder ved opdagelse |

SpamBrain repræsenterer et grundlæggende skifte i, hvordan søgemaskiner bekæmper spam via kunstig intelligens og maskinlæring. Introduceret af Google i 2022 analyserer SpamBrain mønstre på milliarder af hjemmesider for at identificere spamkarakteristika med hidtil uset nøjagtighed. Systemet opererer kontinuerligt og undersøger både on-page-faktorer (indholdskvalitet, nøgleordsfordeling, strukturelle elementer) og off-page-signaler (linkprofiler, domænehistorik, brugeradfærdsmønstre). SpamBrains maskinlæringsmodeller er trænet på store datasæt af kendt spam og legitime hjemmesider, hvilket gør systemet i stand til at genkende nye spamvarianter, før de bliver udbredte. AI-systemet kan identificere sofistikerede spamforsøg, der kan undslippe regelbaserede opdagelsessystemer, herunder koordinerede linkordninger, indholdsmanipulation og udnyttelse af hackede hjemmesider. Google har rapporteret, at SpamBrains forbedringer har reduceret lavkvalitets, uoriginalt indhold i søgeresultater med cirka 45% siden implementeringen, hvilket demonstrerer effektiviteten af AI-drevet spam-opdagelse.

Udbredelsen af søgemaskinespam forringer direkte kvaliteten og anvendeligheden af søgeresultater for slutbrugerne. Når spamindhold rangerer højt, møder brugerne irrelevant, lavkvalitets eller vildledende information i stedet for autoritative kilder, der reelt besvarer deres forespørgsler. Denne forringelse af søgekvaliteten underminerer brugernes tillid til søgemaskiner og tvinger platformene til at investere massivt i spam-opdagelse og fjernelse. Tilstedeværelsen af spam skaber også et urimeligt konkurrenceklima, hvor legitime virksomheder midlertidigt kæmper mod sider, der anvender uetiske teknikker. Søgemaskiner reagerer på spamudbredelse med periodiske spamopdateringer – markante forbedringer af deres spam-opdagelsessystemer, der annonceres og spores separat fra kernealgoritmeopdateringer. Googles december 2024 spamopdatering blev for eksempel udrullet globalt på alle sprog og tog op til en uge at implementere fuldt ud, hvilket demonstrerer omfanget og hyppigheden af spam-bekæmpelsesindsatsen. Den konstante kamp mellem spammere og søgemaskiner optager betydelige computerressourcer og ingeniørindsats, der ellers kunne bruges på at forbedre søgekvalitet.

Hjemmesider, der fanges i at anvende søgemaskinespam, står over for en bred vifte af konsekvenser – fra algoritmiske sanktioner til manuelle handlinger og fuldstændig deindeksering. Manuelle handlinger er Googles mest direkte svar på spam, hvor menneskelige gennemgange identificerer overtrædelser og pålægger specifikke sanktioner via Google Search Console. Disse handlinger informerer ejeren om konkrete overtrædelser – som unaturlige links, keyword stuffing eller cloaking – og fører typisk til markante fald i placeringer eller fjernelse fra søgeresultater. Algoritmiske sanktioner sker, når Googles automatiske systemer opdager spammønstre og reducerer sidens synlighed uden menneskelig indgriben. Disse sanktioner kan være midlertidige, indtil spam fjernes og siden recrawles, eller permanente, hvis overtrædelserne er alvorlige eller gentagne. I ekstreme tilfælde bliver hjemmesider deindekseret, hvilket betyder, at de ikke længere optræder i Googles søgeresultater og mister al organisk synlighed. Genopretning fra manuelle handlinger kræver omfattende udbedring, detaljeret dokumentation af ændringer og indsendelse af en anmodning om genovervejelse via Google Search Console. Selv efter vellykket genopretning kan hjemmesider dog ikke genvinde tidligere opnåede fordele fra spammy links – disse fordele er permanent tabt.

Fremkomsten af AI-drevne søgesystemer som ChatGPT, Perplexity, Google AI Overviews og Claude tilfører nye dimensioner til problemet med søgemaskinespam. Disse systemer er afhængige af webindhold for at generere svar, hvilket gør dem sårbare over for spam og lavkvalitetsindhold, der kan påvirke deres output. I modsætning til traditionelle søgemaskiner, som viser rangerede lister af resultater, syntetiserer AI-systemer information til naturlige sprog-svar, hvilket potentielt kan forstærke effekten af spamindhold, hvis det påvirker træningsdata eller retrieval-mekanismer. Organisationer som AmICited er opstået for at imødegå denne udfordring og tilbyder AI prompt-overvågningsplatforme, der sporer, hvor brands og domæner optræder i AI-genererede svar. Denne overvågning er afgørende, fordi spamindhold i AI-svar kan skade brandets omdømme og synlighed på måder, der adskiller sig fra traditionelle søgeresultater. Efterhånden som AI-systemer får større betydning for, hvordan brugere opdager information, vokser vigtigheden af at overvåge og forhindre spam i disse nye søgeparadigmer eksponentielt. Udfordringen for AI-systemer er at skelne mellem autoritative kilder og spamindhold, når de vælger, hvilke oplysninger de skal inkludere i deres svar.

Organisationer, der ønsker bæredygtig synlighed i søgning, bør implementere omfattende strategier for at undgå spam-taktikker og opretholde overensstemmelse med søgemaskinernes retningslinjer. Indholdsstrategi bør fokusere på at skabe originalt, højkvalitets, brugerfokuseret indhold, der naturligt indeholder relevante nøgleord uden kunstig gentagelse eller manipulation. Linkbuilding skal prioritere at opnå naturlige backlinks gennem kvalitetsindhold, branchekontakter og legitim outreach frem for købte links eller deltagelse i linkordninger. Teknisk SEO bør understøtte ren HTML, korrekte metatags, implementering af strukturerede data og gennemsigtige redirects, der behandler søgemaskiner og brugere ens. Regelmæssige audits af hjemmesidens indhold, links og tekniske elementer hjælper med at identificere potentielle spamproblemer, før de udløser sanktioner. Overvågningsværktøjer skal spore nøgleordsplaceringer, backlinkprofiler og søgesynlighed for at opdage usædvanlige ændringer, der kan indikere spamproblemer eller konkurrentangreb. Optimering af brugeroplevelsen sikrer, at indholdet primært tjener menneskelige besøgende, med søgemaskineoptimering som sekundært mål. Organisationer bør også etablere klare interne politikker, der forbyder spam-taktikker og uddanner teamet om risici og konsekvenser ved manipulation.

Fremtiden for opdagelse af søgemaskinespam vil i stigende grad afhænge af avancerede AI- og maskinlæringssystemer, der kan identificere sofistikerede manipulationer i realtid. SpamBrain og lignende AI-systemer vil fortsætte med at udvikle sig for at opdage nye spamvarianter hurtigere, end spammere kan udvikle dem, hvilket skaber et accelererende våbenkapløb mellem opdagelse og undvigelse. Integration af AI-drevne søgesystemer i den almindelige søgeoplevelse vil nødvendiggøre nye spam-opdagelsesmetoder, der er tilpasset til, hvordan disse systemer henter og syntetiserer information. Søgemaskiner vil sandsynligvis implementere mere avanceret analyse af brugeradfærd for at identificere spam baseret på, hvordan rigtige brugere interagerer med indhold, frem for kun at stole på tekniske signaler. Tværplatformsovervågning bliver stadig vigtigere, efterhånden som spam-taktikker udvikles til at målrette mod flere søgesystemer samtidig – traditionelle søgemaskiner, AI-chatbots og nye søgeparadigmer. Fremkomsten af generativt AI-indhold skaber nye spamudfordringer, da automatiserede systemer hurtigt kan generere indhold, der lyder plausibelt, men er lavkvalitets eller vildledende. Organisationer som AmICited vil spille en stadig mere kritisk rolle i at hjælpe brands med at overvåge deres synlighed på tværs af forskellige søgesystemer og opdage spamtrusler, før de påvirker synligheden. Den mest effektive spamforebyggelse vil ultimativt kombinere avanceret algoritmisk opdagelse med menneskelig ekspertise, brugerfeedback og branchesamarbejde for at opretholde søgekvalitet og brugertillid.

Søgemaskinespam overtræder søgemaskinens retningslinjer og bruger vildledende taktikker til at manipulere placeringer, mens legitim SEO følger white-hat-praksis, der giver ægte værdi til brugerne. Legitim SEO fokuserer på at skabe kvalitetsindhold, opnå naturlige backlinks og forbedre brugeroplevelsen, hvorimod spam-taktikker som keyword stuffing og cloaking forsøger at narre algoritmer. Googles retningslinjer forbyder eksplicit spam-taktikker, og hjemmesider der bruger dem risikerer manuelle sanktioner eller fuldstændig fjernelse fra søgeresultaterne.

Google bruger **SpamBrain**, et AI-baseret spam-forebyggelsessystem, der kontinuerligt overvåger hjemmesider for overtrædelser af spam-politikker. SpamBrain anvender maskinlæringsalgoritmer til at identificere mønstre forbundet med spam, herunder unaturlige linkprofiler, keyword stuffing, cloaking og andre vildledende teknikker. Systemet analyserer både on-page og off-page faktorer, brugeradfærdssignaler og indholdskvalitetsmålinger for at skelne mellem legitimt indhold og spam. Google udfører også manuelle gennemgange og modtager brugerindberetninger via Search Console for at identificere og straffe spammy hjemmesider.

De primære søgemaskinespam-taktikker inkluderer **keyword stuffing** (overfyldning af sider med nøgleord), **cloaking** (visning af forskelligt indhold til søgemaskiner og brugere), **snydende redirects** (omdirigering af brugere til andre sider end dem søgemaskiner ser), **linkfarme** (netværk af lavkvalitetssider udelukkende oprettet til linkformål), **skjult tekst og links** (indhold usynligt for brugere men synligt for crawlere), og **kommentarspam** (automatisk spam i kommentarer og fora). Hver taktik forsøger at manipulere søgealgoritmer gennem bedrag frem for at give ægte brugerværdi.

Google pålægger flere forskellige sanktioner for søgemaskinespam, fra fald i placering til fuldstændig fjernelse. Sider kan få **manuelle handlinger** via Google Search Console, der angiver specifikke overtrædelser, eller de kan blive ramt af algoritmiske spam-opdateringer, der automatisk reducerer synligheden. I alvorlige tilfælde kan hjemmesider fjernes helt fra Googles indeks og blive usynlige i søgeresultaterne. Genopretning kræver identifikation og fjernelse af alle spamelementer, hvorefter der skal anmodes om genovervejelse via Search Console. Genopretningsprocessen kan tage måneder, og nogle fordele i rangering mistet på grund af spam-links kan ikke genvindes.

Søgemaskinespam udgør betydelige udfordringer for AI-drevne søgesystemer som **ChatGPT**, **Perplexity** og **Google AI Overviews**. Disse systemer er afhængige af webindhold til at generere svar, og spamindhold kan forurene deres træningsdata eller påvirke deres output. Platforme som AmICited overvåger, hvor brands og domæner optræder i AI-svar, hvilket hjælper organisationer med at spore, om spam eller lavkvalitetsindhold påvirker deres synlighed. Efterhånden som AI-systemer bliver mere udbredte, bliver spam-opdagelse stadig vigtigere for at sikre, at disse platforme leverer nøjagtig og pålidelig information til brugerne.

Ja, hjemmesider kan komme sig over spamsanktioner, men processen kræver omfattende udbedring. Ejerne skal identificere alle spamelementer – herunder keyword stuffing, unaturlige links, cloaking og skjult indhold – og fjerne dem helt. Efter oprydningen skal der indsendes en anmodning om genovervejelse via Google Search Console med detaljeret dokumentation for ændringerne. Genopretning tager typisk flere måneder, da Googles systemer skal genindekser og revurdere siden. Dog kan fordelene ved tidligere spammy links ikke genvindes, og siderne skal fokusere på at opbygge legitim autoritet gennem kvalitetsindhold og naturlig linkopbygning.

Overvågning af søgemaskinespam er afgørende, fordi spamindhold kan skade brandets omdømme og synlighed på tværs af søgeplatforme. Konkurrenter kan bruge spam-taktikker rettet mod dit brand, eller dit eget website kan blive kompromitteret og brugt til spam. Værktøjer som **AmICited** hjælper organisationer med at spore deres brandomtale på tværs af AI-søgesystemer og traditionelle søgemaskiner og identificere, om spam eller lavkvalitetsindhold vises i stedet for legitim brandinformation. Denne overvågning muliggør proaktiv opdagelse af spamproblemer og hjælper med at opretholde brandets integritet i søgeresultater og AI-genererede svar.

Begynd at spore, hvordan AI-chatbots nævner dit brand på tværs af ChatGPT, Perplexity og andre platforme. Få handlingsrettede indsigter til at forbedre din AI-tilstedeværelse.

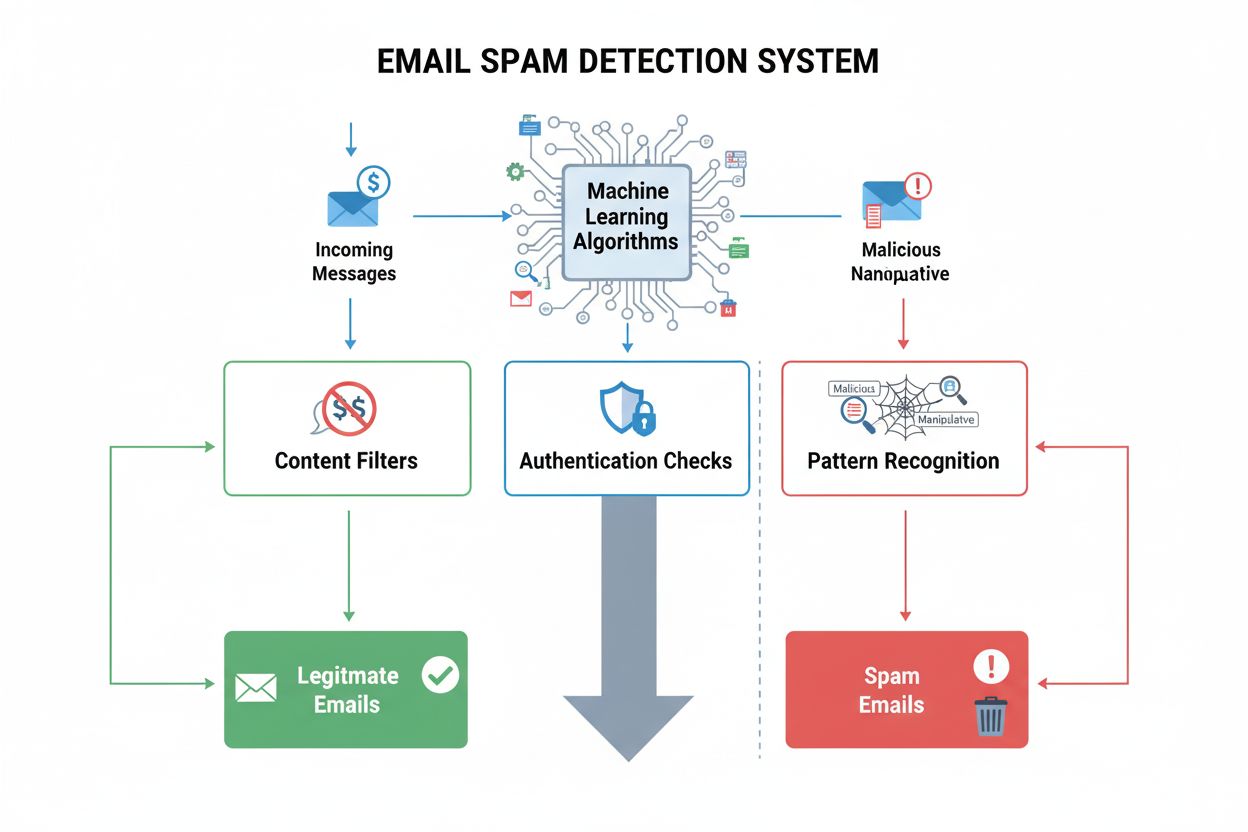

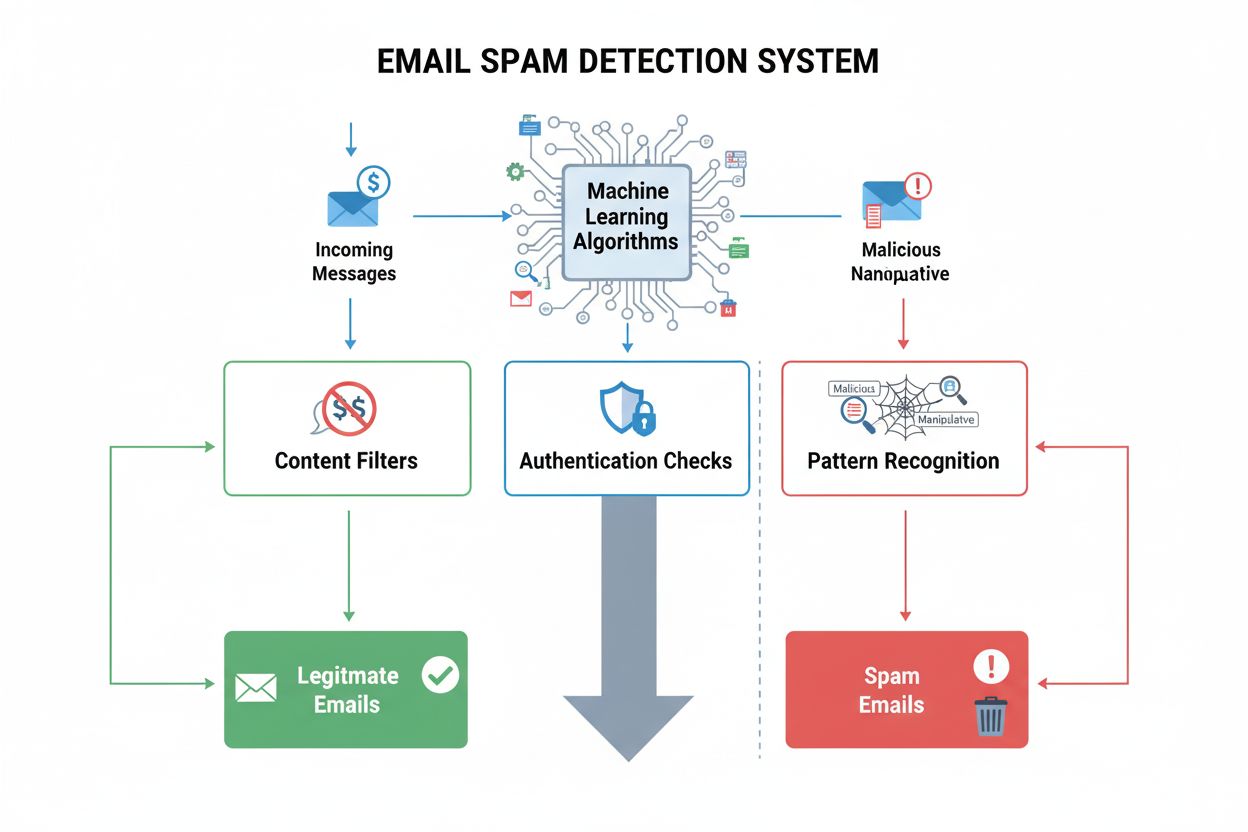

Spamdetektion identificerer uønsket, manipulerende indhold ved hjælp af ML-algoritmer og adfærdsanalyse. Lær hvordan AI-systemer filtrerer spam på tværs af e-ma...

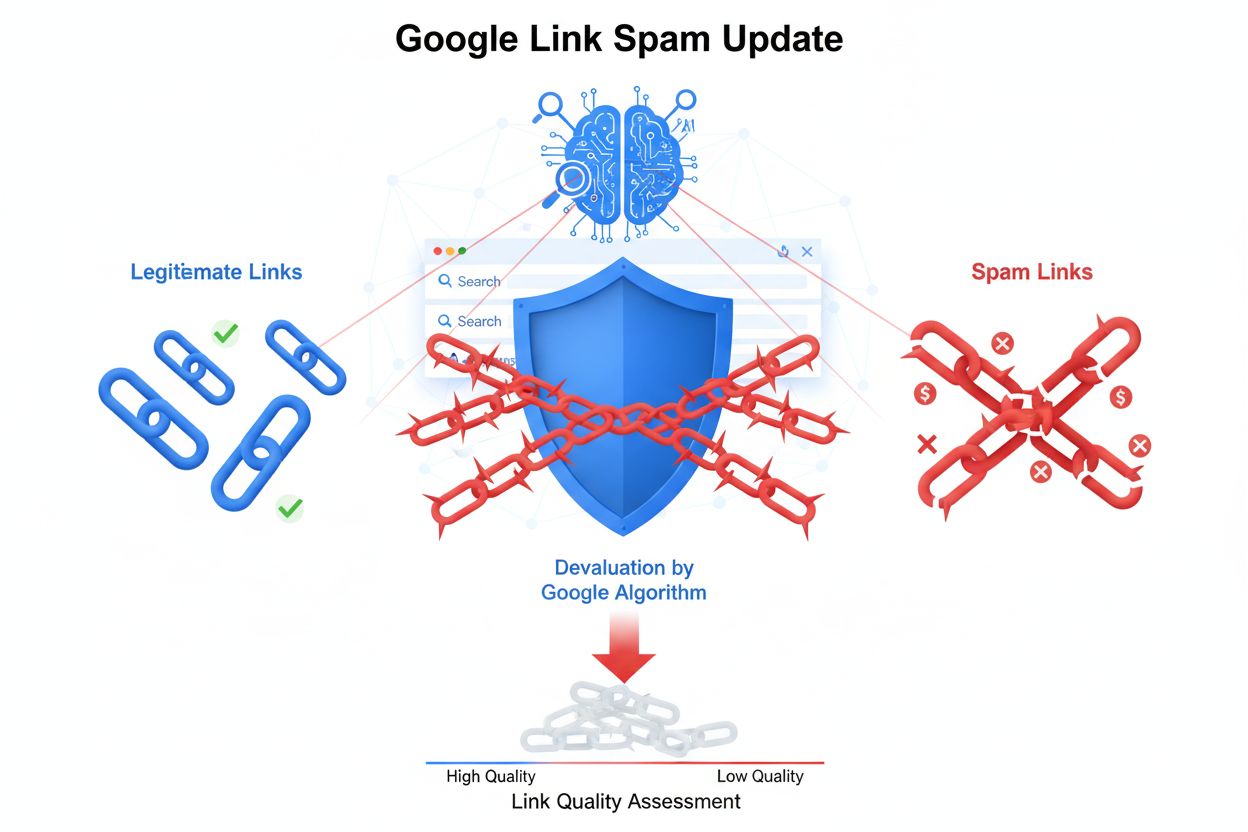

Lær om Googles Link Spam-opdatering, der nedvurderer manipulerende backlinks. Forstå hvordan SpamBrain opdager link spam, indvirkning på SEO og bedste praksis f...

Lær hvad Google Spamopdateringer er, hvordan de målretter spam-taktikker som misbrug af udløbne domæner og masseproduceret indhold, samt deres indvirkning på SE...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.