Wie Datenvisualisierungen die KI-Suche und LLM-Sichtbarkeit unterstützen

Erfahren Sie, wie Datenvisualisierungen die Sichtbarkeit in der KI-Suche verbessern, LLMs beim Verständnis von Inhalten helfen und Zitierungen in KI-generierten...

Erfahren Sie, wie KI-Modelle visuelle Daten und Diagramme zitieren. Lernen Sie, warum Datenvisualisierung für KI-Zitationen wichtig ist und wie Sie Ihre visuellen Inhalte mit AmICited nachverfolgen können.

Visuelle Daten stellen einen grundlegenden Engpass für moderne große Sprachmodelle dar, die hauptsächlich auf textbasierten Informationen trainiert wurden und Schwierigkeiten haben, Diagramme mit derselben Präzision wie geschriebene Inhalte zu verarbeiten, zu interpretieren und zu zitieren. Aktuelle LLMs stehen vor erheblichen Einschränkungen, wenn sie auf Datenvisualisierungen stoßen—sie müssen visuelle Elemente zunächst in Textbeschreibungen umwandeln, wobei oft wesentliche Nuancen, genaue Werte und kontextuelle Beziehungen verloren gehen, die im ursprünglichen Diagramm enthalten sind. Die Unfähigkeit von LLM-Systemen, visuelle Daten präzise zu verarbeiten, führt dazu, dass Diagramme, Grafiken und Infografiken häufig gar nicht oder falsch zitiert werden, was eine Glaubwürdigkeitslücke für Content-Ersteller schafft, die Zeit in hochwertige Visualisierungen investieren. Diese Herausforderung ist besonders für Forschende, Analysten und Organisationen relevant, die auf KI-gestützte Diagrammverarbeitung zur Informationssynthese angewiesen sind, denn fehlende Quellenangaben untergraben sowohl die Arbeit des ursprünglichen Erstellers als auch die Zuverlässigkeit KI-generierter Zusammenfassungen. Das Verständnis dieser Grenzen ist für alle, die in einer zunehmend KI-getriebenen Informationslandschaft visuelle Inhalte erstellen, unerlässlich.

Unterschiedliche KI-Systeme gehen die Zitation visueller Inhalte mit verschiedenem Anspruch und nach unterschiedlichen Trainingsmethoden an. Die folgende Tabelle zeigt, wie große KI-Plattformen visuelle Zitationen handhaben:

| KI-Modell | Fähigkeit zur visuellen Zitation | Zitationsformat | Genauigkeitsniveau | Multimodale Unterstützung |

|---|---|---|---|---|

| ChatGPT (GPT-4V) | Mittel | Beschreibender Text | 65–75 % | Ja (Bildeingabe) |

| Claude 3 | Hoch | Detaillierte Quellenangabe | 80–85 % | Ja (vision-enabled) |

| Perplexity AI | Hoch | Quelle + visuelle Referenz | 85–90 % | Ja (web-integriert) |

| Google AI Overviews | Mittel–hoch | Inline-Zitationen | 75–80 % | Ja (Bildersuche) |

| Gemini Pro Vision | Mittel | Kontextuelle Referenz | 70–78 % | Ja (multimodal) |

Claude zeigt eine überlegene Leistung bei der Quellenangabe visueller Inhalte, indem es oft detaillierte Quelleninformationen und visuellen Kontext bereitstellt, während Perplexity AI bei der Integration von visuellen Zitationen mit Webquellen besonders stark ist und so eine umfassende Zuordnung ermöglicht. ChatGPTs GPT-4V kann zwar Bilder verarbeiten, liefert aber häufig nur generische Beschreibungen anstelle präziser Zitationen, insbesondere bei komplexen Finanzdiagrammen oder wissenschaftlichen Visualisierungen. Google AI Overviews versucht, Inline-Zitationen für visuelle Inhalte beizubehalten, verwechselt jedoch manchmal den Diagrammersteller mit der Datenquelle, was die eindeutige Zuordnung erschwert. Für Content-Ersteller bedeutet diese Varianz, dass dieselbe Visualisierung je nach KI-System ganz unterschiedlich behandelt werden kann—ein Diagramm wird etwa in Claude korrekt zitiert, bleibt jedoch in ChatGPT völlig unbeachtet. Das unterstreicht den dringenden Bedarf an standardisierten Protokollen für visuelle Zitationen im KI-Ökosystem.

Datenvisualisierung spielt eine überraschend einflussreiche Rolle bei der Bildung des KI-Verständnisses und der Repräsentation von Informationen, da in Trainingsdatensätzen eingebettete Diagramme und Grafiken den Modellen helfen, Muster, Beziehungen und Hierarchien in komplexen Daten zu erkennen. Die Qualität und Vielfalt der visuellen Daten in Trainingssets bestimmt maßgeblich, wie gut KI-Systeme später ähnliche Visualisierungen interpretieren und zitieren können—Modelle, die mit umfassenden visuellen Datensätzen trainiert wurden, zeigen deutlich bessere Leistungen bei der Quellenangabe visueller Inhalte. Visuelle Muster, die während des Trainings gelernt werden, prägen die Modellausgaben auf subtile, aber messbare Weise: Ein Modell, das intensiv mit korrekt beschrifteten wissenschaftlichen Diagrammen trainiert wurde, wird mit größerer Wahrscheinlichkeit akkurate Zitationen für ähnliche Visualisierungen generieren als eines, das hauptsächlich auf Textdaten basiert. Die Herausforderung ist besonders groß, weil die meisten großen Sprachmodelle auf Internetdaten trainiert wurden, in denen visuelle Inhalte oft keine Metadaten, Alt-Texte oder Quellenangaben besitzen—so setzt sich ein Kreislauf fort, in dem KI-Systeme lernen, Diagramme zu verarbeiten, aber nicht, sie zu zitieren. Organisationen, die in qualitativ hochwertige, gut dokumentierte Datensätze zur Visualisierung investieren, schaffen so bessere Grundlagen für künftige KI-Systeme, auch wenn dieses Potenzial in der Branche noch wenig genutzt wird.

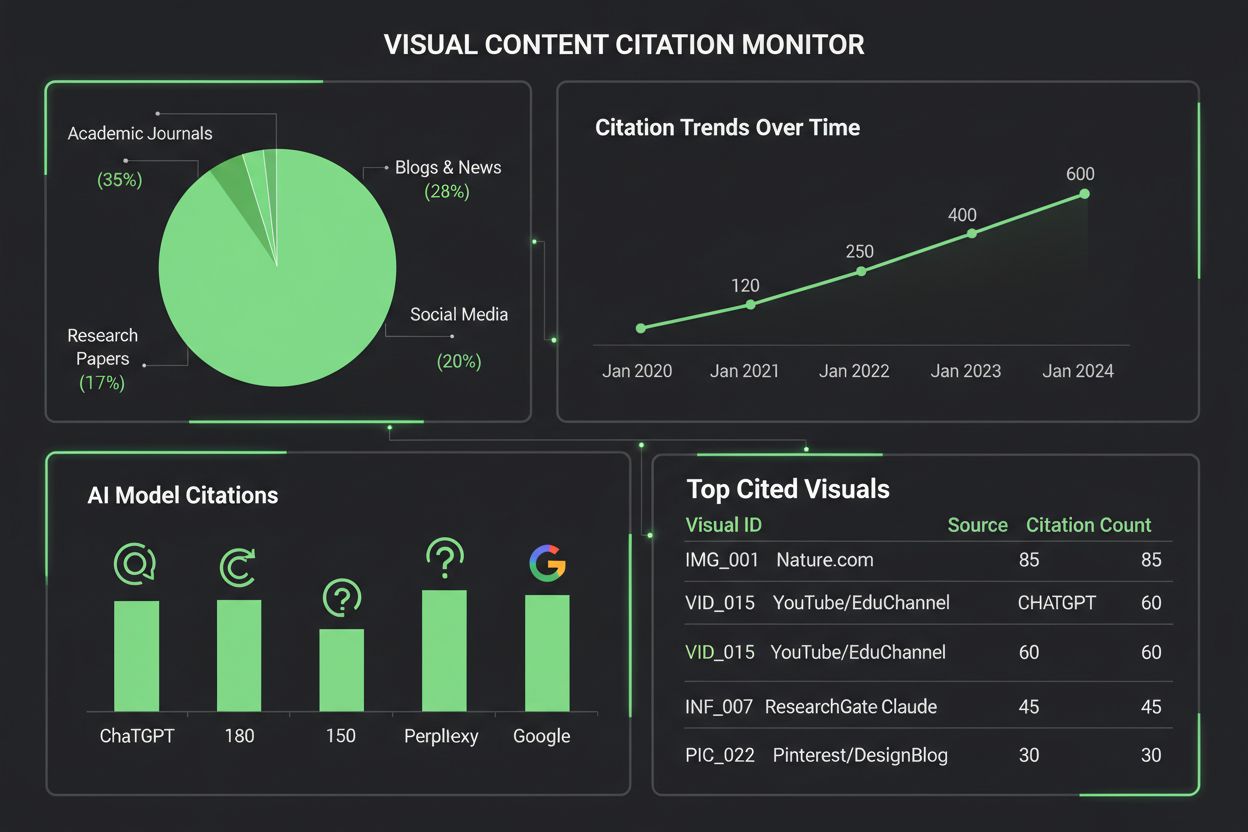

Die Überwachung, wie KI-Systeme visuelle Inhalte zitieren, erfordert einen mehrschichtigen Ansatz aus automatisierter Erkennung und manueller Überprüfung. Wichtige Methoden hierfür sind:

AmICited.com ist auf die Nachverfolgung von Zitationen visueller Inhalte auf mehreren KI-Plattformen spezialisiert und bietet Content-Erstellern detaillierte Berichte darüber, wie ihre Diagramme von ChatGPT, Claude, Perplexity, Google KI und anderen Systemen referenziert, zugeordnet oder übersehen werden. Die Bedeutung der Überwachung visueller Zitationen kann nicht hoch genug eingeschätzt werden—ohne Tracking verlieren Ersteller den Überblick darüber, wie ihre Arbeit KI-generierte Inhalte beeinflusst, und können weder für bessere Quellenangaben eintreten noch die tatsächliche Reichweite ihrer Visualisierungen verstehen. Die Monitoring-Tools von AmICited schließen diese Lücke durch Echtzeit-Benachrichtigungen bei Zitationen, detaillierte Analysen zur Zitationsgenauigkeit und umsetzbare Empfehlungen zur Verbesserung der Auffindbarkeit visueller Inhalte in KI-Systemen.

Um Visualisierungen zu erstellen, die von KI-Systemen mit höherer Wahrscheinlichkeit zitiert werden, sind gezielte Gestaltungsentscheidungen erforderlich, die Klarheit, metadatenreiche Inhalte und maschinelle Lesbarkeit priorisieren. Kräftige, kontrastreiche Farbschemata und klare Beschriftungen verbessern die KI-Verarbeitung von Diagrammen erheblich, denn Modelle haben Schwierigkeiten mit subtilen Farbverläufen, überlappenden Elementen und mehrdeutigen Legenden, die Menschen problemlos deuten. Fügen Sie umfassende Alt-Text-Beschreibungen hinzu, die nicht nur das Gezeigte, sondern auch Datenbeziehungen, zentrale Erkenntnisse und Quelleninformationen erfassen—diese Metadaten sind die Basis für akkurate KI-Zitationen. Betten Sie strukturierte Daten in Ihre Visualisierungen ein, zum Beispiel mit Standards wie JSON-LD oder Microdata, damit KI-Systeme exakte Werte und Beziehungen extrahieren können, ohne auf rein visuelle Interpretation angewiesen zu sein. Stellen Sie sicher, dass Diagrammtitel beschreibend und spezifisch statt generisch sind, da KI-Modelle Titel als zentrale Anker für das Verständnis und die Zitation visueller Inhalte nutzen. Fügen Sie Quellenangaben direkt in der Visualisierung ein, etwa als Fußnoten, Wasserzeichen oder integrierte Quellenlabels, sodass KI-Systeme das Diagramm nicht von seiner Herkunft trennen können. Organisationen, die diese Best Practices konsequent umsetzen, erzielen nachweislich bessere Zitationen, höhere Sichtbarkeit und stärken ihre professionelle Glaubwürdigkeit auf KI-Plattformen.

Das Spektrum an Tools zur Überwachung visueller Zitationen wächst, da immer mehr Organisationen die Bedeutung erkennen, wie KI-Systeme visuelle Inhalte referenzieren. AmICited.com sticht als umfassende Lösung speziell für die Überwachung visueller Zitationen auf mehreren KI-Plattformen hervor und bietet Erstellern detaillierte Dashboards, die genau zeigen, wann und wie ihre Diagramme von ChatGPT, Claude, Perplexity, Google AI Overviews und neuen KI-Systemen zitiert werden. Herkömmliche Zitationsplattformen wie Google Scholar und Scopus konzentrieren sich vorrangig auf wissenschaftliche Arbeiten und textbasierte Zitationen, wodurch visuelle Inhalte weitgehend unbeobachtet und unattributiert bleiben. Spezialisierte Tools wie Tinybird und ähnliche Datenvisualisierungsplattformen integrieren inzwischen Zitations-Tracking-Funktionen, damit Organisationen nachvollziehen können, wie ihre Echtzeit-Visualisierungen von KI-Systemen genutzt und referenziert werden. Die Analysefunktionen von AmICited liefern Metriken zu Zitationshäufigkeit, Genauigkeitsraten und plattformbezogenen Mustern, sodass Content-Ersteller erkennen, welche KI-Systeme ihre Arbeit korrekt zuordnen und wo Handlungsbedarf besteht. Für Organisationen, die ihr visuelles geistiges Eigentum schützen und den Einfluss ihrer Inhalte im KI-getriebenen Informationsökosystem verstehen möchten, ist eine spezialisierte Lösung wie AmICited.com mittlerweile unerlässlich—sie macht aus passiver Beobachtung ein aktives Management, das zu besseren Zitations-Ergebnissen führt.

Aktuelle KI-Modelle verfügen über unterschiedliche Fähigkeiten, wenn es um die Zitation visueller Inhalte geht. Während fortschrittliche Modelle wie Claude und Perplexity Diagramme mit angemessener Genauigkeit referenzieren können, haben viele Systeme Schwierigkeiten mit der korrekten Zuordnung. Die meisten LLMs wurden hauptsächlich mit Textdaten trainiert, wodurch visuelle Zitationen weniger zuverlässig sind als Textzitationen. Deshalb sind Überwachungstools wie AmICited unerlässlich, um nachzuverfolgen, wie Ihre Visualisierungen tatsächlich zitiert werden.

AmICited.com bietet umfassende Überwachung visueller Inhalte auf mehreren KI-Plattformen, darunter ChatGPT, Claude, Perplexity und Google AI Overviews. Die Plattform nutzt automatisiertes visuelles Fingerprinting und Metadatenanalyse, um zu erkennen, wann Ihre Diagramme in KI-generierten Inhalten erscheinen, und liefert Echtzeit-Benachrichtigungen sowie detaillierte Analysen zu Genauigkeit und Häufigkeit der Zitationen.

KI-Systeme zitieren Diagramme genauer, wenn diese kräftige, kontrastreiche Farben, klare Beschriftungen, beschreibende Titel und umfassende Alt-Texte aufweisen. Die Integration strukturierter Daten, Quellenangaben innerhalb der Visualisierung und gut organisierte Legenden verbessert die Verarbeitung und Zitationswahrscheinlichkeit durch KI deutlich. Die Erstellung mehrerer Versionen komplexer Visualisierungen—vereinfacht für KI und detailliert für Menschen—erhöht ebenfalls die Auffindbarkeit.

Nach aktuellem Stand zeigen Claude 3 und Perplexity AI die höchste Genauigkeit bei der Quellenangabe visueller Inhalte, mit Zitationsgenauigkeiten von 80–90 %. Google AI Overviews und Gemini Pro Vision erzielen solide Werte von 75–80 %, während ChatGPTs GPT-4V, obwohl es über Bildverarbeitungsfähigkeiten verfügt, oft auf generische Beschreibungen statt präziser Zitate zurückgreift. Diese Fähigkeiten entwickeln sich weiter, wenn Modelle aktualisiert werden.

Die Nachverfolgung visueller Zitationen ist entscheidend für Markenpräsenz, Bewertung des Content-Werts und Schutz geistigen Eigentums. Werden Ihre Diagramme von KI-Systemen korrekt zitiert, erhöht dies die Sichtbarkeit Ihrer Marke in KI-generierten Inhalten, bestätigt den Einfluss Ihrer Inhalte und hilft Ihnen zu verstehen, wie Ihre Arbeit KI-getriebene Informationssynthese prägt. Ohne Nachverfolgung verlieren Sie Einblick in Reichweite und Wirkung Ihrer Inhalte.

AmICited ist auf die Nachverfolgung von Zitationen visueller Inhalte auf mehreren KI-Plattformen spezialisiert und bietet detaillierte Dashboards, die zeigen, wann und wie Ihre Diagramme zitiert werden. Die Plattform liefert Echtzeit-Benachrichtigungen, Metriken zur Zitationsgenauigkeit, plattformbezogene Analysen und umsetzbare Erkenntnisse zur Verbesserung der Auffindbarkeit visueller Inhalte. So wird das Zitations-Tracking von passiver Beobachtung zum aktiven Management Ihres visuellen geistigen Eigentums.

Textzitationen in KI-Systemen sind im Allgemeinen zuverlässiger, da LLMs hauptsächlich mit Textdaten trainiert wurden. Visuelle Zitationen erfordern zusätzliche Verarbeitungsschritte—KI muss zunächst visuelle Elemente in Textbeschreibungen umwandeln, wobei oft Nuancen und präzise Werte verloren gehen. Dieser Umwandlungsprozess erhöht die Fehleranfälligkeit, wodurch visuelle Zitationen weniger genau und weniger konsistent sind als Textzitationen über verschiedene KI-Plattformen hinweg.

Absolut. Setzen Sie bewährte Methoden um, wie kräftige, kontrastreiche Farben, beschreibende Titel und Alt-Texte, Einbettung strukturierter Daten und Quellenangaben direkt in die Visualisierung. Vermeiden Sie subtile Farbverläufe, überlappende Elemente und mehrdeutige Legenden. Erstellen Sie bei komplexen Diagrammen vereinfachte Versionen speziell für KI-Verarbeitung. Diese Verbesserungen machen Ihre Visualisierungen für KI-Systeme auffindbarer und zitierbarer.

Verfolgen Sie, wie KI-Systeme Ihre Diagramme und Visualisierungen in ChatGPT, Claude, Perplexity und Google AI zitieren. Erhalten Sie Echtzeit-Benachrichtigungen und detaillierte Analysen zur Quellenangabe Ihrer visuellen Inhalte.

Erfahren Sie, wie Datenvisualisierungen die Sichtbarkeit in der KI-Suche verbessern, LLMs beim Verständnis von Inhalten helfen und Zitierungen in KI-generierten...

Entdecken Sie, wie Retrieval-Augmented Generation KI-Zitate transformiert und eine genaue Quellenzuordnung sowie fundierte Antworten in ChatGPT, Perplexity und ...

Community-Diskussion darüber, wie sich Datenvisualisierungen und visuelle Inhalte in der KI-Suche behaupten. Strategien zur Optimierung von Diagrammen, Infograf...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.