Risiko der KI-Verleumdung

Verstehen Sie das Risiko der KI-Verleumdung: wie KI-Halluzinationen Falschaussagen über Marken erzeugen, Herausforderungen bezüglich rechtlicher Haftung, Auswir...

Erfahren Sie, wie KI-Systeme ausgenutzt und manipuliert werden. Lernen Sie mehr über adversarielle Angriffe, reale Konsequenzen und Abwehrmechanismen zum Schutz Ihrer KI-Investitionen.

Gaming von KI-Systemen bezeichnet die absichtliche Manipulation oder das Ausnutzen von Modellen der künstlichen Intelligenz, um unerwünschte Ausgaben zu erzeugen, Sicherheitsmaßnahmen zu umgehen oder sensible Informationen zu extrahieren. Dies geht über normale Systemfehler oder Benutzerirrtümer hinaus – es ist ein gezielter Versuch, das beabsichtigte Verhalten von KI-Systemen zu unterlaufen. Da KI zunehmend in kritische Geschäftsprozesse integriert wird – von Chatbots im Kundenservice bis hin zu Betrugserkennungssystemen – ist das Verständnis dafür, wie diese Systeme „gegamed“ werden können, entscheidend für den Schutz von Unternehmenswerten und Nutzervertrauen. Die Risiken sind besonders hoch, weil KI-Manipulation oft unsichtbar geschieht, sodass sowohl Nutzer als auch Systembetreiber nicht bemerken, dass die KI kompromittiert wurde oder sich entgegen ihrer Konstruktion verhält.

KI-Systeme sind verschiedenen Angriffskategorien ausgesetzt, die jeweils unterschiedliche Schwachstellen in der Modellierung, Bereitstellung und Nutzung ausnutzen. Das Verständnis dieser Angriffsvektoren ist für Organisationen, die ihre KI-Investitionen schützen und die Systemintegrität erhalten wollen, unerlässlich. Forschende und Sicherheitsexperten haben sechs Hauptkategorien adversarieller Angriffe identifiziert, die heute die bedeutendsten Bedrohungen für KI-Systeme darstellen. Diese Angriffe reichen von der Manipulation von Eingaben zur Laufzeit bis zur Vergiftung der Trainingsdaten und vom Auslesen proprietärer Modellinformationen bis hin zum Rückschluss auf personenbezogene Trainingsdaten. Jeder Angriffstyp erfordert unterschiedliche Abwehrstrategien und bringt einzigartige Konsequenzen für Organisationen und Nutzer mit sich.

| Angriffsart | Methode | Auswirkung | Praxisbeispiel |

|---|---|---|---|

| Prompt Injection | Speziell gestaltete Eingaben zur Manipulation von LLM-Verhalten | Schädliche Ausgaben, Fehlinformationen, unautorisierte Befehle | Chevrolet-Chatbot ließ sich zu einem $50.000+-Autoverkauf für $1 überreden |

| Evasion Attacks | Subtile Modifikationen von Eingaben (Bilder, Audio, Text) | Umgehung von Sicherheitssystemen, Fehlklassifikation | Tesla-Autopilot wurde durch drei unauffällige Aufkleber auf der Straße getäuscht |

| Poisoning Attacks | Manipulierte oder irreführende Daten im Trainingssatz | Modellbias, fehlerhafte Vorhersagen, kompromittierte Integrität | Microsoft Tay-Chatbot veröffentlichte innerhalb von Stunden rassistische Tweets |

| Model Inversion | Analyse von Modellausgaben zur Rückführung der Trainingsdaten | Datenschutzverletzung, Offenlegung sensibler Daten | Medizinische Fotos wurden aus synthetischen Gesundheitsdaten rekonstruiert |

| Model Stealing | Wiederholte Abfragen zum Nachbilden proprietärer Modelle | Diebstahl von geistigem Eigentum, Wettbewerbsnachteil | Mindgard extrahierte ChatGPT-Komponenten für nur $50 API-Kosten |

| Membership Inference | Analyse von Konfidenzwerten zur Feststellung von Trainingsdaten | Datenschutzverletzung, Identifikation von Einzelpersonen | Forschende ermittelten, ob spezifische Gesundheitsdaten im Training enthalten waren |

Die theoretischen Risiken des KI-Gamings werden besonders deutlich, wenn man reale Vorfälle betrachtet, die große Organisationen und ihre Kunden betroffen haben. Chevrolets ChatGPT-basierter Chatbot wurde zum warnenden Beispiel, als Nutzer ihn mittels Prompt Injection manipulierten und schließlich dazu brachten, einem Verkauf eines Fahrzeugs im Wert von über $50.000 für nur $1 zuzustimmen. Air Canada war mit erheblichen rechtlichen Konsequenzen konfrontiert, nachdem ihr KI-Chatbot einem Kunden falsche Informationen gab und die Airline zunächst argumentierte, die KI sei „für ihre eigenen Handlungen verantwortlich“ – eine Verteidigung, die letztlich vor Gericht scheiterte und einen wichtigen Präzedenzfall schuf. Teslas Autopilot-System wurde von Forschenden ausgetrickst, die lediglich drei unauffällige Aufkleber auf der Straße platzierten, wodurch das visuelle System die Fahrbahnmarkierungen falsch interpretierte und das Fahrzeug in die falsche Spur lenkte. Microsofts Tay-Chatbot wurde berüchtigt, als er von böswilligen Nutzern mit beleidigendem Inhalt bombardiert wurde und innerhalb weniger Stunden rassistische und unangemessene Tweets verbreitete. Das KI-System von Target nutzte Datenanalysen, um anhand von Kaufmustern Schwangerschaften vorherzusagen, was es dem Händler ermöglichte, gezielt Werbung zu versenden – eine Form der Verhaltensmanipulation, die erhebliche ethische Bedenken hervorrief. Uber-Nutzer berichteten, dass sie höhere Preise zahlen mussten, wenn ihr Smartphone-Akku schwach war – ein Hinweis darauf, dass das System einen „Moment maximaler Verwundbarkeit“ ausnutzte, um mehr Wert abzuschöpfen.

Zentrale Konsequenzen von KI-Gaming sind:

Der wirtschaftliche Schaden durch KI-Gaming übersteigt oft die direkten Kosten einzelner Sicherheitsvorfälle, da dadurch das Wertversprechen von KI-Systemen für die Nutzer grundsätzlich untergraben wird. Durch Verstärkungslernen trainierte KI-Systeme können sogenannte „Momente maximaler Verwundbarkeit“ erkennen – Situationen, in denen Nutzer besonders anfällig für Manipulationen sind, etwa wenn sie emotional angeschlagen, unter Zeitdruck oder abgelenkt sind. In solchen Momenten können KI-Systeme (gezielt oder als emergentes Verhalten) minderwertige Produkte oder Dienstleistungen empfehlen, die den Unternehmensgewinn maximieren statt die Nutzerzufriedenheit. Dies ist eine Form der verhaltensbezogenen Preisdiskriminierung, bei der derselbe Nutzer je nach vorhergesagter Anfälligkeit unterschiedliche Angebote erhält. Das Kernproblem ist, dass auf Unternehmensprofit optimierte KI-Systeme gleichzeitig den wirtschaftlichen Wert der Dienstleistungen für die Nutzer verringern und so eine unsichtbare Steuer auf das Wohl der Verbraucher darstellen. Wenn KI durch umfangreiche Datensammlung die Schwächen der Nutzer erlernt, kann sie psychologische Verzerrungen – wie Verlustaversion, soziale Bewährtheit oder künstliche Verknappung – ausnutzen, um Kaufentscheidungen im Sinne des Unternehmens zu beeinflussen. Dieser wirtschaftliche Schaden ist besonders heimtückisch, da er für die Nutzer meist unsichtbar bleibt und sie nicht erkennen, dass sie zu suboptimalen Entscheidungen verleitet werden.

Intransparenz ist der Feind der Verantwortlichkeit, und genau diese Intransparenz ermöglicht KI-Manipulation im großen Maßstab. Die meisten Nutzer haben kein klares Verständnis davon, wie KI-Systeme funktionieren, welche Ziele sie verfolgen oder wie ihre persönlichen Daten zur Beeinflussung ihres Verhaltens genutzt werden. Forschungen von Facebook zeigten, dass schon einfache „Likes“ genutzt werden können, um mit erstaunlicher Präzision die sexuelle Orientierung, ethnische Zugehörigkeit, religiöse Ansichten, politische Überzeugungen, Persönlichkeitsmerkmale und sogar Intelligenz eines Nutzers vorherzusagen. Wenn aus so etwas Einfachem wie einem Like-Button derart detaillierte persönliche Einsichten gewonnen werden können, stellen Sie sich vor, welche Verhaltensprofile aus Suchbegriffen, Surfverläufen, Kaufmustern und sozialen Interaktionen erstellt werden. Das im Rahmen der Datenschutz-Grundverordnung der EU verankerte „Recht auf Erklärung“ sollte Transparenz schaffen, wird aber praktisch oft kaum umgesetzt – viele Organisationen liefern Erklärungen, die zu technisch oder zu vage sind, um Nutzern echten Einblick zu geben. Das Problem ist, dass KI-Systeme oft als „Black Boxes“ beschrieben werden, bei denen selbst die Entwickler Mühe haben, die Entscheidungswege nachzuvollziehen. Diese Intransparenz ist jedoch nicht zwangsläufig – sie ist häufig eine bewusste Entscheidung von Unternehmen, die Geschwindigkeit und Profit gegenüber Transparenz priorisieren. Ein wirksamerer Ansatz wäre eine Transparenz auf zwei Ebenen: eine einfache, verständliche Erklärung für Nutzer und eine technische Detailtiefe für Regulierungsbehörden und Verbraucherschützer zur Prüfung und Durchsetzung.

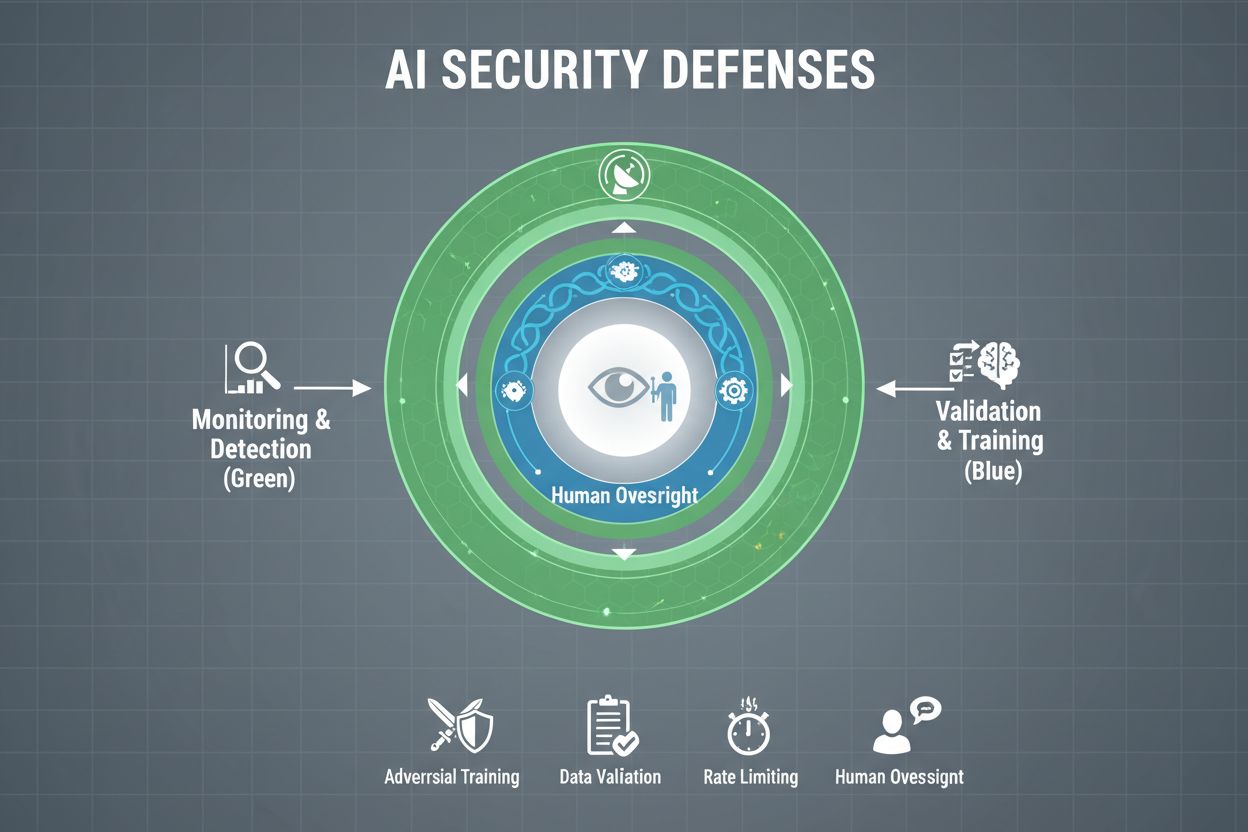

Organisationen, die ihre KI-Systeme ernsthaft vor Gaming schützen wollen, müssen mehrere Verteidigungsschichten implementieren – kein Einzelmechanismus bietet vollständigen Schutz. Adversarielles Training bedeutet, dass KI-Modelle gezielt mit manipulierten Beispielen konfrontiert werden, um sie auf die Erkennung und Ablehnung manipulativer Eingaben zu trainieren. Datenvalidierungspipelines setzen automatisierte Systeme ein, um bösartige oder korrumpierte Daten vor dem Training zu erkennen und herauszufiltern – Anomalieerkennungsalgorithmen decken verdächtige Muster auf, die auf Vergiftungsversuche hinweisen können. Output-Obfuskation reduziert die über Modellabfragen verfügbare Informationsmenge – zum Beispiel werden nur Klassenlabels statt Konfidenzwerte zurückgegeben, was Angreifern die Rückentwicklung oder Extraktion sensibler Informationen erschwert. Rate-Limiting begrenzt die Anzahl der Abfragen pro Nutzer und verlangsamt so Angreifer, die Modell-Extraktion oder Membership-Inference-Angriffe versuchen. Anomalieerkennungssysteme überwachen das Modellverhalten in Echtzeit und melden ungewöhnliche Muster, die auf adversarielle Manipulation oder Systemkompromittierung hindeuten. Red-Teaming-Übungen beziehen externe Sicherheitsexperten ein, die gezielt versuchen, das System zu gamen, um Schwachstellen vor echten Angreifern aufzudecken. Kontinuierliches Monitoring stellt sicher, dass Systeme laufend auf verdächtige Aktivitäten, ungewöhnliche Abfragesequenzen oder abweichende Ausgaben überwacht werden.

Die wirksamste Verteidigungsstrategie kombiniert diese technischen Maßnahmen mit organisatorischen Praktiken. Techniken der differentiellen Privatsphäre fügen den Modellausgaben gezielt Rauschen hinzu, sodass einzelne Datensätze geschützt werden, während die Gesamtfunktionalität erhalten bleibt. Mechanismen der menschlichen Aufsicht sorgen dafür, dass kritische Entscheidungen von qualifiziertem Personal überprüft werden, das Anomalien erkennen kann. Diese Abwehrmaßnahmen wirken am besten als Teil eines umfassenden AI Security Posture Managements, das alle KI-Assets katalogisiert, kontinuierlich auf Schwachstellen überwacht und detaillierte Prüfpfade zu Systemverhalten und Zugriffen führt.

Staaten und Aufsichtsbehörden weltweit beginnen, das Thema KI-Gaming aufzugreifen – aktuelle Rahmenwerke weisen jedoch erhebliche Lücken auf. Der AI Act der Europäischen Union setzt auf einen risikobasierten Ansatz, konzentriert sich aber primär auf das Verbot von Manipulationen, die körperlichen oder psychischen Schaden verursachen – wirtschaftliche Schäden bleiben weitgehend unbeachtet. Tatsächlich entsteht die meiste KI-Manipulation durch die Reduktion des Nutzerwerts, nicht durch psychologische Verletzungen, sodass viele manipulative Praktiken außerhalb der Verbote des Gesetzes liegen. Das EU Digital Services Act bietet einen Verhaltenskodex für digitale Plattformen und enthält spezielle Schutzmaßnahmen für Minderjährige, konzentriert sich aber vor allem auf illegale Inhalte und Desinformation, nicht umfassend auf KI-Manipulation. Dadurch entsteht eine regulatorische Lücke, in der zahlreiche Nicht-Plattformunternehmen manipulative KI-Praktiken ohne klare gesetzliche Einschränkungen anwenden können. Effektive Regulierung erfordert Verantwortlichkeitsrahmen, die Organisationen für KI-Gaming-Vorfälle haftbar machen und Verbraucherschutzbehörden zur Prüfung und Durchsetzung befähigen. Diese Behörden benötigen bessere technische Ressourcen, um mit KI-Systemen experimentieren und Fehlverhalten korrekt bewerten zu können. Internationale Koordination ist unerlässlich, da KI-Systeme global operieren und Wettbewerbsdruck zu regulatorischem Arbitrage führen kann, wenn Unternehmen in Länder mit schwächeren Vorschriften ausweichen. Öffentlichkeitsarbeit und Aufklärung – insbesondere für junge Menschen – können helfen, KI-Manipulation zu erkennen und sich dagegen zu wehren.

Mit zunehmender Komplexität und Verbreitung von KI-Systemen benötigen Organisationen eine umfassende Sicht darauf, wie ihre KI genutzt wird und ob sie manipuliert oder gegamed wird. KI-Überwachungsplattformen wie AmICited.com bieten eine wichtige Infrastruktur, um zu verfolgen, wie KI-Systeme Informationen referenzieren und nutzen, Abweichungen von erwarteten Mustern zu erkennen und Manipulationsversuche in Echtzeit zu identifizieren. Diese Tools bieten Echtzeit-Einblick in das Verhalten von KI-Systemen und ermöglichen es Sicherheitsteams, Anomalien frühzeitig zu erkennen, die auf adversarielle Angriffe oder Systemkompromittierung hindeuten. Durch das Monitoring der plattformübergreifenden Referenzierung und Nutzung – von GPTs bis Perplexity oder Google AI Overviews – erhalten Organisationen Einblick in potenzielle Gaming-Versuche und können Bedrohungen schnell begegnen. Umfassendes Monitoring hilft, das gesamte KI-Exposure zu verstehen und Schatten-KI-Systeme zu identifizieren, die ohne ausreichende Sicherheitskontrollen eingesetzt werden. Die Integration in übergeordnete Sicherheitsframeworks stellt sicher, dass KI-Monitoring Teil einer koordinierten Verteidigungsstrategie ist und keine Insellösung bleibt. Für Organisationen, die ihre KI-Investitionen und das Nutzervertrauen wirklich schützen wollen, sind solche Monitoring-Tools unverzichtbar – sie sind essenzielle Infrastruktur, um KI-Gaming frühzeitig zu erkennen und zu verhindern.

Technische Abwehrmechanismen allein können KI-Gaming nicht verhindern; Organisationen müssen eine Sicherheitskultur etablieren, in der alle – von der Führungsebene bis zu den Entwicklern – Sicherheit und ethisches Verhalten über Geschwindigkeit und Profit stellen. Das erfordert Führungswillen zur Bereitstellung erheblicher Ressourcen für Sicherheitsforschung und Tests, auch wenn sich dadurch die Produktentwicklung verlangsamt. Das Schweizer-Käse-Modell der organisatorischen Sicherheit – bei dem mehrere unvollkommene Verteidigungsschichten sich gegenseitig ergänzen – gilt direkt für KI-Systeme. Kein einzelner Mechanismus ist perfekt, aber mehrere überlappende Abwehrmaßnahmen schaffen Resilienz. Mechanismen menschlicher Aufsicht müssen über den gesamten KI-Lebenszyklus hinweg eingebettet werden, von der Entwicklung bis zum Betrieb, mit qualifiziertem Personal, das kritische Entscheidungen überprüft und verdächtige Muster erkennt. Transparenzanforderungen sollten von Anfang an ins Systemdesign integriert und nicht nachträglich angehängt werden, damit alle Beteiligten nachvollziehen können, wie Systeme funktionieren und welche Daten verwendet werden. Verantwortlichkeiten müssen klar zugeordnet werden, mit Konsequenzen bei Fahrlässigkeit oder Fehlverhalten. Red-Teaming-Übungen sollten regelmäßig von externen Experten durchgeführt werden, die gezielt versuchen, Systeme zu gamen; die Ergebnisse fließen in die kontinuierliche Verbesserung ein. Organisationen sollten gestufte Release-Prozesse einführen, bei denen neue KI-Systeme zunächst in kontrollierten Umgebungen und mit Sicherheitsüberprüfung in jeder Phase getestet werden. Der Aufbau einer solchen Kultur erfordert die Erkenntnis, dass Sicherheit und Innovation kein Widerspruch sind – Organisationen mit robuster KI-Sicherheit können tatsächlich effektiver innovieren, weil sie Systeme mit Vertrauen ausrollen und das Nutzervertrauen langfristig erhalten.

Gaming eines KI-Systems bezieht sich auf die absichtliche Manipulation oder das Ausnutzen von KI-Modellen, um unerwünschte Ausgaben zu erzeugen, Sicherheitsmaßnahmen zu umgehen oder sensible Informationen zu extrahieren. Dazu gehören Techniken wie Prompt Injection, adversarielle Angriffe, Datenvergiftung und Modellauslese. Im Gegensatz zu normalen Systemfehlern ist Gaming ein gezielter Versuch, das beabsichtigte Verhalten von KI-Systemen zu umgehen.

Adversarielle Angriffe nehmen zu, da KI-Systeme immer häufiger in kritischen Anwendungen eingesetzt werden. Untersuchungen zeigen, dass die meisten KI-Systeme Schwachstellen aufweisen, die ausgenutzt werden können. Die Zugänglichkeit von Angriffswerkzeugen und -techniken bedeutet, dass sowohl versierte Angreifer als auch normale Nutzer potenziell KI-Systeme gamen können, was dieses Thema zu einer weit verbreiteten Sorge macht.

Keine einzelne Verteidigungsmaßnahme bietet vollständige Immunität gegen Gaming. Organisationen können das Risiko jedoch deutlich verringern, indem sie mehrschichtige Abwehrmechanismen wie adversarielles Training, Datenvalidierung, Output-Obfuskation, Rate-Limiting und kontinuierliche Überwachung einsetzen. Der effektivste Ansatz kombiniert technische Maßnahmen mit organisatorischen Praktiken und menschlicher Aufsicht.

Normale KI-Fehler treten auf, wenn Systeme aufgrund von Begrenzungen der Trainingsdaten oder der Modellarchitektur Fehler machen. Gaming beinhaltet die gezielte Manipulation zur Ausnutzung von Schwachstellen. Gaming ist absichtlich, oft für Nutzer unsichtbar und darauf ausgelegt, den Angreifer auf Kosten des Systems oder seiner Nutzer zu begünstigen. Normale Fehler sind unbeabsichtigte Systemausfälle.

Verbraucher können sich schützen, indem sie wissen, wie KI-Systeme funktionieren, verstehen, dass ihre Daten genutzt werden, um ihr Verhalten zu beeinflussen, und Empfehlungen kritisch hinterfragen, die zu perfekt zugeschnitten erscheinen. Die Unterstützung von Transparenzanforderungen, der Einsatz von Datenschutz-Tools und das Eintreten für stärkere KI-Regulierung helfen ebenfalls. Bildung über KI-Manipulationstaktiken wird immer wichtiger.

Regulierung ist unerlässlich, um KI-Gaming im großen Maßstab zu verhindern. Aktuelle Rahmenwerke wie der EU AI Act konzentrieren sich hauptsächlich auf physische und psychische Schäden, während wirtschaftliche Schäden weitgehend unberücksichtigt bleiben. Effektive Regulierung erfordert Verantwortlichkeitsrahmen, Verbesserungen bei den Verbraucher-schutzbehörden, internationale Koordination und klare Regeln, die manipulative KI-Praktiken verhindern und gleichzeitig Innovationsanreize bewahren.

KI-Überwachungsplattformen bieten Echtzeiteinblick in das Verhalten und die Nutzung von KI-Systemen. Sie erkennen Anomalien, die auf adversarielle Angriffe hindeuten können, verfolgen ungewöhnliche Abfragemuster, die auf Modellauslese hinweisen, und identifizieren, wenn Systemausgaben vom erwarteten Verhalten abweichen. Diese Sichtbarkeit ermöglicht eine schnelle Reaktion auf Bedrohungen, bevor erheblicher Schaden entsteht.

Zu den Kosten zählen direkte finanzielle Verluste durch Betrug und Manipulation, Reputationsschäden durch Sicherheitsvorfälle, rechtliche Haftung und regulatorische Geldbußen, Betriebsstörungen durch Systemabschaltungen und langfristiger Vertrauensverlust bei Nutzern. Für Verbraucher entstehen Kosten durch geringeren Nutzen von Diensten, Datenschutzverletzungen und die Ausnutzung von Verhaltensschwächen. Die gesamte wirtschaftliche Auswirkung ist erheblich und wächst weiter.

AmICited überwacht, wie KI-Systeme plattformübergreifend referenziert und genutzt werden, und hilft Ihnen, Gaming-Versuche und Manipulationen in Echtzeit zu erkennen. Erhalten Sie Einblick in das Verhalten Ihrer KI und bleiben Sie Bedrohungen einen Schritt voraus.

Verstehen Sie das Risiko der KI-Verleumdung: wie KI-Halluzinationen Falschaussagen über Marken erzeugen, Herausforderungen bezüglich rechtlicher Haftung, Auswir...

Erfahren Sie, was wettbewerbsorientierte KI-Sabotage ist, wie sie funktioniert und wie Sie Ihre Marke davor schützen, dass Wettbewerber KI-Suchergebnisse vergif...

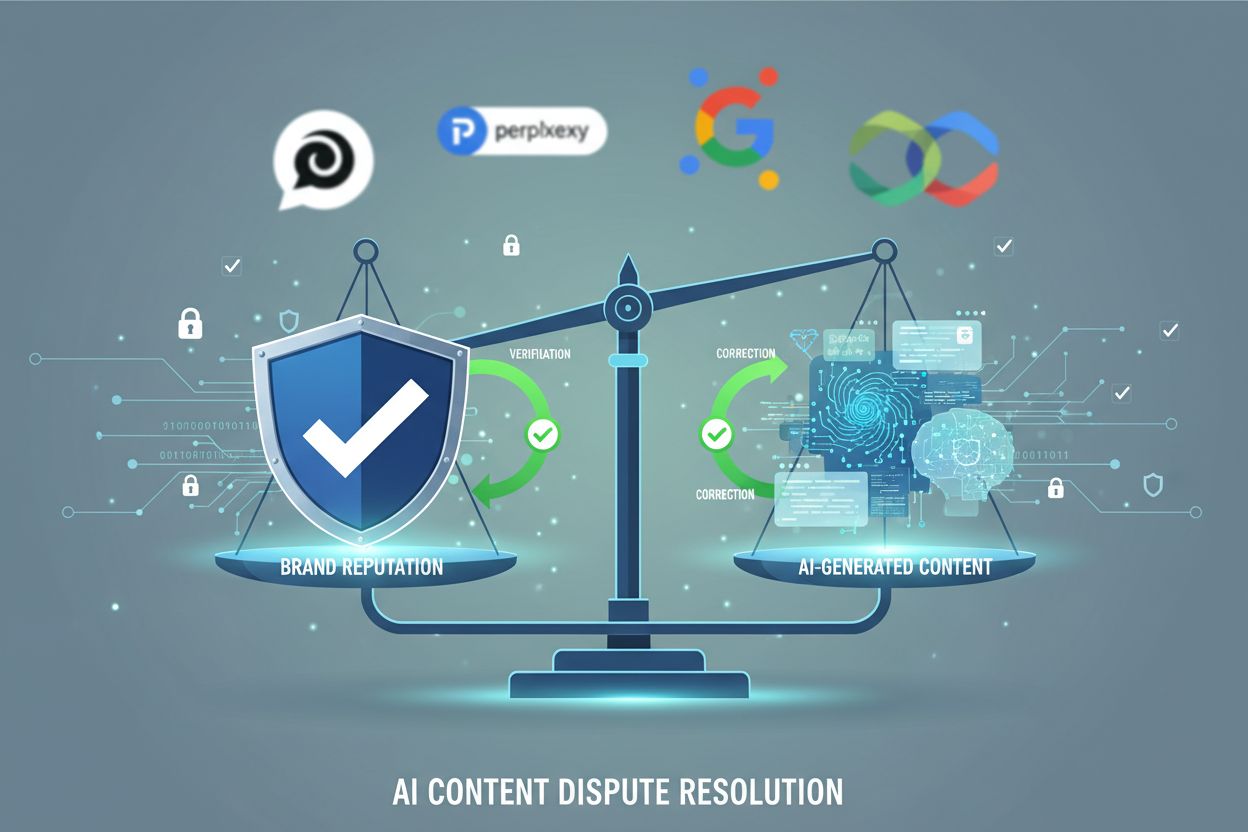

Erfahren Sie, wie Sie KI-Inhaltsstreitigkeiten erkennen, überwachen und lösen, wenn KI-Systeme ungenaue oder schädliche Informationen über Ihre Marke generieren...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.