Was ist Large Language Model Optimization (LLMO)? Vollständiger Leitfaden

Erfahren Sie, was LLMO ist, wie es funktioniert und warum es für die Sichtbarkeit im Bereich KI wichtig ist. Entdecken Sie Optimierungstechniken, um Ihre Marke ...

Entdecken Sie, wie große Sprachmodelle Quellen mittels Evidenzgewichtung, Entitätenerkennung und strukturierter Daten auswählen und zitieren. Erfahren Sie den 7-Phasen-Zitationsprozess und optimieren Sie Ihre Inhalte für KI-Sichtbarkeit.

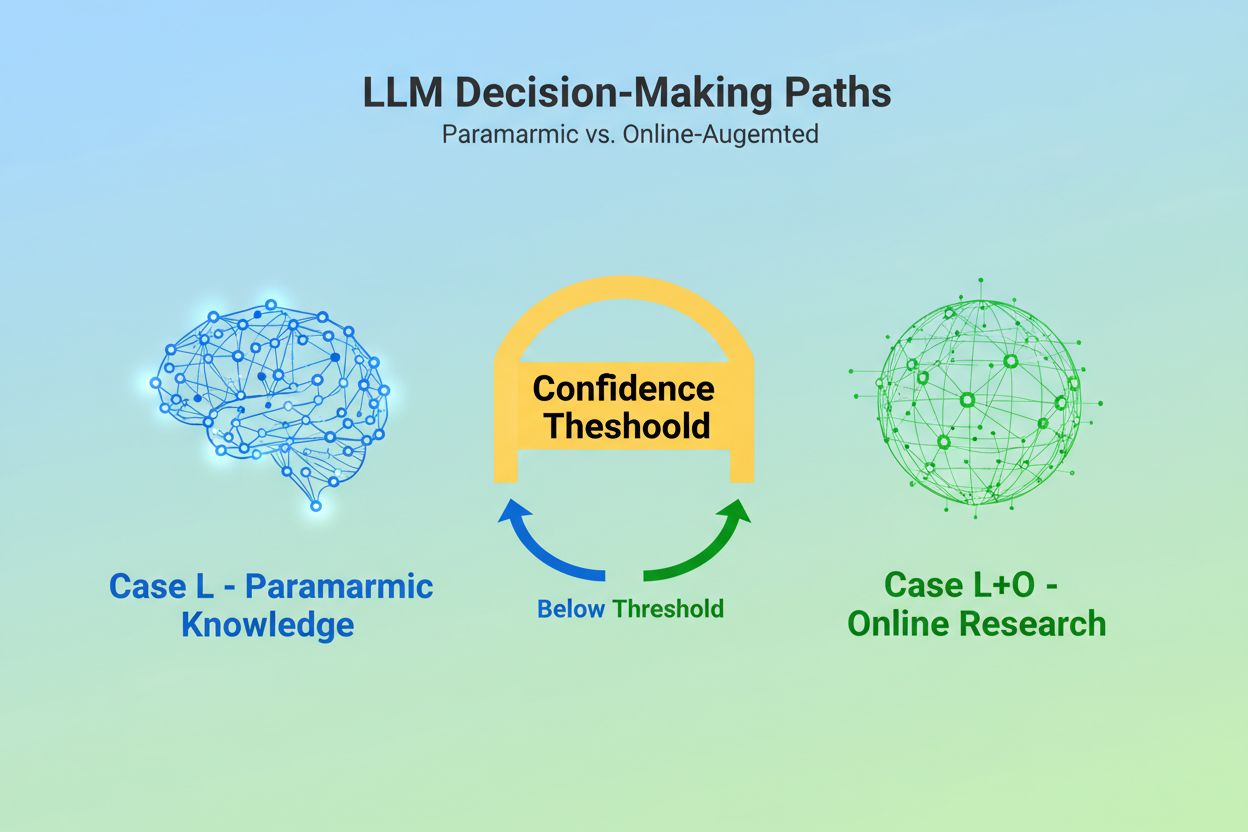

Wenn ein großes Sprachmodell (LLM) eine Anfrage erhält, steht es vor einer grundlegenden Entscheidung: Soll es sich ausschließlich auf das im Training verankerte Wissen verlassen oder das Internet nach aktuellen Informationen durchsuchen? Diese binäre Wahl – von Forschern als Fall L (nur Lerndaten) versus Fall L+O (Lerndaten plus Online-Recherche) bezeichnet – bestimmt, ob ein LLM überhaupt Quellen zitieren wird. Im Fall L-Modus greift das Modell ausschließlich auf seinen parametrischen Wissensschatz zurück, eine komprimierte Darstellung von Mustern aus dem Training, die typischerweise Informationen von mehreren Monaten bis über ein Jahr vor Veröffentlichung abbildet. Im Fall L+O-Modus aktiviert das Modell eine Vertrauensschwelle, die externe Recherche auslöst und damit den sogenannten „Kandidatenraum“ aus URLs und Quellen öffnet. Dieser Entscheidungspunkt ist für die meisten Monitoring-Tools unsichtbar – doch genau hier beginnt der gesamte Zitationsmechanismus, denn ohne die Auslösung der Suchphase können keine externen Quellen bewertet oder zitiert werden.

Sobald ein LLM entscheidet, externe Quellen zu suchen, tritt es in die entscheidende Phase der Zitationsauswahl ein: die Evidenzgewichtung. Hier wird die Unterscheidung zwischen bloßer Erwähnung und autoritativer Empfehlung getroffen. Das Modell zählt nicht einfach, wie oft eine Quelle erscheint oder wie hoch sie in Suchergebnissen rangiert; vielmehr bewertet es die strukturelle Integrität der Evidenz selbst. Es prüft die Dokumentenarchitektur – ob Quellen klare Datenbeziehungen, wiederkehrende Bezeichner und referenzierte Links enthalten – und interpretiert dies als Vertrauenszeichen. Das Modell konstruiert, was Forscher als „Evidenz-Graphen“ bezeichnen, in dem Knoten Entitäten und Kanten Dokumentenbeziehungen repräsentieren. Jede Quelle wird nicht nur nach Inhaltsrelevanz gewichtet, sondern auch danach, wie konsistent Fakten über mehrere Dokumente bestätigt werden, wie thematisch relevant die Informationen sind und wie autoritativ die Domain erscheint. Diese multidimensionale Bewertung ergibt die sogenannte Evidenzmatrix – eine umfassende Einschätzung, welche Quellen als zuverlässig genug zum Zitieren gelten. Entscheidend: Diese Phase läuft in der Denkebene des LLM ab und bleibt traditionellen GEO-Monitoring-Tools, die nur Abrufsignale messen, verborgen.

Strukturierte Daten – insbesondere JSON-LD, Schema.org-Markup und RDFa – wirken als Multiplikator im Evidenzgewichtungsprozess. Quellen mit korrekt implementierten strukturierten Daten erhalten in der Evidenzmatrix eine 2- bis 3-fach höhere Gewichtung als unstrukturierte Inhalte. Das liegt nicht daran, dass LLMs formatierten Daten ästhetisch den Vorzug geben, sondern weil strukturierte Daten die Entitätenverknüpfung ermöglichen: Der Prozess, Erwähnungen über maschinenlesbare Bezeichner wie @id, sameAs und Q-IDs (Wikidata-Identifier) über Dokumente hinweg zu verbinden. Wenn ein LLM beispielsweise eine Quelle mit Q-ID für eine Organisation findet, kann es diese Entität sofort in mehreren Dokumenten verifizieren – das sogenannte „cross-document entity coreference“. Dieser Abgleich erhöht das Vertrauen in die Zuverlässigkeit der Quelle erheblich.

| Datenformat | Zitationsgenauigkeit | Entitätenverknüpfung | Verifizierung über Dokumente hinweg |

|---|---|---|---|

| Unstrukturierter Text | 62% | Keine | Manuelle Zuordnung |

| Einfaches HTML-Markup | 71% | Eingeschränkt | Teilweise Übereinstimmung |

| RDFa/Microdata | 81% | Gut | Musterbasiert |

| JSON-LD mit Q-IDs | 94% | Exzellent | Verifizierte Links |

| Knowledge-Graph-Format | 97% | Perfekt | Automatische Verifizierung |

Der Einfluss strukturierter Daten wirkt auf zwei Zeitebenen. Transient, wenn ein LLM online sucht, liest es JSON-LD und Schema.org-Markup in Echtzeit aus und bezieht diese strukturierten Informationen direkt in die Evidenzgewichtung für die aktuelle Antwort ein. Persistent werden strukturierte, über längere Zeit konsistente Daten in künftigen Trainingszyklen in den parametrischen Wissensschatz des Modells integriert und prägen so das Erkennen und Bewerten von Entitäten auch ohne Online-Recherche. Dieser doppelte Mechanismus bedeutet, dass Marken, die korrekt strukturierte Daten implementieren, sich sowohl sofortige Zitationssichtbarkeit als auch langfristige Autorität im internen Wissensraum des Modells sichern.

Bevor ein LLM eine Quelle zitieren kann, muss es zunächst verstehen, worum es bei dieser Quelle geht und wen sie repräsentiert. Das ist Aufgabe der Entitätenerkennung – ein Prozess, der vage menschliche Sprache in maschinenlesbare Entitäten übersetzt. Wenn in einem Dokument „Apple“ erwähnt wird, muss das LLM entscheiden, ob damit Apple Inc., die Frucht oder etwas ganz anderes gemeint ist. Das gelingt durch trainierte Entitätenmuster aus Wikipedia, Wikidata und Common Crawl, kombiniert mit Kontextanalyse des umgebenden Textes. Im Fall L+O wird dieser Prozess noch ausgefeilter: Das Modell gleicht Entitäten mit externen strukturierten Daten ab, prüft @id-Attribute, sameAs-Links und Q-IDs, die eine eindeutige Identifikation liefern. Dieser Abgleich ist entscheidend, da mehrdeutige oder inkonsistente Entitäten im Denkprozess des Modells untergehen. Eine Marke, die unterschiedliche Namenskonventionen verwendet, keine klaren Entitätenbezeichner festlegt oder Schema.org-Markup nicht implementiert, bleibt für die Maschine semantisch unklar – erscheint also als mehrere verschiedene Entitäten statt als eine kohärente Quelle. Organisationen mit stabilen, konsistent referenzierten Entitäten über viele Dokumente hinweg werden hingegen als zuverlässige Knoten im Wissensgraphen des LLM erkannt und steigern so ihre Zitationswahrscheinlichkeit deutlich.

Der Weg von der Anfrage zur Zitation folgt einem strukturierten Sieben-Phasen-Prozess, den Forscher durch Analyse des LLM-Verhaltens kartiert haben. Phase 0: Intent-Parsing beginnt, wenn das Modell die Nutzereingabe tokenisiert, eine semantische Analyse vornimmt und einen Intent-Vektor erstellt – eine abstrakte Darstellung dessen, was der Nutzer eigentlich fragt. Diese Phase bestimmt, welche Themen, Entitäten und Beziehungen überhaupt berücksichtigt werden. Phase 1: Interner Wissensabruf greift auf das parametrische Wissen des Modells zu und berechnet einen Vertrauenswert. Überschreitet dieser Wert eine Schwelle, bleibt das Modell im Fall L; andernfalls folgt externe Recherche. Phase 2: Fan-Out-Query-Generierung (nur Fall L+O) erstellt mehrere semantisch unterschiedliche Suchanfragen – meist 1-6 Token lang –, um den Kandidatenraum möglichst breit zu öffnen. Phase 3: Evidenzextraktion ruft URLs und Snippets aus den Suchergebnissen ab, parst HTML und extrahiert JSON-LD, RDFa und Microdata. Hier werden strukturierte Daten erstmals für den Zitationsmechanismus sichtbar. Phase 4: Entitätenverknüpfung identifiziert Entitäten in den gefundenen Dokumenten und gleicht sie mit externen Bezeichnern ab, um einen temporären Wissensgraphen aus Beziehungen zu erstellen. Phase 5: Evidenzgewichtung bewertet die Stärke der Evidenz aus allen Quellen – berücksichtigt Dokumentenarchitektur, Quellendiversität, Häufigkeit der Bestätigung und Kohärenz über Quellen hinweg. Phase 6: Schlussfolgerung & Synthese kombiniert interne und externe Evidenz, löst Widersprüche auf und entscheidet, ob eine Quelle nur erwähnt oder empfohlen wird. Phase 7: Endgültige Antwortkonstruktion übersetzt die gewichtete Evidenz in natürliche Sprache und fügt ggf. Zitate ein. Jede Phase baut auf der vorhergehenden auf, Rückkopplungen erlauben, Suche und Evidenzbewertung bei Inkonsistenzen zu verfeinern.

Moderne LLMs setzen zunehmend auf Retrieval-Augmented Generation (RAG) – eine Technik, die Auswahl und Begründung von Zitaten grundlegend verändert. Anstatt sich ausschließlich auf parametrisches Wissen zu stützen, holen RAG-Systeme aktiv relevante Dokumente ein, extrahieren Evidenz und verankern Antworten in konkreten Quellen. Damit wird Zitation vom impliziten Nebenprodukt des Trainings zu einem expliziten, nachvollziehbaren Prozess. Typischerweise verwenden RAG-Implementierungen hybride Suche, die Schlüsselwortsuche mit Vektorähnlichkeitssuche kombiniert, um die Auffindbarkeit zu maximieren. Nach dem Abruf der Kandidaten erfolgt semantisches Ranking – Ergebnisse werden nicht nur nach Schlüsselworten, sondern nach Bedeutung neu bewertet, sodass die relevantesten Quellen oben stehen. Dieser explizite Abrufmechanismus macht den Zitationsprozess transparenter und auditierbar – jede zitierte Quelle kann auf konkrete Abschnitte zurückgeführt werden, die ihre Aufnahme rechtfertigen. Für Organisationen, die ihre KI-Sichtbarkeit überwachen, sind RAG-basierte Systeme besonders wichtig, da sie messbare Zitationsmuster erzeugen. Tools wie AmICited verfolgen, wie RAG-Systeme Ihre Marke in verschiedenen KI-Plattformen referenzieren und liefern Einblicke, ob Sie als zitierte Quelle oder lediglich als Hintergrundmaterial erscheinen.

Nicht jede Zitation ist gleichwertig. Ein LLM kann eine Quelle als Hintergrund erwähnen, während es eine andere als autoritative Evidenz empfiehlt – und diese Unterscheidung basiert allein auf der Evidenzgewichtung, nicht auf dem Abruferfolg. Eine Quelle kann im Kandidatenraum (Phase 2-3) auftauchen, aber dennoch keine Empfehlung erhalten, wenn ihr Evidenzwert zu niedrig ist. Diese Trennung zwischen Erwähnung und Empfehlung ist der Punkt, an dem traditionelle GEO-Metriken versagen. Standard-Monitoring-Tools messen Fan-Out – also ob Ihre Inhalte in Suchergebnissen erscheinen – aber sie können nicht erfassen, ob das LLM Ihre Inhalte tatsächlich als vertrauenswürdig genug für eine Empfehlung hält. Eine Erwähnung klingt wie „Einige Quellen legen nahe…“, eine Empfehlung wie „Laut [Quelle] zeigen die Belege…“. Der Unterschied liegt im Evidenzmatrix-Score aus Phase 5. Quellen mit konsistenten Q-IDs, gut strukturierter Dokumentenarchitektur und Bestätigung über mehrere unabhängige Quellen hinweg erreichen Empfehlungsstatus. Quellen mit mehrdeutigen Entitäten, schwacher Struktur oder isolierten Behauptungen bleiben Erwähnungen. Für Marken ist diese Unterscheidung entscheidend: Aufgerufen zu werden ist nicht gleichbedeutend mit als autoritativ zitiert zu werden. Der Weg von Abruf zu Empfehlung erfordert semantische Klarheit, strukturelle Integrität und Evidenzdichte – Faktoren, die traditionelle SEO-Optimierung nicht adressiert.

Das Verständnis, wie LLMs Quellen auswählen, hat sofortige, umsetzbare Auswirkungen auf Ihre Content-Strategie. Erstens: Implementieren Sie Schema.org-Markup konsequent auf Ihrer Website – besonders für Organisationsdaten, Artikel und zentrale Entitäten. Verwenden Sie das JSON-LD-Format mit korrekten @id-Attributen und sameAs-Links zu Wikidata, Wikipedia oder anderen autoritativen Quellen. Diese strukturierten Daten erhöhen Ihr Evidenzgewicht in Phase 5 direkt. Zweitens: Legen Sie klare Entitätenbezeichner für Ihr Unternehmen, Produkte und zentrale Begriffe fest. Nutzen Sie konsistente Namenskonventionen, vermeiden Sie abkürzende Mehrdeutigkeiten und verknüpfen Sie verwandte Entitäten mit hierarchischen Beziehungen (isPartOf, about, mentions). Drittens: Schaffen Sie maschinenlesbare Evidenz, indem Sie strukturierte Daten zu Ihren Behauptungen, Qualifikationen und Beziehungen veröffentlichen. Schreiben Sie nicht nur „Wir sind führender Anbieter von X“ – strukturieren Sie diese Aussage mit unterstützenden Daten, Zitaten und überprüfbaren Beziehungen. Viertens: Sorgen Sie für Konsistenz Ihrer Inhalte über verschiedene Plattformen und Zeiträume hinweg. LLMs bewerten Evidenzdichte, indem sie prüfen, ob Behauptungen über unabhängige Quellen bestätigt werden; isolierte Aussagen auf einer Plattform wiegen weniger. Fünftens: Verstehen Sie, dass traditionelle SEO-Metriken keine KI-Zitationen vorhersagen. Hohe Suchrankings bedeuten nicht automatisch LLM-Empfehlungen; der Fokus sollte auf semantischer Klarheit und struktureller Integrität liegen. Sechstens: Überwachen Sie Ihre Zitationsmuster mit Tools wie AmICited, die erfassen, wie verschiedene KI-Systeme Ihre Marke referenzieren. So erkennen Sie, ob Sie Erwähnungs- oder Empfehlungsstatus erreichen und welche Inhaltstypen Zitate auslösen. Schließlich: Erkennen Sie, dass KI-Sichtbarkeit eine langfristige Investition ist. Strukturierte Daten, die Sie heute implementieren, beeinflussen sowohl die unmittelbare Zitationswahrscheinlichkeit (transienter Effekt) als auch den internen Wissensschatz des Modells in künftigen Trainingszyklen (persistenter Effekt).

Mit der Weiterentwicklung von LLMs werden auch die Zitationsmechanismen immer ausgefeilter und transparenter. Zukünftige Modelle werden wahrscheinlich Zitationsgraphen implementieren – explizite Abbildungen, die nicht nur zeigen, welche Quellen zitiert wurden, sondern wie sie konkrete Aussagen in der Antwort beeinflusst haben. Einige fortgeschrittene Systeme experimentieren bereits mit probabilistischen Vertrauenswerten an Zitaten, die angeben, wie sicher sich das Modell bezüglich Relevanz und Zuverlässigkeit der Quelle ist. Ein weiterer Trend ist Human-in-the-Loop-Verifikation, bei der Nutzer Zitate anfechten und Feedback geben können, das die Evidenzgewichtung des Modells bei künftigen Anfragen beeinflusst. Die Integration strukturierter Daten in Trainingszyklen bedeutet, dass Organisationen, die heute auf semantische Infrastruktur setzen, ihre langfristige Autorität in KI-Systemen aufbauen. Anders als Suchmaschinenrankings, die sich durch Algorithmus-Updates ändern können, schafft der persistente Effekt strukturierter Daten eine stabilere Grundlage für KI-Sichtbarkeit. Dieser Wandel von traditioneller Sichtbarkeit (gefunden werden) zu semantischer Autorität (als vertrauenswürdig gelten) ist ein grundlegender Paradigmenwechsel für die digitale Markenkommunikation. Die Gewinner in dieser neuen Landschaft werden nicht jene mit den meisten Inhalten oder den höchsten Suchrankings sein, sondern diejenigen, die ihre Informationen so strukturieren, dass Maschinen sie zuverlässig verstehen, verifizieren und empfehlen können.

Fall L verwendet nur Trainingsdaten aus dem parametrischen Wissensschatz des Modells, während Fall L+O diese durch Echtzeit-Webrecherche ergänzt. Der Vertrauenswert des Modells bestimmt, welcher Weg eingeschlagen wird. Diese Unterscheidung ist entscheidend, da sie bestimmt, ob externe Quellen überhaupt bewertet und zitiert werden können.

Die Evidenzgewichtung bestimmt diese Unterscheidung. Quellen mit strukturierten Daten, konsistenten Bezeichnern und Bestätigung über mehrere Dokumente hinweg werden zu 'Empfehlungen' statt bloßer Erwähnungen erhoben. Eine Quelle kann in den Suchergebnissen erscheinen, aber dennoch keine Empfehlung erhalten, wenn ihr Evidenzwert nicht ausreicht.

Strukturierte Daten (JSON-LD, @id, sameAs, Q-IDs) erhalten in Evidenzmatrizen eine 2-3-mal höhere Gewichtung. Diese Auszeichnung ermöglicht Entitätenverknüpfung und die Überprüfung über mehrere Dokumente hinweg und erhöht so die Zuverlässigkeit der Quelle erheblich. Quellen mit korrekter Schema.org-Implementierung werden wesentlich häufiger als autoritativ zitiert.

Entitätenerkennung beschreibt, wie LLMs verschiedene Entitäten (Organisationen, Personen, Konzepte) identifizieren und unterscheiden. Eine klare Entitätenbestimmung durch konsistente Benennung und strukturierte Bezeichner verhindert Verwechslungen und erhöht die Wahrscheinlichkeit einer Zitation. Mehrdeutige Entitäten gehen im Denkprozess des Modells verloren.

RAG-Systeme suchen und bewerten Quellen aktiv in Echtzeit, wodurch die Zitationsauswahl transparenter und evidenzbasierter wird als bei rein parametrischem Wissen. Dieser explizite Abrufmechanismus erzeugt messbare Zitationsmuster, die mit Monitoring-Tools wie AmICited verfolgt und analysiert werden können.

Ja. Implementieren Sie Schema.org-Markup konsequent, legen Sie eindeutige Entitätenbezeichner fest, schaffen Sie maschinenlesbare Evidenz, sorgen Sie für Konsistenz Ihrer Inhalte über Plattformen hinweg und überwachen Sie Ihre Zitationsmuster. Diese Faktoren entscheiden direkt darüber, ob Ihre Inhalte als Erwähnung oder Empfehlung in LLM-Antworten erscheinen.

Traditionelle Sichtbarkeit misst Reichweite und Ranking in Suchergebnissen. KI-Sichtbarkeit misst, ob Ihre Inhalte als autoritative Evidenz im Denkprozess von LLMs erkannt werden. Aufgerufen zu werden ist nicht gleichbedeutend mit als vertrauenswürdig zitiert zu werden – letzteres erfordert semantische Klarheit und strukturelle Integrität.

AmICited verfolgt, wie KI-Systeme Ihre Marke in GPTs, Perplexity und Google KI-Überblicken referenzieren. Es zeigt, ob Sie eine Erwähnung oder Empfehlung erreichen, welche Inhaltstypen Zitate auslösen und wie sich Ihre Zitationsmuster über verschiedene KI-Plattformen hinweg unterscheiden.

Verstehen Sie, wie LLMs Ihre Marke in ChatGPT, Perplexity und Google KI-Überblicken referenzieren. Verfolgen Sie Zitationsmuster und optimieren Sie die KI-Sichtbarkeit mit AmICited.

Erfahren Sie, was LLMO ist, wie es funktioniert und warum es für die Sichtbarkeit im Bereich KI wichtig ist. Entdecken Sie Optimierungstechniken, um Ihre Marke ...

Erfahren Sie, wie LLM-Grounding und Websuche es KI-Systemen ermöglichen, auf Echtzeitinformationen zuzugreifen, Halluzinationen zu reduzieren und genaue Zitate ...

Erfahren Sie, wie LLMs Antworten durch Tokenisierung, Transformer-Architektur, Aufmerksamkeitsmechanismen und probabilistische Vorhersage generieren. Lernen Sie...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.