Perplexity Score

Der Perplexity Score misst die Textvorhersagbarkeit in Sprachmodellen. Erfahren Sie, wie diese zentrale NLP-Kennzahl die Modellunsicherheit quantifiziert, wie s...

Erfahren Sie, was der Perplexity-Score in Inhalten und Sprachmodellen bedeutet. Verstehen Sie, wie er die Unsicherheit des Modells, die Vorhersagegenauigkeit und die Bewertung der Textqualität misst.

Der Perplexity-Score ist eine Kennzahl, die misst, wie gut ein Sprachmodell das nächste Wort in einer Sequenz vorhersagt. Er quantifiziert die Unsicherheit des Modells bei Vorhersagen – niedrigere Werte bedeuten mehr Zuversicht und bessere Vorhersageleistung.

Perplexity-Score ist eine grundlegende Kennzahl in der Sprachverarbeitung (NLP) und im maschinellen Lernen, mit der bewertet wird, wie gut ein Sprachmodell bei der Texterzeugung abschneidet. Im Kern misst er den Grad der Unsicherheit, den ein Modell bei der Zuordnung von Wahrscheinlichkeiten zu Wörtern in einer Sequenz hat. Diese Kennzahl ist besonders wichtig, um die Modellleistung bei Aufgaben wie Textgenerierung, maschineller Übersetzung und konversationeller KI zu verstehen. Wenn ein Sprachmodell Text verarbeitet, weist es auf Basis des vorherigen Kontexts möglichen nächsten Wörtern Wahrscheinlichkeitswerte zu. Perplexity erfasst, wie sicher das Modell in diesen Vorhersagen ist, und ist somit ein wesentliches Bewertungsinstrument für Entwickler und Forscher, die mit großen Sprachmodellen arbeiten.

Das Konzept der Perplexity stammt aus der Informationstheorie, wo sie als Maß für Unsicherheit bei Wahrscheinlichkeitsverteilungen dient. Im Kontext von Sprachmodellen bedeuten niedrigere Perplexity-Werte, dass das Modell bei seinen Vorhersagen zuversichtlicher ist und daher kohärentere und flüssigere Texte erzeugt. Umgekehrt deuten höhere Perplexity-Werte darauf hin, dass das Modell unsicher ist, welches Wort als Nächstes kommen sollte – was potenziell zu weniger zusammenhängendem oder weniger relevantem Output führt. Das Verständnis dieser Kennzahl ist für alle, die mit KI-gestützter Inhaltserzeugung arbeiten, entscheidend, da sie sich direkt auf die Qualität und Zuverlässigkeit des generierten Textes auswirkt.

Die Berechnung des Perplexity-Scores umfasst mehrere mathematische Schritte, die rohe Wahrscheinlichkeitsvorhersagen in eine einzige interpretierbare Kennzahl umwandeln. Die grundlegende Formel basiert auf der Entropie der Modellvorhersagen, welche die Unsicherheit im Output misst. Die mathematische Darstellung lautet: Perplexity = 2^H(p), wobei H(p) die Entropie der Modellvorhersagen darstellt. Diese Formel zeigt, dass Perplexity direkt aus der Entropie abgeleitet wird – niedrigere Entropiewerte führen zu niedrigeren Perplexity-Scores.

Der praktische Berechnungsprozess folgt einem strukturierten Ansatz mit mehreren Schritten. Zuerst sagt das Sprachmodell die Wahrscheinlichkeit des nächsten Tokens auf Basis des eingegebenen Textes und Kontexts voraus. Zweitens wird eine logarithmische Transformation auf diese Wahrscheinlichkeiten angewendet, um sie in eine besser auswertbare Form zu bringen. Drittens wird die durchschnittliche Log-Likelihood aller vorhergesagten Wörter im Testdatensatz über die gesamte Sequenz berechnet. Schließlich erfolgt die Exponentiation der durchschnittlichen Log-Likelihood, um den endgültigen Perplexity-Score zu erhalten. Die vollständige Formel zur Berechnung der Perplexity für eine Wortsequenz lautet: Perplexity = exp(-1/N × Σ log p(w_i | w_{i-1}, w_{i-2}, …, w_1)), wobei p(w_i | w_{i-1}, …, w_1) die vorhergesagte Wahrscheinlichkeit des i-ten Wortes in Abhängigkeit aller vorangehenden Wörter ist und N die Gesamtzahl der Wörter in der Sequenz darstellt.

| Berechnungsschritt | Beschreibung | Zweck |

|---|---|---|

| Token-Vorhersage | Modell sagt Wahrscheinlichkeit des nächsten Wortes voraus | Baseline-Vorhersagen erstellen |

| Log-Transformation | Logarithmus auf Wahrscheinlichkeiten anwenden | In auswertbare Maßeinheit umwandeln |

| Durchschnittsberechnung | Durchschnittliche Log-Likelihood über die Sequenz berechnen | Über Textlänge normalisieren |

| Exponentiation | e zur negativen Durchschnittswert potenzieren | Endgültigen Perplexity-Score erhalten |

Der Perplexity-Score ist eine entscheidende Bewertungskennzahl zur Beurteilung der Sprachmodellleistung in verschiedenen Dimensionen. Sie ist wichtig, weil sie direkten Einblick in die Vorhersagegenauigkeit gibt und Entwicklern hilft zu verstehen, wie gut ein Modell Wörter vorhersagen und kohärenten Text generieren kann. Ein niedriger Perplexity-Score zeigt, dass das Modell zuversichtliche Vorhersagen trifft und wahrscheinlich flüssige, kontextuell passende Inhalte erzeugt. Das ist besonders wertvoll für Anwendungen wie Chatbots, virtuelle Assistenten und Content-Generierungssysteme, bei denen die Textqualität das Nutzererlebnis unmittelbar beeinflusst. Zudem hilft Perplexity, das Vertrauensniveau des Modells in seine Vorhersagen zu bewerten – bei hoher Perplexity ist das Modell unsicher beim nächsten Wort, was zu unzusammenhängender oder irrelevanter Textgenerierung führen kann.

Die Kennzahl ist auch für den Modellvergleich und die Modellauswahl unerlässlich. Beim Vergleich verschiedener Sprachmodelle oder verschiedener Versionen desselben Modells während des Fine-Tunings liefert Perplexity eine quantifizierbare Messgröße für Verbesserung oder Verschlechterung. Entwickler können Perplexity-Scores heranziehen, um festzustellen, ob ein Modell für bestimmte Aufgaben wie Textgenerierung, maschinelle Übersetzung, Zusammenfassung oder Fragebeantwortung geeignet ist. Darüber hinaus ermöglicht Perplexity eine Echtzeitbewertung während des Modelltrainings und erlaubt es Entwicklern, die Modellleistung sofort einzuschätzen und gezielt Anpassungen vorzunehmen. Diese Möglichkeit ist besonders während des Fine-Tunings wichtig, wo die Überwachung der Perplexity dabei hilft sicherzustellen, dass das Modell sicherere Vorhersagen trifft, statt lediglich auf die Trainingsdaten zu überfitten.

Das Verständnis, wie Perplexity-Scores zu interpretieren sind, ist entscheidend für fundierte Entscheidungen bezüglich Modellleistung und Eignung für bestimmte Anwendungen. Ein niedriger Perplexity-Score zeigt, dass das Modell bei seinen Vorhersagen zuversichtlicher ist und in der Regel qualitativ hochwertigere, zusammenhängende Texte erzeugt. Ein Perplexity-Score von beispielsweise 15 deutet darauf hin, dass das Modell bei jedem Vorhersageschritt aus etwa 15 möglichen Wörtern auswählt – ein Zeichen für relativ hohe Sicherheit. Im Gegensatz dazu weist ein hoher Perplexity-Score von 50 oder mehr darauf hin, dass das Modell unsicher ist und viel mehr Möglichkeiten in Betracht zieht, was oft mit weniger kohärenten oder weniger relevanten Ausgaben einhergeht. Was einen “guten” Perplexity-Score ausmacht, hängt jedoch von der jeweiligen Aufgabe, dem Datensatz und der Modellarchitektur ab.

Unterschiedliche Inhaltsarten und Modelle weisen unterschiedliche Basisbereiche für Perplexity auf. So erreichen Modelle, die auf gut strukturiertem, formellem Text wie Wikipedia-Artikeln trainiert wurden, typischerweise niedrigere Perplexity-Scores als Modelle, die auf konversationellen oder kreativen Inhalten trainiert wurden. Beim Vergleich von Perplexity-Scores verschiedener Modelle ist es wichtig, dass sie auf demselben Datensatz und mit derselben Tokenisierungsmethode bewertet werden, da diese Faktoren die Ergebnisse maßgeblich beeinflussen. Ein Modell mit einem Perplexity-Score von 20 auf einem Datensatz ist nicht direkt mit einem Modell mit 25 auf einem anderen Datensatz vergleichbar. Sequenzlänge beeinflusst zudem die Perplexity-Berechnung – längere Sequenzen ergeben tendenziell stabilere Perplexity-Scores, während kürzere Sequenzen höhere Varianz und Ausreißer zeigen können.

Obwohl der Perplexity-Score eine wertvolle Kennzahl ist, gibt es wichtige Einschränkungen, die bei der Bewertung von Sprachmodellen beachtet werden sollten. Eine wesentliche Grenze ist, dass Perplexity kein Verständnis misst – ein Modell mit niedriger Perplexity kann dennoch zusammenhangslosen, irrelevanten oder sachlich falschen Text generieren. Die Kennzahl misst lediglich die Fähigkeit des Modells, das nächste Wort aufgrund statistischer Muster in den Trainingsdaten vorherzusagen, nicht aber, ob das Modell tatsächlich den Sinn oder Kontext des Inhalts versteht. Das bedeutet, ein Modell kann ausgezeichnete Perplexity-Werte erreichen und dabei grammatikalisch korrekten, aber semantisch sinnlosen oder sachlich falschen Text erzeugen.

Ein weiterer wichtiger Punkt ist, dass Perplexity keine langfristigen Abhängigkeiten effektiv abbildet. Die Kennzahl basiert auf unmittelbaren Wortvorhersagen und zeigt nicht, wie gut ein Modell Kohärenz und Konsistenz über längere Textabschnitte hinweg aufrechterhält. Darüber hinaus ist die Tokenisierungs-Sensitivität ein kritischer Faktor – unterschiedliche Tokenisierungsmethoden können die Perplexity stark beeinflussen, was direkte Vergleiche zwischen Modellen mit unterschiedlichen Tokenizern erschwert. Beispielsweise können Zeichen-basierte Modelle niedrigere Perplexity erreichen als wortbasierte, was jedoch nicht zwangsläufig auf bessere Textgenerierung hindeutet. Zudem ist Perplexity vor allem für autoregressive oder kausale Sprachmodelle konzipiert und für maskierte Sprachmodelle wie BERT, die andere Vorhersagemechanismen nutzen, nicht sinnvoll anwendbar.

Um eine umfassende Bewertung der Sprachmodellleistung zu erhalten, sollte Perplexity in Kombination mit anderen Bewertungsmetriken und nicht als alleinige Kennzahl verwendet werden. BLEU, ROUGE und METEOR sind weit verbreitete Metriken, die generierte Texte mit Referenztexten vergleichen und besonders für Aufgaben wie maschinelle Übersetzung und Zusammenfassung nützlich sind. Menschliche Bewertung durch qualifizierte Gutachter liefert Einblicke in Aspekte, die automatisierte Kennzahlen nicht abdecken, etwa Flüssigkeit, Relevanz, Kohärenz und Gesamtqualität. Die Faktengenauigkeit kann durch wissensbasierte QA-Systeme oder Fact-Checking-Frameworks bewertet werden, um sicherzustellen, dass generierte Inhalte nicht nur flüssig, sondern auch korrekt sind. Diversitäts- und Kreativitätsmetriken wie Wiederholungsrate, Neuheitswert und Entropie messen, wie abwechslungsreich und originell die generierten Texte sind – ein wichtiger Aspekt für kreative Anwendungen.

Zudem hilft die Bewertung von Bias und Fairness dabei, ein sicheres Ausrollen von Modellen in der Praxis zu gewährleisten, wo schädliche Verzerrungen erhebliche Probleme verursachen könnten. Durch die Kombination von Perplexity mit diesen Zusatzmetriken können Entwickler die Vorhersagegenauigkeit, Flüssigkeit und praktische Nutzbarkeit eines Modells besser beurteilen. Dieser umfassende Ansatz ermöglicht es, Modelle zu identifizieren, die nicht nur korrekt vorhersagen, sondern dies auch mit Zuversicht, Kohärenz und Zuverlässigkeit tun. Die Kombination verschiedener Kennzahlen bietet ein vollständigeres Bild der Modellleistung und unterstützt dabei, Modelle auszuwählen, die die spezifischen Anforderungen ihrer Anwendungsbereiche erfüllen.

Der Perplexity-Score wird in zahlreichen realen Anwendungen eingesetzt, bei denen die Leistung von Sprachmodellen die Nutzererfahrung und Inhaltsqualität direkt beeinflusst. In Textgenerierungsanwendungen hilft Perplexity sicherzustellen, dass erzeugte Inhalte kohärent und flüssig sind, indem bestätigt wird, dass die Modellvorhersagen zuversichtlich und kontextgerecht sind. Für maschinelle Übersetzungssysteme bewertet Perplexity, wie gut das Übersetzungsmodell das nächste Wort in der Zielsprache vorhersagt – entscheidend für hochwertige Übersetzungen, die Bedeutung und Nuancen der Ausgangssprache erhalten. In Chatbots und virtuellen Assistenten sorgt niedrige Perplexity dafür, dass Antworten flüssig und situationsgerecht sind, was die Nutzerzufriedenheit und -bindung direkt steigert.

Zusammenfassungsmodelle profitieren von der Perplexity-Bewertung, da sie so sicherstellen können, dass generierte Zusammenfassungen lesbar und kohärent bleiben und dennoch die wesentlichen Informationen des Originaltexts enthalten. Inhaltsanbieter und KI-Plattformen nutzen Perplexity, um die Qualität KI-generierter Inhalte vor der Veröffentlichung oder Präsentation gegenüber Nutzern zu bewerten. Da KI-gestützte Inhaltserzeugung in Suchmaschinen und Antwortplattformen immer häufiger eingesetzt wird, hilft das Verständnis und Monitoring von Perplexity-Scores dabei, die Qualitätsstandards einzuhalten. Organisationen, die mit KI-Systemen arbeiten, können Perplexity-Metriken einsetzen, um festzustellen, wann Modelle neu trainiert, feinjustiert oder ersetzt werden müssen, um eine gleichbleibende Inhaltsqualität und das Vertrauen der Nutzer in KI-generierte Antworten sicherzustellen.

Verfolgen Sie, wie Ihre Inhalte in KI-Antworten bei ChatGPT, Perplexity und anderen KI-Suchmaschinen erscheinen. Stellen Sie sicher, dass Ihre Marke in KI-generierten Antworten korrekt zugeordnet wird.

Der Perplexity Score misst die Textvorhersagbarkeit in Sprachmodellen. Erfahren Sie, wie diese zentrale NLP-Kennzahl die Modellunsicherheit quantifiziert, wie s...

Community-Diskussion über den Perplexity-Score in Inhalten und Sprachmodellen. Autoren und KI-Experten diskutieren, ob er für Content-Erstellung und -Optimierun...

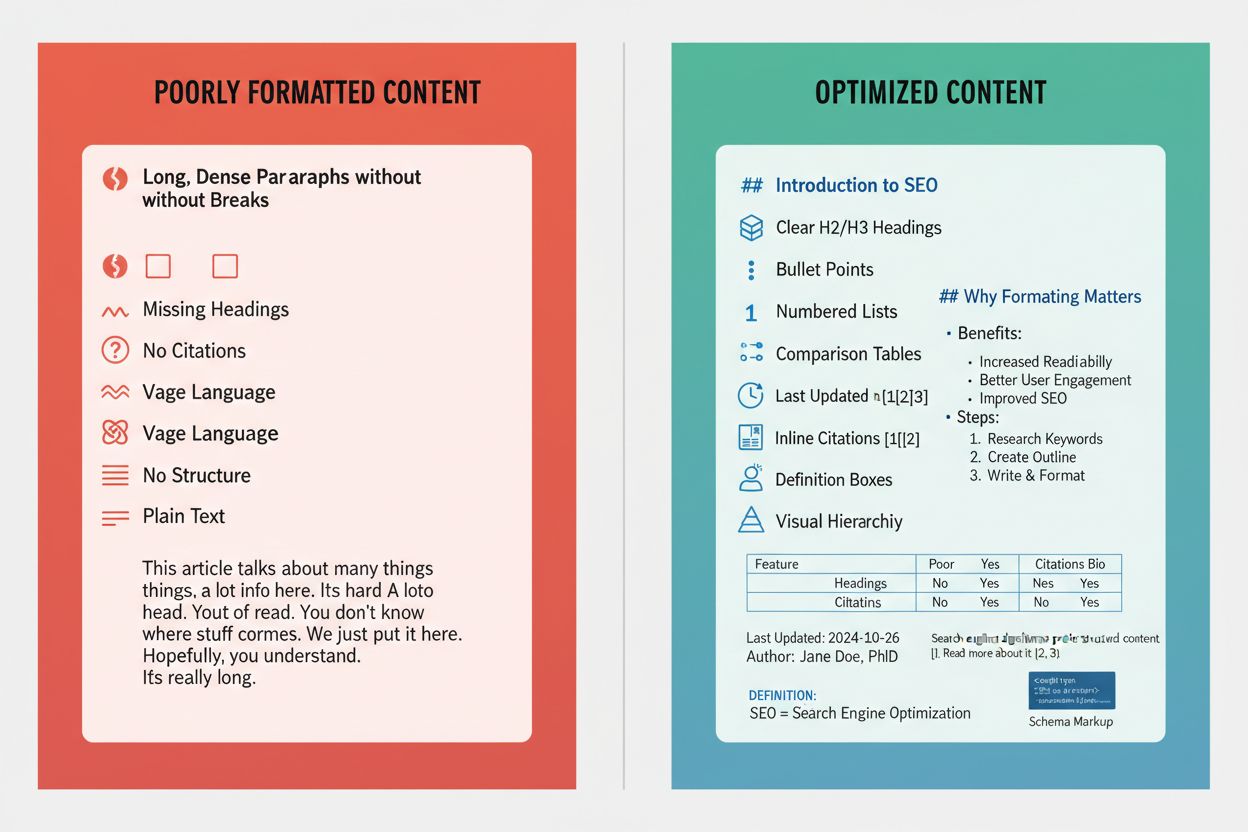

Erfahren Sie, wie Sie Inhalte für maximale Aufnahme in Perplexity-Zitaten formatieren. Beherrschen Sie zitierfähige Inhalte, Schema-Markup und Zitierstrategien,...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.