Recency Bias in KI

Erfahren Sie mehr über Recency Bias in KI-Systemen, wie er die Sichtbarkeit von Inhalten, Empfehlungsalgorithmen und Geschäftsentscheidungen beeinflusst. Entdec...

Erfahren Sie mehr über Source Selection Bias in der KI, wie er sich auf Machine-Learning-Modelle auswirkt, reale Beispiele und Strategien zur Erkennung und Minderung dieses wichtigen Fairnessproblems.

Source Selection Bias tritt auf, wenn Trainingsdaten die Gesamtbevölkerung oder die reale Verteilung nicht repräsentieren, wodurch KI-Modelle für unterrepräsentierte Gruppen oder Szenarien ungenaue Vorhersagen treffen.

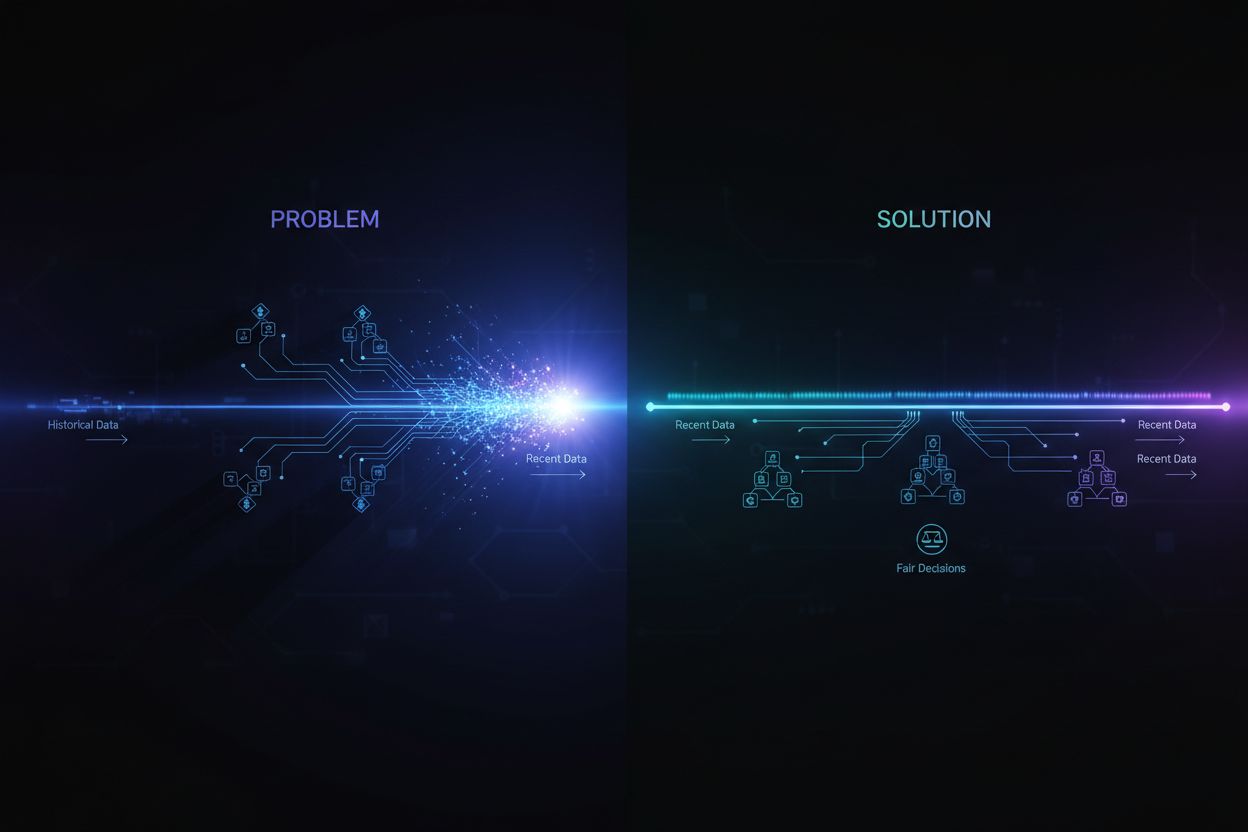

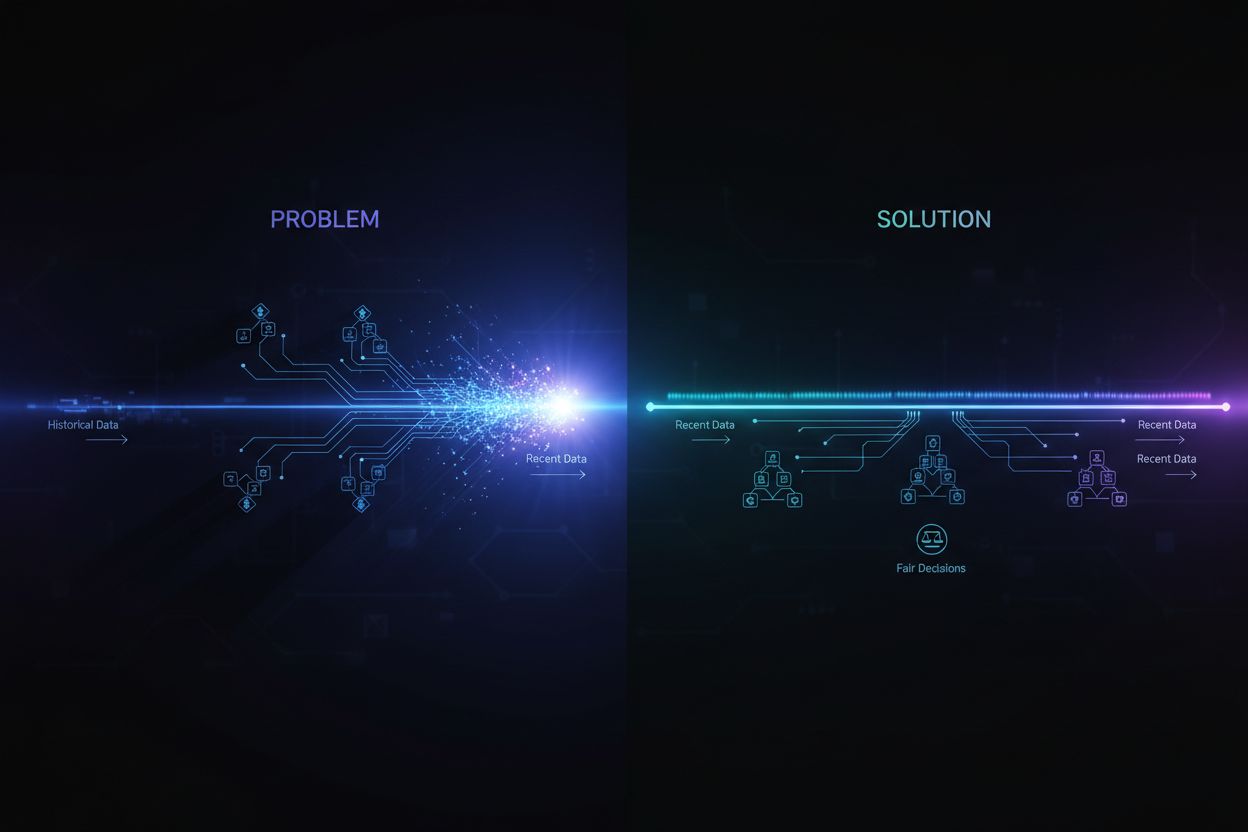

Source Selection Bias ist ein grundlegendes Problem der künstlichen Intelligenz, das auftritt, wenn die Daten, mit denen Machine-Learning-Modelle trainiert werden, die reale Population oder Verteilung, die sie bedienen sollen, nicht korrekt repräsentieren. Diese Art von Bias entsteht, wenn Datensätze so ausgewählt werden, dass bestimmte Gruppen, Szenarien oder Merkmale systematisch ausgeschlossen oder unterrepräsentiert werden. Die Folge ist, dass KI-Modelle Muster aus unvollständigen oder verzerrten Daten lernen und dadurch Vorhersagen treffen, die für unterrepräsentierte Populationen ungenau, unfair oder diskriminierend sind. Das Verständnis dieses Bias ist für alle, die KI-Systeme entwickeln, einsetzen oder darauf vertrauen, entscheidend, da er die Fairness, Genauigkeit und Zuverlässigkeit automatisierter Entscheidungsfindung in allen Branchen direkt beeinflusst.

Source Selection Bias unterscheidet sich von anderen Formen des Bias, da er bereits in der Phase der Datenerhebung entsteht. Anstatt durch algorithmische Entscheidungen oder menschliche Annahmen während der Modellentwicklung hervorgerufen zu werden, ist der Source Selection Bias bereits in den Grundstein des Trainingsdatensatzes eingebettet. Das macht ihn besonders tückisch, denn Modelle, die auf verzerrten Quelldaten trainiert werden, werden diese Verzerrungen in ihren Vorhersagen fortführen und verstärken – unabhängig davon, wie ausgefeilt der Algorithmus ist. Das Problem wird noch gravierender, wenn KI-Systeme in sensiblen Bereichen wie Gesundheitswesen, Finanzen, Justiz oder Personalwesen eingesetzt werden, wo verzerrte Vorhersagen ernsthafte Folgen für Einzelne und Gemeinschaften haben können.

Source Selection Bias entwickelt sich durch mehrere unterschiedliche Mechanismen während der Datenerhebung und -aufbereitung. Der häufigste Weg ist der Coverage Bias (Abdeckungsbias), bei dem bestimmte Populationen oder Szenarien systematisch aus dem Trainingsdatensatz ausgeschlossen werden. Wird z. B. ein Gesichtserkennungssystem hauptsächlich mit Bildern von hellhäutigen Personen trainiert, fehlt die Abdeckung dunkler Hauttypen, was zu höheren Fehlerraten bei diesen Gruppen führt. Dies geschieht, weil Datensammler möglicherweise nur begrenzten Zugang zu diversen Populationen haben oder unbewusst bestimmte Gruppen bei der Datenerhebung bevorzugen.

Ein weiterer wichtiger Mechanismus ist der Non-Response Bias (Nichtantwort-Bias), auch Teilnahmebias genannt, der auftritt, wenn bestimmte Gruppen weniger wahrscheinlich an Datenerhebungen teilnehmen. Beispielsweise: Bei einem Umfragedatensatz zur Vorhersage von Konsumpräferenzen werden die Vorlieben jener demografischen Gruppen, die Umfragen seltener beantworten, im Trainingsdatensatz unterrepräsentiert. So entsteht ein Datensatz, der scheinbar ausgewogen ist, tatsächlich jedoch die Teilnahme und nicht die reale Bevölkerungsstruktur widerspiegelt. Im Gesundheitswesen etwa, wenn klinische Studiendaten überwiegend aus urbanen Populationen mit Zugang zu modernen medizinischen Einrichtungen stammen, können die resultierenden KI-Modelle schlecht auf ländliche oder unterversorgte Gemeinschaften übertragen werden.

Sampling Bias (Stichprobenverzerrung) ist ein dritter Mechanismus, bei dem bei der Datenerhebung keine ordnungsgemäße Zufallsauswahl angewendet wird. Stattdessen wählen Datensammler etwa die ersten verfügbaren Proben oder verwenden bequeme Stichprobenverfahren. So entstehen systematische Fehler, da die ausgewählten Proben nicht die Gesamtbevölkerung widerspiegeln. Wird z. B. ein KI-Modell zur Vorhersage von Kreditausfällen mit Daten aus nur einer Region oder einem bestimmten Zeitraum trainiert, kann es Ausfälle in anderen Regionen oder unter anderen wirtschaftlichen Bedingungen nicht akkurat vorhersagen.

| Bias-Typ | Mechanismus | Reales Beispiel |

|---|---|---|

| Coverage Bias | Systematischer Ausschluss von Populationen | Gesichtserkennung nur mit hellhäutigen Gesichtern trainiert |

| Non-Response Bias | Teilnahmeunterschiede bei der Datenerhebung | Gesundheitsmodelle nur mit urbanen Populationen trainiert |

| Sampling Bias | Fehlende Zufälligkeit bei der Auswahl | Kreditprognosemodell nur mit Daten aus einer Region trainiert |

| Temporal Bias | Daten aus bestimmten Zeiträumen | Vor der Pandemie trainierte Modelle nach der Pandemie angewandt |

| Source Diversity Bias | Begrenzte Datenquellen | Medizinische Bilddatensätze aus nur einem Krankenhaus |

Die Folgen von Source Selection Bias in KI-Systemen sind tiefgreifend und weitreichend – sowohl für Einzelpersonen als auch Organisationen. Im Gesundheitswesen führte Source Selection Bias zu Diagnosesystemen, die bei bestimmten Patientengruppen deutlich schlechter abschneiden. Studien belegen, dass KI-Algorithmen zur Hautkrebsdiagnose bei Patienten mit dunkler Haut erheblich geringere Genauigkeit aufweisen – teils nur halb so genau wie bei hellhäutigen Patienten. Diese Diskrepanz führt direkt zu verspäteten Diagnosen, ungeeigneten Therapieempfehlungen und schlechteren Gesundheitsergebnissen für unterrepräsentierte Gruppen. Wenn Trainingsdaten überwiegend aus einer Bevölkerungsgruppe stammen, lernen die Modelle die Muster dieser Gruppe und können sie nicht auf andere übertragen.

Im Finanzsektor hat Source Selection Bias in Kredit- und Scoring-Algorithmen historische Diskriminierung fortgeschrieben. Modelle, die mit historischen Kreditvergabedaten trainiert wurden, in denen frühere diskriminierende Praktiken abgebildet sind, reproduzieren diese Bias bei neuen Kreditentscheidungen. Wurden bestimmten Gruppen in der Vergangenheit aufgrund systemischer Diskriminierung Kredite verweigert und werden diese Daten zum Training genutzt, lernen die Modelle, auch künftig diesen Gruppen Kredite zu verweigern. So entsteht ein Teufelskreis, in dem historische Ungleichheiten in algorithmische Entscheidungen eingebettet werden und den Zugang zu Kapital und wirtschaftlichen Chancen beeinträchtigen.

Personalgewinnung und Recruiting sind ein weiteres sensibles Feld, in dem Source Selection Bias erheblichen Schaden verursacht. KI-Tools zur Lebenslauf-Sichtung weisen nachweislich Vorurteile gegenüber wahrgenommenem Geschlecht oder ethnischer Zugehörigkeit auf. Studien zeigen, dass Namen, die mit Weißen assoziiert werden, in manchen Systemen zu 85 % bevorzugt wurden. Wenn Trainingsdaten aus historischen Einstellungsakten stammen, in denen Diskriminierung oder homogene Muster vorherrschten, lernen KI-Modelle, diese Muster zu replizieren. Das bedeutet, dass Source Selection Bias im Recruiting zu systematischer Benachteiligung unterrepräsentierter Gruppen und zu weniger Diversität im Unternehmen führt.

In der Strafjustiz hat Source Selection Bias in prädiktiven Polizeisystemen zur überproportionalen Überwachung bestimmter Gemeinschaften geführt. Wenn Trainingsdaten aus historischen Festnahmedaten stammen, die ihrerseits bereits marginalisierte Gruppen benachteiligen, verstärken die Modelle diese Vorurteile durch Vorhersagen höherer Kriminalität in diesen Gemeinden. So entsteht ein Teufelskreis: Verzerrte Vorhersagen führen zu mehr Polizeipräsenz, die wiederum mehr Festnahmedaten liefert und so die Verzerrung im Modell weiter verstärkt.

Die Erkennung von Source Selection Bias erfordert einen systematischen Ansatz mit quantitativer Analyse, qualitativer Bewertung und kontinuierlicher Überwachung während des gesamten Modelllebenszyklus. Der erste Schritt ist ein umfassendes Data Audit, bei dem Quellen, Erhebungsmethoden und Repräsentativität der Trainingsdaten geprüft werden. Dazu gehört die Dokumentation: Woher stammen die Daten? Wie wurden sie erhoben? Wurden bestimmte Populationen oder Szenarien systematisch ausgeschlossen? Kritische Fragen sind: Waren alle relevanten demografischen Gruppen vertreten? Gab es Teilnahmebarrieren? Haben Erhebungszeitraum oder geographische Reichweite die Repräsentation eingeschränkt?

Demografische Paritätsanalyse ist ein quantitativer Ansatz zur Erkennung von Source Selection Bias. Hierbei wird die Verteilung wichtiger Merkmale im Trainingsdatensatz mit der Zielpopulation verglichen. Wenn bestimmte Gruppen, Altersbereiche, Regionen oder andere Merkmale deutlich unterrepräsentiert sind, ist das ein Hinweis auf Source Selection Bias. Beispiel: Enthält Ihr Trainingsdatensatz nur 5 % Frauen, die Zielpopulation besteht aber zu 50 % aus Frauen, besteht ein gravierender Coverage Bias, der zu schlechter Modellleistung für Frauen führen wird.

Performance Slice Analysis ist eine weitere wichtige Methode: Die Modellleistung wird getrennt für verschiedene demografische Gruppen und Subpopulationen ausgewertet. Auch wenn die Gesamttreffgenauigkeit akzeptabel erscheint, kann die Leistung zwischen Gruppen stark variieren. Erzielt Ihr Modell z. B. insgesamt 95 % Genauigkeit, aber nur 70 % für eine bestimmte Gruppe, deutet dies darauf hin, dass Source Selection Bias dazu geführt hat, dass das Modell nur Muster der Mehrheit gelernt hat. Diese Analyse sollte sich nicht nur auf die Gesamtgenauigkeit, sondern auch auf Fairness-Metriken wie Equalized Odds oder Disparate Impact erstrecken.

Adversarial Testing umfasst das gezielte Erstellen von Testfällen, um potenzielle Bias aufzudecken. Dazu gehört, das Modell mit Daten unterrepräsentierter Gruppen, Spezialfällen oder Szenarien zu testen, die im Training kaum vorkamen. Durch solches “Stresstesten” des Modells mit diversen Inputs lassen sich blinde Flecken durch Source Selection Bias aufdecken. Wurde Ihr Modell z. B. mit Daten aus Städten trainiert, testen Sie gezielt mit ländlichen Daten. Stammt das Training aus einem bestimmten Zeitraum, prüfen Sie mit Daten anderer Zeiträume, um Temporal Bias zu erkennen.

Die Minderung von Source Selection Bias erfordert Maßnahmen in mehreren Phasen des KI-Entwicklungszyklus – von der Datenerhebung bis zur Modellbewertung und -auslieferung. Der wirksamste Ansatz ist die datenzentrierte Minderung, bei der die Qualität und Repräsentativität der Trainingsdaten verbessert wird. Es beginnt mit diverser Datenerhebung: Unterrepräsentierte Gruppen und Szenarien werden gezielt in den Trainingsdatensatz aufgenommen. Statt auf bestehende Datensätze oder Convenience Sampling zu setzen, sollten Unternehmen gezielte Erhebungen durchführen, um alle relevanten Gruppen und Anwendungsfälle angemessen zu vertreten.

Resampling- und Reweighting-Techniken sind praktische Methoden, um Ungleichgewichte in bestehenden Datensätzen zu adressieren. Zufälliges Oversampling dupliziert Beispiele unterrepräsentierter Gruppen, während Undersampling Beispiele aus überrepräsentierten Gruppen reduziert. Fortgeschrittene Ansätze wie stratifiziertes Sampling sichern die proportionale Repräsentation in mehreren Dimensionen. Beim Reweighting erhalten unterrepräsentierte Beispiele beim Training ein höheres Gewicht – das Modell achtet so stärker auf Muster von Minderheiten. Am wirksamsten sind diese Techniken in Kombination mit neuer, diverser Datenerhebung.

Generierung synthetischer Daten bietet eine weitere Möglichkeit, insbesondere wenn reale Daten schwer oder teuer zu beschaffen sind. Techniken wie Generative Adversarial Networks (GANs) oder Variational Autoencoders (VAEs) können realistische synthetische Beispiele für unterrepräsentierte Gruppen erzeugen. Speziellere Methoden wie SMOTE (Synthetic Minority Over-sampling Technique) erstellen synthetische Beispiele durch Interpolation zwischen vorhandenen Minderheitenbeispielen. Synthetische Daten sollten jedoch mit Vorsicht und gründlicher Validierung eingesetzt werden, da hier sonst neue Bias entstehen können.

Fairness-bewusste Algorithmen sind eine weitere Strategie, die beim Modelltraining ansetzt. Diese Algorithmen berücksichtigen Fairness explizit im Lernprozess, sodass das Modell akzeptable Leistung für alle Gruppen erzielt – nicht nur für die Mehrheit. Adversarial Debiasing nutzt beispielsweise ein Gegennetzwerk, damit die Vorhersagen des Modells keine geschützten Merkmale wie Geschlecht oder Ethnie widerspiegeln. Fairness-Regularisierung fügt Strafterme zur Verlustfunktion hinzu, die diskriminierendes Verhalten entmutigen. So lässt sich das Gleichgewicht zwischen Gesamtgenauigkeit und Fairness bewusst steuern.

Kontinuierliche Überwachung und Neutraining sorgen dafür, dass Source Selection Bias nicht neu entsteht oder sich im Laufe der Zeit verschärft. Auch wenn die anfänglichen Trainingsdaten repräsentativ sind, können sich die realen Zielpopulationen verändern – etwa durch demografische, wirtschaftliche oder gesellschaftliche Entwicklungen. Performance-Monitoring-Systeme, die die Genauigkeit für verschiedene Gruppen unabhängig verfolgen, helfen, neue Bias früh zu erkennen. Bei Leistungsabfall hilft Neutraining mit aktualisierten Daten, die aktuelle Verteilungen widerspiegeln. Bias-Minderung ist ein fortlaufender Prozess und keine einmalige Maßnahme.

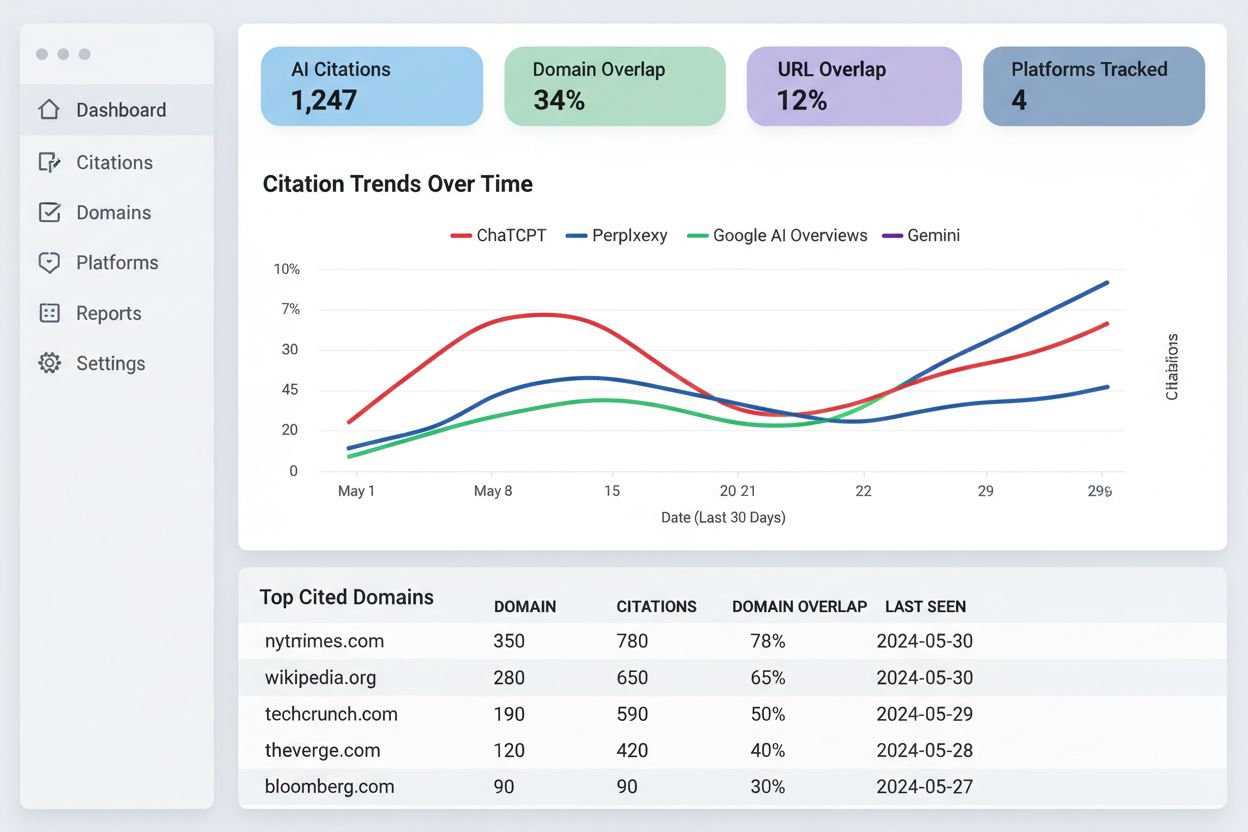

Das Verständnis von Source Selection Bias gewinnt im Kontext von KI-Antwortüberwachung und Markenpräsenz-Tracking zunehmend an Bedeutung. KI-Systeme wie ChatGPT, Perplexity und andere Antwortgeneratoren sind für viele Nutzer zur Hauptinformationsquelle geworden – die von ihnen zitierten Quellen und präsentierten Informationen werden durch die Trainingsdaten geprägt. Weisen diese Trainingsdaten Source Selection Bias auf, spiegeln die generierten Antworten diesen Bias wider. Beispiel: Wenn die Trainingsdaten einer KI bestimmte Websites, Publikationen oder Perspektiven überrepräsentieren und andere unterrepräsentieren, wird die KI diese Quellen häufiger zitieren und deren Informationen verstärken.

Das hat direkte Auswirkungen auf Markenüberwachung und Sichtbarkeit. Ist Ihre Marke, Domain oder Ihre URLs in den Trainingsdaten großer KI-Systeme unterrepräsentiert, werden Ihre Inhalte in KI-Antworten systematisch ausgeschlossen oder kaum berücksichtigt. Im Gegenzug erhalten konkurrierende Marken oder Falschinformationen, die überrepräsentiert sind, eine überproportionale Sichtbarkeit. Die Überwachung, wie Ihre Marke in KI-Antworten auf verschiedenen Plattformen erscheint, hilft zu erkennen, ob Source Selection Bias Ihre Sichtbarkeit und Reputation beeinflusst. Durch das Tracken, welche Quellen zitiert werden, wie oft Ihre Inhalte erscheinen und ob die präsentierten Informationen korrekt sind, lassen sich potenzielle Bias in der Darstellung Ihrer Marke und Branche durch KI identifizieren.

Source Selection Bias in der KI ist ein zentrales Fairnessproblem, das bereits in der Datenerhebung entsteht und sich durch alle nachgelagerten Anwendungen von Machine-Learning-Modellen zieht. Er tritt auf, wenn Trainingsdaten bestimmte Gruppen, Szenarien oder Merkmale systematisch ausschließen oder unterrepräsentieren, sodass Modelle ungenaue oder ungerechte Vorhersagen für unterrepräsentierte Gruppen treffen. Die Konsequenzen sind gravierend und reichen von Gesundheitsergebnissen über finanziellen Zugang bis hin zu Arbeitsmarktchancen und Justizentscheidungen. Die Erkennung von Source Selection Bias erfordert umfassende Data Audits, demografische Paritätsanalysen, Performance Slice Analysen und Adversarial Testing. Die Minderung verlangt einen vielschichtigen Ansatz: diverse Datenerhebung, Resampling und Reweighting, Generierung synthetischer Daten, Fairness-bewusste Algorithmen und kontinuierliche Überwachung. Organisationen müssen erkennen, dass die Bekämpfung von Source Selection Bias nicht optional ist, sondern essenziell, um KI-Systeme zu schaffen, die fair, genau und vertrauenswürdig für alle Populationen und Anwendungsfälle sind.

Stellen Sie sicher, dass Ihre Marke in KI-generierten Antworten auf ChatGPT, Perplexity und anderen KI-Plattformen korrekt erscheint. Verfolgen Sie, wie KI-Systeme Ihre Inhalte zitieren, und erkennen Sie potenzielle Verzerrungen in KI-Antworten.

Erfahren Sie mehr über Recency Bias in KI-Systemen, wie er die Sichtbarkeit von Inhalten, Empfehlungsalgorithmen und Geschäftsentscheidungen beeinflusst. Entdec...

Erfahren Sie mehr über das 7%-Überlappungsproblem – die entscheidende Erkenntnis, dass nur 7% der URLs aus Googles Top 10 in KI-Zitaten erscheinen. Verstehen Si...

Erfahren Sie effektive Methoden, um ungenaue Informationen in KI-generierten Antworten von ChatGPT, Perplexity und anderen KI-Systemen zu erkennen, zu überprüfe...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.