A/B-Tests für KI-Sichtbarkeit: Methodik und Best Practices

Beherrschen Sie A/B-Tests für KI-Sichtbarkeit mit unserem umfassenden Leitfaden. Lernen Sie GEO-Experimente, Methodik, Best Practices und praxisnahe Fallstudien...

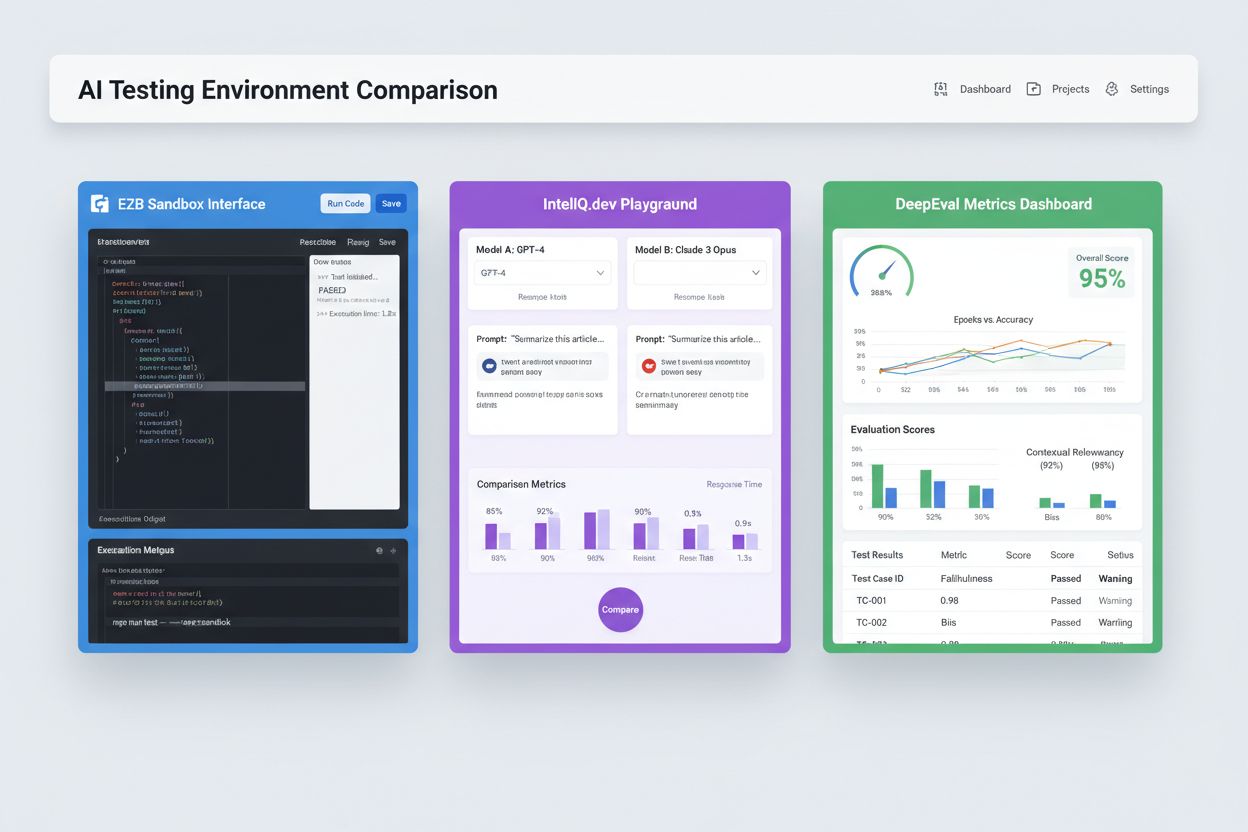

Isolierte Sandbox-Umgebungen, die entwickelt wurden, um künstliche Intelligenz-Modelle und -Anwendungen vor dem Produktiveinsatz zu validieren, zu evaluieren und zu debuggen. Diese kontrollierten Bereiche ermöglichen das Testen der KI-Inhaltsleistung auf verschiedenen Plattformen, die Messung von Metriken und die Sicherstellung der Zuverlässigkeit, ohne Live-Systeme zu beeinträchtigen oder sensible Daten offenzulegen.

Isolierte Sandbox-Umgebungen, die entwickelt wurden, um künstliche Intelligenz-Modelle und -Anwendungen vor dem Produktiveinsatz zu validieren, zu evaluieren und zu debuggen. Diese kontrollierten Bereiche ermöglichen das Testen der KI-Inhaltsleistung auf verschiedenen Plattformen, die Messung von Metriken und die Sicherstellung der Zuverlässigkeit, ohne Live-Systeme zu beeinträchtigen oder sensible Daten offenzulegen.

Eine KI-Testumgebung ist ein kontrollierter, isolierter Computerraum, der dazu dient, künstliche Intelligenz-Modelle und -Anwendungen vor der Bereitstellung in Produktivsystemen zu validieren, zu evaluieren und zu debuggen. Sie fungiert als Sandbox, in der Entwickler, Data Scientists und QA-Teams KI-Modelle sicher ausführen, verschiedene Konfigurationen testen und die Leistung anhand vordefinierter Metriken messen können – ohne Live-Systeme zu beeinträchtigen oder sensible Daten offenzulegen. Diese Umgebungen replizieren Produktionsbedingungen bei vollständiger Isolation, sodass Teams Probleme identifizieren, das Modellverhalten optimieren und Zuverlässigkeit in verschiedenen Szenarien sicherstellen können. Die Testumgebung agiert als kritische Qualitäts-Schranke im KI-Entwicklungszyklus und schlägt die Brücke zwischen experimentellem Prototyping und unternehmenskritischer Bereitstellung.

Eine umfassende KI-Testumgebung besteht aus mehreren miteinander verbundenen technischen Schichten, die gemeinsam vollständige Testfunktionen bieten. Die Modellausführungsschicht übernimmt die eigentliche Inferenz und Berechnung und unterstützt mehrere Frameworks (PyTorch, TensorFlow, ONNX) und Modelltypen (LLMs, Computer Vision, Zeitreihen). Die Datenverwaltungsschicht verwaltet Testdatensätze, Fixtures und die Generierung synthetischer Daten und sorgt dabei für Datenisolation und Compliance. Das Evaluierungs-Framework umfasst Metrik-Engines, Assertion-Bibliotheken und Bewertungssysteme, die Modellausgaben mit erwarteten Ergebnissen vergleichen. Die Überwachungs- und Protokollierungsschicht erfasst Ausführungstraces, Leistungsmetriken, Latenzdaten und Fehlerprotokolle zur Analyse nach dem Test. Die Orchestrierungsschicht verwaltet Test-Workflows, parallele Ausführung, Ressourcenallokation und die Bereitstellung von Umgebungen. Nachfolgend ein Vergleich wichtiger Architekturkomponenten verschiedener Testumgebungs-Typen:

| Komponente | LLM-Testing | Computer Vision | Zeitreihe | Multi-Modal |

|---|---|---|---|---|

| Modell-Laufzeit | Transformer-Inferenz | GPU-beschleunigte Inferenz | Sequenzielle Verarbeitung | Hybride Ausführung |

| Datenformat | Text/Tokens | Bilder/Tensoren | Numerische Sequenzen | Gemischte Medien |

| Evaluierungsmetriken | Semantische Ähnlichkeit, Halluzination | Genauigkeit, IoU, F1-Score | RMSE, MAE, MAPE | Cross-modale Ausrichtung |

| Latenzanforderungen | 100-500ms typisch | 50-200ms typisch | <100ms typisch | 200-1000ms typisch |

| Isolationsmethode | Container/VM | Container/VM | Container/VM | Firecracker microVM |

Moderne KI-Testumgebungen müssen heterogene Modellökosysteme unterstützen und Teams die Bewertung von Anwendungen über verschiedene LLM-Anbieter, Frameworks und Deployment-Ziele hinweg ermöglichen. Multi-Plattform-Testing erlaubt es Organisationen, Modellausgaben von OpenAIs GPT-4, Anthropics Claude, Mistral und Open-Source-Alternativen wie Llama im selben Test-Harness zu vergleichen und so fundierte Modellentscheidungen zu treffen. Plattformen wie E2B bieten isolierte Sandboxes, die von jedem LLM generierten Code ausführen, unterstützen Python, JavaScript, Ruby und C++ mit vollständigem Dateisystemzugriff, Terminal-Funktionen und Paketinstallation. IntelIQ.dev ermöglicht den direkten Vergleich mehrerer KI-Modelle mit einheitlichen Schnittstellen, sodass Teams Guardrail-Prompts und policy-basierte Templates anbieterübergreifend testen können. Testumgebungen müssen Folgendes leisten:

KI-Testumgebungen dienen vielfältigen organisatorischen Anforderungen in Entwicklung, Qualitätssicherung und Compliance. Entwicklungsteams nutzen Testumgebungen, um das Modellverhalten bei iterativer Entwicklung zu validieren, Prompt-Variationen zu testen, Parameter zu optimieren und unerwartete Ausgaben vor der Integration zu debuggen. Data-Science-Teams bewerten Modellleistung auf Holdout-Datensätzen, vergleichen Architekturen und messen Metriken wie Genauigkeit, Präzision, Recall und F1-Scores. Produktionsüberwachung umfasst kontinuierliches Testen bereitgestellter Modelle gegen Baseline-Metriken, erkennt Leistungsabfall und löst Retraining-Pipelines aus, wenn Qualitätsgrenzen überschritten werden. Compliance- und Sicherheitsteams validieren, dass Modelle regulatorische Anforderungen erfüllen, keine verzerrten Ausgaben produzieren und sensible Daten angemessen behandeln. Enterprise-Einsatzbereiche sind:

Das KI-Testumfeld umfasst spezialisierte Plattformen für verschiedene Test-Szenarien und Unternehmensgrößen. DeepEval ist ein Open-Source-LLM-Evaluierungsframework mit über 50 wissenschaftlich belegten Metriken – darunter Antwortkorrektheit, semantische Ähnlichkeit, Halluzinationserkennung, Toxicity-Scoring – und nativer Pytest-Integration für CI/CD-Workflows. LangSmith (von LangChain) bietet umfassende Observability-, Evaluierungs- und Deployment-Funktionen mit integriertem Tracing, Prompt-Versionierung und Datensatzverwaltung für LLM-Anwendungen. E2B stellt sichere, isolierte Sandboxes bereit, die auf Firecracker microVMs basieren, unterstützt Codeausführung mit <200ms Startzeit, Sitzungen bis zu 24 Stunden und Integration mit führenden LLM-Anbietern. IntelIQ.dev setzt auf privacy-first Testing mit Ende-zu-Ende-Verschlüsselung, rollenbasierter Zugriffskontrolle und Unterstützung für mehrere KI-Modelle inklusive GPT-4, Claude und Open-Source-Alternativen. Die folgende Tabelle vergleicht zentrale Funktionen:

| Tool | Hauptfokus | Metriken | CI/CD-Integration | Multi-Modell-Support | Preismodell |

|---|---|---|---|---|---|

| DeepEval | LLM-Evaluierung | 50+ Metriken | Native Pytest | Eingeschränkt | Open Source + Cloud |

| LangSmith | Observability & Evaluierung | Individuelle Metriken | API-basiert | LangChain-Ökosystem | Freemium + Enterprise |

| E2B | Codeausführung | Performance-Metriken | GitHub Actions | Alle LLMs | Pay-per-use + Enterprise |

| IntelIQ.dev | Privacy-first Testing | Individuelle Metriken | Workflow-Builder | GPT-4, Claude, Mistral | Abonnementbasiert |

Enterprise-KI-Testumgebungen müssen strenge Sicherheitsmaßnahmen implementieren, um sensible Daten zu schützen, regulatorische Anforderungen zu erfüllen und unbefugten Zugriff zu verhindern. Datenisolation verlangt, dass Testdaten niemals an externe APIs oder Drittanbieterdienste gelangen; Plattformen wie E2B nutzen Firecracker microVMs für vollständige Prozessisolation ohne gemeinsamen Kernelzugriff. Verschlüsselungsstandards sollten Ende-zu-Ende-Verschlüsselung für Daten im Ruhezustand und während der Übertragung umfassen mit Unterstützung für HIPAA, SOC 2 Type 2 und DSGVO. Zugriffskontrollen müssen rollenbasierte Rechte, Audit-Logging und Freigabe-Workflows für sensible Testszenarien durchsetzen. Best Practices sind: getrennte Testdatensätze ohne Produktivdaten pflegen, Datenmaskierung für personenbezogene Daten (PII) umsetzen, synthetische Datengenerierung für realistische Tests ohne Datenschutzrisiko nutzen, regelmäßige Sicherheitsprüfungen der Testinfrastruktur durchführen und alle Testergebnisse für Compliance dokumentieren. Unternehmen sollten zudem Bias-Detection einsetzen, um diskriminierendes Modellverhalten zu erkennen, Interpretierbarkeitstools wie SHAP oder LIME zur Nachvollziehbarkeit von Modellentscheidungen nutzen und Entscheidungsprotokollierung einführen, um regulatorische Rechenschaft über Modell-Outputs zu gewährleisten.

KI-Testumgebungen müssen sich nahtlos in bestehende Continuous-Integration- und Continuous-Deployment-Pipelines integrieren, um automatisierte Qualitätsprüfungen und schnelle Iterationszyklen zu ermöglichen. Native CI/CD-Integration erlaubt, dass Tests automatisch bei Code-Commits, Pull Requests oder geplanten Zeiten via GitHub Actions, GitLab CI oder Jenkins ausgelöst werden. DeepEvals Pytest-Integration ermöglicht es Entwicklern, Testfälle als Standard-Python-Tests zu schreiben, die in bestehenden CI-Workflows ausgeführt und zusammen mit klassischen Unit-Tests reportet werden. Automatisierte Evaluierung kann Modellmetriken messen, Ausgaben mit Baseline-Versionen vergleichen und Deployments blockieren, wenn Qualitätsgrenzen nicht eingehalten werden. Artefaktmanagement umfasst das Speichern von Testdatensätzen, Modell-Checkpoints und Ergebnissen in Versionskontrollsystemen oder Artefakt-Repositories für Nachvollziehbarkeit und Audit-Trails. Typische Integrationsmuster:

Das Feld der KI-Testumgebungen entwickelt sich rasant weiter, um neuen Herausforderungen wie Modellkomplexität, Skalierung und Heterogenität zu begegnen. Agentisches Testing gewinnt an Bedeutung, da KI-Systeme zunehmend über Einzelmodell-Inferenz hinaus zu mehrstufigen Workflows wachsen, in denen Agenten Tools nutzen, Entscheidungen treffen und mit externen Systemen interagieren – das erfordert neue Evaluierungsrahmen für Task Completion, Sicherheit und Zuverlässigkeit. Verteilte Evaluierung ermöglicht Testing im großen Maßstab durch tausende parallele Testinstanzen in der Cloud – essenziell für Reinforcement Learning und großflächiges Modelltraining. Echtzeit-Monitoring verschiebt sich von Batch-Evaluierung zu kontinuierlichem, produktionsnahem Testing, das Leistungsabfall, Daten-Drift und neue Biases im Live-Betrieb erkennt. Observability-Plattformen wie AmICited entwickeln sich zu unverzichtbaren Tools für umfassende KI-Überwachung und -Sichtbarkeit, mit zentralisierten Dashboards für Modellperformance, Nutzungsmuster und Qualitätsmetriken über ganze KI-Portfolios hinweg. Zukünftige Testumgebungen werden verstärkt automatisierte Remediation integrieren, bei der Systeme nicht nur Probleme erkennen, sondern automatisch Retraining- oder Modell-Updates anstoßen, sowie cross-modale Evaluierung für simultanes Testen von Text-, Bild-, Audio- und Videomodellen in einheitlichen Frameworks.

Eine KI-Testumgebung ist eine isolierte Sandbox, in der Sie Modelle, Prompts und Konfigurationen sicher testen können, ohne Live-Systeme oder Nutzer zu beeinträchtigen. Produktion ist die Live-Umgebung, in der Modelle reale Nutzer bedienen. Testumgebungen ermöglichen es, Probleme zu erkennen, die Leistung zu optimieren und Änderungen zu validieren, bevor sie in die Produktion gelangen – das reduziert Risiken und sichert Qualität.

Ja, moderne KI-Testumgebungen unterstützen das Testen mehrerer Modelle gleichzeitig. Plattformen wie E2B, IntelIQ.dev und DeepEval ermöglichen es, denselben Prompt oder Input parallel bei verschiedenen LLM-Anbietern (OpenAI, Anthropic, Mistral usw.) zu testen, sodass Sie Ausgaben und Leistungsmetriken direkt vergleichen können.

Enterprise-KI-Testumgebungen implementieren mehrere Sicherheitsschichten, darunter Datenisolation (Containerisierung oder MicroVMs), Ende-zu-Ende-Verschlüsselung, rollenbasierte Zugriffskontrollen, Audit-Logging und Compliance-Zertifizierungen (SOC 2, DSGVO, HIPAA). Daten verlassen die isolierte Umgebung niemals, es sei denn, sie werden explizit exportiert – so werden sensible Informationen geschützt.

Testumgebungen ermöglichen Compliance, indem sie Audit-Trails aller Modellbewertungen bereitstellen, Datenmaskierung und synthetische Datengenerierung unterstützen, Zugriffskontrollen durchsetzen und vollständige Isolation der Testdaten von Produktivsystemen gewährleisten. Diese Dokumentation und Kontrolle hilft Unternehmen, regulatorische Anforderungen wie DSGVO, HIPAA und SOC 2 zu erfüllen.

Die wichtigsten Metriken hängen vom Anwendungsfall ab: Für LLMs sollten Sie Genauigkeit, semantische Ähnlichkeit, Halluzinationsraten und Latenz verfolgen; für RAG-Systeme Kontext-Präzision/Recall und Korrektheit; für Klassifikationsmodelle Präzision, Recall und F1-Scores; generell für alle Modelle Leistungsverschlechterung über die Zeit und Bias-Indikatoren.

Die Kosten variieren je nach Plattform: DeepEval ist Open Source und kostenlos; LangSmith bietet einen kostenlosen Tarif mit kostenpflichtigen Plänen ab 39 $/Monat; E2B nutzt nutzungsbasiertes Preismodell abhängig von der Sandbox-Laufzeit; IntelIQ.dev bietet abonnementbasierte Preise. Viele Plattformen bieten auch Enterprise-Preise für großflächige Einsätze.

Ja, die meisten modernen Testumgebungen unterstützen CI/CD-Integration. DeepEval integriert sich nativ mit Pytest, E2B arbeitet mit GitHub Actions und GitLab CI, und LangSmith bietet API-basierte Integration. So ist automatisiertes Testen bei jedem Code-Commit und die Durchsetzung von Deployment-Gates möglich.

End-to-End-Tests behandeln Ihre gesamte KI-Anwendung als Blackbox und prüfen die endgültige Ausgabe gegen erwartete Ergebnisse. Komponententests bewerten einzelne Teile (LLM-Calls, Retriever, Toolnutzung) separat mit Tracing und Instrumentierung. Komponententests liefern tiefergehende Einblicke, wo Probleme auftreten, während End-to-End-Tests das Gesamtverhalten des Systems validieren.

AmICited verfolgt, wie KI-Systeme Ihre Marke und Inhalte über ChatGPT, Claude, Perplexity und Google AI hinweg referenzieren. Erhalten Sie Echtzeit-Transparenz über Ihre KI-Präsenz mit umfassender Überwachung und Analysen.

Beherrschen Sie A/B-Tests für KI-Sichtbarkeit mit unserem umfassenden Leitfaden. Lernen Sie GEO-Experimente, Methodik, Best Practices und praxisnahe Fallstudien...

Erfahren Sie, wie Sie die Präsenz Ihrer Marke in KI-Engines mit Prompt-Testing testen. Entdecken Sie manuelle und automatisierte Methoden, um die KI-Sichtbarkei...

Entdecken Sie die besten kostenlosen KI-Sichtbarkeitstools, um die Erwähnung Ihrer Marke in ChatGPT, Perplexity und Google KI-Overviews zu überwachen. Vergleich...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.