Wie optimieren Finanzdienstleister für die KI-Suche?

Erfahren Sie, wie Finanzinstitute für KI-Suchmaschinen optimieren und Sichtbarkeit in KI-generierten Antworten sicherstellen können. Entdecken Sie Strategien zu...

Regulatorische Anforderungen für Finanzinstitute, die eine transparente Offenlegung des Einsatzes von künstlicher Intelligenz in Entscheidungsprozessen, Risikomanagement und kundenorientierten Anwendungen vorschreiben. Umfasst Erwartungen der SEC, CFPB, FINRA und anderer Aufsichtsbehörden an die Dokumentation der KI-Governance, der Modellleistung sowie der Auswirkungen auf Verbraucher und Märkte.

Regulatorische Anforderungen für Finanzinstitute, die eine transparente Offenlegung des Einsatzes von künstlicher Intelligenz in Entscheidungsprozessen, Risikomanagement und kundenorientierten Anwendungen vorschreiben. Umfasst Erwartungen der SEC, CFPB, FINRA und anderer Aufsichtsbehörden an die Dokumentation der KI-Governance, der Modellleistung sowie der Auswirkungen auf Verbraucher und Märkte.

Finanzielle KI-Offenlegung bezeichnet die regulatorischen Anforderungen und Best Practices für Finanzinstitute, den Einsatz von künstlicher Intelligenz in Entscheidungsprozessen, im Risikomanagement und in kundenorientierten Anwendungen transparent offenzulegen. Sie umfasst die Erwartungen von SEC, CFPB, FINRA und weiteren Aufsichtsbehörden bezüglich der Dokumentation der KI-Governance, der Modellleistung sowie potenzieller Auswirkungen auf Verbraucher und Märkte. Im Dezember 2024 legte das Investor Advisory Committee (IAC) der SEC eine formelle Empfehlung vor, dass die Behörde Leitlinien herausgeben solle, die Emittenten verpflichten, Informationen über den Einfluss von künstlicher Intelligenz auf ihre Unternehmen offenzulegen. Das IAC verwies auf einen „Mangel an Konsistenz“ bei aktuellen KI-Offenlegungen, was „für Anleger, die klare und vergleichbare Informationen suchen, problematisch sein kann“. Nur 40 % der S&P 500-Unternehmen veröffentlichen KI-bezogene Offenlegungen, und nur 15 % geben Informationen zur Überwachung von KI durch den Vorstand an, obwohl 60 % der S&P 500-Unternehmen KI als erhebliches Risiko betrachten.

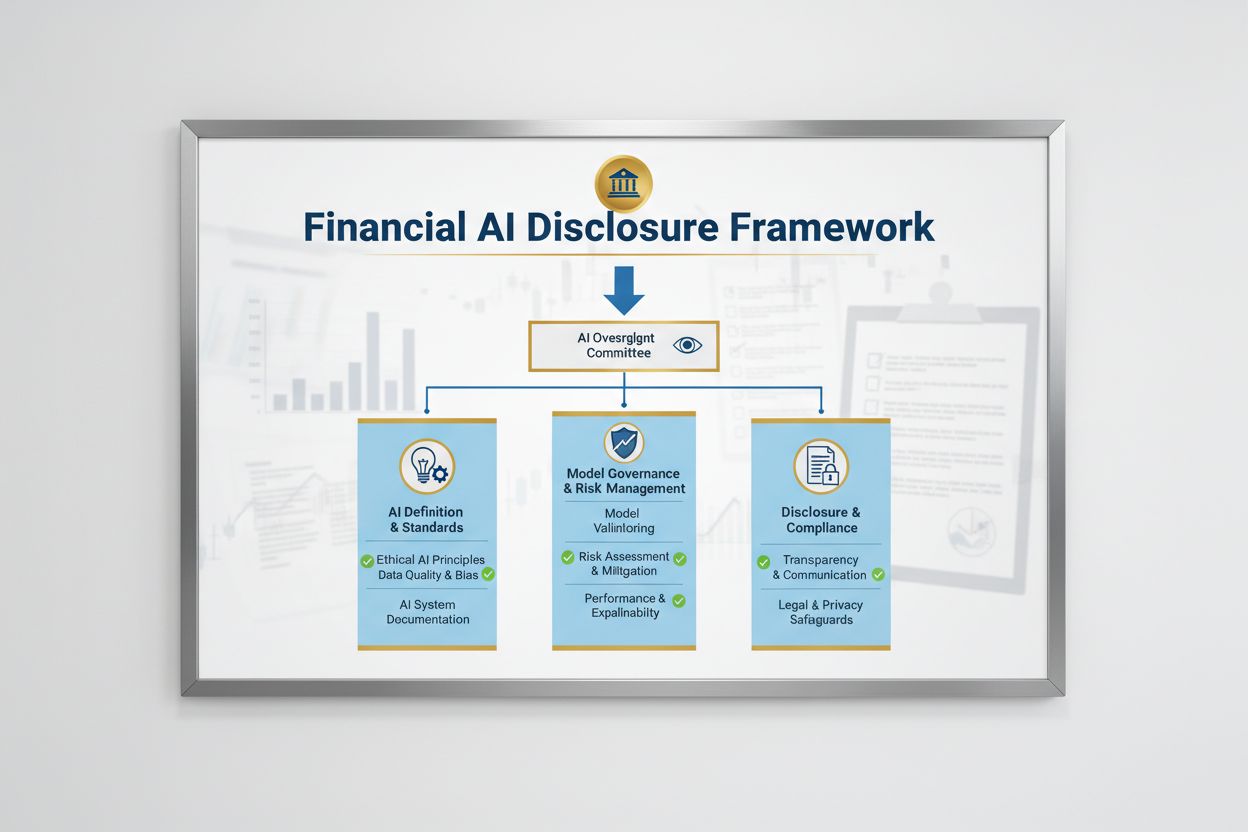

Das regulatorische Umfeld für die finanzielle KI-Offenlegung wird von mehreren Bundesbehörden geprägt, die bestehende, technologie-neutrale Gesetze auf KI-Systeme anwenden. Das Investor Advisory Committee der SEC schlug einen Rahmen mit drei zentralen Säulen vor: (1) Emittenten dazu verpflichten, zu definieren, was sie unter „Künstlicher Intelligenz“ verstehen, (2) Mechanismen zur Überwachung durch den Vorstand für den KI-Einsatz offenzulegen und (3) über wesentliche KI-Einsätze und deren Auswirkungen auf interne Abläufe und kundenorientierte Produkte zu berichten. Neben der SEC haben CFPB, FINRA, OCC und Federal Reserve Leitlinien herausgegeben, die betonen, dass bestehende Verbraucherschutzgesetze – einschließlich fairer Kreditvergabe, Datenschutz und Betrugsbekämpfung – unabhängig von der eingesetzten Technologie auf KI-Systeme angewendet werden. Diese Behörden verfolgen einen technologie-neutralen Ansatz, was bedeutet, dass Compliance-Anforderungen aus dem Equal Credit Opportunity Act (ECOA), Fair Credit Reporting Act (FCRA), Gramm-Leach-Bliley Act (GLBA) und Unfair or Deceptive Acts or Practices (UDAAP) auch bei KI unverändert bleiben.

| Regulierer | Fokusbereich | Zentrale Anforderung |

|---|---|---|

| SEC | Anlegeroffenlegung, Interessenkonflikte | KI definieren, Überwachung durch Vorstand offenlegen, wesentliche Einsätze berichten |

| CFPB | Faire Kreditvergabe, Verbraucherschutz | Sicherstellen, dass KI-Modelle ECOA-konform sind, Negativbescheide bereitstellen |

| FINRA | Broker-Dealer-Betrieb, Kundenkommunikation | KI-Governance-Richtlinien etablieren, KI-Nutzung in allen Funktionen überwachen |

| OCC/Federal Reserve/FDIC | Modell-Governance in Banken, operationelles Risiko | KI-Modelle validieren, Kontrollen dokumentieren, Zuverlässigkeit bewerten |

| FTC | Irreführende Praktiken, Datenverarbeitung | KI-bezogene Aussagen überwachen, unfairen Datengebrauch verhindern |

Eine wirksame finanzielle KI-Offenlegung erfordert eine klare Überwachung des KI-Einsatzes und des Risikomanagements auf Vorstandsebene. Die Empfehlung des IAC der SEC betont, dass Anleger ein legitimes Interesse daran haben, zu verstehen, ob es klare Verantwortlichkeiten für den Einsatz von KI-Technologien in internen Geschäftsabläufen und Produktlinien gibt. Finanzinstitute müssen Governance-Strukturen etablieren, die die Verantwortung für die KI-Überwachung dem Vorstand oder einem zuständigen Ausschuss zuweisen, um sicherzustellen, dass KI-bezogene Risiken auf oberster Ebene gesteuert werden. Dieses Governance-Rahmenwerk sollte dokumentierte Richtlinien und Verfahren für Entwicklung, Test, Validierung und Einsatz von KI umfassen, mit regelmäßigen Berichten an den Vorstand über die Leistung der Modelle, festgestellte Risiken und Abhilfemaßnahmen. Ohne klare Verantwortlichkeiten auf Vorstandsebene drohen Finanzinstituten aufsichtsrechtliche Prüfungen und mögliche Durchsetzungsmaßnahmen wegen unzureichender Kontrolle wesentlicher KI-Systeme.

Finanzinstitute müssen die wesentlichen Auswirkungen des KI-Einsatzes auf interne Geschäftsabläufe und kundenorientierte Produkte separat offenlegen. Für interne Abläufe sollten Offenlegungen den Einfluss von KI auf Humankapital (wie Personalabbau oder Weiterbildungsbedarf), die Genauigkeit der Finanzberichterstattung, Governance-Prozesse und Cybersecurity-Risiken behandeln. In Bezug auf kundenorientierte Themen sollten Institute Investitionen in KI-basierte Plattformen, die Integration von KI in Produkte und Dienstleistungen, regulatorische Auswirkungen durch KI-Nutzung sowie den Einfluss von KI auf Preisstrategien oder Unternehmenskennzahlen offenlegen. Die SEC empfiehlt, diese Offenlegungen in bestehende Punkte der Regulation S-K (wie die Items 101, 103, 106 und 303) auf Basis der Wesentlichkeit zu integrieren, statt vollständig neue Offenlegungskategorien zu schaffen. Dieser Ansatz ermöglicht es Finanzinstituten, bestehende Offenlegungsrahmen zu nutzen und Anlegern dennoch klare, vergleichbare Informationen über die Rolle von KI in der Organisation und ihrer strategischen Ausrichtung zu bieten.

Hochwertige Daten sind die Grundlage für einen verantwortungsvollen KI-Einsatz im Finanzbereich, doch viele Institute kämpfen mit Daten-Governance-Rahmenwerken, die regulatorischen Erwartungen entsprechen. Finanzinstitute müssen sicherstellen, dass die Daten, die für Training, Test und Validierung von KI-Modellen verwendet werden, sauber, vollständig, standardisiert und umfassend sind, mit klarer Dokumentation der Datenquellen, des Ursprungs und etwaiger bekannter Einschränkungen. Datenschutzmaßnahmen müssen „Datenvergiftung“ – also die Manipulation von Trainingsdaten zur Beeinträchtigung der Modellintegrität – verhindern und den unbefugten Zugriff oder die Offenlegung sensibler Informationen unterbinden. Das Gramm-Leach-Bliley Act (GLBA) bietet grundlegende Schutzmaßnahmen für Finanzdaten von Verbrauchern, doch viele Aufsichtsbehörden und Verbraucherschützer argumentieren, dass diese im KI-Kontext unzureichend sind, insbesondere im Hinblick auf die zunehmende Datenerhebung und -nutzung für das Modelltraining. Finanzinstitute müssen auch geistige Eigentumsrechte beachten und sicherstellen, dass sie zur Datennutzung für KI-Entwicklung befugt sind und Rechte Dritter respektieren. Die Umsetzung robuster Daten-Governance-Rahmenwerke einschließlich Datenminimierung, Zugriffskontrollen und regelmäßiger Audits ist für die Einhaltung regulatorischer Erwartungen unerlässlich.

Regulatorische Behörden haben klargestellt, dass KI-Modelle im Finanzbereich auf Verzerrungen und mögliche Diskriminierung getestet werden müssen, unabhängig von deren Genauigkeit oder Leistung. Das „Black-Box“-Problem – dass komplexe KI-Systeme Ergebnisse liefern, die schwer oder gar nicht erklärbar sind – birgt erhebliche Compliance-Risiken, besonders bei Anwendungen wie Kreditvergabe, Preisbildung und Betrugserkennung. Finanzinstitute müssen Prozesse implementieren, um Verzerrungen während des gesamten Modelllebenszyklus zu erkennen und zu mindern, einschließlich Tests während Entwicklung, Validierung und laufender Überwachung. Die Einhaltung der Anforderungen an faire Kreditvergabe verlangt, dass Institute die Gründe für negative Entscheidungen (z. B. Kreditablehnung) erklären können und nachweisen, dass ihre KI-Modelle keine unterschiedlichen Auswirkungen auf geschützte Gruppen haben. Das Testen auf „weniger diskriminierende Alternativen“ – Methoden, die gleiche Geschäftsziele mit weniger Verzerrung erreichen – wird zunehmend von Aufsichtsbehörden erwartet. Viele Institute setzen erklärbare KI-Techniken (xAI) wie Feature-Importance-Analysen und Entscheidungsbäume ein, um Transparenz und Verantwortlichkeit bei KI-gestützten Entscheidungen zu verbessern.

Finanzinstitute, die KI in kundenorientierten Anwendungen einsetzen, müssen geltende Verbraucherschutzgesetze einhalten, einschließlich Anforderungen an Negativbescheide, Datenschutzerklärungen und faire Behandlung. Wird ein KI-System genutzt, um Entscheidungen über Kredite, Versicherungen oder andere Finanzprodukte zu treffen oder maßgeblich zu beeinflussen, haben Verbraucher das Recht zu erfahren, warum sie abgelehnt wurden oder schlechtere Konditionen erhalten. Die CFPB betont, dass Kreditgeber, die dem Equal Credit Opportunity Act (ECOA) unterliegen, keine „Black-Box“-Modelle verwenden dürfen, wenn sie keine spezifischen und zutreffenden Gründe für Negativentscheidungen nennen können. Zusätzlich gilt der UDAAP-Standard für KI-gestützte Systeme, die Verbrauchern durch intransparente Datenerhebung, Datenschutzverletzungen oder die Lenkung zu ungeeigneten Produkten schaden können. Finanzinstitute müssen sicherstellen, dass KI-Systeme im Kundenservice, bei Produktempfehlungen und im Kontenmanagement den KI-Einsatz transparent machen und klare Hinweise dazu geben, wie Verbraucherdaten erhoben, verwendet und geschützt werden.

Die meisten Finanzinstitute verlassen sich auf Drittanbieter für Entwicklung, Einsatz oder Wartung von KI-Systemen, was erhebliche Verpflichtungen im Third-Party Risk Management (TPRM) mit sich bringt. Die Interagency Guidance on Third-Party Relationships der Bundesbanken betont, dass Finanzinstitute auch für Leistung und Compliance von KI-Systemen Dritter verantwortlich bleiben, selbst wenn das Modell nicht selbst entwickelt wurde. Effektives TPRM für KI erfordert eine sorgfältige Prüfung vor der Auswahl eines Anbieters, einschließlich Bewertung der Daten-Governance-Praktiken, Modellvalidierung und Transparenz über den Modellbetrieb. Institute müssen auch das Konzentrationsrisiko überwachen – das potenzielle systemische Risiko, wenn wenige KI-Anbieter ausfallen oder Störungen erleiden. Risiken in der Lieferkette, wie die Zuverlässigkeit von Datenquellen und die Stabilität der Drittanbieter-Infrastruktur, müssen bewertet und dokumentiert werden. Verträge mit KI-Anbietern sollten klare Anforderungen an Datensicherheit, Überwachung der Modellleistung, Vorfallberichterstattung und Auditierbarkeit enthalten. Besonders kleinere Institute haben oft nicht die nötige technische Expertise zur Bewertung komplexer KI-Systeme, weshalb Branchenstandards oder Zertifizierungsprogramme zur Lieferantenbewertung erforderlich sein können.

Finanzinstitute mit grenzüberschreitenden Aktivitäten sehen sich einer zunehmend komplexen Vielfalt an KI-Vorschriften gegenüber, wobei der AI Act der EU den bislang umfassendsten Regulierungsrahmen darstellt. Die EU stuft KI-Systeme für Kreditwürdigkeitsprüfung, Betrugsbekämpfung und Geldwäscheprävention als „hochriskant“ ein und verlangt umfangreiche Dokumentation, Verzerrungstests, menschliche Überwachung und Konformitätsbewertungen. Auch OECD und G7 haben Grundsätze und Empfehlungen für verantwortungsvolle KI-Governance im Finanzsektor veröffentlicht, die Transparenz, Fairness, Verantwortlichkeit und menschliche Kontrolle betonen. Viele dieser internationalen Standards haben extraterritoriale Wirkung, sodass Finanzinstitute mit Kunden in der EU, dem Vereinigten Königreich oder anderen regulierten Jurisdiktionen diese Standards auch dann einhalten müssen, wenn sie ihren Sitz anderswo haben. Die Bemühungen um regulatorische Harmonisierung dauern an, doch bestehen weiterhin erhebliche Unterschiede zwischen Rechtsräumen, was die Compliance für globale Finanzinstitute erschwert. Eine proaktive Angleichung an die höchsten internationalen Standards – wie den EU AI Act und die OECD-Prinzipien – kann Institute auf künftige regulatorische Entwicklungen vorbereiten und das Risiko von Durchsetzungsmaßnahmen in mehreren Ländern senken.

Finanzinstitute sollten umfassende Dokumentations- und Governance-Praktiken implementieren, um die Einhaltung der Erwartungen an die finanzielle KI-Offenlegung nachzuweisen. Wichtige Best Practices sind:

Durch die Umsetzung dieser Maßnahmen können Finanzinstitute regulatorische Risiken reduzieren, das Vertrauen von Interessengruppen stärken und sich als Vorreiter für verantwortungsvollen KI-Einsatz im Finanzsektor positionieren.

Finanzielle KI-Offenlegung bezieht sich auf die regulatorischen Anforderungen für Finanzinstitute, den Einsatz von künstlicher Intelligenz in Entscheidungsprozessen, Risikomanagement und kundenorientierten Anwendungen transparent offenzulegen. Sie umfasst die Erwartungen von SEC, CFPB, FINRA und anderen Aufsichtsbehörden an die Dokumentation der KI-Governance, der Modellleistung sowie der Auswirkungen auf Verbraucher und Märkte. Der Investor Advisory Committee der SEC empfahl im Dezember 2024, dass Finanzinstitute ihren KI-Einsatz definieren, Mechanismen zur Überwachung durch den Vorstand offenlegen und über wesentliche KI-Einsätze berichten.

Finanzinstitute müssen den KI-Einsatz offenlegen, um Anleger, Verbraucher und die Integrität der Märkte zu schützen. Aufsichtsbehörden haben festgestellt, dass nur 40 % der S&P 500-Unternehmen KI-bezogene Offenlegungen bereitstellen, was zu Inkonsistenzen und Informationslücken für Anleger führt. Offenlegungspflichten sorgen dafür, dass Interessengruppen verstehen, wie KI Finanzentscheidungen, Risikomanagement und Verbraucherresultate beeinflusst. Zudem gelten bestehende Verbraucherschutzgesetze – einschließlich Gesetzen zu fairem Kreditwesen und Datenschutz – auch für KI-Systeme, weshalb Offenlegung für die Einhaltung von Vorschriften unerlässlich ist.

Der Investor Advisory Committee der SEC empfahl drei zentrale Säulen für die KI-Offenlegung: (1) Emittenten dazu zu verpflichten, zu definieren, was sie unter 'Künstlicher Intelligenz' verstehen, (2) Mechanismen zur Überwachung durch den Vorstand für den KI-Einsatz offenzulegen und (3) über wesentliche KI-Einsätze und deren Auswirkungen auf interne Abläufe und kundenorientierte Produkte zu berichten. Diese Empfehlungen sollen Anlegern klare, vergleichbare Informationen darüber liefern, wie KI die Abläufe und strategische Ausrichtung von Finanzinstituten beeinflusst.

Finanzielle KI-Offenlegung konzentriert sich speziell auf regulatorische Anforderungen für die transparente Kommunikation des KI-Einsatzes gegenüber externen Interessengruppen (Anleger, Aufsichtsbehörden, Verbraucher), während sich allgemeine KI-Governance auf interne Prozesse und Kontrollen für das Management von KI-Systemen bezieht. Offenlegung ist die externe Komponente der KI-Governance und stellt sicher, dass Interessengruppen Zugang zu wesentlichen Informationen über KI-Einsatz, Risiken und Auswirkungen erhalten. Beide sind für einen verantwortungsvollen KI-Einsatz im Finanzdienstleistungssektor unerlässlich.

Offenlegungen zum KI-Einsatz sollten sowohl interne Abläufe als auch Auswirkungen auf Verbraucher behandeln. Für interne Abläufe sollten Institute Auswirkungen auf Humankapital, Finanzberichterstattung, Governance und Cybersecurity-Risiken offenlegen. Für kundenorientierte Produkte sollten Investitionen in KI-gestützte Plattformen, Integration von KI in Produkte, regulatorische Auswirkungen und der Einfluss von KI auf Preisgestaltung oder Geschäftsstrategien genannt werden. Die Offenlegungen sollten in bestehende regulatorische Offenlegungspunkte (wie SEC Regulation S-K) auf Basis der Wesentlichkeit integriert werden.

Gesetze zum fairen Kreditwesen, einschließlich des Equal Credit Opportunity Act (ECOA) und des Fair Credit Reporting Act (FCRA), gelten für KI-Systeme, die bei Kreditentscheidungen eingesetzt werden, unabhängig von der verwendeten Technologie. Finanzinstitute müssen die spezifischen Gründe für abgelehnte Anträge (z. B. Kreditablehnungen) erklären können und nachweisen, dass ihre KI-Modelle keine unterschiedlichen Auswirkungen auf geschützte Gruppen haben. Die Aufsichtsbehörden erwarten, dass Institute KI-Modelle auf Verzerrungen testen, wo angebracht 'weniger diskriminierende Alternativen' einsetzen und die Dokumentation zu Fairness-Tests und Validierungen führen.

Die meisten Finanzinstitute verlassen sich bei KI-Systemen auf Drittanbieter, was erhebliche Verpflichtungen im Third-Party Risk Management (TPRM) schafft. Finanzinstitute bleiben für die Leistung und Compliance von KI-Systemen Dritter verantwortlich, auch wenn sie das Modell nicht selbst entwickelt haben. Effektives TPRM für KI erfordert sorgfältige Prüfung, laufende Überwachung, Bewertung der Daten-Governance des Anbieters und Dokumentation der Modellleistung. Institute müssen auch das Konzentrationsrisiko beobachten – also den potenziellen systemischen Einfluss, wenn eine geringe Zahl von KI-Anbietern Störungen erfährt.

Der AI Act der Europäischen Union ist der umfassendste Regulierungsrahmen für KI, stuft Finanz-KI-Systeme als 'hochriskant' ein und verlangt umfangreiche Dokumentation, Verzerrungstests und menschliche Überwachung. Auch OECD und G7 haben Grundsätze für verantwortungsvolle KI-Governance herausgegeben. Viele dieser internationalen Standards haben extraterritoriale Wirkung, sodass Finanzinstitute mit Kunden in regulierten Rechtsräumen diese Standards einhalten müssen. Proaktive Angleichung an internationale Standards kann Institute auf künftige regulatorische Entwicklungen vorbereiten und das Durchsetzungsrisiko senken.

Verfolgen Sie, wie Ihr Finanzinstitut in KI-Antworten über GPTs, Perplexity und Google AI Overviews erwähnt wird. Stellen Sie sicher, dass Ihre Marke in KI-generierten Finanzinhalten sichtbar und korrekt bleibt.

Erfahren Sie, wie Finanzinstitute für KI-Suchmaschinen optimieren und Sichtbarkeit in KI-generierten Antworten sicherstellen können. Entdecken Sie Strategien zu...

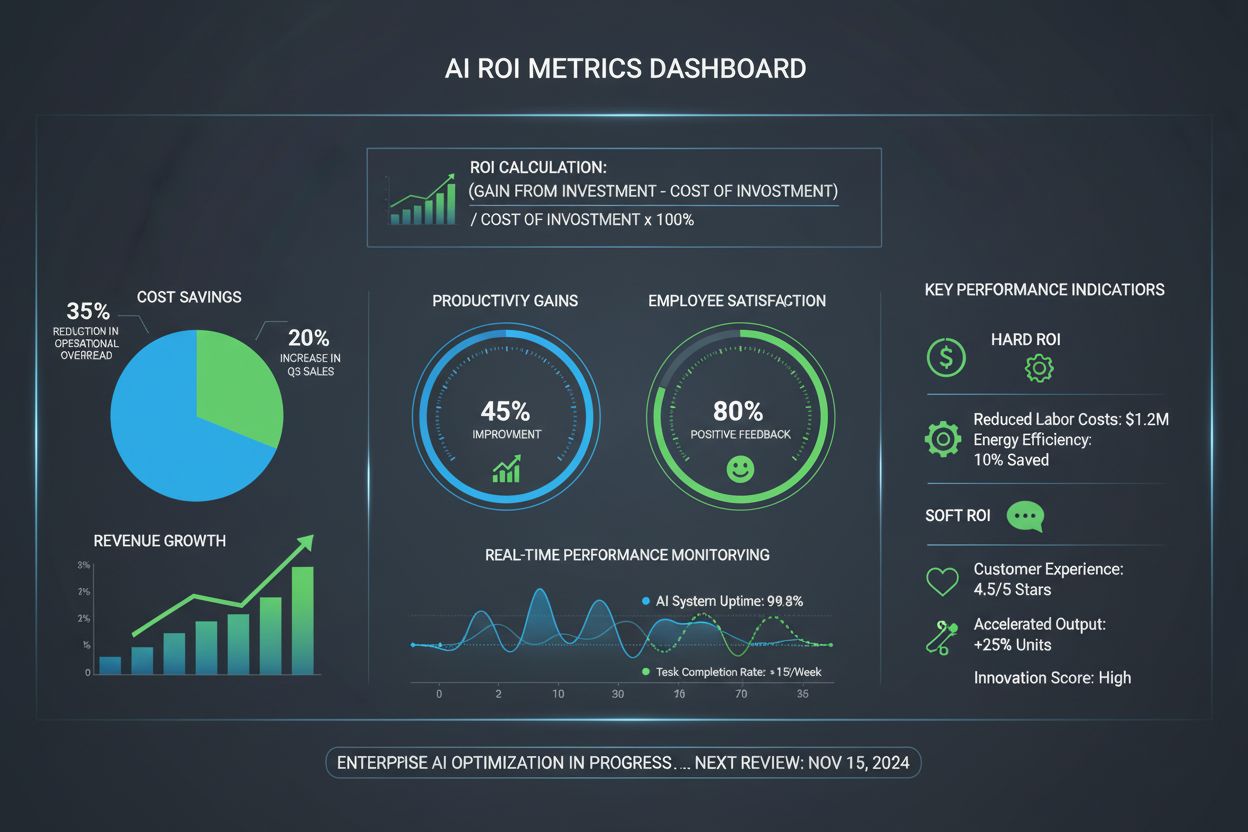

Der KI-ROI misst die finanziellen und betrieblichen Erträge aus KI-Investitionen. Erfahren Sie, wie Sie harten und weichen ROI berechnen, wichtige Kennzahlen un...

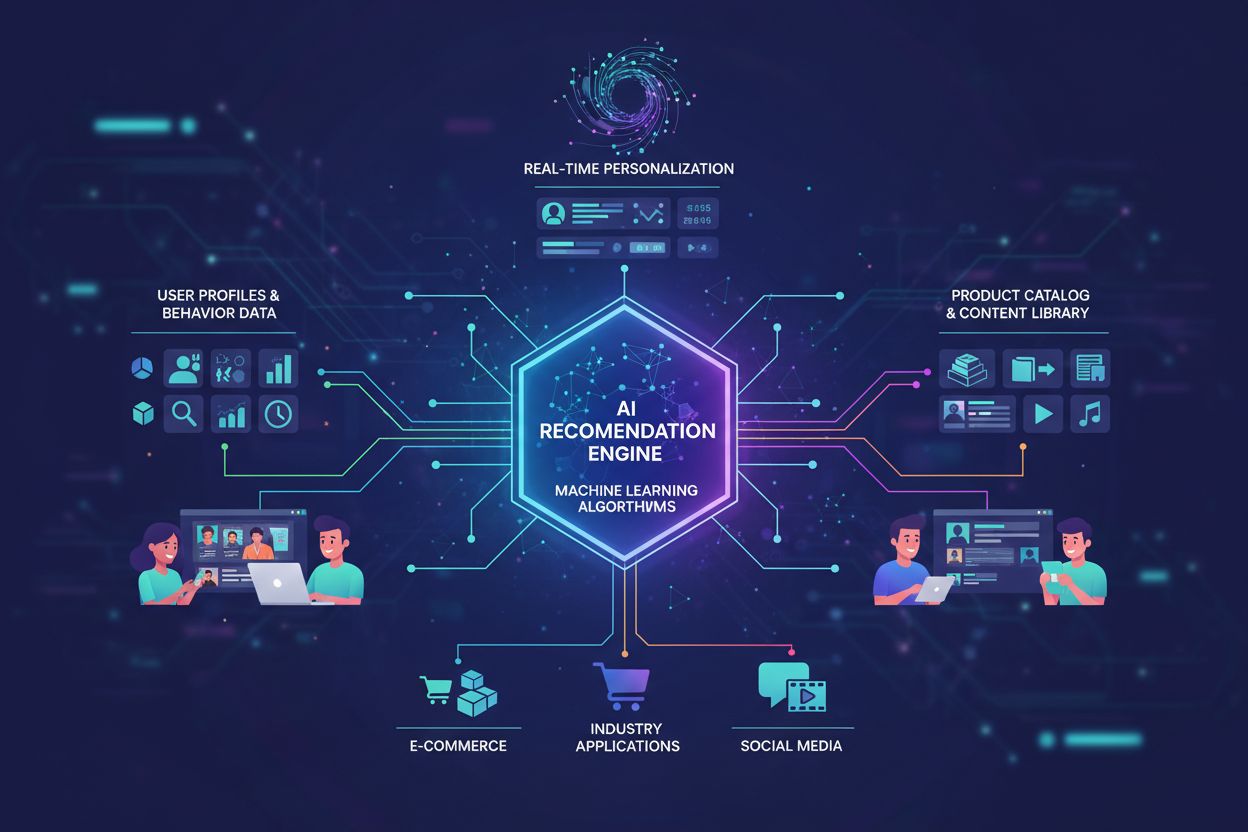

Erfahren Sie, wie KI-gestützte Empfehlungen funktionieren, vom kollaborativen Filtern bis zu hybriden Systemen. Entdecken Sie, wie maschinelles Lernen Produkt- ...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.