Natural Language Understanding in der KI-Suche: Wie KI menschliche Sprache versteht

Erfahren Sie, wie Natural Language Understanding in KI-Suchmaschinen funktioniert. Entdecken Sie, wie NLU ChatGPT, Perplexity und andere KI-Systeme befähigt, Nu...

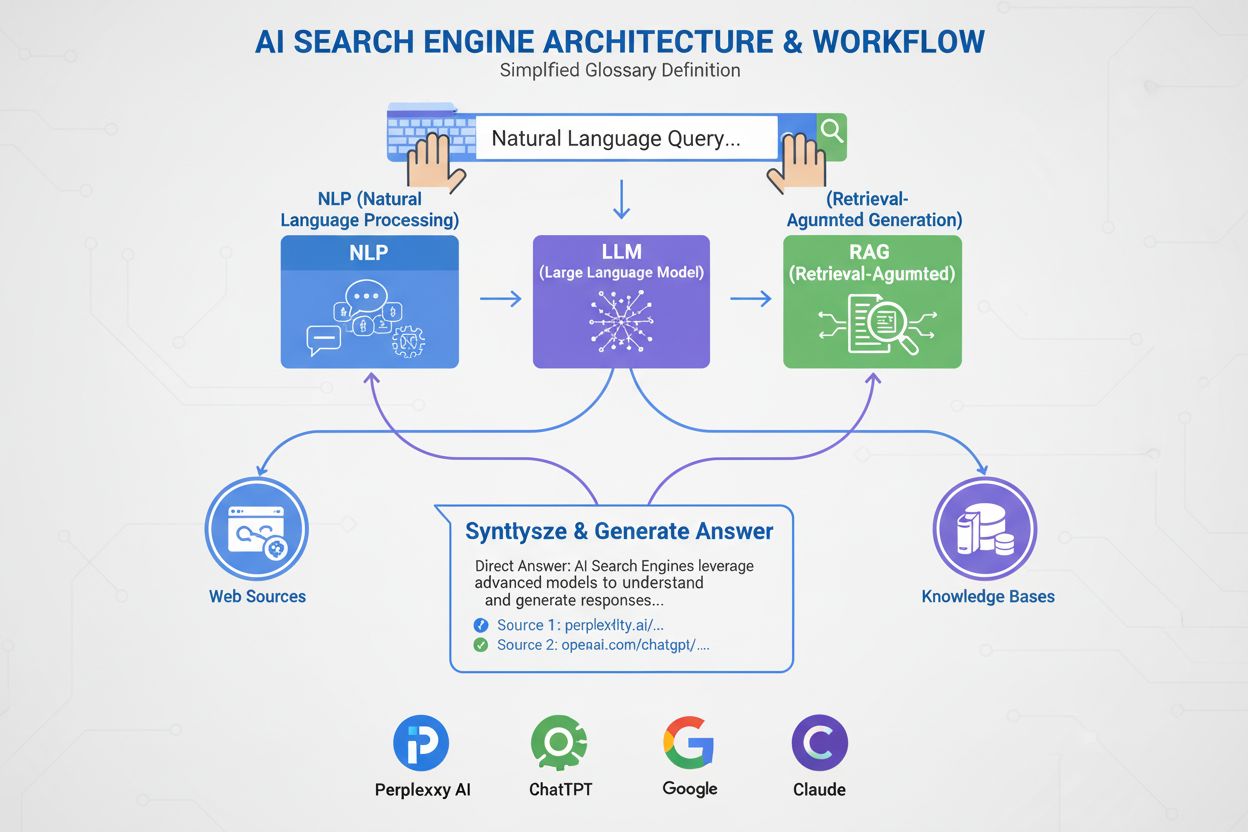

Natural Language Processing (NLP) ist ein Teilgebiet der Künstlichen Intelligenz, das es Computern ermöglicht, menschliche Sprache durch computerlinguistische, maschinelle Lern- und Deep-Learning-Techniken zu verstehen, zu interpretieren und zu generieren. NLP kombiniert statistische Methoden und neuronale Netzwerke, um sowohl Text- als auch Sprachdaten zu verarbeiten und ist damit grundlegend für moderne KI-Anwendungen wie Chatbots, Suchmaschinen und KI-Monitoringsysteme.

Natural Language Processing (NLP) ist ein Teilgebiet der Künstlichen Intelligenz, das es Computern ermöglicht, menschliche Sprache durch computerlinguistische, maschinelle Lern- und Deep-Learning-Techniken zu verstehen, zu interpretieren und zu generieren. NLP kombiniert statistische Methoden und neuronale Netzwerke, um sowohl Text- als auch Sprachdaten zu verarbeiten und ist damit grundlegend für moderne KI-Anwendungen wie Chatbots, Suchmaschinen und KI-Monitoringsysteme.

Natural Language Processing (NLP) ist ein Teilgebiet der Künstlichen Intelligenz und Informatik, das Computern ermöglicht, menschliche Sprache auf sinnvolle Weise zu verstehen, zu interpretieren, zu manipulieren und zu generieren. NLP verbindet Computerlinguistik (regelbasierte Modellierung menschlicher Sprache), maschinelle Lernalgorithmen und Deep-Learning-Neuronale Netzwerke, um sowohl Text- als auch Sprachdaten zu verarbeiten. Die Technologie erlaubt es Maschinen, die semantische Bedeutung von Sprache zu erfassen, Muster in der menschlichen Kommunikation zu erkennen und kohärente Antworten zu generieren, die menschliches Sprachverständnis nachahmen. NLP ist grundlegend für moderne KI-Anwendungen und treibt alles an – von Suchmaschinen und Chatbots über Sprachassistenten bis zu KI-Monitoringsystemen, die Markenerwähnungen auf Plattformen wie ChatGPT, Perplexity und Google AI Overviews verfolgen.

Das Feld des Natural Language Processing entstand in den 1950er Jahren, als Forscher erstmals maschinelle Übersetzung versuchten. Das bahnbrechende Georgetown-IBM-Experiment von 1954 übersetzte erfolgreich 60 russische Sätze ins Englische. Frühere NLP-Systeme waren jedoch stark eingeschränkt, da sie auf starre, regelbasierte Ansätze angewiesen waren und nur auf spezifische, vorprogrammierte Eingaben reagieren konnten. In den 1990er- und frühen 2000er-Jahren gab es bedeutende Fortschritte mit der Entwicklung statistischer NLP-Methoden, die maschinelles Lernen in die Sprachverarbeitung einführten und Anwendungen wie Spam-Filterung, Dokumentklassifizierung und einfache Chatbots ermöglichten. Die eigentliche Revolution erfolgte in den 2010er-Jahren mit dem Aufkommen von Deep-Learning-Modellen und neuronalen Netzwerken, die größere Textmengen analysieren und komplexe Muster in Sprachdaten erkennen konnten. Heute erlebt der NLP-Markt ein explosives Wachstum – Prognosen zufolge wächst der globale NLP-Markt von 59,70 Milliarden US-Dollar im Jahr 2024 auf 439,85 Milliarden US-Dollar bis 2030, was einer durchschnittlichen jährlichen Wachstumsrate (CAGR) von 38,7 % entspricht. Dieses Wachstum verdeutlicht die wachsende Bedeutung von NLP in Unternehmenslösungen, KI-gestützter Automatisierung und Anwendungen im Markenmonitoring.

Natural Language Processing nutzt mehrere grundlegende Techniken, um menschliche Sprache zu zerlegen und zu analysieren. Tokenisierung ist der Prozess der Aufteilung von Text in kleinere Einheiten wie Wörter, Sätze oder Phrasen und macht komplexe Texte für maschinelle Lernmodelle handhabbar. Stemming und Lemmatisierung reduzieren Wörter auf ihre Wortstämme (z. B. werden “laufen”, “läuft” und “lief” zu “lauf”), sodass Systeme verschiedene Formen desselben Wortes erkennen können. Named Entity Recognition (NER) identifiziert und extrahiert spezifische Begriffe wie Personennamen, Orte, Organisationen, Daten und Geldbeträge aus Text – eine entscheidende Fähigkeit für Markenmonitoringsysteme, die Unternehmensnamen in KI-generierten Inhalten erkennen müssen. Sentiment-Analyse bestimmt die emotionale Tonlage oder Meinung in Texten und klassifiziert sie als positiv, negativ oder neutral. Dies ist essenziell, um zu verstehen, wie Marken in KI-Antworten dargestellt werden. Wortarten-Tagging (Part-of-Speech-Tagging) identifiziert die grammatische Rolle jedes Wortes im Satz (Substantiv, Verb, Adjektiv usw.) und hilft Systemen, Satzstruktur und Bedeutung zu erfassen. Textklassifikation ordnet Dokumente oder Textpassagen vordefinierten Kategorien zu, sodass Systeme Informationen organisieren und filtern können. Diese Techniken arbeiten zusammen in NLP-Pipelines, um unstrukturierte Rohtexte in strukturierte, analysierbare Daten zu überführen, die von KI-Systemen verarbeitet und erlernt werden können.

| NLP-Ansatz | Beschreibung | Anwendungsfälle | Vorteile | Einschränkungen |

|---|---|---|---|---|

| Regelbasierte NLP | Nutzt vorprogrammierte Wenn-Dann-Entscheidungsbäume und Grammatikregeln | Einfache Chatbots, grundlegende Textfilterung | Vorhersehbar, transparent, kein Trainingsdatensatz nötig | Nicht skalierbar, kann keine Sprachvariationen verarbeiten, eingeschränkte Flexibilität |

| Statistische NLP | Nutzt maschinelles Lernen zur Mustererkennung in beschrifteten Daten | Spam-Erkennung, Dokumentklassifikation, Wortarten-Tagging | Flexibler als regelbasiert, lernt aus Daten | Benötigt beschriftete Trainingsdaten, Schwierigkeiten mit Kontext und Nuancen |

| Deep Learning NLP | Nutzt neuronale Netzwerke und Transformer-Modelle auf riesigen, unstrukturierten Datensätzen | Chatbots, maschinelle Übersetzung, Content-Generierung, Markenmonitoring | Sehr genau, erkennt komplexe Sprachmuster, lernt Kontext | Benötigt enorme Rechenressourcen, anfällig für Verzerrungen in Trainingsdaten |

| Transformer-Modelle (BERT, GPT) | Nutzt Self-Attention-Mechanismen zur gleichzeitigen Verarbeitung kompletter Sequenzen | Sprachverständnis, Textgenerierung, Sentiment-Analyse, NER | Spitzenleistung, effizientes Training, Kontextverständnis | Rechenintensiv, benötigt große Datensätze, schwer interpretierbar (Black-Box) |

| Überwachtes Lernen | Trainiert auf beschrifteten Input-Output-Paaren | Sentiment-Klassifikation, Named Entity Recognition, Textkategorisierung | Hohe Genauigkeit für spezifische Aufgaben, vorhersehbare Leistung | Benötigt umfangreiche beschriftete Daten, zeitaufwändiger Annotierungsprozess |

| Unüberwachtes Lernen | Erkennt Muster in unbeschrifteten Daten | Themenmodellierung, Clustering, Anomalieerkennung | Keine Beschriftung erforderlich, entdeckt verborgene Muster | Weniger genau, schwerer interpretierbar, erfordert Fachexpertise |

Natural Language Processing arbeitet in einer systematischen Pipeline, die rohe menschliche Sprache in maschinenlesbare Erkenntnisse umwandelt. Der Prozess beginnt mit der Textvorverarbeitung, bei der der Eingabetext bereinigt und standardisiert wird. Tokenisierung teilt Text in einzelne Wörter oder Phrasen, Kleinschreibung konvertiert alle Zeichen in Kleinbuchstaben, sodass “Apple” und “apple” identisch behandelt werden, und Stoppwort-Entfernung filtert häufige Wörter wie “der” oder “ist”, die wenig zum Inhalt beitragen. Stemming und Lemmatisierung reduzieren Wörter auf ihre Stammformen, und Textbereinigung entfernt Satzzeichen, Sonderzeichen und irrelevante Elemente. Nach der Vorverarbeitung folgt die Merkmalextraktion, bei der Text in numerische Repräsentationen umgewandelt wird, die von maschinellen Lernmodellen verarbeitet werden können. Techniken wie Bag of Words und TF-IDF quantifizieren die Bedeutung von Wörtern, während Word Embeddings wie Word2Vec und GloVe Wörter als dichte Vektoren im kontinuierlichen Raum darstellen, um semantische Beziehungen abzubilden. Fortgeschrittene kontextuelle Embeddings berücksichtigen umliegende Wörter und ermöglichen reichhaltigere Repräsentationen. Im nächsten Schritt folgt die Textanalyse, in der Systeme Methoden wie Named Entity Recognition zur Identifikation spezifischer Entitäten, Sentiment-Analyse zur Bestimmung der emotionalen Tonlage, Abhängigkeitsanalyse zum Verständnis grammatischer Beziehungen und Themenmodellierung zur Erkennung zugrundeliegender Themen anwenden. Abschließend nutzt das System die verarbeiteten Daten zum Modelltraining, um maschinelle Lernmodelle zu trainieren, die Muster und Zusammenhänge erkennen. Das trainierte Modell wird dann eingesetzt, um Vorhersagen für neue, unbekannte Daten zu treffen. Diese gesamte Pipeline ermöglicht es Systemen wie AmICited, Markenerwähnungen in KI-generierten Antworten auf Plattformen wie ChatGPT, Perplexity und Google AI Overviews zu erkennen und zu analysieren.

Das Aufkommen von Deep Learning hat das Natural Language Processing grundlegend verändert und die statistischen Methoden um neuronale Netzwerkarchitekturen erweitert, die komplexe Sprachmuster aus riesigen Datensätzen lernen können. Recurrent Neural Networks (RNNs) und Long Short-Term Memory (LSTM)-Netzwerke waren frühe Deep-Learning-Ansätze zur Verarbeitung sequenzieller Daten, stießen jedoch bei langen Abhängigkeiten an ihre Grenzen. Der Durchbruch gelang mit Transformer-Modellen, die den Self-Attention-Mechanismus einführten – einen revolutionären Ansatz, der es Modellen erlaubt, alle Wörter einer Sequenz gleichzeitig zu betrachten und zu bewerten, welche Teile für das Verständnis der Bedeutung am wichtigsten sind. BERT (Bidirectional Encoder Representations from Transformers), entwickelt von Google, bildet die Basis für moderne Suchmaschinen und Aufgaben des Sprachverständnisses, indem es Text bidirektional verarbeitet und Kontext aus beiden Richtungen versteht. GPT (Generative Pre-trained Transformer)-Modelle, einschließlich des weit verbreiteten GPT-4, nutzen eine autoregressive Architektur zur Vorhersage des nächsten Wortes in einer Sequenz und ermöglichen so anspruchsvolle Textgenerierung. Diese Transformer-Modelle können mit selbstüberwachtem Lernen auf riesigen Textdatenbanken ohne manuelle Annotation trainiert werden und sind dadurch äußerst effizient und skalierbar. Foundation Models wie IBMs Granite sind vorgefertigte, kuratierte Modelle, die schnell für verschiedene NLP-Aufgaben wie Content-Generierung, Insight-Extraktion und Named Entity Recognition eingesetzt werden können. Die Stärke dieser Modelle liegt darin, dass sie nuancierte semantische Beziehungen erfassen, Kontext über lange Textpassagen hinweg verstehen und kohärente, kontextgerechte Antworten generieren – Fähigkeiten, die für KI-Monitoring-Plattformen, die Markenerwähnungen in KI-generierten Inhalten verfolgen, unerlässlich sind.

Natural Language Processing ist mittlerweile in nahezu jeder Branche unverzichtbar und ermöglicht es Organisationen, verwertbare Erkenntnisse aus riesigen Mengen unstrukturierter Text- und Sprachdaten zu gewinnen. Im Finanzwesen beschleunigt NLP die Analyse von Finanzberichten, regulatorischen Dokumenten und Pressemitteilungen und unterstützt Händler und Analysten bei schnelleren, fundierteren Entscheidungen. Gesundheitsorganisationen nutzen NLP zur Analyse medizinischer Akten, Fachliteratur und klinischer Notizen, was schnellere Diagnosen, Therapieplanung und Forschung ermöglicht. Versicherungen setzen NLP zur Analyse von Schadensfällen ein, um Betrugsmuster oder Ineffizienzen zu erkennen und Prozesse zu optimieren. Rechtskanzleien verwenden NLP für die automatisierte Dokumentenprüfung, organisieren große Mengen an Fallakten und Präzedenzfällen und reduzieren so Zeit und Kosten erheblich. Kundendienstabteilungen setzen NLP-basierte Chatbots für Routineanfragen ein, sodass menschliche Mitarbeiter sich auf komplexe Anliegen konzentrieren können. Marketing- und Markenmanagement-Teams verlassen sich zunehmend auf NLP für Sentiment-Analyse und Markenmonitoring, indem sie verfolgen, wie ihre Marken in digitalen Kanälen erwähnt und wahrgenommen werden. Besonders relevant für AmICiteds Mission ist, dass NLP KI-Monitoring-Plattformen ermöglicht, Markenerwähnungen in KI-generierten Antworten von Systemen wie ChatGPT, Perplexity, Google AI Overviews und Claude zu erkennen und zu analysieren. Diese Plattformen verwenden Named Entity Recognition, um Markennamen zu identifizieren, Sentiment-Analyse, um den Kontext und Tonfall der Erwähnungen zu verstehen, und Textklassifikation, um die Art der Erwähnung zu kategorisieren. Diese Fähigkeit wird immer wichtiger, da Unternehmen erkennen, dass ihre Markenpräsenz in KI-Antworten den Kundenzugang und das Markenimage im Zeitalter generativer KI direkt beeinflusst.

Trotz bemerkenswerter Fortschritte steht Natural Language Processing vor erheblichen Herausforderungen, die Genauigkeit und Anwendbarkeit begrenzen. Mehrdeutigkeit ist wohl die grundlegendste Schwierigkeit – Wörter und Phrasen haben oft je nach Kontext verschiedene Bedeutungen, und Sätze können unterschiedlich interpretiert werden. Beispiel: “Ich sah den Mann mit dem Fernrohr” kann bedeuten, dass der Sprecher ein Fernrohr benutzte, um den Mann zu sehen, oder dass der Mann selbst ein Fernrohr hatte. Kontextuelles Verständnis bleibt für NLP-Systeme schwierig, insbesondere wenn Bedeutung auf Informationen aus viel früheren Textteilen basiert oder Weltwissen erfordert. Sarkasmus, Redewendungen und Metaphern sind besonders herausfordernd, da ihre wörtliche von der beabsichtigten Bedeutung abweicht und Systeme, die auf Standardsprache trainiert wurden, sie oft falsch interpretieren. Tonfall und emotionale Nuancen sind im reinen Text schwer zu erfassen – dieselben Wörter können je nach Betonung, Ausdruck und Körpersprache völlig unterschiedliche Bedeutungen haben. Verzerrungen im Trainingsdatensatz sind ein zentrales Problem: NLP-Modelle, die mit Webdaten trainiert werden, übernehmen häufig gesellschaftliche Vorurteile und liefern diskriminierende oder ungenaue Ausgaben. Neues Vokabular und sprachlicher Wandel fordern NLP-Systeme ständig heraus, da neue Wörter, Slang und Grammatik schneller entstehen, als Trainingsdaten aktualisiert werden können. Seltene Sprachen und Dialekte verfügen über weniger Trainingsdaten, was zu deutlich schlechterer Performance für deren Sprecher führt. Grammatikfehler, undeutliche Aussprache, Hintergrundgeräusche und nicht standardisierte Sprache in realen Audiodaten stellen zusätzliche Herausforderungen für Spracherkennungssysteme dar. Diese Einschränkungen bedeuten, dass selbst modernste NLP-Systeme Bedeutungen falsch interpretieren können, insbesondere in Grenzfällen oder bei der Verarbeitung informeller, kreativer oder kulturell spezifischer Sprache.

Das Feld des Natural Language Processing entwickelt sich rasant weiter, wobei mehrere neue Trends die Zukunft bestimmen. Multimodales NLP, das Text-, Bild- und Audioverarbeitung kombiniert, ermöglicht ausgefeiltere KI-Systeme, die Inhalte über mehrere Modalitäten hinweg verstehen und generieren können. Few-shot- und Zero-shot-Lernen reduzieren den Bedarf an riesigen beschrifteten Datensätzen, sodass NLP-Modelle neue Aufgaben mit nur wenigen Trainingsbeispielen bewältigen. Retrieval-Augmented Generation (RAG) verbessert die Genauigkeit und Zuverlässigkeit von KI-generierten Inhalten, indem Sprachmodelle mit externen Wissensquellen verbunden werden – so werden Halluzinationen reduziert und Fakten verbessert. Effiziente NLP-Modelle werden entwickelt, um den Rechenaufwand zu senken und fortschrittliche NLP-Funktionen auch kleineren Unternehmen und Edge-Geräten zugänglich zu machen. Erklärbare KI im NLP gewinnt an Bedeutung, da Unternehmen verstehen wollen, wie Modelle Entscheidungen treffen und regulatorische Anforderungen einhalten. Branchenspezifische NLP-Modelle werden für Spezialanwendungen in Gesundheitswesen, Recht, Finanzen und anderen Branchen feinabgestimmt und verbessern die Genauigkeit für spezifische Fachsprache und Terminologie. Ethische KI und Bias-Reduktion rücken zunehmend in den Fokus, da Unternehmen die Bedeutung fairer, unverzerrter NLP-Systeme erkennen. Besonders für das Markenmonitoring wird die Integration von NLP in KI-Monitoring-Plattformen unerlässlich, da Markenpräsenz und -wahrnehmung in KI-generierten Antworten immer stärker den Kundenzugang und die Wettbewerbsposition beeinflussen. Da KI-Systeme wie ChatGPT, Perplexity und Google AI Overviews zu primären Informationsquellen für Verbraucher werden, wird die Fähigkeit, zu überwachen und zu verstehen, wie Marken dort erscheinen – unterstützt durch ausgereifte NLP-Technologien – zu einem zentralen Bestandteil moderner Marketing- und Markenstrategien.

Natural Language Processing ist die technologische Grundlage, die Plattformen wie AmICited ermöglicht, Markenerwähnungen in KI-Systemen zu verfolgen. Wenn Nutzer ChatGPT, Perplexity, Google AI Overviews oder Claude abfragen, generieren diese Systeme Antworten mit großen Sprachmodellen, die auf fortschrittlichen NLP-Technologien basieren. AmICited nutzt NLP-Algorithmen, um diese KI-generierten Antworten zu analysieren, erkennt, wann Marken erwähnt werden, extrahiert den Kontext dieser Erwähnungen und analysiert die geäußerte Stimmung. Named Entity Recognition identifiziert Markennamen und verwandte Begriffe, Sentiment-Analyse bestimmt, ob Erwähnungen positiv, negativ oder neutral sind, und Textklassifikation kategorisiert die Art der Erwähnung (Produktempfehlung, Vergleich, Kritik etc.). Diese Fähigkeit verschafft Unternehmen entscheidende Sichtbarkeit ihrer KI-Präsenz – also wie ihre Marke in KI-Systemen, die zunehmend als primäre Informationsquelle für Verbraucher dienen, entdeckt und diskutiert wird. Während der NLP-Markt weiter rasant wächst und Prognosen zufolge bis 2030 auf 439,85 Milliarden US-Dollar ansteigt, wird die Bedeutung von NLP-basiertem Markenmonitoring weiter zunehmen. Es ist daher für Unternehmen unerlässlich, diese Technologien zu verstehen und zu nutzen, um ihre Markenreputation in der KI-getriebenen Zukunft zu schützen und zu stärken.

Natural Language Understanding (NLU) ist ein Teilbereich von NLP, der sich speziell auf die Analyse und das Verständnis der Bedeutung von Sätzen und Texten konzentriert. Während NLP das breitere Feld der Verarbeitung menschlicher Sprache einschließlich Generierung und Manipulation umfasst, fokussiert sich NLU auf das Extrahieren semantischer Bedeutung und Intention. NLU ermöglicht es Systemen, Kontext, Nuancen und die tatsächliche Absicht hinter Benutzeranfragen zu verstehen und ist daher essenziell für Anwendungen wie Chatbots und Sprachassistenten, die erfassen müssen, was Benutzer wirklich meinen, statt nur Wörter zu verarbeiten.

NLP ist entscheidend für KI-Monitoring-Plattformen, da es Systemen ermöglicht, Marken-Erwähnungen in KI-generierten Antworten zu erkennen und zu analysieren. Mit Techniken wie Named Entity Recognition (NER), Sentiment-Analyse und Textklassifikation können NLP-Algorithmen feststellen, wann eine Marke erwähnt wird, den Kontext dieser Erwähnung extrahieren und die geäußerte Stimmung bestimmen. So können Plattformen wie AmICited verfolgen, wie Marken in KI-Antworten von ChatGPT, Perplexity, Google AI Overviews und Claude erscheinen und bieten wichtige Einblicke in die Markenpräsenz in KI-generierten Inhalten.

Moderne NLP-Anwendungen basieren auf mehreren Schlüsseltechniken, darunter Tokenisierung (Aufteilung von Text in Wörter/Phrasen), Sentiment-Analyse (Bestimmung der emotionalen Tonlage), Named Entity Recognition (Erkennung von Personen, Orten, Organisationen) und Textklassifikation (Kategorisierung von Inhalten). Fortgeschrittene Techniken umfassen Word Embeddings (Darstellung von Wörtern als numerische Vektoren), Transformer-Modelle wie BERT und GPT mit Attention-Mechanismen sowie Sequenz-zu-Sequenz-Modelle für Übersetzungen. Diese Techniken arbeiten in Deep-Learning-Architekturen zusammen, damit KI-Systeme Kontext verstehen, kohärente Antworten generieren und komplexe Sprachaufgaben erfüllen können.

Transformer-Modelle haben das NLP revolutioniert, indem sie den Self-Attention-Mechanismus eingeführt haben. Dieser ermöglicht es Modellen, ganze Sequenzen gleichzeitig zu verarbeiten und Beziehungen zwischen weit entfernten Wörtern zu verstehen. Modelle wie BERT (Bidirectional Encoder Representations from Transformers) und GPT (Generative Pre-trained Transformer) nutzen die Transformer-Architektur, um Spitzenleistungen beim Sprachverständnis und in der Generierung zu erzielen. Transformer können mit selbstüberwachtem Lernen auf riesigen Datensätzen trainiert werden und sind dadurch äußerst effizient und skalierbar für verschiedene NLP-Aufgaben von Übersetzung bis Content-Erstellung.

NLP steht vor mehreren bedeutenden Herausforderungen, darunter Mehrdeutigkeit in der Sprache (Wörter mit mehreren Bedeutungen), Verständnis von Kontext und Nuancen, Umgang mit Sarkasmus und Redewendungen, grammatikalische Abweichungen und Fehler sowie die Verarbeitung mehrerer Sprachen. Zusätzlich haben NLP-Systeme Schwierigkeiten mit Verzerrungen im Trainingsdatensatz, seltenem oder neuem Vokabular, Interpretation von Tonfall und kulturellem Kontext. Diese Herausforderungen führen dazu, dass selbst modernste NLP-Modelle Bedeutung falsch interpretieren können, insbesondere bei informeller Sprache, Dialekten oder fachspezifischem Vokabular.

Die NLP-Vorverarbeitung wandelt Rohtext in ein Format um, das von Machine-Learning-Modellen effektiv verarbeitet werden kann. Wichtige Schritte sind Tokenisierung (Aufteilung des Textes in handhabbare Einheiten), Kleinschreibung (Standardisierung), Entfernung von Stoppwörtern (Filterung häufiger Wörter), Stemming und Lemmatisierung (Reduktion auf Wortstämme) sowie Entfernung von Satzzeichen und Sonderzeichen. Diese Schritte reduzieren Störfaktoren, standardisieren die Eingabe und helfen Modellen, sich auf bedeutungsvolle sprachliche Muster zu konzentrieren, was die Genauigkeit und Effizienz nachgelagerter NLP-Aufgaben und des Modelltrainings deutlich verbessert.

Überwachte NLP-Methoden trainieren Modelle mit beschrifteten Datensätzen, bei denen Eingaben und gewünschte Ausgaben bekannt sind. Dadurch sind sie besonders genau für spezifische Aufgaben wie Sentiment-Klassifikation oder Named Entity Recognition. Unüberwachte NLP-Methoden arbeiten mit unbeschrifteten Daten und entdecken eigenständig Muster, was für Aufgaben wie Topic Modeling oder Clustering nützlich ist. Semi-supervised Ansätze kombinieren beide Methoden und nutzen kleine beschriftete mit größeren unbeschrifteten Datensätzen. Die Wahl hängt von der Datenverfügbarkeit, den Aufgabenanforderungen und dem Bedarf an spezifischen oder allgemeinen Sprachmodellen ab.

Beginnen Sie zu verfolgen, wie KI-Chatbots Ihre Marke auf ChatGPT, Perplexity und anderen Plattformen erwähnen. Erhalten Sie umsetzbare Erkenntnisse zur Verbesserung Ihrer KI-Präsenz.

Erfahren Sie, wie Natural Language Understanding in KI-Suchmaschinen funktioniert. Entdecken Sie, wie NLU ChatGPT, Perplexity und andere KI-Systeme befähigt, Nu...

Erfahren Sie, was KI-Suchmaschinen sind, wie sie sich von traditionellen Suchmaschinen unterscheiden und welche Auswirkungen sie auf die Sichtbarkeit von Marken...

Erfahren Sie mehr über BERT, seine Architektur, Anwendungsfälle und aktuelle Relevanz. Verstehen Sie, wie BERT mit modernen Alternativen verglichen wird und war...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.