Cuando los rankings SEO no equivalen a visibilidad en IA: la desconexión

Descubre por qué los altos rankings en Google no garantizan visibilidad en IA. Conoce la brecha entre SEO y citas de IA, y cómo optimizar para ambos canales de ...

El grado en que las plataformas de IA revelan cómo seleccionan y clasifican las fuentes al generar respuestas. La transparencia en el ranking de la IA se refiere a la visibilidad de los algoritmos y criterios que determinan qué fuentes aparecen en las respuestas generadas por IA, distinguiéndose del ranking tradicional de motores de búsqueda. Esta transparencia es fundamental para creadores de contenido, editores y usuarios que necesitan entender cómo se selecciona y prioriza la información. Sin transparencia, los usuarios no pueden verificar la credibilidad de las fuentes ni comprender posibles sesgos en el contenido generado por IA.

El grado en que las plataformas de IA revelan cómo seleccionan y clasifican las fuentes al generar respuestas. La transparencia en el ranking de la IA se refiere a la visibilidad de los algoritmos y criterios que determinan qué fuentes aparecen en las respuestas generadas por IA, distinguiéndose del ranking tradicional de motores de búsqueda. Esta transparencia es fundamental para creadores de contenido, editores y usuarios que necesitan entender cómo se selecciona y prioriza la información. Sin transparencia, los usuarios no pueden verificar la credibilidad de las fuentes ni comprender posibles sesgos en el contenido generado por IA.

La transparencia en el ranking de la IA se refiere a la divulgación de cómo los sistemas de inteligencia artificial seleccionan, priorizan y presentan fuentes al generar respuestas a las consultas de los usuarios. A diferencia de los motores de búsqueda tradicionales que muestran listas clasificadas de enlaces, las plataformas modernas de IA como Perplexity, ChatGPT y AI Overviews de Google integran la selección de fuentes en su proceso de generación de respuestas, haciendo que los criterios de ranking sean en gran parte invisibles para los usuarios. Esta opacidad crea una brecha crítica entre lo que los usuarios ven (una respuesta sintetizada) y cómo se construyó esa respuesta (qué fuentes se eligieron, ponderaron y citaron). Para los creadores de contenido y editores, esta falta de transparencia significa que su visibilidad depende de algoritmos que no pueden entender ni influir mediante métodos tradicionales de optimización. La distinción con la transparencia de los motores de búsqueda tradicionales es significativa: mientras Google publica factores generales de ranking y directrices de calidad, las plataformas de IA suelen tratar sus mecanismos de selección de fuentes como secretos comerciales propietarios. Los principales afectados incluyen creadores de contenido que buscan visibilidad, editores preocupados por la atribución de tráfico, gestores de marca que monitorean la reputación, investigadores que verifican fuentes de información y usuarios que necesitan comprender la credibilidad de las respuestas generadas por IA. Comprender la transparencia en el ranking de la IA se ha vuelto esencial para cualquiera que produzca, distribuya o dependa de contenido digital en un entorno informativo cada vez más mediado por IA.

Las plataformas de IA emplean sistemas de Generación Aumentada por Recuperación (RAG) que combinan modelos de lenguaje con recuperación de información en tiempo real para fundamentar las respuestas en fuentes reales en lugar de depender únicamente de datos de entrenamiento. El proceso RAG implica tres etapas principales: recuperación (encontrar documentos relevantes), clasificación (ordenar fuentes por relevancia) y generación (sintetizar información manteniendo las citaciones). Diferentes plataformas implementan enfoques de ranking distintos: Perplexity prioriza la autoridad y actualidad de la fuente, AI Overviews de Google enfatiza la relevancia temática y las señales E-E-A-T (Experiencia, Pericia, Autoridad y Confiabilidad), mientras que ChatGPT Search equilibra la calidad de la fuente con la exhaustividad de la respuesta. Los factores que influyen en la selección de fuentes suelen incluir autoridad de dominio (reputación establecida y perfil de enlaces), actualidad del contenido (frescura de la información), relevancia temática (alineación semántica con la consulta), señales de interacción (métricas de interacción del usuario) y frecuencia de citación (con qué frecuencia las fuentes son referenciadas por otros sitios autorizados). Los sistemas de IA ponderan estas señales de manera diferente según la intención de la consulta: las consultas fácticas pueden priorizar la autoridad y actualidad, mientras que las consultas basadas en opiniones pueden enfatizar perspectivas diversas y señales de interacción. Los algoritmos de ranking permanecen en gran medida no revelados, aunque la documentación de las plataformas proporciona una visión limitada sobre sus mecanismos de ponderación.

| Plataforma | Transparencia en la Citación | Criterios de Selección de Fuentes | Divulgación del Algoritmo de Ranking | Control del Usuario |

|---|---|---|---|---|

| Perplexity | Alta - citaciones en línea con enlaces | Autoridad, actualidad, relevancia, experiencia temática | Moderada - alguna documentación | Media - opciones de filtrado de fuentes |

| Google AI Overviews | Media - fuentes citadas listadas | E-E-A-T, relevancia temática, frescura, interacción | Baja - divulgación mínima | Baja - personalización limitada |

| ChatGPT Search | Media - fuentes listadas por separado | Calidad, relevancia, exhaustividad, autoridad | Baja - algoritmo propietario | Baja - sin personalización del ranking |

| Brave Leo | Media - atribución de fuentes | Fuentes que respetan la privacidad, relevancia, autoridad | Baja - opacidad centrada en privacidad | Media - opciones de selección de fuentes |

| Consensus | Muy Alta - enfoque académico con métricas | Conteo de citaciones, estado de revisión por pares, actualidad, relevancia de campo | Alta - estándares académicos transparentes | Alta - filtro por tipo y calidad de estudio |

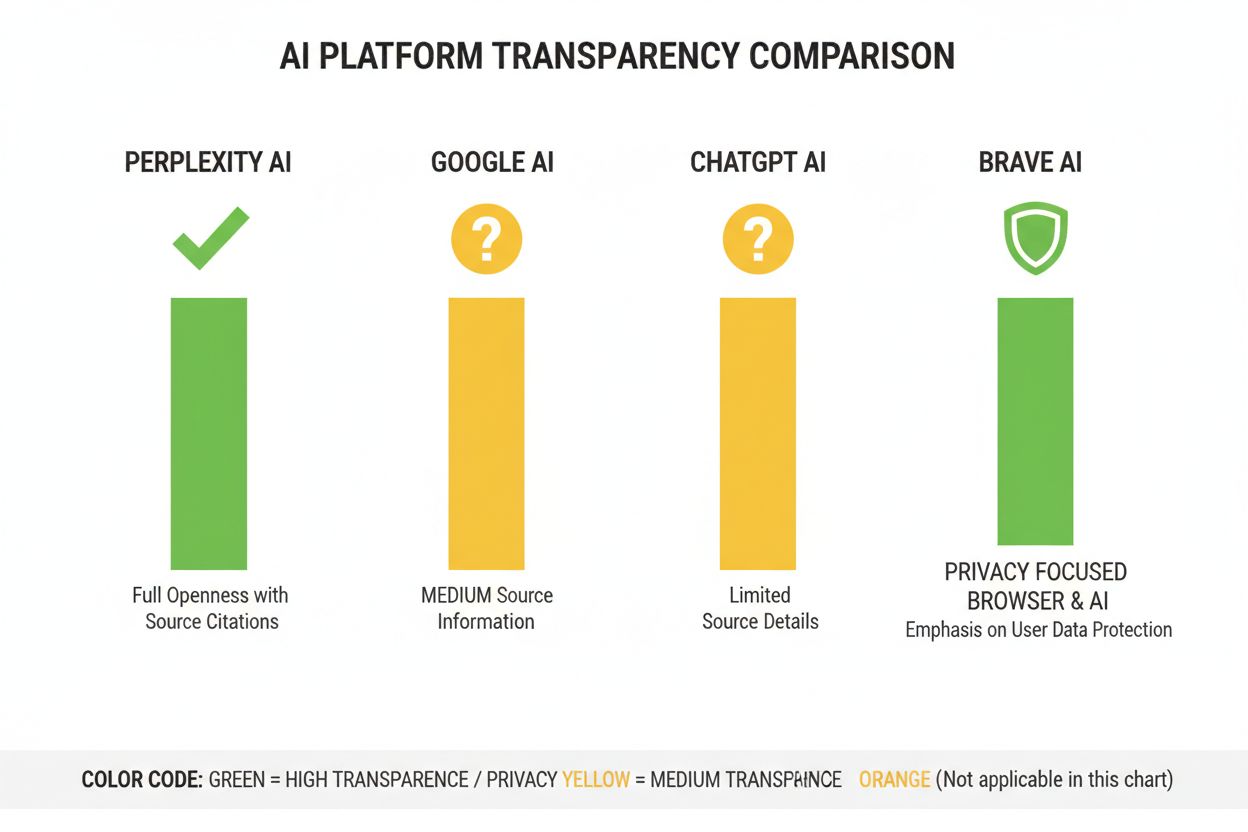

La industria de la IA carece de prácticas estandarizadas de divulgación sobre el funcionamiento de los sistemas de ranking, lo que crea un panorama fragmentado donde cada plataforma determina su propio nivel de transparencia. ChatGPT Search de OpenAI proporciona una explicación mínima de la selección de fuentes, los sistemas de IA de Meta ofrecen documentación limitada y AI Overviews de Google divulga más que los competidores pero aún retiene detalles críticos del algoritmo. Las plataformas se resisten a la divulgación total citando ventajas competitivas, preocupaciones de propiedad intelectual y la complejidad de explicar sistemas de aprendizaje automático a audiencias generales; sin embargo, esta opacidad impide la auditoría externa y la rendición de cuentas. El problema de “lavado de fuentes” surge cuando los sistemas de IA citan fuentes que a su vez agregan o reescriben el contenido original, oscureciendo el verdadero origen de la información y potencialmente amplificando la desinformación a través de múltiples capas de síntesis. La presión regulatoria va en aumento: la Ley de IA de la UE exige que los sistemas de IA de alto riesgo mantengan documentación sobre datos de entrenamiento y procesos de toma de decisiones, mientras que la Política de Responsabilidad de IA de la NTIA pide a las empresas que revelen capacidades, limitaciones y casos de uso apropiados de los sistemas de IA. Fallos específicos de divulgación incluyen los problemas iniciales de Perplexity con la atribución adecuada (posteriormente mejorados), la explicación vaga de Google sobre cómo AI Overviews selecciona las fuentes y la limitada transparencia de ChatGPT sobre por qué ciertas fuentes aparecen en las respuestas y otras no. La ausencia de métricas estandarizadas para medir la transparencia dificulta que usuarios y reguladores comparen las plataformas objetivamente.

La opacidad de los sistemas de ranking de IA crea desafíos significativos de visibilidad para los creadores de contenido, ya que las estrategias tradicionales de SEO diseñadas para motores de búsqueda no se traducen directamente en optimización para plataformas de IA. Los editores no pueden comprender fácilmente por qué su contenido aparece en algunas respuestas de IA pero no en otras, lo que hace imposible desarrollar estrategias dirigidas para mejorar la visibilidad en respuestas generadas por IA. Surge el sesgo de citación cuando los sistemas de IA favorecen desproporcionadamente ciertas fuentes—medios establecidos, instituciones académicas o sitios web de alto tráfico—mientras marginan a editores pequeños, creadores independientes y expertos de nicho que pueden tener información igualmente valiosa. Los editores pequeños enfrentan desventajas particulares porque los sistemas de ranking de IA suelen ponderar fuertemente la autoridad de dominio, y los sitios nuevos o especializados carecen del perfil de enlaces y reconocimiento de marca que poseen los medios establecidos. Investigaciones de Search Engine Land indican que AI Overviews ha reducido la tasa de clics hacia los resultados de búsqueda tradicionales entre un 18% y un 64% según el tipo de consulta, concentrando el tráfico entre las pocas fuentes citadas en las respuestas de IA. La distinción entre SEO (Optimización para Motores de Búsqueda) y GEO (Optimización para Motores Generativos) se vuelve crítica: mientras que el SEO se enfoca en el ranking en la búsqueda tradicional, el GEO requiere comprender y optimizar para los criterios de selección de las plataformas de IA, que siguen siendo en gran parte opacos. Los creadores de contenido necesitan herramientas como AmICited.com para monitorear dónde aparece su contenido en las respuestas de IA, rastrear la frecuencia de citación y comprender su visibilidad en diferentes plataformas de IA.

La industria de la IA ha desarrollado varios marcos para documentar y divulgar el comportamiento del sistema, aunque la adopción sigue siendo inconsistente entre plataformas. Las Model Cards proporcionan documentación estandarizada sobre el rendimiento de modelos de aprendizaje automático, casos de uso previstos, limitaciones y análisis de sesgos—similares a etiquetas nutricionales para sistemas de IA. Las Datasheets for Datasets documentan la composición, metodología de recolección y posibles sesgos en los datos de entrenamiento, abordando el principio de que los sistemas de IA solo son tan buenos como su información de entrenamiento. Las System Cards adoptan un enfoque más amplio, documentando el comportamiento del sistema de extremo a extremo, incluidas las interacciones de componentes, posibles modos de falla y desempeño real en diferentes grupos de usuarios. La Política de Responsabilidad de IA de la NTIA recomienda que las empresas mantengan documentación detallada del desarrollo, pruebas y despliegue de sistemas de IA, con énfasis especial en aplicaciones de alto riesgo que afectan el bienestar público. La Ley de IA de la UE obliga a que los sistemas de alto riesgo mantengan documentación técnica, registros de datos de entrenamiento y logs de desempeño, con requisitos de informes de transparencia y notificación al usuario. Las mejores prácticas de la industria incluyen cada vez más:

Perplexity se ha posicionado como la plataforma de IA más transparente en cuanto a citaciones, mostrando enlaces de fuentes en línea a lo largo de las respuestas y permitiendo a los usuarios ver exactamente qué fuentes contribuyeron a cada afirmación. La plataforma ofrece documentación relativamente clara de su enfoque de ranking, enfatizando la autoridad de la fuente, la experiencia temática y la actualidad del contenido, aunque la ponderación precisa de estos factores sigue siendo propietaria. AI Overviews de Google ofrece transparencia moderada al listar las fuentes citadas al final de las respuestas, pero proporciona poca explicación de por qué se seleccionaron ciertas fuentes sobre otras o cómo el algoritmo de ranking pondera las diferentes señales. La documentación de Google enfatiza los principios E-E-A-T pero no revela completamente cómo se miden o ponderan en el proceso de ranking de la IA. ChatGPT Search de OpenAI representa un punto intermedio, mostrando las fuentes por separado del texto de respuesta y permitiendo a los usuarios acceder al contenido original, aunque ofrece explicaciones mínimas sobre los criterios de selección de fuentes o la metodología de ranking. Brave Leo prioriza la transparencia enfocada en la privacidad, revelando que utiliza fuentes que respetan la privacidad y no rastrea las consultas del usuario, aunque esto implica una explicación menos detallada de los mecanismos de ranking. Consensus se destaca al centrarse exclusivamente en investigación académica, proporcionando alta transparencia mediante métricas de citación, estado de revisión por pares e indicadores de calidad del estudio—lo que la convierte en la plataforma más transparente algorítmicamente para consultas orientadas a la investigación. El control del usuario varía significativamente: Perplexity permite el filtrado de fuentes, Consensus permite filtrar por tipo y calidad de estudio, mientras que Google y ChatGPT ofrecen una personalización mínima de las preferencias de ranking. La variación en los enfoques de transparencia refleja diferentes modelos de negocio y audiencias objetivo, con plataformas orientadas a la investigación priorizando la divulgación, mientras que las plataformas de consumo equilibran la transparencia con preocupaciones propietarias.

La confianza y credibilidad dependen fundamentalmente de que los usuarios comprendan cómo les llega la información—cuando los sistemas de IA ocultan sus fuentes o lógica de ranking, los usuarios no pueden verificar de forma independiente las afirmaciones ni evaluar la fiabilidad de las fuentes. La transparencia permite la verificación y comprobación de hechos, permitiendo a investigadores, periodistas y usuarios informados rastrear afirmaciones hasta las fuentes originales y evaluar su precisión y contexto. Los beneficios de la prevención de desinformación y sesgos son sustanciales: cuando los algoritmos de ranking son visibles, los investigadores pueden identificar sesgos sistemáticos (como favorecer ciertas perspectivas políticas o intereses comerciales) y las plataformas pueden ser responsables por amplificar información falsa. La rendición de cuentas algorítmica representa un derecho fundamental del usuario en sociedades democráticas—las personas merecen entender cómo los sistemas que moldean su entorno informativo toman decisiones, particularmente cuando esos sistemas influyen en la opinión pública, decisiones de compra y acceso al conocimiento. Para el trabajo académico y de investigación, la transparencia es esencial porque los académicos deben entender la selección de fuentes para contextualizar adecuadamente los resúmenes generados por IA y asegurarse de no depender inadvertidamente de conjuntos de fuentes sesgadas o incompletas. Las implicaciones comerciales para los creadores de contenido son profundas: sin comprender los factores de ranking, los editores no pueden optimizar su estrategia de contenido, los creadores pequeños no pueden competir en igualdad de condiciones con los medios establecidos y todo el ecosistema se vuelve menos meritocrático. La transparencia también protege a los usuarios de la manipulación—cuando los criterios de ranking están ocultos, actores maliciosos pueden explotar vulnerabilidades desconocidas para promover contenido engañoso, mientras que los sistemas transparentes pueden ser auditados y mejorados.

Las tendencias regulatorias están impulsando hacia la transparencia obligatoria: la implementación de la Ley de IA de la UE en 2025-2026 requerirá documentación y divulgación detallada para los sistemas de IA de alto riesgo, mientras que regulaciones similares están surgiendo en el Reino Unido, California y otras jurisdicciones. La industria avanza hacia la estandarización de las prácticas de transparencia, con organizaciones como Partnership on AI e instituciones académicas desarrollando marcos comunes para documentar y divulgar el comportamiento de los sistemas de IA. La demanda de transparencia por parte de los usuarios está aumentando a medida que crece la conciencia sobre el papel de la IA en la distribución de información—las encuestas indican que más del 70% de los usuarios quieren entender cómo los sistemas de IA seleccionan fuentes y clasifican la información. Las innovaciones técnicas en IA explicable (XAI) hacen cada vez más factible proporcionar explicaciones detalladas de las decisiones de ranking sin exponer completamente los algoritmos propietarios, utilizando técnicas como LIME (Explicaciones Locales Model-agnostic) y SHAP (Explicaciones Aditivas de Shapley). Herramientas de monitoreo como AmICited.com serán cada vez más importantes a medida que las plataformas implementen medidas de transparencia, ayudando a creadores de contenido y editores a rastrear su visibilidad en múltiples sistemas de IA y comprender cómo los cambios en el ranking afectan su alcance. La convergencia de requisitos regulatorios, expectativas de usuarios y capacidades técnicas sugiere que 2025-2026 serán años clave para la transparencia en el ranking de la IA, con plataformas que probablemente adopten prácticas de divulgación más estandarizadas, implementen mejores controles de usuario sobre la selección de fuentes y proporcionen explicaciones más claras de la lógica de ranking. El panorama futuro probablemente contará con una transparencia por niveles—plataformas académicas y de investigación liderando con alta divulgación, plataformas de consumo ofreciendo transparencia moderada con opciones de personalización de usuario y el cumplimiento normativo convirtiéndose en una expectativa mínima en toda la industria.

La transparencia en el ranking de la IA se refiere a cuán abiertamente las plataformas de IA revelan sus algoritmos para seleccionar y clasificar fuentes en las respuestas generadas. Es importante porque los usuarios necesitan entender la credibilidad de las fuentes, los creadores de contenido deben optimizar su visibilidad en IA y los investigadores deben verificar las fuentes de información. Sin transparencia, los sistemas de IA pueden amplificar la desinformación y crear ventajas injustas para medios establecidos frente a editores más pequeños.

Las plataformas de IA utilizan sistemas de Generación Aumentada por Recuperación (RAG) que combinan modelos de lenguaje con recuperación de información en tiempo real. Clasifican fuentes según factores como autoridad de dominio, actualidad del contenido, relevancia temática, señales de interacción y frecuencia de citación. Sin embargo, la ponderación exacta de estos factores sigue siendo en gran medida propietaria y no revelada por la mayoría de las plataformas.

El SEO tradicional se centra en clasificar en listas de enlaces de motores de búsqueda, donde Google publica factores generales de ranking. La transparencia en el ranking de la IA trata sobre cómo las plataformas de IA seleccionan fuentes para respuestas sintetizadas, lo cual implica criterios distintos y en gran parte no revelados. Mientras que las estrategias SEO están bien documentadas, los factores de ranking de IA permanecen mayormente opacos.

Puedes hacer clic en las fuentes originales para verificar las afirmaciones en su contexto completo, comprobar si las fuentes provienen de dominios autorizados, buscar estado de revisión por pares (especialmente en contenido académico) y contrastar la información entre múltiples fuentes. Herramientas como AmICited ayudan a rastrear qué fuentes aparecen en respuestas de IA y con qué frecuencia se cita tu contenido.

Consensus lidera en transparencia al enfocarse exclusivamente en investigación académica revisada por pares con métricas de citación claras. Perplexity proporciona citaciones en línea y documentación moderada de factores de ranking. AI Overviews de Google ofrecen transparencia media, mientras que ChatGPT Search y Brave Leo brindan una divulgación limitada de sus algoritmos de ranking.

Las model cards son documentación estandarizada sobre el desempeño del sistema de IA, usos previstos, limitaciones y análisis de sesgos. Las datasheets documentan la composición de los datos de entrenamiento, métodos de recolección y posibles sesgos. Las system cards describen el comportamiento del sistema de extremo a extremo. Estas herramientas ayudan a hacer los sistemas de IA más transparentes y comparables, similar a las etiquetas nutricionales en los alimentos.

La Ley de IA de la UE requiere que los sistemas de IA de alto riesgo mantengan documentación técnica detallada, registros de datos de entrenamiento y logs de desempeño. Obliga a informes de transparencia y notificación al usuario sobre el uso de sistemas de IA. Estos requisitos están impulsando a las plataformas de IA a una mayor divulgación de mecanismos de ranking y criterios de selección de fuentes.

AmICited.com es una plataforma de monitoreo de citaciones de IA que rastrea cómo sistemas de IA como Perplexity, Google AI Overviews y ChatGPT citan tu marca y contenido. Proporciona visibilidad sobre qué fuentes aparecen en respuestas de IA, con qué frecuencia se cita tu contenido y cómo se compara tu transparencia en el ranking entre diferentes plataformas de IA.

Rastrea cómo plataformas de IA como Perplexity, Google AI Overviews y ChatGPT citan tu contenido. Comprende tu transparencia en el ranking y optimiza tu visibilidad en motores de búsqueda de IA con AmICited.

Descubre por qué los altos rankings en Google no garantizan visibilidad en IA. Conoce la brecha entre SEO y citas de IA, y cómo optimizar para ambos canales de ...

Aprende a conectar las métricas de visibilidad de la IA con resultados empresariales medibles. Haz seguimiento de menciones de marca en ChatGPT, Perplexity y Go...

Aprende cómo comenzar con la visibilidad de IA en solo 30 días. Una guía práctica para principiantes que cubre descubrimiento, optimización, estrategia de conte...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.