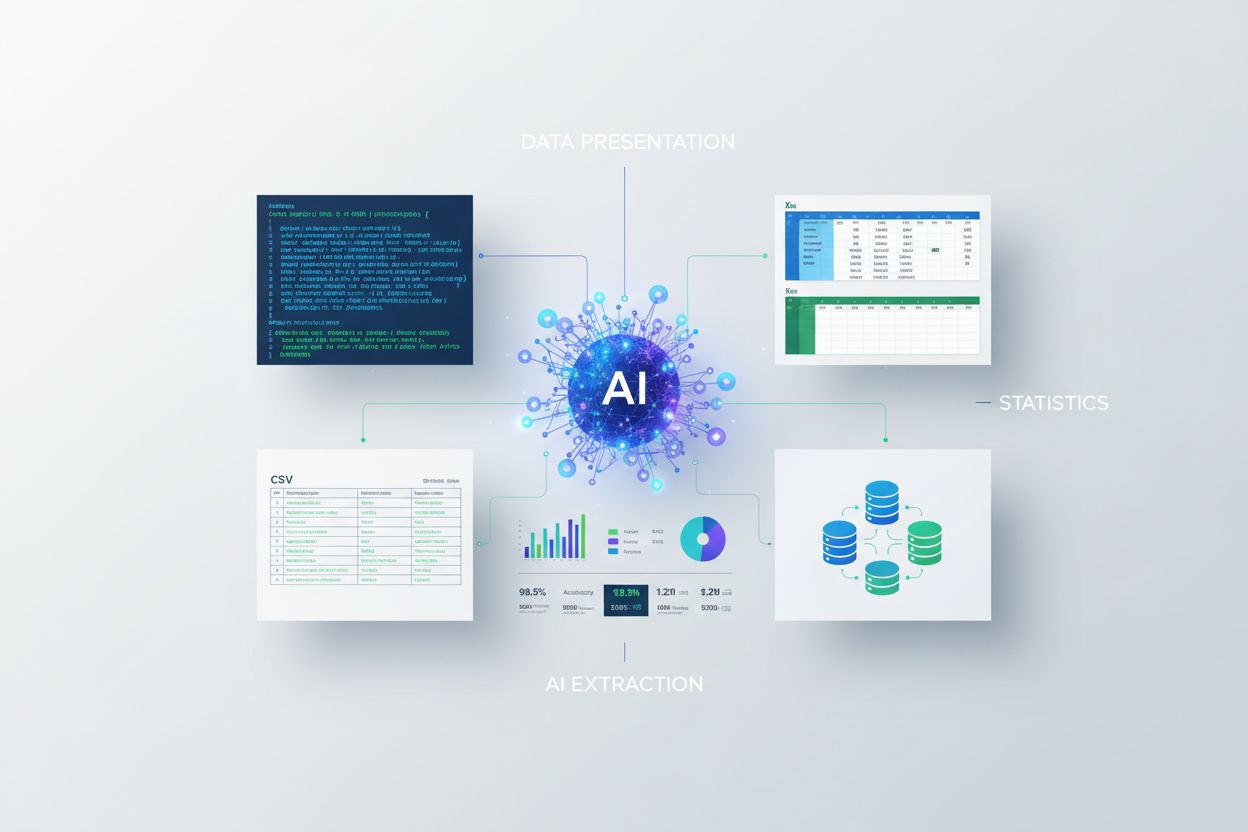

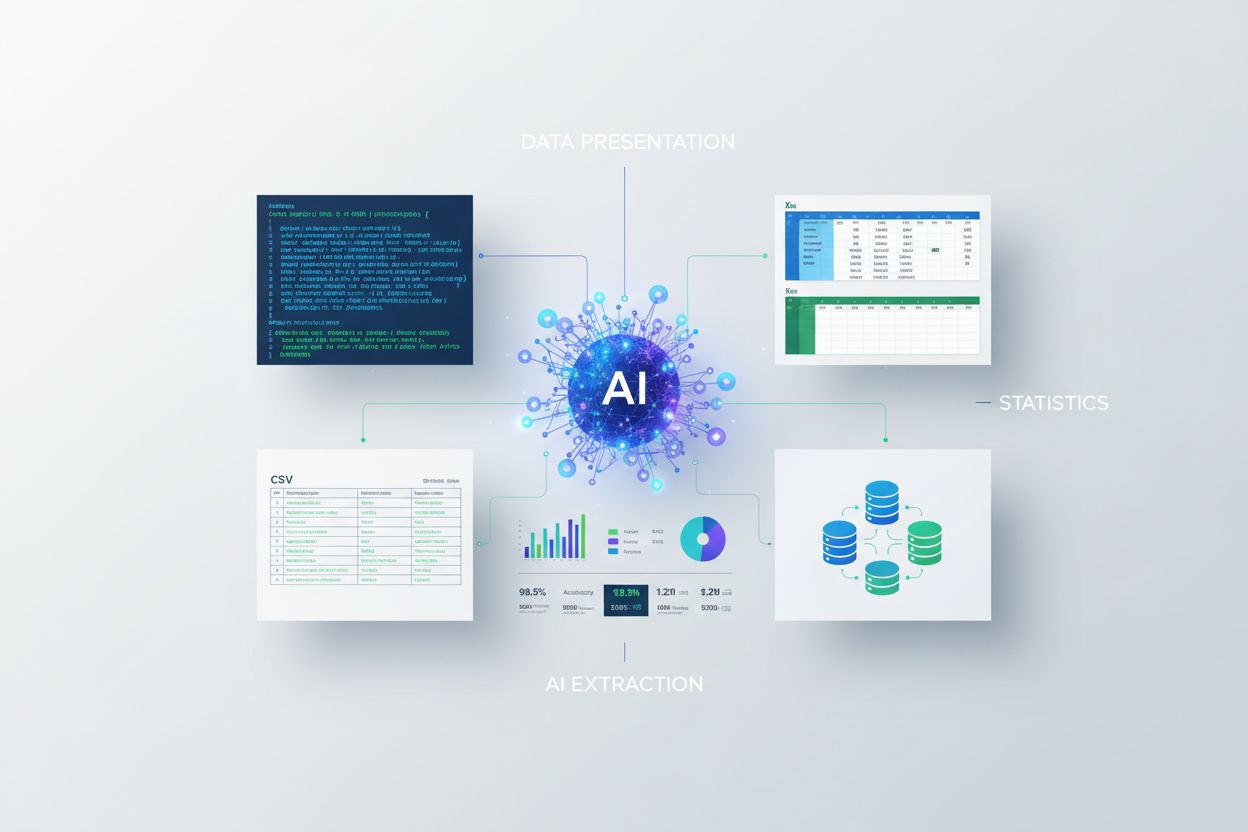

Présentation des statistiques pour l’extraction par IA

Découvrez comment présenter des statistiques pour l'extraction par IA. Découvrez les meilleures pratiques de formatage des données, JSON vs CSV, et comment prép...

Découvrez pourquoi la qualité des données est plus importante que la quantité pour les modèles d’IA. Apprenez des stratégies d’allocation des ressources, les implications sur les coûts et des cadres pratiques pour optimiser votre investissement dans les données d’entraînement IA.

La croyance classique en apprentissage automatique a longtemps été que « plus de données, c’est toujours mieux ». Cependant, des recherches récentes remettent en cause cette idée, avec des preuves convaincantes que la qualité des données l’emporte largement sur la quantité en matière de performance des modèles d’IA. Une étude arxiv de 2024 (2411.15821) sur de petits modèles de langage a montré que la qualité des données d’entraînement joue un rôle bien plus important que le simple volume, révélant que la relation entre quantité de données et précision du modèle est beaucoup plus nuancée qu’on ne le pensait. Les implications en termes de coûts sont considérables : les organisations qui investissent massivement dans la collecte de données sans prioriser la qualité gaspillent souvent des ressources en stockage, traitement et puissance de calcul, tout en obtenant des rendements décroissants sur la performance des modèles.

La qualité des données n’est pas un concept monolithique, mais un cadre multidimensionnel englobant plusieurs aspects clés. La précision désigne à quel point les données reflètent la réalité et si les étiquettes sont correctes. La cohérence garantit que les données respectent des formats et standards uniformes sur l’ensemble du jeu de données. La complétude mesure si toutes les informations nécessaires sont présentes sans lacunes majeures. La pertinence détermine si les données répondent directement au problème que le modèle d’IA doit résoudre. La fiabilité indique la confiance que l’on peut accorder à la source des données et à sa stabilité dans le temps. Enfin, le bruit représente les variations ou erreurs indésirables pouvant induire en erreur l’entraînement du modèle. Comprendre ces dimensions aide les organisations à prioriser stratégiquement leurs efforts de curation des données.

| Dimension de qualité | Définition | Impact sur l’IA |

|---|---|---|

| Précision | Correction des étiquettes et représentation des données | Affecte directement la fiabilité des prédictions ; des données mal étiquetées causent des erreurs systématiques |

| Cohérence | Formatage uniforme et structure de données standardisée | Permet un entraînement stable ; les incohérences troublent les algorithmes d’apprentissage |

| Complétude | Présence de toutes les informations nécessaires sans lacunes | Les valeurs manquantes réduisent les données réellement exploitables et la généralisation |

| Pertinence | Les données répondent directement au domaine du problème | Des données pertinentes surpassent de grands volumes de données génériques |

| Fiabilité | Fiabilité des sources et stabilité dans le temps | Les sources peu fiables introduisent des biais systématiques et nuisent à la robustesse |

| Bruit | Variations indésirables et erreurs de mesure | Un bruit contrôlé améliore la robustesse ; un excès de bruit dégrade les performances |

La recherche de quantité sans garanties de qualité entraîne une cascade de problèmes bien au-delà des indicateurs de performance des modèles. Les travaux de Rishabh Iyer démontrent que les expériences sur le bruit d’étiquetage révèlent des chutes spectaculaires de précision : des données mal étiquetées dégradent activement les performances du modèle, et non simplement en fournissant des exemples neutres. Au-delà de la précision, les organisations font face à des coûts croissants de stockage et de traitement pour des jeux de données qui n’améliorent pas les résultats des modèles, ainsi qu’à un impact environnemental important dû à une consommation computationnelle inutile. L’imagerie médicale offre un exemple concret et préoccupant : un jeu de milliers de radiographies mal étiquetées pourrait former un modèle qui commet en toute confiance des erreurs de diagnostic dangereuses, mettant potentiellement des patients en danger. L’économie illusoire des données bon marché et de faible qualité devient évidente lorsqu’on prend en compte les coûts de réentraînement, de débogage et d’échecs de déploiement dus à de mauvaises données d’entraînement.

La qualité spécifique au domaine surpasse systématiquement la quantité générique dans les applications pratiques de l’IA. Prenons un classificateur de sentiment destiné aux critiques de films : un jeu de 10 000 critiques de films soigneusement sélectionnées dépassera largement un jeu générique de 100 000 exemples issus de la presse financière, des réseaux sociaux et d’avis produits. La pertinence des données d’entraînement pour la problématique visée compte bien plus que la taille brute, car les modèles apprennent des schémas propres à leur distribution d’entraînement. Si les données manquent de pertinence pour l’application cible, le modèle apprend des corrélations erronées et ne généralise pas aux cas réels. Les organisations doivent privilégier la collecte de jeux de données plus petits mais parfaitement adaptés à leur domaine, plutôt que d’accumuler des masses génériques nécessitant un filtrage et un prétraitement intensifs.

La meilleure stratégie de données ne se situe à aucun extrême, mais dans la « zone Goldilocks » : le point d’équilibre où quantité et qualité de données sont adaptées au problème à résoudre. Trop peu de données, même parfaitement étiquetées, laissent les modèles sous-ajustés et incapables de capturer la complexité réelle. À l’inverse, un excès de données de mauvaise qualité engendre du gaspillage computationnel et de l’instabilité d’entraînement. L’étude arxiv l’illustre concrètement : une duplication minimale améliore la précision de 0,87 % à 25 % de duplication, tandis qu’une duplication excessive à 100 % fait chuter la précision de 40 %. L’équilibre idéal dépend de multiples facteurs : type d’algorithme, complexité du problème, ressources, et variance naturelle du domaine cible. La distribution des données doit refléter la variance réelle plutôt qu’être artificiellement uniforme, afin d’apprendre aux modèles à gérer la variabilité en production.

Toutes les données supplémentaires ne se valent pas : distinguer entre une augmentation bénéfique et une dégradation nuisible est crucial pour une stratégie efficace. Les perturbations contrôlées et les techniques d’augmentation améliorent la robustesse en apprenant aux algorithmes à gérer les variations réelles (rotations, luminosité, petites variations d’étiquettes…). Le jeu de chiffres manuscrits MNIST l’illustre bien : les modèles entraînés sur des versions augmentées (chiffres tournés, redimensionnés, légèrement déformés) généralisent mieux à la vraie écriture que ceux formés sur les images originales seules. À l’inverse, des corruptions sévères (bruit aléatoire, étiquetage systématiquement faux, injection de données hors sujet) dégradent la performance et gaspillent des ressources. Tout est question d’intention : l’augmentation est conçue pour refléter des variations réalistes, alors que les données « poubelle » ne sont qu’un bruit qui désoriente l’apprentissage. Les organisations doivent faire la différence lors de l’enrichissement de leurs jeux de données.

Pour les organisations à ressources limitées, l’apprentissage actif offre une solution puissante pour réduire les besoins en données tout en maintenant ou améliorant les performances du modèle. Plutôt que de collecter et d’étiqueter passivement toutes les données disponibles, les algorithmes d’apprentissage actif identifient les exemples non étiquetés les plus informatifs pour le modèle, réduisant drastiquement l’effort d’annotation humaine. Cette approche permet d’obtenir de bonnes performances avec nettement moins de données annotées, en concentrant l’effort sur les exemples les plus impactants. L’apprentissage actif démocratise le développement IA en le rendant accessible à des équipes sans budgets d’annotation massifs, qui peuvent ainsi bâtir des modèles performants via une sélection stratégique des données, plutôt que par la force brute. En apprenant efficacement avec moins de données, les organisations itèrent plus vite, réduisent les coûts et peuvent investir dans l’assurance qualité plutôt que dans une collecte massive.

Allouer stratégiquement ses ressources implique de prioriser fondamentalement la qualité sur la quantité dans les décisions liées aux données. Les organisations doivent investir dans des pipelines de validation robustes pour détecter les erreurs avant l’entraînement, avec des contrôles automatisés de cohérence, complétude et précision. Des outils de profilage de données permettent de repérer à grande échelle les problèmes de qualité : étiquetage erroné, valeurs manquantes, exemples non pertinents… L’apprentissage actif réduit le volume de données à valider tout en assurant que chaque exemple revu est aussi informatif que possible. Un suivi continu des performances en production révèle si des problèmes de qualité des données d’entraînement se traduisent par des défaillances réelles, permettant des boucles de retour rapides. La meilleure stratégie équilibre collecte et curation rigoureuse, sachant que 1 000 exemples parfaitement étiquetés surpassent souvent 100 000 exemples bruités, tant en performance qu’en coût total de possession.

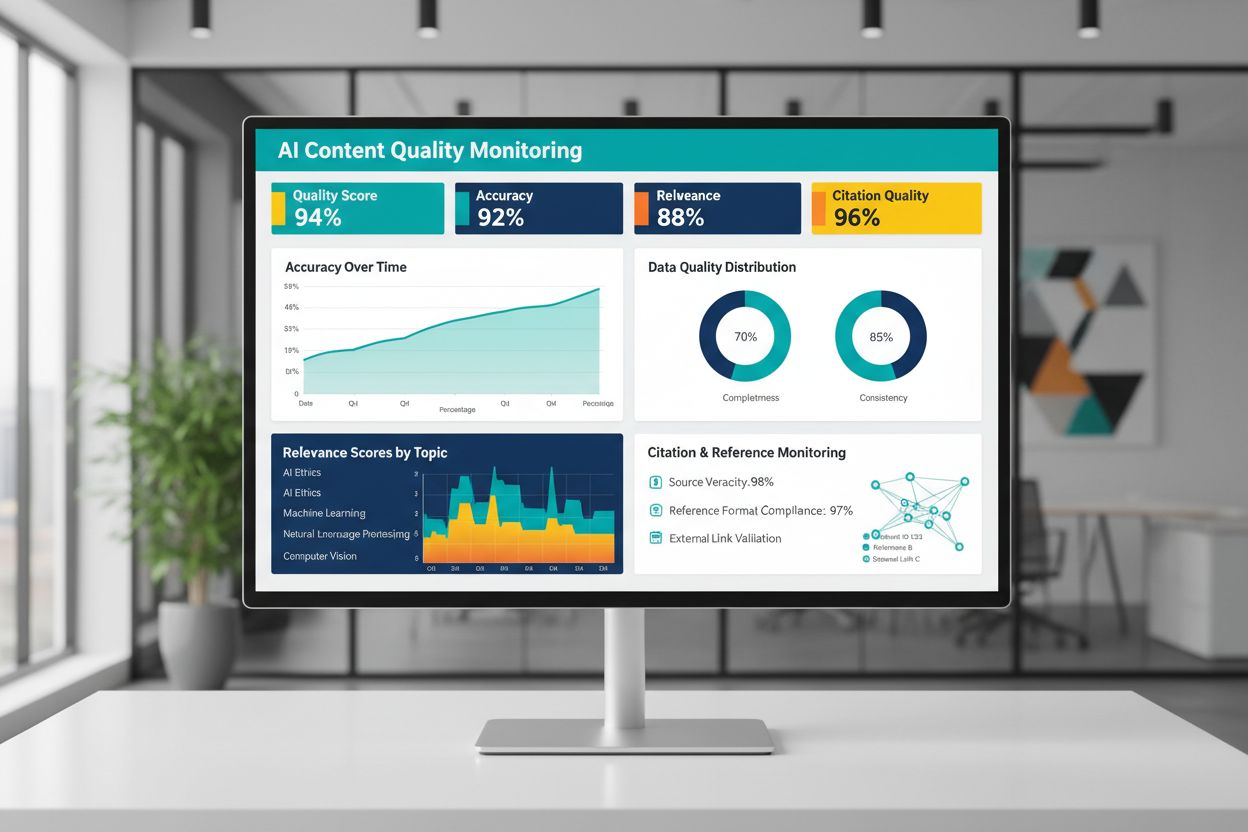

La qualité des contenus générés ou entraînés par l’IA dépend fondamentalement de la qualité des données d’apprentissage, ce qui rend indispensable le suivi continu des sorties de l’IA pour garantir leur fiabilité. Des plateformes comme AmICited.com répondent à ce besoin en surveillant les réponses IA et la justesse des citations – un indicateur direct de la qualité et de la fiabilité du contenu. Lorsque les systèmes sont formés sur des données de mauvaise qualité ou mal référencées, leurs réponses héritent de ces défauts et peuvent diffuser des erreurs à grande échelle. Les outils de monitoring doivent suivre non seulement la précision, mais aussi la pertinence, la cohérence et la présence de preuves pour les affirmations générées par l’IA. Les organisations déployant des systèmes IA doivent instaurer des boucles de retour pour détecter rapidement toute dérive par rapport aux standards de qualité attendus, et ainsi réentraîner ou ajuster les données sous-jacentes. L’investissement dans l’infrastructure de suivi porte ses fruits en détectant très tôt toute dégradation de qualité, avant que cela n’affecte les utilisateurs ou la crédibilité de l’organisation.

Transformer les principes de qualité des données en actions demande une démarche structurée, de l’évaluation jusqu’à la mesure et l’itération. Commencez par évaluer votre niveau de base – analysez la qualité existante via des audits et du profilage. Définissez des métriques claires en phase avec votre cas d’usage : seuils de précision, standards de cohérence, critères de pertinence… Mettez en place des pratiques de gouvernance pour identifier les responsables, formaliser les procédures de validation et instaurer des contrôles qualité avant l’intégration dans les pipelines d’entraînement. Démarrez avec des ensembles de données petits et soigneusement sélectionnés, avant de traiter des volumes importants, afin de bâtir vos standards et processus à une échelle maîtrisable. Mesurez rigoureusement les améliorations en comparant la performance du modèle avant/après intervention sur la qualité, ce qui justifie concrètement de poursuivre l’investissement. Élargissez progressivement la collecte de données seulement après avoir démontré que les gains de qualité se traduisent en bénéfices réels.

Non. Des recherches récentes montrent que la qualité des données compte souvent plus que la quantité. Des données de mauvaise qualité, mal étiquetées ou non pertinentes peuvent réellement dégrader les performances du modèle, même à grande échelle. L’essentiel est de trouver le bon équilibre entre quantité suffisante pour un entraînement efficace et maintien de normes de qualité élevées.

La qualité des données recouvre plusieurs dimensions : précision (étiquettes correctes), cohérence (formatage uniforme), complétude (pas de valeurs manquantes), pertinence (alignement avec votre problématique), fiabilité (sources dignes de confiance) et niveau de bruit. Définissez des métriques spécifiques à votre cas d’usage et mettez en place des contrôles pour détecter les problèmes avant l’entraînement.

La taille idéale dépend de la complexité de l’algorithme, du type de problème et des ressources disponibles. Plutôt que de viser la taille maximale, cherchez la « zone Goldilocks » : assez de données pour refléter la réalité sans être submergé par des exemples redondants ou non pertinents. Démarrez petit avec des données sélectionnées, puis augmentez progressivement selon les améliorations constatées.

L’augmentation de données applique des perturbations contrôlées (rotations, légères distorsions, variations de luminosité) qui conservent la vraie étiquette tout en apprenant au modèle à gérer la variabilité réelle. Cela diffère des données inutiles : l’augmentation est intentionnelle et reflète des variations réalistes, rendant les modèles plus robustes en conditions réelles.

L’apprentissage actif identifie les exemples non étiquetés les plus informatifs pour le modèle, réduisant ainsi fortement la charge d’annotation. Au lieu d’étiqueter toutes les données disponibles, vous concentrez l’effort humain sur les exemples les plus impactants, obtenant de bonnes performances avec beaucoup moins de données annotées.

Priorisez la qualité sur la quantité. Investissez dans des pipelines de validation des données, des outils de profilage et des processus de gouvernance assurant des données d’entraînement de haute qualité. Les recherches montrent que 1 000 exemples parfaitement étiquetés surpassent souvent 100 000 exemples bruyants, tant en performance modèle qu’en coût total de possession.

Des données de mauvaise qualité engendrent de multiples coûts : réentraînement, débogage, échecs de déploiement, surcharge de stockage et gaspillage computationnel. Dans des domaines critiques comme l’imagerie médicale, des données d’entraînement de qualité médiocre peuvent provoquer des erreurs dangereuses. L’économie illusoire de données bon marché se révèle lorsqu’on tient compte de ces coûts cachés.

Mettez en place un suivi continu des sorties IA en contrôlant l’exactitude, la pertinence, la cohérence et la qualité des citations. Des plateformes comme AmICited surveillent la façon dont les systèmes d’IA référencent l’information et la justesse des citations. Établissez des boucles de retour reliant les performances en production à la qualité des données d’entraînement pour une amélioration rapide.

Suivez la façon dont les systèmes d’IA citent votre marque et assurez-vous de la justesse des contenus grâce à la plateforme de monitoring IA d’AmICited. Comprenez la qualité des réponses générées par l’IA à propos de votre entreprise.

Découvrez comment présenter des statistiques pour l'extraction par IA. Découvrez les meilleures pratiques de formatage des données, JSON vs CSV, et comment prép...

Découvrez pourquoi le trafic IA convertit 23x mieux que la recherche organique. Apprenez à optimiser pour les plateformes IA et à mesurer le véritable ROI des v...

Discussion communautaire sur l'influence des données d'entraînement de l'IA concernant votre marque. Retours concrets sur la façon dont la création de contenu a...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.