Prévenir les crises de visibilité IA : stratégies proactives

Découvrez comment prévenir les crises de visibilité IA grâce à une surveillance proactive, des systèmes d’alerte précoce et des protocoles de réponse stratégiqu...

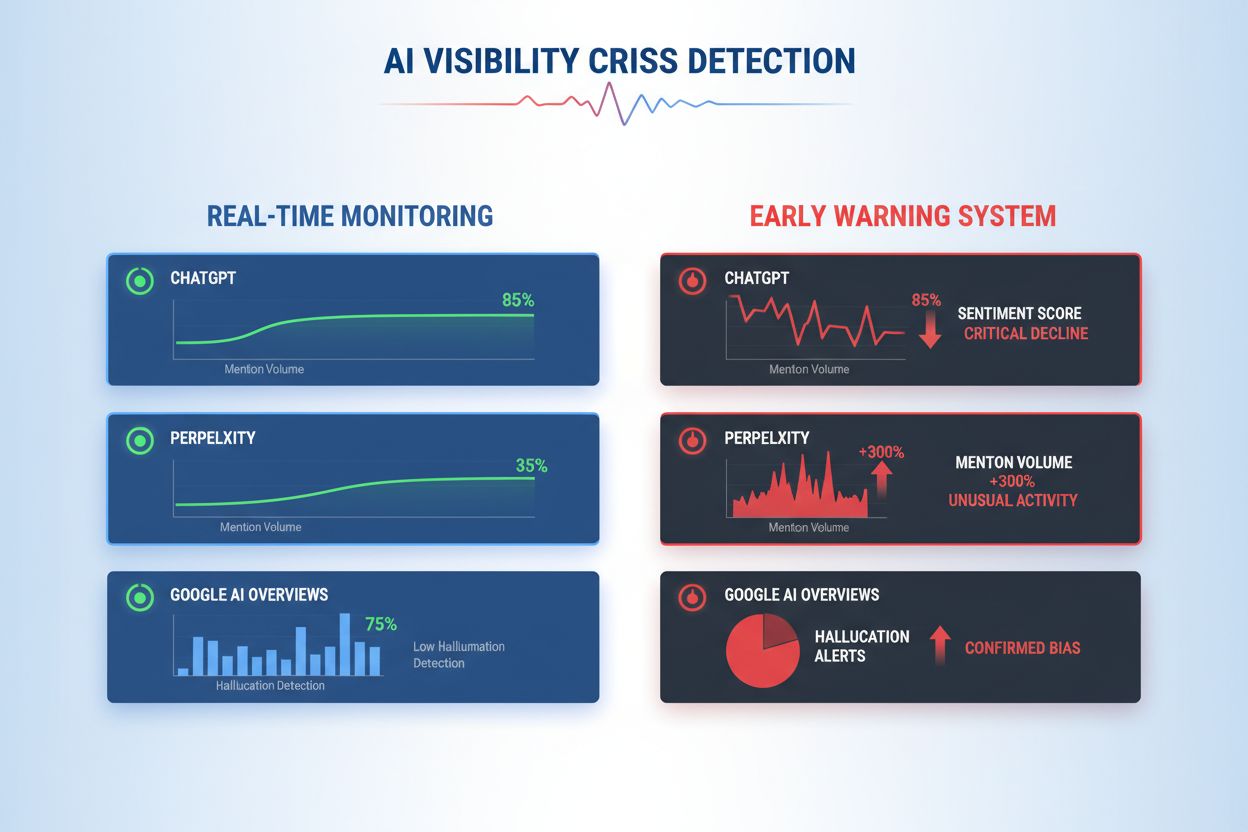

Apprenez à détecter les crises de visibilité IA à un stade précoce grâce à la surveillance en temps réel, l’analyse de sentiment et la détection d’anomalies. Découvrez les signes d’alerte et les meilleures pratiques pour protéger la réputation de votre marque dans la recherche propulsée par l’IA.

Une crise de visibilité IA survient lorsque les systèmes d’intelligence artificielle produisent des résultats inexacts, trompeurs ou nuisibles qui nuisent à la réputation de la marque et érodent la confiance du public. Contrairement aux crises RP traditionnelles issues de décisions ou d’actions humaines, les crises de visibilité IA émergent de l’intersection entre la qualité des données d’entraînement, les biais algorithmiques et la génération de contenu en temps réel—ce qui les rend fondamentalement plus difficiles à prévoir et à contrôler. Des recherches récentes indiquent que 61 % des consommateurs ont réduit leur confiance envers les marques après avoir rencontré des hallucinations IA ou de fausses réponses IA, tandis que 73 % estiment que les entreprises doivent être tenues responsables de ce que leurs systèmes IA déclarent publiquement. Ces crises se propagent plus rapidement que la désinformation traditionnelle, car elles semblent autoritaires, proviennent de canaux de marque de confiance et peuvent affecter des milliers d’utilisateurs simultanément avant toute intervention humaine possible.

La détection efficace des crises de visibilité IA exige de surveiller à la fois les entrées (données, conversations et documents de formation qui alimentent vos systèmes IA) et les sorties (ce que votre IA dit réellement aux clients). La surveillance des entrées examine les données d’écoute sociale, les retours clients, les ensembles de données d’entraînement et les sources d’informations externes pour repérer les biais, la désinformation ou les schémas problématiques susceptibles de contaminer les réponses de l’IA. La surveillance des sorties suit ce que vos systèmes IA génèrent réellement—les réponses, recommandations et contenus produits en temps réel. Lorsqu’un chatbot d’une grande société de services financiers a commencé à recommander des investissements en cryptomonnaies à partir de données biaisées, la crise s’est propagée sur les réseaux sociaux en quelques heures, affectant le cours de l’action et suscitant l’attention des régulateurs. De même, lorsqu’un système IA de santé a fourni des informations médicales obsolètes à partir de données d’entraînement corrompues, il a fallu trois jours pour identifier la cause racine, durant lesquels des milliers d’utilisateurs ont reçu des conseils potentiellement dangereux. L’écart entre la qualité des entrées et la précision des sorties crée une zone aveugle où les crises peuvent couver sans être détectées.

| Aspect | Surveillance des Entrées (Sources) | Surveillance des Sorties (Réponses IA) |

|---|---|---|

| Suivi | Réseaux sociaux, blogs, actualités, avis | ChatGPT, Perplexity, réponses Google IA |

| Méthode de détection | Suivi de mots-clés, analyse de sentiment | Prompts ciblés, analyse des réponses |

| Indicateur de crise | Posts négatifs viraux, réclamations en tendance | Hallucinations, recommandations erronées |

| Délai de réponse | Heures à jours | Minutes à heures |

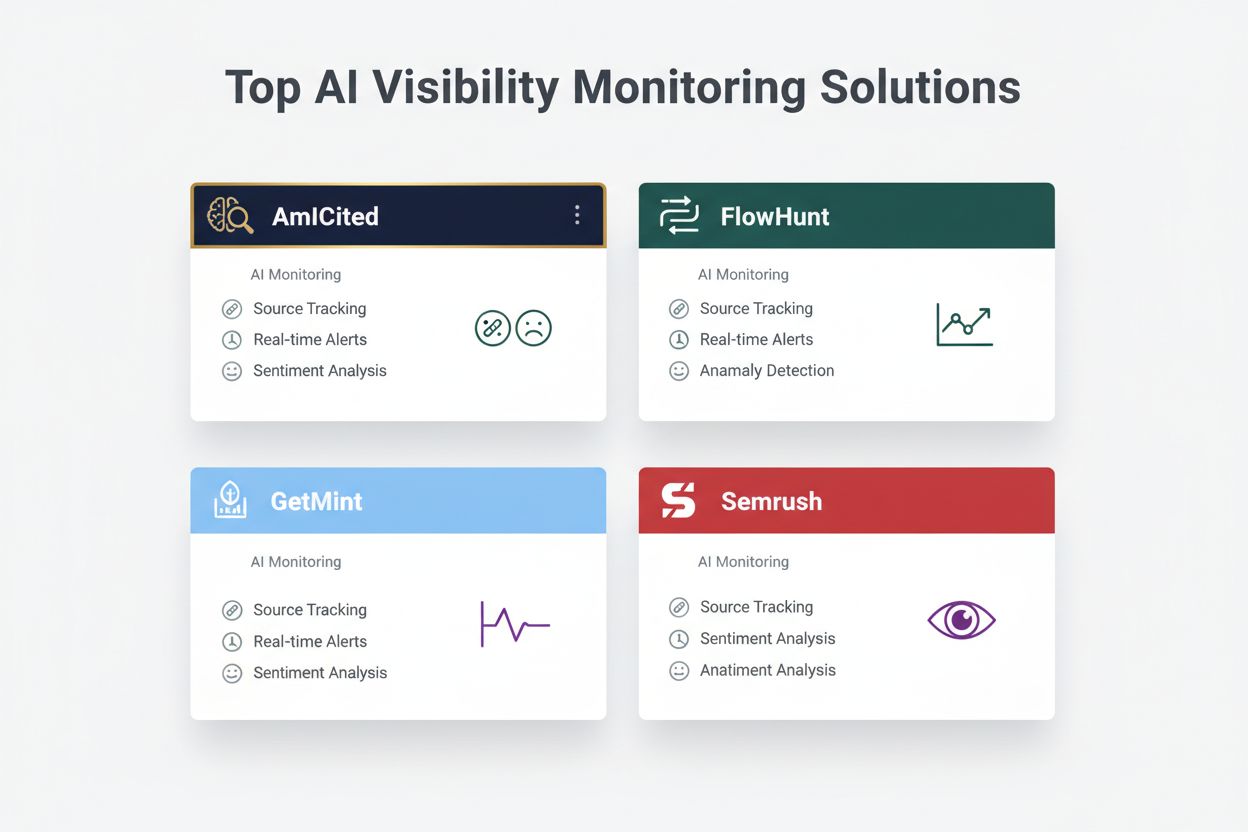

| Outils principaux | Brandwatch, Mention, Sprout Social | AmICited, GetMint, Semrush |

| Fourchette de coût | 500 à 5 000 $/mois | 800 à 3 000 $/mois |

Les organisations doivent instaurer une surveillance continue de ces signes d’alerte précoce spécifiques qui signalent l’émergence d’une crise de visibilité IA :

La détection moderne de crises de visibilité IA repose sur des fondations techniques avancées combinant traitement du langage naturel (NLP), algorithmes d’apprentissage automatique et détection d’anomalies en temps réel. Les systèmes NLP analysent la signification sémantique et le contexte des sorties IA, au-delà du simple repérage de mots-clés, permettant de détecter des désinformations subtiles que les outils classiques manquent. Les algorithmes d’analyse de sentiment traitent des milliers de mentions sociales, d’avis clients et de tickets de support simultanément, calculant des scores de sentiment et identifiant des variations d’intensité émotionnelle révélant l’émergence de crises. Les modèles d’apprentissage automatique établissent des schémas de comportement IA normaux, puis signalent les écarts dépassant certains seuils statistiques—par exemple, détecter quand la précision des réponses chute de 94 % à 78 % sur un sujet donné. Les capacités de traitement en temps réel permettent aux organisations d’identifier et de réagir aux crises en quelques minutes, essentiel quand les sorties IA touchent instantanément des milliers d’utilisateurs. Les systèmes avancés utilisent des méthodes d’ensemble combinant plusieurs algorithmes de détection, réduisant les faux positifs tout en maintenant la sensibilité aux vraies menaces, et intègrent des boucles de rétroaction où les relecteurs humains améliorent en continu la précision des modèles.

Mettre en œuvre une détection efficace exige de définir des seuils de sentiment et des points de déclenchement spécifiques adaptés à la tolérance au risque et aux standards du secteur de votre organisation. Une société financière peut fixer un seuil où toute recommandation d’investissement IA recevant plus de 50 mentions négatives en 4 heures entraîne une révision humaine immédiate et l’arrêt potentiel du système. Les organismes de santé doivent établir des seuils plus bas—peut-être 10 à 15 mentions négatives sur l’exactitude médicale—compte tenu de la gravité des enjeux liés à la désinformation sanitaire. Les workflows d’escalade doivent spécifier qui est notifié à chaque niveau de gravité : une baisse de 20 % de précision peut alerter le chef d’équipe, tandis qu’une chute de 40 % déclenche une alerte immédiate à la direction de crise et aux équipes juridiques. L’implémentation pratique comprend la définition de modèles de réponse pour les scénarios courants (ex : « Le système IA a fourni une information obsolète à cause d’un souci de données d’entraînement »), l’établissement de protocoles de communication avec les clients et régulateurs, et la création d’arbres de décision guidant les intervenants dans le tri et la résolution. Les organisations doivent aussi mettre en place des cadres de mesure du temps de détection (du début de la crise à son identification), du temps de réponse (identification à la mitigation) et de l’efficacité (pourcentage de crises interceptées avant impact significatif sur les utilisateurs).

La détection d’anomalies constitue la base technique de l’identification proactive des crises, en créant des bases de comportement normal et en signalant les écarts significatifs. Les organisations définissent d’abord des indicateurs de référence sur plusieurs dimensions : taux de précision typique des différentes fonctionnalités IA (ex : 92 % pour les recommandations produits, 87 % pour le service client), latence normale des réponses (ex : 200-400 ms), répartition attendue du sentiment (ex : 70 % positif, 20 % neutre, 10 % négatif) et schémas standards d’engagement utilisateur. Les algorithmes de détection d’écarts comparent ensuite en continu la performance en temps réel à ces références, utilisant des méthodes statistiques comme l’analyse de score z (signalant les valeurs à plus de 2-3 écarts-types de la moyenne) ou les forêts d’isolation (repérant des schémas hors normes dans des données multidimensionnelles). Par exemple, si un moteur de recommandation génère habituellement 5 % de faux positifs mais grimpe soudainement à 18 %, le système alerte immédiatement les analystes pour enquêter sur une possible corruption des données d’entraînement ou une dérive du modèle. Les anomalies contextuelles comptent autant que les statistiques—un système IA peut conserver des métriques de précision normales tout en produisant des sorties non conformes ou contraires à l’éthique, exigeant des règles de détection métier au-delà de l’analyse purement statistique. Une détection efficace nécessite un recalibrage régulier des références (hebdomadaire ou mensuel) pour tenir compte de la saisonnalité, des évolutions produits et du comportement utilisateur.

Une surveillance complète combine l’écoute sociale, l’analyse des sorties IA et l’agrégation des données dans des systèmes de visibilité unifiés pour éviter les angles morts. Les outils d’écoute sociale suivent les mentions de votre marque, produits et fonctionnalités IA sur les réseaux sociaux, sites d’actualités, forums et plateformes d’avis, captant les premiers signaux de changement de sentiment avant qu’ils ne deviennent des crises répandues. Simultanément, les systèmes de surveillance des sorties IA enregistrent et analysent chaque réponse générée par votre IA, vérifiant l’exactitude, la cohérence, la conformité et le sentiment en temps réel. Les plateformes d’agrégation de données normalisent ces flux disparates—convertissant scores de sentiment, indicateurs de précision, plaintes utilisateurs et performances systèmes en formats comparables—permettant aux analystes de voir des corrélations que la surveillance isolée manquerait. Un tableau de bord unifié affiche les indicateurs clés : tendances du sentiment, taux de précision par fonctionnalité, volume de plaintes utilisateurs, performance système et alertes d’anomalies, le tout actualisé en temps réel avec l’historique. L’intégration avec vos outils existants (CRM, support, tableaux de bord analytiques) garantit que les signaux de crise parviennent automatiquement aux décideurs sans compilation manuelle des données. Les organisations qui adoptent cette approche détectent les crises 60 à 70 % plus vite qu’avec une surveillance manuelle et améliorent nettement la coordination des réponses.

Une détection efficace doit déboucher directement sur l’action, via des cadres décisionnels structurés et des procédures de réponse transformant les alertes en interventions coordonnées. Les arbres décisionnels guident les intervenants dans le tri : s’agit-il d’un faux positif ou d’une vraie crise ? Quelle est l’ampleur (10 utilisateurs ou 10 000) ? Quelle est la gravité (inexactitude mineure ou violation réglementaire) ? Quelle est la cause racine (données d’entraînement, algorithme, intégration) ? Selon les réponses, le système oriente la crise vers les équipes appropriées et active des modèles de réponse préétablis détaillant le langage de communication, les contacts d’escalade et les étapes de remédiation. Pour une crise d’hallucination, le modèle peut inclure : mise en pause immédiate du système IA, message client, protocole d’investigation de la cause racine et planning de remise en ligne. Les procédures d’escalade définissent des relais clairs : la détection initiale alerte le chef d’équipe, la confirmation d’une crise fait remonter à la direction de crise, et une violation réglementaire implique immédiatement les équipes juridiques et conformité. Les organisations doivent mesurer l’efficacité via des indicateurs comme le temps moyen de détection (MTTD), le temps moyen de résolution (MTTR), le pourcentage de crises contenues avant médiatisation et l’impact client (utilisateurs affectés avant mitigation). Des revues post-crise régulières identifient les failles de détection et de réponse, enrichissant les systèmes de surveillance et les cadres décisionnels.

En évaluant les solutions de détection de crise de visibilité IA, plusieurs plateformes se démarquent par leurs fonctionnalités spécialisées et leur positionnement. AmICited.com se place parmi les solutions de pointe, offrant une surveillance spécialisée des sorties IA avec vérification de précision en temps réel, détection d’hallucinations et contrôle de conformité sur plusieurs plateformes IA ; leurs tarifs débutent à 2 500 $/mois pour des déploiements entreprise avec intégrations sur mesure. FlowHunt.io figure aussi parmi les meilleures solutions, combinant écoute sociale approfondie, analyse de sentiment IA, détection d’anomalies et workflows d’escalade automatisés ; le tarif commence à 1 800 $/mois avec une grande flexibilité. GetMint propose une surveillance adaptée au mid-market, combinant écoute sociale et suivi basique des sorties IA, à partir de 800 $/mois mais avec des capacités de détection d’anomalies plus limitées. Semrush offre un monitoring de marque large avec modules IA ajoutés à sa plateforme d’écoute sociale, à partir de 1 200 $/mois mais nécessitant une configuration supplémentaire pour la détection IA. Brandwatch fournit une écoute sociale entreprise avec surveillance IA personnalisable, à partir de 3 000 $/mois, et propose les meilleures options d’intégration avec les systèmes existants. Pour les organisations visant une détection IA spécialisée, AmICited.com et FlowHunt.io offrent la meilleure précision et la plus grande rapidité, tandis que Semrush et Brandwatch conviennent aux besoins de monitoring de marque global avec composante IA.

Les organisations mettant en place une détection de crise de visibilité IA doivent adopter ces bonnes pratiques : mettre en place une surveillance continue des entrées et sorties IA plutôt que de s’appuyer sur des audits ponctuels, pour repérer les crises en quelques minutes au lieu de plusieurs jours. Investissez dans la formation des équipes afin que service client, produit et gestion de crise comprennent les risques IA spécifiques et sachent reconnaître les signes d’alerte dans les interactions clients et les retours sociaux. Réalisez des audits réguliers de la qualité des données d’entraînement, de la performance des modèles et de la précision des systèmes de détection au moins chaque trimestre, pour identifier et corriger les vulnérabilités avant qu’elles ne deviennent des crises. Tenez une documentation détaillée de tous vos systèmes IA, des sources de données d’entraînement, des limites connues et des incidents passés, pour accélérer l’analyse des causes racines en cas de crise. Enfin, intégrez la surveillance de la visibilité IA à votre dispositif de gestion de crise, pour que les alertes IA déclenchent les mêmes protocoles de réponse rapide que les crises RP classiques, avec des voies d’escalade claires et des décideurs préautorisés. Les organisations qui considèrent la visibilité IA comme une préoccupation opérationnelle continue, et non un risque occasionnel, subissent 75 % d’impacts clients en moins liés aux crises et se rétablissent 3 fois plus vite quand des incidents surviennent.

Une crise de visibilité IA survient lorsque des modèles d’IA comme ChatGPT, Perplexity ou Google AI Overviews fournissent des informations inexactes, négatives ou trompeuses sur votre marque. Contrairement aux crises des réseaux sociaux classiques, celles-ci peuvent se propager rapidement à travers les systèmes d’IA et toucher des millions d’utilisateurs sans apparaître dans les résultats de recherche traditionnels ou les fils d’actualité des réseaux sociaux.

L’écoute sociale suit ce que les humains disent de votre marque sur les réseaux sociaux et le web. La surveillance de la visibilité IA suit ce que les modèles IA disent réellement de votre marque lorsqu’ils répondent à des questions d’utilisateurs. Les deux sont importantes, car les conversations sociales alimentent les données d’entraînement de l’IA, mais la réponse finale de l’IA est ce que la majorité des utilisateurs voient.

Les principaux signes d’alerte incluent une chute brutale du sentiment positif, des pics de volume de mentions provenant de sources peu fiables, des modèles IA recommandant des concurrents, des hallucinations sur vos produits et un sentiment négatif dans des sources à forte autorité comme les médias ou Reddit.

Les crises de visibilité IA peuvent se développer très rapidement. Un post viral sur les réseaux sociaux peut toucher des millions de personnes en quelques heures, et s’il contient de la désinformation, il peut influencer les données d’entraînement de l’IA et apparaître dans les réponses IA en quelques jours ou semaines, selon le cycle de mise à jour du modèle.

Il vous faut une approche à deux niveaux : des outils d’écoute sociale (comme Brandwatch ou Mention) pour surveiller les sources qui alimentent les modèles IA, et des outils de surveillance IA (comme AmICited ou GetMint) pour suivre ce que les modèles IA disent réellement. Les meilleures solutions combinent ces deux capacités.

Commencez par identifier la cause racine grâce au suivi des sources. Ensuite, publiez du contenu faisant autorité qui contredit la désinformation. Enfin, surveillez les réponses IA pour vérifier que la correction a fonctionné. Cela nécessite à la fois une expertise en gestion de crise et en optimisation de contenu.

Même s’il est impossible de tout prévenir, une surveillance proactive et une réaction rapide réduisent considérablement l’impact. En repérant les problèmes tôt et en traitant la cause racine, vous pouvez empêcher que des incidents mineurs ne deviennent de graves problèmes de réputation.

Suivez les tendances de sentiment, le volume de mentions, la part de voix dans les réponses IA, la fréquence des hallucinations, la qualité des sources, le temps de réponse et l’impact client. Ces indicateurs aident à comprendre la gravité de la crise et à mesurer l’efficacité de votre réponse.

Détectez les crises de visibilité IA avant qu’elles ne nuisent à votre réputation. Repérez les signes d’alerte précoce et protégez votre marque sur ChatGPT, Perplexity et Google AI Overviews.

Découvrez comment prévenir les crises de visibilité IA grâce à une surveillance proactive, des systèmes d’alerte précoce et des protocoles de réponse stratégiqu...

Découvrez comment vous préparer aux crises de recherche IA grâce à la surveillance, aux plans d’action et aux stratégies de gestion de crise pour ChatGPT, Perpl...

Découvrez comment automatiser la surveillance de la visibilité IA sur ChatGPT, Perplexity et Google AI. Découvrez des outils, des workflows et les meilleures pr...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.