Recherche IA multimodale

Découvrez comment les systèmes de recherche IA multimodale traitent ensemble texte, images, audio et vidéo pour fournir des résultats plus précis et contextuell...

Découvrez comment optimiser le texte, les images et la vidéo pour les systèmes d’IA multimodale. Découvrez des stratégies pour améliorer les citations IA et la visibilité sur ChatGPT, Gemini et Perplexity.

L’IA multimodale représente un changement fondamental dans la manière dont les systèmes d’intelligence artificielle traitent et comprennent l’information. Contrairement aux systèmes unimodaux qui gèrent indépendamment le texte, les images ou la vidéo, l’IA multimodale intègre plusieurs types de données simultanément pour créer une compréhension plus globale d’informations complexes. Cette approche reflète la façon dont les humains perçoivent naturellement le monde — nous ne séparons pas ce que nous voyons de ce que nous entendons ou lisons, mais synthétisons tous les apports ensemble. Le marché de l’IA multimodale, évalué à 1,6 milliard de dollars en 2024, connaît une croissance explosive avec un TCAC de 32,7 %, reflétant l’importance cruciale de cette technologie dans les stratégies IA des entreprises. Les analystes du secteur prévoient que 40 % de toutes les solutions d’IA générative seront multimodales d’ici 2027, selon une étude Gartner. Cette transition n’est pas simplement incrémentale ; elle représente un changement de paradigme dans la manière dont les organisations exploitent l’IA pour un avantage concurrentiel. La convergence des capacités de traitement du texte, de l’image et de la vidéo permet aux systèmes d’IA de fournir des informations et des capacités auparavant impossibles avec les approches à modalité unique.

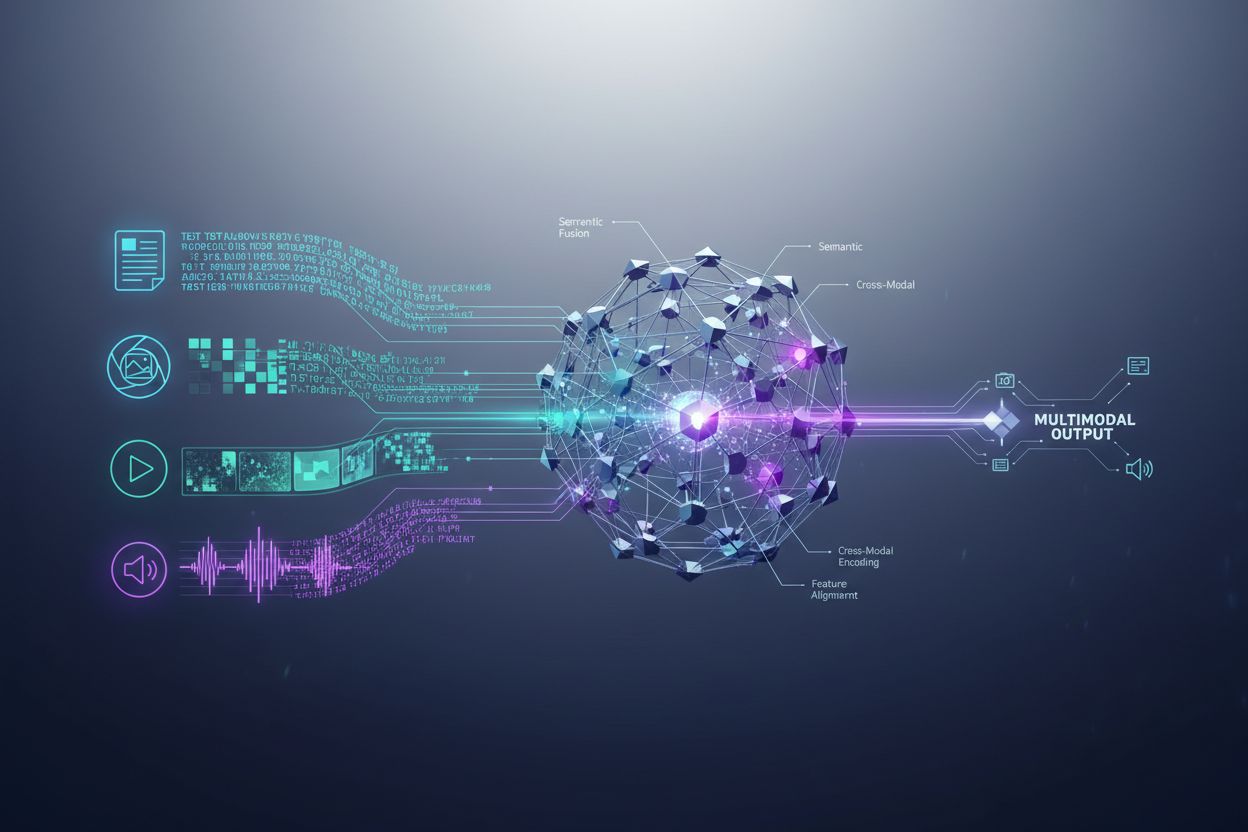

Les systèmes d’IA multimodale utilisent des composants architecturaux sophistiqués pour gérer de manière transparente des entrées de données variées. Les encodeurs sont des réseaux neuronaux spécialisés qui convertissent chaque type de données — texte, images et vidéo — en une représentation numérique unifiée appelée embeddings. Ces embeddings capturent la signification sémantique de chaque modalité dans un espace mathématique partagé, permettant au système de comparer et relier l’information entre différents types de contenu. Le mécanisme de fusion combine ensuite ces embeddings, soit par concaténation, addition ou des techniques de fusion avancées apprises qui déterminent le poids de chaque modalité dans le résultat final. Les mécanismes d’attention croisée permettent au modèle de se concentrer dynamiquement sur l’information pertinente entre les modalités ; par exemple, lors de l’analyse d’une image de produit accompagnée de texte, le système peut prêter attention à des caractéristiques visuelles spécifiques correspondant aux descriptions textuelles. Ce processus en plusieurs étapes permet aux systèmes multimodaux d’atteindre une compréhension contextuelle que les systèmes à modalité unique ne peuvent pas reproduire. Le tableau suivant illustre les différences de capacités :

| Capacité | IA unimodale | IA multimodale |

|---|---|---|

| Analyse de texte | Excellente | Excellente |

| Compréhension d’image | Limitée/Nulle | Excellente |

| Traitement vidéo | Limité/Nul | Excellente |

| Raisonnement intermodal | Impossible | Excellent |

| Intégration du contexte | Source unique | Sources multiples |

| Précision réelle | 60-75% | 85-95% |

| Vitesse de traitement | Rapide | Rapidité optimisée |

Le paysage de l’IA multimodale est dominé par plusieurs plateformes puissantes qui ont établi de nouveaux standards pour le traitement intégré. GPT-4o d’OpenAI représente un modèle multimodal phare, gérant de manière transparente le texte, les images et la vidéo avec une intégration native entre toutes les modalités. Google Gemini offre des capacités multimodales de niveau entreprise avec une force particulière dans la compréhension de documents visuels complexes et de contenus vidéo longs. Claude d’Anthropic fournit un raisonnement multimodal sophistiqué avec un accent sur la précision et la compréhension nuancée des entrées texte et image. La technologie ImageBind de Meta démontre une approche architecturale différente, créant un espace d’embeddings unifié pour six modalités, dont texte, image, audio, profondeur, thermique et données IMU. Ces plateformes représentent le sommet de la technologie multimodale, chacune apportant des innovations architecturales et des stratégies d’optimisation distinctes. Les organisations choisissant des plateformes multimodales doivent évaluer non seulement l’étendue des capacités, mais aussi l’optimisation des performances, l’efficacité des coûts et l’intégration avec les flux de travail existants.

L’IA multimodale transforme les opérations dans presque tous les secteurs, apportant des améliorations mesurables en efficacité, précision et expérience client. Les organisations qui mettent en œuvre ces technologies rapportent des résultats remarquables :

Santé : Les radiologues utilisent l’IA multimodale pour analyser des imageries médicales combinées aux dossiers patient et notes cliniques, améliorant la précision des diagnostics et réduisant le temps d’analyse jusqu’à 40 %. Les systèmes d’IA peuvent corréler les résultats visuels avec l’historique médical textuel pour identifier des schémas que l’humain pourrait manquer.

Vente au détail : Les entreprises de mode et de e-commerce exploitent l’IA multimodale pour faire correspondre les descriptions clients à l’inventaire visuel, permettant la recherche “par description” qui augmente les taux de conversion. Les recommandations de produits s’améliorent significativement lorsque l’IA comprend à la fois les préférences visuelles et les retours textuels.

Fabrication : Les processus de contrôle qualité s’accélèrent considérablement avec des systèmes d’inspection multimodaux qui combinent détection de défauts visuelle, données capteurs et journaux de maintenance, atteignant un catalogage des problèmes de production 100 fois plus rapide que les processus manuels.

Création de contenu : Les entreprises de médias utilisent l’IA multimodale pour générer automatiquement des légendes, transcriptions et métadonnées pour le contenu vidéo, avec 72 % des dirigeants médias utilisant l’IA générative rapportant un ROI positif sur leurs investissements.

Service client : Les chatbots enrichis de capacités multimodales peuvent traiter des images de problèmes envoyées par les clients en plus des descriptions textuelles, fournissant des solutions de support plus précises et contextuelles.

Agriculture : Les agriculteurs déploient des systèmes multimodaux qui analysent des images de cultures, des données météo et des relevés de capteurs de sol pour optimiser l’irrigation, la fertilisation et la gestion des nuisibles.

Robotique : Les systèmes autonomes utilisent la perception multimodale pour naviguer dans des environnements complexes, combinant l’entrée visuelle avec des signaux audio et un retour tactile pour une opération plus sûre et intelligente.

Pour maximiser l’efficacité des systèmes d’IA multimodale, le contenu textuel nécessite des stratégies d’optimisation délibérées qui améliorent la lisibilité par la machine et la compréhension contextuelle. Le balisage de données structurées utilisant les standards schema.org aide les systèmes d’IA à comprendre les relations sémantiques dans votre contenu, permettant des connexions intermodales plus précises. L’utilisation d’un langage conversationnel plutôt qu’un style purement formel permet aux systèmes multimodaux de mieux saisir l’intention et le contexte, en particulier lorsque le texte est traité avec des éléments visuels ou vidéo. Les titres et sous-titres descriptifs servent un double objectif : ils guident les lecteurs humains tout en fournissant des signaux structurels essentiels aidant les systèmes d’IA à organiser et prioriser l’information. L’inclusion de mots-clés pertinents dans des contextes naturels — plutôt que du bourrage de mots-clés — garantit que le contenu textuel s’aligne sur la manière dont les systèmes multimodaux identifient les relations thématiques entre modalités. L’optimisation des métadonnées, incluant balises titre, meta descriptions et attributs de données structurées, fournit des signaux explicites sur la signification du contenu que les systèmes multimodaux peuvent exploiter. Les organisations doivent aussi considérer la façon dont le texte complète le contenu visuel ; les légendes et textes alternatifs ne sont pas seulement des fonctionnalités d’accessibilité — ce sont des éléments d’optimisation essentiels permettant à l’IA multimodale de comprendre la relation entre texte et information visuelle.

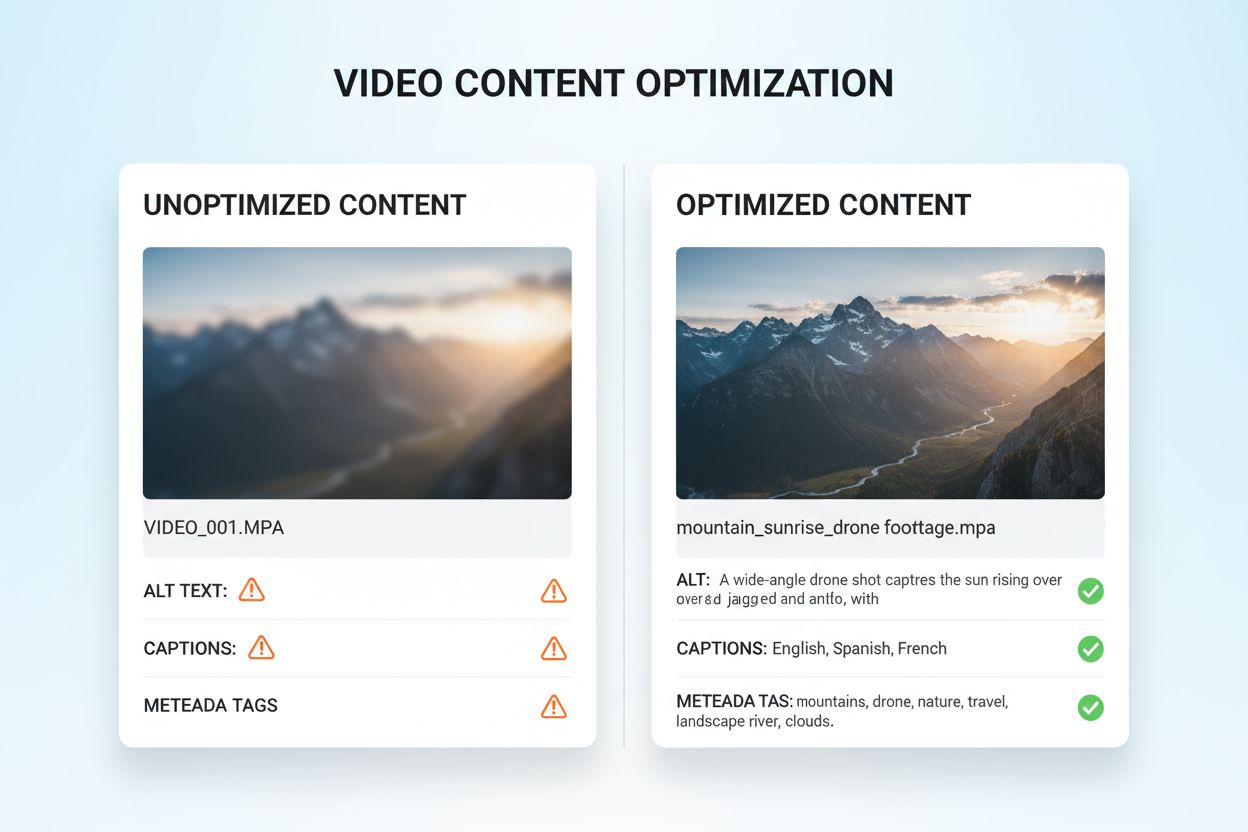

L’optimisation du contenu visuel et vidéo pour l’IA multimodale nécessite une approche globale allant bien au-delà des pratiques SEO traditionnelles. Le texte alternatif descriptif est fondamental ; plutôt que des descriptions génériques, le texte alternatif doit capturer la signification sémantique, le contexte et les détails pertinents aidant les systèmes d’IA à comprendre ce que l’image véhicule. Les conventions de nommage des fichiers sont très importantes — des noms descriptifs comme “comparatif-produits-2024.jpg” fournissent un contexte crucial que l’IA utilise pour comprendre la finalité du contenu. Les légendes et transcriptions vidéo sont des éléments essentiels d’optimisation ; elles permettent aux systèmes multimodaux de faire le lien entre le contenu parlé et les éléments visuels, améliorant considérablement la compréhension des vidéos complexes. Les champs de métadonnées tels que titre, description et tags doivent être renseignés avec précision et spécificité, car ils influencent directement la façon dont l’IA catégorise et relie le contenu visuel aux autres modalités. La compression d’images et l’optimisation technique garantissent une qualité visuelle suffisante pour l’analyse IA tout en maintenant des temps de chargement rapides. Les données structurées pour le contenu visuel, incluant le balisage pour images, vidéos et galeries médias, fournissent des signaux explicites sur les relations de contenu. Les organisations doivent également prendre en compte les métadonnées temporelles pour les vidéos — marquer les moments clés, changements de scène et transitions de sujets aide les systèmes multimodaux à comprendre la structure narrative et à extraire les segments pertinents.

Les systèmes d’IA multimodale emploient deux principales approches architecturales, chacune avec des avantages et compromis distincts. Les architectures unifiées traitent toutes les modalités via un seul réseau neuronal intégré qui apprend des représentations conjointes dès le début du traitement. Cette approche fournit généralement un raisonnement intermodal supérieur car le système développe une compréhension approfondie des relations entre modalités, mais nécessite davantage de ressources informatiques et des temps d’entraînement plus longs. Les architectures modulaires maintiennent des réseaux spécialisés distincts pour chaque modalité, puis combinent leurs sorties via des mécanismes de fusion. Cette approche offre une plus grande flexibilité, permettant aux organisations de remplacer les processeurs de modalité individuelle sans réentraîner le système complet, et requiert généralement moins de ressources informatiques. Les modèles Mixture of Experts (MoE) représentent une approche hybride émergente, où différents réseaux experts se spécialisent dans différentes modalités ou tâches, et un mécanisme de routage oriente les entrées vers les experts appropriés. Cette architecture permet une amélioration de l’efficacité de 30 à 50 % par rapport aux modèles unifiés denses tout en maintenant une précision comparable. Le choix entre ces approches architecturales dépend des cas d’usage : les architectures unifiées excellent dans les tâches de raisonnement complexes nécessitant une compréhension profonde entre modalités, tandis que les approches modulaires conviennent pour la flexibilité et l’efficacité des ressources.

La mise en œuvre efficace de l’IA multimodale nécessite des cadres de mesure robustes pour suivre à la fois la performance technique et l’impact commercial. Les indicateurs clés de performance (KPI) doivent inclure des mesures de précision pour chaque modalité, la qualité du raisonnement intermodal, la latence de traitement et le coût par inférence. Les plateformes d’analytique doivent capter comment l’IA multimodale influence les métriques métier : taux de conversion dans la vente au détail, précision des diagnostics en santé, efficacité de production en fabrication. Les organisations doivent mettre en place un suivi d’attribution pour comprendre quelle modalité contribue le plus à chaque résultat — cet éclairage guide les efforts d’optimisation et l’allocation des ressources. La mesure du ROI doit prendre en compte à la fois les économies directes (comme le catalogage 100 fois plus rapide rapporté en fabrication) et les bénéfices indirects comme la satisfaction client ou la réduction des erreurs. Les outils de monitoring doivent suivre la dégradation des performances du modèle dans le temps, car la dérive des données réelles peut réduire l’exactitude des systèmes multimodaux si elle n’est pas gérée activement. Pour les organisations utilisant du contenu et des insights générés par l’IA, le suivi des citations et attributions devient de plus en plus important ; des outils comme AmICited.com aident à surveiller comment les systèmes d’IA citent les sources et attribuent l’information, offrant une visibilité sur les processus décisionnels IA et assurant la conformité avec les exigences de provenance du contenu. Des audits réguliers de performance et des cycles d’optimisation garantissent que les systèmes multimodaux continuent de délivrer de la valeur à mesure que les besoins métiers et les profils de données évoluent.

Le paysage de l’IA multimodale évolue rapidement, avec plusieurs tendances transformatrices redéfinissant la façon dont les organisations exploiteront ces technologies. L’intégration de la voix représente la prochaine frontière, les systèmes combinant de plus en plus l’audio avec les données visuelles et textuelles, permettant une compréhension vraiment complète de la communication humaine et du contexte environnemental. Les systèmes d’IA agentique — des agents IA capables de planifier et d’exécuter de manière autonome des tâches multi-étapes — exploiteront la perception multimodale pour naviguer dans des scénarios réels complexes, des véhicules autonomes à l’automatisation robotique des processus en entreprise. Les capacités de traitement en temps réel progressent considérablement, permettant l’analyse multimodale de flux vidéo, audio et de données capteurs en direct, ouvrant la voie à une prise de décision instantanée dans des applications sensibles au temps. Les améliorations d’efficacité via des techniques comme la distillation et la quantification rendront les capacités multimodales sophistiquées accessibles aux organisations disposant de ressources informatiques limitées, démocratisant ainsi l’accès à l’IA avancée. Des modèles spécialisés par domaine émergeront, avec des systèmes multimodaux ajustés pour des secteurs spécifiques comme la santé, le juridique ou la finance, offrant des performances supérieures aux modèles généralistes. La convergence de ces tendances suggère que l’IA multimodale passera d’un avantage concurrentiel à un prérequis fondamental pour les organisations souhaitant rester pertinentes dans un monde de plus en plus piloté par l’IA. Les organisations qui commencent à optimiser leur contenu et leurs processus pour l’IA multimodale aujourd’hui seront les mieux positionnées pour tirer parti de ces capacités émergentes demain.

L’IA multimodale traite plusieurs types de données (texte, images, audio, vidéo) simultanément, tandis que l’IA unimodale traditionnelle ne traite qu’un seul type. Cela permet une compréhension du contexte plus riche et des résultats plus précis. Les systèmes multimodaux peuvent comprendre les relations entre différentes modalités, fournissant des informations que les systèmes à modalité unique ne peuvent pas reproduire.

À mesure que l’IA multimodale devient la norme des solutions d’IA générative (prévue à 40 % d’ici 2027), optimiser votre contenu garantit une meilleure visibilité dans les réponses générées par l’IA. Les organisations qui optimisent à travers texte, image et vidéo voient une amélioration des citations IA, une plus grande visibilité sur des plateformes comme ChatGPT et Gemini, et de meilleures performances globales du contenu.

Suivez les indicateurs clés, y compris la précision à travers les modalités, la qualité du raisonnement intermodal, la latence de traitement, et l’impact commercial (taux de conversion, engagement, etc.). Utilisez des outils comme AmICited.com pour surveiller comment les systèmes d’IA citent votre contenu, et mettez en place des analyses pour comprendre quelles modalités contribuent le plus à vos résultats commerciaux.

Les défis clés incluent l’assurance d’une métadonnée cohérente entre les modalités, le maintien d’un texte alternatif et de légendes de haute qualité, l’alignement des données temporelles dans les vidéos, et la gestion des ressources informatiques requises pour le traitement. Les organisations doivent aussi prévoir la préparation des données (10 à 20 % du budget projet) et la gestion du changement à mesure que les équipes s’adaptent aux nouvelles pratiques d’optimisation.

La santé, la vente au détail, la fabrication, la création de contenu, le service client, l’agriculture et la robotique en tirent tous des avantages significatifs. La santé l’utilise pour l’exactitude des diagnostics, la vente au détail pour la découverte de produits, la fabrication pour le contrôle qualité (catalogage 100 fois plus rapide), et les entreprises de médias rapportent 72 % de ROI sur leurs investissements dans l’IA générative.

AmICited.com surveille comment les systèmes d’IA comme ChatGPT, Perplexity et Google AI Overviews citent votre contenu à travers différentes modalités. Il fournit une visibilité en temps réel sur votre présence dans la recherche IA, vous aidant à comprendre comment vos contenus texte, image et vidéo sont référencés dans les réponses générées par l’IA.

Les architectures unifiées traitent toutes les modalités via un seul réseau intégré, offrant un raisonnement intermodal supérieur mais nécessitant plus de ressources informatiques. Les architectures modulaires maintiennent des réseaux séparés pour chaque modalité, offrant plus de flexibilité et d’efficacité. Les modèles Mixture of Experts (MoE) offrent une approche hybride avec une amélioration de l’efficacité de 30 à 50 %.

Optimisez le texte avec des données structurées et un langage conversationnel, ajoutez un texte alternatif descriptif et des métadonnées aux images, incluez des légendes et des transcriptions pour la vidéo, et utilisez des conventions de nommage de fichiers cohérentes. Assurez-vous que toutes les modalités fonctionnent ensemble pour fournir un contexte complet, et implémentez un balisage de schéma pour aider les systèmes d’IA à comprendre les relations sémantiques.

Suivez comment les systèmes d’IA multimodale citent votre contenu sur ChatGPT, Perplexity, Google AI Overviews et d’autres plateformes. Obtenez une visibilité en temps réel sur votre présence dans la recherche IA.

Découvrez comment les systèmes de recherche IA multimodale traitent ensemble texte, images, audio et vidéo pour fournir des résultats plus précis et contextuell...

Maîtrisez l’optimisation de la recherche IA multimodale. Découvrez comment optimiser images et requêtes vocales pour des résultats de recherche alimentés par l’...

Découvrez ce qu'est le contenu multimodal pour l'IA, comment il fonctionne et pourquoi il est important. Explorez des exemples de systèmes d'IA multimodaux et l...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.