L'IA peut-elle accéder au contenu protégé ? Méthodes et implications

Découvrez comment les systèmes d'IA accèdent au contenu payant et protégé, les techniques qu'ils utilisent, et comment protéger votre contenu tout en maintenant...

Découvrez comment les systèmes d’IA contournent les paywalls et reconstituent des contenus premium. Comprenez l’impact sur le trafic des éditeurs et les stratégies efficaces pour protéger votre visibilité.

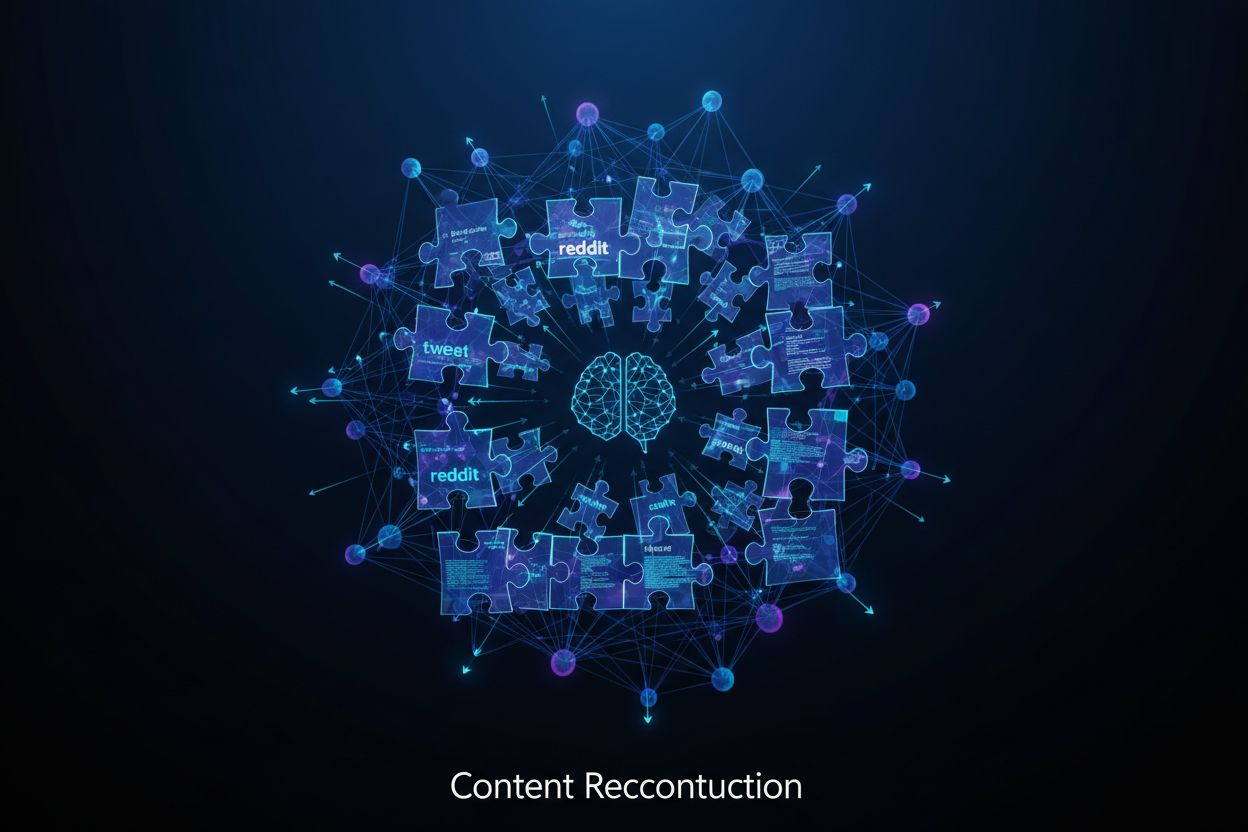

Votre contenu payant n’est pas volé par un accès direct—il est reconstruit à partir de fragments éparpillés sur Internet. Lorsque vous publiez un article, des morceaux finissent inévitablement dans des tweets, des posts LinkedIn, des discussions Reddit et des résumés en cache. Les systèmes d’IA agissent comme des détectives numériques, rassemblant ces fragments et les assemblant en un résumé cohérent qui capte 70 à 80 % de la valeur de votre article sans jamais toucher à vos serveurs. Le chatbot n’a pas besoin de scraper votre site ; il triangule entre déclarations publiques, réactions sur les réseaux sociaux et couverture concurrente pour recomposer votre exclusivité. Cette reconstruction basée sur les fragments est particulièrement efficace pour l’actualité brûlante, où de multiples sources couvrent un même sujet, offrant à l’IA plusieurs angles à synthétiser. Les blocages de bots et les défenses classiques contre les paywalls sont impuissants face à cette approche, car l’IA n’accède jamais directement à votre contenu—elle se contente d’assembler des morceaux publics. Comprendre ce mécanisme est crucial car il explique pourquoi les mesures de sécurité traditionnelles échouent : vous ne combattez pas un scraper, mais un système qui apprend de tout Internet.

Les chiffres racontent une réalité inquiétante sur la façon dont l’IA redessine la visibilité des éditeurs. Partout dans le monde, les éditeurs subissent des baisses de trafic inédites, avec un impact majeur venu des moteurs de recherche et outils de résumé alimentés par l’IA. Le tableau suivant illustre l’ampleur du défi :

| Métrique | Impact | Période |

|---|---|---|

| Perte de trafic des 500 principaux éditeurs | Baisse annuelle de 20-27 % | Depuis février 2024 |

| Visites mensuelles perdues dans le secteur | 64 millions de visites | Impact mensuel moyen |

| Baisse du trafic référent du New York Times | -27,4 % | T2 2025 |

| Baisse du trafic due à Google AI Overviews | Jusqu’à 70 % de perte de trafic | 2025 |

| Référencements mensuels venant de chatbots IA | 25 millions de visites | 2025 (contre 1M début 2024) |

Ce qui rend ces chiffres particulièrement préoccupants, c’est le phénomène de la recherche sans clic—les utilisateurs obtiennent leurs réponses directement via les résumés IA sans jamais visiter la source. Bien que les chatbots IA commencent à générer plus de trafic référent (25 millions par mois en 2025), cela reste faible comparé aux 64 millions de visites perdues chaque mois par les éditeurs. CNBC déclare avoir perdu 10 à 20 % de son trafic issu de la recherche, tandis que le contenu lié aux élections a connu des baisses encore plus marquées. Le problème fondamental : les éditeurs perdent bien plus de trafic que ce que les IA ne génèrent de nouveaux référencements, créant un impact net négatif sur la visibilité et le chiffre d’affaires.

Vos lecteurs ne cherchent pas à contourner sciemment votre paywall—ils ont simplement découvert que l’IA rend cela facile. Comprendre ces quatre méthodes explique pourquoi la protection des paywalls est devenue si complexe :

Demandes de résumé directes : Les utilisateurs demandent à des IA comme ChatGPT ou Claude de résumer des articles payants précis par leur titre ou sujet. L’IA assemble sa réponse à partir de prévisualisations en cache, de commentaires publics, de reprises dans d’autres médias et d’extraits déjà cités, livrant ainsi un résumé complet sans que l’utilisateur ne visite votre site.

Collecte de fragments sur les réseaux sociaux : Des plateformes comme X (Twitter) et Reddit regorgent de captures d’écran, de citations et de paraphrases d’articles payants. Les outils d’IA formés sur ces plateformes y piochent des fragments pour reconstituer fidèlement le message original.

Demandes d’essentiels : Plutôt que de demander un résumé complet, les utilisateurs obtiennent les points clés (“Donne-moi les points principaux du dernier article du WSJ sur l’inflation”), et l’IA génère alors des synthèses précises, surtout si l’article a fait l’objet de discussions en ligne.

Reconstruction de contenus académiques et techniques : Les professionnels demandent fréquemment à l’IA de “recréer l’argumentation” d’articles scientifiques ou techniques verrouillés. L’IA s’appuie sur des résumés, des citations, des publications précédentes et des commentaires pour reconstituer un contenu convaincant.

La plupart des utilisateurs ne considèrent pas cela comme du contournement ou du vol de contenu. Ils voient simplement une façon plus intelligente de s’informer—un seul prompt, une réponse instantanée, sans penser à l’impact sur les abonnements, le trafic ou les éditeurs d’origine.

Les éditeurs ont mis en place des défenses de plus en plus sophistiquées, mais toutes ont des limites majeures. Le blocage des bots a beaucoup évolué, Cloudflare ayant activé par défaut ces blocages sur les nouveaux domaines et développé des modèles de paiement à la consultation pour les entreprises IA. TollBit a signalé 26 millions de tentatives de scraping bloquées en mars 2025, tandis que Cloudflare a observé une hausse du trafic bot de 3 % à 13 % en un trimestre—preuve de l’ampleur du problème et de l’efficacité de certains blocages. Les honeypots IA sont une astuce défensive, attirant les bots sur des pages leurres pour identifier et bloquer des crawlers spécifiques. Certains éditeurs testent le watermarking de contenu et des formulations uniques pour repérer plus facilement les reproductions illicites, d’autres déploient des systèmes de suivi sophistiqués pour surveiller la présence de leur contenu dans les réponses IA. Mais toutes ces mesures ne concernent que le scraping direct, pas la reconstruction par fragments. Le vrai défi demeure : comment protéger un contenu qui doit rester visible pour attirer les lecteurs tout en restant assez caché pour empêcher l’IA de le reconstituer depuis l’espace public ? Aucune solution technique seule n’offre une protection complète, puisque l’IA n’a jamais besoin d’accéder à vos serveurs.

Les éditeurs qui réussissent le mieux abandonnent les modèles dépendants du trafic au profit de relations directes avec des lecteurs fidèles à leur marque. Dotdash Meredith illustre ce succès, avec une croissance de revenus au T1 2024—une exception dans le paysage actuel. Leur PDG Neil Vogel a révélé que la recherche Google ne représente plus qu’un tiers de leur trafic, contre 60 % en 2021. Ce basculement vers la construction d’audience directe les protège des pertes de trafic liées à l’IA qui frappent les concurrents. Ce tournant demande une refonte profonde de la stratégie : au lieu d’optimiser pour les mots-clés ou le potentiel viral, les éditeurs à succès bâtissent la confiance, l’expertise et la communauté autour de leur marque. Ils créent du contenu que les lecteurs recherchent spécifiquement, et pas seulement des découvertes fortuites. Les stratégies d’abonnement évoluent pour intégrer la montée de l’IA, avec des propositions de valeur qu’aucune IA ne peut copier—interviews exclusives, accès en coulisses, fonctionnalités communautaires et expériences personnalisées. The Athletic et The Information en sont des exemples, fidélisant leur base d’abonnés via l’unicité et la communauté plus que par la visibilité SEO. La construction de marque remplace les stratégies SEO intensives comme moteur de croissance, avec des investissements dans l’emailing direct, les programmes de membres et les communautés fermées qui créent des coûts de sortie et un engagement plus fort que n’importe quel trafic issu de la recherche.

Comprendre les différentes implémentations de paywalls est essentiel, car chacune a des implications propres sur la visibilité dans la recherche et la vulnérabilité à l’IA. Les éditeurs utilisent généralement quatre modèles : paywall strict (tout est verrouillé), freemium (une partie gratuite, une partie payante), paywall mesuré (nombre limité d’articles gratuits), et paywall dynamique (quotas personnalisés selon l’utilisateur). Les recherches Google indiquent que les paywalls mesurés et d’accroche sont les plus compatibles avec la visibilité, puisque Googlebot explore sans cookies et voit le contenu lors de la première visite. Les éditeurs doivent ajouter l’attribut structuré isAccessibleForFree (à false) pour informer Google du caractère payant, ainsi que des sélecteurs CSS pour localiser le début du paywall. Les stratégies de détection d’agent utilisateur offrent une protection renforcée, servant un HTML différent aux internautes et à Googlebot, mais doivent être implémentées avec soin pour éviter les sanctions de cloaking. Les paywalls JavaScript sont faciles à contourner en désactivant le JS, tandis que les paywalls qui bloquent tout le contenu empêchent l’indexation complète et entraînent un déclassement faute de signaux de qualité. L’enjeu SEO central est le signal d’engagement “retour à la SERP”—quand un utilisateur revient sur Google après un paywall, Google interprète cela comme une mauvaise expérience, ce qui diminue la visibilité du site sur la durée. Les éditeurs peuvent limiter cet effet en permettant l’accès au premier clic depuis Google ou en utilisant un métrage intelligent qui n’écarte pas le trafic de recherche.

La bataille juridique sur l’IA et les contenus payants se poursuit, avec des conséquences majeures pour les éditeurs. L’affaire New York Times contre OpenAI est la plus médiatisée, centrée sur la question de l’utilisation des contenus éditeurs pour l’entraînement des IA sans compensation ni autorisation. Si l’issue fera jurisprudence, elle met surtout en lumière un problème fondamental : le droit d’auteur n’a pas été conçu pour la reconstruction de contenus à partir de fragments. Certains éditeurs optent pour des accords de licence—ceux conclus avec Associated Press, Future Publishing, etc., montrent que les sociétés d’IA sont prêtes à rémunérer. Mais ces accords ne couvrent qu’une minorité d’éditeurs, laissant la majorité sans protection ni partage de revenus. Les différences réglementaires internationales compliquent la donne, avec des protections très variables d’un pays à l’autre et des IA qui ignorent les frontières. Le défi juridique central est que si l’IA reconstitue votre contenu à partir de fragments publics et non par copie directe, le droit d’auteur classique devient quasi inapplicable. Les éditeurs ne peuvent se permettre d’attendre que la justice rattrape l’IA—les procès durent des années, l’IA évolue en quelques mois. L’approche la plus pragmatique reste donc de mettre en œuvre des stratégies défensives efficaces dès aujourd’hui, en attendant l’évolution du cadre légal.

L’industrie de l’édition atteint un point critique, avec trois scénarios distincts en vue. Dans le scénario de consolidation, seuls les grands éditeurs avec des marques fortes, des revenus diversifiés et des ressources juridiques survivent. Les petits éditeurs, incapables de négocier ou d’assurer leur défense, pourraient disparaître. Le scénario de coexistence rappelle l’évolution de la musique avec le streaming—éditeurs et IA trouvent des accords de licence, permettant à l’IA de fonctionner tout en garantissant une juste compensation. Cela exige coordination sectorielle et pression réglementaire, mais offre une voie durable. Le scénario de disruption est le plus radical : le modèle éditorial classique s’effondre car l’IA ne fait plus que résumer, elle crée le contenu. Les journalistes pourraient devenir concepteurs de prompts ou éditeurs d’IA, les modèles d’abonnement et de publicité s’effaçant. Chaque scénario implique une stratégie différente : la consolidation favorise l’investissement dans la marque et la diversification, la coexistence exige négociation et normalisation, la disruption requiert une innovation radicale du modèle économique. Les éditeurs doivent se préparer à plusieurs avenirs à la fois, en développant l’audience directe, en explorant les licences et en inventant des stratégies de contenu natives pour l’IA.

Les éditeurs doivent pouvoir voir comment l’IA utilise leurs contenus, et plusieurs approches concrètes permettent de repérer les schémas de reconstruction. Le test direct consiste à interroger les outils d’IA avec des titres ou sujets précis pour vérifier s’ils produisent des résumés détaillés—si l’IA parvient à synthétiser fidèlement un contenu payant, c’est sans doute qu’elle le reconstitue depuis des fragments. Repérez les signes révélateurs de reconstruction : des résumés qui reprennent les arguments principaux mais omettent les citations précises, les chiffres exacts ou les informations récentes accessibles seulement dans l’article complet. Les reconstructions IA semblent souvent un peu vagues ou générales comparées à des citations directes. La veille sur les réseaux sociaux permet d’identifier où vos fragments circulent—surveillez les mentions de vos articles sur X, Reddit et LinkedIn pour repérer les sources exploitées par l’IA. La veille de forums IA sur Reddit r/ChatGPT ou des communautés spécialisées montre comment les utilisateurs sollicitent des résumés de vos contenus. Certains éditeurs utilisent des outils de veille légère pour surveiller en continu la présence de leur contenu dans les réponses IA et repérer les tendances. C’est ici qu’AmICited.com devient précieux—il propose une veille complète sur GPT, Perplexity, Google AI Overviews et autres systèmes d’IA, suivant automatiquement la façon dont votre marque et vos contenus sont référencés et reconstruits. Au lieu de tester manuellement chaque outil, AmICited donne aux éditeurs une visibilité en temps réel sur leur exposition à l’IA, montrant comment leur contenu payant est utilisé, résumé et présenté aux utilisateurs dans tout l’écosystème IA. Cette intelligence permet d’ajuster vos stratégies défensives, de négocier des licences et de faire évoluer votre stratégie éditoriale en toute connaissance de cause.

Le test direct consiste à interroger les outils d'IA avec les titres d'articles spécifiques pour voir s'ils génèrent des synthèses détaillées. Repérez les signes révélateurs : des résumés qui reprennent les arguments principaux mais manquent de citations précises, de données exactes, ou d'informations récentes disponibles uniquement dans l'article complet. La veille des réseaux sociaux et la surveillance des forums IA révèlent aussi où apparaissent des fragments de votre contenu et comment les utilisateurs demandent des synthèses.

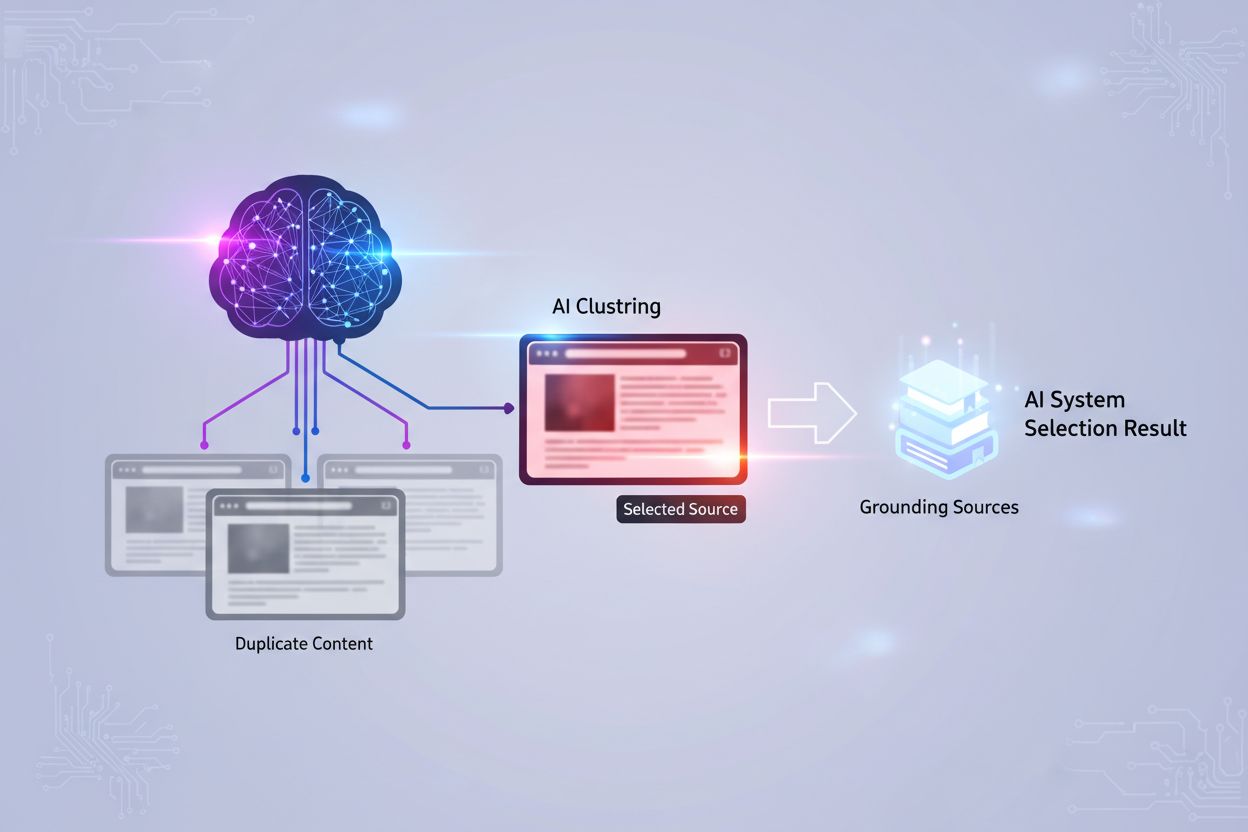

Le scraping implique que les systèmes d'IA accèdent directement à votre contenu et l'extraient, ce qui apparaît dans les logs serveurs et peut être bloqué par des mesures techniques. La reconstruction assemble votre contenu à partir de fragments publics comme des posts sur les réseaux sociaux, des extraits en cache et des articles connexes. L'IA n'accède jamais à vos serveurs, ce qui la rend bien plus difficile à détecter et à empêcher.

Aucune solution technique unique n'offre une protection totale car la reconstruction par l'IA ne nécessite pas d'accès direct à votre contenu. Les défenses traditionnelles comme le blocage des bots aident contre le scraping direct mais offrent une protection limitée contre la reconstruction par fragments. L'approche la plus efficace combine mesures techniques, adaptations de la stratégie de contenu et transformation du modèle économique.

Les recherches de Google indiquent que les paywalls mesurés et d'accroche sont les plus compatibles avec la visibilité sur les moteurs de recherche, car Googlebot explore sans cookies et voit tout le contenu lors de la première visite. Les paywalls stricts et ceux qui verrouillent tout le contenu empêchent Google d'indexer l'intégralité, entraînant un déclassement. Les éditeurs doivent implémenter l'attribut de données structurées isAccessibleForFree pour informer Google du caractère payant du contenu.

Les moteurs de recherche permettent le contournement via les AI Overviews et les résultats sans clic qui répondent aux requêtes des utilisateurs sans générer de trafic vers les sites sources. Toutefois, ils restent une source de trafic majeure pour de nombreux éditeurs. Le défi est de maintenir la visibilité tout en protégeant la valeur du contenu. Les moteurs de recherche développent des programmes de licences et explorent des solutions pour mieux rémunérer les créateurs de contenu.

Les accords de licence avec les sociétés d'IA montrent leur volonté de négocier une compensation. Les accords conclus avec l'Associated Press et Future Publishing illustrent une voie possible. Néanmoins, ces accords ne couvrent actuellement qu'une petite fraction des éditeurs. Les différences réglementaires mondiales ajoutent à la complexité, car les protections varient fortement d'une juridiction à l'autre.

AmICited propose une surveillance complète sur les GPT, Perplexity, Google AI Overviews et d'autres systèmes d'IA, en suivant automatiquement la façon dont votre marque et votre contenu sont référencés et reconstruits. Plutôt que de tester chaque outil manuellement, AmICited offre aux éditeurs une visibilité en temps réel sur leur exposition à l'IA, montrant précisément comment leur contenu payant est utilisé et présenté aux utilisateurs.

Adoptez une approche multicouche : combinez défenses techniques (blocage des bots, paiement par crawl), développez des relations directes avec l'audience, créez du contenu exclusif que l'IA ne peut pas reproduire, surveillez où votre contenu apparaît dans les réponses IA et explorez les opportunités de licence. Misez sur la marque et les abonnements directs plutôt que sur le seul trafic de recherche, afin de vous prémunir contre la perte de trafic induite par l'IA.

Découvrez comment les systèmes d'IA exploitent vos contenus payants et reprenez le contrôle de votre visibilité sur ChatGPT, Perplexity, Google AI Overviews, et plus encore.

Découvrez comment les systèmes d'IA accèdent au contenu payant et protégé, les techniques qu'ils utilisent, et comment protéger votre contenu tout en maintenant...

Découvrez comment optimiser la lisibilité du contenu pour les systèmes d’IA, ChatGPT, Perplexity et les moteurs de recherche IA. Trouvez les meilleures pratique...

Découvrez comment la republication de contenu crée des problèmes de contenu dupliqué qui nuisent à la visibilité dans la recherche IA bien plus sévèrement que d...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.