Comment la recherche par IA évoluera-t-elle en 2026 ?

Découvrez les tendances clés qui façonnent l'évolution de la recherche par IA en 2026, notamment les capacités multimodales, les systèmes agentiques, la récupér...

Découvrez comment optimiser le contenu basé sur les questions pour les systèmes d’IA conversationnelle comme ChatGPT et Perplexity. Découvrez la structure, l’autorité et les stratégies de suivi pour maximiser les citations par l’IA.

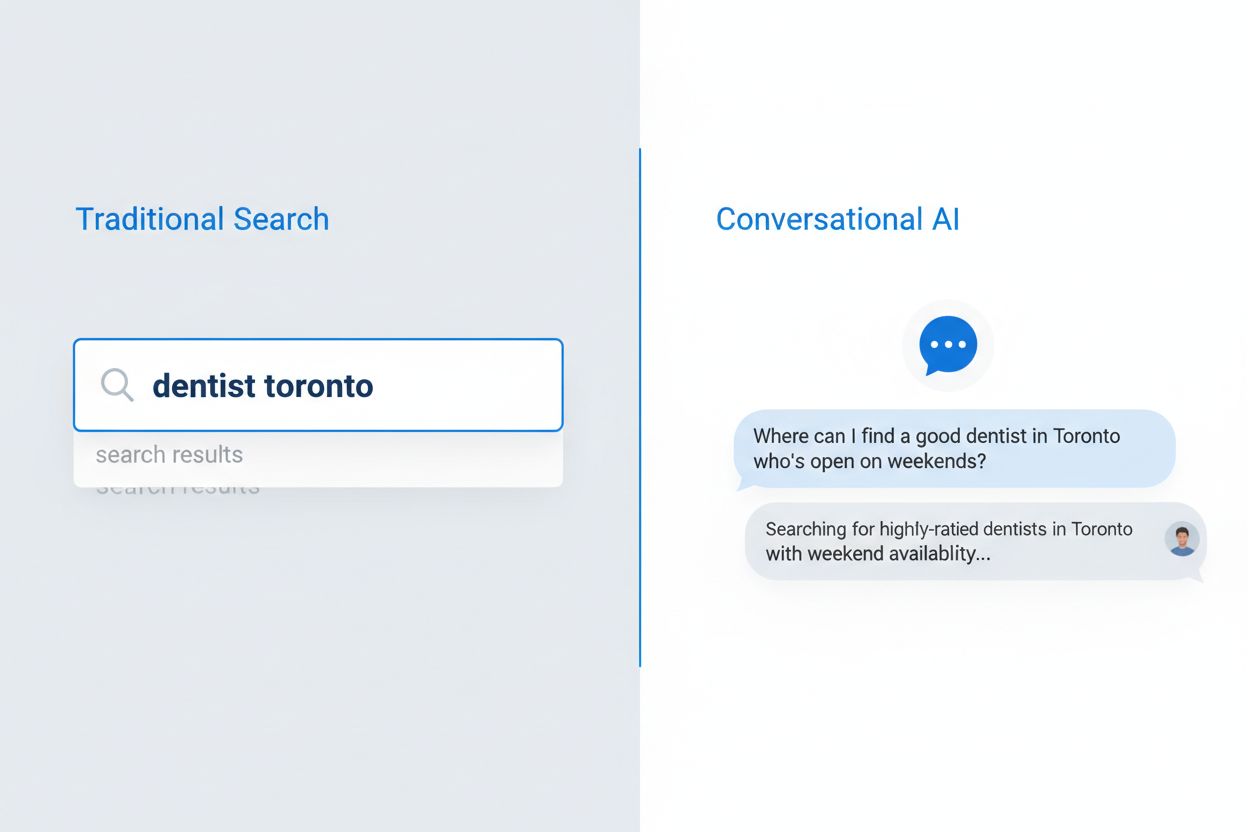

Le comportement des utilisateurs en matière de recherche a profondément changé en cinq ans, délaissant les phrases de mots-clés fragmentées au profit de requêtes naturelles et conversationnelles. Cette évolution s’est accélérée avec l’adoption massive de la recherche vocale, la navigation mobile-first, et les avancées algorithmiques majeures comme les mises à jour BERT et MUM de Google qui privilégient désormais la compréhension sémantique à la simple correspondance de mots-clés. Les utilisateurs ne recherchent plus des termes isolés ; ils posent des questions complètes, reflétant leur façon naturelle de parler et de penser. La différence est frappante :

L’adoption de la recherche vocale a particulièrement pesé, 50 % des recherches étant désormais vocales, forçant moteurs de recherche et IA à s’adapter à des requêtes plus longues et naturelles. Les appareils mobiles sont devenus l’interface de recherche principale, et les requêtes conversationnelles s’y prêtent mieux que la saisie de mots-clés. Les évolutions algorithmiques de Google ont montré que la compréhension de l’intention et du contexte de l’utilisateur prime sur la densité ou l’exactitude des mots-clés, transformant la façon d’écrire et structurer le contenu pour rester visible dans la recherche traditionnelle comme dans les systèmes IA.

La recherche IA conversationnelle représente un paradigme fondamentalement différent de la recherche traditionnelle basée sur les mots-clés, avec des différences nettes dans le traitement des requêtes, la livraison des résultats et l’interprétation de l’intention utilisateur. Là où les moteurs traditionnels retournent une liste de liens classés à parcourir, les IA conversationnelles analysent les requêtes dans leur contexte, récupèrent l’information de multiples sources et synthétisent des réponses complètes en langage naturel. L’architecture technique diffère : la recherche traditionnelle repose sur la correspondance de mots-clés et l’analyse des liens ; l’IA conversationnelle utilise de grands modèles de langage avec génération augmentée par récupération (RAG) pour comprendre la sémantique et générer des réponses contextuelles. Comprendre ces différences est essentiel pour les créateurs désirant la visibilité dans les deux systèmes, car les stratégies d’optimisation divergent sensiblement.

| Dimension | Recherche traditionnelle | IA conversationnelle |

|---|---|---|

| Entrée | Mots-clés ou phrases courts (2-4 mots en moyenne) | Questions complètes et conversationnelles (8-15 mots en moyenne) |

| Sortie | Liste de liens classés à cliquer | Réponse synthétisée avec citations de sources |

| Contexte | Limité aux termes de la requête et à la localisation | Historique complet de la conversation et préférences utilisateur |

| Intention utilisateur | Déduite des mots-clés et clics | Compréhension explicite via le langage naturel |

| Expérience utilisateur | Nécessite de cliquer sur un site externe | Réponse fournie directement dans l’interface |

Cette distinction a de profondes implications pour la stratégie de contenu. En recherche traditionnelle, apparaître dans le top 10 assure la visibilité ; dans l’IA conversationnelle, c’est la sélection comme source citée qui compte. Une page peut bien se positionner sur un mot-clé sans jamais être citée si elle ne répond pas aux critères d’autorité, d’exhaustivité et de clarté de l’IA. Les IA conversationnelles évaluent différemment, privilégiant les réponses directes, la hiérarchie claire de l’information et l’expertise démontrée plutôt que l’optimisation de mots-clés ou les backlinks seuls.

Les grands modèles de langage utilisent la génération augmentée par récupération (RAG) pour choisir le contenu à citer, un processus très différent du classement traditionnel. Lorsqu’un utilisateur pose une question, le LLM récupère d’abord des documents pertinents dans ses données ou sources indexées, puis les évalue selon plusieurs critères avant de décider ceux à citer dans sa réponse. Plusieurs facteurs clés sont prioritaires :

La citation n’est donc pas aléatoire : les LLM citent les sources qui étayent le mieux leurs réponses et affichent de plus en plus ces citations, faisant du choix de la source un enjeu clé pour les créateurs de contenu.

La structure du contenu est devenue un facteur central pour la visibilité IA, mais beaucoup continuent d’optimiser uniquement pour les lecteurs humains sans tenir compte de la façon dont les IA extraient l’information. Les LLM traitent le contenu de façon hiérarchique, s’appuyant sur les titres, les séparations et la mise en forme pour comprendre l’organisation et extraire les passages à citer. La structure optimale pour l’IA suit plusieurs règles : sections de 120 à 180 mots, H2 et H3 indiquant clairement la hiérarchie, réponses directes placées tôt dans chaque section.

Les titres sous forme de question et les sections FAQ sont particulièrement efficaces car ils correspondent exactement à la logique de traitement des IA conversationnelles. Lorsqu’un utilisateur demande « Quelles sont les bonnes pratiques du content marketing ? », une IA peut immédiatement faire le lien avec une section intitulée « Quelles sont les bonnes pratiques du content marketing ? » et extraire le passage pertinent. Cet alignement structurel augmente fortement les chances de citation. Exemple de structure optimale :

## Quelles sont les bonnes pratiques du content marketing ?

### Définir votre audience cible

[120-180 mots de conseils directs répondant à cette question spécifique]

### Créer un calendrier éditorial

[120-180 mots de conseils directs répondant à cette question spécifique]

### Mesurer et optimiser la performance

[120-180 mots de conseils directs répondant à cette question spécifique]

Cette structure permet aux LLM de repérer les sections pertinentes, d’extraire des blocs complets et de citer précisément. Un contenu sans structure claire – paragraphes très longs, réponses enfouies, hiérarchie floue – sera rarement cité, même s’il est de qualité.

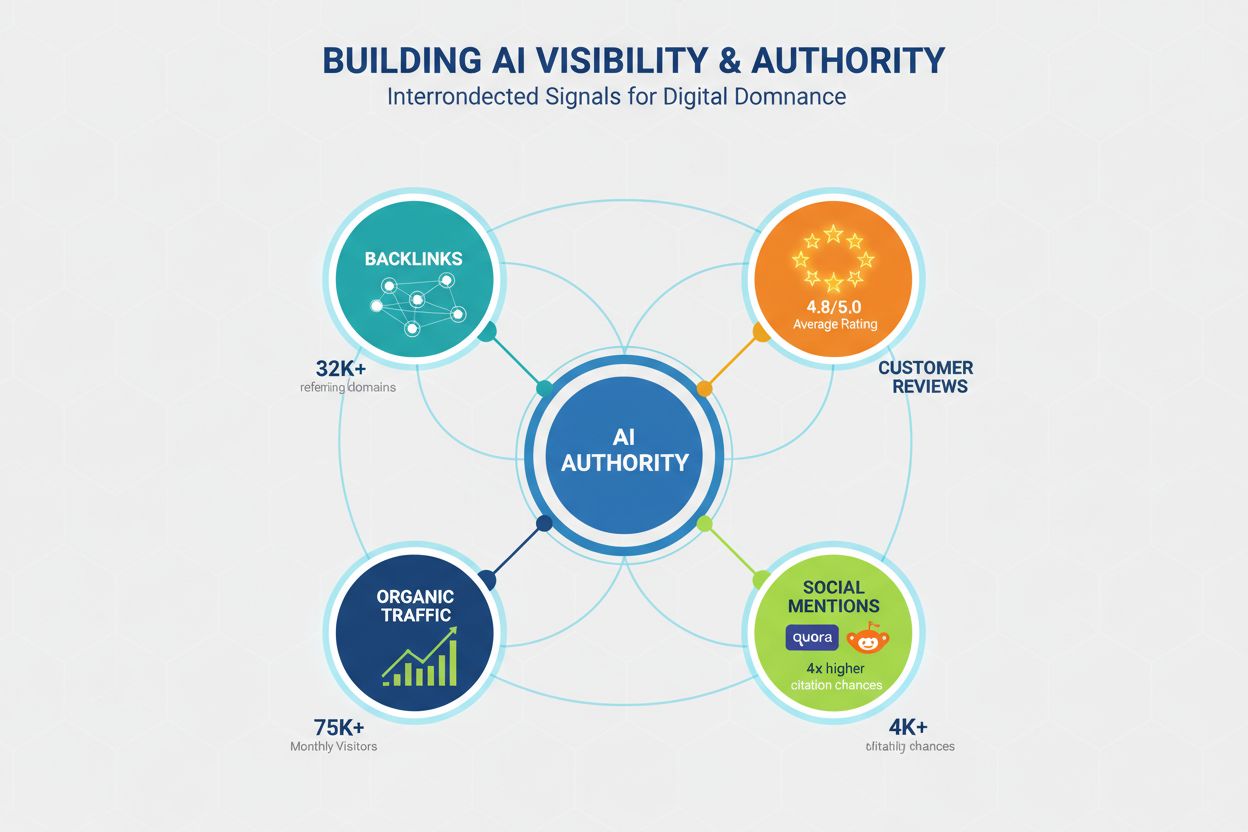

L’autorité demeure cruciale pour la visibilité IA, mais ses signaux vont au-delà des métriques SEO traditionnelles. Les LLM identifient l’autorité via plusieurs canaux ; il faut donc construire sa crédibilité sous différents axes pour maximiser les chances de citation. Les études montrent que les domaines ayant plus de 32 000 domaines référents bénéficient de taux de citation bien supérieurs, et la confiance du domaine (Domain Trust) est fortement corrélée à la visibilité IA. Mais l’autorité ne repose pas uniquement sur les backlinks ; elle englobe :

Construire l’autorité pour la visibilité IA implique donc un travail de fond, mêlant engagement communautaire, gestion des avis, branding et optimisation technique.

La profondeur du contenu est l’un des meilleurs prédicteurs de citation IA : plus la couverture est complète, plus les citations augmentent. Le minimum pour une visibilité compétitive : 1 900 mots environ ; la domination passe par des contenus de 2 900+ mots vraiment complets. Il ne s’agit pas de longueur pour la longueur, mais de richesse d’informations, de données, et de diversité des points de vue.

Les données sont parlantes :

La profondeur est cruciale car les LLM privilégient les réponses complètes et sourcées, recherchant des contenus qui agrègent perspectives, données et avis d’experts.

La fraîcheur du contenu, souvent négligée, est pourtant décisive : un contenu actualisé dans les 3 derniers mois reçoit en moyenne 6,0 citations, contre 3,6 pour un contenu vieux d’un an. Les LLM privilégient les informations récentes, estimant qu’elles sont plus fiables et pertinentes.

Une stratégie de rafraîchissement trimestriel devrait devenir la norme pour viser la visibilité IA. Pas besoin de tout réécrire à chaque fois : il suffit d’ajouter de nouvelles statistiques, d’actualiser des exemples, des études de cas et d’intégrer les nouveautés du secteur. Pour les sujets sensibles à l’actualité (tech, tendances marketing…), une mise à jour mensuelle peut s’avérer nécessaire. Le processus doit inclure :

Un contenu statique finit par perdre sa visibilité IA, même s’il reste pertinent pour les humains, car les LLM considèrent l’information datée comme moins utile.

La performance technique prend de plus en plus d’importance pour la visibilité IA, car les LLM et les systèmes qui les alimentent privilégient les sites rapides et optimisés. Les Core Web Vitals de Google sont fortement corrélés au taux de citation, signe que les LLM tiennent compte de l’expérience utilisateur dans le choix des sources. Exemple : pages avec un First Contentful Paint (FCP) < 0,4 s : 6,7 citations en moyenne, contre 2,1 si FCP > 2,5 s.

L’optimisation technique doit cibler :

La performance technique n’est pas qu’un bonus UX : c’est un signal direct de qualité et de fiabilité pour les IA.

L’optimisation basée sur les questions est la méthode la plus directe pour aligner le contenu sur les recherches IA conversationnelles, avec un effet encore plus marqué pour les petits sites. Les études montrent que les titres sous forme de question ont un impact 7x supérieur pour les domaines de moins de 50 000 visiteurs/mois, et les sections FAQ doublent les chances de citation si elles sont bien construites.

Différence entre titres traditionnels et questionnels :

Mauvais titre : « Top 10 des outils marketing »

Bon titre : « Quels sont les 10 meilleurs outils marketing pour les petites entreprises ? »

Mauvais titre : « Stratégie de content marketing »

Bon titre : « Comment une petite entreprise peut-elle développer une stratégie de content marketing ? »

Mauvais titre : « Bonnes pratiques de l’email marketing »

Bon titre : « Quelles sont les meilleures pratiques d’email marketing pour l’e-commerce ? »

Bonnes pratiques :

L’optimisation par les questions ne vise pas à « tromper » l’IA, mais à structurer le contenu selon la façon dont les utilisateurs posent réellement leurs questions et dont les IA les interprètent.

Beaucoup perdent du temps sur des tactiques inefficaces, voire contre-productives pour la visibilité IA. Par exemple, les fichiers LLMs.txt ont un impact négligeable : les domaines qui en utilisent affichent des taux de citation quasiment identiques (3,8 vs 4,1 en moyenne).

À éviter :

Misez sur la qualité réelle, la structure claire et l’expertise authentique, pas sur les astuces d’optimisation.

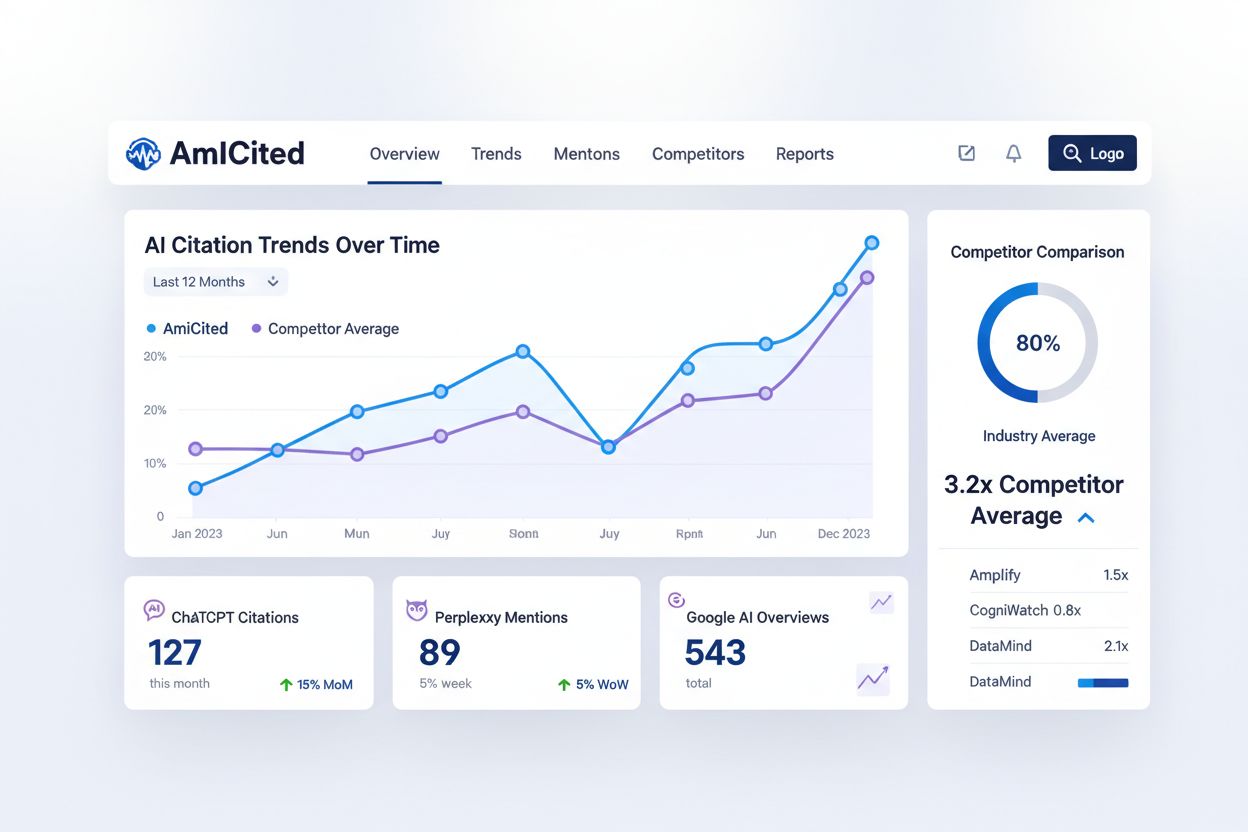

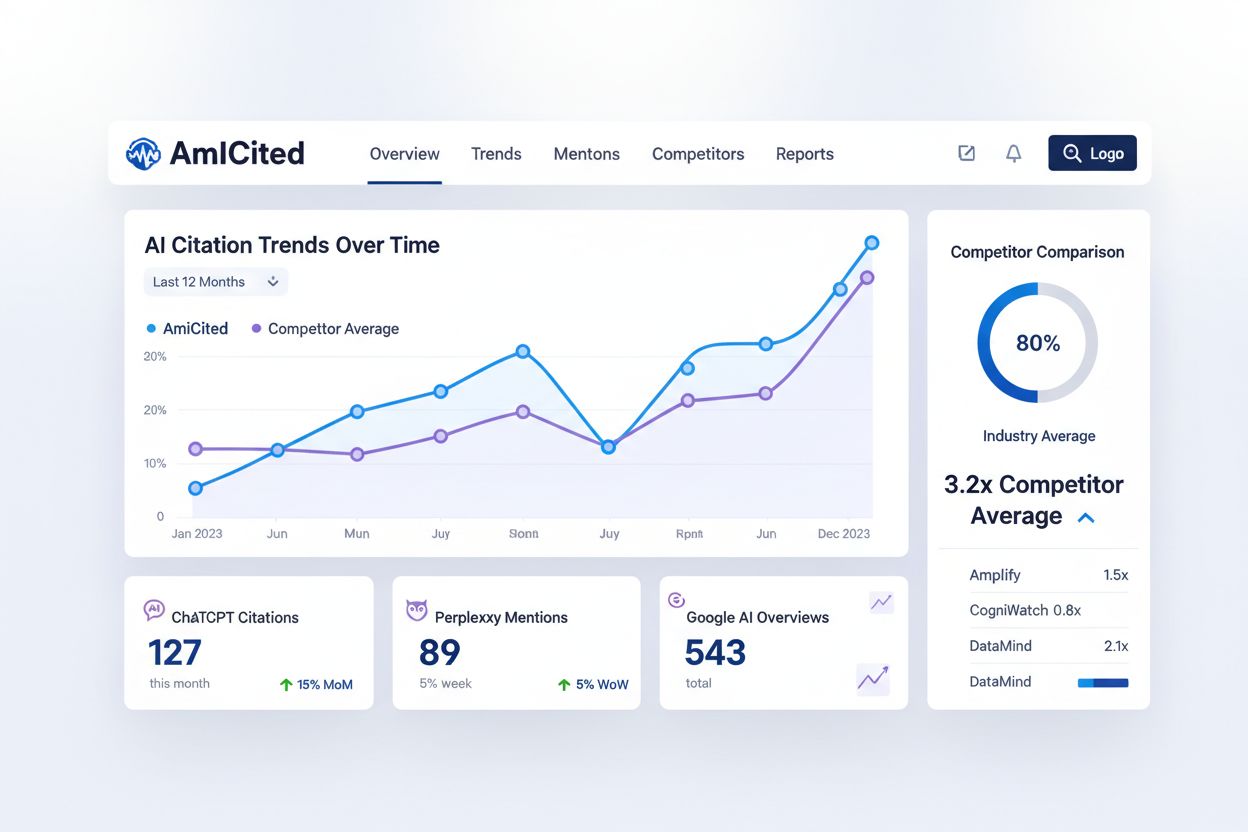

Surveiller comment les IA conversationnelles citent votre contenu est essentiel pour comprendre votre visibilité IA et identifier des pistes d’optimisation, mais la plupart des créateurs n’ont aucune visibilité sur ce point. AmICited.com offre une plateforme dédiée pour suivre les citations de votre marque et vos contenus par ChatGPT, Perplexity, Google AI Overviews, etc. Ce suivi comble une lacune clé des outils SEO traditionnels, en vous éclairant sur ce nouveau paradigme de recherche.

AmICited mesure des indicateurs inédits :

Intégrer AmICited à votre stratégie de suivi vous fournit les données pour optimiser spécifiquement la visibilité IA, sans devoir deviner l’efficacité de vos efforts.

Mettre en place une stratégie de contenu basée sur les questions pour l’IA conversationnelle exige une démarche méthodique, reposant sur l’existant et intégrant de nouvelles pratiques d’optimisation. Le processus doit être structuré et piloté par la donnée, de l’audit au suivi continu, en passant par la restructuration et le renforcement de l’autorité. Ce plan en huit étapes offre une feuille de route concrète :

Cette stratégie transforme votre approche, passant du SEO traditionnel à une optimisation globale pour maximiser la visibilité sur la recherche classique et l’IA conversationnelle.

Le contenu basé sur les questions est un contenu structuré autour de questions en langage naturel que les utilisateurs posent aux systèmes d'IA conversationnelle. Au lieu de cibler des mots-clés comme « dentiste Toronto », il cible des questions complètes comme « Où puis-je trouver un bon dentiste à Toronto ouvert le week-end ? ». Cette approche aligne le contenu sur la façon dont les gens parlent naturellement et la manière dont les IA interprètent les requêtes.

La recherche traditionnelle retourne une liste de liens classés selon la correspondance des mots-clés, tandis que l'IA conversationnelle synthétise des réponses directes à partir de plusieurs sources. L'IA conversationnelle comprend le contexte, maintient l'historique de la conversation et fournit des réponses synthétisées uniques avec des citations. Cette différence fondamentale exige des stratégies d’optimisation de contenu différentes.

Les LLM analysent le contenu de manière hiérarchique en utilisant les structures de titres et les séparations de sections pour comprendre l'organisation de l'information. Une structure optimale avec des sections de 120 à 180 mots, une hiérarchie H2/H3 claire et des réponses directes en début de section facilite l’extraction et la citation du contenu par les IA. Une mauvaise structure réduit la probabilité de citation, quel que soit la qualité du contenu.

Des recherches montrent qu’environ 1 900 mots constituent le seuil minimal pour une visibilité IA compétitive, une couverture vraiment complète atteignant 2 900+ mots. Cependant, la profondeur compte plus que la longueur : un contenu avec des citations d’experts, des données statistiques et des points de vue variés reçoit bien plus de citations qu’un contenu gonflé artificiellement.

Un contenu mis à jour au cours des trois derniers mois obtient en moyenne 6,0 citations, contre 3,6 pour un contenu obsolète. Mettez en place une stratégie de rafraîchissement trimestriel qui ajoute de nouvelles statistiques, met à jour les exemples et intègre les derniers développements. Cela signale la fraîcheur aux IA et maintient la compétitivité en matière de citations.

Oui. Même si les grands domaines bénéficient d’un avantage d’autorité, les petits sites peuvent rivaliser grâce à une meilleure structure de contenu, une optimisation basée sur les questions et l’engagement communautaire. Les titres basés sur des questions ont un impact 7x plus fort pour les petits domaines, et une présence active sur Quora et Reddit multiplie par 4 les chances de citation.

AmICited surveille comment ChatGPT, Perplexity et Google AI Overviews citent votre marque et vos contenus. Il offre une visibilité sur les modèles de citation, identifie les lacunes de contenu, suit la visibilité IA des concurrents et mesure l’impact de vos efforts d’optimisation — des métriques que les outils SEO traditionnels ne fournissent pas.

Non. Si le balisage schema est utile pour la recherche traditionnelle, il apporte peu d’avantages pour la visibilité IA. Un contenu avec schema FAQ reçoit en moyenne 3,6 citations, alors qu’un contenu bien structuré sans schema en reçoit 4,2. Concentrez-vous sur la structure et la qualité réelle du contenu plutôt que sur le balisage seul.

Voyez comment ChatGPT, Perplexity et Google AI Overviews citent votre marque grâce au suivi des citations IA d'AmICited.

Découvrez les tendances clés qui façonnent l'évolution de la recherche par IA en 2026, notamment les capacités multimodales, les systèmes agentiques, la récupér...

Comprenez comment les requêtes conversationnelles diffèrent des requêtes traditionnelles par mots-clés. Découvrez pourquoi les moteurs de recherche IA privilégi...

Découvrez les principaux enseignements des conférences GEO sur l’optimisation de la visibilité des marques dans les moteurs de réponse IA. Apprenez à surveiller...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.