La vision à long terme pour la visibilité de l’IA : où allons-nous ?

Découvrez l’avenir du suivi de la visibilité de l’IA, des standards de transparence à la conformité réglementaire. Apprenez comment les marques peuvent se prépa...

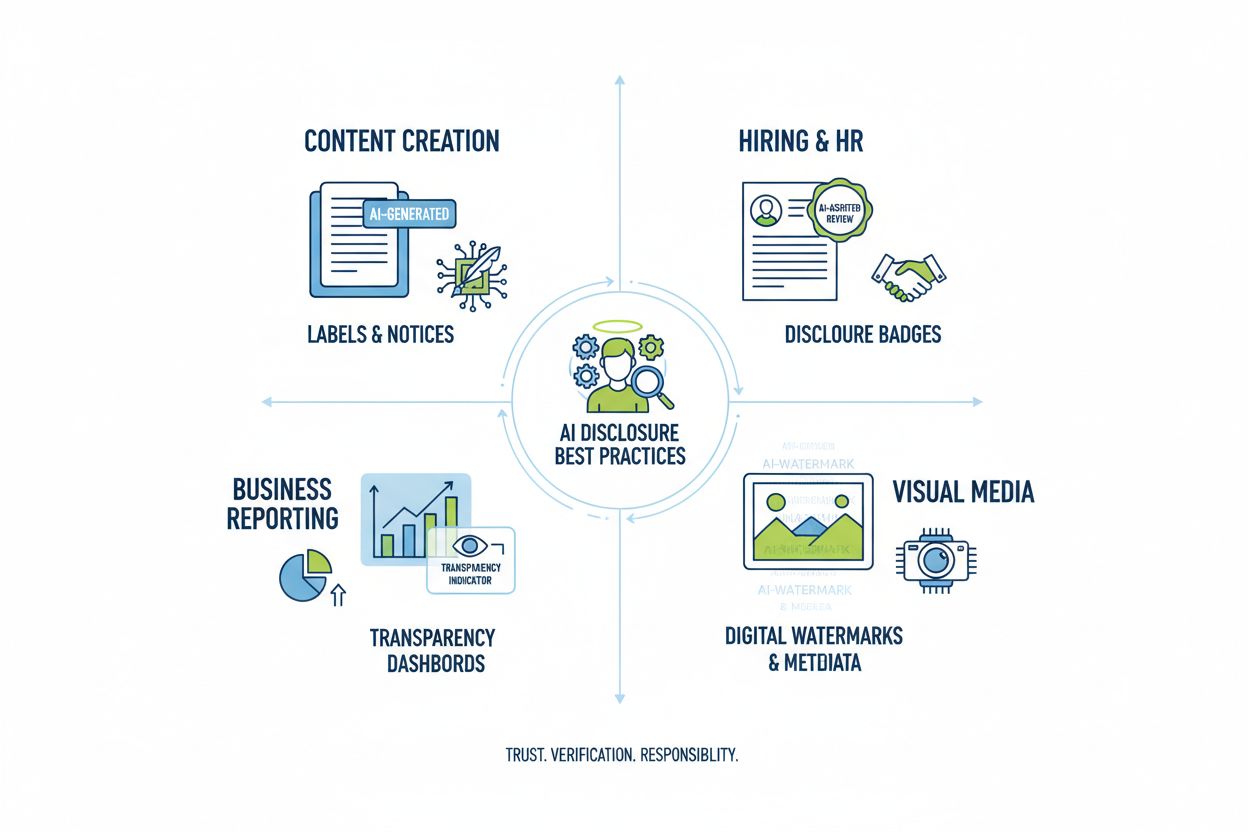

Découvrez les meilleures pratiques essentielles pour la transparence et la divulgation de l’IA. Explorez les méthodes de divulgation comportementale, verbale et technique afin de bâtir la confiance et d’assurer la conformité avec l’évolution des réglementations sur l’IA.

La transparence de l’IA est devenue un impératif crucial à une époque où les systèmes d’intelligence artificielle influencent tout, de la création de contenu aux décisions d’embauche et aux recommandations financières. Alors que le contenu généré par l’IA prolifère sur les plateformes numériques, les organisations subissent une pression croissante pour divulguer quand et comment elles utilisent ces technologies, non seulement en tant qu’obligation légale mais aussi comme condition fondamentale au maintien de la confiance et de la crédibilité auprès de leur public. Les enjeux sont particulièrement élevés pour les marques et les créateurs de contenu, car les consommateurs exigent de plus en plus de savoir si l’information qu’ils consomment provient d’une expertise humaine ou d’une génération algorithmique. Sans pratiques de divulgation transparentes, les organisations risquent d’éroder la confiance acquise au fil des années, avec à la clé des dommages réputationnels, des sanctions réglementaires et une perte de confiance du public. La relation entre transparence et crédibilité est symbiotique : les organisations qui divulguent de façon proactive leur utilisation de l’IA font preuve d’intégrité et de respect envers leurs parties prenantes, se positionnant comme des acteurs honnêtes dans un paysage de plus en plus piloté par l’IA.

La prolifération du contenu généré par l’IA a créé un profond paradoxe de la confiance : les publics peinent à distinguer le travail authentique d’origine humaine des alternatives sophistiquées générées par l’IA, tandis que la transparence sur l’utilisation de l’IA reste inégale selon les secteurs. Cette confusion mine le contrat fondamental entre créateurs et consommateurs, où le public s’attend à connaître la véritable origine du contenu qu’il consulte. Lorsque le contenu généré par l’IA est présenté sans divulgation, cela viole cet accord implicite, créant une dichotomie « réel vs faux » qui va au-delà de la simple question d’authenticité : elle touche à la tromperie, à la manipulation et au consentement éclairé. Le paradoxe s’accentue car certains contenus générés par l’IA peuvent être indiscernables du travail humain en termes de qualité et de style, rendant les indices visuels ou stylistiques peu fiables pour déceler l’origine. La transparence est cruciale précisément parce qu’elle résout ce paradoxe en donnant au public les informations nécessaires pour prendre des décisions éclairées sur le contenu qu’il consomme et auquel il accorde sa confiance. Les organisations qui adoptent des pratiques de divulgation claires transforment le scepticisme potentiel en confiance, démontrant qu’elles n’ont rien à cacher et tout à gagner à communiquer honnêtement.

L’environnement réglementaire autour de la divulgation de l’IA évolue rapidement, avec de multiples juridictions mettant en place ou proposant des exigences que les organisations doivent naviguer avec soin. L’AI Act de l’UE, l’un des cadres les plus complets, impose que le contenu généré ou fortement modifié par l’IA comporte une divulgation visible ou au niveau des métadonnées, avec des exigences spécifiques pour les systèmes d’IA à haut risque et des obligations de transparence pour les développeurs. Aux États-Unis, la FTC a averti que le fait de ne pas mettre à jour les Conditions d’Utilisation et les Politiques de Confidentialité concernant l’IA pourrait être considéré comme une pratique trompeuse, tandis que des réglementations au niveau des États—en particulier la récente AI Frontier Model Law de Californie—imposent des obligations accrues de transparence et de déclaration aux développeurs de grands systèmes d’IA. Les considérations de droit d’auteur et de propriété intellectuelle ajoutent un niveau de complexité supplémentaire, les organisations devant divulguer si les données d’entraînement comprenaient du matériel protégé et comment les systèmes d’IA ont été entraînés. De plus, les exigences du RGPD et du CCPA s’appliquent aux systèmes d’IA traitant des données personnelles, obligeant les organisations à divulguer la prise de décision automatisée et à fournir aux individus des informations significatives sur le traitement par l’IA. Le tableau suivant résume les principales obligations réglementaires selon les grandes juridictions :

| Juridiction | Réglementation | Principales exigences | Date d’entrée en vigueur |

|---|---|---|---|

| Union européenne | AI Act de l’UE | Divulgation pour IA à haut risque ; rapports de transparence ; étiquetage via métadonnées pour contenu généré par l’IA | Progressif (2024-2026) |

| États-Unis (Fédéral) | Directives FTC | Mettre à jour les politiques de confidentialité ; divulguer l’utilisation de l’IA ; éviter les pratiques trompeuses | En cours |

| Californie | AI Frontier Model Law | Divulgation standardisée ; obligations de déclaration ; mesures de sécurité | 2025 |

| Union européenne | RGPD | Divulguer la prise de décision automatisée ; fournir des informations sur le traitement IA | En cours |

| États-Unis (Multi-États) | CCPA & similaires | Divulguer l’utilisation des données dans l’IA ; offrir des options de retrait | Variable selon l’État |

| International | Considérations sur le droit d’auteur | Divulguer les sources des données d’entraînement ; gérer le droit d’auteur dans les productions IA | Émergent |

Les organisations opérant sur plusieurs juridictions doivent mettre en œuvre des pratiques de divulgation répondant aux exigences les plus strictes, car la conformité à une norme dépasse souvent le minimum requis pour les autres.

Les signaux comportementaux représentent la forme de divulgation de l’IA la plus subtile mais aussi la plus puissante, opérant à travers la présentation, le style, la voix et les choix créatifs que le public perçoit inconsciemment lorsqu’il évalue l’authenticité d’un contenu. Ces signaux incluent des motifs distinctifs dans le style d’écriture, la cohérence de la voix, les choix de composition visuelle, les caractéristiques de l’avatar ou du personnage, et le degré de « fidélité » du créateur—c’est-à-dire à quel point le contenu reflète une personnalité et une prise de décision authentiquement humaines. Par exemple, un texte généré par l’IA présente souvent des schémas particuliers dans la structure des phrases, le choix du vocabulaire et la logique qui diffèrent de l’écriture humaine, tandis que les images générées par l’IA peuvent présenter des incohérences subtiles dans l’éclairage, l’anatomie ou les détails en arrière-plan que des observateurs avertis peuvent détecter. Le concept de fidélité du créateur est ici central : le public développe des attentes sur la façon dont un créateur doit s’exprimer, apparaître et se présenter, et tout écart par rapport à ce schéma établi peut signaler l’implication de l’IA. Toutefois, s’appuyer uniquement sur les signaux comportementaux est problématique car les systèmes d’IA s’améliorent rapidement dans l’imitation des caractéristiques humaines, et il n’est pas réaliste d’attendre du public qu’il devienne expert en détection de l’IA. Les signaux comportementaux doivent donc compléter, et non remplacer, les méthodes de divulgation explicite, constituant une couche secondaire de transparence qui renforce plutôt que de se substituer à une communication claire et directe sur l’utilisation de l’IA.

Les stratégies de divulgation verbale offrent une communication explicite et directe sur l’utilisation de l’IA via des signaux linguistiques qui ne laissent aucune ambiguïté quant à l’origine du contenu et à l’implication de l’IA. Ces méthodes sont essentielles car elles créent une trace claire et documentée de la divulgation, assurant que le public reçoive une information non équivoque sur l’usage de l’IA. Les organisations peuvent mettre en œuvre la divulgation verbale par plusieurs approches complémentaires :

La pertinence de chaque méthode dépend du contexte : les étiquettes conviennent bien aux réseaux sociaux et au contenu visuel, les filigranes s’adaptent à la vidéo et à l’audio, les signatures à la presse et à la création, les champs de divulgation servent le contenu long, et les remerciements donnent un contexte complet pour les projets complexes. Les organisations doivent sélectionner des méthodes adaptées au format de leur contenu et aux attentes de leur public, garantissant que la divulgation est impossible à ignorer tout en restant non intrusive pour l’expérience utilisateur.

Les signaux techniques et métadonnées fournissent des informations lisibles par machine, normalisées, sur l’implication de l’IA, permettant la détection, la vérification et le suivi automatisés du contenu généré par l’IA à travers les écosystèmes numériques. Ces méthodes exploitent des données intégrées et des techniques cryptographiques pour créer des traces permanentes et infalsifiables de l’origine du contenu et de son historique de traitement. Les normes IPTC, récemment mises à jour pour inclure des propriétés spécifiques à l’IA, permettent aux créateurs d’intégrer dans les fichiers image des informations structurées sur l’utilisation de l’IA : systèmes utilisés, traitements appliqués, modifications humaines apportées, etc. La C2PA (Coalition for Content Provenance and Authenticity) représente une norme sectorielle émergente utilisant des signatures cryptographiques et des identifiants de contenu pour établir des chaînes de traçabilité vérifiables, permettant au public de remonter le contenu à sa source d’origine et de comprendre toutes les modifications effectuées. Ces approches techniques répondent à une limite majeure de la divulgation lisible par l’humain : elles créent des traces permanentes et vérifiables qui ne peuvent être aisément supprimées ou altérées, et permettent aux systèmes automatisés d’identifier et signaler du contenu généré par l’IA à grande échelle. Les organisations mettant en œuvre la divulgation technique devraient envisager l’adoption des identifiants C2PA pour les contenus à forte valeur, l’intégration des métadonnées IPTC dans les images et médias, et la tenue d’une documentation détaillée des types de sources numériques retraçant l’implication de l’IA à chaque étape du cycle de vie du contenu. L’avantage des signaux techniques est leur permanence et leur vérifiabilité ; le défi consiste à s’assurer que le public et les plateformes comprennent et respectent ces signaux.

Une divulgation efficace de l’IA nécessite d’institutionnaliser les pratiques de transparence tout au long des processus de création, transformant la divulgation d’un ajout tardif en un composant fondamental de la gouvernance du contenu. Les organisations devraient mettre en place des cadres de contenu structurés permettant de capturer l’implication de l’IA à chaque étape—de la recherche initiale à la rédaction, la relecture et la publication—afin que l’information sur la divulgation circule naturellement dans les systèmes de gestion de contenu existants. L’automatisation et l’intégration dans les workflows sont essentielles : les systèmes de gestion de contenu doivent comporter des champs obligatoires pour la divulgation de l’IA, des rappels automatiques exigeant que les créateurs documentent l’utilisation de l’IA avant publication, et des circuits de validation vérifiant l’exhaustivité de la divulgation avant la mise en ligne. Cette approche traite la divulgation comme une exigence d’assurance qualité, à l’image de la vérification des faits, de l’examen juridique ou de la conformité à la marque. Les organisations doivent aussi établir des politiques claires définissant ce qui constitue un usage de l’IA nécessitant une divulgation (ex. : l’utilisation de l’IA pour la recherche doit-elle être divulguée ? Et pour la relecture assistée ?), assurant ainsi la cohérence entre les équipes et évitant les lacunes de divulgation. La formation et la documentation sont tout aussi importantes : les créateurs doivent disposer de directives claires sur la manière de divulguer l’usage de l’IA selon les types de contenu et plateformes. En intégrant la divulgation dans les modèles et workflows de contenu, les organisations transforment la transparence d’une contrainte de conformité en une procédure standard qui protège à la fois l’organisation et son public.

Différentes applications de l’IA nécessitent des approches de divulgation adaptées au contexte, aux attentes du public et aux exigences réglementaires. Pour la création de contenu (articles, réseaux sociaux, rédaction marketing), il convient d’ajouter des étiquettes claires ou de modifier la signature pour indiquer l’implication de l’IA, avec des champs de divulgation précisant les outils utilisés et la supervision humaine appliquée ; ceci est particulièrement crucial pour l’actualité et l’éditorial, où la confiance du public dépend de l’origine du contenu. Dans le recrutement, la divulgation doit être la plus rigoureuse, les candidats ayant le droit de savoir quand l’IA évalue leurs candidatures ou procède à un premier tri, avec des explications détaillées sur la prise de décision IA et les processus de relecture humaine. Pour les rapports et analyses (rapports financiers, études de marché, analyses de données), il faut inclure des divulgations techniques et des métadonnées indiquant quelles analyses ont été assistées par l’IA, en particulier lorsque des systèmes d’IA ont identifié des tendances ou généré des insights influençant les conclusions. Pour le contenu visuel (images, vidéos, graphiques), il est nécessaire d’apposer à la fois des filigranes visibles et d’ajouter la divulgation dans les métadonnées, le public ne pouvant distinguer de façon fiable le visuel généré par IA du contenu authentique ; ceci est crucial pour la photographie d’actualité, les images produits, et tout contenu où l’authenticité influe sur l’achat ou la confiance. Pour les communications clients (chatbots, réponses automatiques, service client), il faut clairement signaler l’implication de l’IA dès le début de l’interaction, permettant au client de demander une assistance humaine si désiré. Les organisations doivent auditer leurs usages de l’IA dans ces différents contextes et appliquer des pratiques de divulgation proportionnées à la sensibilité et à l’impact de chaque cas d’usage, en reconnaissant que les exigences de transparence varient selon l’impact des décisions IA sur le public.

L’avenir de la divulgation de l’IA dépend de la standardisation sectorielle et du développement de cadres interopérables permettant une transparence cohérente et comparable entre organisations et plateformes. Les normes émergentes comme la C2PA, les spécifications de métadonnées IPTC et le cadre de gestion des risques IA du NIST fournissent des bases solides, mais leur large adoption exige des efforts coordonnés de la part des plateformes technologiques, des créateurs de contenu, des régulateurs et des organismes professionnels. L’AI Act de l’UE et d’autres cadres réglementaires similaires accélèrent la standardisation en imposant des formats de divulgation précis et des catégories d’information, créant une pression pour l’adoption sectorielle de standards communs plutôt que d’approches disparates. Les initiatives sectorielles telles que les lignes directrices éthiques de la PRSA sur l’IA et les différents cadres de rapports de transparence témoignent d’un consensus croissant sur les meilleures pratiques, même si l’adoption reste inégale tant qu’elle est volontaire. La prochaine étape essentielle consiste à passer de standards volontaires à des obligations réglementaires imposant la divulgation normalisée, à l’image de l’étiquetage nutritionnel standardisé par la FDA pour l’alimentation. Les plateformes de surveillance et de visibilité—comme AmICited.com—jouent un rôle de plus en plus important en suivant la façon dont l’IA référence les marques et contenus dans les réponses générées, donnant aux organisations de la visibilité sur la façon dont leur travail apparaît dans les productions IA et si l’attribution et la divulgation sont correctement respectées. À mesure que l’IA devient plus sophistiquée et omniprésente, la capacité à surveiller, vérifier et auditer les pratiques de divulgation devient essentielle pour maintenir la confiance dans les écosystèmes d’information numériques. Les organisations qui investissent dès aujourd’hui dans des pratiques robustes de divulgation et des capacités de suivi seront les mieux placées pour naviguer dans un paysage réglementaire en mutation et conserver la confiance du public dans un avenir piloté par l’IA.

La divulgation comportementale utilise des choix de présentation (style, voix, avatar) pour signaler l'implication de l'IA. La divulgation verbale repose sur des déclarations explicites, des étiquettes et des filigranes. La divulgation technique intègre des métadonnées lisibles par machine et des signatures cryptographiques. Chaque méthode s'adresse à des publics et à des contextes différents, et les organisations devraient combiner plusieurs méthodes ensemble pour une transparence complète.

Les exigences légales varient selon la juridiction. L'AI Act de l'UE impose la divulgation pour les systèmes d'IA à haut risque. La FTC exige une divulgation lorsque l'utilisation de l'IA peut influencer les décisions des consommateurs. Des lois d'État comme la California AI Frontier Model Law imposent des obligations de déclaration. Le droit d'auteur requiert la divulgation du contenu généré par l'IA. Les organisations devraient consulter un conseil juridique pour connaître les obligations spécifiques à leur juridiction.

Les images générées par l'IA doivent inclure à la fois des filigranes visuels et une divulgation via les métadonnées. Les filigranes visuels doivent être visibles mais non intrusifs, indiquant clairement la génération par IA. Les métadonnées doivent inclure le type de source numérique IPTC et les identifiants C2PA lorsque disponibles. Les légendes et champs de divulgation doivent clairement indiquer que les images sont générées par l'IA, en particulier pour les contenus d'information, de produit ou promotionnels.

Les normes IPTC fournissent des champs de métadonnées structurés pour documenter l'utilisation de l'IA dans les images et fichiers médias. Elles permettent la détection et le suivi automatisés du contenu généré par l'IA sur différentes plateformes. Les catégories de type de source numérique IPTC incluent « Trained Algorithmic Media », « Composite Synthetic » et « Algorithmic Media ». Ces normes sont importantes car elles créent des traces permanentes et vérifiables de l'implication de l'IA, qui ne peuvent être facilement supprimées ou modifiées.

Les entreprises devraient réaliser un audit de l'IA pour identifier tous les cas d'usage, mettre en œuvre des politiques de divulgation conformes aux réglementations applicables, intégrer la divulgation dans les processus de gestion de contenu, former les équipes aux exigences et surveiller régulièrement la conformité. Il est essentiel de consulter des experts juridiques familiers avec la réglementation IA de votre juridiction, car les exigences varient considérablement selon les régions.

Les conséquences incluent des sanctions réglementaires (amendes FTC, violations des lois d'État), des dommages à la réputation et à la confiance du public, une responsabilité légale pour violation du droit d'auteur ou pratiques trompeuses, ainsi que des poursuites potentielles de la part des parties affectées. Les organisations qui omettent de divulguer l'utilisation de l'IA risquent de perdre la crédibilité acquise au fil des années, faisant de la divulgation proactive un investissement stratégique dans la confiance à long terme.

Différentes parties prenantes ont besoin de niveaux d'information différents. Le grand public a besoin de messages simples et clairs sur l'implication de l'IA. Les régulateurs demandent une documentation technique détaillée et des preuves de conformité. Les journalistes et créateurs de contenu ont besoin d'informations précises sur les outils d'IA et la supervision humaine. Les clients doivent comprendre l'impact de l'IA sur leur expérience. Il faut adapter le format et le niveau de détail de la divulgation aux besoins et attentes de chaque public.

C2PA (Coalition for Content Provenance and Authenticity) fournit des identifiants cryptographiques pour la vérification du contenu. Les normes IPTC permettent d'intégrer des métadonnées dans les images. Les systèmes de gestion de contenu incluent de plus en plus des champs dédiés à la divulgation de l'IA. Des plateformes de veille comme AmICited.com suivent les références à l'IA et la visibilité. Des cadres sectoriels proposés par la PRSA, le NIST et d'autres offrent des lignes directrices. L'adoption de ces outils et normes s'accélère à mesure que la réglementation se durcit.

Suivez comment les systèmes d'IA référencent votre marque à travers les GPT, Perplexity et Google AI Overviews. Assurez-vous que votre contenu reçoit l'attribution et la visibilité appropriées dans les réponses générées par l'IA.

Découvrez l’avenir du suivi de la visibilité de l’IA, des standards de transparence à la conformité réglementaire. Apprenez comment les marques peuvent se prépa...

Découvrez comment choisir la bonne plateforme de suivi de la visibilité IA pour votre marque. Comparez les fonctionnalités, les tarifs et les capacités pour sui...

Découvrez comment créer une feuille de route pour la visibilité IA avec des objectifs trimestriels et des jalons GEO. Obtenez un modèle, les meilleures pratique...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.