Robots.txt pour l'IA : Comment contrôler quels bots accèdent à votre contenu

Découvrez comment utiliser robots.txt pour contrôler quels bots d'IA accèdent à votre contenu. Guide complet pour bloquer GPTBot, ClaudeBot et d'autres crawlers...

Découvrez comment les pare-feux applicatifs web offrent un contrôle avancé sur les crawlers IA au-delà du robots.txt. Mettez en place des règles WAF pour protéger votre contenu contre le scraping IA non autorisé et surveillez les citations IA avec AmICited.

L’insuffisance du robots.txt en tant que mécanisme de défense autonome devient de plus en plus évidente à l’ère de la consommation de contenu pilotée par l’IA. Alors que les moteurs de recherche traditionnels respectent généralement les directives du robots.txt, les crawlers IA modernes fonctionnent avec des incitations et des mécanismes d’application fondamentalement différents, rendant les politiques textuelles simples insuffisantes pour protéger le contenu. Selon l’analyse de Cloudflare, les crawlers IA représentent désormais près de 80 % du trafic bot sur les sites web, avec des crawlers d’entraînement consommant d’énormes quantités de contenu tout en ramenant très peu de trafic référent—les crawlers d’OpenAI maintiennent un ratio crawl/référent de 400:1, celui d’Anthropic atteignant jusqu’à 38 000:1. Pour les éditeurs et propriétaires de contenu, cette relation asymétrique représente une menace commerciale critique, car les modèles IA entraînés sur leur contenu peuvent réduire directement le trafic organique et diminuer la valeur de leur propriété intellectuelle.

Un pare-feu applicatif web (WAF) fonctionne comme un proxy inverse placé entre les utilisateurs et les serveurs web, inspectant chaque requête HTTP en temps réel afin de filtrer le trafic indésirable selon des règles configurables. Contrairement au robots.txt, qui repose sur le respect volontaire des crawlers, les WAF appliquent la protection au niveau de l’infrastructure, ce qui les rend nettement plus efficaces pour contrôler l’accès des crawlers IA. La comparaison suivante illustre comment les WAF diffèrent des approches de sécurité traditionnelles :

| Fonctionnalité | Robots.txt | Pare-feu traditionnel | WAF moderne |

|---|---|---|---|

| Niveau d’application | Consultatif/volontaire | Blocage IP | Inspection orientée application |

| Détection de crawler IA | Uniquement correspondance user-agent | Reconnaissance limitée de bots | Analyse comportementale + empreinte digitale |

| Adaptation en temps réel | Fichier statique | Mises à jour manuelles requises | Renseignement sur les menaces en continu |

| Contrôle granulaire | Uniquement au niveau du chemin | Plages IP larges | Politiques au niveau de la requête |

| Machine learning | Aucun | Aucun | Classification avancée de bots |

Les WAF offrent une classification granulaire des bots grâce à l’empreinte digitale, l’analyse comportementale et le machine learning pour profiler les bots selon leur intention et leur sophistication, permettant un contrôle bien plus nuancé que de simples règles autoriser/refuser.

Les crawlers IA se divisent en trois catégories distinctes, chacune présentant des menaces différentes et nécessitant des stratégies d’atténuation adaptées. Les crawlers d’entraînement comme GPTBot, ClaudeBot et Google-Extended collectent systématiquement le contenu web pour constituer des jeux de données à destination des grands modèles de langage, représentant environ 80 % du trafic des crawlers IA et ne rapportant aucune valeur référente aux éditeurs. Les crawlers de recherche et de citation tels que OAI-SearchBot et PerplexityBot indexent le contenu pour des expériences de recherche enrichies par l’IA et peuvent fournir du trafic référent via des citations, mais à des volumes bien moindres que les moteurs de recherche classiques. Les fetchers activés par l’utilisateur ne s’activent que lorsque les utilisateurs demandent spécifiquement du contenu via des assistants IA, opérant à un volume minimal avec des requêtes ponctuelles plutôt qu’avec des schémas de crawling systématique. Le panorama des menaces inclut :

Les WAF modernes emploient des méthodes de détection technique sophistiquées qui vont bien au-delà de la simple correspondance de chaînes user-agent pour identifier et classifier les crawlers IA avec une grande précision. Ces systèmes utilisent l’analyse comportementale pour examiner les schémas de requêtes, notamment la vélocité de crawl, la séquence des requêtes et les caractéristiques de gestion des réponses qui différencient les bots des utilisateurs humains. Les techniques d’empreinte digitale analysent les en-têtes HTTP, signatures TLS et caractéristiques du navigateur afin d’identifier les user-agents usurpés tentant de contourner les défenses classiques. Les modèles de machine learning entraînés sur des millions de requêtes détectent en temps réel de nouveaux schémas de crawl et tactiques de bots, s’adaptant aux menaces émergentes sans nécessiter de mises à jour manuelles des règles. De plus, les WAF peuvent vérifier la légitimité des crawlers en recoupant les adresses IP des requêtes avec les plages IP publiées par les grandes entreprises d’IA—OpenAI publie des IP vérifiées sur https://openai.com/gptbot.json, tandis qu’Amazon fournit les siennes sur https://developer.amazon.com/amazonbot/ip-addresses/—garantissant que seuls les crawlers authentifiés issus de sources légitimes sont autorisés.

Mettre en place des règles WAF efficaces pour les crawlers IA nécessite une approche multi-couche combinant blocage user-agent, vérification IP et politiques comportementales. L’exemple de code suivant montre une configuration WAF basique qui bloque les crawlers d’entraînement connus tout en autorisant la recherche légitime :

# Règle WAF : Bloquer les crawlers d’entraînement IA

Nom de la règle : Block-AI-Training-Crawlers

Condition 1 : HTTP User-Agent correspond à (GPTBot|ClaudeBot|anthropic-ai|Google-Extended|Meta-ExternalAgent|Amazonbot|CCBot|Bytespider)

Action : Bloquer (retourner 403 Forbidden)

# Règle WAF : Autoriser les crawlers de recherche vérifiés

Nom de la règle : Allow-Verified-Search-Crawlers

Condition 1 : HTTP User-Agent correspond à (OAI-SearchBot|PerplexityBot)

Condition 2 : IP source dans la plage IP vérifiée

Action : Autoriser

# Règle WAF : Limiter le trafic bot suspect

Nom de la règle : Rate-Limit-Suspicious-Bots

Condition 1 : Taux de requêtes supérieur à 100 requêtes/minute

Condition 2 : User-Agent contient un indicateur de bot

Condition 3 : Pas de correspondance IP vérifiée

Action : Challenge (CAPTCHA) ou Blocage

Les organisations doivent gérer la priorité des règles avec soin, en s’assurant que les règles les plus spécifiques (comme la vérification IP pour les crawlers légitimes) s’exécutent avant les règles de blocage plus larges. Des tests et une surveillance régulière de l’efficacité des règles sont essentiels, car les user-agents et plages IP des crawlers évoluent fréquemment. De nombreux fournisseurs WAF proposent des ensembles de règles pré-construites spécialement conçus pour la gestion des crawlers IA, réduisant la complexité d’implémentation tout en maintenant une protection complète.

La vérification IP et la mise en liste blanche constituent la méthode la plus fiable pour distinguer les crawlers IA légitimes des requêtes usurpées, car les user-agents peuvent être facilement falsifiés tandis que les adresses IP sont bien plus difficiles à usurper à grande échelle. Les grandes entreprises d’IA publient leurs plages IP officielles au format JSON, permettant une vérification automatisée sans maintenance manuelle—OpenAI fournit des listes IP séparées pour GPTBot, OAI-SearchBot et ChatGPT-User, tandis qu’Amazon maintient une liste complète pour Amazonbot. Les règles WAF peuvent être configurées pour n’autoriser que les requêtes provenant de ces plages IP vérifiées, empêchant ainsi les acteurs malveillants de contourner les restrictions en modifiant simplement leur user-agent. Pour les organisations utilisant un blocage au niveau serveur via .htaccess ou des règles de pare-feu, combiner la vérification IP et la correspondance user-agent offre une défense en profondeur indépendante de la configuration WAF. De plus, certains crawlers respectent les balises meta HTML telles que <meta name="robots" content="noarchive">, qui signalent aux crawlers conformes que le contenu ne doit pas être utilisé pour l’entraînement de modèles, offrant un contrôle supplémentaire aux éditeurs souhaitant une protection fine au niveau de la page.

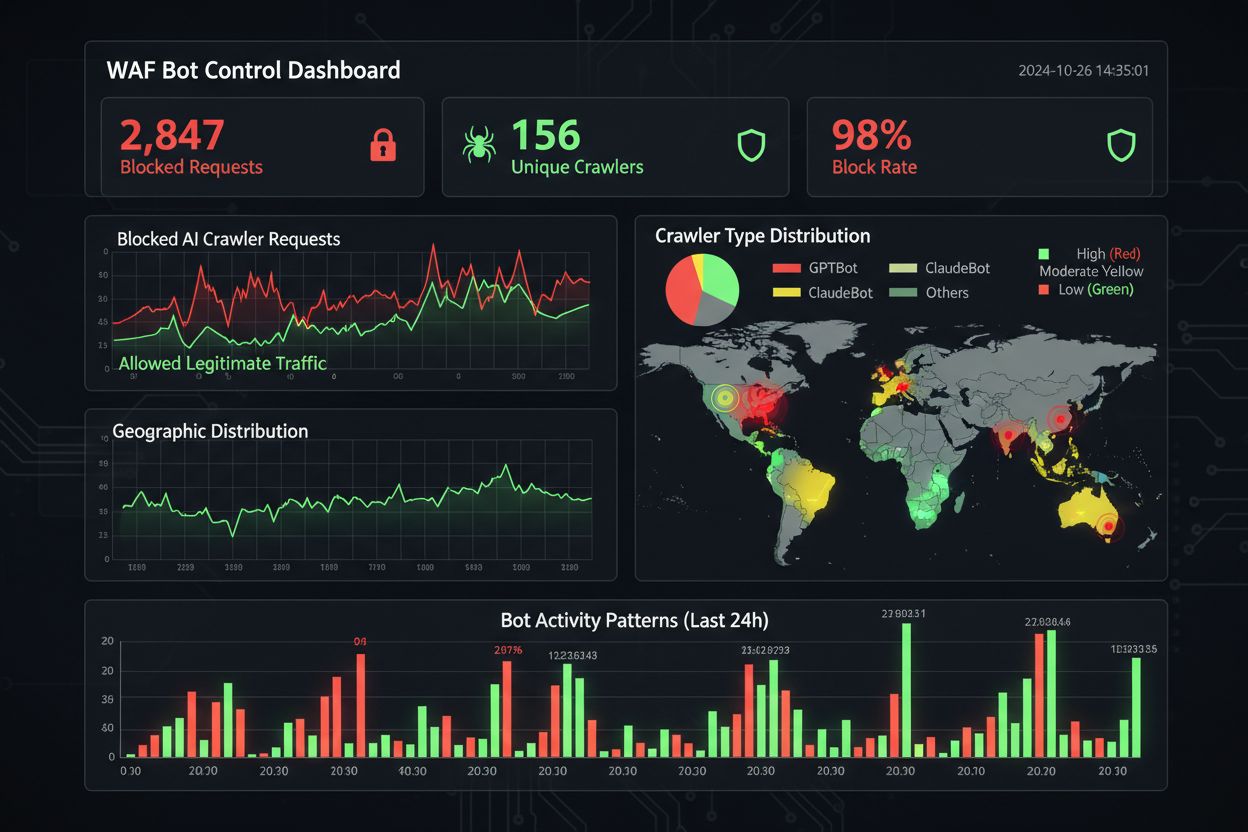

Une surveillance et conformité efficaces nécessitent une visibilité continue sur l’activité des crawlers et la vérification du bon fonctionnement des règles de blocage. Les organisations doivent analyser régulièrement les logs d’accès serveur pour identifier quels crawlers accèdent à leurs sites et si des crawlers bloqués continuent de faire des requêtes—les logs Apache se trouvent généralement dans /var/log/apache2/access.log et ceux de Nginx dans /var/log/nginx/access.log, et un filtrage via grep permet d’identifier rapidement les schémas suspects. Les plateformes d’analytique différencient de plus en plus le trafic bot du trafic humain, permettant de mesurer l’impact du blocage des crawlers sur des métriques légitimes comme le taux de rebond, le suivi des conversions et la performance SEO. Des outils comme Cloudflare Radar offrent une visibilité globale sur les flux de bots IA et permettent d’identifier de nouveaux crawlers non encore présents dans votre liste de blocage. D’un point de vue conformité, les logs WAF génèrent des traces d’audit démontrant que l’organisation a mis en œuvre des mesures de sécurité raisonnables pour protéger les données clients et la propriété intellectuelle, ce qui devient essentiel pour le RGPD, la CCPA et d’autres réglementations sur la protection des données. Des revues trimestrielles de votre liste de blocage des crawlers sont indispensables, car de nouveaux crawlers IA apparaissent régulièrement et les existants modifient leurs user-agents—le projet communautaire ai.robots.txt sur GitHub

constitue une ressource précieuse pour suivre les menaces émergentes.

Équilibrer la protection du contenu et les objectifs business requiert une analyse attentive des crawlers à bloquer ou à autoriser, car un blocage trop agressif peut réduire la visibilité dans les nouveaux canaux de découverte pilotés par l’IA. Bloquer les crawlers d’entraînement comme GPTBot et ClaudeBot protège la propriété intellectuelle sans impact direct sur le trafic, car ces crawlers n’envoient jamais de trafic référent. En revanche, bloquer les crawlers de recherche comme OAI-SearchBot et PerplexityBot peut diminuer la visibilité dans les résultats de recherche enrichis par l’IA, où les utilisateurs recherchent activement des citations et sources—un compromis qui dépend de votre stratégie de contenu et de votre audience. Certains éditeurs explorent des approches alternatives, comme autoriser les crawlers de recherche tout en bloquant ceux d’entraînement, ou la mise en place de modèles de paiement par crawl où les entreprises IA rémunèrent les éditeurs pour l’accès au contenu. Des outils comme AmICited.com aident les éditeurs à vérifier si leur contenu est cité dans les réponses générées par IA, fournissant des données pour guider les décisions de blocage. La configuration WAF optimale dépend de votre modèle économique : les éditeurs d’actualités peuvent privilégier le blocage des crawlers d’entraînement pour protéger leur contenu tout en autorisant les crawlers de recherche pour la visibilité, tandis que les entreprises SaaS pourraient bloquer tous les crawlers IA pour empêcher les concurrents d’analyser prix et fonctionnalités. Une surveillance régulière des schémas de trafic et des métriques de revenus après la mise en place des règles WAF garantit que votre stratégie de protection reste alignée sur les résultats business réels.

Lors de la comparaison des solutions WAF pour la gestion des crawlers IA, les organisations doivent évaluer plusieurs capacités clés qui distinguent les plateformes de niveau entreprise des offres basiques. AI Crawl Control de Cloudflare s’intègre à son WAF pour offrir des règles préconstruites pour les crawlers IA connus, avec la possibilité de bloquer, autoriser ou monétiser via paiement par crawl pour des crawlers spécifiques—l’ordre de priorité de la plateforme assure que les règles WAF s’exécutent avant les autres couches de sécurité. AWS WAF Bot Control propose des niveaux de protection basique et ciblée, ce dernier utilisant l’interrogation du navigateur, l’empreinte digitale et des heuristiques comportementales pour détecter les bots sophistiqués qui ne s’identifient pas, avec en option une analyse machine learning des statistiques de trafic. Azure WAF propose des fonctionnalités similaires via ses ensembles de règles gérés, bien que moins spécialisées IA que Cloudflare ou AWS. Au-delà de ces grandes plateformes, des solutions spécialisées de gestion de bots comme DataDome offrent des modèles machine learning avancés entraînés spécifiquement sur le comportement des crawlers IA, mais à un coût plus élevé. Le choix dépend de votre infrastructure existante, budget et niveau de sophistication requis—les organisations déjà clientes Cloudflare bénéficient d’une intégration transparente, tandis que les clients AWS peuvent exploiter Bot Control au sein de leur infrastructure WAF actuelle.

Les bonnes pratiques pour la gestion des crawlers IA recommandent une défense en profondeur, combinant plusieurs mécanismes de contrôle plutôt que de s’appuyer sur une solution unique. Les organisations doivent procéder à des revues trimestrielles de listes de blocage pour repérer de nouveaux crawlers et user-agents mis à jour, maintenir une analyse des logs serveur pour vérifier que les crawlers bloqués ne contournent pas les règles, et tester régulièrement la configuration du WAF pour s’assurer de la bonne exécution des règles. L’avenir des technologies WAF intégrera de plus en plus une détection des menaces pilotée par IA, s’adaptant en temps réel aux nouvelles tactiques de crawlers, avec une intégration dans des écosystèmes de sécurité plus larges pour une protection contextuelle. À mesure que les réglementations se durcissent sur le scraping de données et l’utilisation des données pour l’entraînement IA, les WAF deviendront des outils de conformité essentiels plus que de simples solutions de sécurité optionnelles. Les organisations doivent commencer dès maintenant à implémenter des règles WAF complètes pour les crawlers IA, avant que de nouvelles menaces telles que les agents IA sur navigateur et les crawlers headless ne se généralisent—le coût de l’inaction, mesuré en perte de trafic, analyses compromises et exposition légale potentielle, dépasse largement l’investissement requis pour une infrastructure de protection robuste.

Robots.txt est un fichier consultatif qui dépend du respect volontaire de vos directives par les crawlers, tandis que les règles WAF sont appliquées au niveau de l’infrastructure et s’appliquent à toutes les requêtes quel que soit le respect des crawlers. Les WAF offrent une détection et un blocage en temps réel, alors que robots.txt est statique et facilement contourné par les crawlers non conformes.

Oui, de nombreux crawlers IA ignorent les directives robots.txt car ils sont conçus pour maximiser la collecte de données d'entraînement. Alors que les crawlers respectueux des grandes entreprises respectent généralement robots.txt, les acteurs malveillants et certains nouveaux crawlers ne le font pas. C’est pourquoi les règles WAF offrent une protection plus fiable.

Consultez les logs d'accès de votre serveur (généralement dans /var/log/apache2/access.log ou /var/log/nginx/access.log) pour repérer les chaînes user-agent contenant des identifiants de bots. Des outils comme Cloudflare Radar offrent une visibilité globale sur les flux de trafic des crawlers IA, et les plateformes d’analyse différencient de plus en plus le trafic bot du trafic humain.

Le blocage des crawlers d’entraînement comme GPTBot n’a pas d’impact direct sur le SEO car ils n’envoient pas de trafic référent. En revanche, le blocage des crawlers de recherche comme OAI-SearchBot peut réduire la visibilité dans les résultats de recherche enrichis par l’IA. Les AI Overviews de Google suivent les règles standard de Googlebot, donc le blocage de Google-Extended n’affecte pas l’indexation classique.

AI Crawl Control de Cloudflare, AWS WAF Bot Control, et Azure WAF offrent tous des solutions efficaces. Cloudflare propose les fonctionnalités les plus spécifiques à l’IA avec des règles préconstruites et des options de paiement par crawl. AWS offre une détection avancée par machine learning, tandis qu’Azure propose des ensembles de règles gérés solides. Choisissez en fonction de votre infrastructure existante et de votre budget.

Examinez et mettez à jour vos règles WAF au moins trimestriellement, car de nouveaux crawlers IA apparaissent régulièrement et les crawlers existants modifient leurs user-agents. Surveillez le projet communautaire ai.robots.txt sur GitHub pour les menaces émergentes, et vérifiez les logs de serveur chaque mois pour identifier les nouveaux crawlers qui touchent votre site.

Oui, c’est une stratégie courante. Vous pouvez configurer des règles WAF pour bloquer les crawlers d’entraînement comme GPTBot et ClaudeBot tout en autorisant les crawlers de recherche comme OAI-SearchBot et PerplexityBot. Cela protège votre contenu de l’entraînement de modèles tout en conservant la visibilité dans les résultats de recherche enrichis par l’IA.

Le prix des WAF varie selon le fournisseur. Cloudflare propose un WAF à partir de 20 $/mois avec des fonctionnalités AI Crawl Control. AWS WAF facture par ACL web et par règle, typiquement 5-10 $/mois pour une protection basique. Azure WAF est inclus avec Application Gateway. Les coûts d’implémentation sont minimes comparés à la valeur de la protection de votre contenu et le maintien d’analyses précises.

AmICited suit l’activité des crawlers IA et surveille la manière dont votre contenu est cité sur ChatGPT, Perplexity, Google AI Overviews et d'autres plateformes IA. Obtenez de la visibilité sur votre présence IA et comprenez quels crawlers accèdent à votre contenu.

Découvrez comment utiliser robots.txt pour contrôler quels bots d'IA accèdent à votre contenu. Guide complet pour bloquer GPTBot, ClaudeBot et d'autres crawlers...

Découvrez comment gérer l’accès des crawlers IA au contenu de votre site web. Comprenez la différence entre crawlers d’entraînement et de recherche, mettez en p...

Découvrez comment autoriser ou bloquer sélectivement les crawlers IA en fonction des objectifs commerciaux. Mettez en œuvre un accès différentiel aux crawlers p...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.