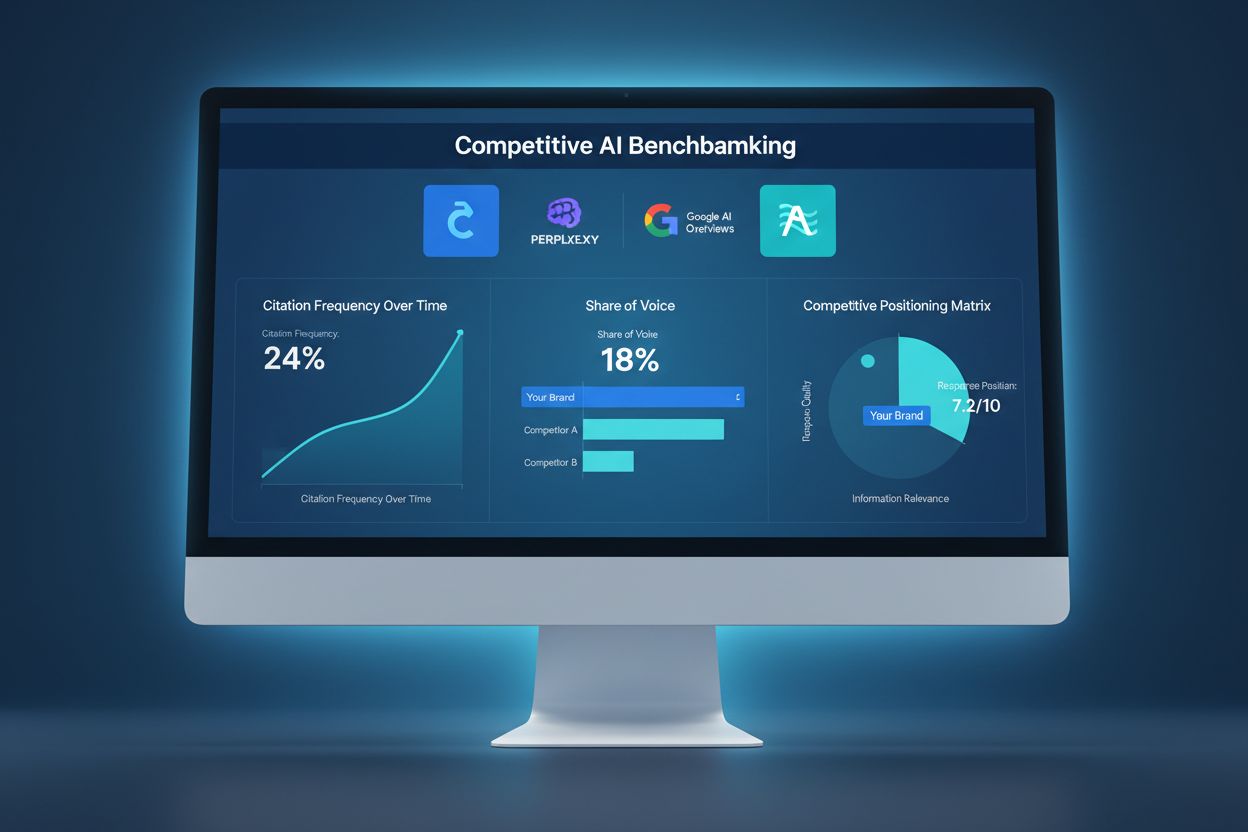

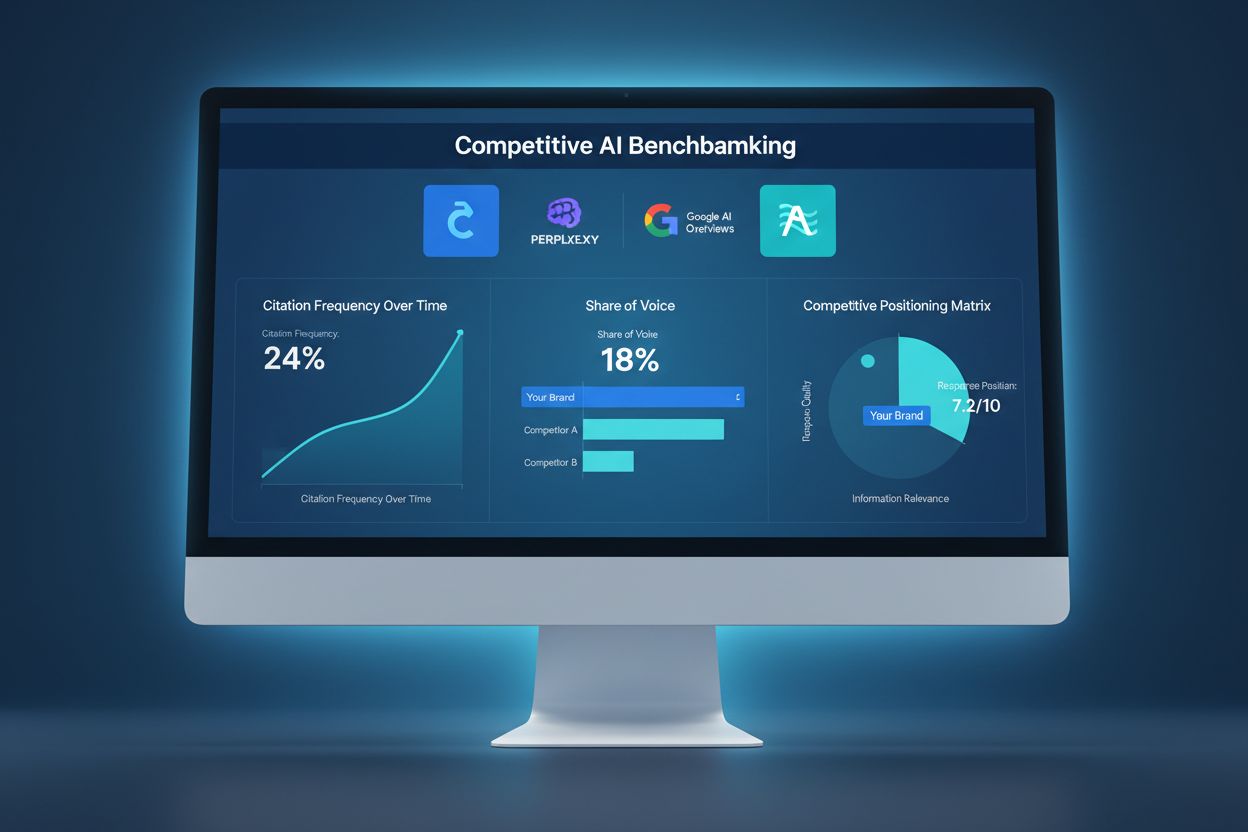

Benchmarking concurrentiel de l’IA

Découvrez comment comparer votre visibilité dans l’IA face à vos concurrents. Suivez les citations, la part de voix et le positionnement concurrentiel sur ChatG...

La sabotage concurrentielle de l’IA fait référence aux tentatives délibérées de concurrents visant à influencer négativement la visibilité, la perception ou la performance d’une marque dans les résultats de recherche et les réponses de chatbots alimentés par l’IA. Cela inclut l’empoisonnement des données, les faux avis, les campagnes de désinformation et la manipulation des données d’entraînement de l’IA dans le but de nuire à la réputation d’une marque et de réduire les citations par l’IA.

La sabotage concurrentielle de l'IA fait référence aux tentatives délibérées de concurrents visant à influencer négativement la visibilité, la perception ou la performance d'une marque dans les résultats de recherche et les réponses de chatbots alimentés par l'IA. Cela inclut l'empoisonnement des données, les faux avis, les campagnes de désinformation et la manipulation des données d'entraînement de l'IA dans le but de nuire à la réputation d'une marque et de réduire les citations par l'IA.

Le sabotage concurrentiel de l’IA désigne les tentatives délibérées de manipuler, empoisonner ou corrompre les données utilisées par les moteurs de recherche et les modèles de langage alimentés par l’IA pour générer des résultats et des citations. Contrairement au SEO négatif traditionnel, qui vise à dégrader le classement du site web d’un concurrent par des schémas de liens ou des exploits techniques, le sabotage de l’IA cible les données d’entraînement et les sources sur lesquelles les systèmes d’IA s’appuient pour fournir des réponses. Cette distinction est essentielle, car des systèmes d’IA comme Google AI Overviews, Perplexity et les GPT citent directement des sources issues de leurs données d’entraînement, les rendant vulnérables aux campagnes de désinformation coordonnées. L’impact réel est considérable : avec 60 % des recherches se terminant sans clic vers des sites web, les concurrents peuvent désormais empoisonner les résultats de l’IA pour détourner le trafic, nuire à la réputation d’une marque ou promouvoir de fausses informations sans affecter le référencement traditionnel.

Le sabotage concurrentiel de l’IA exploite plusieurs vecteurs d’attaque interconnectés qui tirent parti de la manière dont les systèmes d’IA ingèrent et traitent l’information. L’empoisonnement des données est la technique principale, consistant à injecter des informations fausses, trompeuses ou malveillantes dans les sources utilisées par l’IA pour l’entraînement – telles que les bases de données publiques, les forums, les sites d’avis et les agrégateurs d’actualités. Les attaquants emploient le changement d’étiquette (modification des métadonnées pour mal classer un contenu), l’injection de données (ajout de fausses entrées dans des ensembles de données) et des attaques par porte dérobée (intégration de déclencheurs cachés dans les données d’entraînement). Les concurrents lancent également des campagnes coordonnées de faux avis pour inonder les plateformes de témoignages fabriqués, tout en diffusant désinformation et deepfakes via les réseaux sociaux, les blogs et les contenus indexés par l’IA. La vulnérabilité provient du fait que les systèmes d’IA font souvent confiance au volume et à la cohérence de l’information plutôt qu’à son authenticité. Voici comment se comparent les différentes méthodes de sabotage :

| Méthode | Fonctionnement | Impact sur l’IA | Difficulté de détection |

|---|---|---|---|

| Empoisonnement de données | Injection d’informations erronées dans les ensembles d’entraînement | L’IA cite directement les sources empoisonnées dans les résultats | Élevée – nécessite une analyse des données |

| Faux avis | Bombardement coordonné d’avis sur les plateformes | Biais l’analyse de sentiment et les recommandations de l’IA | Moyenne – l’analyse des schémas aide |

| Campagnes de désinformation | Diffusion de fausses affirmations sur des sites indexés | L’IA amplifie les fausses narratives dans les résultats | Élevée – nécessite une vérification des faits |

| Deepfakes | Création de médias synthétiques sur des dirigeants ou produits | Porte atteinte à la crédibilité de la marque citée par l’IA | Très élevée – demande vérification |

| Détournement d’annuaires | Prise de contrôle des fiches d’une entreprise concurrente | L’IA extrait de fausses informations des annuaires détournés | Moyenne – la vérification aide |

| Faux articles de presse | Publication de contenus fabriqués sur des sites d’apparence journalistique | L’IA considère ces sources comme faisant autorité | Élevée – nécessite une vérification des sources |

Les systèmes d’IA sont fondamentalement plus vulnérables au sabotage que les moteurs de recherche traditionnels, car ils font confiance aux données d’entraînement de manière plus implicite que les humains. Alors que l’algorithme de Google évalue l’autorité des liens et la réputation du domaine, les modèles d’IA apprennent simplement des schémas à partir de toutes les données qui leur sont fournies – ce qui les rend sensibles aux attaques coordonnées. Des études montrent que seulement 250 documents malveillants peuvent empoisonner un modèle d’IA, un seuil d’entrée bien plus bas que pour les attaques SEO traditionnelles. Le problème est aggravé par le fait que les systèmes d’IA citent directement les sources, de sorte que les données empoisonnées ne se contentent pas d’influencer les résultats : elles deviennent la réponse faisant autorité aux yeux des utilisateurs. Détecter ces données est exponentiellement plus complexe qu’identifier un mauvais lien, car la manipulation s’opère au niveau de l’entraînement et est souvent invisible lors des audits externes. Avec une augmentation de 527 % du trafic de recherche par l’IA en seulement cinq mois (janvier-mai 2025) et 79 % des Américains faisant confiance aux moteurs de recherche IA, la tentation de saboter est plus forte que jamais, alors que l’infrastructure de sécurité reste sous-développée.

L’exemple le plus marquant de sabotage de l’IA s’est produit lorsque Target a été victime d’une campagne de désinformation coordonnée affirmant à tort que le distributeur vendait des vêtements pour enfants à thème “satanique”. Les systèmes d’IA, entraînés sur ce récit fabriqué, ont commencé à faire remonter ces fausses affirmations dans les résultats de recherche et les synthèses d’IA, causant des dommages réputationnels importants avant que l’entreprise ne puisse réagir. Les systèmes de messagerie électronique ont connu des attaques similaires via l’empoisonnement des filtres antispam, où des concurrents injectent des schémas malveillants dans les données d’entraînement, entraînant le classement d’e-mails légitimes comme spam. Le bombardement d’avis négatifs par les concurrents est de plus en plus courant, des entreprises inondant les fiches de rivaux d’avis négatifs factices qui sont ensuite agrégés par l’IA dans ses scores de sentiment. Le détournement d’annuaires professionnels constitue un autre vecteur : des attaquants revendiquent les profils d’entreprises concurrentes sur Google My Business ou d’autres annuaires pour y diffuser de fausses informations indexées et citées par l’IA. Ces exemples montrent que le sabotage de l’IA n’est pas théorique : il nuit activement aux entreprises aujourd’hui, avec des dégâts aggravés par la perception d’autorité des résultats IA, qui sont souvent le premier contact des utilisateurs avec la marque.

Détecter un sabotage concurrentiel de l’IA nécessite une surveillance multicouche de la façon dont votre marque apparaît dans les résultats de recherche et les sources de citation de l’IA. La première étape consiste en une surveillance continue des résultats IA pour votre marque, vos produits et vos dirigeants clés sur des plateformes comme Google AI Overviews, Perplexity, ChatGPT et Claude. Le suivi du sentiment sur les sources indexées permet d’identifier des changements soudains dans la façon dont votre marque est évoquée, ce qui constitue un signal d’alerte pour une campagne de désinformation. L’identification des faux avis passe par l’analyse de schémas statistiques, comme des pics soudains d’avis négatifs ou des formulations identiques. La détection précoce est essentielle : les études montrent que les 48 premières heures d’une attaque sont cruciales pour contenir et réagir. La surveillance doit également porter sur les sources citées par les systèmes IA au sujet de votre marque, afin d’identifier les données empoisonnées avant qu’elles ne causent des dégâts importants. Voici les méthodes de détection essentielles :

Renforcer sa résilience face au sabotage concurrentiel de l’IA impose une stratégie de défense proactive et multifacette, allant au-delà de la gestion de réputation traditionnelle. Créer du contenu de qualité et faisant autorité est la meilleure protection : les systèmes d’IA sont entraînés à reconnaître et privilégier les sources établies et crédibles, rendant plus difficile la concurrence des données empoisonnées. Amplifier l’information exacte sur plusieurs plateformes indexées garantit que l’IA trouve des récits cohérents et véridiques lorsqu’elle recherche votre marque. Sécuriser la présence de votre marque implique de revendiquer et vérifier toutes vos fiches d’entreprise, profils sociaux et annuaires sectoriels pour prévenir les détournements. Mettez en place des systèmes de surveillance robustes pour suivre votre marque en temps réel dans les résultats IA, permettant de réagir rapidement aux menaces émergentes. Développez des protocoles de réponse détaillant la réaction de votre équipe face à un sabotage détecté : documentation, signalement aux plateformes, actions juridiques si nécessaire. Bâtir des relations avec des journalistes, influenceurs et médias reconnus crée des couches supplémentaires de crédibilité identifiées et privilégiées par l’IA.

Des plateformes de surveillance dédiées à l’IA sont devenues indispensables à la protection des marques à l’ère de la recherche automatisée. Ces outils offrent des alertes en temps réel sur l’apparition de votre marque dans les résultats IA, vous permettant de suivre non seulement les classements mais aussi les citations effectives et les sources utilisées par l’IA. AmICited.com se distingue comme une solution complète, spécifiquement conçue pour surveiller la façon dont votre marque, vos produits et vos dirigeants sont cités dans les moteurs de recherche IA, y compris Google AI Overviews, Perplexity et les GPT. La plateforme suit les sources citées par l’IA au sujet de votre marque, vous permettant d’identifier les données empoisonnées et d’agir avant qu’elles ne causent des dégâts importants. L’intégration à votre stratégie globale de sécurité de marque permet de croiser les schémas de citation IA avec les métriques SEO traditionnelles, le sentiment sur les réseaux sociaux et les plateformes d’avis pour une vision complète de votre paysage concurrentiel. En combinant la veille IA à vos outils de gestion de réputation existants, vous construisez un dispositif unifié qui détecte précocement les tentatives de sabotage et fournit les données nécessaires à une réponse rapide.

À mesure que le sabotage concurrentiel de l’IA se généralise, les cadres juridiques évoluent pour répondre à ces nouvelles menaces. Les notices de retrait DMCA peuvent permettre de supprimer des contenus empoisonnés des sources indexées, même si la procédure reste lente et requiert des preuves claires d’infraction ou d’usurpation. Le droit de la diffamation offre un recours lorsque le sabotage implique des déclarations fausses portant atteinte à votre réputation, même si la preuve du préjudice dans le contexte IA demeure complexe. La plupart des grandes plateformes ont désormais des mécanismes de signalement spécifiques aux abus liés à l’IA : empoisonnement des données, faux avis, campagnes de désinformation, avec des niveaux d’application variables. Les réglementations émergentes, comme l’AI Act de l’UE et les projets de lois américains, commencent à établir des cadres de responsabilité pour les systèmes IA amplifiant de fausses informations, ouvrant potentiellement de nouveaux recours juridiques. Les entreprises doivent documenter rigoureusement toute tentative de sabotage, car ces preuves sont essentielles tant pour les procédures judiciaires que pour les recours auprès des plateformes. Il devient de plus en plus important de consulter un juriste spécialisé en IA et en réputation numérique pour élaborer des stratégies conformes à l’évolution de la réglementation.

Le paysage du sabotage concurrentiel de l’IA continuera d’évoluer au rythme des innovations des attaquants et des défenseurs. Les faux avis générés par l’IA à l’aide de grands modèles de langage deviendront de plus en plus indiscernables des retours authentiques, nécessitant des systèmes de détection perfectionnés. La vérification par blockchain et les systèmes décentralisés de crédibilité émergent comme solutions potentielles pour authentifier les sources avant l’intégration dans les jeux de données d’entraînement IA. Les fournisseurs de plateformes investissent massivement dans l’amélioration des défenses : validation avancée des données, vérification des sources, algorithmes de détection d’empoisonnement, même si ces mesures restent toujours en retard sur les nouveaux vecteurs d’attaque. Les systèmes de vérification communautaire, où utilisateurs et experts signalent les contenus suspects, pourraient devenir la norme, créant une défense collaborative contre le sabotage. L’avantage compétitif ira de plus en plus aux entreprises qui anticipent les menaces émergentes grâce à une surveillance continue, des protocoles de réaction rapides et une acculturation forte à l’IA au sein des équipes. Les organisations qui font de la surveillance IA un pilier central de leur protection de marque aujourd’hui seront les mieux armées contre les attaques sophistiquées de demain.

Le SEO négatif traditionnel vise les classements des moteurs de recherche via la manipulation de liens et le scraping de contenu. Le sabotage concurrentiel de l'IA cible les données d'entraînement de l'IA et le comportement des modèles, en empoisonnant les sources citées par les systèmes d'IA dans leurs réponses. Les systèmes d'IA sont plus vulnérables car ils citent directement les sources et font davantage confiance aux données d'entraînement qu'aux algorithmes de recherche traditionnels.

Surveillez chaque semaine la façon dont les plateformes d'IA décrivent votre marque à l'aide d'outils comme AmICited.com. Soyez attentif aux changements soudains de sentiment, aux fausses affirmations dans les réponses de l'IA, aux avis négatifs coordonnés ou à la désinformation qui se propage sur plusieurs plateformes. La détection précoce dans les 48 premières heures est cruciale pour contenir le problème.

Documentez immédiatement tout avec des captures d'écran et des horodatages. Signalez-le aux plateformes concernées (OpenAI, Google, Anthropic). Diffusez des informations exactes via vos propres canaux. Contactez un conseiller juridique si vous subissez une diffamation ou un préjudice financier. Mettez en place des systèmes de surveillance pour détecter rapidement de futures attaques.

Les recherches montrent que les attaquants n'ont besoin que de 250 documents malveillants ou de 7 à 8 % d'un ensemble de données pour empoisonner significativement des modèles d'IA. Ce seuil d'entrée bas rend les systèmes d'IA particulièrement vulnérables par rapport aux moteurs de recherche traditionnels, qui disposent de mécanismes de détection de spam plus sophistiqués.

Les plateformes d'IA actuelles disposent de capacités de détection limitées et s'appuient principalement sur les signalements des utilisateurs et la réentraînement périodique avec des données propres. Cependant, elles mettent en place de meilleurs systèmes de vérification, de détection d'anomalies et de contrôles d'accès. La responsabilité de la détection précoce incombe souvent aux marques elles-mêmes.

Bâtissez une réputation authentique avec du contenu de haute qualité, surveillez régulièrement les résultats de recherche par l'IA, sécurisez la présence de votre marque sur les annuaires, mettez en place des systèmes de surveillance en temps réel et réagissez rapidement aux attaques. La prévention par la construction de la réputation est plus efficace que la remédiation après sabotage.

AmICited.com surveille la façon dont les plateformes d'IA (ChatGPT, Perplexity, Google AI Overviews) référencent votre marque, en suivant les changements de sentiment et les schémas de citation. Des alertes en temps réel vous informent de tout changement soudain dans la façon dont l'IA décrit votre marque, vous permettant de réagir rapidement à toute tentative de sabotage.

Vous pouvez engager des actions en diffamation, déposer des plaintes DMCA pour supprimer les faux contenus, signaler les violations des conditions d'utilisation auprès des plateformes et éventuellement demander des dommages-intérêts pour préjudice financier. La documentation du sabotage est essentielle. Consultez un avocat spécialisé dans les droits numériques et la propriété intellectuelle.

Protégez votre marque contre le sabotage concurrentiel de l'IA grâce à une surveillance en temps réel sur ChatGPT, Perplexity et Google AI Overviews. Détectez les menaces avant qu'elles n'endommagent votre réputation.

Découvrez comment comparer votre visibilité dans l’IA face à vos concurrents. Suivez les citations, la part de voix et le positionnement concurrentiel sur ChatG...

Discussion communautaire sur les tactiques black hat qui nuisent à la visibilité dans l'IA. Retours réels sur l'empoisonnement de l'IA, la manipulation de conte...

Découvrez ce qu'est l'intelligence concurrentielle en IA et comment surveiller la visibilité des concurrents sur ChatGPT, Perplexity et Google AI Overviews. Sui...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.